Pokrycie indeksu

Pokrycie indeksu mierzy, które strony internetowe są zindeksowane przez wyszukiwarki. Dowiedz się, co to oznacza, dlaczego jest ważne dla SEO oraz jak monitorow...

Procent treści witryny skutecznie zindeksowanej i dostępnej dla systemów AI, takich jak ChatGPT, Google AI Overviews i Perplexity. Silne pokrycie indeksu AI zapewnia, że Twoje treści są odnajdywane w odpowiedziach generowanych przez AI i mogą być cytowane jako źródło. W przeciwieństwie do tradycyjnego indeksowania wyszukiwarki, pokrycie indeksu AI decyduje o widoczności na wielu platformach AI i systemach opartych na LLM.

Procent treści witryny skutecznie zindeksowanej i dostępnej dla systemów AI, takich jak ChatGPT, Google AI Overviews i Perplexity. Silne pokrycie indeksu AI zapewnia, że Twoje treści są odnajdywane w odpowiedziach generowanych przez AI i mogą być cytowane jako źródło. W przeciwieństwie do tradycyjnego indeksowania wyszukiwarki, pokrycie indeksu AI decyduje o widoczności na wielu platformach AI i systemach opartych na LLM.

Pokrycie indeksu AI to procent treści Twojej strony internetowej, który został skutecznie odkryty, przeszukany i zindeksowany przez systemy sztucznej inteligencji takie jak ChatGPT, Google AI Overviews, Perplexity i inne duże modele językowe (LLM). W przeciwieństwie do tradycyjnego indeksowania przez wyszukiwarki, które skupia się na widoczności treści w wynikach wyszukiwania, pokrycie indeksu AI określa, czy Twoje treści są dostępne dla systemów AI do trenowania, cytowania i włączania do odpowiedzi generowanych przez AI. Gdy Twoje treści mają silne pokrycie indeksu AI, stają się widoczne na wielu platformach AI, zwiększając szansę, że Twoja marka, produkty lub informacje zostaną wspomniane, gdy użytkownicy korzystają z tych systemów. Słabe pokrycie indeksu AI sprawia, że cenne treści pozostają niewidoczne dla AI, a Ty tracisz kluczowe możliwości budowania widoczności marki w dynamicznie rozwijającym się środowisku wyszukiwania opartym na AI.

Pokrycie indeksu AI bezpośrednio wpływa na widoczność Twojej marki w coraz bardziej zdominowanym przez AI ekosystemie cyfrowym. Wyniki oparte na AI pojawiają się już w ponad 91% wyszukiwań produktów, a platformy takie jak ChatGPT obsługują ponad miliard wyszukiwań tygodniowo, dlatego zapewnienie indeksowania Twoich treści przez te systemy jest niezbędne w nowoczesnej strategii cyfrowej. Ma to duży wpływ biznesowy: treści z silnym pokryciem indeksu AI mogą być cytowane w odpowiedziach AI, generując wartościowy ruch i rozpoznawalność marki, podczas gdy treści zablokowane lub słabo zindeksowane pozostają całkowicie niewidoczne w tych potężnych kanałach odkrywania. Dodatkowo, systemy AI często cytują źródła, które nie są wysoko w tradycyjnych wynikach wyszukiwania — tylko około 20% stron cytowanych przez AI pojawia się w pierwszej dziesiątce wyników organicznych Google, co oznacza, że indeksowanie przez AI tworzy zupełnie nowe możliwości widoczności.

| Scenariusz | Wpływ na widoczność w AI | Efekt biznesowy |

|---|---|---|

| Prawidłowo zindeksowane, wysokiej jakości treści | Często cytowane w odpowiedziach AI | Więcej wzmianek marki, wartościowy ruch, budowa autorytetu |

| Zindeksowane, ale rzadko cytowane | Minimalne wzmianki w wynikach AI | Ograniczona widoczność mimo dostępności technicznej |

| Zablokowane lub niezindeksowane | Brak widoczności w systemach AI | Utracone szanse, konkurencja zyskuje udział głosu |

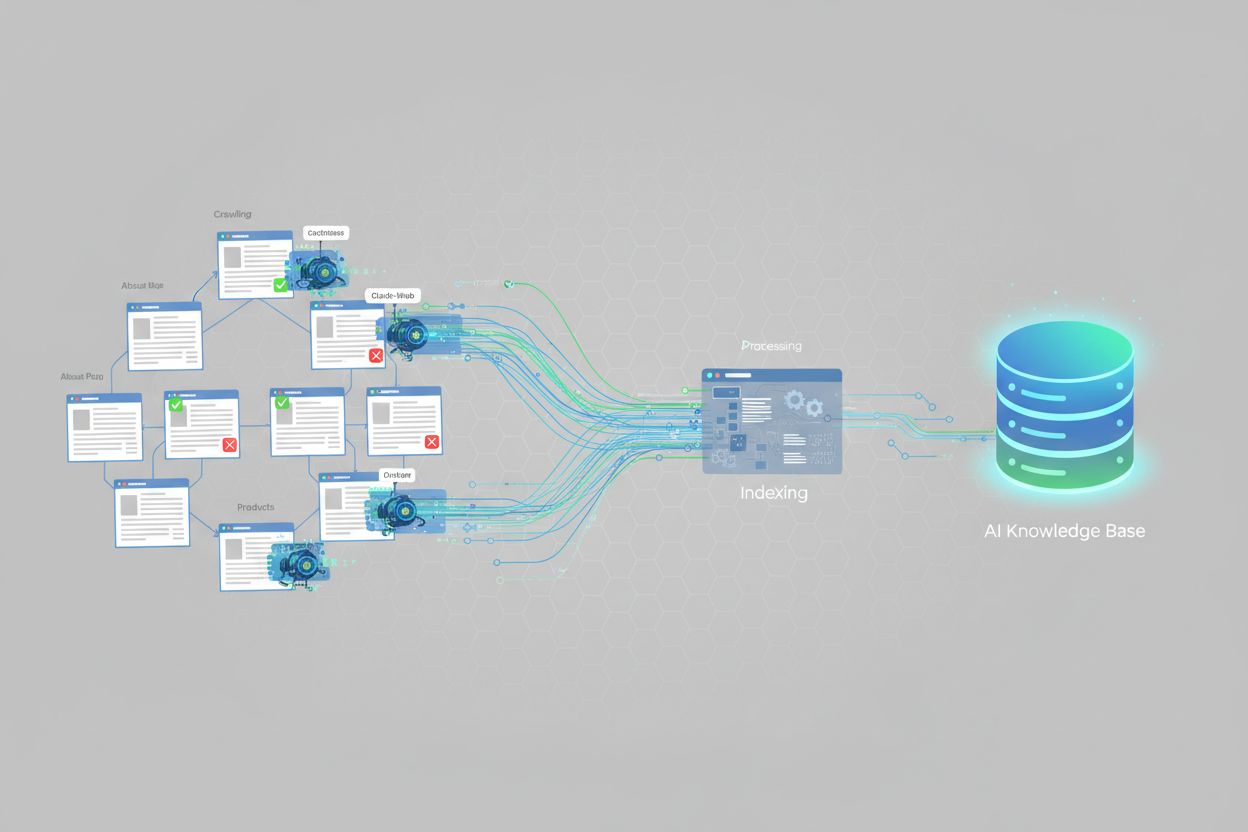

Systemy AI indeksują treści za pomocą wyspecjalizowanych robotów zaprojektowanych do zrozumienia i przetwarzania informacji na potrzeby dużych modeli językowych. ChatGPT używa robotów takich jak GPTBot do ciągłego skanowania sieci i zbierania danych treningowych, a także korzysta z funkcji wyszukiwania w czasie rzeczywistym. Google AI Overviews wykorzystuje istniejącą infrastrukturę crawl Google, ale stosuje dodatkowe przetwarzanie, by lepiej rozumieć strukturę treści, ich trafność i autorytet na potrzeby podsumowań generowanych przez AI. Perplexity AI stawia na wyszukiwanie w czasie rzeczywistym i pobiera wyniki z ponad 20 źródeł na zapytanie, z dużym naciskiem na platformy społecznościowe jak Reddit i treści tworzone przez społeczność. Każda platforma AI ma odmienne preferencje indeksowania: niektóre preferują uporządkowane dane i schematy, inne stawiają na kompleksowe, dobrze napisane treści, a jeszcze inne mocniej ważą cytowania i recenzje z zewnętrznych źródeł. Zrozumienie tych różnic jest kluczowe, gdyż optymalizacja pod jedną platformę AI nie gwarantuje optymalizacji pod inne — strategia treści musi uwzględniać specyficzne zachowania indeksujące platform najistotniejszych dla Twoich odbiorców.

Na skuteczne indeksowanie Twojej strony przez systemy AI wpływa kilka czynników technicznych. Najważniejsze z nich to:

<meta name="robots" content="noindex"> są jawnie wykluczane z indeksowania przez AI. Takie tagi są czasem przypadkowo pozostawiane na stronach produkcyjnych po etapie deweloperskim.Rozwiązanie tych kwestii technicznych jest podstawą do poprawy pokrycia indeksu AI. Narzędzia takie jak AmICited.com pomagają monitorować, jak skutecznie Twoje treści są indeksowane na różnych platformach AI, wskazując, które problemy techniczne mogą ograniczać pokrycie.

Śledzenie pokrycia indeksu AI wymaga połączenia tradycyjnych narzędzi SEO z rozwiązaniami dedykowanymi AI. Google Search Console oferuje raporty pokrycia indeksu pokazujące, które strony są zindeksowane przez Google, choć dotyczy to tradycyjnego indeksowania, a nie systemów AI. Bing Webmaster Tools oferuje podobne funkcje dla wyszukiwarki Bing. W monitorowaniu specyficznym dla AI wyspecjalizowany jest AmICited.com, który śledzi obecność Twojej marki w ChatGPT, Google AI Overviews, Perplexity i innych, pokazując częstotliwość cytowań, sentyment i udział głosu. Platformy SEO takie jak Semrush, Ahrefs i Moz coraz częściej dodatkowo prezentują metryki widoczności AI obok tradycyjnych danych SEO. Kluczowe metryki to: procent stron Twojej witryny pojawiających się w odpowiedziach AI, częstotliwość cytowania marki względem konkurencji, sentyment wzmianek AI oraz typy treści generujące najwięcej cytowań. Regularne monitorowanie pozwala wykryć problemy techniczne, luki w treściach i szanse na poprawę pokrycia indeksu AI.

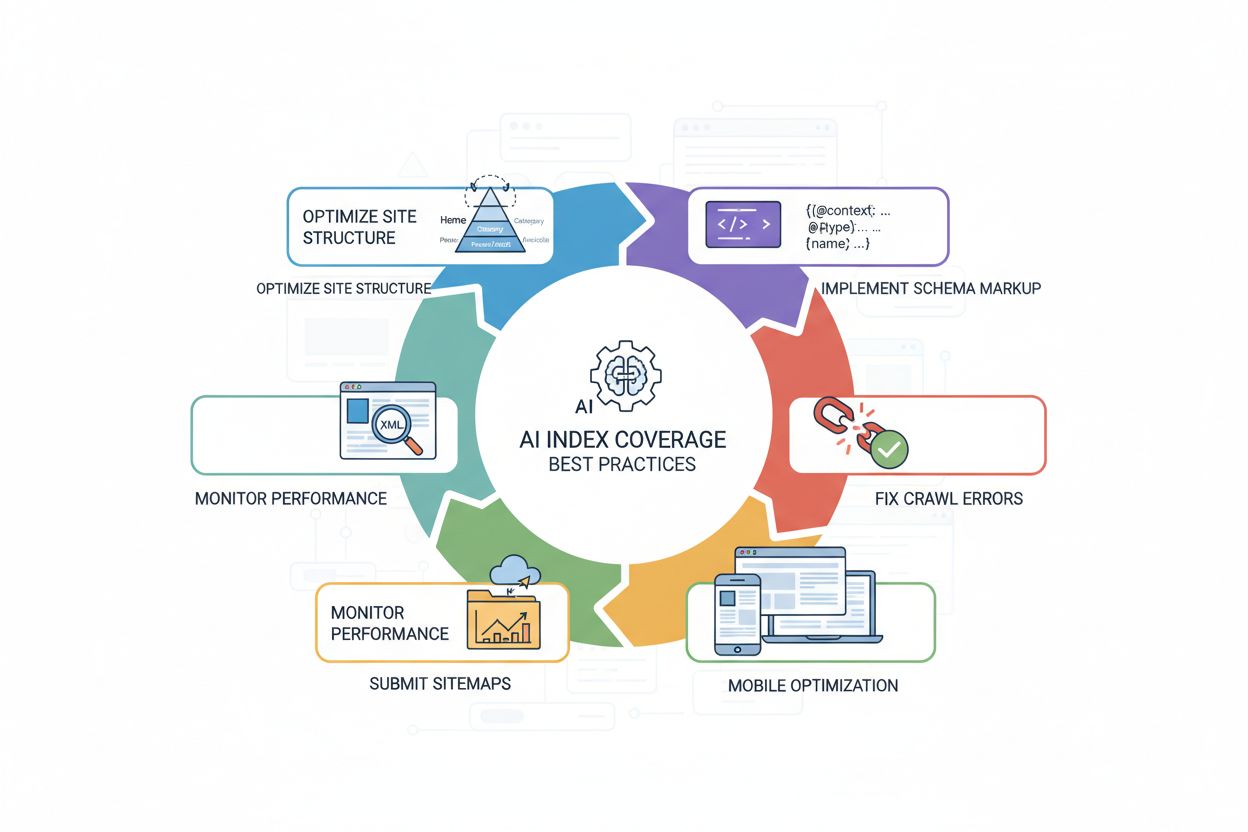

Aby poprawić pokrycie indeksu AI, potrzebne jest strategiczne podejście łączące optymalizację techniczną z wysoką jakością treści. Najskuteczniejsze praktyki to:

<article>, <section>, <header>, <nav>), by jasno komunikować strukturę i znaczenie treści systemom AI.Te działania razem sprawiają, że strona jest przyjazna AI – łatwa do przeszukania, zrozumienia i cytowania. Efektem jest silniejsze pokrycie indeksu AI i większa widoczność na platformach opartych o AI.

Mimo że pokrycie indeksu AI i tradycyjne pokrycie indeksu wyszukiwania są powiązane, nie są tym samym. Tradycyjne indeksowanie wyszukiwarek skupia się na widoczności w wynikach wyszukiwania (SERP), a ranking zależy od linków zwrotnych, trafności słów kluczowych i sygnałów zaangażowania użytkowników. Pokrycie indeksu AI natomiast określa, czy treści są dostępne dla systemów AI do trenowania i cytowania w czasie rzeczywistym – przy zupełnie innych czynnikach rankingowych. Systemy AI często cytują źródła, które nie mają wysokiej pozycji w tradycyjnych wynikach – 20% pokrycia między cytowaniami AI a top 10 wynikami organicznymi podkreśla tę różnicę. Ponadto systemy AI mogą preferować inne formaty treści: podczas gdy tradycyjne wyszukiwanie stawia na autorytet domen, AI często bardziej waży konkretne formaty (FAQ, listy, porównania, recenzje). Strona może być wysoko w Google, a rzadko cytowana przez AI – i odwrotnie. Dlatego strategia powinna uwzględniać oba kanały: tradycyjne SEO zwiększa widoczność w SERP, a optymalizacje pod AI (schemat, struktura, dostępność) zwiększają pokrycie indeksu AI i szansę na cytowanie.

Kilka typowych problemów uniemożliwia osiągnięcie silnego pokrycia indeksu AI. Zbyt restrykcyjne pliki robots.txt to jeden z najczęstszych – wiele stron przypadkowo blokuje roboty AI, chcąc zablokować jedynie tradycyjne wyszukiwarki, przez co całkowicie uniemożliwia indeksowanie przez AI. Niepoprawnie umieszczone tagi noindex na stronach produkcyjnych po wdrożeniu lub migracji mogą sprawić, że całe sekcje będą niewidoczne dla AI. Słaba struktura treści utrudnia robotom AI zrozumienie i wydobycie informacji – strony bez wyraźnych nagłówków, semantycznego HTML czy logicznej organizacji są rzadziej indeksowane i cytowane. Brak lub niepełne oznaczenia schematem pozbawia AI jednoznacznego kontekstu, ograniczając skuteczność indeksowania i cytowań. Strony oparte na JavaScript bez renderowania po stronie serwera to poważna przeszkoda, bo wiele robotów AI nie wykonuje JavaScriptu, przez co kluczowa treść pozostaje ukryta. Zduplikowana treść bez odpowiedniej kanonikalizacji dezorientuje AI co do wersji autorytatywnej, co może ograniczyć pokrycie. Wreszcie, wolne ładowanie i słaba optymalizacja mobilna obniżają efektywność indeksowania, ograniczając liczbę stron objętych indeksem. Systematyczne rozwiązanie tych problemów — od weryfikacji robots.txt, przez wdrożenie schematów, poprawę struktury strony, po zapewnienie szybkości i mobile-friendly — może znacząco zwiększyć pokrycie indeksu AI i widoczność na platformach AI.

Obecnie nie istnieje ustandaryzowany wskaźnik pokrycia indeksu AI dla wszystkich stron, ale badania pokazują, że wyniki oparte na AI pojawiają się w ponad 91% wyszukiwań produktów. Jednak wiele stron ma słabe pokrycie indeksu AI z powodu problemów technicznych, takich jak blokady robots.txt, brak oznaczeń schematu lub problemy z renderowaniem JavaScript. Strony z silnym technicznym SEO i uporządkowanymi danymi zazwyczaj osiągają lepsze pokrycie indeksu AI.

Tradycyjne pokrycie indeksu Google skupia się na widoczności treści w wynikach wyszukiwania, natomiast pokrycie indeksu AI decyduje, czy treści są dostępne dla systemów AI do trenowania i cytowania. Systemy AI często cytują źródła, które nie zajmują miejsc w pierwszej dziesiątce Google — tylko około 20% stron cytowanych przez AI znajduje się w tradycyjnej pierwszej dziesiątce wyników organicznych. Różne platformy AI mają też różne preferencje dotyczące indeksowania i ważenia źródeł.

Tak, możesz zablokować konkretne roboty AI za pomocą pliku robots.txt. Na przykład możesz zablokować GPTBot (OpenAI), CCBot (Common Crawl), lub Claude-Web (Anthropic). Jednak blokowanie robotów AI oznacza, że Twoje treści nie zostaną zindeksowane przez te systemy i nie pojawią się w odpowiedziach generowanych przez AI. Większość firm korzysta na umożliwieniu robotom AI indeksowania w celu zwiększenia widoczności na platformach AI.

Czas indeksowania różni się w zależności od platformy AI. GPTBot ChatGPT przeszukuje sieć na bieżąco, ale może potrzebować kilku dni lub tygodni, by odkryć nową treść. Google AI Overviews korzysta z infrastruktury crawl Google, więc indeksowanie może nastąpić w ciągu kilku godzin lub dni. Perplexity stawia na wyszukiwanie w czasie rzeczywistym, więc najnowsze treści mogą pojawić się szybko. Korzystanie z map XML i zgłaszanie do narzędzi webmastera przyspiesza proces.

Pokrycie indeksu AI i tradycyjne pozycje w wyszukiwarkach są powiązane, ale różne. Optymalizacja pod kątem pokrycia indeksu AI (poprzez schemat, strukturę strony i dostępność) poprawia też tradycyjne SEO. Jednak strona może dobrze pozycjonować się w Google, a rzadko być cytowana przez systemy AI – i odwrotnie. Najlepsza strategia to optymalizacja obu: tradycyjne SEO zwiększa widoczność w wyszukiwarkach, a optymalizacje pod AI poprawiają pokrycie indeksu AI.

Najczęstsze powody to: 1) Zbyt restrykcyjne pliki robots.txt przypadkowo blokujące roboty AI, 2) Brak lub niekompletne oznaczenia schematu utrudniające AI zrozumienie kontekstu treści, 3) Strony oparte na JavaScript bez renderowania po stronie serwera, których roboty AI nie przetwarzają, oraz 4) Słaba struktura strony utrudniająca nawigację robotom. Rozwiązanie tych problemów technicznych zwykle znacząco poprawia pokrycie indeksu AI.

Możesz monitorować pokrycie indeksu AI za pomocą narzędzi takich jak AmICited.com, które śledzą obecność Twojej marki w ChatGPT, Google AI Overviews, Perplexity i innych systemach AI. Zwracaj uwagę na częstotliwość cytowań, udział głosu względem konkurencji i sentyment wzmianek. Możesz też ręcznie testować, wyszukując markę i kluczowe tematy w systemach AI i sprawdzając, czy Twoje treści pojawiają się w odpowiedziach.

Chociaż nie są bezwzględnie wymagane, oznaczenia schematem znacznie poprawiają pokrycie indeksu AI. Ustrukturyzowane dane (JSON-LD) pomagają systemom AI zrozumieć kontekst treści, dokładnie wydobywać informacje i określać ich trafność. Strony z odpowiednim schematem dla produktów, artykułów, FAQ i organizacji są znacznie częściej indeksowane i cytowane przez AI. To najlepsza praktyka optymalizacji pod pokrycie indeksu AI.

Śledź, jak systemy AI odnajdują i cytują Twoją markę w ChatGPT, Google AI Overviews, Perplexity i innych. Uzyskaj wgląd w czasie rzeczywistym w swoją widoczność AI, częstotliwość cytowań i udział głosu w odpowiedziach generowanych przez AI.

Pokrycie indeksu mierzy, które strony internetowe są zindeksowane przez wyszukiwarki. Dowiedz się, co to oznacza, dlaczego jest ważne dla SEO oraz jak monitorow...

Dowiedz się, czym jest wskaźnik pokrycia zapytań, jak go mierzyć i dlaczego jest kluczowy dla widoczności marki w wyszukiwarkach zasilanych AI. Poznaj benchmark...

Dowiedz się, czym jest Indeks Widoczności AI, jak łączy metryki częstotliwości cytowań, pozycji, sentymentu i zasięgu oraz dlaczego ma znaczenie dla widoczności...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.