Jak zakwestionować i poprawić niedokładne informacje w odpowiedziach AI

Dowiedz się, jak zakwestionować niedokładne informacje AI, zgłaszać błędy do ChatGPT i Perplexity oraz wdrażać strategie gwarantujące prawidłową reprezentację T...

Korekta dezinformacji AI odnosi się do strategii i narzędzi służących do identyfikowania i eliminowania nieprawidłowych informacji o marce pojawiających się w odpowiedziach generowanych przez AI, takich jak ChatGPT, Gemini i Perplexity. Obejmuje monitorowanie sposobu, w jaki systemy AI przedstawiają marki oraz wdrażanie poprawek na poziomie źródła, aby zapewnić dystrybucję prawidłowych informacji na zaufanych platformach. W przeciwieństwie do tradycyjnego fact-checkingu, skupia się na korygowaniu źródeł, którym ufają systemy AI, a nie samych odpowiedzi AI. Jest to kluczowe dla utrzymania reputacji marki i poprawności informacji w środowisku wyszukiwania napędzanym przez AI.

Korekta dezinformacji AI odnosi się do strategii i narzędzi służących do identyfikowania i eliminowania nieprawidłowych informacji o marce pojawiających się w odpowiedziach generowanych przez AI, takich jak ChatGPT, Gemini i Perplexity. Obejmuje monitorowanie sposobu, w jaki systemy AI przedstawiają marki oraz wdrażanie poprawek na poziomie źródła, aby zapewnić dystrybucję prawidłowych informacji na zaufanych platformach. W przeciwieństwie do tradycyjnego fact-checkingu, skupia się na korygowaniu źródeł, którym ufają systemy AI, a nie samych odpowiedzi AI. Jest to kluczowe dla utrzymania reputacji marki i poprawności informacji w środowisku wyszukiwania napędzanym przez AI.

Korekta dezinformacji AI to strategie, procesy i narzędzia służące do identyfikowania i eliminowania nieprawidłowych, przestarzałych lub wprowadzających w błąd informacji o markach pojawiających się w odpowiedziach generowanych przez AI, takich jak ChatGPT, Gemini i Perplexity. Najnowsze badania wskazują, że około 45% zapytań do AI skutkuje błędnymi odpowiedziami, co sprawia, że poprawność informacji o marce w systemach AI staje się kluczowym wyzwaniem dla firm. W przeciwieństwie do tradycyjnych wyników wyszukiwania, gdzie marki mogą kontrolować własne listingi, systemy AI syntetyzują informacje z wielu źródeł w sieci, tworząc złożone środowisko, w którym dezinformacja może utrzymywać się niezauważona. Wyzwanie nie polega jedynie na poprawianiu pojedynczych odpowiedzi AI — chodzi o zrozumienie, dlaczego systemy AI przekazują błędne informacje o marce, i wdrożenie systemowych poprawek na poziomie źródła.

Systemy AI nie wymyślają informacji o marce od zera; składają je z tego, co już istnieje w internecie. Proces ten generuje jednak kilka przewidywalnych punktów awarii prowadzących do błędnego przedstawienia marki:

| Przyczyna źródłowa | Jak do tego dochodzi | Wpływ na biznes |

|---|---|---|

| Niespójność źródeł | Marka opisywana różnie na stronach, w katalogach i artykułach | AI wyciąga błędny konsensus z rozbieżnych informacji |

| Nieaktualne autorytatywne źródła | Stare wpisy w Wikipedii, katalogach czy porównaniach zawierają błędne dane | Nowsze poprawki są ignorowane, bo starsze źródła mają wyższy autorytet |

| Pomyłki encji | Zbliżone nazwy marek lub pokrywające się kategorie wprowadzają AI w błąd | Konkurenci dostają zasługi za Twoje osiągnięcia lub marka jest całkowicie pomijana |

| Brak kluczowych sygnałów | Brak danych strukturalnych, przejrzystych stron “O nas” lub spójnej terminologii | AI musi zgadywać informacje, co skutkuje nieprecyzyjnymi lub błędnymi opisami |

Gdy marka jest różnie opisywana na różnych platformach, systemy AI mają trudność z wyłonieniem wersji autorytatywnej. Zamiast prosić o wyjaśnienia, wyciągają konsensus na podstawie częstotliwości i postrzeganego autorytetu — nawet jeśli ten konsensus jest błędny. Drobne różnice w nazwach, opisach czy pozycjonowaniu często są powielane na różnych platformach, a po ich powtórzeniu stają się sygnałami, które modele AI uznają za wiarygodne. Problem nasila się, gdy nieaktualne, ale wysoko oceniane strony zawierają błędne informacje; systemy AI często preferują te starsze źródła względem nowszych poprawek, zwłaszcza jeśli poprawki nie są szeroko rozpowszechnione na zaufanych platformach.

Naprawa błędnych informacji o marce w systemach AI wymaga fundamentalnie odmiennego podejścia niż tradycyjne czyszczenie SEO. W klasycznym SEO marki aktualizują własne listingi, poprawiają dane NAP (nazwa, adres, telefon) i optymalizują treści na stronach. Korekta marki w AI skupia się na zmianie tego, co o Twojej marce mówią zaufane źródła, a nie na kontroli własnej widoczności. Nie poprawiasz AI bezpośrednio — poprawiasz to, czemu AI ufa. Próby “naprawiania” odpowiedzi AI poprzez wielokrotne powtarzanie błędnych informacji (nawet w celu ich zaprzeczenia) mogą przynieść odwrotny skutek, wzmacniając powiązanie, które chcesz usunąć. Systemy AI rozpoznają wzorce, a nie intencje. Oznacza to, że każda poprawka musi się zaczynać na poziomie źródła, cofając się do miejsc, z których systemy AI faktycznie pobierają informacje.

Zanim naprawisz nieprawidłowe informacje o marce, potrzebujesz wglądu w to, jak systemy AI obecnie opisują Twoją markę. Skuteczne monitorowanie koncentruje się na:

Ręczna kontrola jest zawodna, bo odpowiedzi AI różnią się w zależności od zapytania, kontekstu i cyklu aktualizacji. Strukturalne narzędzia monitorujące zapewniają widoczność niezbędną do wczesnego wykrywania błędów, zanim się utrwalą w systemach AI. Wiele marek nie zdaje sobie sprawy, że są błędnie przedstawiane w AI, dopóki nie wspomni o tym klient lub nie wybuchnie kryzys. Proaktywne monitorowanie zapobiega temu przez wychwytywanie niespójności, zanim się rozprzestrzenią.

Po zidentyfikowaniu błędnych informacji o marce, poprawki muszą być wdrożone tam, skąd systemy AI faktycznie się uczą — nie tam, gdzie pojawia się błąd. Skuteczne korekty na poziomie źródła obejmują:

Kluczowa zasada: poprawki działają tylko wtedy, gdy są wdrażane na poziomie źródła. Zmiana tego, co pojawia się w odpowiedziach AI bez naprawy źródeł, jest co najwyżej tymczasowa. Systemy AI nieustannie ponownie oceniają sygnały wraz z pojawianiem się nowych treści i powrotem starszych stron. Poprawka, która nie dotyka źródła problemu, zostanie w końcu nadpisana pierwotną dezinformacją.

Podczas korygowania nieprawidłowych informacji o marce w katalogach, na platformach handlowych czy stronach zasilających AI, większość systemów wymaga weryfikacji powiązania marki z legalnym właścicielem i jej użyciem. Najczęściej wymagane dokumenty to:

Celem nie jest ilość — liczy się spójność. Platformy oceniają, czy dokumentacja, listingi i dane publiczne o marce są zgodne. Dobrze zorganizowane materiały skracają czas rozpatrywania poprawek i zmniejszają liczbę odrzuceń przy masowej korekcie nieprawidłowych informacji. Spójność między źródłami sygnalizuje systemom AI, że informacje o Twojej marce są wiarygodne i autorytatywne.

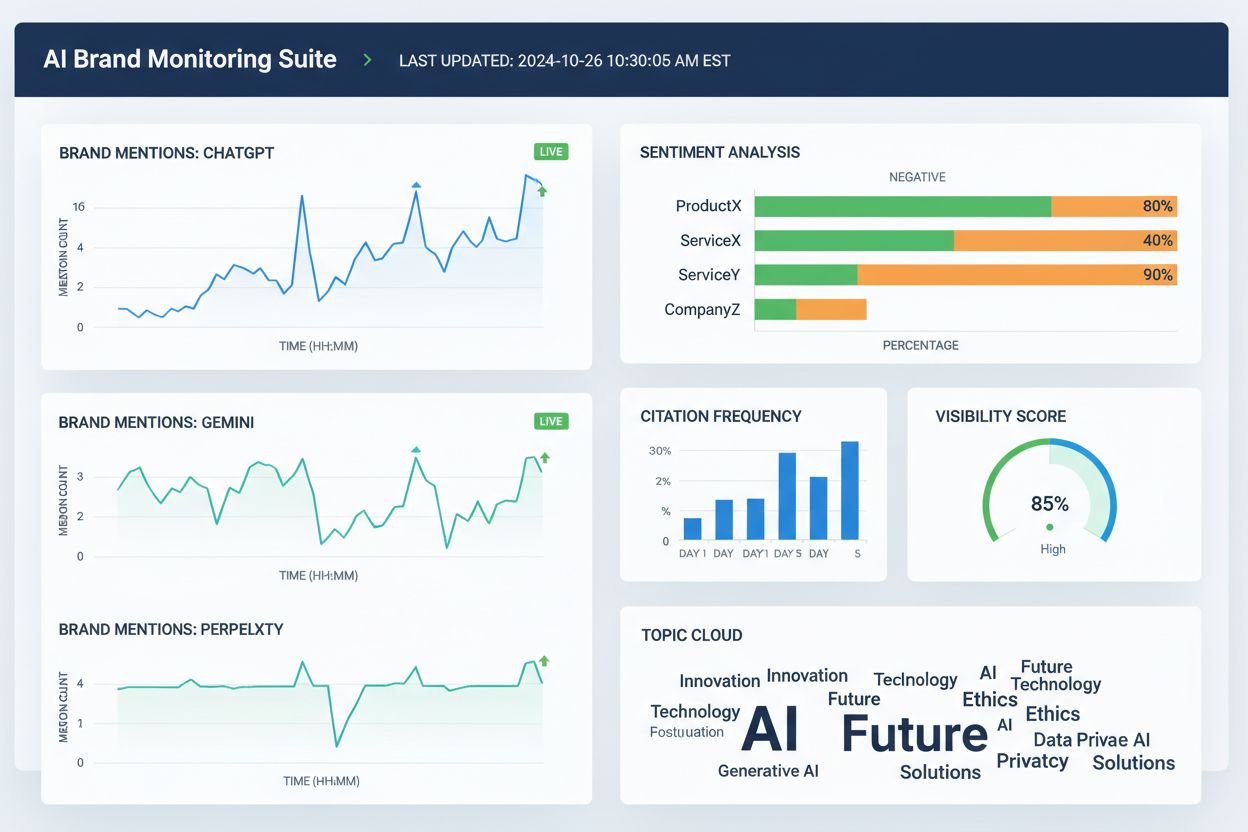

Obecnie dostępnych jest wiele narzędzi pomagających zespołom śledzić prezentację marki na platformach wyszukiwania AI i w szerszym internecie. Ich funkcjonalności często się pokrywają, ale ogólnie skupiają się na widoczności, przypisaniu i spójności:

Te narzędzia nie korygują błędnych informacji bezpośrednio. Pomagają natomiast wykrywać błędy na wczesnym etapie, identyfikować rozbieżności danych o marce zanim się rozprzestrzenią, weryfikować skuteczność poprawek na poziomie źródła oraz monitorować długoterminowe trendy w przypisaniach i widoczności AI. W połączeniu z poprawkami źródłowymi i dokumentacją, narzędzia monitorujące dostarczają pętli zwrotnej niezbędnej do trwałej poprawy informacji o marce.

Dokładność wyszukiwania AI rośnie, gdy marki są jasno zdefiniowanymi encjami, a nie ogólnymi uczestnikami kategorii. By ograniczyć błędne przedstawianie marki w AI, skup się na:

Celem nie jest mówienie więcej — chodzi o powtarzanie tego samego wszędzie. Gdy systemy AI spotykają spójne definicje marki w autorytatywnych źródłach, przestają zgadywać i zaczynają powielać prawidłowe informacje. Ten etap jest szczególnie ważny dla marek, które zmagają się z błędnymi wzmiankami, przypisaniem cech konkurencji czy pomijaniem w odpowiedziach AI. Nawet po skorygowaniu błędnych informacji poprawność nie jest trwała. Systemy AI ciągle rewidują sygnały, dlatego ciągła klarowność jest niezbędna.

Nie istnieje stały harmonogram naprawy błędnych informacji o marce w systemach AI. Modele AI aktualizują się na podstawie siły sygnału i konsensusu, a nie dat zgłoszeń. Typowe wzorce to:

Wczesne postępy rzadko objawiają się jako nagła “naprawiona” odpowiedź. Należy raczej wypatrywać sygnałów pośrednich: mniejszej zmienności w odpowiedziach AI, mniej sprzecznych opisów, bardziej spójnych cytowań i stopniowego pojawiania się marki tam, gdzie wcześniej była pomijana. Stagnacja wygląda inaczej — jeśli te same błędy utrzymują się mimo wielu poprawek, zwykle oznacza to, że pierwotne źródło nie zostało naprawione lub wymagane są silniejsze sygnały w innych miejscach.

Najpewniejszym sposobem naprawy błędnych informacji o marce jest ograniczenie warunków sprzyjających ich powstawaniu. Skuteczna prewencja to:

Marki traktujące widoczność w AI jako dynamiczny system — a nie jednorazowy projekt czyszczenia — szybciej wychodzą z błędów i rzadziej doświadczają powtarzających się przekłamań. Prewencja nie polega na kontroli odpowiedzi AI. Chodzi o utrzymywanie czystych, spójnych wejść, które systemy AI mogą bezpiecznie powielać. Wraz z rozwojem wyszukiwania AI, sukces odniosą te marki, które uznają korektę dezinformacji za proces ciągły, wymagający stałego monitoringu, zarządzania źródłami i świadomego wzmacniania prawidłowych informacji na zaufanych platformach.

Korekta dezinformacji AI to proces identyfikowania i poprawiania nieprawidłowych, nieaktualnych lub wprowadzających w błąd informacji o markach pojawiających się w odpowiedziach generowanych przez AI. W przeciwieństwie do tradycyjnego fact-checkingu, skupia się na korygowaniu źródeł, którym ufają systemy AI (katalogi, artykuły, listingi), a nie bezpośredniej edycji odpowiedzi AI. Celem jest zapewnienie, że gdy użytkownicy pytają systemy AI o Twoją markę, otrzymują prawidłowe informacje.

Systemy AI, takie jak ChatGPT, Gemini i Perplexity, kształtują obecnie wiedzę milionów osób o markach. Badania pokazują, że 45% zapytań do AI zawiera błędy, a nieprawidłowe informacje o marce mogą zaszkodzić reputacji, wprowadzić klientów w błąd i prowadzić do utraty biznesu. W odróżnieniu od tradycyjnych wyszukiwarek, gdzie marki kontrolują swoje listingi, systemy AI syntetyzują informacje z wielu źródeł, co utrudnia kontrolę nad poprawnością marki, a jednocześnie czyni ją jeszcze bardziej krytyczną.

Nie, bezpośrednia korekta nie jest skuteczna. Systemy AI nie przechowują faktów o marce w edytowalnych miejscach — generują odpowiedzi na podstawie zewnętrznych źródeł. Wielokrotne proszenie AI o 'poprawienie' informacji może wręcz utrwalić błędne skojarzenia, które chcesz usunąć. Zamiast tego korekty należy wdrażać na poziomie źródła: aktualizując katalogi, poprawiając nieaktualne listingi i publikując prawidłowe informacje na zaufanych platformach.

Nie ma stałego harmonogramu, ponieważ systemy AI aktualizują się w oparciu o siłę sygnału i konsensus, a nie daty zgłoszeń. Drobne korekty faktów zazwyczaj pojawiają się w ciągu 2-4 tygodni, doprecyzowania na poziomie encji zajmują 1-3 miesiące, a wypieranie konkurencji może trwać 3-6 miesięcy lub dłużej. Postęp rzadko objawia się jako nagła 'poprawiona' odpowiedź — należy raczej szukać zmniejszonej zmienności odpowiedzi i bardziej spójnych cytowań w różnych źródłach.

Obecnie dostępnych jest kilka narzędzi śledzących sposób prezentacji marki na platformach AI: Wellows monitoruje wzmianki i sentyment w ChatGPT, Gemini i Perplexity; Profound porównuje widoczność w różnych LLM; Otterly.ai analizuje sentyment marki w odpowiedziach AI; BrandBeacon oferuje analitykę pozycjonowania; Ahrefs Brand Radar śledzi wzmianki w sieci; a AmICited.com specjalizuje się w monitorowaniu cytowań i prezentacji marki w systemach AI. Narzędzia te umożliwiają wczesne wykrywanie błędów i weryfikację skuteczności poprawek.

Halucynacje AI to sytuacje, gdy systemy AI generują informacje niezwiązane z danymi treningowymi lub niepoprawnie je dekodują. Dezinformacja AI to fałszywe lub wprowadzające w błąd informacje pojawiające się w odpowiedziach AI, powstałe zarówno w wyniku halucynacji, jak i przestarzałych źródeł, pomyłek encji czy niespójnych danych na różnych platformach. Korekta dezinformacji dotyczy zarówno halucynacji, jak i nieścisłości w źródłach prowadzących do błędnego przedstawienia marki.

Monitoruj sposób, w jaki systemy AI opisują Twoją markę, zadając im pytania o firmę, produkty i pozycjonowanie. Zwracaj uwagę na nieaktualne informacje, błędne opisy, brakujące szczegóły lub przypisywanie cech konkurencji. Korzystaj z narzędzi monitorujących wzmianki w ChatGPT, Gemini i Perplexity. Sprawdź, czy Twoja marka nie jest pomijana w istotnych odpowiedziach AI. Porównuj opisy AI z oficjalnymi informacjami o marce, by wykryć rozbieżności.

To proces ciągły. Systemy AI nieustannie rewidują sygnały wraz z pojawianiem się nowych treści i powrotem starszych stron. Jednorazowa korekta bez stałego monitoringu zostanie w końcu nadpisana przez pierwotną dezinformację. Marki, którym się udaje, traktują widoczność w AI jako żywy system: utrzymują spójne definicje marki we wszystkich źródłach, regularnie audytują katalogi i stale monitorują wzmianki, by wychwycić nowe błędy, zanim się rozpowszechnią.

Śledź, jak systemy AI, takie jak ChatGPT, Gemini i Perplexity, przedstawiają Twoją markę. Uzyskaj wgląd w czasie rzeczywistym w wzmianki o marce, cytowania i widoczność na platformach AI dzięki AmICited.com.

Dowiedz się, jak zakwestionować niedokładne informacje AI, zgłaszać błędy do ChatGPT i Perplexity oraz wdrażać strategie gwarantujące prawidłową reprezentację T...

Poznaj skuteczne metody identyfikowania, weryfikowania i poprawiania nieścisłych informacji w odpowiedziach generowanych przez AI, takich jak ChatGPT, Perplexit...

Dyskusja społeczności na temat kwestionowania nieprawdziwych informacji AI o firmach i produktach. Prawdziwe doświadczenia managerów marek z formalnymi procesam...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.