Fine-Tuning

Definicja fine-tuningu: dostosowywanie wstępnie wytrenowanych modeli AI do konkretnych zadań poprzez domenowy trening. Dowiedz się, jak fine-tuning poprawia wyd...

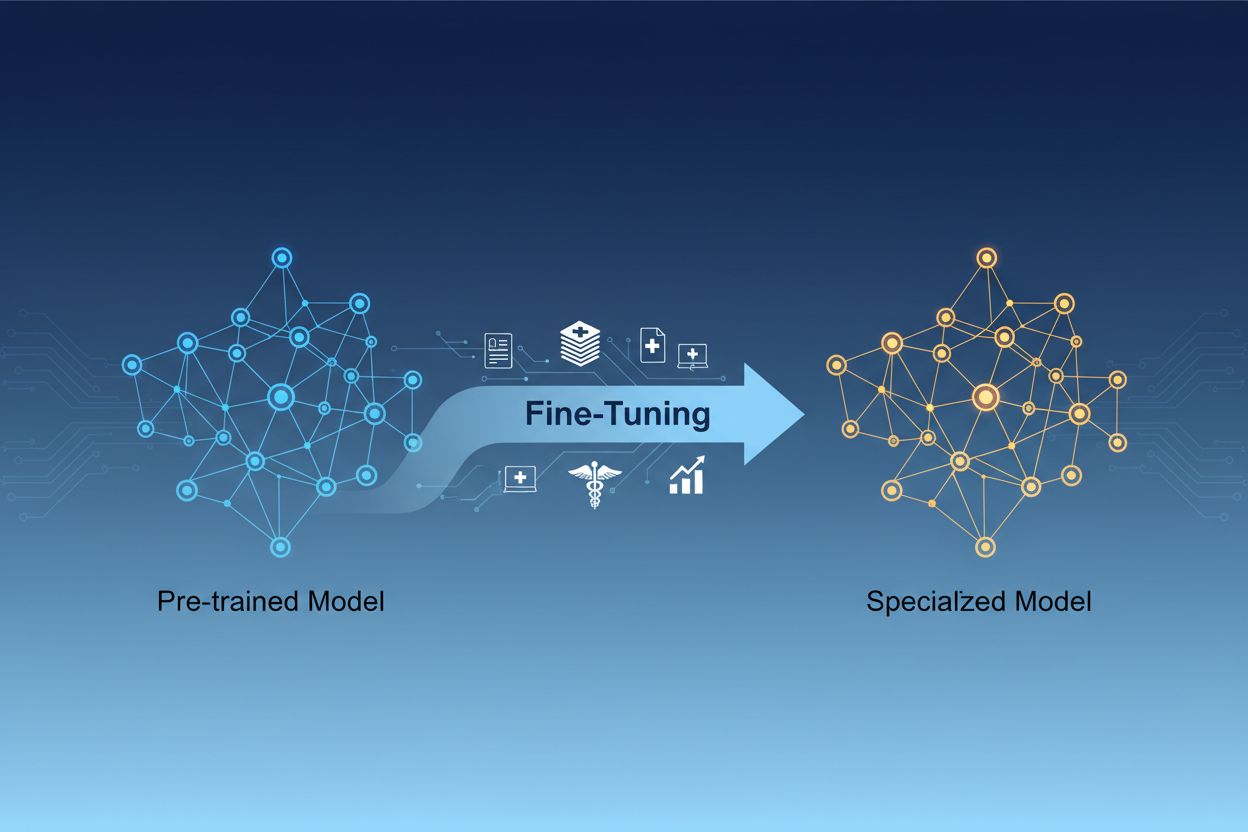

Dostrajanie modelu AI to proces adaptacji wstępnie wytrenowanych modeli sztucznej inteligencji do realizacji konkretnych zadań lub pracy z wyspecjalizowanymi danymi poprzez dostosowanie ich parametrów podczas dodatkowego treningu na dziedzinowych zbiorach danych. Takie podejście wykorzystuje istniejącą wiedzę bazową, jednocześnie umożliwiając personalizację modeli do konkretnych zastosowań biznesowych, co pozwala organizacjom tworzyć wysoce wyspecjalizowane systemy AI bez kosztów obliczeniowych związanych ze szkoleniem od podstaw.

Dostrajanie modelu AI to proces adaptacji wstępnie wytrenowanych modeli sztucznej inteligencji do realizacji konkretnych zadań lub pracy z wyspecjalizowanymi danymi poprzez dostosowanie ich parametrów podczas dodatkowego treningu na dziedzinowych zbiorach danych. Takie podejście wykorzystuje istniejącą wiedzę bazową, jednocześnie umożliwiając personalizację modeli do konkretnych zastosowań biznesowych, co pozwala organizacjom tworzyć wysoce wyspecjalizowane systemy AI bez kosztów obliczeniowych związanych ze szkoleniem od podstaw.

Dostrajanie modelu AI to proces polegający na wzięciu wstępnie wytrenowanego modelu sztucznej inteligencji i przystosowaniu go do realizacji konkretnych zadań lub pracy na wyspecjalizowanych danych. Zamiast trenować model od zera, dostrajanie wykorzystuje już zakodowaną wiedzę bazową i dostosowuje parametry modelu poprzez dodatkowy trening na zbiorach danych specyficznych dla danej dziedziny lub zadania. Takie podejście łączy efektywność transfer learningu z możliwością personalizacji pod konkretne zastosowania biznesowe. Dostrajanie pozwala organizacjom tworzyć wysoce wyspecjalizowane modele AI bez ponoszenia kosztów obliczeniowych i czasowych związanych ze szkoleniem od podstaw, czyniąc tę technikę kluczową we współczesnym rozwoju uczenia maszynowego.

Różnica między dostrajaniem, a trenowaniem od podstaw to jedna z najważniejszych decyzji w rozwoju rozwiązań uczenia maszynowego. Trenując model od zera, zaczynasz od losowo zainicjalizowanych wag i musisz nauczyć model wszystkiego o wzorcach językowych, cechach wizualnych czy wiedzy dziedzinowej, korzystając z ogromnych zbiorów danych i znaczących zasobów obliczeniowych. Takie podejście może wymagać tygodni lub miesięcy treningu oraz dostępu do specjalistycznego sprzętu, takiego jak GPU czy TPU. Dostrajanie natomiast rozpoczyna się od modelu, który już rozumie podstawowe wzorce i pojęcia, wymagając jedynie ułamka danych i mocy obliczeniowej, by dopasować go do twoich potrzeb. Model wstępnie wytrenowany poznał już ogólne cechy podczas początkowego treningu, więc dostrajanie skupia się na ich dopasowaniu do konkretnego przypadku użycia. Ta oszczędność sprawia, że dostrajanie jest preferowaną metodą dla większości organizacji – skraca czas wdrożenia i redukuje koszty infrastruktury, a często zapewnia lepsze rezultaty niż trenowanie mniejszych modeli od podstaw.

| Aspekt | Dostrajanie | Trenowanie od zera |

|---|---|---|

| Czas treningu | Od kilku dni do tygodni | Od tygodni do miesięcy |

| Wymagania dotyczące danych | Tysiące do milionów przykładów | Miliony do miliardów przykładów |

| Koszt obliczeniowy | Umiarkowany (często wystarczy pojedynczy GPU) | Bardzo wysoki (potrzebnych wiele GPU/TPU) |

| Wiedza początkowa | Wykorzystuje wstępnie wytrenowane wagi | Startuje z losowej inicjalizacji |

| Wydajność | Często lepsza przy ograniczonych danych | Lepsza przy ogromnych zbiorach danych |

| Wymagane kompetencje | Średniozaawansowane | Zaawansowane |

| Poziom personalizacji | Wysoki dla konkretnych zadań | Maksymalna elastyczność |

| Infrastruktura | Standardowe zasoby chmurowe | Specjalistyczne klastry sprzętowe |

Dostrajanie stało się kluczową umiejętnością dla organizacji chcących wdrażać rozwiązania AI zapewniające przewagę konkurencyjną. Adaptując wstępnie wytrenowane modele do własnego kontekstu biznesowego, możesz tworzyć systemy AI, które z niezwykłą dokładnością rozumieją branżową terminologię, preferencje klientów i wymagania operacyjne. Takie dostosowanie pozwala osiągać poziomy wydajności, których ogólne „gotowe” modele nie są w stanie zapewnić, zwłaszcza w specjalistycznych branżach, jak medycyna, prawo czy obsługa techniczna. Ekonomiczność dostrajania sprawia, że nawet mniejsze firmy mogą korzystać z rozwiązań AI klasy enterprise bez ogromnych wydatków infrastrukturalnych. Dodatkowo dostrojone modele można wdrażać szybciej, co umożliwia szybką reakcję na zmieniający się rynek i presję konkurencji. Możliwość ciągłego doskonalenia modeli poprzez dostrajanie na nowych danych zapewnia, że Twoje systemy AI pozostaną aktualne i skuteczne wraz ze zmianami w otoczeniu biznesowym.

Kluczowe korzyści biznesowe dostrajania:

Wypracowano kilka sprawdzonych technik dostrajania, z których każda ma swoje zalety w zależności od Twoich wymagań. Pełne dostrajanie polega na aktualizacji wszystkich parametrów wstępnie wytrenowanego modelu, zapewniając maksymalną elastyczność i często najwyższą wydajność, ale wymaga znacznych zasobów obliczeniowych i dużych zbiorów danych, by uniknąć przeuczenia. Efektywne parametrowo techniki dostrajania, takie jak LoRA (Low-Rank Adaptation) czy QLoRA, zrewolucjonizowały podejście do dostrajania, umożliwiając skuteczną adaptację modelu przy aktualizacji tylko niewielkiej części parametrów, co radykalnie obniża wymagania pamięciowe i czas treningu. Techniki te polegają na dodawaniu trenowalnych macierzy niskiego rzędu do macierzy wag modelu, rejestrując zmiany specyficzne dla zadania bez modyfikowania oryginalnych wag wstępnych. Adaptery to kolejne podejście, polegające na wstawianiu małych trenowalnych sieci między warstwy zamrożonego modelu, co umożliwia efektywne dostrajanie przy minimalnej liczbie dodatkowych parametrów. Dostrajanie przez prompty skupia się na optymalizacji wejściowych promptów zamiast wag modelu — jest to przydatne, gdy nie mamy dostępu do parametrów modelu. Dostrajanie instrukcji polega na uczeniu modeli realizowania określonych poleceń i instrukcji, szczególnie ważne w dużych modelach językowych, które muszą odpowiadać na różnorodne żądania użytkowników. Wybór techniki zależy od ograniczeń sprzętowych, wielkości zbioru danych, wymagań dotyczących wydajności i specyfiki architektury modelu.

Dostrajanie dużych modeli językowych (LLM) to szczególne wyzwania i możliwości w porównaniu z dostrajaniem mniejszych modeli czy innych sieci neuronowych. Współczesne LLM-y, takie jak modele w stylu GPT, mają miliardy parametrów, co sprawia, że pełne dostrajanie jest kosztowne obliczeniowo i praktycznie poza zasięgiem większości firm. To spowodowało rozwój efektywnych parametrowo technik, które pozwalają skutecznie adaptować LLM-y bez potrzeby infrastruktury klasy enterprise. Dostrajanie instrukcji stało się szczególnie istotne, pozwalając trenować modele na przykładach poleceń i jakościowych odpowiedzi, co umożliwia im skuteczniejsze realizowanie wytycznych użytkownika. Uczenie przez wzmocnienie z informacją zwrotną od człowieka (RLHF) to zaawansowana metoda dostrajania, gdzie modele są dodatkowo dopasowywane na podstawie ocen i preferencji ludzi, poprawiając zgodność z ludzkimi wartościami i oczekiwaniami. Relatywnie niewielka ilość danych potrzebnych do dostrajania LLM-ów — często setki lub tysiące przykładów — sprawia, że ta metoda jest dostępna nawet dla firm bez ogromnych zbiorów danych. Jednak proces wymaga starannego doboru hiperparametrów, harmonogramu uczenia i zapobiegania zjawisku katastrofalnego zapominania, kiedy model traci wcześniej nabyte umiejętności podczas adaptacji do nowych zadań.

Organizacje z różnych branż odkryły potężne zastosowania dostrojonych modeli AI, które przynoszą wymierne korzyści biznesowe. Automatyzacja obsługi klienta to jedno z najczęstszych zastosowań — modele dostrajane na firmowych zgłoszeniach, informacjach produktowych i stylu komunikacji pozwalają budować chatboty odpowiadające klientom z ekspercką wiedzą branżową i spójnym wizerunkiem marki. Analiza dokumentów medycznych i prawnych wykorzystuje dostrajanie do adaptacji ogólnych modeli językowych do rozumienia specjalistycznej terminologii, wymogów regulacyjnych czy branżowych formatów, umożliwiając precyzyjne wydobywanie i klasyfikowanie informacji. Analiza sentymentu i moderacja treści zyskują na jakości dzięki dostrajaniu na przykładach ze specyficznej branży lub społeczności, pozwalając uchwycić niuanse językowe i kontekst, których nie wyłapują modele ogólne. Generowanie kodu i pomoc programistyczna korzystają na dostrojeniu do firmowego kodu, konwencji programistycznych i wzorców architektonicznych, umożliwiając AI generowanie kodu zgodnego z wewnętrznymi standardami. Systemy rekomendacyjne często są dostrajane na podstawie danych o zachowaniach użytkowników i katalogach produktów, by zapewnić spersonalizowane sugestie zwiększające zaangażowanie i przychody. Rozpoznawanie nazw własnych i wydobywanie informacji z dokumentów branżowych — takich jak raporty finansowe, publikacje naukowe czy specyfikacje techniczne — można znacząco usprawnić przez dostrajanie na odpowiednich przykładach. Te różnorodne zastosowania pokazują, że dostrajanie nie jest ograniczone do jednej branży czy zastosowania, lecz stanowi fundamentalną umiejętność budowania AI dających przewagę konkurencyjną w praktycznie każdej dziedzinie biznesu.

Proces dostrajania to zorganizowany workflow rozpoczynający się od starannych przygotowań i kończący wdrożeniem oraz monitoringiem. Przygotowanie danych to kluczowy pierwszy krok, który wymaga zebrania, oczyszczenia i sformatowania dziedzinowego zbioru danych w sposób odpowiadający strukturze wejścia-wyjścia oczekiwanej przez wstępnie wytrenowany model. Zbiór ten powinien być reprezentatywny dla zadań, które model ma wykonywać w produkcji — jakość jest ważniejsza od ilości: mniejszy, ale wysokiej jakości zbiór zwykle daje lepsze efekty niż większy, ale niespójny lub zaszumiony. Podział na zbiór treningowy, walidacyjny i testowy pozwala właściwie ocenić wydajność modelu (typowo 70-80% – trening, 10-15% – walidacja, 10-15% – test). Wybór hiperparametrów obejmuje ustalenie tempa uczenia, wielkości batcha, liczby epok i innych parametrów kontrolujących proces dostrajania — mają one duży wpływ zarówno na wydajność, jak i efektywność treningu. Inicjalizacja modelu wykorzystuje wstępnie wytrenowane wagi jako punkt wyjścia, zachowując wiedzę bazową i pozwalając na dostosowanie do konkretnego zadania. Wykonanie treningu polega na iteracyjnej aktualizacji parametrów modelu na danych treningowych przy jednoczesnym monitorowaniu wydajności walidacyjnej, by wykryć przeuczenie. Ewaluacja i iteracja opierają się na zbiorze testowym do oceny końcowej i decyzji, czy dalsze dostrajanie, inne hiperparametry lub więcej danych poprawią wyniki. Przygotowanie do wdrożenia obejmuje optymalizację modelu pod kątem szybkości wnioskowania i efektywności zasobów, np. poprzez kwantyzację czy destylację. Wreszcie monitorowanie i utrzymanie w produkcji gwarantuje, że model nadal działa poprawnie mimo zmian rozkładów danych, a okresowe ponowne dostrajanie na nowych danych utrzymuje wysoką dokładność.

Dostrajanie, choć efektywniejsze niż trenowanie od podstaw, niesie własne wyzwania, z którymi należy się zmierzyć. Przeuczenie pojawia się, gdy model zapamiętuje dane treningowe zamiast uczyć się ogólnych wzorców — to szczególne ryzyko przy małych zbiorach, któremu można przeciwdziałać przez wczesne zatrzymanie, regularyzację i augmentację danych. Katastrofalne zapominanie to sytuacja, gdy podczas dostrajania model traci wcześniej nabyte umiejętności, co jest problematyczne przy adaptacji modeli ogólnych do wyspecjalizowanych zadań — odpowiedni dobór tempa uczenia i techniki takie jak destylacja wiedzy pomagają utrzymać wiedzę bazową. Jakość danych i etykietowanie to poważne wyzwanie praktyczne — dostrajanie wymaga wysokiej jakości, poprawnie oznaczonych przykładów dobrze reprezentujących docelową domenę i przypadki użycia. Zarządzanie zasobami obliczeniowymi wymaga równoważenia zysków wydajności z czasem treningu i kosztami infrastruktury, co jest szczególnie ważne przy dużych modelach. Wrażliwość na hiperparametry sprawia, że wydajność dostrajania może się znacznie różnić w zależności od tempa uczenia, batcha i innych ustawień — wymaga to systematycznych eksperymentów i walidacji.

Najlepsze praktyki skutecznego dostrajania:

Organizacje często stoją przed wyborem jednej z trzech komplementarnych metod adaptacji modeli AI do konkretnych zadań: dostrajania, Retrieval-Augmented Generation (RAG) oraz prompt engineering. Prompt engineering polega na starannym formułowaniu instrukcji i przykładów, by sterować zachowaniem modelu bez ingerowania w jego parametry; podejście to jest szybkie i nie wymaga treningu, ale ma ograniczoną skuteczność w złożonych zadaniach i nie pozwala nauczyć modelu całkiem nowych informacji. RAG poszerza odpowiedzi modelu o wyszukiwanie odpowiednich dokumentów lub danych z zewnętrznych źródeł przed generowaniem odpowiedzi — pozwala to na dostęp do aktualnej wiedzy i informacji branżowej bez aktualizacji parametrów; świetnie sprawdza się w zadaniach wymagających aktualnej wiedzy, choć zwiększa opóźnienia i złożoność wnioskowania. Dostrajanie zmienia parametry modelu, głęboko osadzając wiedzę i wzorce specyficzne dla zadania — daje najlepsze efekty w dobrze zdefiniowanych zadaniach i przy wystarczającej liczbie danych, ale wymaga więcej czasu i zasobów niż pozostałe podejścia. Optymalne rozwiązanie często polega na łączeniu tych technik: prompt engineering do szybkiego prototypowania, RAG do aplikacji wymagających aktualnej wiedzy oraz dostrajania do systemów krytycznych, gdzie inwestycja w trening się opłaca. Dostrajanie jest najlepsze, gdy potrzebujesz spójnego, wysokiej jakości działania w konkretnych zadaniach, masz odpowiednie dane i gdy zyski z wydajności uzasadniają nakład pracy. RAG najlepiej sprawdza się tam, gdzie potrzebny jest dostęp do aktualnych lub zastrzeżonych informacji, które często się zmieniają. Prompt engineering to świetny punkt startowy do eksploracji i prototypowania przed podjęciem decyzji o bardziej zasobożernych metodach. Zrozumienie mocnych i słabych stron każdej metody pozwala organizacjom podejmować świadome decyzje o wyborze techniki dla różnych komponentów systemu AI.

Transfer learning to szersza koncepcja wykorzystania wiedzy z jednego zadania do poprawy wyników w innym, natomiast dostrajanie to konkretna implementacja transfer learningu. Dostrajanie polega na wzięciu wstępnie wytrenowanego modelu i dostosowaniu jego parametrów do nowych danych, podczas gdy transfer learning może obejmować także ekstrakcję cech, gdzie zamraża się wstępnie wytrenowane wagi i trenuje tylko nowe warstwy. Każde dostrajanie to transfer learning, ale nie każdy transfer learning wymaga dostrajania.

Czas dostrajania zależy znacząco od wielkości modelu, zbioru danych i dostępnego sprzętu. Przy użyciu efektywnych technik, takich jak LoRA, model z 13 miliardami parametrów można dostroić w około 5 godzin na jednej karcie A100 GPU. Mniejsze modele lub metody efektywne parametrowo mogą wymagać jedynie kilku godzin, podczas gdy pełne dostrajanie większych modeli może trwać dni lub tygodnie. Kluczową zaletą jest to, że dostrajanie jest znacznie szybsze niż trening od podstaw, który może trwać miesiącami.

Tak, dostrajanie zostało zaprojektowane specjalnie z myślą o efektywnej pracy z ograniczoną ilością danych. Wstępnie wytrenowane modele już nauczyły się ogólnych wzorców, więc zazwyczaj potrzeba tylko setek do kilku tysięcy przykładów, aby skutecznie dostroić model – zamiast milionów wymaganych przy trenowaniu od zera. Jednak jakość danych jest ważniejsza od ilości — mniejszy zbiór wysokiej jakości, reprezentatywnych przykładów przewyższy większy, ale niespójny czy zaszumiony zbiór danych.

LoRA (Low-Rank Adaptation) to efektywna parametrowo technika dostrajania, która dodaje trenowalne macierze niskiego rzędu do macierzy wag modelu zamiast aktualizacji wszystkich parametrów. Takie podejście zmniejsza liczbę trenowanych parametrów nawet tysiące razy, zachowując porównywalną wydajność do pełnego dostrajania. LoRA jest ważna, ponieważ umożliwia dostrajanie na standardowym sprzęcie, znacząco obniża wymagania pamięciowe i pozwala organizacjom dostrajać duże modele bez kosztownej infrastruktury.

Przeuczenie występuje, gdy strata treningowa maleje, ale strata walidacyjna rośnie, co oznacza, że model zapamiętuje dane treningowe zamiast uczyć się ogólnych wzorców. Monitoruj oba wskaźniki podczas treningu – jeśli wydajność na walidacji plateauje lub się pogarsza, podczas gdy wyniki treningowe się poprawiają, Twój model najprawdopodobniej się przeucza. Zastosuj wczesne zatrzymanie (early stopping), aby przerwać trening, gdy wydajność na walidacji przestaje się poprawiać oraz używaj technik takich jak regularyzacja czy augmentacja danych, aby temu zapobiec.

Koszty dostrajania obejmują zasoby obliczeniowe (czas GPU/TPU), przygotowanie i oznaczanie danych, infrastrukturę przechowywania i wdrażania modelu oraz bieżący monitoring i utrzymanie. Jednak te koszty są zazwyczaj 10-100 razy niższe niż trenowanie modeli od podstaw. Zastosowanie efektywnych parametrowo technik, takich jak LoRA, może zmniejszyć koszty obliczeniowe o 80-90% w porównaniu do pełnego dostrajania, czyniąc to podejście ekonomicznym dla większości organizacji.

Tak, dostrajanie zazwyczaj znacząco poprawia dokładność modelu w określonych zadaniach. Trenując na danych dziedzinowych, modele uczą się wzorców i terminologii istotnych dla zadania, których modele ogólne nie wychwytują. Badania pokazują, że dostrajanie może poprawić dokładność o 10-30% lub więcej w zależności od zadania i jakości zbioru danych. Poprawa jest największa, gdy zadanie dostrajania różni się od zadania treningu wstępnego, bo model dopasowuje swoje cechy do Twoich wymagań.

Dostrajanie umożliwia organizacjom przechowywanie wrażliwych danych na własnej infrastrukturze zamiast wysyłania ich do zewnętrznych API. Możesz dostrajać modele lokalnie na danych firmowych lub regulowanych, bez ujawniania ich usługom zewnętrznym, zapewniając zgodność z przepisami o ochronie danych, takimi jak RODO, HIPAA lub wymagania branżowe. To podejście daje korzyści zarówno pod względem bezpieczeństwa, jak i zgodności, zachowując jednocześnie wysoką wydajność wynikającą z użycia wstępnie wytrenowanych modeli.

Śledź, jak systemy AI takie jak GPT, Perplexity i Google AI Overviews cytują i wspominają Twoją markę dzięki platformie monitoringu AI AmICited.

Definicja fine-tuningu: dostosowywanie wstępnie wytrenowanych modeli AI do konkretnych zadań poprzez domenowy trening. Dowiedz się, jak fine-tuning poprawia wyd...

Porównaj optymalizację danych treningowych i strategie pobierania w czasie rzeczywistym dla AI. Dowiedz się, kiedy używać fine-tuningu, a kiedy RAG, jakie są ko...

Dowiedz się, jak modele AI przetwarzają tekst przez tokenizację, embeddingi, bloki transformerów i sieci neuronowe. Poznaj cały proces od wejścia do wyjścia....

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.