Jak skonfigurować robots.txt dla botów AI: Kompletny przewodnik

Dowiedz się, jak skonfigurować robots.txt, aby kontrolować dostęp botów AI, w tym GPTBot, ClaudeBot i Perplexity. Zarządzaj widocznością swojej marki w odpowied...

Konfiguracja robots.txt z regułami user-agent ukierunkowanymi specjalnie na roboty AI. AI-specific robots.txt pozwala właścicielom stron kontrolować, w jaki sposób systemy sztucznej inteligencji, duże modele językowe i boty trenujące AI uzyskują dostęp do treści i wykorzystują je. Rozróżnia różne typy robotów AI—boty trenujące, boty wyszukiwawcze i fetchery wywoływane przez użytkownika—umożliwiając szczegółową kontrolę nad widocznością treści dla systemów AI. Ta konfiguracja stała się kluczowa, ponieważ roboty AI stanowią obecnie około 80% ruchu botów na wielu stronach internetowych.

Konfiguracja robots.txt z regułami user-agent ukierunkowanymi specjalnie na roboty AI. AI-specific robots.txt pozwala właścicielom stron kontrolować, w jaki sposób systemy sztucznej inteligencji, duże modele językowe i boty trenujące AI uzyskują dostęp do treści i wykorzystują je. Rozróżnia różne typy robotów AI—boty trenujące, boty wyszukiwawcze i fetchery wywoływane przez użytkownika—umożliwiając szczegółową kontrolę nad widocznością treści dla systemów AI. Ta konfiguracja stała się kluczowa, ponieważ roboty AI stanowią obecnie około 80% ruchu botów na wielu stronach internetowych.

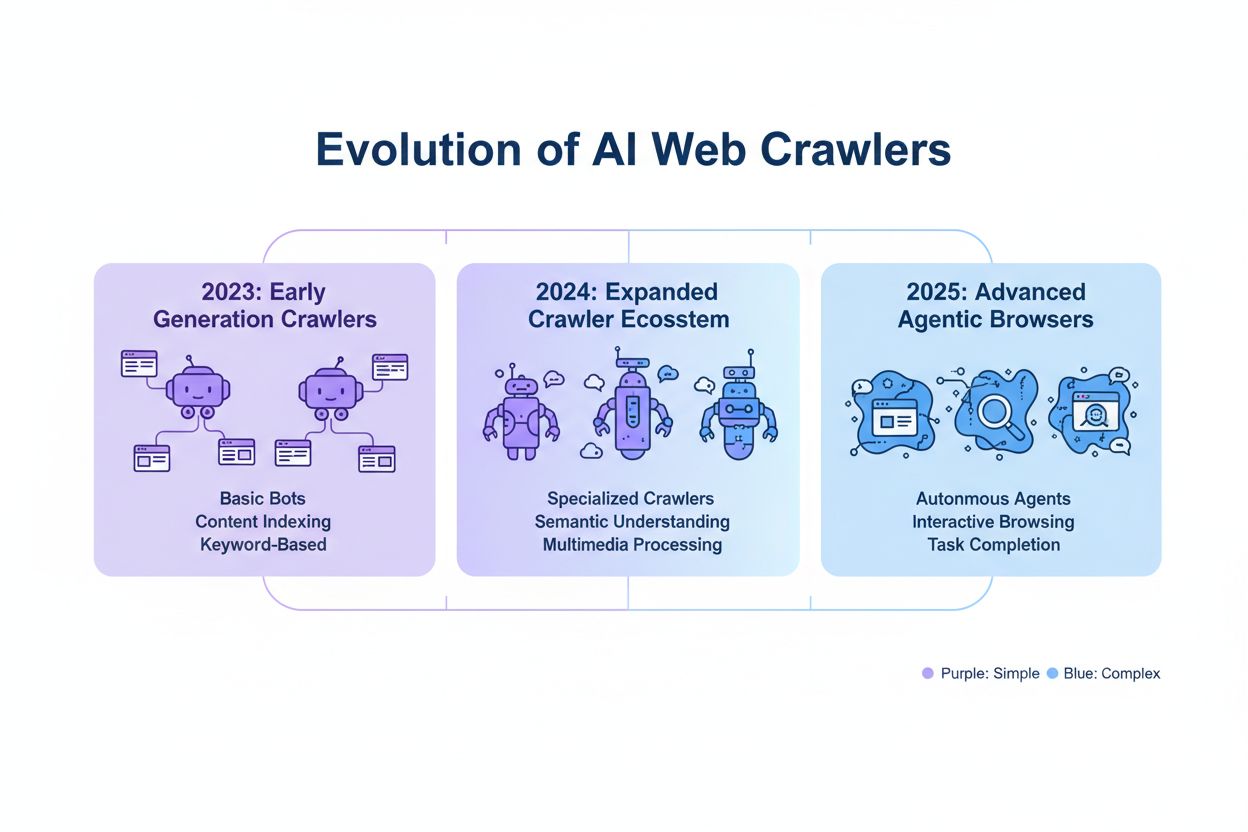

Konfiguracja AI-specific robots.txt odnosi się do praktyki tworzenia ukierunkowanych reguł w pliku robots.txt, które odnoszą się bezpośrednio do robotów sztucznej inteligencji i botów trenujących, odróżniając je od tradycyjnych robotów wyszukiwarek, takich jak Googlebot. Podczas gdy klasyczny robots.txt historycznie skupiał się na zarządzaniu Googlebotem, Bingbotem i innymi indeksującymi wyszukiwarek, pojawienie się dużych modeli językowych i systemów trenujących AI stworzyło zupełnie nową kategorię ruchu botów, która wymaga oddzielnych strategii zarządzania. Według danych z listopada 2025 roku, roboty AI stanowią obecnie około 80% całego ruchu botów na wielu stronach wydawców, co zasadniczo przesuwa znaczenie robots.txt z przydatnego narzędzia SEO na kluczowy mechanizm ochrony treści. To rozróżnienie ma znaczenie, ponieważ boty trenujące AI działają w innym modelu biznesowym niż wyszukiwarki—zbierają dane do trenowania własnych modeli, a nie do generowania ruchu referencyjnego—co sprawia, że tradycyjny kompromis „dopuszczasz boty, by mieć widoczność w wyszukiwarce” przestaje mieć zastosowanie. Dla wydawców oznacza to, że decyzje dotyczące robots.txt bezpośrednio wpływają na widoczność treści dla systemów AI, potencjalne nieautoryzowane użycie własnych treści w zbiorach treningowych oraz ogólne konsekwencje dla ruchu i przychodów wynikające z odkrywania treści przez AI.

Roboty AI dzielą się na trzy wyraźne kategorie operacyjne, z których każda charakteryzuje się innymi cechami, wpływem na ruch oraz strategicznymi konsekwencjami dla wydawców. Boty trenujące służą do zbierania dużych ilości danych tekstowych na potrzeby rozwoju modeli uczenia maszynowego; zwykle wymagają dużej przepustowości, generują znaczne obciążenie serwera i nie przynoszą żadnego ruchu referencyjnego—przykłady to GPTBot OpenAI i ClaudeBot Anthropic. Boty wyszukiwawcze i cytujące działają podobnie do tradycyjnych wyszukiwarek, indeksując treści do wyszukiwania i zapewniając atrybucję; generują umiarkowane natężenie ruchu i mogą kierować ruch referencyjny poprzez cytowania i linki—do tej kategorii należą OAI-SearchBot OpenAI i bot AI Overviews Google. Boty wywoływane przez użytkownika działają na żądanie, gdy końcowy użytkownik wyraźnie prosi AI o analizę strony, np. funkcja przeglądania internetu przez ChatGPT czy analiza dokumentów przez Claude; generują mniejszy ruch, ale reprezentują bezpośrednie zaangażowanie użytkownika w Twoje treści. To rozróżnienie jest kluczowe strategicznie, ponieważ boty trenujące stwarzają największe zagrożenie dla ochrony treści przy minimalnych korzyściach biznesowych, boty wyszukiwawcze oferują kompromis z pewnym potencjałem ruchu, a boty wywoływane przez użytkownika zazwyczaj odpowiadają intencji użytkownika i mogą zwiększać widoczność treści.

| Kategoria robota | Cel | Natężenie ruchu | Potencjał referencyjny | Ryzyko dla treści | Przykłady |

|---|---|---|---|---|---|

| Trenujący | Rozwój modeli | Bardzo wysoki | Brak | Bardzo wysokie | GPTBot, ClaudeBot |

| Wyszukiwawczy/Cytujący | Indeksowanie & atrybucja | Umiarkowane | Umiarkowane | Umiarkowane | OAI-SearchBot, Google AI |

| Wywoływany przez użytkownika | Analiza na żądanie | Niskie | Niskie | Niskie | ChatGPT Web Browse, Claude |

Najwięksi operatorzy botów AI to OpenAI, Anthropic, Google, Meta, Apple i Amazon, każdy z własnymi ciągami user-agent, które umożliwiają ich identyfikację w logach serwera i konfiguracji robots.txt. OpenAI zarządza kilkoma robotami: GPTBot (user-agent: GPTBot/1.0) do zbierania danych treningowych, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) do indeksowania wyszukiwania i cytowania oraz ChatGPT-User (user-agent: ChatGPT-User/1.0) do przeglądania www na żądanie użytkownika. Główny bot Anthropic to ClaudeBot (user-agent: Claude-Web/1.0 lub anthropic-ai) używany do trenowania i rozwoju bazy wiedzy. Google korzysta z Google-Extended (user-agent: Google-Extended/1.1) dla Gemini i innych produktów AI, Meta używa facebookexternalhit do analizy treści, Apple obsługuje AppleBot dla Siri i wyszukiwania, a Amazon korzysta z Amazonbot dla Alexa i funkcji wyszukiwania. Aby zidentyfikować te roboty w logach serwera, sprawdź nagłówek User-Agent w żądaniach HTTP—większość legalnych robotów AI zawiera nazwę firmy i numer wersji w tym polu. Dla zwiększenia bezpieczeństwa można weryfikować legalność bota po adresie IP żądania, porównując go z opublikowanymi zakresami IP danej firmy; OpenAI, Google i inni duzi operatorzy publikują takie zakresy, co umożliwia odróżnienie legalnych botów od podszywających się user-agentów.

Podstawowa składnia reguł AI-specific robots.txt opiera się na standardowym formacie robots.txt z dopasowaniem user-agent i dyrektywami allow/disallow skierowanymi do konkretnych botów. Aby zablokować GPTBot OpenAI przed zbieraniem danych do trenowania, a jednocześnie dopuścić ich bota wyszukiwawczego, skonfiguruj robots.txt w następujący sposób:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

Dla większej szczegółowości możesz stosować reguły dotyczące konkretnych ścieżek, blokując wybrane sekcje, a inne udostępniając—np. blokując botom AI dostęp do treści za paywallem czy sekcji z treściami użytkowników:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Możesz grupować wiele user-agentów pod jedną regułą, by stosować identyczne ograniczenia do kilku robotów i uprościć konfigurację. Testowanie i walidacja robots.txt są kluczowe; narzędzia takie jak tester robots.txt w Google Search Console oraz zewnętrzne walidatory pozwolą sprawdzić, czy reguły są poprawne i będą interpretowane zgodnie z zamysłem. Pamiętaj, że robots.txt jest zaleceniem, nie nakazem—zgodne boty będą przestrzegać reguł, ale złośliwi lub nieprzestrzegający mogą je zignorować, dlatego dla wrażliwych treści potrzebne są dodatkowe zabezpieczenia na poziomie serwera.

Decyzja o blokowaniu lub dopuszczaniu botów AI to podstawowy kompromis między ochroną treści a widocznością, który zależy od modelu biznesowego i strategii treści. Blokowanie botów trenujących, takich jak GPTBot, całkowicie eliminuje ryzyko wykorzystania treści do trenowania modeli AI bez rekompensaty, lecz oznacza też brak obecności treści w odpowiedziach generowanych przez AI, co może ograniczyć odkrywalność i ruch z platform AI. Z kolei dopuszczenie botów trenujących zwiększa prawdopodobieństwo wykorzystania treści w zbiorach treningowych AI, często bez atrybucji czy rekompensaty, ale może poprawić widoczność, jeśli systemy AI zaczną cytować Twoje materiały. Decyzja strategiczna powinna uwzględniać przewagę konkurencyjną treści—autorskie badania, oryginalna analiza i unikalne dane wymagają ostrzejszego blokowania, podczas gdy ogólnodostępne treści edukacyjne lub popularne informacje mogą skorzystać z szerszej widoczności w AI. Różni wydawcy podejmują różne decyzje: organizacje newsowe mogą dopuszczać boty wyszukiwawcze dla ruchu z cytowań, blokując trenujące, wydawcy edukacyjni mogą udostępniać szerzej, a firmy SaaS blokować całość dla ochrony dokumentacji. Monitorowanie skutków blokowania przez logi serwera i analitykę ruchu jest niezbędne do sprawdzenia, czy konfiguracja realizuje założenia biznesowe.

Chociaż robots.txt jasno komunikuje politykę wobec robotów, jest to mechanizm zaleceniowy i niewymagalny prawnie—zgodne boty będą go przestrzegać, ale niezgodne mogą ignorować, wymagając dodatkowych warstw zabezpieczeń technicznych. Weryfikacja IP i allowlisting to najpewniejszy sposób egzekwowania; utrzymując listę legalnych adresów IP publikowanych przez OpenAI, Google, Anthropic i innych dużych operatorów, możesz sprawdzić, czy żądania faktycznie pochodzą z ich infrastruktury. Reguły firewalla i blokowanie na poziomie serwera to najskuteczniejszy mechanizm, pozwalający odrzucać żądania od wybranych user-agentów lub zakresów IP już na poziomie sieci. Dla serwerów Apache, konfiguracja .htaccess może wymusić ograniczenia dla botów:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Meta tagi w sekcji head HTML dają szczegółową kontrolę dostępu do pojedynczych stron bez modyfikacji robots.txt:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Regularne sprawdzanie logów serwera pozwala wykryć nowe boty, zweryfikować przestrzeganie reguł i wychwycić podszywające się user-agenty próbujące obejść ograniczenia. Narzędzia takie jak Knowatoa i Merkle umożliwiają automatyczną walidację i monitoring robots.txt oraz zachowań botów, dając wgląd w to, które roboty odwiedzają Twoją stronę i czy respektują dyrektywy.

Ciągłe utrzymanie konfiguracji AI-specific robots.txt jest kluczowe, ponieważ krajobraz botów AI dynamicznie się zmienia, pojawiają się nowe boty, a istniejące aktualizują user-agenty i schematy działania. Twoja strategia monitoringu powinna obejmować:

Dynamiczny rozwój technologii botów AI oznacza, że konfiguracja robots.txt sprzed pół roku może już nie odpowiadać bieżącym potrzebom lub zagrożeniom, dlatego regularny przegląd i dostosowanie są niezbędne dla skutecznej ochrony treści.

Nowa generacja botów AI stawia przed wydawcami wyzwania, których tradycyjna konfiguracja robots.txt może nie rozwiązać. Agentowe roboty przeglądarkowe, takie jak ChatGPT Atlas i Google Project Mariner, działają jak pełnoprawne przeglądarki, renderując JavaScript, wykonując interakcje użytkownika i zachowując się jak ludzie—często nie identyfikują się unikalnymi user-agentami, przez co blokowanie przez robots.txt jest nieskuteczne. Wiele nowych botów przyjmuje standardowe ciągi user-agent Chrome, by uniknąć wykrycia i blokowania, celowo ukrywając swoją tożsamość i obchodząc reguły robots.txt oraz inne zabezpieczenia. Trend ten wymusza przejście na blokowanie oparte na adresach IP, gdzie wydawcy muszą utrzymywać allowlisty legalnych IP i blokować pozostały ruch z podejrzanych źródeł, zmieniając model egzekwowania z dopasowania user-agent do kontroli dostępu na poziomie sieciowym. Podszywanie się pod user-agentów i techniki obchodzenia stają się coraz powszechniejsze, a źli aktorzy udają legalne boty lub używają ogólnych user-agentów, by uniknąć wykrycia. Przyszłość zarządzania botami AI prawdopodobnie wymagać będzie podejścia wielowarstwowego: konfiguracji robots.txt, weryfikacji IP, reguł firewalla oraz analizy behawioralnej, by odróżnić legalne boty od złośliwych. Pozostawanie na bieżąco z rozwojem technologii botów i udział w dyskusjach branżowych o etyce i standardach robotów jest kluczowe dla skutecznej ochrony treści.

Skuteczna konfiguracja AI-specific robots.txt wymaga całościowego podejścia, które równoważy ochronę treści z celami widoczności. Zacznij od jasnej polityki ochrony treści, określając, które kategorie wymagają blokowania (badania własne, treści premium, treści użytkowników), a które można bezpiecznie udostępnić botom AI (artykuły publiczne, treści edukacyjne, informacje powszechne). Wdrażaj strategię blokowania warstwowego, rozróżniając boty trenujące (zwykle blokuj), wyszukiwawcze (zwykle dopuść z monitoringiem) i wywoływane przez użytkownika (zwykle dopuść), zamiast stosować jednolitą politykę dla wszystkich botów AI. Łącz robots.txt z egzekwowaniem na poziomie serwera, wdrażając reguły firewalla i weryfikację IP dla najwrażliwszych treści, mając świadomość, że robots.txt sam w sobie nie zapewnia silnej ochrony. Włącz zarządzanie botami AI w szerszą strategię SEO i contentową, analizując, jak decyzje blokujące wpływają na widoczność w odpowiedziach AI, cytowaniach i funkcjach wyszukiwawczych AI—dzięki temu robots.txt wspiera, a nie hamuje cele biznesowe. Ustal harmonogram monitoringu i utrzymania: cotygodniowe przeglądy logów, miesięczna weryfikacja IP, kwartalne audyty konfiguracji, by zachować skuteczność w zmieniającym się środowisku botów. Korzystaj z narzędzi takich jak AmICited.com, by monitorować widoczność swoich treści w AI i zrozumieć wpływ decyzji blokujących na odkrywanie i cytowanie przez AI. Dla różnych typów wydawców: organizacje newsowe powinny zwykle dopuszczać boty wyszukiwawcze, blokując trenujące, by maksymalizować ruch z cytowań; wydawcy edukacyjni mogą rozważyć szerszy dostęp dla zwiększenia zasięgu; firmy SaaS powinny stosować ścisłe blokowanie dokumentacji. Gdy blokowanie przez robots.txt jest niewystarczające z powodu podszywających się user-agentów lub nieprzestrzegających botów, zastosuj reguły firewalla i blokowanie IP, by egzekwować politykę ochrony treści na poziomie sieciowym.

Boty trenujące, takie jak GPTBot i ClaudeBot, zbierają dane do rozwoju modeli i nie generują ruchu referencyjnego, co czyni je wysokim ryzykiem dla ochrony treści. Boty wyszukiwawcze, takie jak OAI-SearchBot i PerplexityBot, indeksują treści na potrzeby wyszukiwania AI i mogą kierować ruch referencyjny poprzez cytowania. Większość wydawców blokuje boty trenujące, a dopuszcza wyszukiwawcze, aby zrównoważyć ochronę treści z widocznością.

Google oficjalnie informuje, że blokowanie Google-Extended nie wpływa na pozycje w wyszukiwarce ani na obecność w AI Overviews. Jednak niektórzy webmasterzy zgłaszali obawy, dlatego monitoruj swoje wyniki po wprowadzeniu blokad. AI Overviews w Google Search stosuje standardowe reguły Googlebota, a nie Google-Extended.

Tak, robots.txt jest zaleceniem, a nie wymogiem. Roboty głównych firm zwykle respektują robots.txt, ale niektóre mogą je ignorować. Dla silniejszej ochrony wdrażaj blokowanie na poziomie serwera przez .htaccess lub reguły firewalla i weryfikuj legalność robotów po opublikowanych zakresach adresów IP.

Przeglądaj i aktualizuj listę blokowanych co najmniej raz na kwartał. Nowe roboty AI pojawiają się regularnie, więc sprawdzaj logi serwera co miesiąc, aby wykryć nowe boty odwiedzające witrynę. Śledź społecznościowe źródła, takie jak projekt ai.robots.txt na GitHubie, by być na bieżąco z nowymi robotami i ciągami user-agent.

To zależy od priorytetów firmy. Blokowanie botów trenujących chroni treści przed wykorzystaniem do trenowania modeli AI bez rekompensaty. Blokowanie botów wyszukiwawczych może zmniejszyć widoczność w platformach AI, takich jak wyszukiwanie ChatGPT czy Perplexity. Wielu wydawców decyduje się na selektywne blokowanie: blokują boty trenujące, a dopuszczają wyszukiwawcze i cytujące.

Sprawdzaj logi serwera pod kątem ciągów user-agent i weryfikuj, czy zablokowane boty nie mają dostępu do stron z treścią. Używaj narzędzi analitycznych do monitorowania ruchu botów. Przetestuj konfigurację w Knowatoa AI Search Console lub Merkle robots.txt Tester, by zweryfikować poprawność reguł.

Agentowe roboty przeglądarkowe, takie jak ChatGPT Atlas czy Google Project Mariner, działają jak pełnoprawne przeglądarki internetowe, a nie proste klienty HTTP. Często używają standardowych ciągów user-agent Chrome, przez co są nie do odróżnienia od zwykłego ruchu użytkowników. W takich przypadkach konieczna staje się blokada oparta na adresach IP.

AI-specific robots.txt kontroluje dostęp do Twoich treści, natomiast narzędzia takie jak AmICited monitorują, jak platformy AI cytują i referują Twoje materiały. Razem zapewniają pełną widoczność i kontrolę: robots.txt zarządza dostępem botów, a narzędzia monitorujące śledzą wpływ treści w systemach AI.

AmICited śledzi, jak systemy AI takie jak ChatGPT, Claude, Perplexity i Google AI Overviews cytują i referują Twoją markę. Połącz konfigurację robots.txt z monitoringiem widoczności w AI, aby zrozumieć wpływ Twoich treści na różnych platformach AI.

Dowiedz się, jak skonfigurować robots.txt, aby kontrolować dostęp botów AI, w tym GPTBot, ClaudeBot i Perplexity. Zarządzaj widocznością swojej marki w odpowied...

Dowiedz się, jak zapory Web Application Firewall pozwalają na zaawansowaną kontrolę nad botami AI wychodząc poza robots.txt. Wdrażaj zasady WAF, by chronić swoj...

Dowiedz się, jak blokować lub zezwalać robotom AI, takim jak GPTBot i ClaudeBot, za pomocą robots.txt, blokowania na poziomie serwera oraz zaawansowanych metod ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.