Okno kontekstu

Wyjaśnienie okna kontekstu: maksymalna liczba tokenów, które LLM może przetworzyć jednocześnie. Dowiedz się, jak okna kontekstu wpływają na dokładność AI, haluc...

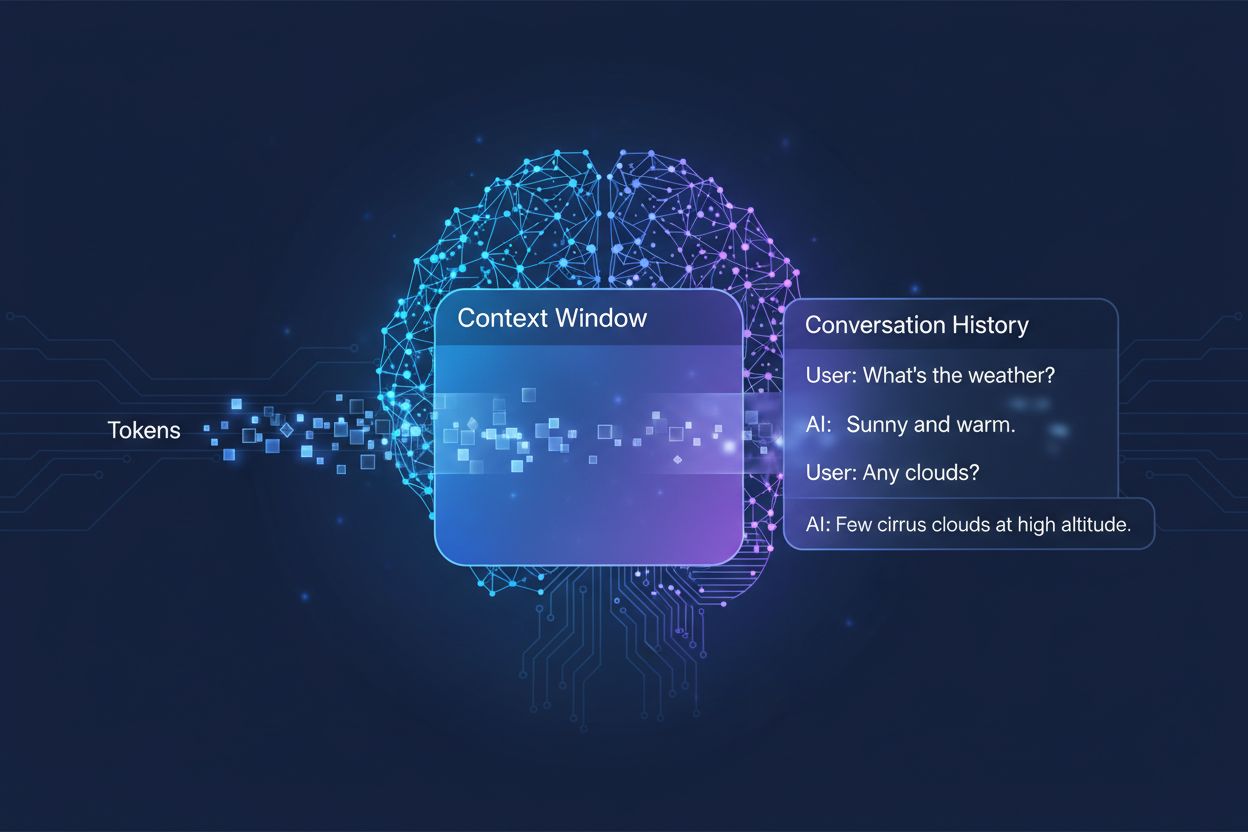

Ilość wcześniejszej rozmowy, którą system AI bierze pod uwagę podczas generowania odpowiedzi, mierzona w tokenach. Określa, ile tekstu AI może przetworzyć jednocześnie i bezpośrednio wpływa na jakość oraz spójność jego odpowiedzi w rozmowach wieloturowych.

Ilość wcześniejszej rozmowy, którą system AI bierze pod uwagę podczas generowania odpowiedzi, mierzona w tokenach. Określa, ile tekstu AI może przetworzyć jednocześnie i bezpośrednio wpływa na jakość oraz spójność jego odpowiedzi w rozmowach wieloturowych.

Okno kontekstu to maksymalna ilość tekstu, jaką model językowy AI może przetworzyć i odnieść się do niej jednocześnie podczas rozmowy lub zadania. Można to porównać do pamięci roboczej człowieka — tak jak ludzie mogą utrzymać w świadomości tylko ograniczoną ilość informacji, tak modele AI mogą „widzieć” tylko określoną ilość tekstu przed i po aktualnej pozycji. Ta pojemność mierzona jest w tokenach, czyli małych jednostkach tekstu, które zazwyczaj odpowiadają słowom lub fragmentom słów (średnio jedno angielskie słowo to około 1,5 tokena). Zrozumienie okna kontekstu Twojego modelu jest kluczowe, ponieważ bezpośrednio określa, ile informacji AI może uwzględnić podczas generowania odpowiedzi, co stanowi fundamentalne ograniczenie w skutecznym radzeniu sobie z rozbudowanymi rozmowami wieloturowymi lub długimi dokumentami.

Nowoczesne modele językowe, szczególnie oparte na architekturze transformer, przetwarzają tekst poprzez konwersję na tokeny i analizę relacji między wszystkimi tokenami w oknie kontekstu jednocześnie. Architektura transformer, zaprezentowana w przełomowej pracy z 2017 roku “Attention is All You Need”, wykorzystuje mechanizm zwany self-attention do ustalania, które części wejścia są dla siebie najistotniejsze. Ten mechanizm uwagi pozwala modelowi ważyć znaczenie poszczególnych tokenów względem siebie, umożliwiając zrozumienie kontekstu i sensu w całym oknie. Jednak ten proces staje się kosztowny obliczeniowo wraz ze wzrostem okna kontekstu, ponieważ mechanizm uwagi musi obliczać relacje między każdym tokenem a każdym innym — to problem skalowania kwadratowego. Poniższa tabela pokazuje, jak różne wiodące modele AI wypadają pod względem możliwości okna kontekstu:

| Model | Okno kontekstu (tokeny) | Data wydania |

|---|---|---|

| GPT-4 | 128 000 | marzec 2023 |

| Claude 3 Opus | 200 000 | marzec 2024 |

| Gemini 1.5 Pro | 1 000 000 | maj 2024 |

| GPT-4 Turbo | 128 000 | listopad 2023 |

| Llama 2 | 4 096 | lipiec 2023 |

Te różnice odzwierciedlają różne decyzje projektowe i kompromisy obliczeniowe podejmowane przez każdą organizację — większe okna umożliwiają bardziej zaawansowane zastosowania, ale wymagają większej mocy obliczeniowej.

Droga do większych okien kontekstu to jeden z najważniejszych postępów w rozwoju AI ostatniej dekady. Wczesne recurrent neural networks (RNNs) i long short-term memory (LSTM) miały problemy z utrzymaniem kontekstu, ponieważ przetwarzały tekst sekwencyjnie i trudno im było zachować informacje z odległych fragmentów wejścia. Przełom nastąpił w 2017 roku wraz z wprowadzeniem architektury Transformer, która umożliwiła równoległe przetwarzanie całych sekwencji i znacznie poprawiła zdolność modelu do utrzymywania kontekstu w dłuższych tekstach. To umożliwiło stworzenie GPT-2 w 2019 roku z oknem kontekstu 1 024 tokenów, następnie GPT-3 w 2020 roku z 2 048 tokenami i ostatecznie GPT-4 w 2023 roku z 128 000 tokenami. Każde z tych osiągnięć miało znaczenie, ponieważ powiększało możliwości modeli: większe okna oznaczały możliwość obsługi dłuższych dokumentów, utrzymania spójności w rozmowach wieloturowych oraz rozumienia powiązań między odległymi pojęciami w tekście. Eksplozja wielkości okien kontekstu odzwierciedla zarówno innowacje architektoniczne, jak i rosnącą moc obliczeniową dostępną w laboratoriach AI.

Większe okna kontekstu fundamentalnie rozszerzają możliwości modeli AI, umożliwiając zastosowania wcześniej niemożliwe lub bardzo ograniczone. Oto kluczowe korzyści:

Lepsza ciągłość rozmowy: Modele mogą utrzymywać świadomość całej historii rozmowy, co ogranicza konieczność ponownego wyjaśniania kontekstu i umożliwia naturalniejsze, spójniejsze dialogi wieloturowe, które sprawiają wrażenie ciągłych, a nie fragmentarycznych.

Przetwarzanie dokumentów na dużą skalę: Większe okna pozwalają AI analizować całe dokumenty, prace naukowe czy bazy kodu w jednym przebiegu, rozpoznając wzorce i powiązania w całej treści bez utraty informacji z wcześniejszych sekcji.

Ulepszone rozumowanie i analiza: Mając dostęp do większego kontekstu, modele mogą wykonywać bardziej zaawansowane zadania wymagające zrozumienia powiązań między wieloma pojęciami, co czyni je skuteczniejszymi w badaniach, analizie i rozwiązywaniu złożonych problemów.

Mniejsze koszty przełączania kontekstu: Użytkownicy nie muszą już wielokrotnie podsumowywać lub wprowadzać informacji; model może odwoływać się do całej historii rozmowy, zwiększając efektywność i wygodę pracy zespołowej.

Lepsza obsługa złożonych zadań: Takie zastosowania jak analiza dokumentów prawnych, przegląd dokumentacji medycznej czy audyt kodu zyskują znacząco na możliwości rozpatrzenia pełnego kontekstu, co prowadzi do dokładniejszych i pełniejszych wyników.

Spójne przepływy pracy z wieloma dokumentami: Profesjonaliści mogą pracować z wieloma powiązanymi dokumentami jednocześnie, pozwalając modelowi na krzyżowe odniesienia i identyfikację powiązań, których nie da się wykryć przy mniejszych oknach kontekstu.

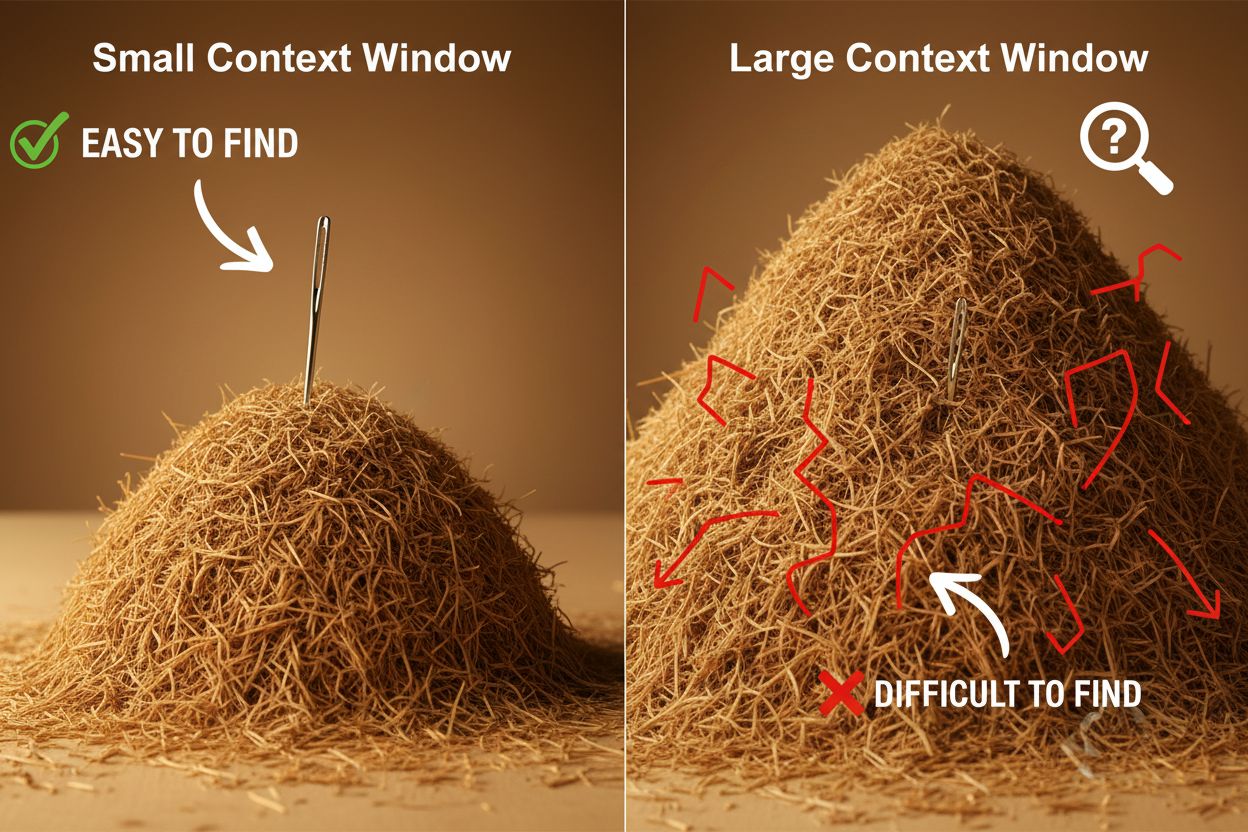

Pomimo zalet, duże okna kontekstu wprowadzają znaczne wyzwania techniczne i praktyczne, z którymi muszą mierzyć się deweloperzy i użytkownicy. Najbardziej oczywistym problemem jest koszt obliczeniowy: przetwarzanie dłuższych sekwencji wymaga wykładniczo więcej pamięci i mocy obliczeniowej ze względu na kwadratowe skalowanie mechanizmu uwagi, przez co większe okna są znacznie droższe w eksploatacji. Zwiększone zapotrzebowanie na zasoby powoduje też opóźnienia, ponieważ dłuższe okna oznaczają wolniejsze odpowiedzi — co jest kluczowe w aplikacjach wymagających natychmiastowej reakcji. Kolejnym subtelnym, ale ważnym problemem jest zjawisko “igły w stogu siana”, gdzie model ma trudności ze znalezieniem i wykorzystaniem właściwych informacji, gdy są one ukryte w ogromnym oknie kontekstu, czasem dając gorsze wyniki niż przy mniejszych oknach. Dodatkowo, pojawia się context rot — informacja z początku długiego okna ma coraz mniejszy wpływ na odpowiedź, ponieważ mechanizm uwagi może depriorytetyzować odległe tokeny na rzecz tych najnowszych. Te wyzwania sprawiają, że samo zwiększanie rozmiaru okna kontekstu nie zawsze jest najlepszym rozwiązaniem dla każdego przypadku użycia.

Zrozumienie context rot jest kluczowe podczas pracy z dużymi oknami kontekstu: wraz ze wzrostem długości sekwencji tokeny z początku kontekstu mają coraz mniejszy wpływ na wynik modelu, co oznacza, że istotne informacje mogą zostać „zapomniane”, mimo że technicznie mieszczą się w oknie. Dzieje się tak, ponieważ attention budget — zdolność modelu do efektywnego skupienia uwagi na wszystkich tokenach — rozciąga się na znacznie dłuższy tekst. Na szczęście pojawiło się kilka zaawansowanych technik radzenia sobie z tymi ograniczeniami. Retrieval-Augmented Generation (RAG) rozwiązuje problem poprzez przechowywanie informacji w zewnętrznych bazach danych i pobieranie tylko najistotniejszych fragmentów w razie potrzeby, co skutecznie powiększa bazę wiedzy modelu bez konieczności ogromnego okna kontekstu. Techniki kompaktowania kontekstu polegają na podsumowywaniu lub kompresowaniu mniej istotnych informacji, zachowując najważniejsze szczegóły przy jednoczesnym ograniczeniu liczby tokenów. Strukturalne notatki zachęcają użytkowników do hierarchicznej organizacji informacji, co ułatwia modelowi priorytetyzację i odnalezienie kluczowych pojęć. Te rozwiązania polegają na strategicznym doborze informacji, które trafiają do okna kontekstu i ich organizacji, zamiast prób zmieszczenia wszystkiego naraz w pamięci.

Rozszerzone okna kontekstu w nowoczesnych modelach AI otworzyły wiele zastosowań praktycznych, wcześniej niemożliwych lub trudnych do zrealizowania. Systemy obsługi klienta mogą teraz analizować całą historię zgłoszeń i powiązaną dokumentację w jednym zapytaniu, udzielając trafniejszych i bardziej kontekstowych odpowiedzi bez potrzeby powtarzania informacji przez klientów. Analiza dokumentów i badania naukowe zostały zrewolucjonizowane dzięki modelom, które mogą przyswoić całą pracę naukową, umowę prawną czy specyfikację techniczną, wyszukując kluczowe informacje i odpowiadając na szczegółowe pytania dotyczące treści, co wcześniej zajmowało ludziom godziny. Przegląd kodu i rozwój oprogramowania korzystają z okien na tyle dużych, by objąć całe pliki lub nawet kilka powiązanych plików, co pozwala AI rozumieć architekturę i proponować bardziej inteligentne sugestie. Tworzenie długich form treści i iteracyjne pisanie są bardziej efektywne, gdy model może utrzymać świadomość tonu, stylu i narracji całego dokumentu przez cały proces edycji. Analiza transkrypcji spotkań i synteza badań wykorzystują duże okna kontekstu do wyciągania wniosków z godzin rozmów lub dziesiątek źródeł, identyfikując tematy i powiązania trudne do wychwycenia ręcznie. Te przykłady pokazują, że rozmiar okna kontekstu przekłada się bezpośrednio na praktyczną wartość dla profesjonalistów z różnych branż.

Kierunek rozwoju okien kontekstu sugeruje, że w najbliższym czasie czekają nas jeszcze bardziej spektakularne wzrosty — Gemini 1.5 Pro już teraz oferuje okno kontekstu o wielkości 1 000 000 tokenów, a laboratoria badawcze testują jeszcze większe pojemności. Poza samym rozmiarem, przyszłość prawdopodobnie przyniesie dynamiczne okna kontekstu, które inteligentnie dostosowują swoją wielkość do zadania, przydzielając więcej miejsca przy bardziej złożonych zapytaniach i ograniczając je przy prostszych — dla zwiększenia efektywności i obniżenia kosztów. Trwają także prace nad wydajniejszymi mechanizmami uwagi, które zmniejszą koszt obliczeniowy dużych okien, potencjalnie przełamując barierę kwadratowego skalowania, która obecnie ogranicza ich rozmiar. Wraz z dojrzewaniem tych technologii można oczekiwać, że okna kontekstu przestaną być wąskim gardłem, a deweloperzy skupią się na innych aspektach możliwości i niezawodności AI. Połączenie większych okien, wyższej wydajności i inteligentniejszego zarządzania kontekstem prawdopodobnie zdefiniuje następną generację aplikacji AI, umożliwiając zastosowania, o których jeszcze nie myśleliśmy.

Okno kontekstu to całkowita ilość tekstu (mierzona w tokenach), którą model AI może przetworzyć jednocześnie, podczas gdy limit tokenów odnosi się do maksymalnej liczby tokenów, które model może obsłużyć. Terminy te są często używane zamiennie, ale okno kontekstu odnosi się konkretnie do pamięci roboczej dostępnej podczas jednego wnioskowania, podczas gdy limit tokenów może również dotyczyć ograniczeń wyjściowych lub limitów korzystania z API.

Większe okna kontekstu zazwyczaj poprawiają jakość odpowiedzi, pozwalając modelowi uwzględnić więcej istotnych informacji i lepiej utrzymać ciągłość rozmowy. Jednak bardzo duże okna mogą czasem pogarszać jakość z powodu zjawiska context rot, gdzie model ma trudności z priorytetyzacją ważnych informacji wśród ogromnej ilości tekstu. Optymalny rozmiar okna kontekstu zależy od konkretnego zadania i sposobu organizacji informacji.

Większe okna kontekstu wymagają większej mocy obliczeniowej ze względu na kwadratową skalowalność mechanizmu uwagi w modelach transformerowych. Mechanizm uwagi musi obliczyć relacje między każdym tokenem a każdym innym tokenem, więc podwojenie okna kontekstu oznacza w przybliżeniu czterokrotny wzrost wymagań obliczeniowych. Dlatego większe okna kontekstu są droższe w użytkowaniu i generują wolniejsze odpowiedzi.

Problem 'igły w stogu siana' pojawia się, gdy model AI ma trudności ze znalezieniem i wykorzystaniem istotnych informacji (czyli 'igły'), gdy są one ukryte w bardzo dużym oknie kontekstu ('stogu siana'). Modele czasem radzą sobie gorzej przy ogromnych oknach kontekstu, ponieważ mechanizm uwagi rozprasza się na zbyt dużej ilości informacji, przez co trudniej zidentyfikować to, co naprawdę ważne.

Aby zmaksymalizować skuteczność okna kontekstu, organizuj informacje jasno i hierarchicznie, umieszczaj najważniejsze informacje na początku lub na końcu kontekstu, korzystaj ze struktur takich jak JSON lub markdown oraz rozważ użycie Retrieval-Augmented Generation (RAG), aby dynamicznie ładować tylko najbardziej istotne dane. Unikaj przeciążania modelu nieistotnymi szczegółami, które zużywają tokeny bez dodawania wartości.

Okno kontekstu to techniczna zdolność modelu do przetwarzania tekstu w jednym czasie, natomiast historia rozmowy to faktyczny zapis poprzednich wiadomości w rozmowie. Historia rozmowy musi zmieścić się w oknie kontekstu, ale okno kontekstu obejmuje też miejsce na prompt systemowy, instrukcje i inne metadane. Historia rozmowy może być dłuższa niż okno kontekstu, co wymaga jej skracania lub podsumowywania.

Obecnie żaden model AI nie posiada naprawdę nieograniczonego okna kontekstu, ponieważ wszystkie mają ograniczenia architektoniczne i obliczeniowe. Jednak niektóre modele, takie jak Gemini 1.5 Pro, oferują bardzo duże okna (1 000 000 tokenów), a techniki takie jak Retrieval-Augmented Generation (RAG) skutecznie rozszerzają bazę wiedzy modelu poza jego okno kontekstu dzięki dynamicznemu pobieraniu informacji w razie potrzeby.

Rozmiar okna kontekstu bezpośrednio wpływa na koszty API, ponieważ większe okna wymagają więcej zasobów obliczeniowych. Większość dostawców API AI pobiera opłaty na podstawie użycia tokenów, więc korzystanie z większego okna kontekstu oznacza więcej przetworzonych tokenów i wyższe koszty. Niektórzy dostawcy oferują też modele z większymi oknami kontekstu w wyższych cenach, dlatego warto dobrać rozmiar modelu do własnych potrzeb.

AmICited śledzi, jak systemy AI takie jak ChatGPT, Perplexity i Google AI Overviews cytują i odnoszą się do Twoich treści. Poznaj swoją widoczność w AI i monitoruj wzmianki o marce na platformach AI.

Wyjaśnienie okna kontekstu: maksymalna liczba tokenów, które LLM może przetworzyć jednocześnie. Dowiedz się, jak okna kontekstu wpływają na dokładność AI, haluc...

Dyskusja społeczności na temat okien kontekstu w AI i ich znaczenia dla marketingu treści. Zrozumienie, jak limity kontekstu wpływają na przetwarzanie Twojej tr...

Dowiedz się, czym są okna kontekstowe w modelach językowych AI, jak działają, jaki mają wpływ na wydajność modeli oraz dlaczego są ważne dla aplikacji opartych ...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.