Widoczność AI w usługach finansowych: Zgodność i optymalizacja

Monitoruj, jak Twoja marka finansowa pojawia się w odpowiedziach generowanych przez AI. Poznaj wymagania dotyczące zgodności, strategie widoczności oraz technik...

Wymogi regulacyjne dla instytucji finansowych dotyczące transparentnego ujawniania wykorzystania sztucznej inteligencji w procesach decyzyjnych, zarządzaniu ryzykiem oraz aplikacjach skierowanych do klientów. Obejmuje oczekiwania regulacyjne SEC, CFPB, FINRA i innych organów w zakresie dokumentowania zarządzania AI, wydajności modeli i wpływu na konsumentów oraz rynki.

Wymogi regulacyjne dla instytucji finansowych dotyczące transparentnego ujawniania wykorzystania sztucznej inteligencji w procesach decyzyjnych, zarządzaniu ryzykiem oraz aplikacjach skierowanych do klientów. Obejmuje oczekiwania regulacyjne SEC, CFPB, FINRA i innych organów w zakresie dokumentowania zarządzania AI, wydajności modeli i wpływu na konsumentów oraz rynki.

Finansowe ujawnianie AI odnosi się do wymogów regulacyjnych i najlepszych praktyk dla instytucji finansowych dotyczących transparentnego ujawniania wykorzystania sztucznej inteligencji w procesach decyzyjnych, zarządzaniu ryzykiem oraz aplikacjach skierowanych do klientów. Obejmuje oczekiwania regulacyjne SEC, CFPB, FINRA i innych organów w zakresie dokumentowania zarządzania AI, wydajności modeli oraz potencjalnego wpływu na konsumentów i rynki. W grudniu 2024 roku Komitet Doradczy Inwestorów SEC (IAC) przedstawił formalną rekomendację, aby agencja wydała wytyczne wymagające od emitentów ujawniania informacji o wpływie sztucznej inteligencji na ich działalność. IAC wskazał na “brak spójności” we współczesnych ujawnieniach dotyczących AI, co “może być problematyczne dla inwestorów poszukujących jasnych i porównywalnych informacji”. Tylko 40% spółek z indeksu S&P 500 podaje informacje związane z AI, a jedynie 15% ujawnia informacje o nadzorze zarządu nad AI, mimo że 60% tych firm uznaje AI za istotne ryzyko.

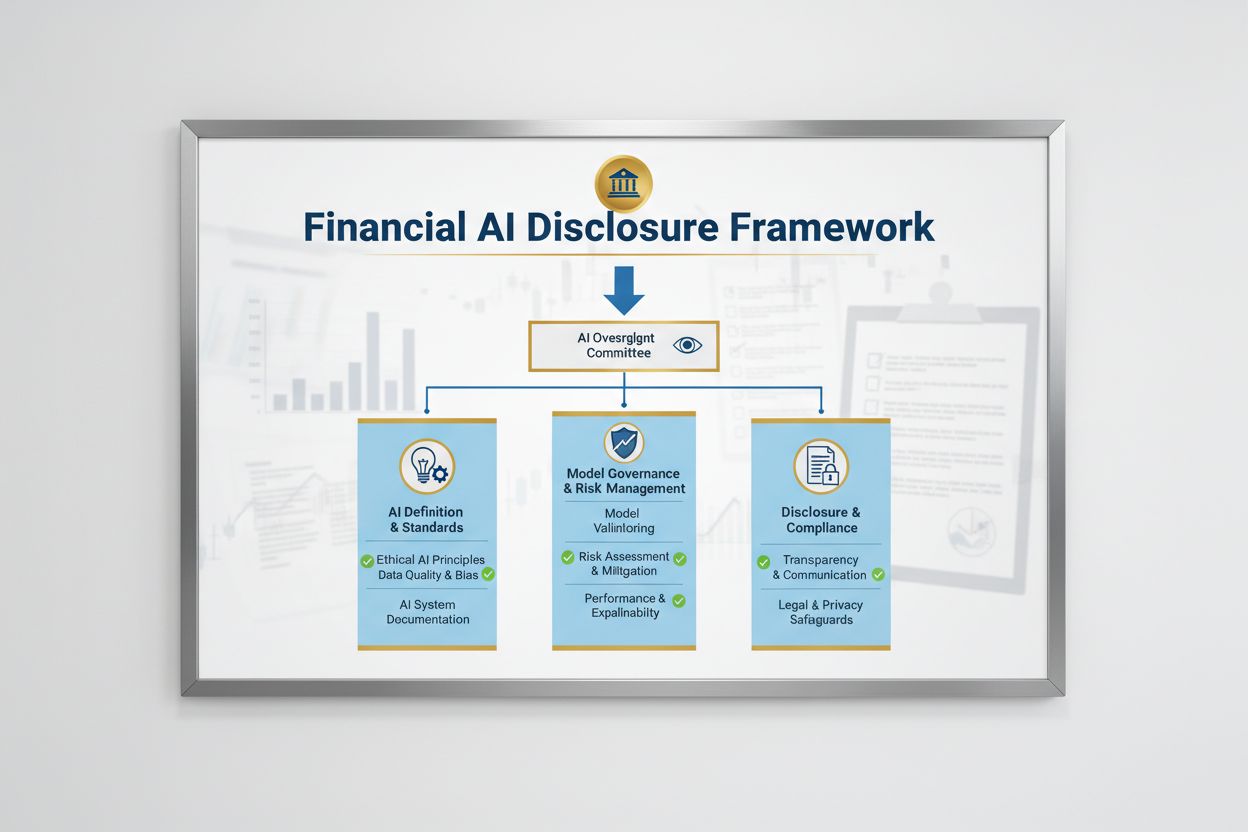

Krajobraz regulacyjny Finansowego ujawniania AI kształtowany jest przez wiele agencji federalnych stosujących istniejące neutralne technologicznie przepisy do systemów AI. Komitet Doradczy Inwestorów SEC zaproponował początkowe ramy oparte na trzech filarach: (1) wymaganie od emitentów zdefiniowania, co rozumieją przez “sztuczną inteligencję”, (2) ujawnienie mechanizmów nadzoru zarządu nad wdrożeniami AI oraz (3) raportowanie o istotnych wdrożeniach AI i ich wpływie na operacje wewnętrzne oraz produkty skierowane do klientów. Poza SEC, CFPB, FINRA, OCC i Rezerwa Federalna wydały wytyczne podkreślające, że obowiązujące przepisy o ochronie konsumentów – w tym równości kredytowej, prywatności danych i przeciwdziałania oszustwom – mają zastosowanie do systemów AI niezależnie od wykorzystanej technologii. Organy te stosują podejście neutralne technologicznie, co oznacza, że obowiązki wynikające z Equal Credit Opportunity Act (ECOA), Fair Credit Reporting Act (FCRA), Gramm-Leach-Bliley Act (GLBA) oraz standardów UDAAP (Unfair or Deceptive Acts or Practices) pozostają niezmienne, gdy wykorzystywane jest AI.

| Regulator | Obszar działania | Kluczowy wymóg |

|---|---|---|

| SEC | Ujawnienia dla inwestorów, konflikty interesów | Definiowanie AI, ujawnienie nadzoru zarządu, raportowanie istotnych wdrożeń |

| CFPB | Równość kredytowa, ochrona konsumentów | Zapewnienie zgodności modeli AI z ECOA, przekazywanie powiadomień o odmowie |

| FINRA | Działalność brokerów, komunikacja z klientami | Opracowanie polityk zarządzania AI, nadzór nad wykorzystaniem AI w całej działalności |

| OCC/Rezerwa Federalna/FDIC | Zarządzanie modelami bankowymi, ryzyko operacyjne | Walidacja modeli AI, dokumentacja kontroli, ocena wiarygodności |

| FTC | Praktyki wprowadzające w błąd, zarządzanie danymi | Monitorowanie twierdzeń dotyczących AI, zapobieganie nieuczciwemu wykorzystywaniu danych |

Skuteczne Finansowe ujawnianie AI wymaga jasnego nadzoru zarządu nad wdrożeniem sztucznej inteligencji i zarządzaniem ryzykiem. Rekomendacja IAC SEC podkreśla, że inwestorzy mają uzasadniony interes w wiedzy, czy istnieją wyraźne linie odpowiedzialności dotyczące wdrażania technologii AI w operacjach wewnętrznych i produktach firmy. Instytucje finansowe muszą ustanowić struktury zarządzania przypisujące odpowiedzialność za nadzór nad AI Radzie Dyrektorów lub wyznaczonemu komitetowi, zapewniając, że ryzyka związane z AI są zarządzane na najwyższym szczeblu organizacji. Ramy zarządzania powinny obejmować udokumentowane polityki i procedury dotyczące rozwoju, testowania, walidacji i wdrożenia AI oraz regularne raportowanie do zarządu o wydajności modeli, zidentyfikowanych ryzykach i działaniach naprawczych. Brak wyraźnej odpowiedzialności zarządu naraża instytucje finansowe na kontrolę regulacyjną i potencjalne działania egzekucyjne za niewystarczający nadzór nad istotnymi systemami AI.

Instytucje finansowe muszą osobno ujawniać istotne skutki wdrożeń AI na operacje wewnętrzne i produkty skierowane do klientów. W przypadku operacji wewnętrznych ujawnienia powinny dotyczyć wpływu AI na kapitał ludzki (takiego jak redukcje zatrudnienia lub konieczność dokształcania), rzetelność sprawozdawczości finansowej, procesy zarządzania oraz ryzyka cyberbezpieczeństwa. W odniesieniu do produktów skierowanych do klientów instytucje powinny ujawniać inwestycje w platformy oparte na AI, integrację AI w produktach i usługach, wpływ regulacyjny wynikający z wykorzystania AI oraz sposób, w jaki AI wpływa na strategie cenowe lub biznesowe. SEC zaleca włączenie tych ujawnień do istniejących pozycji ujawnieniowych Regulation S-K (takich jak Items 101, 103, 106 i 303) na podstawie istotności, zamiast tworzenia całkowicie nowych kategorii ujawnień. Takie podejście pozwala instytucjom finansowym wykorzystać istniejące ramy ujawnień przy jednoczesnym zapewnieniu inwestorom jasnych, porównywalnych informacji o roli AI w działalności i strategii organizacji.

Wysoka jakość danych jest podstawą odpowiedzialnego wdrażania AI w usługach finansowych, jednak wiele instytucji ma trudności z wdrożeniem ram zarządzania danymi spełniających oczekiwania regulatorów. Instytucje finansowe muszą zadbać, by dane wykorzystywane do trenowania, testowania i walidacji modeli AI były czyste, kompletne, wystandaryzowane i wyczerpujące, z jasną dokumentacją źródeł, pochodzenia oraz wszelkich znanych ograniczeń. Zabezpieczenia danych muszą zapobiegać “zatruwaniu danych” – manipulacji danymi treningowymi w celu naruszenia integralności modeli – oraz chronić przed nieautoryzowanym dostępem lub ujawnieniem poufnych informacji. Gramm-Leach-Bliley Act (GLBA) zapewnia podstawową ochronę danych finansowych konsumentów, jednak wielu regulatorów i rzeczników konsumentów uważa, że te zabezpieczenia są niewystarczające w kontekście AI, zwłaszcza biorąc pod uwagę rosnący zakres zbierania i wykorzystywania danych do trenowania modeli. Instytucje finansowe muszą także rozwiązywać kwestie własności intelektualnej, zapewniając sobie odpowiednie uprawnienia do wykorzystywania danych do rozwoju AI i respektując prawa własności intelektualnej stron trzecich. Wdrażanie solidnych ram zarządzania danymi, obejmujących zasadę minimalizacji danych, kontrolę dostępu i regularne audyty, jest kluczowe do wykazania zgodności z oczekiwaniami regulatorów.

Organy regulacyjne jasno stwierdzają, że modele AI wykorzystywane w decyzjach finansowych muszą być testowane pod kątem uprzedzeń i potencjalnych skutków dyskryminacyjnych, niezależnie od ich ogólnej dokładności czy wydajności. Problem “czarnej skrzynki” – gdy złożone systemy AI generują wyniki trudne lub niemożliwe do wyjaśnienia – tworzy znaczne ryzyko niezgodności, zwłaszcza w zastosowaniach konsumenckich, takich jak udzielanie kredytów, ustalanie cen czy wykrywanie oszustw. Instytucje finansowe muszą wdrożyć procesy wykrywania i ograniczania uprzedzeń na każdym etapie cyklu życia modelu, w tym testy uprzedzeń podczas rozwoju, walidacji i ciągłego monitoringu. Zgodność z zasadami równości kredytowej wymaga, by instytucje mogły wyjaśnić konkretne powody decyzji negatywnych (takich jak odmowa kredytu) i wykazać, że ich modele AI nie mają negatywnego wpływu na chronione grupy społeczne. Testowanie “mniej dyskryminujących alternatyw” – metod osiągających te same cele biznesowe przy jednoczesnym zmniejszeniu uprzedzeń – jest coraz częściej oczekiwane przez regulatorów. Wiele instytucji wdraża techniki wyjaśnialnej AI (xAI), takie jak analiza ważności cech czy drzewa decyzyjne, by zwiększyć transparentność i odpowiedzialność decyzji opartych na AI.

Instytucje finansowe wykorzystujące AI w aplikacjach skierowanych do klientów muszą przestrzegać obowiązujących przepisów o ochronie konsumentów, w tym wymogów dotyczących powiadomień o odmowie, ujawniania informacji o prywatności danych i sprawiedliwego traktowania. Gdy system AI jest wykorzystywany do podejmowania lub istotnego wpływania na decyzje dotyczące kredytu, ubezpieczenia czy innych produktów finansowych, konsument ma prawo wiedzieć, dlaczego otrzymał odmowę lub mniej korzystne warunki. CFPB podkreśla, że kredytodawcy zobowiązani do przestrzegania Equal Credit Opportunity Act (ECOA) nie mogą korzystać z modeli typu “czarna skrzynka”, jeśli nie są w stanie podać konkretnych i dokładnych powodów decyzji negatywnych. Ponadto standard UDAAP (Unfair or Deceptive Acts or Practices) dotyczy systemów opartych na AI, które mogą szkodzić konsumentom przez nieprzejrzyste gromadzenie danych, naruszenia prywatności lub kierowanie na nieodpowiednie produkty. Instytucje finansowe muszą zapewnić, że systemy AI wykorzystywane w obsłudze klienta, rekomendacjach produktów i zarządzaniu kontem są transparentne co do wykorzystania AI i jasno informują, jak dane konsumenta są zbierane, wykorzystywane i chronione.

Większość instytucji finansowych opiera się na zewnętrznych dostawcach przy opracowywaniu, wdrażaniu lub utrzymaniu systemów AI, co rodzi znaczące obowiązki w zakresie zarządzania ryzykiem stron trzecich (TPRM). Międzyagencyjne wytyczne federalnych organów bankowych dotyczące relacji ze stronami trzecimi podkreślają, że instytucje finansowe pozostają odpowiedzialne za skuteczność i zgodność systemów AI stron trzecich, nawet jeśli nie są twórcą modelu. Skuteczne TPRM dla AI wymaga solidnego due diligence przed podjęciem współpracy z dostawcą, w tym oceny praktyk zarządzania danymi, procesów walidacji modeli i zdolności do zapewnienia transparentności działania modeli. Instytucje muszą również monitorować ryzyko koncentracji – potencjalny systemowy wpływ zakłóceń lub awarii u niewielkiej liczby dostawców AI. Należy oceniać i dokumentować ryzyka związane z łańcuchem dostaw, w tym wiarygodność źródeł danych i stabilność infrastruktury stron trzecich. Umowy z dostawcami AI powinny zawierać jasne wymogi dotyczące bezpieczeństwa danych, monitorowania wydajności modeli, raportowania incydentów oraz możliwości audytu lub testowania systemu AI. Szczególnie mniejsze instytucje finansowe mogą mieć trudność z oceną zaawansowanych systemów AI, co rodzi potrzebę standaryzacji branżowej lub programów certyfikacyjnych ułatwiających ocenę dostawców.

Instytucje finansowe działające transgranicznie stają wobec coraz bardziej złożonej mozaiki regulacji AI, z europejskim AI Act jako najpełniejszym dotychczas ramowym aktem prawnym. AI Act UE klasyfikuje systemy AI wykorzystywane do oceny zdolności kredytowej, wykrywania oszustw i przeciwdziałania praniu pieniędzy jako “wysokiego ryzyka”, wymagając szerokiej dokumentacji, testowania pod kątem uprzedzeń, nadzoru człowieka i ocen zgodności. OECD i G7 również wydały zasady i zalecenia dotyczące odpowiedzialnego zarządzania AI w usługach finansowych, kładąc nacisk na transparentność, sprawiedliwość, odpowiedzialność i nadzór człowieka. Wiele z tych standardów ma zasięg eksterytorialny, co oznacza, że instytucje finansowe obsługujące klientów w UE, Wielkiej Brytanii lub innych regulowanych jurysdykcjach mogą być zobowiązane do przestrzegania tych norm, nawet jeśli ich siedziba znajduje się gdzie indziej. Prace nad harmonizacją regulacji trwają, ale między poszczególnymi jurysdykcjami nadal istnieją istotne różnice, co stanowi wyzwanie dla globalnych instytucji finansowych. Proaktywne dostosowanie się do najwyższych standardów międzynarodowych – takich jak AI Act UE i zasady OECD – może pomóc w przygotowaniu się na przyszłe zmiany regulacyjne i ograniczyć ryzyko działań egzekucyjnych w wielu jurysdykcjach.

Instytucje finansowe powinny wdrożyć kompleksową dokumentację i praktyki zarządzania, aby wykazać zgodność z wymogami Finansowego ujawniania AI. Do kluczowych najlepszych praktyk należą:

Stosując te praktyki, instytucje finansowe mogą zredukować ryzyko regulacyjne, budować zaufanie interesariuszy i pozycjonować się jako liderzy odpowiedzialnego wdrażania AI w branży usług finansowych.

Finansowe ujawnianie AI odnosi się do wymogów regulacyjnych dla instytucji finansowych dotyczących transparentnego ujawniania wykorzystania sztucznej inteligencji w procesach decyzyjnych, zarządzaniu ryzykiem oraz aplikacjach skierowanych do klientów. Obejmuje oczekiwania regulacyjne SEC, CFPB, FINRA i innych organów w zakresie dokumentowania zarządzania AI, wydajności modeli i wpływu na konsumentów oraz rynki. Komitet Doradczy Inwestorów SEC zalecił w grudniu 2024 roku, aby instytucje finansowe definiowały wykorzystanie AI, ujawniały mechanizmy nadzoru zarządu i raportowały wdrożenia AI mające istotny wpływ.

Instytucje finansowe muszą ujawniać wykorzystanie AI, aby chronić inwestorów, konsumentów i integralność rynku. Organy regulacyjne stwierdziły, że jedynie 40% spółek z indeksu S&P 500 podaje informacje dotyczące AI, co prowadzi do niespójności i braków informacyjnych dla inwestorów. Wymogi ujawniania zapewniają interesariuszom zrozumienie, jak AI wpływa na decyzje finansowe, zarządzanie ryzykiem oraz wyniki konsumentów. Ponadto, obowiązujące przepisy dotyczące ochrony konsumentów – w tym równości kredytowej i prywatności danych – mają zastosowanie do systemów AI, przez co ujawnianie jest kluczowe dla zgodności regulacyjnej.

Komitet Doradczy Inwestorów SEC zalecił trzy kluczowe filary ujawniania AI: (1) wymaganie od emitentów zdefiniowania, co rozumieją przez 'sztuczną inteligencję', (2) ujawnianie mechanizmów nadzoru zarządu nad wdrożeniami AI oraz (3) raportowanie wdrożeń AI mających istotny wpływ i ich efektów na operacje wewnętrzne oraz produkty skierowane do klientów. Zalecenia te mają dostarczyć inwestorom jasnych, porównywalnych informacji o wpływie AI na działalność i strategię instytucji finansowej.

Finansowe ujawnianie AI koncentruje się konkretnie na wymogach regulacyjnych dotyczących transparentnej komunikacji o wykorzystaniu AI do zewnętrznych interesariuszy (inwestorów, regulatorów, konsumentów), podczas gdy ogólne zarządzanie AI odnosi się do wewnętrznych procesów i kontroli zarządzania systemami AI. Ujawnianie to zewnętrzny komponent zarządzania AI, zapewniający dostęp do istotnych informacji o wdrożeniach, ryzykach i wpływie AI. Oba aspekty są kluczowe dla odpowiedzialnego wdrażania AI w usługach finansowych.

Ujawnienia dotyczące wdrożeń AI powinny obejmować zarówno operacje wewnętrzne, jak i wpływ na klientów. W przypadku operacji wewnętrznych instytucje powinny ujawniać wpływ na kapitał ludzki, sprawozdawczość finansową, zarządzanie i ryzyko cyberbezpieczeństwa. W odniesieniu do produktów skierowanych do klientów ujawnienia powinny dotyczyć inwestycji w platformy oparte na AI, integracji AI w produktach, wpływu regulacyjnego oraz sposobu, w jaki AI wpływa na wyceny lub strategie biznesowe. Ujawnienia powinny być włączone do istniejących pozycji ujawnieniowych regulacyjnych (takich jak SEC Regulation S-K) na podstawie istotności.

Prawa równości kredytowej, w tym Equal Credit Opportunity Act (ECOA) oraz Fair Credit Reporting Act (FCRA), mają zastosowanie do systemów AI wykorzystywanych w decyzjach kredytowych niezależnie od zastosowanej technologii. Instytucje finansowe muszą być w stanie wyjaśnić konkretne powody odmowy (np. odrzucenia wniosku kredytowego) i wykazać, że ich modele AI nie mają negatywnego wpływu na chronione grupy. Organy regulacyjne oczekują, że instytucje będą testować modele AI pod kątem uprzedzeń, wdrażać 'mniej dyskryminujące alternatywy', gdy to możliwe, oraz dokumentować testy sprawiedliwości i ich walidację.

Większość instytucji finansowych polega na zewnętrznych dostawcach systemów AI, co rodzi znaczne obowiązki w zakresie zarządzania ryzykiem stron trzecich (TPRM). Instytucje finansowe pozostają odpowiedzialne za wydajność i zgodność systemów AI stron trzecich, nawet jeśli nie opracowały modelu samodzielnie. Skuteczne TPRM dla AI wymaga dokładnego due diligence, bieżącego monitorowania, oceny praktyk zarządzania danymi dostawcy oraz dokumentowania wydajności modeli. Instytucje muszą również monitorować ryzyko koncentracji – potencjalny systemowy wpływ zakłóceń u kilku dostawców AI.

AI Act Unii Europejskiej jest najbardziej kompleksowym ramowym aktem regulacyjnym dla AI, klasyfikując systemy AI finansowe jako 'wysokiego ryzyka' i wymagając szerokiej dokumentacji, testowania uprzedzeń oraz nadzoru człowieka. OECD i G7 również wydały zasady dotyczące odpowiedzialnego zarządzania AI. Wiele z tych standardów ma zasięg eksterytorialny, co oznacza, że instytucje finansowe obsługujące klientów z regulowanych jurysdykcji mogą być zobowiązane do ich przestrzegania. Proaktywne dostosowanie się do standardów międzynarodowych pozwala przygotować się na przyszłe zmiany regulacyjne i ograniczyć ryzyko sankcji.

Śledź, jak Twoja instytucja finansowa jest wymieniana w odpowiedziach AI w GPT, Perplexity i Google AI Overviews. Zapewnij swojej marce widoczność i dokładność w finansowych treściach generowanych przez AI.

Monitoruj, jak Twoja marka finansowa pojawia się w odpowiedziach generowanych przez AI. Poznaj wymagania dotyczące zgodności, strategie widoczności oraz technik...

Poznaj niezbędne najlepsze praktyki przejrzystości i ujawniania AI. Odkryj behawioralne, werbalne i techniczne metody ujawniania, aby budować zaufanie i zapewni...

Dowiedz się, czym jest pokrycie indeksu AI i dlaczego ma znaczenie dla widoczności Twojej marki w ChatGPT, Google AI Overviews i Perplexity. Poznaj czynniki tec...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.