Jak certyfikacje pomagają budować zaufanie do systemów AI?

Dowiedz się, jak certyfikacje AI budują zaufanie dzięki ustandaryzowanym ramom, wymaganiom przejrzystości oraz niezależnej weryfikacji. Poznaj CSA STAR, ISO 420...

Zgodność AI w opiece zdrowotnej odnosi się do przestrzegania przez systemy sztucznej inteligencji wykorzystywane w opiece zdrowotnej obowiązujących norm regulacyjnych, prawnych i etycznych, które regulują ich rozwój, wdrażanie i eksploatację. Obejmuje wymagania dotyczące dokładności medycznej, bezpieczeństwa pacjenta, ochrony danych i skuteczności klinicznej w różnych jurysdykcjach. Krajobraz zgodności opiera się na standardach YMYL (Your Money or Your Life) oraz wymaganiach dotyczących dokładności medycznej, które wymagają walidacji roszczeń klinicznych opartej na dowodach.

Zgodność AI w opiece zdrowotnej odnosi się do przestrzegania przez systemy sztucznej inteligencji wykorzystywane w opiece zdrowotnej obowiązujących norm regulacyjnych, prawnych i etycznych, które regulują ich rozwój, wdrażanie i eksploatację. Obejmuje wymagania dotyczące dokładności medycznej, bezpieczeństwa pacjenta, ochrony danych i skuteczności klinicznej w różnych jurysdykcjach. Krajobraz zgodności opiera się na standardach YMYL (Your Money or Your Life) oraz wymaganiach dotyczących dokładności medycznej, które wymagają walidacji roszczeń klinicznych opartej na dowodach.

Zgodność AI w opiece zdrowotnej odnosi się do przestrzegania przez systemy sztucznej inteligencji wykorzystywane w opiece zdrowotnej obowiązujących norm regulacyjnych, prawnych i etycznych, które regulują ich rozwój, wdrażanie i eksploatację. Obejmuje to kompleksowe ramy zapewniające, że rozwiązania AI w opiece zdrowotnej spełniają rygorystyczne wymagania dotyczące dokładności medycznej, bezpieczeństwa pacjenta, ochrony danych i skuteczności klinicznej. Znaczenia zgodności AI w opiece zdrowotnej nie można przecenić, ponieważ brak zgodności może skutkować szkodą dla pacjenta, sankcjami regulacyjnymi, utratą wiarygodności klinicznej i odpowiedzialnością prawną dla organizacji medycznych oraz dostawców technologii. Krajobraz zgodności opiera się na dwóch filarach: standardach YMYL (Your Money or Your Life), które podkreślają wiarygodność treści oraz wymaganiach dotyczących dokładności medycznej, które wymagają walidacji klinicznych roszczeń opartej na dowodach. Organizacje wdrażające AI w opiece zdrowotnej muszą poruszać się po złożonych wymaganiach regulacyjnych w wielu jurysdykcjach, zachowując najwyższe standardy przejrzystości i odpowiedzialności.

YMYL (Your Money or Your Life) to koncepcja jakości wyszukiwania Google, która identyfikuje kategorie treści, w których niedokładności mogą bezpośrednio wpłynąć na zdrowie, bezpieczeństwo, stabilność finansową lub dobrostan użytkownika. W kontekście opieki zdrowotnej YMYL dotyczy każdego systemu AI dostarczającego informacji medycznych, wspierającego diagnostykę, rekomendacje leczenia lub porady zdrowotne, ponieważ mają one bezpośredni wpływ na kluczowe decyzje zdrowotne. Kryteria Google E-E-A-T—Ekspertyza, Doświadczenie, Autorytatywność i Wiarygodność—ustanawiają próg jakości dla treści medycznych, wymagając, aby systemy AI wykazywały wiedzę kliniczną, walidację w rzeczywistych warunkach, uznany autorytet w dziedzinie medycznej oraz spójną rzetelność. Systemy AI w opiece zdrowotnej muszą spełniać standardy YMYL, zapewniając, że wszystkie roszczenia medyczne są poparte dowodami klinicznymi, wyraźnie ujawniają udział AI w rekomendacjach i zachowują przejrzystą dokumentację źródeł danych szkoleniowych oraz metod walidacji. Krytycznym wymogiem dla zgodności AI z YMYL w opiece zdrowotnej jest recenzja przez licencjonowanego klinicystę, gdzie wykwalifikowani specjaliści medyczni weryfikują wyniki AI przed wdrożeniem klinicznym i ustalają mechanizmy nadzoru nad bieżącym monitorowaniem wydajności. Poniższa tabela ilustruje, jak wymagania YMYL przekładają się na konkretne standardy wdrożenia AI w opiece zdrowotnej:

| Wymaganie | Standard YMYL | Wdrożenie AI w opiece zdrowotnej |

|---|---|---|

| Dokładność treści | Roszczenia muszą być faktycznie poprawne i oparte na dowodach | Algorytmy AI walidowane względem klinicznych złotych standardów z udokumentowanymi metrykami czułości/specyficzności |

| Autorytet źródła | Treści tworzone przez uznanych ekspertów | Systemy AI rozwijane z udziałem rad doradczych i recenzowanych badań walidacyjnych |

| Przejrzystość | Jasne ujawnienie ograniczeń treści | Wyraźne oznaczenie udziału AI, wyników pewności i ograniczeń rekomendacji w interfejsach użytkownika |

| Demonstrowanie ekspertyzy | Udokumentowana wiedza w danej dziedzinie | Protokoły przeglądu przez klinicystów, ciągłe szkolenia dla twórców AI, udokumentowana ekspertyza kliniczna zespołów walidacyjnych |

| Sygnały zaufania użytkownika | Uprawnienia, cytowania, status zawodowy | Zgody regulacyjne (zatwierdzenie FDA), dane z badań klinicznych, afiliacje instytucjonalne, niezależne audyty |

| Minimalizacja uprzedzeń | Sprawiedliwa reprezentacja demograficzna | Walidacja w różnych populacjach pacjentów z udokumentowaną analizą równości i wynikami testów na uprzedzenia |

FDA (Food and Drug Administration) odgrywa kluczową rolę regulacyjną w nadzorze nad urządzeniami medycznymi opartymi na AI, ustanawiając wymagania przedrynkowe i porejestracyjne zapewniające bezpieczeństwo i skuteczność przed wdrożeniem klinicznym. Klasyfikacja Oprogramowanie jako urządzenie medyczne (SaMD) określa ścieżki regulacyjne w zależności od poziomu ryzyka; systemy AI diagnozujące, leczące lub monitorujące stany medyczne zazwyczaj wymagają nadzoru FDA. FDA oferuje trzy główne ścieżki przedrynkowe: 510(k) dla urządzeń zasadniczo równoważnych do już zatwierdzonych (najczęstsze dla aplikacji AI o niższym ryzyku), De Novo dla nowatorskich technologii AI bez urządzeń referencyjnych oraz PMA (Premarket Approval) dla urządzeń wysokiego ryzyka wymagających obszernej dokumentacji klinicznej. Wymagania dotyczące oceny wydajności i walidacji nakładają na twórców obowiązek przeprowadzenia rygorystycznych testów potwierdzających dokładność algorytmu, odporność w różnych populacjach pacjentów i bezpieczeństwo w rzeczywistych warunkach klinicznych, z dokumentacją zbiorów treningowych, metod walidacji i metryk wydajności. Plan działania FDA dotyczący AI/ML z 2021 roku i kolejne wytyczne podkreślają potrzebę przejrzystości algorytmów, monitorowania wydajności w rzeczywistych warunkach oraz protokołów modyfikacji zapewniających utrzymanie ważności klinicznej AI w trakcie jej ewolucji. Organizacje medyczne muszą prowadzić kompleksową dokumentację regulacyjną, obejmującą badania walidacyjne, analizy ryzyka i dowody zgodności z wytycznymi FDA przez cały cykl życia urządzenia.

Zgodność z HIPAA (Health Insurance Portability and Accountability Act) jest obowiązkowa dla każdego systemu AI w opiece zdrowotnej przetwarzającego chronione dane zdrowotne (PHI), wymagając ścisłej kontroli nad sposobem zbierania, przechowywania, przesyłania i wykorzystywania danych pacjentów w szkoleniu i wnioskowaniu modeli AI. Reguła prywatności ogranicza wykorzystanie i ujawnianie PHI do standardów minimalnej konieczności, podczas gdy reguła bezpieczeństwa nakłada wymogi techniczne i administracyjne, takie jak szyfrowanie, kontrola dostępu, dzienniki audytowe oraz procedury powiadamiania o naruszeniach dla systemów AI operujących na wrażliwych danych zdrowotnych. Deidentyfikacja danych treningowych jest kluczowym mechanizmem zgodności, wymagającym usunięcia lub transformacji 18 określonych identyfikatorów, aby umożliwić rozwój AI bez bezpośredniego narażenia PHI, choć ryzyko ponownej identyfikacji pozostaje przy zaawansowanej analizie. Organizacje medyczne stoją przed wyjątkowymi wyzwaniami podczas wdrażania AI zgodnie z HIPAA, w tym koniecznością równoważenia potrzeby posiadania dużych, reprezentatywnych zbiorów danych do szkolenia modeli z zasadą minimalizacji danych, zarządzaniem zgodnością dostawców zewnętrznych oraz prowadzeniem ścieżek audytu potwierdzających zgodność z HIPAA przez cały cykl życia AI. Zgodność z HIPAA nie jest opcjonalna, lecz fundamentalna dla wdrożenia AI w opiece zdrowotnej, ponieważ naruszenia skutkują istotnymi sankcjami cywilnymi, odpowiedzialnością karną i nieodwracalną utratą reputacji oraz zaufania pacjentów.

Walidacja kliniczna algorytmów AI w opiece zdrowotnej wymaga rygorystycznych standardów dowodowych potwierdzających, że systemy AI działają bezpiecznie i skutecznie w przewidzianych zastosowaniach klinicznych przed szerokim wdrożeniem. Organizacje medyczne muszą ustanowić ramy walidacyjne zgodne z metodologią badań klinicznych, w tym badania prospektywne porównujące rekomendacje AI ze złotymi standardami diagnoz, ocenę wydajności w różnych populacjach pacjentów oraz dokumentację scenariuszy awaryjnych i przypadków brzegowych, w których wydajność AI się pogarsza. Wykrywanie uprzedzeń i ocena sprawiedliwości to kluczowe elementy walidacji, wymagające systematycznej oceny różnic w wydajności AI w zależności od rasy, etniczności, płci, wieku i statusu społeczno-ekonomicznego w celu identyfikacji i minimalizacji algorytmicznych nierówności zdrowotnych. Wyjaśnialność i interpretowalność zapewniają, że klinicyści mogą zrozumieć rozumowanie AI, zweryfikować rekomendacje względem własnej wiedzy i zidentyfikować sytuacje, w których wyniki AI wymagają sceptycyzmu lub dodatkowej weryfikacji. Następujące kluczowe wymagania walidacyjne stanowią podstawę klinicznie wiarygodnej AI w opiece zdrowotnej:

GDPR (General Data Protection Regulation) i międzynarodowe ramy ochrony danych ustanawiają rygorystyczne wymagania wobec systemów AI w opiece zdrowotnej działających transgranicznie, ze szczególnym naciskiem na zgodę pacjenta, minimalizację danych i indywidualne prawa do dostępu oraz usuwania danych. EU AI Act wprowadza regulację ryzyka systemów AI, klasyfikując AI w opiece zdrowotnej jako wysokiego ryzyka i wymagającą oceny zgodności, mechanizmów nadzoru ludzkiego i dokumentacji przejrzystości przed wprowadzeniem na rynek. Różnice regionalne w regulacji AI w opiece zdrowotnej odzwierciedlają odmienne priorytety polityczne: Wielka Brytania utrzymuje standardy zgodne z GDPR z wytycznymi sektorowymi Information Commissioner’s Office, Australia podkreśla przejrzystość i odpowiedzialność algorytmiczną przez ramy Automated Decision Systems, a Kanada wymaga zgodności z PIPEDA (Personal Information Protection and Electronic Documents Act) z uwzględnieniem specyfiki sektora zdrowia. Inicjatywy harmonizujące prowadzone przez międzynarodowe organizacje normalizacyjne, takie jak ISO i IEC, rozwijają wspólne ramy walidacji AI, zarządzania ryzykiem i dokumentacji, choć znaczące różnice regulacyjne nadal występują między jurysdykcjami. Globalna zgodność jest istotna, ponieważ organizacje medyczne i dostawcy AI działający międzynarodowo muszą poruszać się po nakładających się i czasem sprzecznych wymaganiach regulacyjnych, co wymaga struktur zarządzania spełniających najwyższe obowiązujące standardy we wszystkich regionach działalności.

Efektywna zgodność AI w opiece zdrowotnej wymaga ustanowienia solidnych struktur zarządzania, które definiują role, odpowiedzialności i uprawnienia decyzyjne w zakresie rozwoju, walidacji, wdrażania i monitorowania AI w całej organizacji. Dokumentacja i ścieżki audytu są kluczowymi mechanizmami zgodności, wymagającymi kompleksowej rejestracji decyzji dotyczących rozwoju algorytmów, protokołów i wyników badań walidacyjnych, procesów przeglądu klinicznego, szkoleń użytkowników oraz monitorowania wydajności, które demonstrują zgodność podczas inspekcji regulacyjnych i postępowań prawnych. Monitoring porejestracyjny i protokoły ciągłego nadzoru zapewniają, że wdrożone systemy AI zachowują ważność kliniczną w czasie, poprzez systematyczne gromadzenie danych o wydajności w rzeczywistych warunkach, identyfikowanie degradacji wydajności lub pojawiających się zagrożeń oraz udokumentowane procedury ponownego szkolenia lub modyfikacji algorytmu. Zarządzanie dostawcami i programy zgodności dla stron trzecich ustalają wymagania umowne, procedury audytu i standardy wydajności, zapewniając, że zewnętrzni twórcy, dostawcy danych i usługodawcy spełniają oczekiwania organizacji i wymogi regulacyjne. Organizacje medyczne powinny wdrożyć struktury zarządzania obejmujące rady doradcze, komitety ds. zgodności i zespoły interdyscyplinarne odpowiedzialne za nadzór nad AI; prowadzić ścieżki audytu dokumentujące wszystkie istotne decyzje i modyfikacje; przeprowadzać regularne przeglądy monitoringu porejestracyjnego; oraz utrzymywać kompleksowe umowy z dostawcami określające zakres odpowiedzialności i standardy wydajności w zakresie zgodności.

Organizacje medyczne napotykają istotne luki w zgodności w obecnych praktykach wdrażania AI, w tym niewystarczającą walidację kliniczną algorytmów przed użyciem klinicznym, niewłaściwą ocenę uprzedzeń w różnych populacjach pacjentów i ograniczoną przejrzystość udziału AI w podejmowaniu decyzji klinicznych. Krajobraz regulacyjny stale się dynamicznie zmienia, z częstymi aktualizacjami wytycznych FDA, norm międzynarodowych i ram polityki zdrowotnej, co tworzy niepewność zgodności dla organizacji wdrażających nowoczesne technologie AI przy jednoczesnym zachowaniu zgodności z przepisami. Nowe narzędzia i technologie usprawniają możliwości monitorowania zgodności; na przykład platformy takie jak AmICited pomagają organizacjom śledzić, jak systemy AI w opiece zdrowotnej i informacje o zgodności są cytowane w szerszym ekosystemie AI, zapewniając wgląd w to, jak marki medyczne i wytyczne regulacyjne są włączane do innych systemów AI. Przyszłe trendy zgodności wskazują na rosnący nacisk na monitoring wydajności w rzeczywistych warunkach, przejrzystość i wyjaśnialność algorytmów, ocenę równości i sprawiedliwości oraz ciągłe ramy walidacyjne traktujące wdrożenie AI jako proces ciągły, a nie jednorazowe zatwierdzenie. Organizacje medyczne muszą wdrażać proaktywne strategie zgodności, przewidywać ewolucję regulacji, inwestować w infrastrukturę zarządzania i ekspertyzę kliniczną oraz zachować elastyczność, by dostosować się do zmieniających się standardów i oczekiwań.

Zgodność AI w opiece zdrowotnej odnosi się do przestrzegania przez systemy sztucznej inteligencji norm regulacyjnych, prawnych i etycznych regulujących ich rozwój, wdrażanie i eksploatację w środowiskach opieki zdrowotnej. Obejmuje wymagania dotyczące dokładności medycznej, bezpieczeństwa pacjenta, ochrony danych i efektywności klinicznej, zapewniając, że systemy AI spełniają standardy YMYL i wymagania walidacji opartej na dowodach przed wdrożeniem klinicznym.

YMYL (Your Money or Your Life) to koncepcja jakości wyszukiwania Google identyfikująca treści, które mogą mieć istotny wpływ na zdrowie i dobrostan użytkownika. Systemy AI w opiece zdrowotnej muszą spełniać standardy YMYL, zapewniając, że wszystkie roszczenia medyczne są poparte dowodami klinicznymi, wyraźnie ujawniają udział AI oraz zachowując przejrzystą dokumentację źródeł danych szkoleniowych i metod walidacji.

Główne ramy regulacyjne obejmują nadzór FDA nad urządzeniami medycznymi z AI, zgodność z HIPAA dla systemów przetwarzających chronione dane zdrowotne, GDPR i EU AI Act dla międzynarodowej ochrony danych oraz regionalne standardy w Wielkiej Brytanii, Australii i Kanadzie. Każde z nich ustala określone wymagania dotyczące bezpieczeństwa, skuteczności, prywatności i przejrzystości.

Walidacja kliniczna to rygorystyczny proces testowania wykazujący, że systemy AI działają bezpiecznie i skutecznie w zamierzonych zastosowaniach klinicznych. Obejmuje badania prospektywne porównujące rekomendacje AI ze złotym standardem diagnoz, ocenę wydajności w różnych populacjach pacjentów, wykrywanie uprzedzeń i ocenę sprawiedliwości oraz dokumentację wyjaśnialności i interpretowalności z myślą o zrozumieniu przez klinicystów.

Zgodność z HIPAA jest obowiązkowa dla każdego systemu AI w opiece zdrowotnej przetwarzającego chronione dane zdrowotne (PHI). Wymaga ścisłej kontroli nad zbieraniem, przechowywaniem, transmisją i wykorzystaniem danych w szkoleniu modeli AI, w tym szyfrowania, kontroli dostępu, dzienników audytowych, procedur powiadamiania o naruszeniach oraz deidentyfikacji danych szkoleniowych poprzez usunięcie lub transformację 18 konkretnych identyfikatorów.

FDA nadzoruje urządzenia medyczne z AI poprzez ścieżki przedrynkowe, w tym zatwierdzenie 510(k) dla urządzeń równoważnych, klasyfikację De Novo dla nowatorskich technologii AI oraz zatwierdzenie PMA dla urządzeń wysokiego ryzyka. FDA wymaga kompleksowej dokumentacji rozwoju algorytmów, badań walidacyjnych, metryk wydajności, monitorowania rzeczywistego oraz protokołów modyfikacji przez cały cykl życia urządzenia.

Główne wyzwania obejmują niewystarczającą walidację kliniczną przed wdrożeniem, niewłaściwą ocenę uprzedzeń w różnych populacjach pacjentów, ograniczoną przejrzystość udziału AI w decyzjach klinicznych, równoważenie minimalizacji danych z potrzebami szkoleniowymi modeli, zarządzanie zgodnością dostawców zewnętrznych oraz poruszanie się po szybko zmieniających się przepisach w różnych jurysdykcjach.

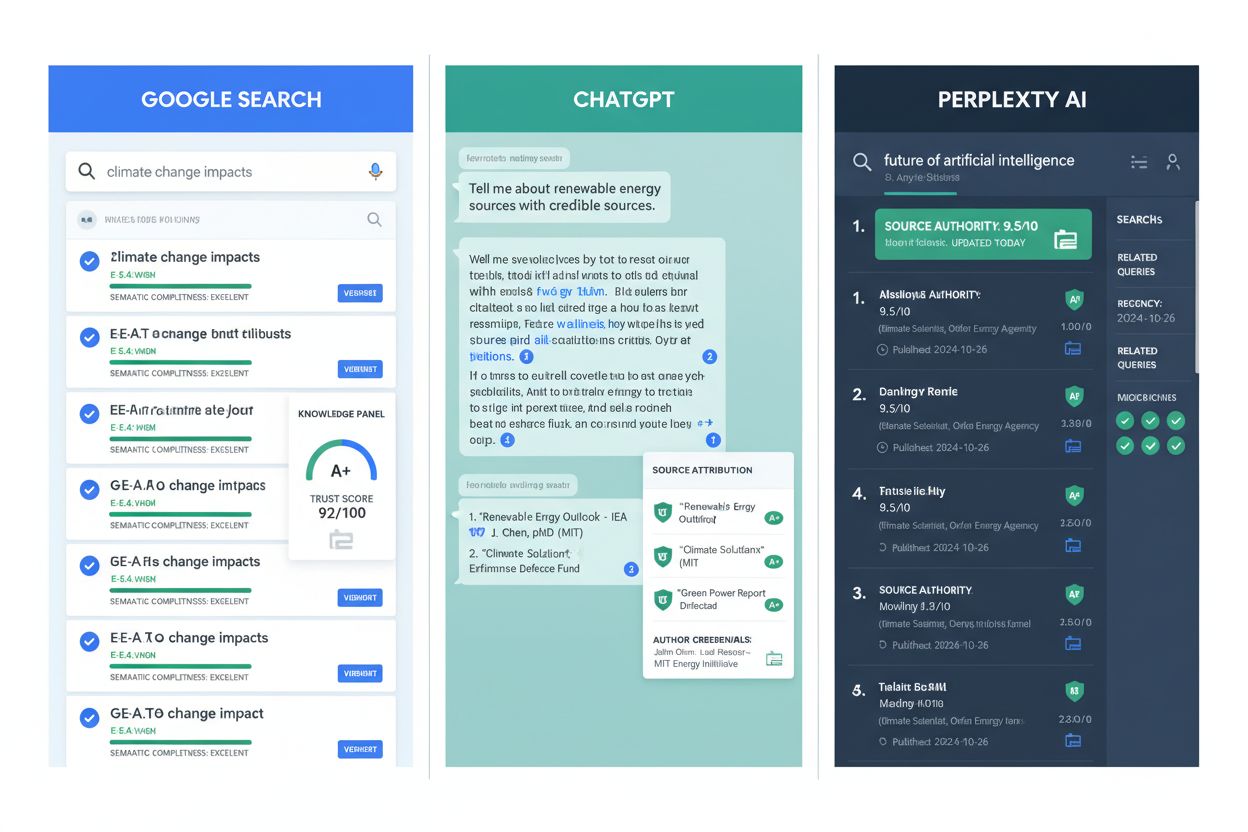

Organizacje mogą korzystać z platform monitorujących AI, takich jak AmICited, aby śledzić, jak ich marki medyczne, informacje o zgodności i wytyczne regulacyjne są cytowane w systemach AI takich jak ChatGPT, Perplexity i Google AI Overviews. Zapewnia to wgląd w to, jak standardy zgodności są włączane do szerszego ekosystemu AI i pozwala identyfikować potencjalne błędne przedstawienia informacji medycznych.

Śledź, jak Twoja marka medyczna i informacje o zgodności są cytowane w systemach AI takich jak ChatGPT, Perplexity i Google AI Overviews dzięki AmICited.

Dowiedz się, jak certyfikacje AI budują zaufanie dzięki ustandaryzowanym ramom, wymaganiom przejrzystości oraz niezależnej weryfikacji. Poznaj CSA STAR, ISO 420...

Dowiedz się, jak systemy AI oceniają wiarygodność źródeł poprzez kwalifikacje autora, cytowania i weryfikację. Poznaj techniczne mechanizmy, kluczowe czynniki o...

Dyskusja społecznościowa o tym, jak systemy AI radzą sobie z tematami YMYL (Your Money or Your Life). Prawdziwe spostrzeżenia dotyczące widoczności treści zdrow...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.