Tworzenie metaodpowiedzi LLM: Samodzielne wnioski, które AI może cytować

Dowiedz się, jak tworzyć metaodpowiedzi LLM, które są cytowane przez systemy AI. Poznaj techniki strukturalne, strategie zagęszczania odpowiedzi i formaty treśc...

Treści, które bezpośrednio odnoszą się do sposobu, w jaki modele językowe mogą interpretować i odpowiadać na powiązane zapytania, zaprojektowane w celu zwiększenia widoczności w odpowiedziach generowanych przez AI na platformach takich jak ChatGPT, Google AI Overviews i Perplexity. LLM Meta Answers to zsyntezowane odpowiedzi, które łączą informacje z wielu źródeł w spójne, konwersacyjne odpowiedzi odpowiadające intencji użytkownika.

Treści, które bezpośrednio odnoszą się do sposobu, w jaki modele językowe mogą interpretować i odpowiadać na powiązane zapytania, zaprojektowane w celu zwiększenia widoczności w odpowiedziach generowanych przez AI na platformach takich jak ChatGPT, Google AI Overviews i Perplexity. LLM Meta Answers to zsyntezowane odpowiedzi, które łączą informacje z wielu źródeł w spójne, konwersacyjne odpowiedzi odpowiadające intencji użytkownika.

LLM Meta Answers to zsyntezowane, generowane przez AI odpowiedzi, które duże modele językowe tworzą, gdy użytkownicy zadają im pytania na platformach takich jak ChatGPT, Claude czy Google AI Overviews. Odpowiedzi te zasadniczo różnią się od tradycyjnych wyników wyszukiwania, ponieważ łączą informacje z wielu źródeł w spójną, konwersacyjną odpowiedź, która bezpośrednio odnosi się do intencji użytkownika. Zamiast prezentować listę linków, LLM-y analizują pobrane treści i generują oryginalny tekst, który łączy fakty, perspektywy i spostrzeżenia z danych treningowych oraz systemów generowania wspieranych wyszukiwaniem (RAG). Zrozumienie, jak LLM-y budują te metaodpowiedzi, jest kluczowe dla twórców treści, którzy chcą, aby ich prace były cytowane i referowane w odpowiedziach AI. Widoczność Twojej treści w tych odpowiedziach AI stała się równie ważna, jak pozycjonowanie w tradycyjnych wynikach wyszukiwania, czyniąc optymalizację pod LLM (LLMO) istotnym elementem nowoczesnej strategii contentowej.

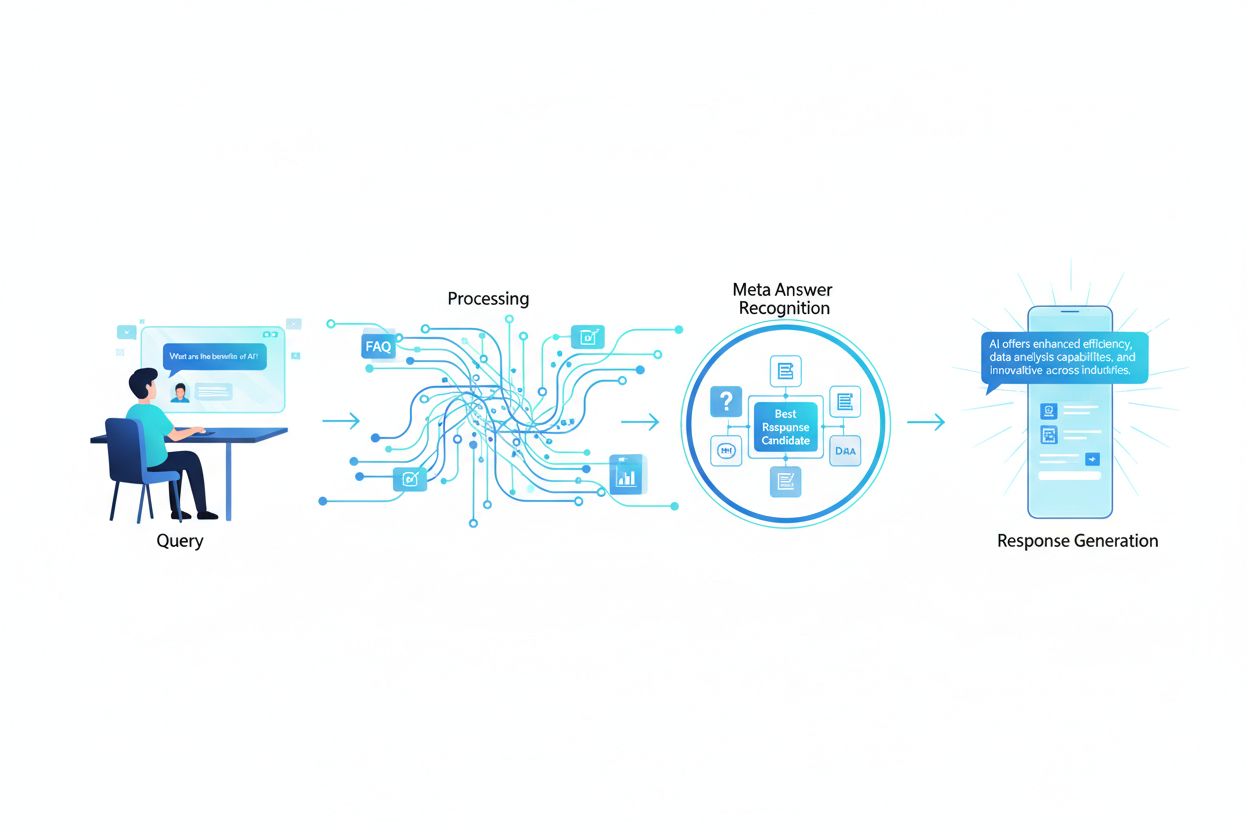

Gdy użytkownik wysyła zapytanie do LLM, system nie ogranicza się do dopasowywania słów kluczowych jak tradycyjne wyszukiwarki. Zamiast tego, LLM-y przeprowadzają analizę semantyczną, by zrozumieć intencję, kontekst i niuanse pytania. Model rozbija zapytanie na składniki koncepcyjne, identyfikuje powiązane tematy i byty oraz określa, jaki typ odpowiedzi byłby najbardziej pomocny — czy jest to definicja, porównanie, instrukcja krok po kroku czy analiza. LLM-y następnie pobierają odpowiednie treści ze swojej bazy wiedzy, korzystając z systemów RAG, które priorytetyzują źródła na podstawie trafności, autorytetu i kompletności. Proces ten uwzględnia nie tylko dokładne dopasowania słów kluczowych, ale także podobieństwo semantyczne, relacje tematyczne i to, jak dobrze treść odnosi się do konkretnych aspektów zapytania. Oznacza to, że Twoje treści muszą być wykrywalne nie tylko dla konkretnych słów kluczowych, ale także dla pojęć semantycznych i powiązanych tematów, o które faktycznie pytają użytkownicy.

| Czynnik interpretacji zapytania | Tradycyjne wyszukiwanie | LLM Meta Answers |

|---|---|---|

| Metoda dopasowania | Dopasowanie słów kluczowych | Zrozumienie semantyczne |

| Format wyniku | Lista linków | Zsyntezowana narracja |

| Wybór źródła | Ranking trafności | Trafność + kompletność + autorytet |

| Uwzględnienie kontekstu | Ograniczone | Szeroki kontekst semantyczny |

| Synteza odpowiedzi | Użytkownik czyta wiele źródeł | AI łączy wiele źródeł |

| Wymóg cytowania | Opcjonalny | Często stosowany |

Aby Twoje treści były wybierane i cytowane w metaodpowiedziach LLM, muszą posiadać kilka kluczowych cech zgodnych z tym, jak te systemy oceniają i syntezują informacje. Po pierwsze, Twoja treść musi wykazywać wyraźną ekspertyzę i autorytet w danym temacie, z silnymi sygnałami E-E-A-T (Doświadczenie, Ekspertyza, Autorytatywność, Wiarygodność), które pomagają LLM-om zidentyfikować rzetelne źródła. Po drugie, treści powinny wnosić rzeczywistą wartość informacyjną — unikalne spostrzeżenia, dane lub perspektywy, które wykraczają poza powszechnie dostępne informacje. Po trzecie, treść musi być strukturalnie zorganizowana w sposób ułatwiający LLM-om analizę i wydobywanie odpowiednich fragmentów, z czytelną hierarchią i logicznym układem. Po czwarte, istotne jest bogactwo semantyczne; treść powinna gruntownie eksplorować powiązane koncepcje, używać różnorodnej terminologii i budować szeroki autorytet tematyczny zamiast skupiać się wyłącznie na pojedynczych słowach kluczowych. Po piąte, aktualność treści ma ogromne znaczenie w tematach bieżących, gdyż LLM-y premiują świeże, aktualne informacje przy syntezie odpowiedzi. Na koniec, Twoje treści powinny zawierać potwierdzające dowody w postaci cytatów, danych i odniesień zewnętrznych budujących zaufanie do systemów LLM.

Najważniejsze cechy zwiększające cytowanie przez LLM:

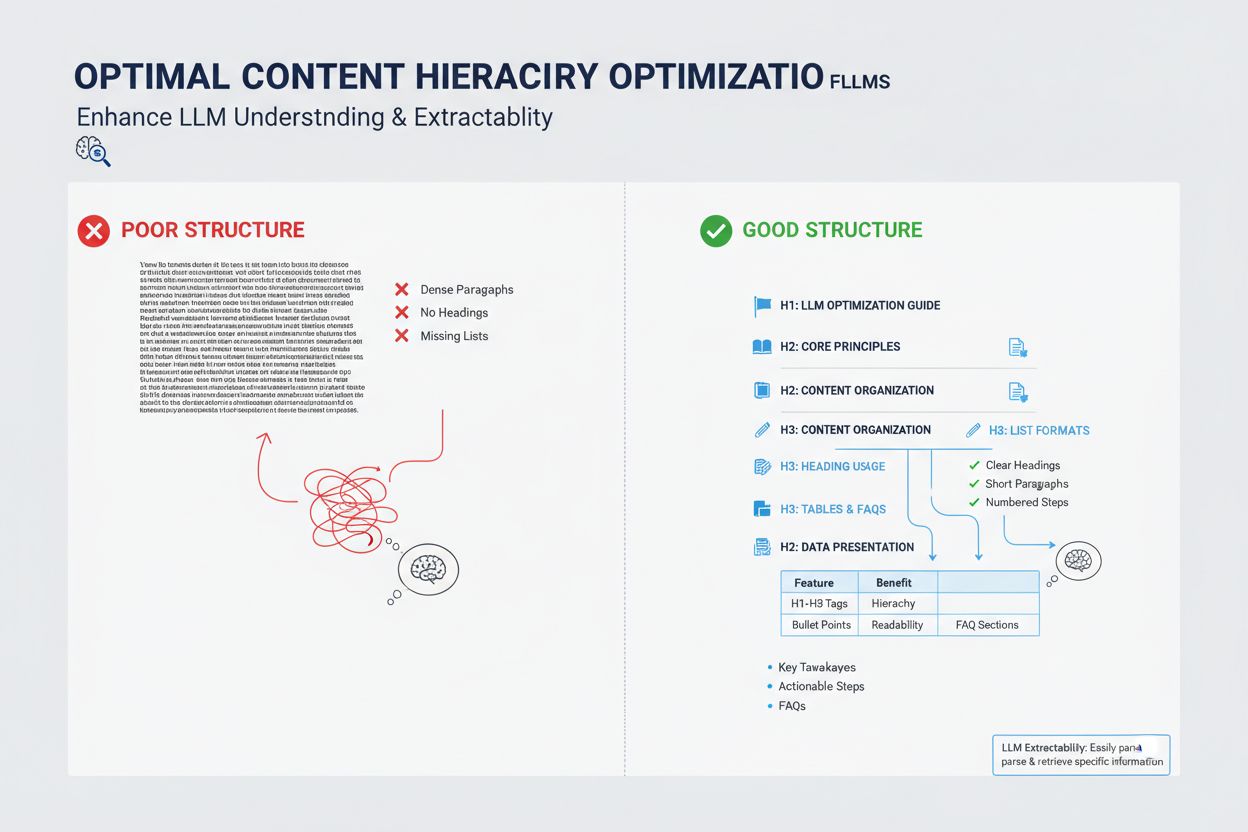

Sposób, w jaki strukturyzujesz treść, ma ogromny wpływ na to, czy LLM wybierze ją do metaodpowiedzi, gdyż systemy te są zoptymalizowane do wydobywania i syntezy dobrze zorganizowanych informacji. LLM-y mocno preferują treści z czytelną hierarchią nagłówków (H1, H2, H3), która tworzy logiczną architekturę informacji, pozwalając modelowi zrozumieć relacje między pojęciami i wydobywać istotne sekcje efektywnie. Punktory i listy numerowane są szczególnie cenne, ponieważ prezentują informacje w przystępnej, wyodrębnionej formie, którą LLM-y łatwo włączają do zsyntezowanych odpowiedzi. Tabele są wyjątkowo skuteczne dla widoczności w LLM, gdyż prezentują dane w strukturze łatwej do analizy i cytowania przez AI. Krótkie akapity (3-5 zdań) wypadają lepiej niż zbite bloki tekstu, pozwalając LLM-om na szybkie wyodrębnianie konkretnych informacji. Dodatkowo, używanie znaczników schema (FAQ, Article, HowTo) wysyła wyraźne sygnały co do struktury i celu treści, znacząco zwiększając szansę na cytowanie.

Choć LLM meta answers i featured snippets mogą wydawać się podobne, w rzeczywistości reprezentują zupełnie inne mechanizmy widoczności treści i wymagają odmiennych strategii optymalizacyjnych. Featured snippets są wybierane przez tradycyjne algorytmy wyszukiwarek z istniejących treści internetowych i wyświetlane na określonej pozycji w wynikach wyszukiwania, zazwyczaj jako 40-60 słów wyekstrahowanego tekstu. LLM meta answers to natomiast odpowiedzi generowane przez AI, które syntetyzują informacje z wielu źródeł w nową, oryginalną narrację, często dłuższą i bardziej wyczerpującą niż pojedyncze źródło. Featured snippets premiują treści, które wprost i zwięźle odpowiadają na jedno pytanie, podczas gdy LLM meta answers nagradzają kompleksowe, autorytatywne treści zapewniające głębokie pokrycie tematyczne. Różnią się też mechanizmy cytowania: featured snippets pokazują link do źródła, a treść jest przytaczana dosłownie, natomiast LLM meta answers mogą parafrazować lub syntetyzować treść i zwykle zawierają atrybucję. Featured snippets są optymalizowane głównie pod tradycyjne wyszukiwanie, podczas gdy LLM meta answers pod platformy AI i mogą nie pojawiać się w wynikach wyszukiwania.

| Aspekt | Featured Snippets | LLM Meta Answers |

|---|---|---|

| Metoda generowania | Algorytm wyodrębnia istniejący tekst | AI syntetyzuje z wielu źródeł |

| Format wyświetlania | Pozycja na stronie wyników wyszukiwania | Odpowiedź na platformie AI |

| Długość treści | Zwykle 40-60 słów | 200-500+ słów |

| Styl cytowania | Link do źródła z przytoczonym tekstem | Atrybucja z parafrazowaną treścią |

| Cel optymalizacji | Zwięzłe, bezpośrednie odpowiedzi | Kompleksowy autorytet |

| Platforma | Google Search | ChatGPT, Claude, Google AI Overviews |

| Miar widoczności | Wyświetlenia w wyszukiwarce | Cytowania w odpowiedziach AI |

Bogactwo semantyczne — głębia i zakres pokrycia pojęciowego w Twojej treści — to jeden z najważniejszych, a często niedocenianych czynników optymalizacji pod LLM. LLM-y nie szukają wyłącznie docelowego słowa kluczowego; analizują relacje semantyczne między pojęciami, kontekst otaczający główny temat oraz to, jak gruntownie eksplorujesz powiązane idee. Treści o wysokim bogactwie semantycznym używają różnorodnej terminologii, przedstawiają temat z wielu perspektyw i budują powiązania między pokrewnymi pojęciami, pomagając LLM-om zrozumieć, że Twój materiał jest rzeczywiście autorytatywny, a nie tylko zoptymalizowany pod frazy. Pisząc o temacie, włączaj powiązane terminy, synonimy i koncepcje sąsiadujące, które pomagają LLM umieścić Twoją treść w szerszej sieci wiedzy. Na przykład artykuł o “content marketingu” powinien naturalnie zawierać rozważania o segmentacji odbiorców, personach, dystrybucji treści, analizie i ROI — nie po to, by upychać słowa kluczowe, lecz by semantycznie i kompleksowo omówić temat. Ta głębia sygnalizuje LLM-om prawdziwą ekspertyzę i zdolność do udzielania wieloaspektowych odpowiedzi, których oczekują użytkownicy.

LLM-y oceniają autorytet inaczej niż tradycyjne wyszukiwarki, kładąc większy nacisk na sygnały prawdziwej ekspertyzy i wiarygodności, a nie tylko popularności linków. Szczególnie ważne są kompetencje autora i udokumentowane doświadczenie; LLM-y preferują treści od uznanych ekspertów, praktyków czy organizacji o ugruntowanej pozycji w branży. Zewnętrzne cytowania i odniesienia do innych autorytatywnych źródeł budują wiarygodność wobec LLM, pokazując, że Twoja treść opiera się na szerokiej wiedzy i jest potwierdzana przez innych specjalistów. Spójność w publikowaniu wielu treści na dany temat wzmacnia autorytet tematyczny; LLM-y zauważają, gdy autor lub organizacja systematycznie tworzy wyczerpujące materiały w powiązanych dziedzinach. Zewnętrzna walidacja poprzez wzmianki, cytaty czy referencje od innych autorytetów znacząco zwiększa widoczność w LLM meta answers. Oryginalne badania, własne dane czy autorskie metody to potężne sygnały autorytetu, bo stanowią unikalną wiedzę niedostępną gdzie indziej. Również regularne odświeżanie treści i aktualizacje publikacji pokazują, że jesteś na bieżąco i aktywnie rozwijasz tematykę.

Sygnały autorytetu wpływające na wybór przez LLM:

Świeżość treści stała się kluczowa dla widoczności w LLM, zwłaszcza w tematach, gdzie informacje szybko się zmieniają lub bieżące wydarzenia mają istotny wpływ na odpowiedzi. LLM-y są trenowane na danych o określonej dacie zakończenia zbioru wiedzy, ale coraz częściej korzystają z systemów RAG pobierających aktualne informacje z internetu, co oznacza, że data publikacji i częstotliwość aktualizacji treści bezpośrednio wpływają na ich wybór do metaodpowiedzi. W przypadku tematów evergreen regularne aktualizacje — nawet drobne, odświeżające datę publikacji — sygnalizują LLM-om, że treść jest utrzymywana i godna zaufania. Przy tematach bieżących, takich jak trendy branżowe, nowe technologie czy wydarzenia, przestarzałe treści są aktywnie deprecjonowane na rzecz nowszych źródeł. Najlepszą praktyką jest ustalenie harmonogramu przeglądów i aktualizacji kluczowych materiałów co kwartał lub pół roku, odświeżanie statystyk, dodawanie nowych przykładów i uwzględnianie najnowszych wydarzeń. Takie utrzymanie nie tylko poprawia widoczność w LLM, ale także pokazuje AI i czytelnikom, że jesteś aktualnym i rzetelnym źródłem wiedzy.

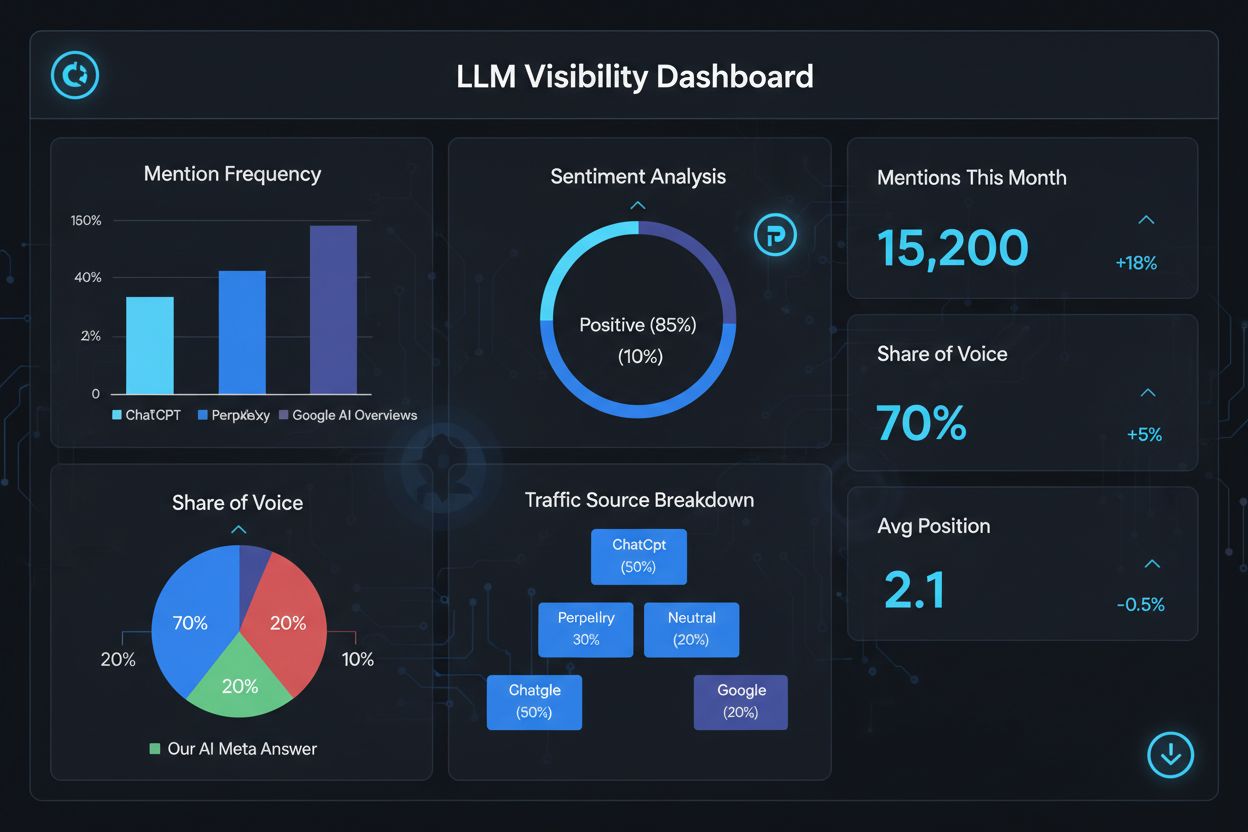

Pomiar sukcesu w LLM meta answers wymaga innych wskaźników i narzędzi niż tradycyjne SEO, ponieważ odpowiedzi te funkcjonują poza ekosystemem wyników wyszukiwania. Narzędzia takie jak AmICited.com oferują specjalistyczny monitoring, który śledzi, kiedy i gdzie Twoje treści pojawiają się w odpowiedziach generowanych przez AI, dając wgląd w to, które materiały są cytowane i jak często. Powinieneś monitorować kilka kluczowych wskaźników: częstotliwość cytowania (jak często Twoje treści pojawiają się w odpowiedziach LLM), kontekst cytowania (jakie tematy wywołują cytowanie), różnorodność źródeł (czy jesteś cytowany na różnych platformach LLM), oraz pozycję odpowiedzi (czy Twoje treści są eksponowane w zsyntezowanych odpowiedziach). Śledź, które strony lub sekcje Twoich treści są najczęściej cytowane — to pokazuje, jakie informacje LLM-y uznają za najbardziej wartościowe i godne zaufania. Monitoruj zmiany we wzorcach cytowań w czasie, by ocenić skuteczność optymalizacji i zidentyfikować tematy wymagające dalszego rozwoju. Analizuj także zapytania wywołujące cytowanie, by zrozumieć, jak LLM-y interpretują intencje użytkowników i które warianty semantyczne są najskuteczniejsze.

Kluczowe wskaźniki skuteczności LLM meta answers:

Optymalizacja pod LLM meta answers wymaga strategicznego podejścia łączącego wdrożenia techniczne, jakość treści i stały monitoring. Zacznij od kompleksowego researchu tematycznego, by zidentyfikować luki, w których Twoja ekspertyza może dać unikalną wartość, którą LLM-y przedłożą nad źródła ogólne. Strukturyzuj treść wyraźnie, używając nagłówków H2 i H3 do budowy logicznej architektury informacji, którą LLM-y łatwo zanalizują i wydobędą. Wdrażaj znaczniki schema (FAQ, Article, HowTo), by jasno sygnalizować strukturę i cel treści, co znacząco podnosi wykrywalność. Twórz kompleksowe, autorytatywne treści, które gruntownie eksplorują temat z różnych perspektyw, włączając powiązane pojęcia i budując bogactwo semantyczne świadczące o prawdziwej ekspertyzie. Dodawaj oryginalne badania, dane lub autorskie spostrzeżenia zapewniające wartość informacyjną i odróżniające Twoje treści od konkurencji. Ustal harmonogram regularnych aktualizacji, odświeżając kluczowe materiały co kwartał, by utrzymać aktualność i sygnalizować ciągły autorytet. Buduj autorytet tematyczny, tworząc powiązane treści, które wspólnie budują Twoją pozycję eksperta w danym obszarze. Stosuj jasny, bezpośredni język udzielający konkretnych odpowiedzi na pytania użytkowników — ułatwi to LLM-om ekstrakcję i syntezę treści. Na koniec monitoruj wyniki cytowań LLM za pomocą specjalistycznych narzędzi, by zidentyfikować skuteczne działania i stale optymalizować strategię na podstawie danych.

LLM Meta Answers koncentrują się na tym, jak modele językowe interpretują i cytują treści, podczas gdy tradycyjne SEO skupia się na pozycjonowaniu w wynikach wyszukiwania. LLM-y priorytetyzują trafność i klarowność nad autorytetem domeny, przez co dobrze zorganizowana treść, udzielająca odpowiedzi na początku, jest ważniejsza niż linki zwrotne. Twoje treści mogą być cytowane w odpowiedziach LLM nawet jeśli nie znajdują się w czołówce wyników Google.

Strukturyzuj treść za pomocą jasnych nagłówków, udzielaj bezpośrednich odpowiedzi już na wstępie, używaj znaczników schema (FAQ, Article), dodawaj cytaty i statystyki, buduj autorytet tematyczny i upewnij się, że Twoja strona jest dostępna dla botów AI. Skup się na bogactwie semantycznym, wartości informacyjnej i wyczerpującym pokryciu tematu, a nie na wąskim targetowaniu słów kluczowych.

LLM-y łatwiej wyodrębniają fragmenty z dobrze zorganizowanych treści. Jasne nagłówki, listy, tabele i krótkie akapity pomagają modelom zidentyfikować i cytować istotne informacje. Badania pokazują, że strony cytowane przez LLM zawierają znacznie więcej elementów strukturalnych niż przeciętne strony www, dlatego struktura jest kluczowym czynnikiem rankingowym.

Tak. W przeciwieństwie do tradycyjnego SEO, LLM-y priorytetyzują trafność zapytania i jakość treści ponad autorytet domeny. Dobrze zorganizowana, bardzo trafna strona niszowa może zostać cytowana przez LLM nawet jeśli nie jest wysoko w Google, więc eksperckość i jasność są ważniejsze niż autorytet witryny.

Aktualizuj treści regularnie, szczególnie w przypadku tematów wrażliwych na czas. Dodawaj daty ostatniej aktualizacji. W przypadku tematów evergreen zalecane są kwartalne przeglądy. Świeże treści sygnalizują LLM-om aktualność, zwiększając szansę na cytowanie i potwierdzając Twój autorytet.

AmICited.com specjalizuje się w monitorowaniu wzmianek AI w ChatGPT, Perplexity i Google AI Overviews. Inne narzędzia to Semrush AI SEO Toolkit, Ahrefs Brand Radar i Peec AI. Narzędzia te śledzą częstotliwość wzmianek, udział w głosie, sentyment i pomagają mierzyć skuteczność optymalizacji.

Znaczniki schema (FAQ, Article, HowTo) zapewniają strukturę zrozumiałą dla maszyn, która pomaga LLM-om lepiej zrozumieć i wydobyć treści. Sygnałują typ i intencję treści, zwiększając szansę, że Twoja strona zostanie wybrana dla odpowiednich zapytań i poprawiając ogólną wykrywalność.

Zewnętrzne wzmianki w serwisach o wysokim autorytecie (news, Wikipedia, branżowe publikacje) budują wiarygodność i zwiększają szansę, że LLM zacytuje Twoje treści. Kilka niezależnych źródeł wspominających Twoją markę lub dane tworzy wzorzec autorytetu, który LLM-y rozpoznają i nagradzają częstszymi cytowaniami.

Śledź, jak Twoja marka pojawia się w odpowiedziach generowanych przez AI na ChatGPT, Perplexity i Google AI Overviews dzięki specjalistycznej platformie monitorującej AmICited.

Dowiedz się, jak tworzyć metaodpowiedzi LLM, które są cytowane przez systemy AI. Poznaj techniki strukturalne, strategie zagęszczania odpowiedzi i formaty treśc...

Dowiedz się, czym jest LLMO i odkryj sprawdzone techniki optymalizacji marki pod kątem widoczności w odpowiedziach generowanych przez AI, takich jak ChatGPT, Pe...

Dowiedz się, jak identyfikować i celować w strony źródłowe LLM dla strategicznych backlinków. Sprawdź, które platformy AI najczęściej cytują źródła i zoptymaliz...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.