Rozwinięcie zapytania (Query Fanout)

Dowiedz się, jak działa rozwinięcie zapytania w systemach wyszukiwania AI. Odkryj, jak AI rozszerza pojedyncze zapytania na wiele podzapytań, by poprawić trafno...

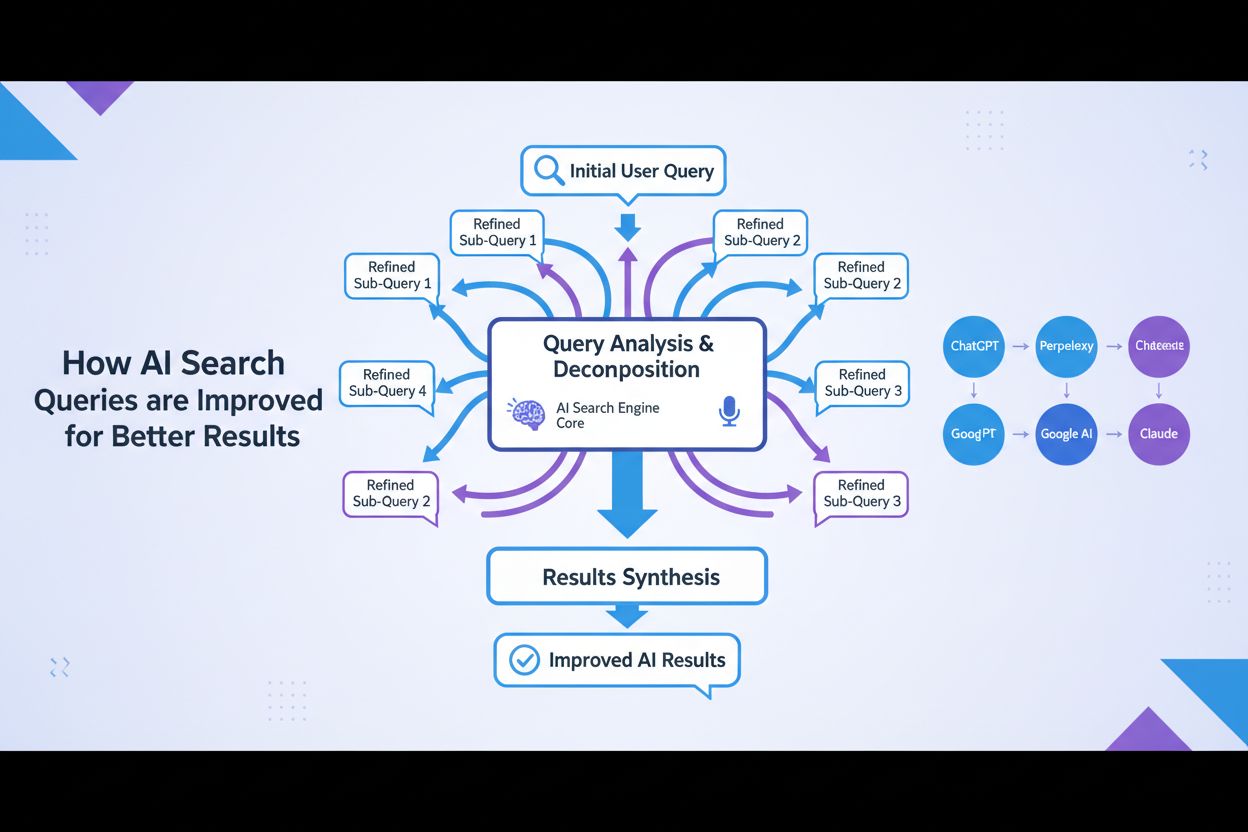

Optymalizacja rozszerzania zapytania to proces ulepszania zapytań wyszukiwawczych użytkownika poprzez dodawanie powiązanych terminów, synonimów i wariantów kontekstowych w celu zwiększenia dokładności wyszukiwania oraz trafności treści przez systemy AI. Pomaga ona pokonać różnice w słownictwie pomiędzy zapytaniami użytkowników a odpowiednimi dokumentami, zapewniając, że systemy AI, takie jak GPT czy Perplexity, mogą znaleźć i zacytować bardziej adekwatne treści. Technika ta jest niezbędna do poprawy zarówno kompletności, jak i precyzji odpowiedzi generowanych przez AI. Inteligentne rozszerzanie zapytań pozwala platformom AI znacząco poprawić sposób odnajdywania i cytowania odpowiednich źródeł.

Optymalizacja rozszerzania zapytania to proces ulepszania zapytań wyszukiwawczych użytkownika poprzez dodawanie powiązanych terminów, synonimów i wariantów kontekstowych w celu zwiększenia dokładności wyszukiwania oraz trafności treści przez systemy AI. Pomaga ona pokonać różnice w słownictwie pomiędzy zapytaniami użytkowników a odpowiednimi dokumentami, zapewniając, że systemy AI, takie jak GPT czy Perplexity, mogą znaleźć i zacytować bardziej adekwatne treści. Technika ta jest niezbędna do poprawy zarówno kompletności, jak i precyzji odpowiedzi generowanych przez AI. Inteligentne rozszerzanie zapytań pozwala platformom AI znacząco poprawić sposób odnajdywania i cytowania odpowiednich źródeł.

Optymalizacja rozszerzania zapytania to proces reformułowania i ulepszania zapytań wyszukiwawczych poprzez dodawanie powiązanych terminów, synonimów i wariantów semantycznych w celu poprawy efektywności wyszukiwania oraz jakości odpowiedzi. Podstawową funkcją rozszerzania zapytania jest rozwiązanie problemu niedopasowania słownictwa — czyli wyzwania polegającego na tym, że użytkownicy i systemy AI często używają różnych określeń na te same pojęcia, co prowadzi do pominięcia istotnych wyników. Technika ta jest kluczowa dla systemów AI, ponieważ niweluje lukę pomiędzy naturalnym sposobem wyrażania potrzeb informacyjnych przez ludzi a sposobem indeksowania i przechowywania treści. Inteligentne rozszerzanie zapytań pozwala platformom AI znacząco poprawić zarówno trafność, jak i kompletność odpowiedzi.

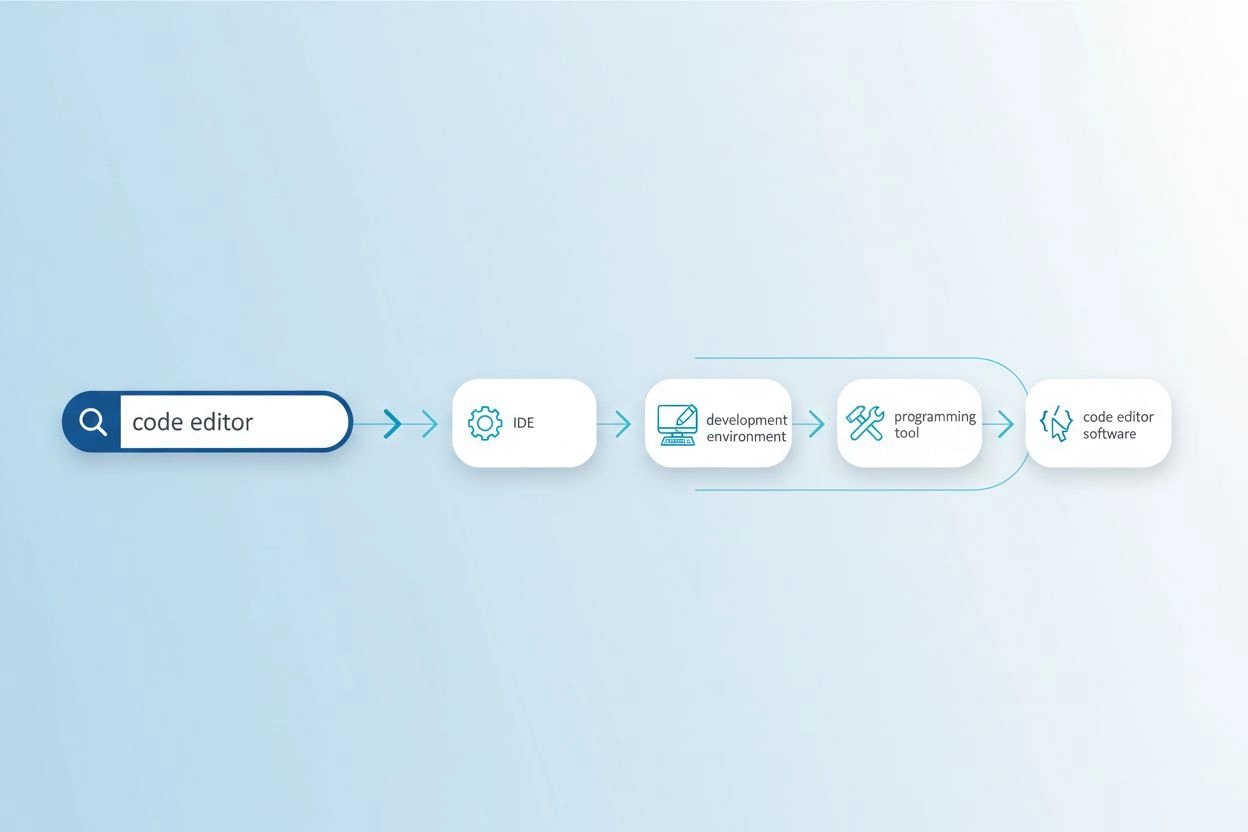

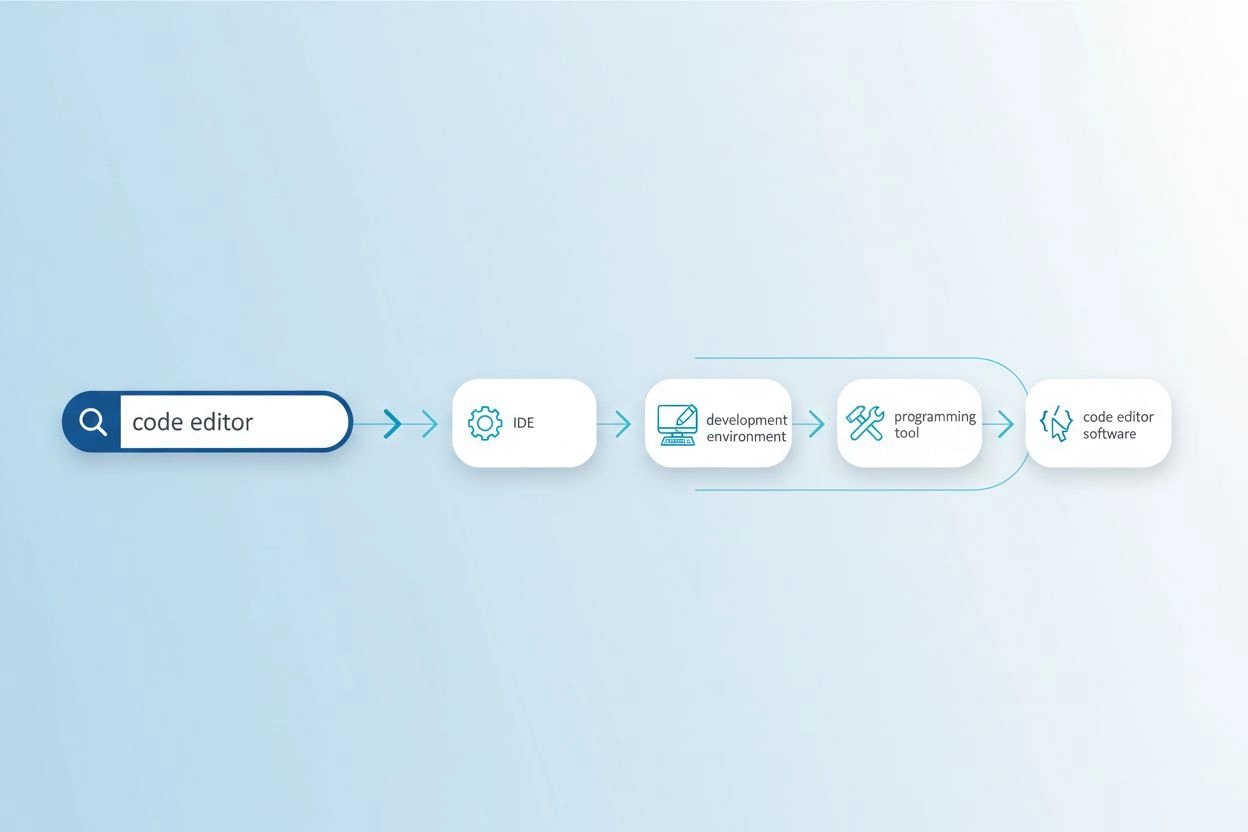

Problem niedopasowania słownictwa pojawia się, gdy słowa użyte w zapytaniu nie pokrywają się z terminologią występującą w odpowiednich dokumentach, przez co systemy wyszukiwania pomijają cenne informacje. Przykładowo, użytkownik szukający “edytor kodu” może nie znaleźć wyników dotyczących “IDE” (Zintegrowane Środowiska Programistyczne) czy “edytory tekstu”, mimo że są to trafne alternatywy. Podobnie osoba wpisująca “pojazd” może nie trafić na wyniki oznaczone jako “samochód”, “auto” czy “pojazd mechaniczny”, mimo ich oczywistego podobieństwa semantycznego. Problem ten narasta w wyspecjalizowanych dziedzinach, gdzie to samo pojęcie może być określane wieloma terminami technicznymi, a bezpośrednio wpływa na jakość generowanych przez AI odpowiedzi poprzez ograniczenie dostępnych materiałów źródłowych do syntezy. Rozszerzanie zapytania rozwiązuje ten problem, automatycznie generując powiązane warianty zapytań, które odzwierciedlają różne sposoby wyrażania tych samych informacji.

| Oryginalne zapytanie | Rozszerzone zapytanie | Wpływ |

|---|---|---|

| edytor kodu | IDE, edytor tekstu, środowisko programistyczne, edytor kodu źródłowego | Znajduje 3-5x więcej trafnych wyników |

| uczenie maszynowe | AI, sztuczna inteligencja, deep learning, sieci neuronowe | Uchwycenie wariantów terminologii branżowej |

| pojazd | samochód, auto, pojazd mechaniczny, transport | Uwzględnia popularne synonimy i terminy powiązane |

| ból głowy | migrena, napięciowy ból głowy, ulga w bólu, leczenie bólu głowy | Różnice w terminologii medycznej |

Nowoczesne rozszerzanie zapytania wykorzystuje kilka uzupełniających się technik, z których każda ma inne zalety w zależności od zastosowania i dziedziny:

Każda z technik oznacza inne kompromisy pomiędzy kosztem obliczeniowym, jakością rozszerzenia i specyfiką dziedzinową, przy czym metody LLM oferują najwyższą jakość, lecz wymagają większych zasobów.

Rozszerzanie zapytań poprawia odpowiedzi AI, dostarczając modelom językowym i systemom wyszukiwania bogatszy oraz bardziej kompletny zestaw materiałów źródłowych do generowania odpowiedzi. Gdy zapytanie zostaje rozszerzone o synonimy, powiązane pojęcia i alternatywne sformułowania, system wyszukiwania może dotrzeć do dokumentów używających innej terminologii, lecz zawierających istotne informacje, znacząco zwiększając recall procesu wyszukiwania. Rozszerzony kontekst pozwala systemom AI tworzyć pełniejsze i bardziej zniuansowane odpowiedzi, ponieważ nie są już ograniczone do słownictwa z oryginalnego zapytania. Jednak rozszerzanie zapytania wprowadza kompromis pomiędzy precyzją a kompletnością: choć rozszerzone zapytania pobierają więcej odpowiednich dokumentów, mogą też generować szum i mniej trafne wyniki, jeśli ekspansja jest zbyt agresywna. Kluczem do optymalizacji jest kalibracja intensywności rozszerzania, by maksymalizować poprawę trafności przy jednoczesnym minimalizowaniu nieistotnego szumu, co pozwala, by odpowiedzi AI były pełniejsze bez utraty dokładności.

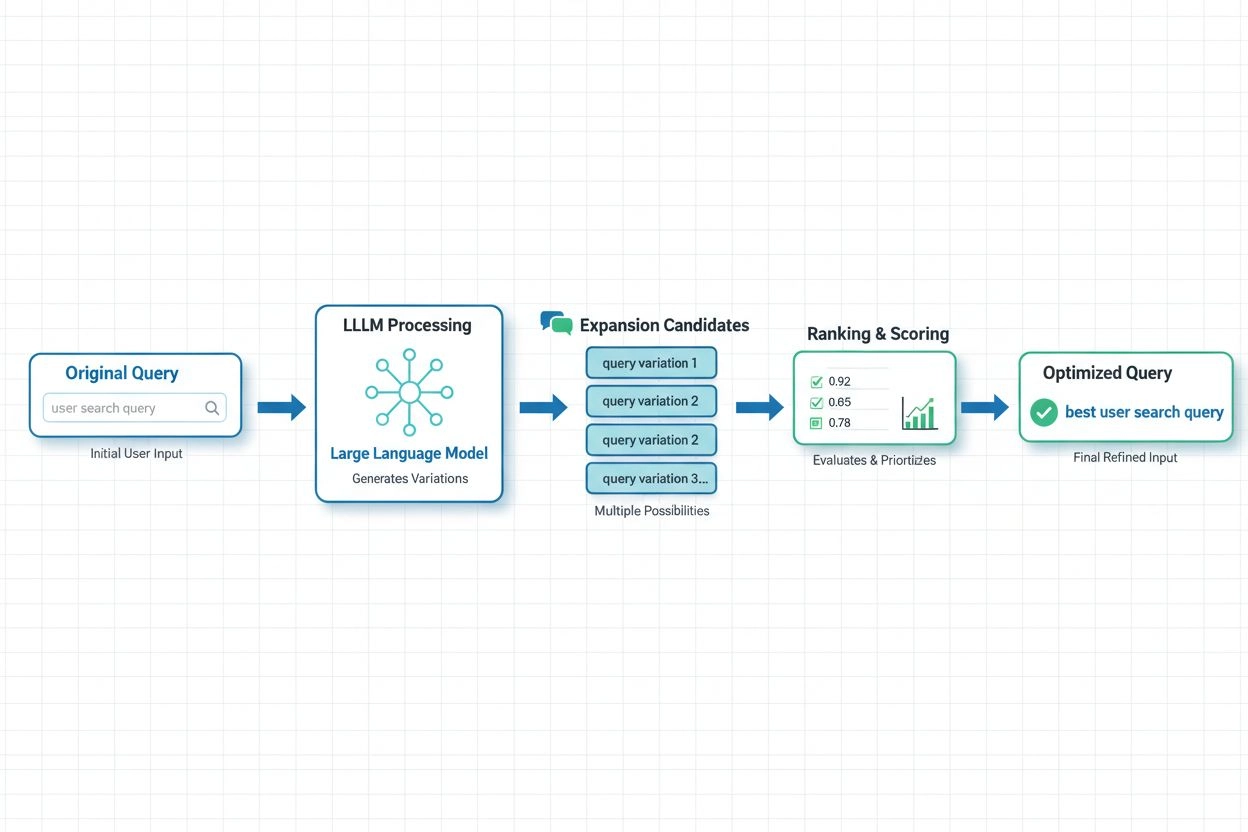

W nowoczesnych systemach AI rozszerzanie zapytań oparte na LLM stało się najbardziej zaawansowanym podejściem, wykorzystującym możliwości semantycznego rozumienia dużych modeli językowych do generowania kontekstowo odpowiednich wariantów zapytań. Najnowsze badania Spotify pokazują skuteczność tego podejścia: ich wdrożenie z użyciem technik dopasowania preferencji (łączenie metod RSFT i DPO) pozwoliło osiągnąć około 70% skrócenie czasu przetwarzania przy jednoczesnej poprawie dokładności wyszukiwania top-1. Systemy te trenują modele językowe do rozumienia preferencji i intencji użytkowników, a następnie generują rozszerzenia zgodne z tym, co użytkownicy uznają za wartościowe, a nie tylko przypadkowe synonimy. Podejścia do optymalizacji w czasie rzeczywistym nieustannie dostosowują strategie rozszerzania na podstawie opinii użytkowników i analiz skuteczności, pozwalając systemom uczyć się, jakie rozszerzenia najlepiej sprawdzają się dla konkretnych typów zapytań i dziedzin. Takie dynamiczne podejście jest szczególnie cenne dla platform monitorujących AI, ponieważ pozwala śledzić, jak rozszerzanie zapytań wpływa na dokładność cytowań i odkrywalność treści w różnych tematach i branżach.

Pomimo korzyści, rozszerzanie zapytań niesie ze sobą istotne wyzwania wymagające przemyślanych strategii optymalizacyjnych. Problem nadmiernego rozszerzania pojawia się, gdy dodaje się zbyt wiele wariantów zapytań, co wprowadza szum i pobiera nieistotne dokumenty, obniżając jakość odpowiedzi i zwiększając koszty obliczeniowe. Dostosowanie do specyfiki dziedziny jest kluczowe, ponieważ techniki skuteczne w wyszukiwaniu ogólnym mogą zawodzić w specjalistycznych obszarach, takich jak medycyna czy prawo, gdzie precyzja terminologii jest szczególnie ważna. Organizacje muszą znaleźć równowagę pomiędzy zakresem a dokładnością — rozszerzać zapytania na tyle, by uchwycić istotne warianty, nie dopuszczając do tego, by nieistotne wyniki zdominowały wyniki wyszukiwania. Efektywna walidacja obejmuje testy A/B różnych strategii rozszerzania na tle ocen trafności dokonywanych przez ludzi, monitorowanie metryk takich jak precision@k i recall@k oraz ciągłą analizę, które rozszerzenia rzeczywiście poprawiają skuteczność zadań końcowych. Najlepsze wdrożenia stosują adaptacyjne rozszerzanie, dostosowując intensywność do charakterystyki zapytania, kontekstu dziedziny i obserwowanej jakości wyszukiwania, zamiast stosować jednolite zasady dla wszystkich zapytań.

Dla AmICited.com i platform monitorujących AI optymalizacja rozszerzania zapytania jest kluczowa do dokładnego śledzenia, jak systemy AI cytują i odnoszą się do źródeł w różnych tematach i kontekstach wyszukiwania. Gdy systemy AI wewnętrznie wykorzystują rozszerzone zapytania, uzyskują dostęp do szerszego zakresu materiałów źródłowych, co bezpośrednio wpływa na to, które cytowania pojawiają się w odpowiedziach i na jaką skalę obejmują dostępne informacje. Oznacza to, że monitorowanie jakości odpowiedzi AI wymaga zrozumienia nie tylko, o co pytają użytkownicy, ale także jakich rozszerzonych wariantów zapytań system AI używa w tle do pozyskiwania informacji. Marki i twórcy treści powinni optymalizować swoją strategię poprzez stosowanie wielu wariantów terminologicznych, synonimów i powiązanych pojęć w treści, by zapewnić widoczność przy różnych formułowaniach zapytań. AmICited pomaga organizacjom śledzić to, monitorując, jak ich treści pojawiają się w odpowiedziach generowanych przez AI dla różnych typów i wariantów zapytań, wskazując miejsca, w których treści mogą być pomijane z powodu niedopasowania słownictwa oraz dostarczając informacji, jak strategie rozszerzania zapytań wpływają na wzorce cytowań i odkrywalność treści w systemach AI.

Rozszerzanie zapytania dodaje powiązane terminy i synonimy do oryginalnego zapytania, zachowując jego główny sens, natomiast przepisywanie zapytania reformułuje całe zapytanie, by lepiej dopasować je do możliwości systemu wyszukiwawczego. Rozszerzanie jest działaniem dodającym – poszerza zakres wyszukiwania – natomiast przepisywanie jest transformacją, zmieniającą sposób wyrażenia zapytania. Obie techniki poprawiają wyszukiwanie, jednak rozszerzanie jest zazwyczaj mniej ryzykowne, ponieważ zachowuje pierwotny sens zapytania.

Rozszerzanie zapytania bezpośrednio wpływa na to, jakie źródła systemy AI odkrywają i cytują, ponieważ zmienia ono dostępne dokumenty do pobrania. Gdy systemy AI wewnętrznie wykorzystują rozszerzone zapytania, mają dostęp do szerszego zakresu potencjalnych źródeł, co wpływa na to, które cytowania pojawiają się w odpowiedziach. Oznacza to, że monitorowanie jakości odpowiedzi AI wymaga zrozumienia nie tylko, o co pytają użytkownicy, ale też jakich rozszerzonych wariantów zapytań system AI może używać w tle.

Tak, nadmierne rozszerzanie może wprowadzić szum i pobierać nieistotne dokumenty, co obniża jakość odpowiedzi. Dzieje się tak, gdy dodaje się zbyt wiele wariantów zapytań bez odpowiedniej filtracji. Kluczem jest wyważenie intensywności rozszerzania, by zmaksymalizować trafność, a jednocześnie zminimalizować nieistotny szum. Skuteczne wdrożenia stosują adaptacyjne rozszerzanie, które dostosowuje intensywność na podstawie charakterystyki zapytania i obserwowanej jakości wyszukiwania.

Duże modele językowe zrewolucjonizowały rozszerzanie zapytań, umożliwiając semantyczne rozumienie intencji użytkownika i generowanie kontekstowo odpowiednich wariantów zapytań. Rozszerzanie oparte na LLM wykorzystuje techniki dopasowania preferencji, by trenować modele do generowania rozszerzeń, które rzeczywiście poprawiają wyniki wyszukiwania, zamiast po prostu dodawać przypadkowe synonimy. Ostatnie badania pokazują, że podejścia oparte na LLM mogą skrócić czas przetwarzania o ~70% i jednocześnie poprawić dokładność wyszukiwania.

Marki powinny stosować różne warianty terminologii, synonimy i powiązane koncepcje w swoich treściach, aby zapewnić widoczność przy różnych formułowaniach zapytań. Oznacza to, że należy rozważyć, jak materiały mogą być odkrywane poprzez rozszerzanie zapytań – używać zarówno terminów technicznych, jak i potocznych, alternatywnych sformułowań oraz poruszać pokrewne tematy. Taka strategia zapewnia, że treści będą znajdowane niezależnie od wariantów zapytań wykorzystywanych przez systemy AI.

Kluczowe metryki to precision@k (trafność najlepszych k wyników), recall@k (pokrycie istotnych treści w najlepszych k wynikach), Mean Reciprocal Rank (pozycja pierwszego istotnego wyniku) oraz efektywność zadań końcowych. Organizacje monitorują także czas przetwarzania, koszty obliczeniowe i poziom satysfakcji użytkowników. Najbardziej wiarygodną walidację zapewniają testy A/B różnych strategii rozszerzania w zestawieniu z ocenami trafności dokonanymi przez ludzi.

Nie, to techniki komplementarne, ale odmienne. Rozszerzanie zapytania modyfikuje zapytanie wejściowe w celu poprawy wyszukiwania, podczas gdy wyszukiwanie semantyczne wykorzystuje osadzenia i reprezentacje wektorowe do znajdowania koncepcyjnie podobnych treści. Rozszerzanie zapytania może być elementem procesu wyszukiwania semantycznego, lecz wyszukiwanie semantyczne może działać także bez jawnego rozszerzania zapytań. Obie techniki rozwiązują problem niedopasowania słownictwa, ale różnymi metodami.

AmICited śledzi, jak systemy AI cytują i odnoszą się do źródeł w różnych tematach i kontekstach wyszukiwania, pokazując, które rozszerzone zapytania prowadzą do wzmianki o Twojej marce. Monitorując wzorce cytowań w różnych typach zapytań i rozszerzeniach, AmICited dostarcza informacji o tym, jak strategie rozszerzania zapytań wpływają na odkrywalność treści i dokładność cytowania w systemach AI, takich jak GPT i Perplexity.

Optymalizacja rozszerzania zapytania wpływa na to, jak systemy AI, takie jak GPT i Perplexity, odkrywają i cytują Twoje treści. Skorzystaj z AmICited, aby śledzić, które rozszerzone zapytania prowadzą do wzmianki o Twojej marce w odpowiedziach AI.

Dowiedz się, jak działa rozwinięcie zapytania w systemach wyszukiwania AI. Odkryj, jak AI rozszerza pojedyncze zapytania na wiele podzapytań, by poprawić trafno...

Dowiedz się, jak Rozszerzanie FAQ rozwija kompleksowe pary pytanie-odpowiedź dla systemów AI. Poznaj strategie poprawy cytowań przez AI, optymalizacji pod konkr...

Udoskonalanie zapytań to iteracyjny proces optymalizacji zapytań wyszukiwania dla lepszych wyników w wyszukiwarkach AI. Dowiedz się, jak działa w ChatGPT, Perpl...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.