Czym jest wyszukiwanie w czasie rzeczywistym w AI?

Dowiedz się, jak działa wyszukiwanie w czasie rzeczywistym w AI, jakie korzyści przynosi użytkownikom i firmom oraz czym różni się od tradycyjnych wyszukiwarek ...

API, które dostarczają systemom AI aktualizacje treści na bieżąco dla informacji wrażliwych na czas, umożliwiając natychmiastowy dostęp do świeżych danych poprzez utrzymywane połączenia strumieniowe. Te API dostarczają informacje w milisekundach zamiast wymagać okresowego odpytywania, zapewniając modelom AI zawsze najnowszy kontekst do podejmowania trafnych decyzji i generowania odpowiedzi.

API, które dostarczają systemom AI aktualizacje treści na bieżąco dla informacji wrażliwych na czas, umożliwiając natychmiastowy dostęp do świeżych danych poprzez utrzymywane połączenia strumieniowe. Te API dostarczają informacje w milisekundach zamiast wymagać okresowego odpytywania, zapewniając modelom AI zawsze najnowszy kontekst do podejmowania trafnych decyzji i generowania odpowiedzi.

API treści w czasie rzeczywistym to interfejs programowania aplikacji, który dostarcza systemom AI aktualizacje treści i informacji natychmiast po ich pojawieniu się, umożliwiając niezwłoczny dostęp do danych wrażliwych na czas bez opóźnień. W przeciwieństwie do tradycyjnych API opartych na schemacie żądanie-odpowiedź, które wymagają od klientów okresowego odpytywania w poszukiwaniu nowych danych, API treści w czasie rzeczywistym ustanawiają trwałe połączenia, przez które nowe informacje są natychmiast przesyłane do systemów AI w momencie ich wygenerowania lub aktualizacji. Takie API są kluczowe dla nowoczesnych aplikacji AI wymagających aktualnego kontekstu, takich jak duże modele językowe (LLM), agenci AI czy systemy retrieval-augmented generation (RAG). Dostarczając świeże i istotne treści w milisekundach, zapewniają systemom AI możliwość podejmowania świadomych decyzji na podstawie najnowszych dostępnych informacji, a nie przestarzałych danych.

API treści w czasie rzeczywistym działają na zupełnie innych zasadach niż tradycyjne REST API, stawiając na ciągłe dostarczanie danych zamiast cykli żądanie-odpowiedź. Ich architektura opiera się na trwałych połączeniach utrzymywanych pomiędzy klientem (systemem AI) a serwerem, co pozwala na przepływ danych dwukierunkowy lub jednokierunkowy, w zależności od protokołu. Te API wykorzystują architekturę zdarzeniową, w której aktualizacje są przesyłane natychmiast po pojawieniu się nowej treści, zamiast czekać na zaplanowane zadania wsadowe. Wdrożenia techniczne kładą nacisk na dostarczanie o niskich opóźnieniach, zwykle mierzonych w milisekundach, gwarantując, że systemy AI otrzymują informacje z minimalnym opóźnieniem. Skalowalność zapewniona jest przez rozproszone platformy strumieniowe, które mogą obsługiwać miliony jednoczesnych połączeń i przetwarzać ogromne ilości danych jednocześnie.

| Cechy | API treści w czasie rzeczywistym | Tradycyjne REST API | Przetwarzanie wsadowe |

|---|---|---|---|

| Typ połączenia | Trwałe/Strumieniowe | Żądanie-Odpowiedź | Zaplanowane zadania |

| Dostarczanie danych | Push (inicjowane przez serwer) | Pull (inicjowane przez klienta) | Okresowe paczki |

| Opóźnienie | Milisekundy | Sekundy do minut | Godziny do dni |

| Świeżość danych | Zawsze aktualne | Zależna od odpytywania | Znacznie opóźnione |

| Skalowalność | Wysoka równoczesność | Ograniczone połączenia | Zależne od wsadów |

| Zastosowanie | AI w czasie rzeczywistym, aktualizacje na żywo | Standardowe usługi webowe | Analizy, raportowanie |

| Model kosztowy | Na podstawie połączeń | Na podstawie żądań | Na podstawie mocy obliczeniowej |

Przepływ działania API treści w czasie rzeczywistym rozpoczyna się od pobrania danych, gdzie treści z różnych źródeł — baz danych, kolejek komunikatów, zewnętrznych API czy zdarzeń generowanych przez użytkowników — są przechwytywane i normalizowane do ustandaryzowanego formatu. Po pobraniu dane trafiają do potoku przetwarzania, gdzie mogą zostać wzbogacone, przefiltrowane lub przekształcone w celu nadania kontekstu i istotności dla systemów AI. Przetworzona treść udostępniana jest następnie przez punkty końcowe strumieniowania, które utrzymują otwarte połączenia z subskrybującymi klientami AI. Gdy pojawi się nowa lub zaktualizowana treść, API natychmiast przekazuje ją przez trwałe połączenia do wszystkich zainteresowanych odbiorców. Taka architektura eliminuje potrzebę wielokrotnego odpytywania przez systemy AI, zmniejszając obciążenie sieci i zapewniając, że kluczowe informacje docierają do modeli AI w ciągu milisekund od ich pojawienia się. Cały proces zaprojektowany jest z myślą o odporności na błędy, z mechanizmami obsługi awarii połączeń, gwarancją dostarczenia wiadomości i utrzymaniem spójności danych w rozproszonych systemach.

Znaczenia świeżości danych w systemach AI nie można przecenić, ponieważ dokładność i trafność wyników AI bezpośrednio zależą od aktualności dostępnych informacji. Gdy systemy AI, takie jak LLM czy agenci AI, operują na nieaktualnych danych, ryzykują udzielaniem błędnych rekomendacji, pominięciem istotnego kontekstu lub podejmowaniem decyzji w oparciu o nieaktualne fakty. API treści w czasie rzeczywistym rozwiązują ten problem, zapewniając systemom AI stały dostęp do najnowszych dostępnych informacji, umożliwiając tym samym udzielanie trafniejszych odpowiedzi i podejmowanie lepiej uzasadnionych decyzji. W aplikacjach takich jak handel finansowy, wykrywanie oszustw czy rekomendacje personalizowane, nawet opóźnienie rzędu sekund może prowadzić do poważnych błędów lub utraty okazji. Dzięki ciągłemu dostępowi do świeżych danych, API treści w czasie rzeczywistym pozwalają systemom AI rozumieć aktualny stan świata, adaptować się do zmieniających się warunków i generować odpowiedzi odzwierciedlające najnowsze wydarzenia. Ta świeżość jest szczególnie istotna dla systemów retrieval-augmented generation (RAG), gdzie jakość pobranego kontekstu bezpośrednio wpływa na jakość generowanych odpowiedzi.

API treści w czasie rzeczywistym wykorzystują szereg kluczowych protokołów i technologii strumieniowania, z których każdy jest zoptymalizowany pod inne zastosowania i wymagania:

WebSockets: Umożliwia komunikację pełnodupleksową przez jedno połączenie TCP, zapewniając dwukierunkową wymianę danych w czasie rzeczywistym. Idealne do aplikacji interaktywnych wymagających niskich opóźnień i komunikacji dwukierunkowej między klientem a serwerem.

Server-Sent Events (SSE): Pozwala serwerom przesyłać dane do klientów przez połączenia HTTP w sposób jednokierunkowy. Prostsze we wdrożeniu niż WebSockets i dobrze sprawdza się tam, gdzie potrzebne są tylko aktualizacje od serwera do klienta.

gRPC: Wysokowydajny framework RPC wykorzystujący Protocol Buffers do wydajnej serializacji. Wspiera różne tryby strumieniowania i jest szczególnie skuteczny w komunikacji mikroserwisów oraz obsłudze modeli AI.

Apache Kafka: Rozproszona platforma strumieniowania, działająca jako broker wiadomości i umożliwiająca niezawodne, skalowalne przesyłanie zdarzeń. Często stanowi kręgosłup potoków danych w czasie rzeczywistym dostarczających treści do systemów AI.

MQTT: Lekki protokół publish-subscribe zaprojektowany dla IoT i aplikacji mobilnych. Pozwala na efektywne gospodarowanie przepustowością i jest idealny dla środowisk o ograniczonych zasobach sieciowych.

AMQP: Zaawansowany protokół kolejkowania wiadomości zapewniający niezawodne dostarczanie z obsługą złożonych wzorców routingu. Odpowiedni dla zastosowań korporacyjnych wymagających gwarantowanego dostarczenia wiadomości i wsparcia dla transakcji.

API treści w czasie rzeczywistym umożliwiają szeroką gamę zastosowań AI zależnych od aktualnych informacji. Systemy retrieval-augmented generation (RAG) korzystają z tych API do pobierania najnowszych dokumentów, artykułów lub wpisów baz wiedzy, zapewniając, że generowane odpowiedzi zawierają najbardziej aktualne informacje. Agenci AI wykorzystują API w czasie rzeczywistym do dostępu do bieżących danych rynkowych, stanów magazynowych, informacji o klientach i wskaźników operacyjnych, umożliwiając podejmowanie szybkich decyzji i adekwatnych działań. Silniki personalizacyjne używają API treści w czasie rzeczywistym do śledzenia zachowań użytkowników, preferencji i kontekstu, pozwalając systemom AI na dostarczanie spersonalizowanych doświadczeń dostosowanych do zmieniających się potrzeb. Systemy wykrywania oszustw polegają na tych API, by uzyskiwać dane o transakcjach, profilach użytkowników i wzorcach historycznych, umożliwiając natychmiastowe wykrywanie podejrzanych działań. Systemy rekomendacyjne wykorzystują API w czasie rzeczywistym do uwzględniania aktualnych trendów, interakcji użytkowników i informacji kontekstowych, zapewniając, że rekomendacje są zawsze trafne i aktualne. Chatboty i konwersacyjne AI korzystają z dostępu do baz wiedzy, FAQ i informacji produktowych w czasie rzeczywistym, zapewniając precyzyjne i aktualne odpowiedzi na zapytania użytkowników.

API treści w czasie rzeczywistym odgrywają kluczową rolę w zapewnianiu widoczności i monitoringu AI, umożliwiając organizacjom śledzenie, jak systemy AI uzyskują dostęp do treści, przetwarzają je i wykorzystują. Dzięki wyposażeniu tych API w funkcje monitorujące, organizacje mogą obserwować, jakie treści są pobierane przez systemy AI, jak często uzyskują dostęp do konkretnych informacji i jak te treści wpływają na wyniki AI. Taka widoczność jest niezbędna do zrozumienia zachowania AI, zapewnienia zgodności z politykami zarządzania danymi oraz wykrywania sytuacji, w których AI korzysta z przestarzałych lub nieprawidłowych informacji. Śledzenie atrybucji treści przez API w czasie rzeczywistym pozwala organizacjom zidentyfikować, z jakich źródeł systemy AI korzystają do generowania odpowiedzi, wspierając przejrzystość i odpowiedzialność. Monitoring w czasie rzeczywistym wzorców użycia API pomaga wykrywać wąskie gardła wydajności, optymalizować dostarczanie danych i zapewniać systemom AI dostęp do niezbędnych informacji. Dla organizacji korzystających z platform takich jak AmICited.com, API treści w czasie rzeczywistym stanowią fundament monitorowania, jak systemy AI, takie jak ChatGPT, Perplexity czy Google AI Overviews, odnoszą się do i cytują treści marki, umożliwiając obserwację odniesień i cytowań generowanych przez AI w czasie rzeczywistym.

Różnica między API treści w czasie rzeczywistym a przetwarzaniem wsadowym stanowi fundamentalną zmianę w sposobie dostarczania danych do systemów AI. Przetwarzanie wsadowe polega na gromadzeniu danych przez pewien czas i przetwarzaniu ich w zaplanowanych odstępach, zazwyczaj kilka godzin lub dni później, co sprawia, że nadaje się ono do analiz historycznych i raportowania, ale nie do aplikacji AI wymagających natychmiastowej reakcji. API treści w czasie rzeczywistym, w przeciwieństwie do tego, dostarczają dane natychmiast po ich pojawieniu się, umożliwiając systemom AI reagowanie na bieżące warunki i podejmowanie decyzji na podstawie najnowszych informacji. W zastosowaniach AI wymagających natychmiastowych odpowiedzi — takich jak wykrywanie oszustw, systemy handlu czy chatboty obsługi klienta — opóźnienia przetwarzania wsadowego są nieakceptowalne. API w czasie rzeczywistym umożliwiają także ciągłe uczenie się i adaptację, pozwalając systemom AI dostosowywać swoje działanie na podstawie natychmiastowej informacji zwrotnej i zmian otoczenia. Choć przetwarzanie wsadowe świetnie sprawdza się w efektywnym analizowaniu dużych zbiorów danych historycznych, API treści w czasie rzeczywistym są niezbędne w aplikacjach, gdzie liczy się szybkość i dokładność. Wiele nowoczesnych architektur AI wykorzystuje podejście hybrydowe, łącząc API w czasie rzeczywistym do natychmiastowego podejmowania decyzji z przetwarzaniem wsadowym do głębokiej analizy i treningu modeli na danych historycznych.

Wdrażanie API treści w czasie rzeczywistym dla systemów AI niesie za sobą szereg wyzwań technicznych i operacyjnych. Skalowalność pozostaje kluczowym aspektem, ponieważ utrzymywanie milionów jednoczesnych połączeń przy zachowaniu spójnej wydajności wymaga zaawansowanej infrastruktury i przemyślanego zarządzania zasobami. Spójność danych w rozproszonych systemach staje się bardziej złożona w środowiskach czasu rzeczywistego, gdzie konieczne jest zapewnienie, że wszystkie systemy AI otrzymują aktualizacje w odpowiedniej kolejności i bez duplikatów. Obsługa błędów i odporność są kluczowe, ponieważ awarie sieci, przerwy w działaniu czy uszkodzenie danych mogą wpływać na wydajność AI; niezbędne są solidne mechanizmy odzyskiwania połączeń, ponownego przesyłania wiadomości i synchronizacji stanu. Koszty mogą być znaczne, ponieważ infrastruktura strumieniowa zwykle wymaga większych zasobów niż przetwarzanie wsadowe, choć wartość wynikająca z poprawy dokładności i reaktywności AI często uzasadnia inwestycję. Bezpieczeństwo i kontrola dostępu muszą być starannie wdrożone, aby zapewnić, że systemy AI mają dostęp wyłącznie do autoryzowanych treści i że wrażliwe informacje są chronione podczas transmisji. Monitoring i obserwowalność zyskują na znaczeniu w systemach czasu rzeczywistego, gdzie szybkie przepływy danych i złożone interakcje wymagają kompleksowego wglądu w zachowanie i wydajność systemów.

Istnieje wiele dojrzałych platform i technologii umożliwiających organizacjom budowę i wdrażanie API treści w czasie rzeczywistym dla systemów AI. Confluent oferuje kompleksową platformę strumieniowania danych opartą na Apache Kafka, zapewniającą zarządzane usługi do pobierania, przetwarzania i udostępniania danych w czasie rzeczywistym aplikacjom AI dzięki funkcjom Real-Time Context Engine i Confluent Intelligence. Tinybird specjalizuje się w przetwarzaniu danych w czasie rzeczywistym i generowaniu API, umożliwiając organizacjom pobieranie strumieniowanych danych i natychmiastowe wystawianie ich przez API o niskich opóźnieniach odpowiednich do zastosowań AI. Realtime API OpenAI pozwala na bezpośrednią komunikację w czasie rzeczywistym z modelami AI, wspierając interakcje głos-głos i wejścia multimodalne przy minimalnych opóźnieniach. Apache Kafka pozostaje branżowym standardem dla rozproszonego strumieniowania zdarzeń, stanowiąc fundament dla wielu potoków danych w czasie rzeczywistym. AmICited.com wyróżnia się jako wiodąca platforma do monitoringu i widoczności AI, wykorzystując API treści w czasie rzeczywistym do śledzenia, jak systemy AI odnoszą się do i cytują treści marki w ChatGPT, Perplexity, Google AI Overviews i innych platformach AI. Te platformy wspólnie umożliwiają organizacjom budowanie zaawansowanych systemów AI, które wykorzystują treści w czasie rzeczywistym dla zwiększenia dokładności, responsywności i jakości podejmowanych decyzji.

API treści w czasie rzeczywistym ustanawiają trwałe połączenia, które przekazują dane do klientów w momencie ich dostępności, podczas gdy tradycyjne REST API wymagają od klientów wysyłania zapytań i oczekiwania na odpowiedzi. API treści w czasie rzeczywistym dostarczają informacje w milisekundach, oferując ciągłe aktualizacje, podczas gdy REST API charakteryzują się większymi opóźnieniami i wymagają odpytywania w poszukiwaniu nowych danych. Sprawia to, że API w czasie rzeczywistym są idealne dla systemów AI potrzebujących bieżących informacji, natomiast REST API lepiej sprawdzają się w standardowych usługach internetowych.

Systemy AI, takie jak LLM i agenci AI, podejmują decyzje na podstawie dostępnych im informacji. Nieaktualne lub przestarzałe dane mogą prowadzić do niedokładnych odpowiedzi, utraty szans oraz błędnych decyzji. API treści w czasie rzeczywistym zapewniają, że systemy AI zawsze mają dostęp do najbardziej aktualnych informacji, co umożliwia im udzielanie trafnych odpowiedzi, rozumienie bieżących warunków i adaptację do zmieniających się okoliczności. Jest to szczególnie istotne w aplikacjach takich jak wykrywanie oszustw, handel czy spersonalizowane rekomendacje, gdzie opóźnienia mogą skutkować poważnymi błędami.

Typowe protokoły to WebSockets do komunikacji dwukierunkowej, Server-Sent Events (SSE) do jednokierunkowych aktualizacji serwer-klient, gRPC do wydajnej komunikacji mikroserwisów, Apache Kafka do rozproszonego strumieniowania zdarzeń, MQTT dla aplikacji IoT oraz AMQP do komunikatów korporacyjnych. Każdy protokół ma swoje zalety i jest zoptymalizowany pod konkretne zastosowania – od aplikacji interaktywnych po duże strumienie danych.

API treści w czasie rzeczywistym poprawiają dokładność, zapewniając modelom AI dostęp do najbardziej aktualnych i istotnych informacji podczas generowania odpowiedzi. Jest to szczególnie ważne w systemach retrieval-augmented generation (RAG), gdzie jakość pobranego kontekstu bezpośrednio wpływa na jakość odpowiedzi. Dzięki świeżym danym systemy AI mogą udzielać bardziej trafnych rekomendacji, skuteczniej wykrywać oszustwa i podejmować lepsze decyzje na podstawie aktualnych, a nie przestarzałych informacji.

Kluczowe wyzwania to zarządzanie skalowalnością przy milionach jednoczesnych połączeń, zapewnienie spójności danych w rozproszonych systemach, wdrażanie solidnych mechanizmów obsługi błędów i odzyskiwania, kontrola kosztów infrastruktury w czasie rzeczywistym, zabezpieczenie wrażliwych danych podczas transmisji oraz utrzymanie kompleksowego monitoringu i obserwowalności. Wymaga to zaawansowanej infrastruktury, przemyślanej architektury i ciągłego zarządzania operacyjnego.

API treści w czasie rzeczywistym umożliwiają organizacjom śledzenie, do jakich treści mają dostęp systemy AI, jak często pobierają konkretne informacje oraz jak te treści wpływają na wyniki działania AI. Poprzez wyposażenie API w funkcje monitorujące organizacje mogą obserwować zachowanie AI, zapewniać zgodność z politykami zarządzania danymi, śledzić atrybucję treści i rozumieć, na jakich źródłach opierają się systemy AI. Taka widoczność jest kluczowa dla przejrzystości, odpowiedzialności i zrozumienia wydajności systemów AI.

API treści w czasie rzeczywistym zwykle wymagają więcej zasobów infrastrukturalnych niż przetwarzanie wsadowe, ponieważ muszą utrzymywać trwałe połączenia i dostarczać dane z minimalnym opóźnieniem. Jednak wartość wynikająca z poprawy dokładności AI, szybszego podejmowania decyzji i lepszego doświadczenia użytkownika często uzasadnia wyższe koszty. Wiele organizacji stosuje podejście hybrydowe, wykorzystując API w czasie rzeczywistym do natychmiastowych decyzji, a przetwarzanie wsadowe do głębszych analiz i trenowania modeli na danych historycznych.

AmICited.com wykorzystuje API treści w czasie rzeczywistym, aby monitorować, jak systemy AI, takie jak ChatGPT, Perplexity i Google AI Overviews, odnoszą się do treści marki i je cytują. Platforma zapewnia widoczność w czasie rzeczywistym odniesień generowanych przez AI, cytowań oraz atrybucji treści, umożliwiając organizacjom śledzenie, jak ich treści wykorzystywane są przez systemy AI. Ten monitoring w czasie rzeczywistym pomaga markom zrozumieć swoją obecność w wynikach AI i zapewnić właściwe przedstawienie na różnych platformach AI.

Śledź i monitoruj, jak systemy AI, takie jak ChatGPT, Perplexity i Google AI Overviews cytują i odnoszą się do Twojej marki z platformą monitoringu treści w czasie rzeczywistym AmICited.com.

Dowiedz się, jak działa wyszukiwanie w czasie rzeczywistym w AI, jakie korzyści przynosi użytkownikom i firmom oraz czym różni się od tradycyjnych wyszukiwarek ...

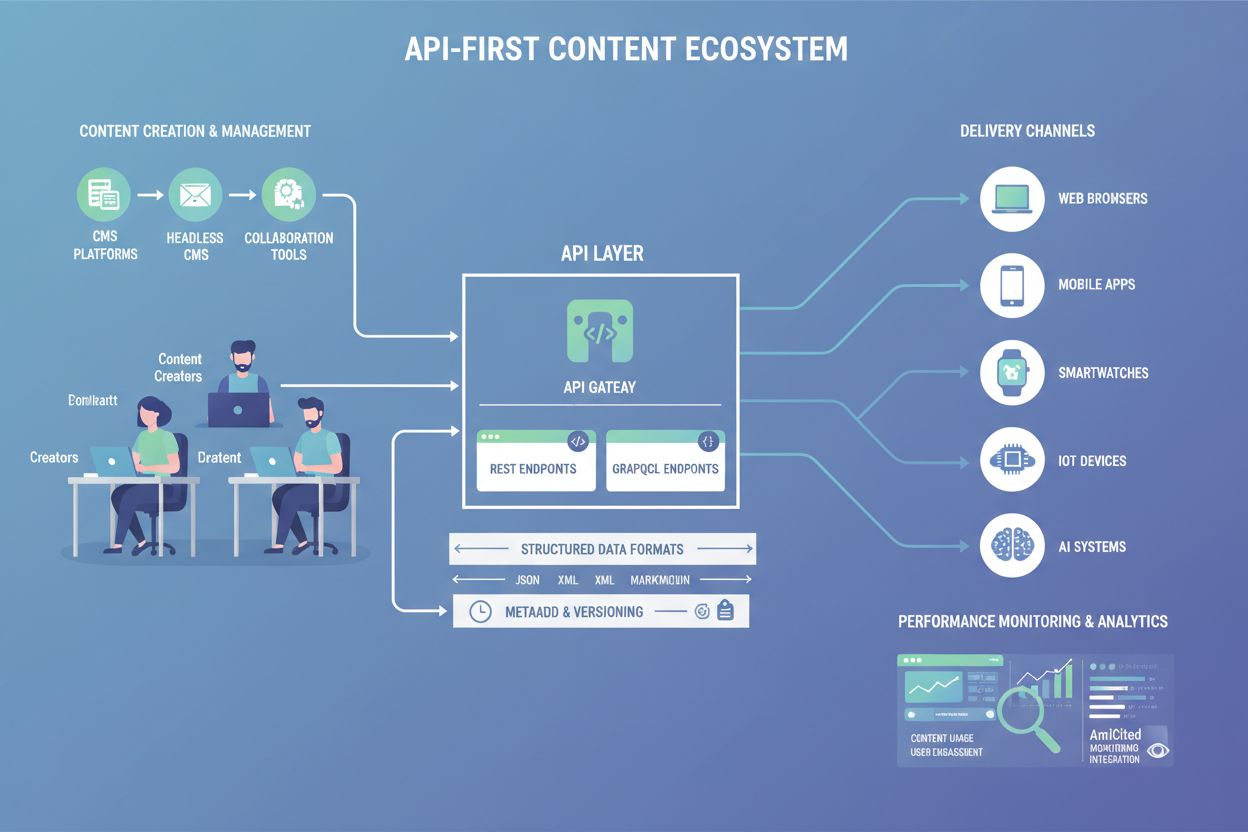

Dowiedz się, czym jest Treść API-First, jak umożliwia widoczność dla AI i dlaczego jest ważna dla architektury treści. Odkryj, jak uporządkowane API poprawiają ...

Dowiedz się, jak dane w czasie rzeczywistym i sztuczna inteligencja zmieniają zarządzanie zapasami. Poznaj wymagania dotyczące danych, technologie i najlepsze p...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.