Wykrywanie spamu

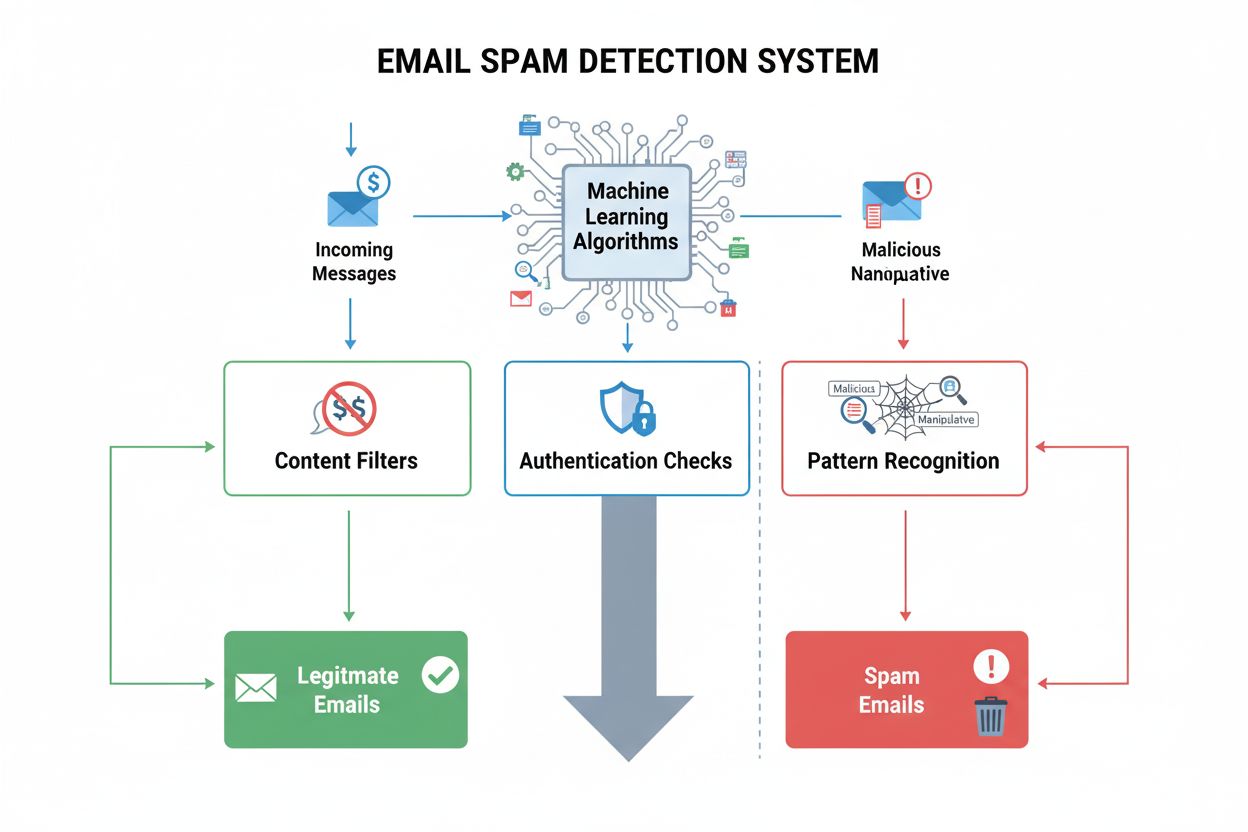

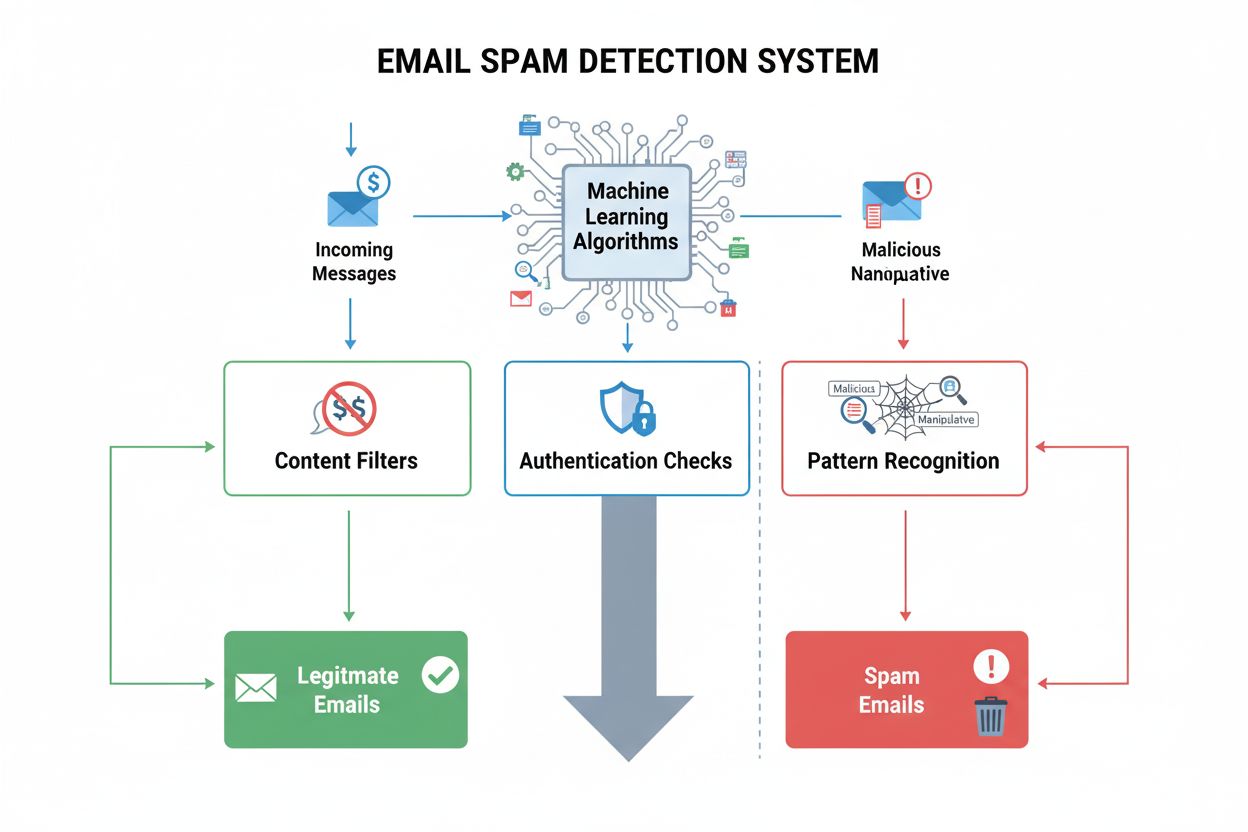

Wykrywanie spamu identyfikuje niechciane, manipulacyjne treści przy użyciu algorytmów ML i analizy behawioralnej. Dowiedz się, jak systemy AI filtrują spam w e-...

Spam wyszukiwarek odnosi się do celowych taktyk manipulacyjnych stosowanych w celu sztucznego wpływania na pozycje w wyszukiwarkach za pomocą zwodniczych technik naruszających wytyczne wyszukiwarek. Praktyki te obejmują upychanie słów kluczowych, cloaking, farmy linków i ukryty tekst, mające na celu oszukanie algorytmów zamiast dostarczania rzeczywistej wartości użytkownikom.

Spam wyszukiwarek odnosi się do celowych taktyk manipulacyjnych stosowanych w celu sztucznego wpływania na pozycje w wyszukiwarkach za pomocą zwodniczych technik naruszających wytyczne wyszukiwarek. Praktyki te obejmują upychanie słów kluczowych, cloaking, farmy linków i ukryty tekst, mające na celu oszukanie algorytmów zamiast dostarczania rzeczywistej wartości użytkownikom.

Spam wyszukiwarek, znany również jako spamdexing, odnosi się do celowego manipulowania indeksami wyszukiwarek za pomocą zwodniczych technik mających sztucznie podnieść pozycję strony w rankingach. Termin ten obejmuje szeroki zakres nieetycznych praktyk naruszających wytyczne wyszukiwarek, takich jak upychanie słów kluczowych, cloaking, farmy linków, ukryty tekst oraz podstępne przekierowania. Tego typu działania mają na celu oszukanie algorytmów wyszukiwarek, zamiast dostarczania rzeczywistej wartości użytkownikom, przez co fundamentalnie podważają wiarygodność wyników wyszukiwania. Gdy wyszukiwarki wykrywają spam na stronie, zazwyczaj nakładają kary – od obniżenia pozycji po całkowite usunięcie z indeksów, co sprawia, że strona staje się niewidoczna dla potencjalnych odwiedzających.

Spam wyszukiwarek istnieje od początków internetu, kiedy algorytmy wyszukiwarek były mniej zaawansowane i łatwiejsze do manipulacji. W latach 90. i na początku XXI wieku techniki spamdexingu rozprzestrzeniły się, gdy webmasterzy odkryli, że mogą sztucznie poprawić pozycje przez proste powtarzanie słów kluczowych i manipulacje linkami. Wraz z rozwojem wyszukiwarek – szczególnie po wprowadzeniu przez Google algorytmu PageRank oraz późniejszych aktualizacji, takich jak Panda (2011) i Penguin (2012) – wykrywanie i karanie spamu stało się coraz bardziej zaawansowane. Pojawienie się SpamBrain – opartego na AI systemu Google do zwalczania spamu, wprowadzonego w 2022 roku – oznaczało istotną zmianę w kierunku wykrywania spamu przy użyciu uczenia maszynowego. Obecnie wyszukiwarki stosują zaawansowane algorytmy analizujące setki czynników rankingowych, przez co tradycyjne techniki spamerskie są w większości nieskuteczne, choć jednocześnie pojawiają się nowe, bardziej wyrafinowane próby manipulacji.

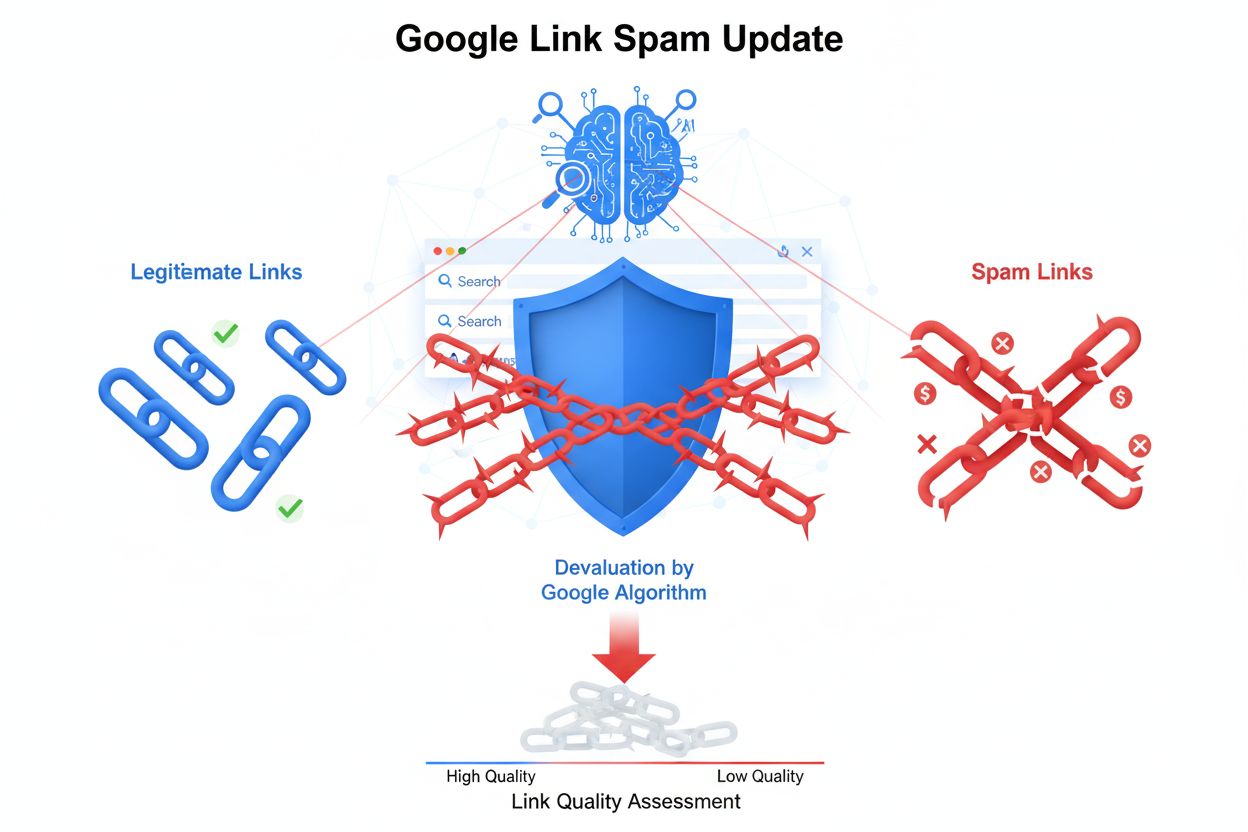

Upychanie słów kluczowych pozostaje jedną z najbardziej rozpoznawalnych technik spamu – polega na nienaturalnym powtarzaniu fraz kluczowych w treści strony, metatagach i ukrytych elementach. Zabieg ten sztucznie zawyża gęstość słów kluczowych bez dostarczania wartościowych czy spójnych informacji dla czytelnika. Cloaking to bardziej zaawansowana forma oszustwa, gdzie inne treści prezentowane są robotom wyszukiwarki, a inne użytkownikom – zwykle przy użyciu JavaScript lub technik serwerowych, które rozpoznają, czy odwiedzający to człowiek czy bot. Farmy linków i Private Blog Networks (PBNs) to kolejna kategoria spamu – sieci niskiej jakości stron stworzonych wyłącznie w celu generowania sztucznych linków prowadzących do wybranych witryn. Sieci te wykorzystują fakt, że wyszukiwarki historycznie mocno uwzględniały linki zwrotne jako sygnał rankingowy, choć nowoczesne algorytmy coraz lepiej rozpoznają i dewaluuują takie sztuczne schematy linkowania.

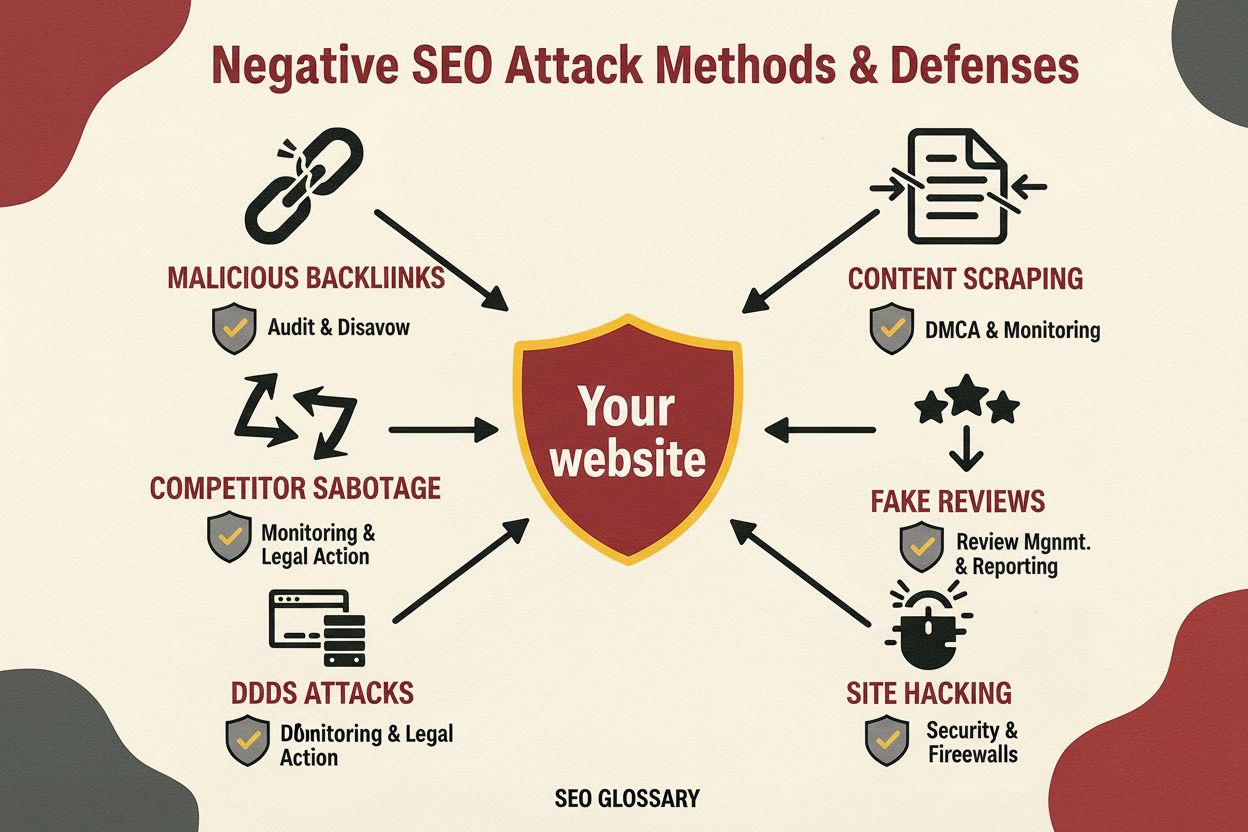

Podstępne przekierowania manipulują zachowaniem użytkownika, kierując go na inne adresy URL niż te, które indeksują wyszukiwarki – często po kliknięciu w wynik zostaje on przekierowany na nieistotne lub złośliwe treści. Ukryty tekst i linki polegają na umieszczaniu treści w kolorze tła, bardzo małą czcionką lub poza widocznym obszarem strony – są one niewidoczne dla użytkownika, ale widoczne dla robotów wyszukiwarek. Spam komentarzy i spam na forach wykorzystują platformy z treściami tworzonymi przez użytkowników do automatycznego publikowania linków i treści promocyjnych na blogach, forach i w mediach społecznościowych. Scraping treści polega na kopiowaniu materiałów z innych stron bez zgody lub modyfikacji i publikowaniu ich w celu sztucznego powiększenia zawartości strony i przechwytywania ruchu z wyszukiwarki. Każda z tych technik ma na celu oszukanie algorytmów, a nie zdobycie pozycji uczciwymi metodami.

| Aspekt | Spam wyszukiwarek (Black Hat) | Legalne SEO (White Hat) | Gray Hat SEO |

|---|---|---|---|

| Główny cel | Manipulowanie algorytmami przez oszustwo | Dostarczanie wartości użytkownikom i naturalne zdobywanie pozycji | Wykorzystywanie niejasnych zapisów wytycznych |

| Jakość treści | Niska, upychana słowami kluczowymi lub kopiowana | Wysoka, oryginalna, skupiona na użytkowniku | Mieszana, z elementami wątpliwymi |

| Link building | Sztuczne linki z farm, PBN lub przejętych stron | Naturalne linki zdobyte za wartościowe treści | Kupowane linki lub schematy wzajemnej wymiany |

| Metody techniczne | Cloaking, ukryty tekst, podstępne przekierowania | Czysty HTML, właściwe metatagi, dane strukturalne | Przekierowania JavaScript, strony przejściowe |

| Doświadczenie użytkownika | Słabe; treści dla algorytmów, nie dla ludzi | Doskonałe; treści dla ludzi | Średnie; kompromisy w UX |

| Kary wyszukiwarek | Działania ręczne, deindeksacja, spadki pozycji | Brak; ciągła poprawa pozycji | Możliwe kary przy wykryciu |

| Trwałość efektów | Nietrwała; kary nieuniknione | Trwała; budowa autorytetu | Ryzykowna; zależna od wykrycia |

| Czas odzyskiwania | Miesiące-lata; część korzyści nie do odzyskania | N/D; brak kar | Tygodnie-miesiące po wykryciu |

SpamBrain to zasadnicza zmiana w zwalczaniu spamu przez wyszukiwarki dzięki sztucznej inteligencji i uczeniu maszynowemu. Wprowadzony przez Google w 2022 roku, SpamBrain analizuje wzorce w miliardach stron, by z niespotykaną dotąd skutecznością wykrywać cechy charakterystyczne dla spamu. System działa nieprzerwanie, badając zarówno czynniki on-page (jakość treści, rozkład słów kluczowych, struktura strony), jak i off-page (profile linków, historia domeny, zachowania użytkowników). Modele uczenia maszynowego SpamBrain były trenowane na ogromnych zbiorach danych – zarówno spamerskich, jak i legalnych stron – umożliwiając rozpoznawanie nowych wariantów spamu, zanim staną się one powszechne. Sztuczna inteligencja potrafi wykrywać wyrafinowane próby obejścia reguł, w tym skoordynowane schematy linkowania, manipulacje treściami i przejmowanie stron. Google podaje, że dzięki SpamBrain odsetek niskiej jakości, nieoryginalnych treści w wynikach spadł od 2022 roku o ok. 45%, co dowodzi skuteczności AI w zwalczaniu spamu.

Wzrost ilości spamu wyszukiwarek bezpośrednio pogarsza jakość i przydatność wyników dla użytkowników. Gdy w czołówce pojawiają się treści spamerskie, użytkownicy trafiają na nieistotne, niskiej jakości lub wprowadzające w błąd informacje, zamiast na autorytatywne źródła rzetelnie odpowiadające na ich pytania. Osłabia to zaufanie do wyszukiwarek i zmusza platformy do ciągłych inwestycji w wykrywanie i usuwanie spamu. Obecność spamu tworzy też nieuczciwą konkurencję, w której legalne firmy mają utrudnione szanse, przynajmniej do czasu reakcji wyszukiwarki. Wyszukiwarki odpowiadają na narastający problem regularnymi aktualizacjami antyspamowymi – istotnymi usprawnieniami systemów wykrywania spamu, ogłaszanymi i śledzonymi niezależnie od głównych aktualizacji algorytmów. Przykładowo, grudniowa aktualizacja antyspamowa Google z 2024 roku objęła wszystkie języki i wdrażana była przez tydzień, co pokazuje skalę i częstotliwość walki ze spamem. Nieustanny wyścig zbrojeń między spamerami a wyszukiwarkami pochłania ogromne zasoby obliczeniowe i inżynierskie, które mogłyby być przeznaczone na poprawę jakości wyszukiwania.

Strony przyłapane na spamie mogą napotkać całą gamę konsekwencji – od kar algorytmicznych, przez działania ręczne, po całkowite usunięcie z indeksu. Działania ręczne to najbardziej bezpośrednia reakcja Google – recenzenci ręcznie identyfikują naruszenia i nakładają konkretne kary poprzez Google Search Console. Powiadomienia te określają, które elementy (np. nienaturalne linki, upychanie słów kluczowych, cloaking) naruszają wytyczne i zwykle skutkują dużymi spadkami pozycji lub usunięciem z wyników. Kary algorytmiczne nakładane są automatycznie – systemy Google wykrywają wzorce spamu i obniżają widoczność strony bez udziału człowieka. Kary te mogą być czasowe – do czasu usunięcia spamu i ponownego zindeksowania – lub trwałe, jeśli naruszenia są poważne lub powtarzają się. W skrajnych przypadkach strony są deindeksowane – całkowicie usuwane z wyników Google, tracąc tym samym widoczność organiczną. Powrót po działaniach ręcznych wymaga pełnego usunięcia spamu, szczegółowej dokumentacji zmian i złożenia prośby o ponowne rozpatrzenie przez Google Search Console. Nawet po odzyskaniu pozycji, korzyści rankingowe uzyskane dzięki spamerskim linkom są trwale utracone.

Pojawienie się systemów wyszukiwania opartych na AI, takich jak ChatGPT, Perplexity, Google AI Overviews czy Claude, otwiera nowe rozdziały w walce ze spamem. Systemy te korzystają z treści internetowych do generowania odpowiedzi, przez co są podatne na spam i niskiej jakości treści, które mogą wpływać na wyniki. W przeciwieństwie do tradycyjnych wyszukiwarek, które prezentują listę wyników, systemy AI syntetyzują informacje w formie naturalnego języka, przez co spam może mieć jeszcze większy wpływ, jeśli zanieczyści dane treningowe lub mechanizmy wyszukiwania. Organizacje takie jak AmICited powstały, by przeciwdziałać temu zagrożeniu, oferując platformy do monitorowania promptów AI, które śledzą występowanie marek i domen w odpowiedziach generowanych przez AI. Monitoring jest kluczowy, ponieważ obecność spamu w odpowiedziach AI może szkodzić reputacji marki i widoczności w sposób odmienny niż w tradycyjnych wynikach. Wraz z rosnącą rolą AI w pozyskiwaniu informacji konieczność monitorowania i zwalczania spamu w nowych modelach wyszukiwania gwałtownie rośnie. Wyzwanie dla systemów AI polega na odróżnieniu autorytatywnych źródeł od spamu podczas wyboru informacji do generowanych odpowiedzi.

Firmy dążące do trwałej widoczności w wyszukiwarkach powinny wdrożyć kompleksową strategię unikania taktyk spamerskich i przestrzegania wytycznych wyszukiwarek. Strategia treści powinna stawiać na oryginalne, wysokiej jakości materiały skierowane do użytkownika, z naturalnym wykorzystaniem słów kluczowych bez sztucznego powtarzania. Link building powinien opierać się na zdobywaniu naturalnych linków dzięki jakości treści, relacjom branżowym i legalnym działaniom outreach, nie na kupowaniu linków czy uczestnictwie w schematach. SEO techniczne wymaga czystego HTML, poprawnych metatagów, wdrożenia danych strukturalnych oraz przejrzystych przekierowań, które traktują boty i ludzi jednakowo. Regularne audyty treści, linków i elementów technicznych pomagają wykryć potencjalny spam, zanim dojdzie do nałożenia kary. Narzędzia monitorujące powinny śledzić pozycje słów kluczowych, profil linków i widoczność w wyszukiwarkach, by wykryć nietypowe zmiany mogące sugerować spam lub atak konkurencji. Optymalizacja UX gwarantuje, że treści służą w pierwszej kolejności użytkownikom, a optymalizacja pod wyszukiwarki jest wtórna. Warto również wdrożyć wewnętrzne polityki antyspamowe i edukować zespół o ryzyku związanym z manipulacjami.

Przyszłość wykrywania spamu wyszukiwarek będzie coraz mocniej oparta na zaawansowanej sztucznej inteligencji i systemach uczących się, zdolnych do rozpoznawania wyrafinowanych prób manipulacji w czasie rzeczywistym. SpamBrain i podobne systemy będą stale ewoluować, by wykrywać nowe warianty spamu szybciej, niż spamerzy są w stanie je tworzyć, co napędzi wyścig zbrojeń między detekcją a obchodzeniem zabezpieczeń. Integracja systemów AI z głównymi doświadczeniami wyszukiwawczymi wymusi nowe podejścia do wykrywania spamu, dostosowane do sposobu, w jaki systemy te pobierają i syntezują informacje. Wyszukiwarki prawdopodobnie wdrożą bardziej zaawansowaną analizę zachowań użytkowników, by określać spam na podstawie rzeczywistej interakcji, nie tylko sygnałów technicznych. Monitoring wieloplatformowy stanie się kluczowy, ponieważ taktyki spamerskie będą atakować równocześnie różne systemy – tradycyjne wyszukiwarki, chatboty AI oraz nowe modele wyszukiwania. Rozwój generatywnej AI tworzy nowe wyzwania – automaty generują przekonujące, lecz niskiej jakości lub wprowadzające w błąd treści na masową skalę. Organizacje takie jak AmICited będą odgrywać coraz większą rolę w monitorowaniu widoczności marek w różnych systemach i wczesnym wykrywaniu zagrożeń spamerskich. Ostatecznie najskuteczniejsze zapobieganie spamowi będzie łączyć zaawansowane algorytmy, wiedzę ekspertów, mechanizmy feedbacku użytkowników i współpracę branżową, by utrzymać wysoką jakość wyszukiwania i zaufanie użytkowników.

Spam wyszukiwarek narusza wytyczne wyszukiwarek i wykorzystuje zwodnicze techniki w celu manipulowania pozycjami, podczas gdy legalne SEO stosuje metody white-hat, które zapewniają rzeczywistą wartość użytkownikom. Legalne SEO koncentruje się na tworzeniu wartościowych treści, zdobywaniu naturalnych linków zwrotnych i poprawie doświadczenia użytkownika, podczas gdy taktyki spamerskie, takie jak upychanie słów kluczowych i cloaking, próbują oszukać algorytmy. Wytyczne Google wyraźnie zabraniają stosowania technik spamerskich, a strony je wykorzystujące ryzykują nałożenie ręcznych kar lub całkowite usunięcie z wyników wyszukiwania.

Google wykorzystuje **SpamBrain**, oparty na AI system zapobiegania spamowi, który nieprzerwanie monitoruje strony pod kątem naruszeń polityki antyspamowej. SpamBrain wykorzystuje algorytmy uczenia maszynowego do identyfikowania wzorców charakterystycznych dla spamu, takich jak nienaturalne profile linków, upychanie słów kluczowych, cloaking i inne zwodnicze techniki. System analizuje zarówno czynniki on-page, jak i off-page, sygnały zachowań użytkowników oraz wskaźniki jakości treści, by odróżnić wartościowe treści od spamu. Google przeprowadza także ręczne kontrole oraz przyjmuje zgłoszenia użytkowników przez Search Console, aby identyfikować i karać strony spamerskie.

Podstawowe taktyki spamu wyszukiwarek obejmują **upychanie słów kluczowych** (nadmierne nasycenie stron słowami kluczowymi), **cloaking** (prezentowanie innej treści wyszukiwarce niż użytkownikom), **podstępne przekierowania** (przekierowywanie użytkowników na inne strony niż widzą roboty wyszukiwarki), **farmy linków** (sieci niskiej jakości stron stworzonych wyłącznie do linkowania), **ukryty tekst i linki** (treści niewidoczne dla użytkowników, ale widoczne dla robotów) oraz **spam komentarzy** (zautomatyzowany spam publikowany w komentarzach i na forach). Każda z tych technik ma na celu manipulowanie algorytmami wyszukiwarek poprzez oszustwo, a nie dostarczanie rzeczywistej wartości użytkownikowi.

Google nakłada różne kary za spam wyszukiwarek – od spadków pozycji po całkowite usunięcie z indeksu. Strony mogą otrzymać **ręczne działania** przez Google Search Console, informujące o konkretnych naruszeniach, lub być objęte automatycznymi filtrami antyspamowymi, które samoczynnie obniżają widoczność. W poważnych przypadkach strony mogą być całkowicie usunięte z indeksu Google, przez co stają się niewidoczne w wynikach wyszukiwarki. Odzyskanie pozycji wymaga usunięcia wszystkich elementów spamu i złożenia prośby o ponowne rozpatrzenie przez Search Console. Proces ten może trwać miesiącami, a niektóre korzyści rankingowe uzyskane dzięki spamerskim linkom są nie do odzyskania.

Spam wyszukiwarek stanowi poważne wyzwanie dla systemów wyszukiwania opartych na AI, takich jak **ChatGPT**, **Perplexity** czy **Google AI Overviews**. Systemy te polegają na treściach z sieci, by generować odpowiedzi, a spam może zanieczyszczać ich dane treningowe lub wpływać na generowane wyniki. Platformy takie jak AmICited monitorują, gdzie marki i domeny pojawiają się w odpowiedziach AI, pomagając firmom sprawdzić, czy spam lub niskiej jakości treści nie wpływają na ich widoczność. Wraz z rozwojem systemów AI wykrywanie spamu staje się coraz ważniejsze, by zapewnić użytkownikom rzetelne i wiarygodne informacje.

Tak, strony mogą odzyskać pozycję po karach za spam, ale wymaga to kompleksowej naprawy. Właściciele muszą zidentyfikować wszystkie elementy spamu – takie jak upychanie słów kluczowych, nienaturalne linki, cloaking oraz ukryte treści – i całkowicie je usunąć. Po oczyszczeniu należy złożyć w Google Search Console wniosek o ponowne rozpatrzenie wraz ze szczegółową dokumentacją zmian. Odzyskiwanie trwa zwykle kilka miesięcy, ponieważ Google potrzebuje czasu na ponowne zindeksowanie i ocenę strony. Jednak korzyści rankingowe uzyskane wcześniej dzięki spamerskim linkom nie są odzyskiwane – trzeba budować autorytet na nowo poprzez wartościowe treści i naturalne linki.

Monitorowanie spamu wyszukiwarek jest kluczowe, ponieważ treści spamerskie mogą szkodzić reputacji marki i jej widoczności w wyszukiwarkach. Konkurenci mogą stosować taktyki spamerskie wymierzone w twoją markę lub twoja strona może zostać przejęta i wykorzystywana do spamu. Narzędzia takie jak **AmICited** pomagają organizacjom śledzić wzmianki o marce w systemach AI oraz tradycyjnych wyszukiwarkach, identyfikując, czy w miejsce wiarygodnych informacji pojawia się spam lub niskiej jakości treści. Pozwala to szybko wykryć problem i chronić integralność marki w wynikach wyszukiwania i odpowiedziach AI.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Wykrywanie spamu identyfikuje niechciane, manipulacyjne treści przy użyciu algorytmów ML i analizy behawioralnej. Dowiedz się, jak systemy AI filtrują spam w e-...

Dowiedz się, czym jest Link Spam Update Google, która deprecjonuje manipulacyjne backlinki. Zrozum, jak SpamBrain wykrywa spam linkowy, wpływ na SEO oraz najlep...

Negatywne SEO to praktyka wykorzystania nieetycznych technik w celu zaszkodzenia pozycjom konkurencji. Dowiedz się, jakie są metody ataku, sposoby wykrywania or...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.