Czym jest wyszukiwanie wektorowe i jak działa?

Dowiedz się, jak wyszukiwanie wektorowe wykorzystuje osadzenia uczenia maszynowego do znajdowania podobnych elementów na podstawie znaczenia, a nie dokładnych s...

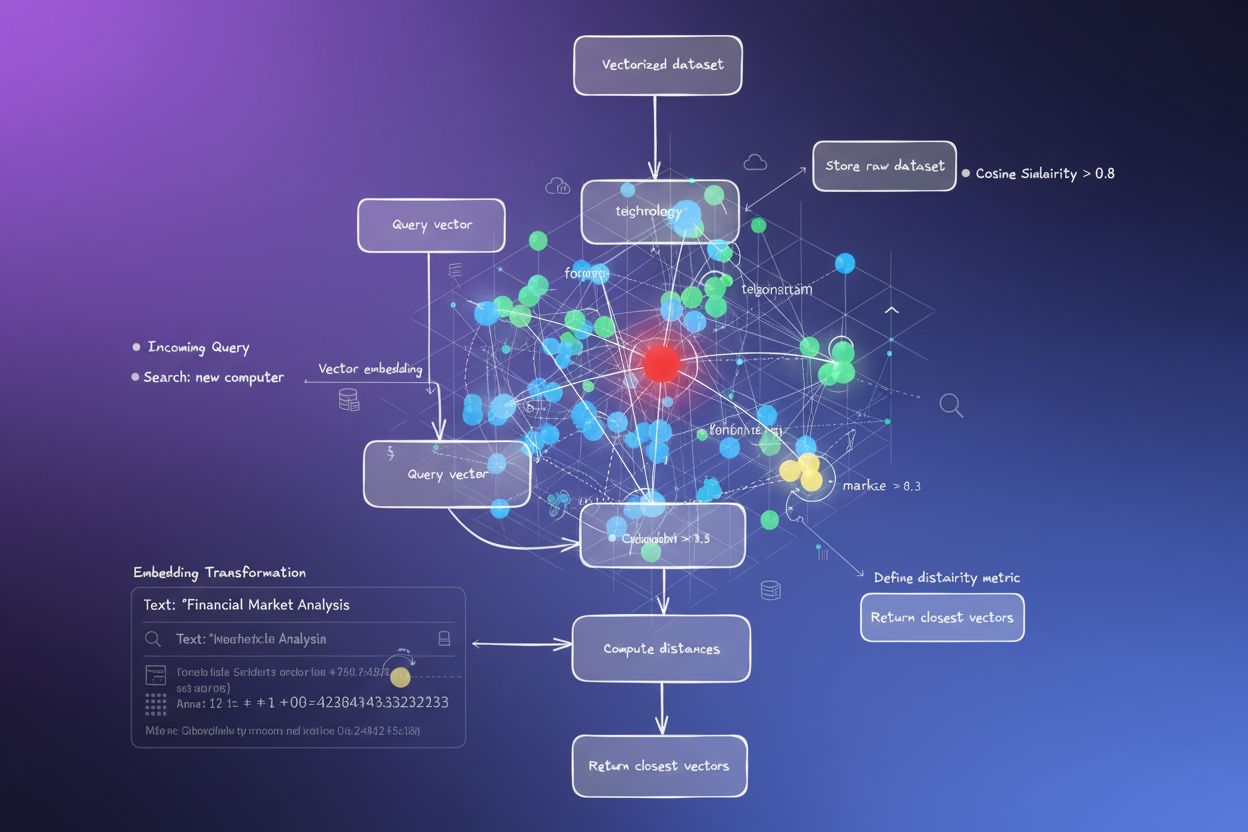

Wyszukiwanie wektorowe to metoda znajdowania podobnych elementów w zbiorze danych poprzez reprezentowanie danych jako matematycznych wektorów i porównywanie ich za pomocą metryk odległości, takich jak podobieństwo cosinusowe lub odległość euklidesowa. To podejście umożliwia semantyczne rozumienie wykraczające poza dopasowanie słów kluczowych, pozwalając systemom odkrywać relacje i podobieństwa na podstawie znaczenia, a nie dokładnych dopasowań tekstu.

Wyszukiwanie wektorowe to metoda znajdowania podobnych elementów w zbiorze danych poprzez reprezentowanie danych jako matematycznych wektorów i porównywanie ich za pomocą metryk odległości, takich jak podobieństwo cosinusowe lub odległość euklidesowa. To podejście umożliwia semantyczne rozumienie wykraczające poza dopasowanie słów kluczowych, pozwalając systemom odkrywać relacje i podobieństwa na podstawie znaczenia, a nie dokładnych dopasowań tekstu.

Wyszukiwanie wektorowe to metoda znajdowania podobnych elementów w zbiorze danych poprzez reprezentowanie danych jako matematycznych wektorów i porównywanie ich za pomocą metryk odległości w celu pomiaru podobieństwa semantycznego. W przeciwieństwie do tradycyjnego wyszukiwania opartego na słowach kluczowych, które polega na dokładnych dopasowaniach tekstu, wyszukiwanie wektorowe rozumie znaczenie i kontekst danych, przekształcając je w wielowymiarowe, numeryczne reprezentacje zwane embeddingami wektorowymi. Takie podejście umożliwia systemom odkrywanie relacji i podobieństw na podstawie treści semantycznych, a nie powierzchownych cech tekstu, dzięki czemu jest szczególnie skuteczne w zastosowaniach wymagających zrozumienia kontekstowego. Wyszukiwanie wektorowe stało się fundamentem współczesnych systemów AI, umożliwiając semantyczne wyszukiwanie, silniki rekomendacji, wykrywanie anomalii oraz generowanie wspomagane wyszukiwaniem (RAG) na platformach takich jak ChatGPT, Perplexity, Google AI Overviews i Claude.

W swej istocie wyszukiwanie wektorowe przekształca dane w numeryczne reprezentacje, gdzie bliskość w przestrzeni oznacza podobieństwo semantyczne. Każdy element danych — czy to tekst, obraz, czy dźwięk — zamieniany jest na wektor, będący tablicą liczb reprezentujących cechy lub znaczenie. Przykładowo, słowo „restauracja” może być przedstawione jako [0.2, -0.5, 0.8, 0.1], gdzie każda liczba oddaje inny aspekt znaczenia semantycznego. Podstawowa zasada mówi, że elementy semantycznie podobne mają wektory położone blisko siebie w tej wysokowymiarowej przestrzeni, natomiast elementy różne — daleko od siebie. Taka struktura matematyczna pozwala komputerom porównywać pojęcia na podstawie znaczenia, a nie tylko dopasowania słów kluczowych, umożliwiając np. wyszukiwanie „najlepsze miejsca na obiad” i otrzymywanie wyników dla „najwyżej oceniane restauracje”, nawet bez dokładnej zgodności słów.

Proces przekształcania danych w wektory to embedding, wykonywany przez modele uczenia maszynowego wytrenowane na dużych zbiorach danych. Modele te uczą się mapować podobne pojęcia do zbliżonych lokalizacji w przestrzeni wektorowej poprzez ekspozycję na miliardy przykładów. Popularne modele embeddingowe to Word2Vec, który poznaje relacje słów z kontekstu; BERT (Bidirectional Encoder Representations from Transformers), oddający znaczenie kontekstowe; oraz CLIP (Contrastive Language-Image Pre-training), obsługujący dane multimodalne. Uzyskane embeddingi mają zwykle od 100 do ponad 1000 wymiarów, tworząc bogatą matematyczną reprezentację relacji semantycznych. Gdy użytkownik przeprowadza wyszukiwanie, jego zapytanie także jest zamieniane na wektor tym samym modelem embeddingowym, a system oblicza odległości pomiędzy wektorem zapytania a wszystkimi zapisanymi wektorami, aby zidentyfikować najbardziej podobne elementy.

Wyszukiwanie wektorowe opiera się na metrykach odległości do ilościowego określania podobieństwa dwóch wektorów. Trzy główne metryki to podobieństwo cosinusowe, odległość euklidesowa oraz podobieństwo iloczynu skalarnego, każda o innych właściwościach matematycznych i zastosowaniach. Podobieństwo cosinusowe mierzy kąt pomiędzy dwoma wektorami w zakresie od -1 do 1, gdzie 1 oznacza identyczny kierunek (maksymalne podobieństwo), a 0 — ortogonalność (brak związku). Ta metryka jest szczególnie cenna w NLP, ponieważ skupia się na kierunku semantycznym niezależnie od długości wektora, co sprawdza się przy porównywaniu dokumentów o różnych długościach. Odległość euklidesowa oblicza prostą odległość pomiędzy wektorami w przestrzeni wielowymiarowej, uwzględniając zarówno wielkość, jak i kierunek. Jest wrażliwa na skalę, więc znajduje zastosowanie tam, gdzie długość wektorów niesie istotne informacje, np. w systemach rekomendacyjnych uwzględniających częstotliwość zakupów.

Podobieństwo iloczynu skalarnego łączy aspekty obu metryk, uwzględniając wielkość i kierunek przy jednoczesnej efektywności obliczeniowej. Wiele dużych modeli językowych wykorzystuje iloczyn skalarny podczas treningu, dlatego jest to właściwy wybór w tych zastosowaniach. Dobór odpowiedniej metryki jest kluczowy — badania pokazują, że korzystanie z tej samej metryki, która była użyta podczas trenowania modelu embeddingowego, zapewnia najlepsze rezultaty. Przykładowo, model all-MiniLM-L6-v2 był trenowany z użyciem podobieństwa cosinusowego, więc stosowanie tej metryki w indeksie zapewni najdokładniejsze wyniki. Organizacje wdrażające wyszukiwanie wektorowe muszą więc starannie dopasować metrykę do modelu embeddingowego i konkretnego przypadku użycia, by zapewnić zarówno dokładność, jak i wydajność.

| Aspekt | Wyszukiwanie wektorowe | Wyszukiwanie słów kluczowych | Wyszukiwanie hybrydowe |

|---|---|---|---|

| Metoda dopasowania | Podobieństwo semantyczne na podstawie znaczenia | Dokładne dopasowanie słowa lub frazy | Łączy dopasowanie semantyczne i słów kluczowych |

| Zrozumienie zapytania | Rozumie intencje i kontekst | Wymaga obecności dokładnych słów kluczowych | Wykorzystuje oba podejścia dla pełnych wyników |

| Obsługa synonimów | Automatycznie znajduje synonimy i powiązane terminy | Pomija synonimy, jeśli nie są jawnie zindeksowane | Wychwytuje synonimy obiema metodami |

| Wyniki dla nieprecyzyjnych zapytań | Doskonałe — rozumie intencje | Słabe — wymaga precyzyjnych słów kluczowych | Bardzo dobre — obejmuje oba ujęcia |

| Koszt obliczeniowy | Wyższy — wymaga embeddingu i obliczeń podobieństwa | Niższy — proste dopasowanie tekstu | Umiarkowany — oba wyszukiwania równolegle |

| Skalowalność | Wymaga specjalistycznych baz wektorowych | Działa z tradycyjnymi bazami danych | Wymaga systemów hybrydowych |

| Zastosowania | Semantyczne wyszukiwanie, rekomendacje, RAG, wykrywanie anomalii | Wyszukiwanie fraz, dane strukturalne | Wyszukiwanie korporacyjne, monitoring AI, śledzenie marki |

| Przykład | Wyszukiwanie „zdrowe pomysły na obiad” znajdzie „odżywcze przygotowania posiłków” | Znajdzie tylko wyniki z dokładnymi słowami „zdrowe” i „obiad” | Znajdzie zarówno dokładne dopasowania, jak i powiązane treści semantycznie |

Implementacja wyszukiwania wektorowego obejmuje kilka powiązanych etapów, które przekształcają surowe dane w przeszukiwalne reprezentacje semantyczne. Pierwszym krokiem jest pobieranie i wstępne przetwarzanie danych, czyli czyszczenie i normalizacja dokumentów, obrazów lub innych danych. Następnie następuje transformacja wektorowa, w której model embeddingowy zamienia każdy element na numeryczny wektor, zwykle o wymiarowości od 100 do ponad 1000. Wektory te są następnie przechowywane w bazie danych wektorowych lub strukturze indeksu zoptymalizowanej do danych wysokowymiarowych. Gdy pojawia się zapytanie, również jest przekształcane na wektor tym samym modelem embeddingowym. System oblicza metryki odległości między wektorem zapytania a wszystkimi zapisanymi wektorami, a następnie sortuje wyniki według ich bliskości względem zapytania.

Aby ten proces był wydajny na dużą skalę, stosowane są algorytmy Approximate Nearest Neighbor (ANN), takie jak HNSW (Hierarchical Navigable Small World), IVF (Inverted File Index) czy ScaNN (Scalable Nearest Neighbors). Algorytmy te rezygnują z pełnej dokładności na rzecz szybkości, pozwalając na przeszukiwanie milionów czy miliardów wektorów w milisekundy zamiast sekund. HNSW organizuje wektory w wielowarstwowej strukturze grafowej, gdzie wyższe warstwy zawierają połączenia dalekiego zasięgu dla szybkiego przeszukiwania, a niższe — krótkiego zasięgu dla precyzji. Takie podejście redukuje złożoność wyszukiwania z liniowej O(n) do logarytmicznej O(log n), czyniąc wyszukiwanie wektorowe skalowalnym. Wybór algorytmu zależy od takich czynników jak rozmiar zbioru danych, liczba zapytań, wymagania czasowe i dostępne zasoby obliczeniowe.

Wyszukiwanie wektorowe stało się niezbędne dla platform monitorujących AI takich jak AmICited, które śledzą wzmianki o marce w systemach AI. Tradycyjne monitorowanie oparte na słowach kluczowych przeoczyłoby parafrazy, odniesienia kontekstowe i semantyczne wariacje nazw marek lub adresów domen. Wyszukiwanie wektorowe umożliwia tym platformom wykrywanie wzmianek o Twojej marce w odpowiedziach generowanych przez AI, nawet jeśli sformułowania się różnią. Na przykład, jeśli Twoją domeną jest „amicited.com”, wyszukiwanie wektorowe pozwoli rozpoznać wzmianki typu „platforma monitorowania promptów AI” czy „widoczność marki w generatywnej AI” jako kontekstowo powiązane z Twoją firmą, nawet bez jawnych odniesień do URL. Takie semantyczne rozumienie jest kluczowe dla kompleksowego śledzenia cytowań AI w ChatGPT, Perplexity, Google AI Overviews oraz Claude.

Rynek technologii wyszukiwania wektorowego przeżywa obecnie gwałtowny wzrost, co odzwierciedla uznanie wartości tej technologii przez przedsiębiorstwa. Według analiz rynkowych rynek baz danych wektorowych był wart 1,97 miliarda dolarów w 2024 roku, a prognozy mówią o wzroście do 10,60 miliarda dolarów do 2032 roku przy rocznej stopie wzrostu (CAGR) 23,38%. Dodatkowo Databricks odnotował 186% wzrost adopcji baz wektorowych już w pierwszym roku po publicznym podglądzie wyszukiwania wektorowego w grudniu 2023. Tak szybka adopcja pokazuje, że przedsiębiorstwa coraz częściej traktują wyszukiwanie wektorowe jako kluczową infrastrukturę dla aplikacji AI. Dla organizacji monitorujących swoją obecność w systemach AI wyszukiwanie wektorowe zapewnia semantyczne rozumienie niezbędne do wychwycenia wszystkich znaczących wzmianek, a nie tylko dokładnych trafień słów kluczowych.

Wydajność wyszukiwania wektorowego na dużą skalę zależy w dużej mierze od zaawansowanych technik indeksowania, które równoważą szybkość, dokładność i zużycie pamięci. HNSW (Hierarchical Navigable Small World) to jedno z najpopularniejszych rozwiązań, organizujące wektory w wielowarstwowym grafie, gdzie każda warstwa zawiera coraz krótsze połączenia. Algorytm rozpoczyna wyszukiwanie na najwyższej warstwie, korzystając z połączeń dalekiego zasięgu dla szybkiego przechodzenia, a następnie schodzi do warstw z coraz precyzyjniejszymi połączeniami. Badania wykazują, że HNSW osiąga najlepsze rezultaty z recall przekraczającym 99% i opóźnieniami zapytań poniżej milisekundy. Jednak HNSW wymaga znacznej ilości pamięci — benchmarki pokazują, że indeksowanie 1 miliona wektorów może wymagać od 0,5 GB do 5 GB w zależności od parametrów, dlatego optymalizacja pamięci jest istotna przy wdrożeniach na dużą skalę.

IVF (Inverted File Index) to alternatywne podejście, w którym wektory są grupowane w klastry i indeksowane według centroidów klastrów. Dzięki temu przeszukiwane są tylko istotne klastry, a nie wszystkie wektory. ScaNN (Scalable Nearest Neighbors), opracowany przez Google Research, jest zoptymalizowany do wyszukiwania względem iloczynu skalarnego i świetnie sprawdza się w systemach rekomendacji. Product Quantization (PQ) kompresuje wektory, dzieląc je na podwektory i kwantyzując każdy niezależnie, co pozwala zredukować wymagania pamięciowe 10-100 razy kosztem niewielkiej utraty dokładności. Organizacje wdrażające wyszukiwanie wektorowe muszą starannie dobrać techniki indeksowania do własnych wymagań — zależnie od tego, czy priorytetem jest dokładność recall, szybkość wyszukiwania, efektywność pamięciowa, czy ich kombinacja. Dziedzina ta rozwija się bardzo dynamicznie, a nowe algorytmy i metody optymalizacji pojawiają się regularnie, by sprostać wyzwaniom obliczeniowym operacji na danych wysokowymiarowych.

Definicja i zastosowania wyszukiwania wektorowego stale ewoluują wraz z postępem systemów AI i rosnącą adopcją w przedsiębiorstwach. Kierunek rozwoju zmierza ku systemom hybrydowym, które łączą wyszukiwanie wektorowe z tradycyjnym wyszukiwaniem słów kluczowych oraz zaawansowanym filtrowaniem. Takie podejście pozwala wykorzystać semantyczne rozumienie wyszukiwania wektorowego, jednocześnie zachowując precyzję i intuicyjność klasycznych metod, zapewniając lepsze wyniki dla złożonych zapytań. Coraz większe znaczenie zyskuje także multimodalne wyszukiwanie wektorowe, umożliwiające przeszukiwanie tekstu, obrazów, dźwięku i wideo jednocześnie w jednej przestrzeni embeddingowej. Pozwoli to na bardziej intuicyjne, kompleksowe doświadczenia wyszukiwania wśród różnorodnych typów danych.

Dla organizacji monitorujących swoją obecność w systemach AI rozwój wyszukiwania wektorowego ma ogromne znaczenie strategiczne. Ponieważ platformy AI takie jak ChatGPT, Perplexity, Google AI Overviews czy Claude coraz częściej stosują wyszukiwanie wektorowe do pozyskiwania i rankingowania treści, zrozumienie, jak Twoja marka pojawia się semantycznie, staje się równie ważne jak tradycyjna widoczność słów kluczowych. Przesunięcie w stronę rozumienia semantycznego oznacza, że monitoring marki i śledzenie cytowań AI muszą wyjść poza proste wykrywanie słów, aby wychwytywać kontekstowe wzmianki i powiązania semantyczne. Organizacje inwestujące w zrozumienie wyszukiwania wektorowego i jego zastosowań będą lepiej przygotowane, by optymalizować swoją widoczność w generatywnych systemach AI. Konwergencja technologii wyszukiwania wektorowego z platformami monitoringu AI stanowi fundamentalną zmianę w sposobie, w jaki marki rozumieją i zarządzają swoją obecnością w krajobrazie informacyjnym napędzanym przez sztuczną inteligencję.

Tradycyjne wyszukiwanie słów kluczowych polega na szukaniu dokładnych dopasowań słów w dokumentach, podczas gdy wyszukiwanie wektorowe rozumie znaczenie semantyczne i kontekst. Wyszukiwanie wektorowe zamienia tekst na numeryczne reprezentacje zwane embeddingami, co pozwala znajdować trafne wyniki nawet wtedy, gdy dokładne słowa kluczowe nie pasują. Na przykład, wyszukując 'bezprzewodowe słuchawki' za pomocą wyszukiwania wektorowego, otrzymasz także wyniki dla 'słuchawek Bluetooth', ponieważ mają podobne znaczenie semantyczne, podczas gdy wyszukiwanie słów kluczowych takiego powiązania by nie znalazło.

Embeddingi wektorowe to numeryczne reprezentacje danych (tekstu, obrazów, dźwięku) przekształcone w tablice liczb oddających ich znaczenie semantyczne. Tworzone są za pomocą modeli uczenia maszynowego takich jak Word2Vec, BERT czy modeli transformerowych, które uczą się mapować podobne pojęcia blisko siebie w wielowymiarowej przestrzeni. Przykładowo słowa 'król' i 'królowa' będą miały embeddingi położone blisko siebie ze względu na powiązania semantyczne, podczas gdy 'król' i 'banan' będą od siebie oddalone.

Trzy główne metryki odległości to podobieństwo cosinusowe (mierzy kąt między wektorami), odległość euklidesowa (mierzy odległość prostą) oraz podobieństwo iloczynu skalarnego (uwzględnia zarówno długość, jak i kierunek). Podobieństwo cosinusowe jest najczęściej stosowane w NLP, ponieważ skupia się na kierunku semantycznym niezależnie od wielkości wektora. Wybór metryki powinien odpowiadać tej użytej podczas treningu modelu embeddingowego dla optymalnej dokładności.

Wyszukiwanie wektorowe umożliwia platformom monitorującym AI, takim jak AmICited, śledzenie wzmianek o marce w systemach AI (ChatGPT, Perplexity, Google AI Overviews, Claude) poprzez rozumienie kontekstu semantycznego, a nie tylko dokładnych dopasowań słów kluczowych. Dzięki temu możliwa jest detekcja parafraz, powiązanych pojęć i kontekstowych odniesień do Twojej marki, zapewniając pełną widoczność tego, jak Twoja domena pojawia się w odpowiedziach generowanych przez AI na wielu platformach.

Algorytmy ANN, takie jak HNSW (Hierarchical Navigable Small World), umożliwiają szybkie wyszukiwanie podobieństw wśród milionów wektorów poprzez znajdowanie przybliżonych, a nie dokładnych najbliższych sąsiadów. Algorytmy te wykorzystują hierarchiczne struktury grafowe, aby zredukować złożoność wyszukiwania z liniowej do logarytmicznej, co czyni wyszukiwanie wektorowe praktycznym dla zastosowań na dużą skalę. HNSW organizuje wektory w wielowarstwowych grafach, gdzie na wyższych warstwach istnieją połączenia dalekiego zasięgu dla szybszego przeszukiwania.

Przedsiębiorstwa generują ogromne ilości niestrukturalnych danych (maile, dokumenty, zgłoszenia serwisowe), z którymi tradycyjne wyszukiwanie słów kluczowych sobie nie radzi. Wyszukiwanie wektorowe umożliwia semantyczne rozumienie tych danych, zasilając inteligentne wyszukiwanie, systemy rekomendacji, wykrywanie anomalii i generowanie wspomagane wyszukiwaniem (RAG). Według analiz rynku, rynek baz wektorowych wzrośnie z 2,65 miliarda dolarów w 2025 roku do 8,95 miliarda dolarów w 2030 roku, co odzwierciedla rosnącą adopcję przez firmy.

Bazy danych wektorowych to wyspecjalizowane systemy zoptymalizowane do przechowywania, indeksowania i zapytań na danych wektorowych wysokiej wymiarowości. Wdrażają wydajne techniki indeksowania, takie jak HNSW, IVF (Inverted File Index) czy ScaNN, pozwalając na szybkie wyszukiwanie podobieństw na dużą skalę. Przykłady to Milvus, Pinecone, Weaviate oraz Zilliz Cloud. Bazy te przejmują na siebie złożoność obliczeniową operacji wektorowych, umożliwiając budowę produkcyjnych aplikacji AI i semantycznego wyszukiwania bez potrzeby zarządzania infrastrukturą.

Zacznij śledzić, jak chatboty AI wspominają Twoją markę w ChatGPT, Perplexity i innych platformach. Uzyskaj praktyczne spostrzeżenia, aby poprawić swoją obecność w AI.

Dowiedz się, jak wyszukiwanie wektorowe wykorzystuje osadzenia uczenia maszynowego do znajdowania podobnych elementów na podstawie znaczenia, a nie dokładnych s...

Wyszukiwanie semantyczne interpretuje znaczenie i kontekst zapytań za pomocą NLP i uczenia maszynowego. Dowiedz się, czym różni się od wyszukiwania po słowach k...

Dowiedz się, jak osadzenia wektorowe umożliwiają systemom AI rozumienie znaczenia semantycznego i dopasowywanie treści do zapytań. Poznaj technologię stojącą za...

Zgoda na Pliki Cookie

Używamy plików cookie, aby poprawić jakość przeglądania i analizować nasz ruch. See our privacy policy.