Construindo Autoridade para Visibilidade em IA

Aprenda como construir autoridade para visibilidade em IA. Descubra estratégias de E-E-A-T, autoridade tópica e como ser citado em AI Overviews e respostas de L...

Aprenda como construir autoridade topical para LLMs com profundidade semântica, otimização de entidades e clusters de conteúdo. Domine as estratégias que fazem os sistemas de IA citarem sua marca.

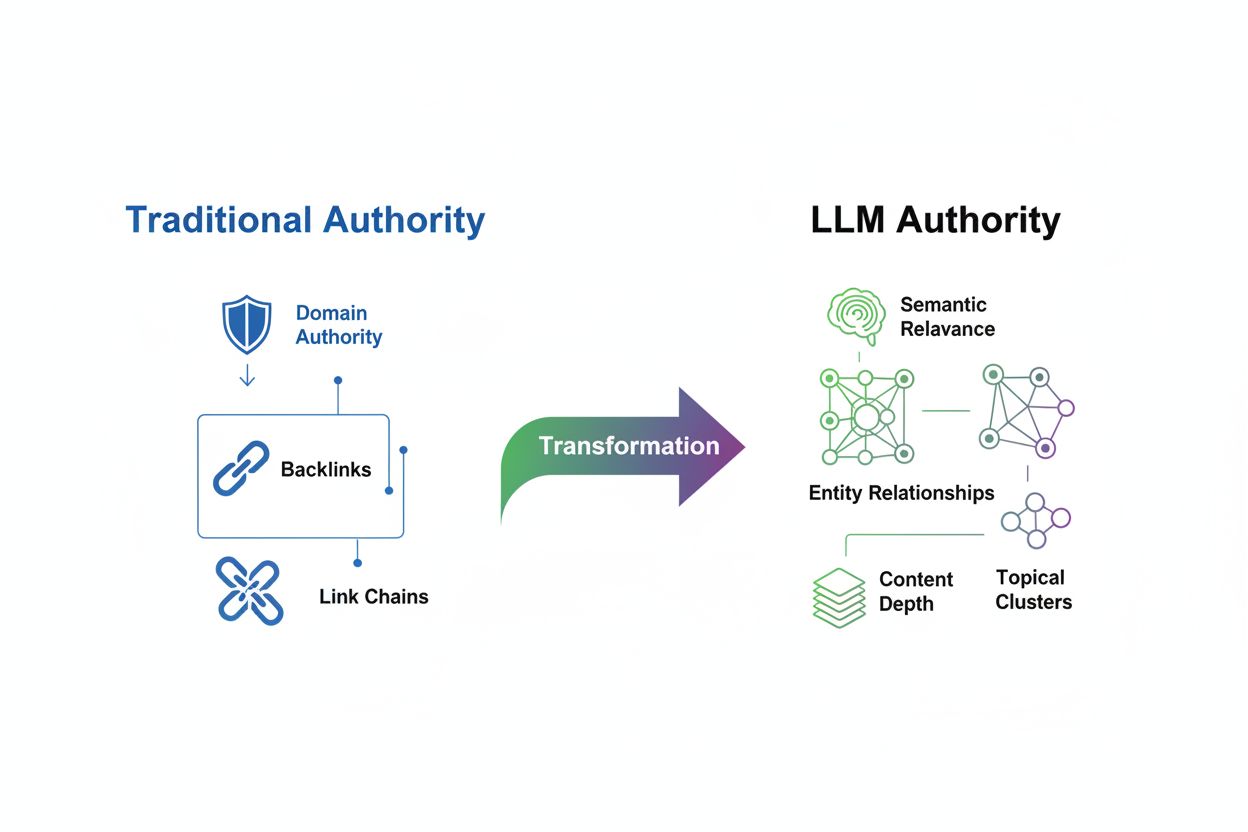

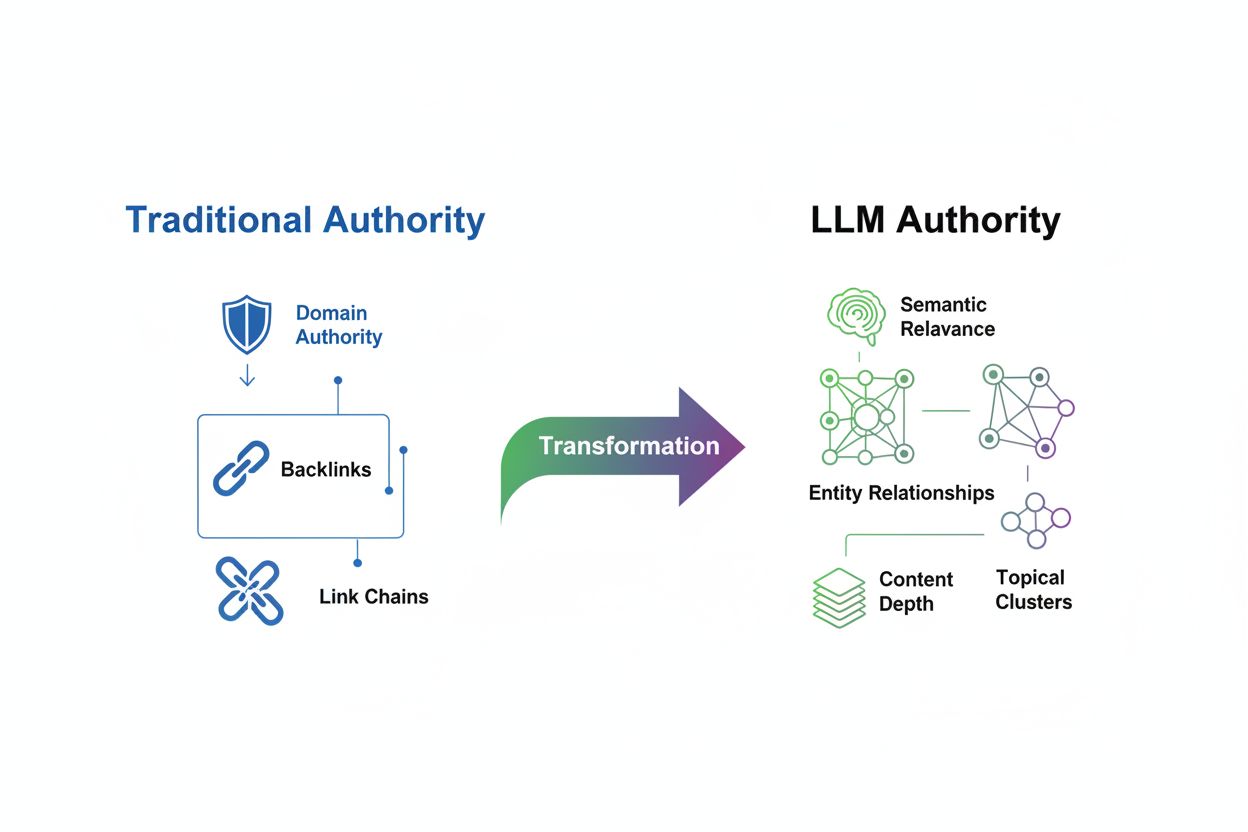

A avaliação da autoridade topical passou por uma transformação fundamental na era dos Grandes Modelos de Linguagem. Onde o SEO tradicional antes priorizava backlinks e densidade de palavras-chave como principais sinais de autoridade, os LLMs modernos avaliam o conteúdo por um prisma totalmente diferente, focado em relevância semântica, profundidade contextual e relacionamentos de entidades. Essa mudança representa mais do que uma mera atualização de algoritmo—é uma completa reinvenção de como mecanismos de busca e sistemas de IA determinam quais fontes merecem visibilidade e confiança. O modelo antigo premiava volume e quantidade de links; o novo paradigma recompensa a riqueza semântica e a cobertura abrangente do tema. Compreender essa transição é fundamental porque marcas que continuam otimizando para sinais de autoridade desatualizados se tornarão cada vez mais invisíveis em respostas geradas por IA, mesmo que mantenham fortes métricas de SEO tradicional. O futuro da visibilidade pertence àqueles que reconhecem que LLMs reconhecem autoridade por profundidade, consistência e clareza semântica em vez da simples acumulação de links externos.

Autoridade topical é definida como o nível de especialização, profundidade e consistência que um site demonstra em uma área temática específica, reconhecido tanto por mecanismos de busca quanto por sistemas de inteligência artificial. Diferente das métricas tradicionais de autoridade que dependem fortemente de validação externa via backlinks, a avaliação de autoridade baseada em LLM foca em quão abrangente e coerentemente um domínio cobre seu tema escolhido. Relevância semântica tornou-se o alicerce desse novo método de avaliação—LLMs avaliam se o conteúdo atende totalmente à intenção do usuário, aborda múltiplos ângulos do tema e mantém conexões lógicas entre conceitos relacionados. A diferença é profunda: um site com 50 artigos superficiais, recheados de palavras-chave, pode ter fortes sinais de autoridade tradicional, mas baixa autoridade topical no contexto dos LLMs, enquanto um concorrente com 10 artigos profundamente pesquisados e interconectados pode dominar respostas geradas por IA.

| Sinal de Autoridade | SEO Tradicional | Avaliação por LLM |

|---|---|---|

| Métrica Primária | Quantidade de backlinks e autoridade do domínio | Profundidade semântica e cobertura do tema |

| Abordagem de Conteúdo | Otimização de palavras-chave e volume | Clusters de conteúdo abrangentes e interconectados |

| Reconhecimento de Entidades | Ênfase mínima | Crítico para entender relacionamentos |

| Linkagem Interna | Consideração secundária | Essencial para demonstrar especialização |

| Foco de Medição | Métricas de nível de domínio (DA, DR, DP) | Visibilidade por tema e frequência de citação |

Grandes Modelos de Linguagem avaliam autoridade por mecanismos sofisticados que diferem fundamentalmente dos algoritmos tradicionais de busca. Quando um LLM encontra conteúdo, ele não simplesmente conta backlinks ou escaneia frequência de palavras-chave; em vez disso, utiliza reconhecimento de padrões em bilhões de documentos para entender como conceitos se relacionam. O modelo analisa relacionamentos de entidades—as conexões entre pessoas, organizações, produtos e conceitos—para determinar se uma fonte realmente entende o tema ou apenas o menciona superficialmente. Riqueza semântica exerce papel fundamental, pois LLMs avaliam a profundidade da explicação, a variedade de perspectivas cobertas e o fluxo lógico entre ideias. Além disso, a consistência em múltiplos conteúdos sinaliza expertise genuína; quando um domínio demonstra repetidamente conhecimento sobre subtemas interconectados, o LLM reconhece isso como autoridade.

Mecanismos-chave usados por LLMs para reconhecer autoridade incluem:

Na era dos LLMs, profundidade de conteúdo tornou-se exponencialmente mais valiosa do que volume. Publicar um guia abrangente de 5.000 palavras que explora um tema com múltiplos ângulos, exemplos práticos e insights acionáveis terá melhor desempenho do que dez artigos de 500 palavras que abordam o tema superficialmente. Esse princípio desafia o manual tradicional de marketing de conteúdo, que premiava publicações prolíficas. LLMs preferem cobertura semântica—o grau em que o conteúdo aborda todas as dimensões relevantes do tema—em vez de repetição de palavras-chave. Ao criar conteúdo que explora o tema sob várias perspectivas, responde perguntas relacionadas e conecta a conceitos mais amplos, você constrói o que pesquisadores chamam de clusters de tópicos, redes de conteúdos interligados que, juntos, demonstram expertise. Por exemplo, uma empresa de serviços financeiros que constrói autoridade sobre “planejamento de aposentadoria” deve criar conteúdo sobre estratégias de investimento, implicações fiscais, custos de saúde, otimização da Previdência Social e planejamento sucessório—e não apenas publicar 20 variações de “como planejar a aposentadoria”. A abordagem de profundidade sinaliza aos LLMs que sua organização entende genuinamente o ecossistema temático, tornando seu conteúdo muito mais provável de ser citado em respostas de IA.

Criar clusters de tópicos eficazes requer uma abordagem estratégica e hierárquica de organização de conteúdo que sinalize expertise tanto para usuários quanto para LLMs. A base dessa estratégia é a página pilar—um recurso abrangente e autoritativo que cobre o tema principal de forma ampla e serve como hub para todos os conteúdos relacionados. Dando suporte ao pilar estão as páginas de cluster, que aprofundam subtemas específicos e mantêm conexões claras com o pilar por meio de linkagem interna estratégica.

Siga estes passos para construir um cluster de tópicos eficaz e uma estratégia de linkagem interna:

Identifique o Tema Pilar Central: Escolha uma área temática ampla na qual sua organização tem expertise genuína e demanda de mercado. Deve ser específica o suficiente para demonstrar autoridade, mas ampla para comportar múltiplos artigos de apoio. Exemplo: “Implementação de ERP Empresarial” em vez de apenas “ERP”.

Mapeie Subtemas e Perguntas Relacionadas: Use ferramentas como SEMrush, AnswerThePublic e o “As pessoas também perguntam” do Google para identificar todas as dúvidas, preocupações e subtemas do seu público. Faça um mapa visual mostrando como esses subtemas se relacionam com o pilar e entre si.

Crie a Página Pilar: Desenvolva um guia abrangente (3.000-5.000+ palavras) que aborde o tema principal de maneira holística. Inclua visão geral dos subtemas, definições-chave e links para os conteúdos de cluster. Use títulos claros e organização lógica para ajudar usuários e LLMs a entender a estrutura.

Desenvolva Conteúdo de Cluster: Escreva de 8 a 15 artigos de apoio que explorem subtemas específicos em profundidade. Cada artigo do cluster deve ter entre 1.500 e 2.500 palavras e focar em um aspecto do tema pilar. Certifique-se de que cada artigo aponte para a página pilar com texto âncora contextual.

Implemente Linkagem Interna Estratégica: Conecte artigos de cluster entre si quando relevante, criando uma teia de conteúdos relacionados. Use texto âncora descritivo, incluindo palavras-chave e nomes de entidades relevantes. Adicione seções de “artigos relacionados” e widgets de navegação para incentivar a exploração da sua rede de conteúdo.

Mantenha Consistência e Atualize Regularmente: Revise periodicamente o cluster para identificar lacunas, informações desatualizadas e novos subtemas. Acrescente novos artigos conforme seu tema evolui e atualize conteúdos existentes para manter relevância e precisão.

Otimização de entidades representa uma mudança de paradigma na estruturação de conteúdo e SEO. Em vez de otimizar para palavras-chave, agora otimizamos para entidades—pessoas, organizações, produtos, locais e conceitos específicos que LLMs usam para compreender o significado do conteúdo. Ao definir claramente e referenciar entidades de forma consistente, você está, essencialmente, ensinando ao grafo de conhecimento do LLM como seu conteúdo se relaciona ao ecossistema informacional mais amplo. Schema markup do Schema.org fornece a base técnica para a otimização de entidades, permitindo que você diga explicitamente aos mecanismos de busca e LLMs quais entidades seu conteúdo aborda e como se relacionam.

Dicas práticas de otimização de entidades incluem:

Defina Claramente Entidades-Chave: Identifique as principais entidades abordadas (ex.: “Google Analytics”, “otimização de taxa de conversão”, “teste A/B”) e mencione-as explicitamente em títulos, subtítulos e corpo do texto. Evite linguagem vaga; seja específico sobre quais produtos, pessoas ou conceitos está discutindo.

Utilize Marcações de Dados Estruturados: Implemente Schema.org para definir entidades e seus relacionamentos. Use Article schema para posts, Organization schema para sua empresa, Product schema para ofertas e Person schema para autores. Esses dados estruturados ajudam LLMs a extrair e compreender informações-chave.

Conecte Entidades a Fontes Autoritativas: Vincule suas entidades a referências externas confiáveis como Wikipedia, DBpedia e Google Knowledge Graph. Essa validação externa reforça a credibilidade das referências de entidades e ajuda LLMs a entender o contexto mais amplo.

Mantenha Consistência nas Menções de Entidades: Use a mesma terminologia, grafia e convenções de nomeação para entidades em todo seu conteúdo, site, redes sociais e plataformas do setor. Consistência sinaliza aos LLMs que você trata da mesma entidade, construindo uma base de conhecimento coesa.

O framework E-E-A-T do Google—Experiência, Expertise, Autoridade e Confiança—evoluiu em significado à medida que LLMs se tornam centrais para busca. Embora esses sinais continuem relevantes para ranqueamento tradicional, sua interpretação mudou em contextos guiados por IA. LLMs avaliam esses sinais não só por backlinks, mas por análise de conteúdo, credenciais do autor e padrões de consistência.

Experiência sinaliza que sua organização ou autor tem envolvimento direto e prático com o tema. LLMs reconhecem experiência por meio de estudos de caso, resultados de clientes, relatos pessoais de autores qualificados e tutoriais detalhados. Em vez de apenas alegar expertise, demonstre com exemplos documentados de resolução de problemas reais. Inclua bios de autores que estabeleçam histórico relevante e destaque depoimentos ou resultados de clientes reais.

Expertise é transmitida por conteúdo abrangente e detalhado que demonstra profundo conhecimento do tema. LLMs avaliam expertise analisando se seu conteúdo cobre casos extremos, reconhece complexidade, cita pesquisas relevantes e oferece insights além do superficial. Publique conteúdos que abordem tópicos avançados, explorem achados contraintuitivos e demonstrem compreensão de debates e práticas em evolução do setor.

Autoridade na era dos LLMs vem do reconhecimento como fonte de referência em seu segmento. Isso se constrói por publicação consistente de conteúdo de alta qualidade, citações por outras fontes autoritativas, palestras, pesquisas publicadas e reconhecimento do setor. LLMs acompanham quais fontes são frequentemente citadas em conjunto e quais aparecem em respostas a consultas de autoridade.

Confiança é estabelecida por transparência, precisão e responsabilidade. Inclua datas de publicação e atualização em todo conteúdo, cite claramente suas fontes, divulgue potenciais conflitos de interesse e corrija erros prontamente. Use credenciais dos autores, certificações profissionais e afiliações para reforçar legitimidade. LLMs estão cada vez mais sofisticados em detectar alegações enganosas e recompensar fontes que priorizam precisão em vez de sensacionalismo.

Acompanhar métricas de autoridade topical exige mudar o foco das medições tradicionais de SEO para novos indicadores que reflitam como LLMs percebem sua expertise. Embora Domain Authority e Domain Rating ainda sejam relevantes para busca tradicional, mostram fraca correlação com visibilidade em LLMs—pesquisa do Search Atlas analisando 21.767 domínios encontrou correlações entre métricas de autoridade e visibilidade em LLMs variando de -0,08 a -0,21, indicando que sinais tradicionais de autoridade têm influência limitada em resultados gerados por IA.

Principais métricas e ferramentas para monitorar autoridade topical incluem:

Score de Visibilidade em LLM: Acompanhe com que frequência e destaque seu conteúdo aparece em respostas do ChatGPT, Gemini e Perplexity. Ferramentas como a funcionalidade de Visibilidade em LLM do Search Atlas medem frequência de citação e porcentagem de visibilidade em múltiplos modelos.

Tráfego por Cluster de Tópico: Monitore tráfego orgânico não apenas para palavras-chave individuais, mas para clusters inteiros de tópicos. Use o Google Analytics para segmentar tráfego por tema e acompanhar se está ganhando visibilidade em várias consultas relacionadas.

Métricas de Completude de Conteúdo: Avalie se seu conteúdo cobre todos os subtemas e perguntas relevantes ao seu tema central. Ferramentas como Clearscope e MarketMuse medem cobertura tópica e identificam lacunas de conteúdo.

Força da Linkagem Interna: Analise sua estrutura de links internos para garantir que páginas de clusters se conectam logicamente ao pilar e entre si. Ferramentas como Screaming Frog ajudam a visualizar e otimizar a arquitetura de links internos.

Monitoramento de Consistência de Entidades: Verifique se você está mencionando e definindo entidades-chave de forma consistente em todo conteúdo. Use o Google Search Console para ver com quais entidades seu conteúdo está associado nos resultados de busca.

Muitas organizações que buscam autoridade topical acabam minando seus próprios esforços por erros evitáveis. Compreender esses deslizes ajuda a evitar desperdício de recursos em estratégias ineficazes.

Erros comuns a evitar incluem:

Publicar Conteúdo Superficial: Criar diversos artigos curtos (300-500 palavras) que abordam um tema sem profundidade real. LLMs reconhecem isso como cobertura insuficiente e preferem menos conteúdos, mas mais completos.

Estrutura Deficiente de Linkagem Interna: Deixar de conectar conteúdos relacionados ou usar texto âncora genérico como “clique aqui” em vez de âncoras descritivas e ricas em entidades. Isso impede que LLMs entendam como os conteúdos se relacionam.

Menções Inconsistentes de Entidades: Usar terminologias diferentes para o mesmo conceito em artigos distintos (ex.: “otimização de taxa de conversão” em um, “CRO” em outro, “melhorando conversões” em um terceiro). Essa fragmentação impede que LLMs reconheçam sua expertise consistente.

Ignorar Lacunas de Conteúdo: Abordar apenas alguns aspectos de um tema e deixar subtemas principais de fora. LLMs percebem cobertura incompleta e podem favorecer concorrentes que oferecem recursos mais abrangentes.

Negligenciar Atualizações de Conteúdo: Permitir que conteúdos antigos fiquem desatualizados enquanto publica novos sobre os mesmos temas. Isso cria redundância e confusão sobre qual recurso representa sua expertise atual.

Construir autoridade topical é um processo estruturado que exige planejamento, execução e otimização contínua. Este roteiro oferece um caminho claro a seguir.

Siga este roteiro para construir autoridade topical reconhecida por LLMs:

Realize uma Auditoria de Autoridade Topical: Analise seu conteúdo atual para identificar áreas temáticas mais fortes e lacunas. Mapeie quais temas você cobre, quais subtemas faltam e onde seu conteúdo é superficial ou desatualizado. Use ferramentas como Topic Research do SEMrush e Ahrefs para entender a cobertura dos concorrentes.

Defina Seus Pilares Topicais Centrais: Selecione de 3 a 5 áreas temáticas centrais com expertise genuína e demanda de mercado. Devem ser específicas o suficiente para demonstrar autoridade, mas amplas para comportar múltiplos artigos de apoio. Documente por que sua organização é única para abordar esses temas.

Crie um Mapa Abrangente de Conteúdo: Desenvolva um mapa visual das páginas pilar e conteúdos de cluster. Mostre como subtemas se relacionam aos pilares principais e entre si. Identifique quais conteúdos já existem, quais precisam ser criados e quais devem ser consolidados ou removidos.

Desenvolva ou Atualize Páginas Pilar: Crie páginas pilar abrangentes (3.000-5.000+ palavras) para cada tema central. Certifique-se de que cada pilar cubra o tema de forma ampla, inclua definições claras de entidades-chave e links para todos os clusters de apoio. Otimize páginas pilar com schema markup para ajudar LLMs a entenderem a estrutura.

Construa Conteúdo de Cluster e Linkagem Interna: Crie de 8 a 15 artigos de apoio para cada pilar, cada um explorando um subtema em profundidade. Implemente linkagem interna estratégica usando texto âncora descritivo. Garanta que artigos de cluster apontem para o pilar e para outros clusters relevantes.

Implemente Otimização de Entidades e Schema Markup: Adicione markup Schema.org em todo conteúdo para definir explicitamente entidades e seus relacionamentos. Mantenha menções consistentes de entidades em todo o conteúdo. Vincule entidades a fontes externas confiáveis para reforçar a credibilidade.

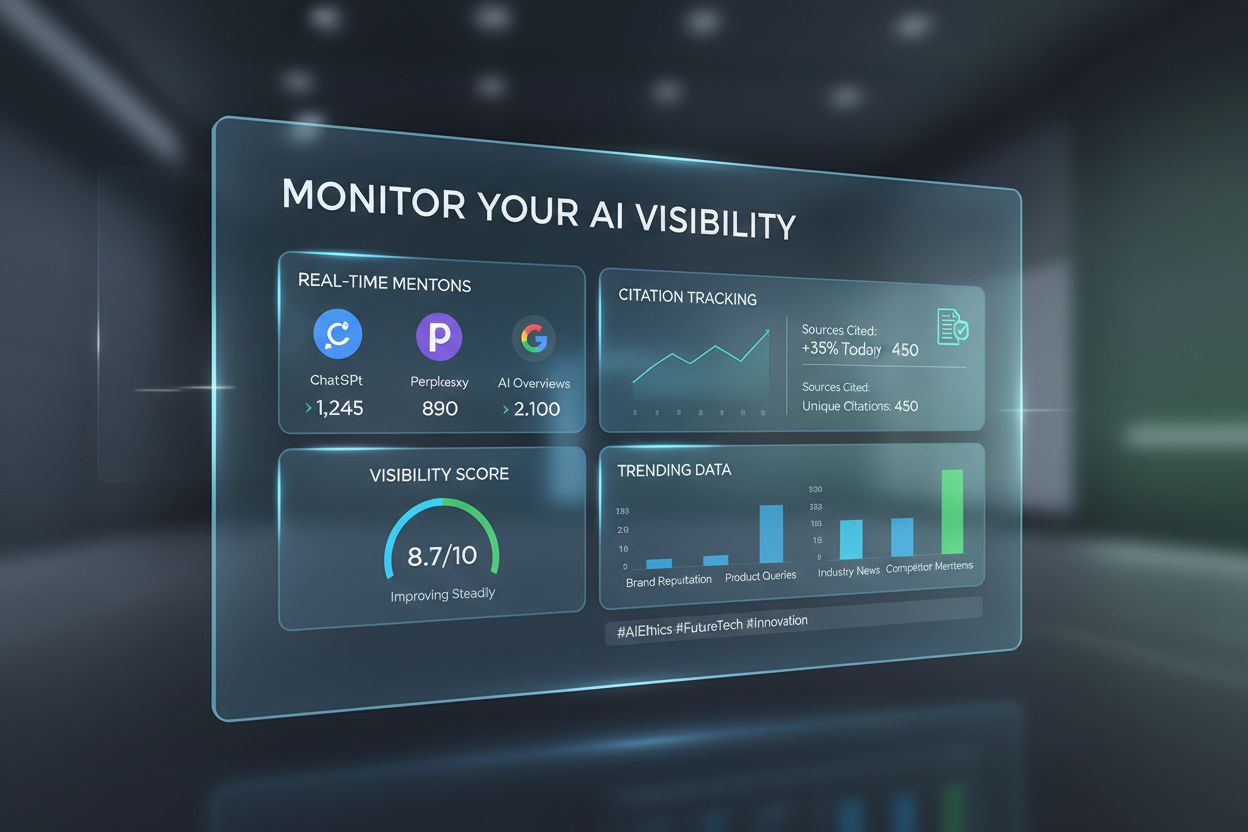

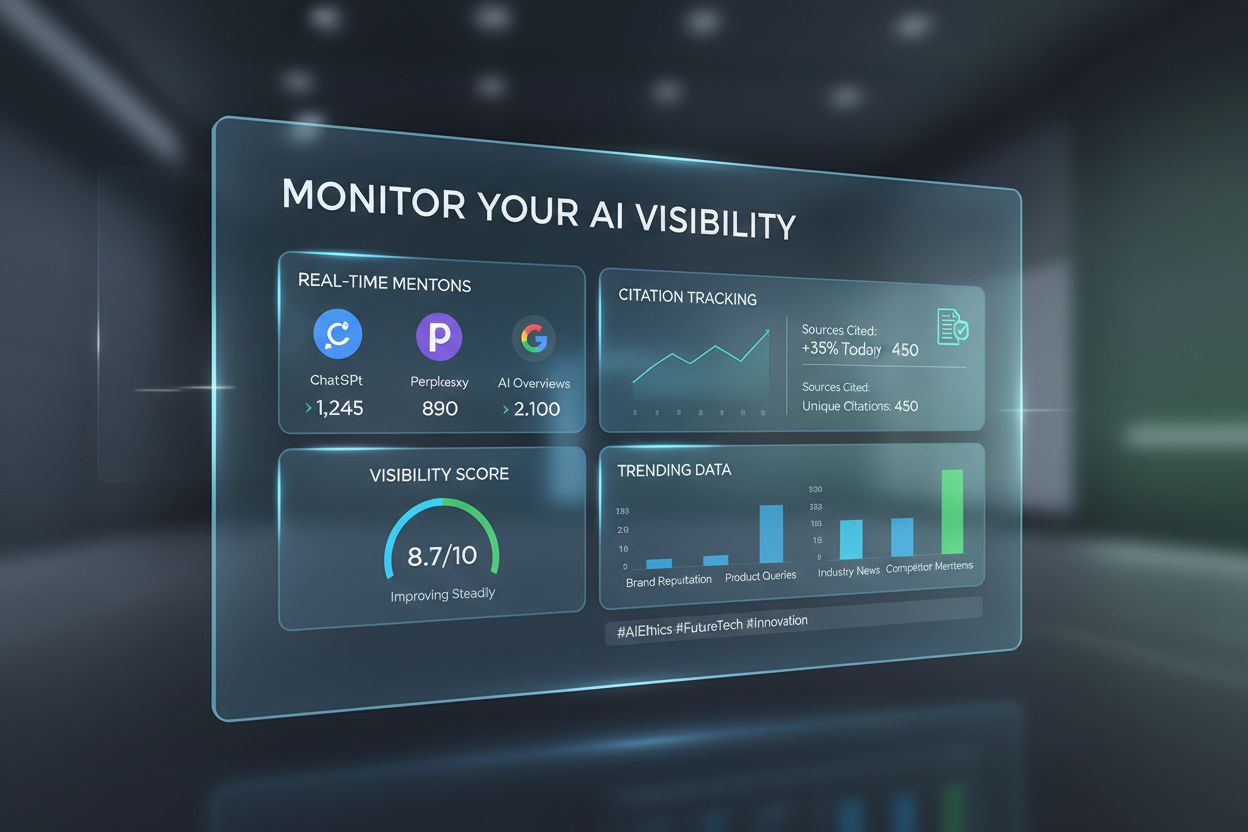

À medida que sua autoridade topical cresce, monitorar como isso se traduz em visibilidade nos sistemas de IA torna-se fundamental. AmICited é uma plataforma especializada para monitorar a presença e citações de sua marca em Grandes Modelos de Linguagem, fornecendo visibilidade sobre como sistemas de IA reconhecem e referenciam seu conteúdo. Diferente das ferramentas tradicionais de SEO, que focam em ranqueamento no Google, o AmICited monitora visibilidade em LLMs—medindo com que frequência e destaque sua marca aparece em respostas do ChatGPT, Gemini, Perplexity e outras plataformas de IA generativa.

A plataforma oferece diversos benefícios-chave para monitoramento de autoridade em IA:

Rastreamento de Citações Multiplataforma: Monitore menções e citações da sua marca em múltiplos LLMs simultaneamente, entendendo quais plataformas reconhecem mais fortemente sua autoridade e onde há lacunas de visibilidade.

Benchmarking Competitivo: Compare sua visibilidade em LLMs com concorrentes do setor. Entenda quais competidores são citados com mais frequência e analise suas estratégias para identificar oportunidades.

Análise de Contexto das Citações: Veja não apenas que você é citado, mas como é citado. Entenda quais temas acionam suas citações, em que contexto as LLMs mencionam sua marca e se as citações são positivas e precisas.

Monitoramento de Tendências de Visibilidade: Acompanhe como sua visibilidade em LLMs evolui ao longo do tempo conforme implementa melhorias em autoridade topical. Meça o impacto de novos conteúdos, atualizações e mudanças estruturais na visibilidade em IA.

Insights de Sinais de Autoridade: Receba recomendações sobre lacunas de conteúdo a preencher, temas a expandir e entidades a otimizar com base em padrões de citações em LLMs e análise competitiva.

Usando o AmICited junto com ferramentas tradicionais de SEO, você obtém uma visão completa da sua autoridade tanto na busca tradicional quanto na descoberta via IA. Essa dupla perspectiva é essencial em 2025 e além, à medida que a busca guiada por LLMs se torna central para a descoberta de informações. As marcas que monitoram e otimizam para visibilidade tradicional e em IA manterão vantagem competitiva conforme a busca evolui para respostas conversacionais geradas por IA.

A autoridade topical mede o quão abrangente e consistentemente você cobre uma área temática, enquanto o ranqueamento de palavras-chave foca em termos de busca individuais. As LLMs avaliam autoridade topical analisando profundidade semântica, relacionamentos de entidades e interconexão de conteúdos. Um site pode ranquear para palavras-chave específicas sem ter verdadeira autoridade topical, mas autoridade topical geralmente leva à visibilidade em várias consultas relacionadas e respostas geradas por IA.

Construir autoridade topical é uma estratégia de longo prazo que normalmente requer de 3 a 6 meses para mostrar resultados iniciais e de 6 a 12 meses para estabelecer forte reconhecimento. O tempo depende do seu ponto de partida, qualidade do conteúdo, nível de concorrência e quão consistentemente você implementa a estratégia. As LLMs reconhecem autoridade por padrões ao longo do tempo, então consistência e profundidade importam mais do que velocidade.

Sim, absolutamente. Ao contrário dos indicadores tradicionais de autoridade que favorecem domínios estabelecidos com muitos backlinks, as LLMs avaliam autoridade topical com base em profundidade semântica e qualidade do conteúdo. Uma marca pequena com 10 artigos abrangentes e interconectados sobre um tema específico pode superar um grande publisher com 100 artigos superficiais. Foque em profundidade, consistência e otimização de entidades em vez de tentar igualar volume.

Backlinks continuam relevantes para ranqueamento tradicional do Google, mas mostram fraca correlação com visibilidade em LLMs. Pesquisas mostram correlações entre métricas tradicionais de autoridade e visibilidade em LLMs variando de -0,08 a -0,21. Embora backlinks ainda importem para SEO, as LLMs priorizam relevância semântica, profundidade do conteúdo e relacionamentos de entidades. Foque em criar conteúdo excepcional que atraia citações naturalmente em vez de buscar links pelo simples objetivo de tê-los.

Sinais de autoridade topical incluem: aparecer em respostas geradas por IA para várias consultas relacionadas, citações consistentes em diferentes LLMs, ranqueamento para clusters de tópicos em vez de palavras-chave isoladas, métricas de engajamento elevadas em conteúdos pilar e de cluster, e reconhecimento como referência no seu setor. Use ferramentas como AmICited para rastrear citações em LLMs e Search Atlas para monitorar visibilidade por tópico.

Você deve focar em ambos, mas com prioridades diferentes. Autoridade topical é cada vez mais importante para descoberta por IA e visibilidade de longo prazo, enquanto SEO tradicional permanece fundamental para ranqueamento no Google. A boa notícia é que estratégias para construir autoridade topical (profundidade semântica, otimização de entidades, clusters de conteúdo) também melhoram o SEO tradicional. Comece com autoridade topical como base e os benefícios em SEO tradicional virão como consequência.

Sinais de engajamento do usuário como tempo de permanência, profundidade de rolagem e visitas recorrentes indicam às LLMs que seu conteúdo oferece valor genuíno. Quando os usuários passam tempo lendo seu conteúdo e exploram artigos relacionados em seu cluster, isso sinaliza que seu conteúdo é abrangente e autoritativo. LLMs interpretam esses padrões de engajamento como indicadores de qualidade e relevância, tornando a otimização da experiência do usuário essencial para autoridade topical.

As LLMs analisam como você menciona e conecta diferentes entidades (pessoas, organizações, produtos, conceitos) ao longo do seu conteúdo. Quando você referencia consistentemente entidades relacionadas e explica seus relacionamentos, as LLMs reconhecem isso como evidência de compreensão abrangente. Schema markup ajuda ao definir explicitamente os relacionamentos de entidades. Por exemplo, conectar 'planejamento de aposentadoria' com 'Previdência Social', 'estratégias de investimento' e 'otimização fiscal' mostra que você entende o ecossistema do tema.

Acompanhe como as LLMs citam seu conteúdo e meça sua autoridade topical no ChatGPT, Gemini e Perplexity com a plataforma de monitoramento de IA da AmICited.

Aprenda como construir autoridade para visibilidade em IA. Descubra estratégias de E-E-A-T, autoridade tópica e como ser citado em AI Overviews e respostas de L...

Discussão da comunidade sobre se as métricas tradicionais de autoridade de domínio ainda importam para a visibilidade em buscas por IA. Profissionais de SEO com...

Descubra o que significa autoridade de marca para IA, por que ela é importante para a visibilidade em buscas por IA e como construir sinais de confiança que aju...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.