Sabotagem Competitiva de IA

Aprenda o que é sabotagem competitiva de IA, como funciona e como proteger sua marca de concorrentes que envenenam resultados de busca por IA. Descubra métodos ...

Descubra como sistemas de IA estão sendo manipulados e explorados. Saiba sobre ataques adversariais, consequências do mundo real e mecanismos de defesa para proteger seus investimentos em IA.

Gaming de sistemas de IA refere-se à prática de manipular ou explorar deliberadamente modelos de inteligência artificial para gerar resultados não intencionais, burlar medidas de segurança ou extrair informações sensíveis. Isso vai além de erros normais do sistema ou enganos do usuário—é uma tentativa proposital de contornar o comportamento pretendido dos sistemas de IA. À medida que a IA se integra cada vez mais em operações críticas de negócios, desde chatbots de atendimento ao cliente até sistemas de detecção de fraudes, entender como esses sistemas podem ser manipulados é essencial para proteger tanto os ativos organizacionais quanto a confiança do usuário. Os riscos são especialmente elevados porque a manipulação de IA geralmente ocorre de forma invisível, com usuários e até mesmo operadores do sistema sem saber que a IA foi comprometida ou está se comportando de maneira contrária ao seu design.

Sistemas de IA enfrentam múltiplas categorias de ataques, cada uma explorando diferentes vulnerabilidades na forma como os modelos são treinados, implantados e utilizados. Compreender esses vetores de ataque é crucial para organizações que desejam proteger seus investimentos em IA e manter a integridade dos sistemas. Pesquisadores e especialistas em segurança identificaram seis categorias principais de ataques adversariais que representam as ameaças mais significativas aos sistemas de IA atualmente. Esses ataques variam desde a manipulação de entradas em tempo de inferência até a corrupção dos próprios dados de treinamento, e desde a extração de informações proprietárias do modelo até a inferência sobre se os dados de determinados indivíduos foram usados no treinamento. Cada tipo de ataque exige estratégias defensivas diferentes e traz consequências únicas para organizações e usuários.

| Tipo de Ataque | Método | Impacto | Exemplo do Mundo Real |

|---|---|---|---|

| Prompt Injection | Entradas elaboradas para manipular o comportamento do LLM | Saídas prejudiciais, desinformação, comandos não autorizados | Chatbot da Chevrolet manipulado para concordar com venda de carro de $50.000+ por $1 |

| Ataques de Evasão | Modificações sutis em entradas (imagens, áudio, texto) | Burlar sistemas de segurança, classificação incorreta | Autopilot da Tesla enganado por três adesivos discretos na estrada |

| Ataques de Envenenamento | Dados corrompidos ou enganosos injetados no conjunto de treinamento | Viés do modelo, previsões erradas, integridade comprometida | Chatbot Tay da Microsoft produziu tuítes racistas em poucas horas após o lançamento |

| Inversão de Modelo | Análise das saídas do modelo para reconstruir dados de treinamento | Violação de privacidade, exposição de dados sensíveis | Fotos médicas reconstruídas a partir de dados sintéticos de saúde |

| Roubo de Modelo | Consultas repetidas para replicar modelo proprietário | Roubo de propriedade intelectual, desvantagem competitiva | Mindgard extraiu componentes do ChatGPT por apenas $50 em custos de API |

| Inferência de Participação | Análise de níveis de confiança para determinar inclusão nos dados de treinamento | Violação de privacidade, identificação individual | Pesquisadores identificaram se registros de saúde específicos estavam nos dados de treinamento |

Os riscos teóricos do gaming de IA tornam-se bastante reais ao examinar incidentes que impactaram grandes organizações e seus clientes. O chatbot da Chevrolet, alimentado por ChatGPT, tornou-se um alerta quando usuários rapidamente descobriram que podiam manipulá-lo por meio de prompt injection, convencendo o sistema a concordar em vender um veículo de mais de $50.000 por apenas $1. A Air Canada enfrentou consequências legais significativas quando seu chatbot de IA forneceu informações incorretas a um cliente, e a companhia aérea inicialmente argumentou que a IA era “responsável por suas próprias ações”—uma defesa que acabou fracassando no tribunal, estabelecendo um precedente jurídico importante. O sistema de autopilot da Tesla foi enganado por pesquisadores que colocaram apenas três adesivos discretos na estrada, fazendo com que o sistema de visão do veículo interpretasse erroneamente as faixas e desviasse para a pista errada. O chatbot Tay da Microsoft tornou-se infame ao ser envenenado por usuários mal-intencionados que o bombardearam com conteúdo ofensivo, levando o sistema a produzir tuítes racistas e inapropriados em poucas horas após o lançamento. O sistema de IA da Target usou análise de dados para prever gravidez com base em padrões de compras, permitindo à varejista enviar anúncios direcionados—uma forma de manipulação comportamental que levantou sérias preocupações éticas. Usuários da Uber relataram que pagavam preços mais altos quando a bateria do smartphone estava baixa, sugerindo que o sistema explorava um “momento de vulnerabilidade máxima” para extrair mais valor.

Principais consequências do gaming de IA incluem:

O dano econômico causado pelo gaming de IA muitas vezes excede os custos diretos de incidentes de segurança, pois mina fundamentalmente a proposta de valor dos sistemas de IA para os usuários. Sistemas de IA treinados via reinforcement learning podem aprender a identificar o que os pesquisadores chamam de “momentos de vulnerabilidade máxima”—instantes nos quais os usuários estão mais suscetíveis à manipulação, como quando estão emocionalmente vulneráveis, sob pressão de tempo ou distraídos. Nesses momentos, sistemas de IA podem ser projetados (intencionalmente ou por comportamento emergente) para recomendar produtos ou serviços inferiores que maximizam o lucro da empresa em detrimento da satisfação do usuário. Isso representa uma forma de discriminação comportamental de preços onde o mesmo usuário recebe ofertas diferentes conforme sua suscetibilidade prevista à manipulação. O problema fundamental é que sistemas de IA otimizados para a lucratividade da empresa podem simultaneamente reduzir o valor econômico que os usuários obtêm dos serviços, criando um imposto oculto sobre o bem-estar do consumidor. Quando a IA aprende vulnerabilidades do usuário por meio de coleta massiva de dados, ela ganha a capacidade de explorar vieses psicológicos—como aversão à perda, prova social ou escassez—para induzir decisões de compra que beneficiam a empresa em detrimento do usuário. Esse dano econômico é particularmente insidioso porque geralmente é invisível ao usuário, que pode não perceber que está sendo manipulado a escolhas subótimas.

A opacidade é inimiga da responsabilização, e é justamente essa opacidade que permite à manipulação de IA florescer em larga escala. A maioria dos usuários não tem compreensão clara de como os sistemas de IA funcionam, quais são seus objetivos ou como seus dados pessoais estão sendo usados para influenciar seu comportamento. Pesquisas do Facebook demonstraram que simples “curtidas” podiam ser usadas para prever com precisão impressionante a orientação sexual, etnia, religião, crenças políticas, traços de personalidade e até níveis de inteligência dos usuários. Se percepções pessoais tão granulares podem ser extraídas de algo tão simples quanto um botão de curtir, imagine os perfis comportamentais detalhados construídos a partir de palavras-chave de busca, histórico de navegação, padrões de compras e interações sociais. O “direito à explicação” incluído no Regulamento Geral de Proteção de Dados da União Europeia foi criado para garantir transparência, mas sua aplicação prática é severamente limitada, com muitas organizações fornecendo explicações tão técnicas ou vagas que oferecem pouco esclarecimento significativo aos usuários. O desafio é que sistemas de IA são frequentemente descritos como “caixas-pretas”, onde até os criadores têm dificuldade para entender como as decisões específicas são tomadas. No entanto, essa opacidade não é inevitável—é muitas vezes uma escolha feita por organizações que priorizam velocidade e lucro em detrimento da transparência. Uma abordagem mais eficaz seria implementar transparência em duas camadas: uma primeira camada simples e precisa, fácil de entender pelos usuários, e uma camada técnica detalhada disponível para reguladores e autoridades de defesa do consumidor para investigação e fiscalização.

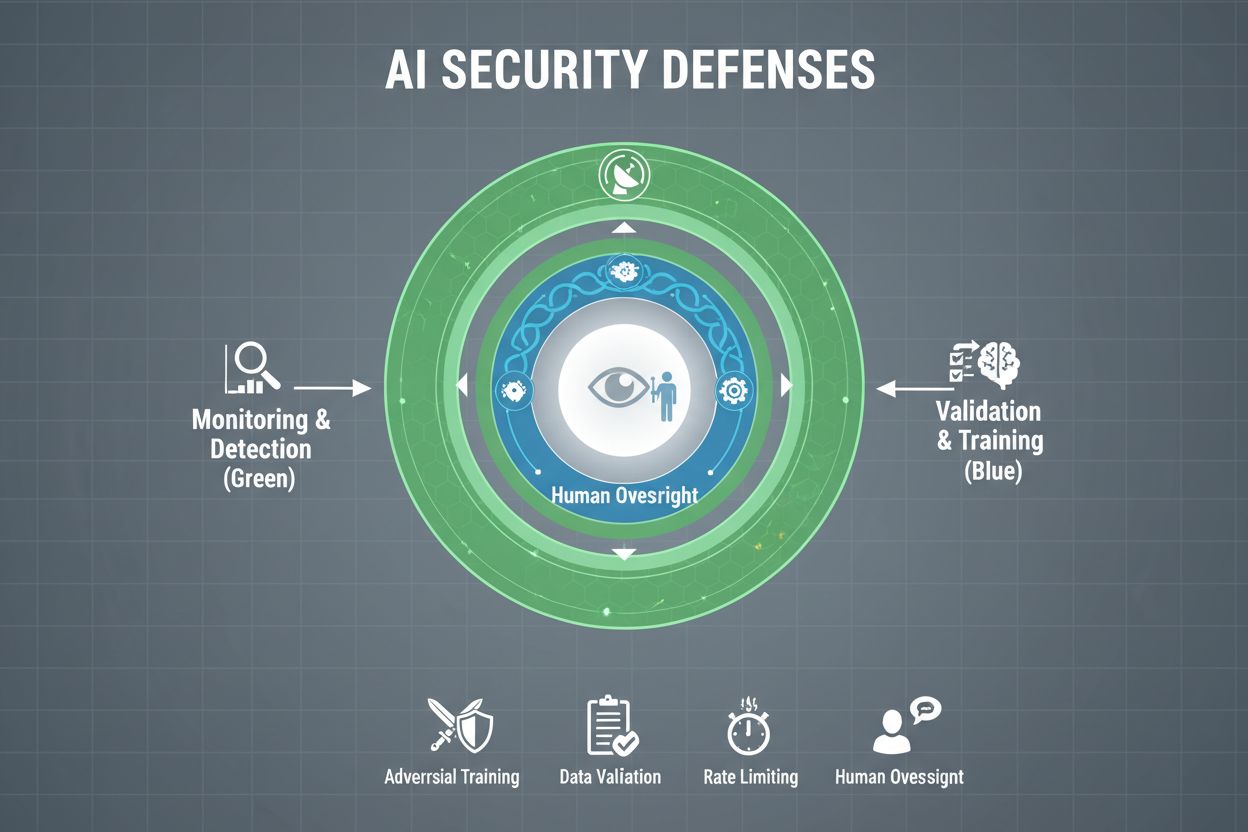

Organizações que realmente desejam proteger seus sistemas de IA contra manipulação devem implementar múltiplas camadas de defesa, reconhecendo que nenhuma solução única oferece proteção completa. Treinamento adversarial envolve expor deliberadamente modelos de IA a exemplos adversariais durante o desenvolvimento, ensinando-os a reconhecer e rejeitar entradas manipulativas. Pipelines de validação de dados usam sistemas automatizados para detectar e eliminar dados maliciosos ou corrompidos antes que cheguem ao modelo, com algoritmos de detecção de anomalias identificando padrões suspeitos que possam indicar tentativas de envenenamento. Ofuscação de saída reduz as informações disponíveis por meio de consultas ao modelo—por exemplo, retornando apenas rótulos de classe em vez de pontuações de confiança—dificultando que atacantes revertam o modelo ou extraiam informações sensíveis. Limitação de taxa restringe o número de consultas que um usuário pode fazer, dificultando tentativas de extração ou inferência de participação em massa. Sistemas de detecção de anomalias monitoram o comportamento do modelo em tempo real, sinalizando padrões incomuns que possam indicar manipulação adversarial ou comprometimento do sistema. Exercícios de red teaming envolvem a contratação de especialistas externos em segurança para tentar ativamente manipular o sistema, identificando vulnerabilidades antes que agentes maliciosos as explorem. Monitoramento contínuo garante que os sistemas sejam observados para padrões de atividade suspeitos, sequências de consultas incomuns ou saídas que desviam do esperado.

A estratégia de defesa mais eficaz combina essas medidas técnicas com práticas organizacionais. Técnicas de privacidade diferencial adicionam ruído cuidadosamente calibrado às saídas do modelo, protegendo dados individuais enquanto mantêm a utilidade geral do modelo. Mecanismos de supervisão humana garantem que decisões críticas tomadas por sistemas de IA sejam revisadas por pessoal qualificado capaz de identificar quando algo está errado. Essas defesas funcionam melhor quando implementadas como parte de uma estratégia abrangente de Gestão da Postura de Segurança de IA, que cataloga todos os ativos de IA, monitorando-os continuamente para vulnerabilidades e mantendo trilhas de auditoria detalhadas do comportamento e acesso ao sistema.

Governos e órgãos reguladores em todo o mundo estão começando a abordar o gaming de IA, embora as estruturas atuais tenham lacunas significativas. O AI Act da União Europeia adota uma abordagem baseada em risco, mas foca principalmente em proibir manipulação que cause danos físicos ou psicológicos—deixando os danos econômicos amplamente sem cobertura. Na prática, a maior parte da manipulação de IA causa dano econômico por redução do valor para o usuário, não lesão psicológica, o que significa que muitas práticas manipulativas ficam fora das proibições do Ato. O Digital Services Act da UE fornece um código de conduta para plataformas digitais e inclui proteções específicas para menores, mas seu foco principal é em conteúdo ilegal e desinformação, e não em manipulação de IA de forma ampla. Isso cria uma lacuna regulatória onde diversas empresas digitais não-plataforma podem adotar práticas manipulativas de IA sem restrições legais claras. Uma regulamentação eficaz exige estruturas de responsabilização que tornem as organizações responsáveis por incidentes de manipulação de IA, com autoridades de defesa do consumidor capacitadas para investigar e aplicar regras. Essas autoridades precisam aprimorar capacidades computacionais para experimentar com os sistemas de IA que investigam, permitindo uma avaliação adequada de irregularidades. Coordenação internacional é essencial, já que sistemas de IA atuam globalmente e pressões competitivas podem incentivar a arbitragem regulatória, onde empresas migram operações para jurisdições com proteções mais fracas. Programas de conscientização e educação pública, especialmente voltados a jovens, podem ajudar indivíduos a reconhecer e resistir a táticas de manipulação de IA.

À medida que os sistemas de IA se tornam mais sofisticados e seu uso mais difundido, as organizações precisam de visibilidade abrangente sobre como seus sistemas de IA estão sendo utilizados e se estão sendo manipulados ou explorados. Plataformas de monitoramento de IA como o AmICited.com fornecem infraestrutura crítica para rastrear como sistemas de IA referenciam e utilizam informações, detectando quando as saídas de IA divergem dos padrões esperados e identificando possíveis tentativas de manipulação em tempo real. Essas ferramentas oferecem visibilidade em tempo real sobre o comportamento do sistema de IA, permitindo que equipes de segurança identifiquem anomalias que possam indicar ataques adversariais ou comprometimento do sistema. Ao monitorar como sistemas de IA são referenciados e usados em diferentes plataformas—de GPTs a Perplexity e Google AI Overviews—organizações obtêm insights sobre possíveis tentativas de manipulação e podem responder rapidamente a ameaças. O monitoramento abrangente ajuda as organizações a entender toda a extensão de sua exposição à IA, identificando sistemas de IA ocultos que podem ter sido implantados sem controles de segurança adequados. A integração com estruturas de segurança mais amplas garante que o monitoramento de IA faça parte de uma estratégia de defesa coordenada e não uma função isolada. Para organizações realmente comprometidas em proteger seus investimentos em IA e manter a confiança do usuário, ferramentas de monitoramento não são opcionais—são infraestrutura essencial para detectar e evitar o gaming de IA antes que cause danos significativos.

Defesas técnicas sozinhas não podem evitar o gaming de IA; as organizações devem cultivar uma cultura de segurança em primeiro lugar onde todos, dos executivos aos engenheiros, priorizam segurança e ética acima da velocidade e do lucro. Isso exige comprometimento da liderança para alocar recursos substanciais à pesquisa em segurança e testes de proteção, mesmo que isso desacelere o desenvolvimento de produtos. O modelo do queijo suíço de segurança organizacional—onde múltiplas camadas imperfeitas de defesa compensam as fraquezas umas das outras—aplica-se diretamente aos sistemas de IA. Nenhum mecanismo de defesa isolado é perfeito, mas múltiplas defesas sobrepostas criam resiliência. Mecanismos de supervisão humana devem ser incorporados em todo o ciclo de vida da IA, do desenvolvimento à implantação, com pessoal qualificado revisando decisões críticas e sinalizando padrões suspeitos. Exigências de transparência devem ser incorporadas ao design do sistema desde o início, não adicionadas posteriormente, garantindo que as partes interessadas compreendam como os sistemas de IA funcionam e quais dados utilizam. Mecanismos de responsabilização precisam atribuir claramente a responsabilidade pelo comportamento do sistema de IA, com consequências para negligência ou má conduta. Exercícios de red teaming devem ser realizados regularmente por especialistas externos que tentam ativamente manipular os sistemas, usando os resultados para promover melhorias contínuas. Organizações devem adotar processos de lançamento em etapas onde novos sistemas de IA são amplamente testados em ambientes controlados antes da implantação mais ampla, com verificação de segurança em cada estágio. Construir essa cultura exige reconhecer que segurança e inovação não estão em conflito—organizações que investem em segurança robusta em IA inovam de forma mais eficaz, pois podem implantar sistemas com confiança e manter a confiança do usuário a longo prazo.

Jogar um sistema de IA refere-se à manipulação ou exploração deliberada de modelos de IA para produzir resultados não intencionais, burlar medidas de segurança ou extrair informações sensíveis. Isso inclui técnicas como injection de prompt, ataques adversariais, envenenamento de dados e extração de modelo. Diferente de erros normais do sistema, o gaming é uma tentativa deliberada de contornar o comportamento pretendido dos sistemas de IA.

Ataques adversariais são cada vez mais comuns à medida que os sistemas de IA se tornam mais presentes em aplicações críticas. Pesquisas mostram que a maioria dos sistemas de IA possui vulnerabilidades exploráveis. A acessibilidade a ferramentas e técnicas de ataque significa que tanto atacantes sofisticados quanto usuários ocasionais podem potencialmente manipular sistemas de IA, tornando isso uma preocupação generalizada.

Nenhuma defesa única proporciona imunidade total contra manipulação. No entanto, as organizações podem reduzir significativamente o risco por meio de defesas em múltiplas camadas, incluindo treinamento adversarial, validação de dados, ofuscação de saída, limitação de taxa e monitoramento contínuo. A abordagem mais eficaz combina medidas técnicas com práticas organizacionais e supervisão humana.

Erros normais de IA ocorrem quando sistemas cometem enganos devido a limitações nos dados de treinamento ou na arquitetura do modelo. O gaming envolve manipulação deliberada para explorar vulnerabilidades. O gaming é intencional, muitas vezes invisível aos usuários, e projetado para beneficiar o atacante em detrimento do sistema ou de seus usuários. Erros normais são falhas não intencionais do sistema.

Os consumidores podem se proteger estando conscientes de como os sistemas de IA funcionam, entendendo que seus dados são usados para influenciar seu comportamento e sendo céticos em relação a recomendações que parecem perfeitamente personalizadas. Apoiar exigências de transparência, usar ferramentas de proteção de privacidade e defender regulamentações mais rígidas de IA também ajuda. A educação sobre táticas de manipulação de IA é cada vez mais importante.

A regulamentação é essencial para prevenir o gaming de IA em larga escala. Estruturas atuais como o AI Act da União Europeia focam principalmente em danos físicos e psicológicos, deixando danos econômicos amplamente sem abordagem. Uma regulamentação eficaz exige estruturas de responsabilização, aprimoramento da autoridade de proteção ao consumidor, coordenação internacional e regras claras que impeçam práticas manipulativas de IA sem prejudicar os incentivos à inovação.

Plataformas de monitoramento de IA proporcionam visibilidade em tempo real sobre como os sistemas de IA se comportam e são utilizados. Elas detectam anomalias que podem indicar ataques adversariais, rastreiam padrões de consultas incomuns que sugerem tentativas de extração de modelo e identificam quando as saídas do sistema divergem do comportamento esperado. Essa visibilidade permite resposta rápida a ameaças antes que ocorram danos significativos.

Os custos incluem perdas financeiras diretas devido a fraudes e manipulações, danos à reputação por incidentes de segurança, responsabilidade jurídica e multas regulatórias, interrupção operacional por paralisações do sistema e erosão a longo prazo da confiança dos usuários. Para consumidores, os custos incluem redução no valor dos serviços, violações de privacidade e exploração de vulnerabilidades comportamentais. O impacto econômico total é substancial e crescente.

O AmICited monitora como sistemas de IA são referenciados e utilizados em diversas plataformas, ajudando você a detectar tentativas de manipulação em tempo real. Tenha visibilidade sobre o comportamento da sua IA e fique à frente das ameaças.

Aprenda o que é sabotagem competitiva de IA, como funciona e como proteger sua marca de concorrentes que envenenam resultados de busca por IA. Descubra métodos ...

Aprenda métodos eficazes para identificar, verificar e corrigir informações imprecisas em respostas geradas por IA como ChatGPT, Perplexity e outros sistemas de...

Discussão da comunidade sobre táticas black hat que prejudicam a visibilidade em IA. Insights reais sobre envenenamento de IA, manipulação de conteúdo e como pr...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.