Intenção de Busca

Intenção de busca é o propósito por trás da consulta de pesquisa de um usuário. Saiba quais são os quatro tipos de intenção de busca, como identificá-los e otim...

Descubra como grandes modelos de linguagem interpretam a intenção do usuário além das palavras-chave. Explore expansão de consultas, compreensão semântica e como sistemas de IA determinam quais conteúdos citar nas respostas.

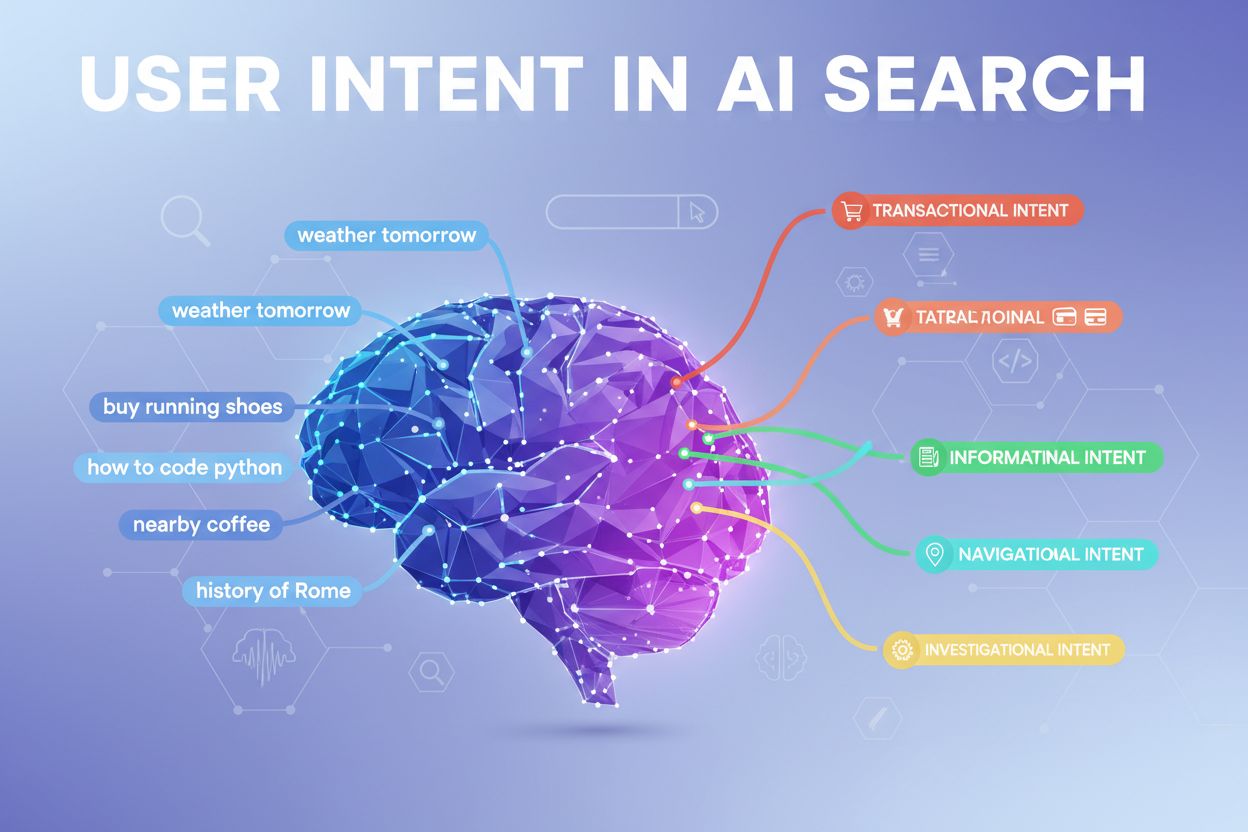

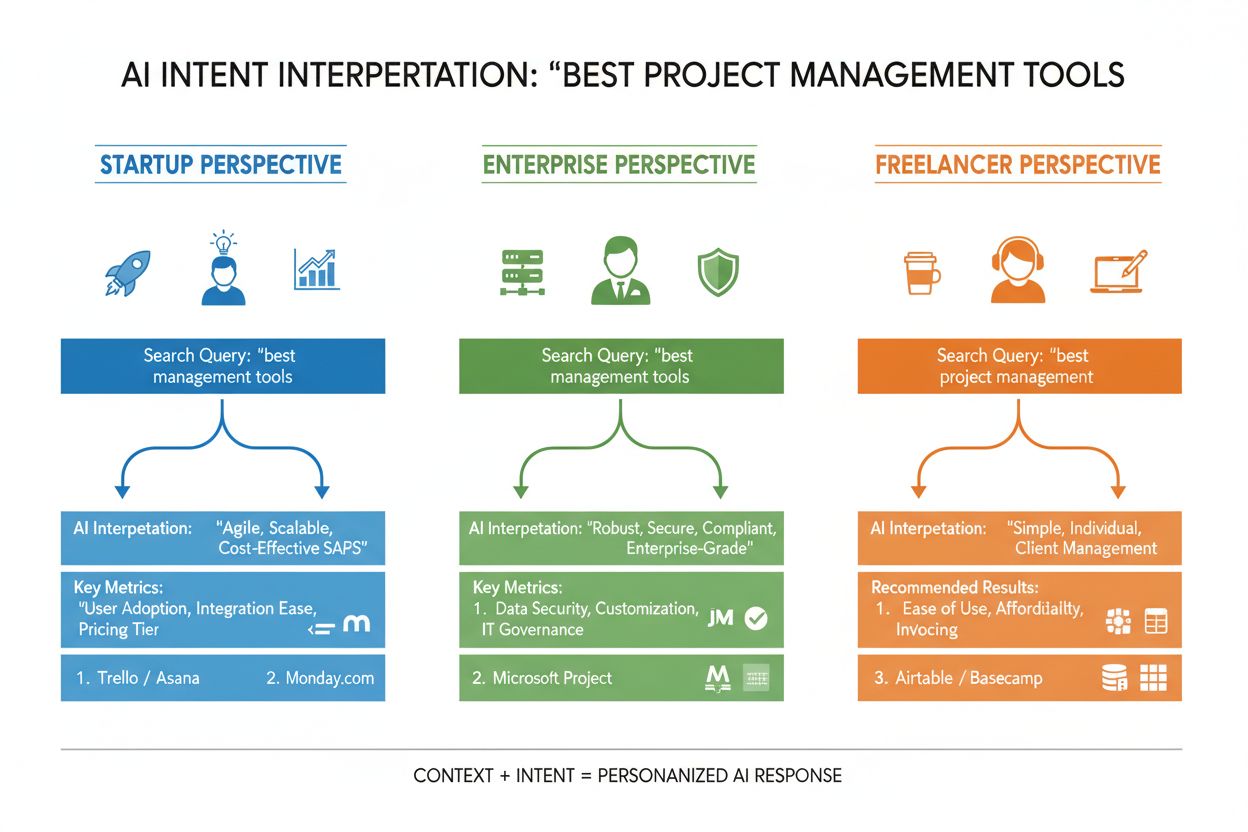

Intenção do usuário na busca por IA refere-se ao objetivo ou propósito subjacente por trás de uma consulta, e não apenas às palavras-chave que alguém digita. Ao pesquisar por “melhores ferramentas de gestão de projetos”, você pode estar buscando uma comparação rápida, informações de preços ou capacidades de integração — e grandes modelos de linguagem (LLMs) como ChatGPT, Perplexity e o Gemini do Google trabalham para entender qual desses objetivos você realmente está perseguindo. Ao contrário dos motores de busca tradicionais que associam palavras-chave a páginas, LLMs interpretam o significado semântico da sua consulta analisando contexto, formulação e sinais relacionados para prever o que você realmente deseja alcançar. Essa mudança da correspondência de palavras-chave para a compreensão da intenção é fundamental para o funcionamento dos sistemas modernos de busca por IA, e determina diretamente quais fontes são citadas nas respostas geradas por IA. Compreender a intenção do usuário tornou-se essencial para marcas que buscam visibilidade nos resultados de busca por IA, já que ferramentas como o AmICited agora monitoram como sistemas de IA referenciam seu conteúdo com base no alinhamento de intenção.

Quando você insere uma única consulta em um sistema de busca por IA, algo notável acontece nos bastidores: o modelo não responde apenas diretamente à sua pergunta. Em vez disso, ele expande sua consulta em dezenas de microperguntas relacionadas, um processo que pesquisadores chamam de “query fan-out”. Por exemplo, uma busca simples como “Notion vs Trello” pode acionar subconsultas como “Qual é melhor para colaboração em equipe?”, “Quais são as diferenças de preços?”, “Qual integra melhor com Slack?” e “Qual é mais fácil para iniciantes?” Essa expansão permite que os LLMs explorem diferentes ângulos da sua intenção e coletem informações mais completas antes de gerar uma resposta. O sistema então avalia trechos de diferentes fontes em um nível granular, em vez de ranquear páginas inteiras, o que significa que um único parágrafo do seu conteúdo pode ser selecionado enquanto o resto da página é ignorado. Essa análise em nível de passagem faz com que clareza e especificidade em cada seção sejam mais importantes do que nunca — uma resposta bem estruturada para uma sub-intenção específica pode ser o motivo de seu conteúdo ser puxado para uma resposta gerada por IA.

| Consulta Original | Sub-Intenção 1 | Sub-Intenção 2 | Sub-Intenção 3 | Sub-Intenção 4 |

|---|---|---|---|---|

| “Melhores ferramentas de gestão de projetos” | “Qual é melhor para equipes remotas?” | “Qual o preço?” | “Qual integra com Slack?” | “Qual é mais fácil para iniciantes?” |

| “Como melhorar a produtividade” | “Quais ferramentas ajudam na gestão do tempo?” | “Quais métodos de produtividade são comprovados?” | “Como reduzir distrações?” | “Quais hábitos aumentam o foco?” |

| “Motores de busca por IA explicados” | “Como diferem do Google?” | “Qual busca por IA é mais precisa?” | “Como lidam com privacidade?” | “Qual o futuro da busca por IA?” |

LLMs não avaliam sua consulta isoladamente — eles constroem o que pesquisadores chamam de “user embedding”, um perfil vetorial que captura sua intenção em evolução com base no histórico de buscas, localização, tipo de dispositivo, horário e até conversas anteriores. Essa compreensão contextual permite que o sistema personalize os resultados de forma dramática: dois usuários buscando por “melhores ferramentas de CRM” podem receber recomendações completamente diferentes se um for fundador de startup e o outro gerente de uma grande empresa. Reclassificação em tempo real refina ainda mais os resultados com base em como você interage — se você clica em certos resultados, passa tempo lendo seções específicas ou faz perguntas adicionais, o sistema ajusta sua compreensão da intenção e atualiza recomendações futuras. Esse ciclo de feedback comportamental faz com que sistemas de IA estejam constantemente aprendendo o que os usuários realmente querem, não apenas o que digitaram inicialmente. Para criadores de conteúdo e profissionais de marketing, isso reforça a importância de criar conteúdos que satisfaçam intenção em múltiplos contextos e estágios de decisão do usuário.

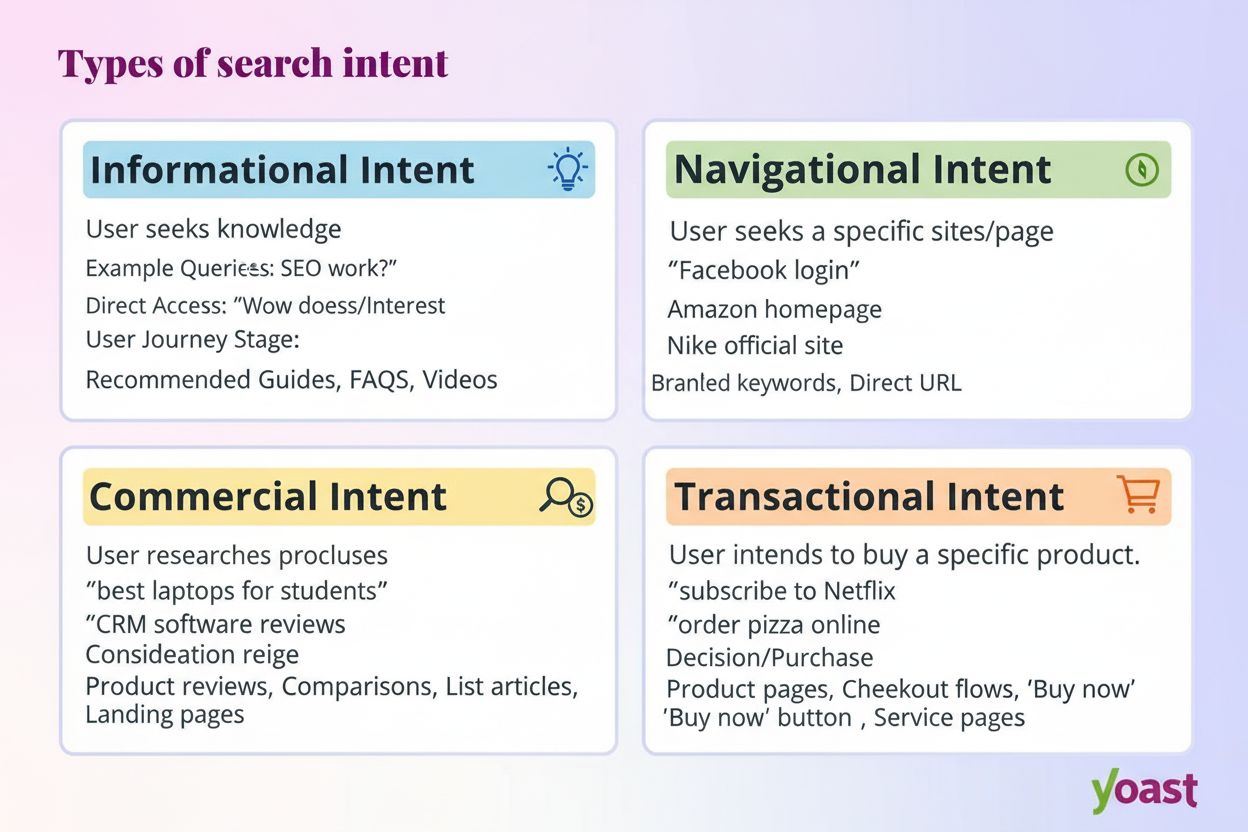

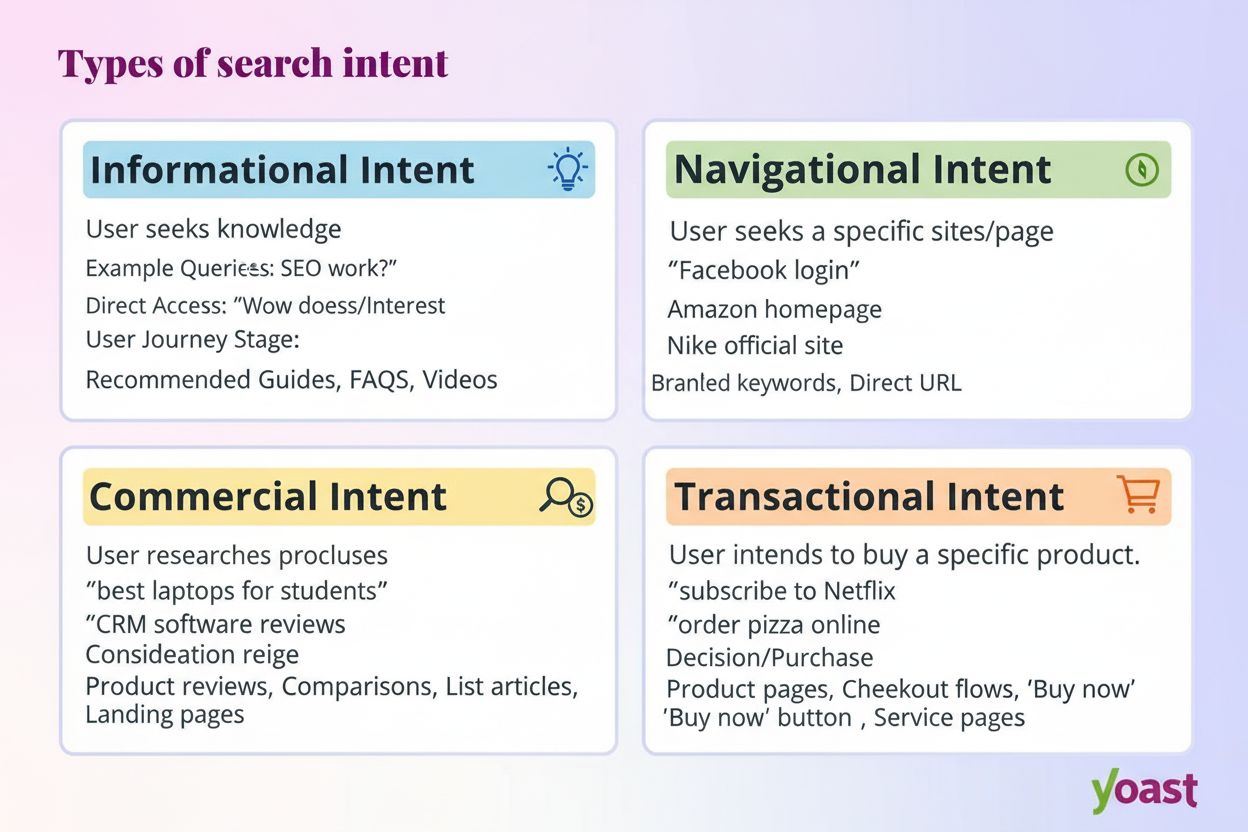

Sistemas modernos de IA classificam a intenção do usuário em várias categorias distintas, cada uma exigindo tipos diferentes de conteúdo e respostas:

LLMs classificam essas intenções automaticamente analisando a estrutura da consulta, palavras-chave e sinais contextuais, selecionando o conteúdo que melhor corresponde ao tipo de intenção detectado. Entender essas categorias ajuda criadores de conteúdo a estruturar suas páginas para abordar a intenção específica que os usuários trazem às buscas.

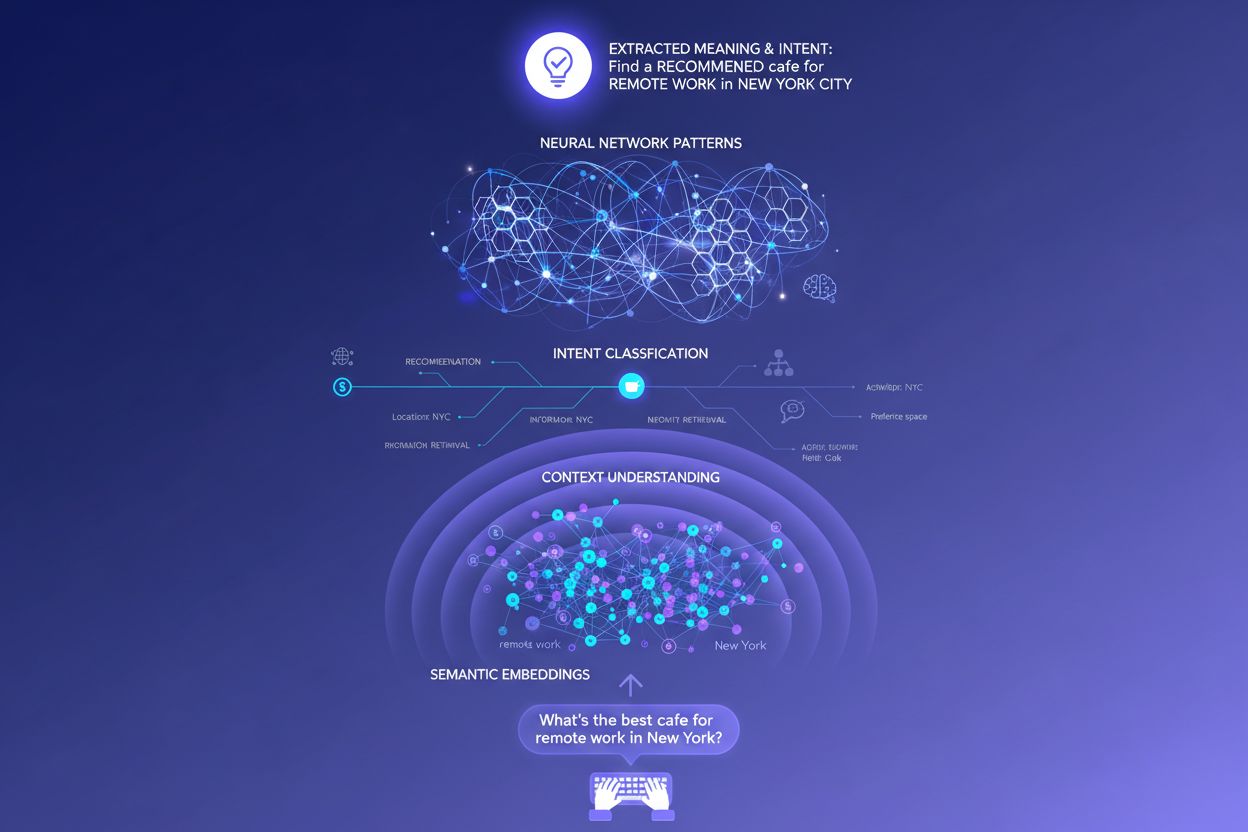

Motores de busca tradicionais baseados em palavras-chave operam através de simples correspondência de strings — se sua página contém as palavras exatas da busca, pode ranquear. Essa abordagem falha completamente com sinônimos, paráfrases e contexto. Se alguém buscar “software de gestão de projetos acessível” e sua página usar a frase “plataforma econômica de coordenação de tarefas”, a busca tradicional pode não perceber a ligação. Embeddings semânticos resolvem esse problema convertendo palavras e frases em vetores matemáticos que capturam significado, e não apenas o texto superficial. Esses vetores existem em um espaço de alta dimensionalidade onde conceitos semanticamente similares se agrupam, permitindo que LLMs reconheçam que “acessível”, “econômico”, “barato” e “baixo custo” expressam a mesma intenção. Essa abordagem semântica também lida muito melhor com buscas longas e conversacionais — uma consulta como “Sou freelancer e preciso de algo simples, mas poderoso” pode ser associada a conteúdos relevantes mesmo sem palavras-chave tradicionais. O resultado prático é que sistemas de IA conseguem apresentar respostas relevantes para consultas vagas, complexas ou incomuns, tornando-os muito mais úteis do que seus predecessores baseados apenas em palavras-chave.

No núcleo técnico da interpretação de intenção está a arquitetura transformer, um modelo de rede neural que processa linguagem analisando as relações entre palavras por meio de um mecanismo chamado “atenção”. Em vez de ler o texto sequencialmente como um humano, transformers avaliam como cada palavra se relaciona com todas as outras na consulta, permitindo captar significado e contexto de forma sutil. Embeddings semânticos são as representações numéricas que emergem desse processo — cada palavra, frase ou conceito é convertido em um vetor de números que codifica seu significado. Modelos como BERT (Bidirectional Encoder Representations from Transformers) e RankBrain usam esses embeddings para entender que “melhor CRM para startups” e “plataforma de gestão de relacionamento com clientes topo para novas empresas” expressam intenções similares, mesmo usando palavras totalmente diferentes. O mecanismo de atenção é especialmente poderoso porque permite ao modelo focar nas partes mais relevantes da consulta — em “melhores ferramentas de gestão de projetos para equipes remotas com orçamento limitado”, o sistema aprende a dar mais peso a “equipes remotas” e “orçamento limitado” como sinais críticos de intenção. Essa sofisticação técnica é o motivo pelo qual a busca por IA moderna parece muito mais inteligente do que sistemas tradicionais baseados em palavras-chave.

Entender como LLMs interpretam intenção muda fundamentalmente a estratégia de conteúdo. Em vez de escrever um guia abrangente tentando ranquear para uma única palavra-chave, conteúdos de sucesso agora abordam múltiplas sub-intenções em seções modulares que podem ser usadas isoladamente. Se você está escrevendo sobre ferramentas de gestão de projetos, em vez de uma comparação gigantesca, crie seções distintas respondendo “Qual é melhor para equipes remotas?”, “Qual é a opção mais acessível?” e “Qual integra com Slack?” — cada seção torna-se um potencial cartão de resposta que LLMs podem extrair e citar. Formatação pronta para citação é fundamental: use fatos em vez de afirmações vagas, inclua números e datas específicos, e estruture informações para que sistemas de IA possam citar ou resumir facilmente. Listas, títulos claros e parágrafos curtos ajudam os LLMs a analisar seu conteúdo com mais eficiência do que textos densos. Ferramentas como o AmICited agora permitem que profissionais de marketing monitorem como sistemas de IA referenciam seu conteúdo no ChatGPT, Perplexity e Google IA, revelando quais alinhamentos de intenção estão funcionando e onde há lacunas. Essa abordagem orientada por dados — otimizando para como sistemas de IA realmente interpretam e citam seu trabalho — representa uma mudança fundamental em relação ao SEO tradicional.

Considere um exemplo de e-commerce: quando alguém busca “jaqueta impermeável até R$ 1.000”, está expressando múltiplas intenções simultaneamente — deseja informações sobre durabilidade, confirmação de preço e recomendações de produtos. Um sistema de IA pode expandir isso em subconsultas sobre tecnologia de impermeabilização, comparações de preços, avaliações de marcas e informações sobre garantia. Uma marca que aborda todos esses ângulos em conteúdo modular e bem estruturado tem muito mais chances de ser citada na resposta gerada por IA do que um concorrente com uma página genérica de produto. No setor de SaaS, a mesma consulta “Como convido minha equipe para este workspace?” pode aparecer centenas de vezes em logs de suporte, sinalizando uma lacuna crítica de conteúdo. Um assistente de IA treinado na sua documentação pode ter dificuldade para responder claramente a essa pergunta, levando a uma experiência ruim do usuário e menor visibilidade em respostas geradas por IA no suporte. Em contextos de notícias e informação, uma consulta como “O que está acontecendo com a regulação de IA?” será interpretada de forma diferente conforme o contexto do usuário — um legislador pode precisar de detalhes legais, um líder empresarial de implicações competitivas, e um tecnólogo de informações sobre padrões técnicos. Conteúdos de sucesso abordam explicitamente esses diferentes contextos de intenção.

Apesar da sofisticação, LLMs enfrentam desafios reais na interpretação de intenção. Consultas ambíguas como “Java” podem se referir à linguagem de programação, à ilha ou ao café — mesmo com contexto, o sistema pode classificar mal a intenção. Intenções mistas ou sobrepostas complicam ainda mais: “Este CRM é melhor que o Salesforce e onde posso testá-lo grátis?” combina comparação, avaliação e intenção transacional em uma única consulta. Limitações de janela de contexto significam que LLMs só podem considerar uma quantidade finita do histórico de conversa, de modo que em diálogos longos, sinais de intenção anteriores podem ser esquecidos. Alucinações e erros factuais continuam sendo um risco, especialmente em áreas que exigem alta precisão como saúde, finanças ou jurídico. Considerações de privacidade também importam — à medida que sistemas coletam mais dados comportamentais para melhorar a personalização, precisam equilibrar precisão de intenção e privacidade do usuário. Compreender essas limitações ajuda criadores de conteúdo e profissionais de marketing a estabelecer expectativas realistas sobre visibilidade em buscas por IA e reconhecer que nem toda consulta será interpretada perfeitamente.

A busca baseada em intenção está evoluindo rapidamente para uma compreensão e interação cada vez mais sofisticadas. IA conversacional será cada vez mais natural, com sistemas mantendo contexto em diálogos longos e complexos, onde a intenção pode mudar e evoluir. Compreensão multimodal de intenção combinará texto, imagens, voz e até vídeo para interpretar objetivos do usuário de forma mais holística — imagine pedir a um assistente de IA “encontre algo como isto” enquanto mostra uma foto. Busca sem consulta representa uma fronteira emergente onde sistemas de IA antecipam necessidades do usuário antes que sejam explicitamente manifestadas, usando sinais comportamentais e contexto para apresentar informações relevantes proativamente. Personalização aprimorada tornará os resultados cada vez mais adaptados ao perfil individual, estágio de decisão e contexto do usuário. Integração com sistemas de recomendação borrará a linha entre busca e descoberta, com sistemas sugerindo conteúdos relevantes que o usuário nem sabia procurar. À medida que essas capacidades amadurecem, a vantagem competitiva será cada vez mais das marcas e criadores que entendem profundamente a intenção e estruturam conteúdos para satisfazê-la de forma abrangente em múltiplos contextos e tipos de usuário.

Intenção do usuário refere-se ao objetivo ou propósito subjacente por trás de uma consulta, e não apenas às palavras-chave digitadas. LLMs interpretam o significado semântico analisando contexto, formulação e sinais relacionados para prever o que os usuários realmente querem alcançar. Por isso, a mesma consulta pode gerar resultados diferentes dependendo do contexto do usuário e da etapa da tomada de decisão.

LLMs usam um processo chamado 'query fan-out' para dividir uma única consulta em dezenas de micro-perguntas relacionadas. Por exemplo, 'Notion vs Trello' pode se expandir em subconsultas sobre colaboração em equipe, preços, integrações e facilidade de uso. Isso permite que sistemas de IA explorem diferentes ângulos da intenção e reúnam informações abrangentes.

Compreender a intenção ajuda criadores de conteúdo a otimizar para a forma como sistemas de IA realmente interpretam e citam seu trabalho. Conteúdos que abordam várias sub-intenções em seções modulares têm mais chances de serem selecionados pelos LLMs. Isso impacta diretamente a visibilidade em respostas geradas por IA no ChatGPT, Perplexity e Google IA.

Embeddings semânticos convertem palavras e frases em vetores matemáticos que capturam significado, não apenas o texto superficial. Isso permite que LLMs reconheçam que 'acessível', 'econômico' e 'barato' expressam a mesma intenção, mesmo usando palavras diferentes. Essa abordagem semântica lida muito melhor com sinônimos, paráfrases e contexto do que a correspondência tradicional de palavras-chave.

Sim, LLMs enfrentam desafios com consultas ambíguas, intenções mistas e limitações de contexto. Consultas como 'Java' podem se referir à linguagem de programação, geografia ou café. Conversas longas podem exceder as janelas de contexto, fazendo com que sinais de intenção anteriores sejam esquecidos. Entender essas limitações ajuda a definir expectativas realistas sobre a visibilidade em buscas por IA.

Marcas devem criar conteúdo modular que aborde múltiplas sub-intenções em seções distintas. Use formatação pronta para citação com fatos, números específicos e estrutura clara. Monitore como sistemas de IA referenciam seu conteúdo usando ferramentas como o AmICited para identificar lacunas de alinhamento de intenção e otimizar conforme necessário.

Intenção é focada em tarefas — o que o usuário quer realizar agora. Interesse é uma curiosidade geral mais ampla. Sistemas de IA priorizam intenção porque ela determina diretamente qual conteúdo é selecionado para respostas. Um usuário pode se interessar por ferramentas de produtividade em geral, mas sua intenção pode ser encontrar algo específico para colaboração de equipes remotas.

Sistemas de IA citam fontes que melhor correspondem à intenção detectada. Se seu conteúdo aborda claramente uma sub-intenção específica com informações bem estruturadas e factuais, ele tem mais chances de ser selecionado. Ferramentas como o AmICited acompanham esses padrões de citação, mostrando quais alinhamentos de intenção impulsionam a visibilidade em respostas geradas por IA.

Entenda como LLMs referenciam seu conteúdo no ChatGPT, Perplexity e Google IA. Acompanhe o alinhamento de intenção e otimize para visibilidade em IA com o AmICited.

Intenção de busca é o propósito por trás da consulta de pesquisa de um usuário. Saiba quais são os quatro tipos de intenção de busca, como identificá-los e otim...

Aprenda como identificar e otimizar para a intenção de busca em mecanismos de busca por IA. Descubra métodos para classificar consultas de usuários, analisar SE...

Aprenda como alinhar seu conteúdo com a intenção da consulta de IA para aumentar citações no ChatGPT, Perplexity e Google AI. Domine estratégias de correspondên...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.