Acesso Diferencial de Crawlers

Saiba como permitir ou bloquear seletivamente crawlers de IA com base em objetivos de negócios. Implemente o acesso diferencial de crawlers para proteger seu co...

Saiba como Firewalls de Aplicação Web oferecem controle avançado sobre crawlers de IA além do robots.txt. Implemente regras WAF para proteger seu conteúdo contra scraping de IA não autorizado e monitore citações de IA com o AmICited.

A insuficiência do robots.txt como mecanismo de defesa isolado tem se tornado cada vez mais evidente na era do consumo de conteúdo por IA. Enquanto motores de busca tradicionais geralmente respeitam as diretivas do robots.txt, crawlers modernos de IA operam com incentivos e mecanismos de aplicação fundamentalmente diferentes, tornando políticas baseadas apenas em texto simples insuficientes para proteger conteúdo. Segundo análise da Cloudflare, crawlers de IA já representam quase 80% de todo o tráfego de bots para sites, com crawlers de treinamento consumindo grandes volumes de conteúdo e retornando tráfego de referência mínimo—os crawlers da OpenAI mantêm uma proporção de 400:1 de crawl para referência, enquanto a Anthropic chega a 38.000:1. Para editores e proprietários de conteúdo, essa relação assimétrica representa uma ameaça crítica ao negócio, já que modelos de IA treinados com seus conteúdos podem reduzir diretamente o tráfego orgânico e diminuir o valor de sua propriedade intelectual.

Um Firewall de Aplicação Web (WAF) opera como um proxy reverso posicionado entre usuários e servidores web, inspecionando cada requisição HTTP em tempo real para filtrar tráfego indesejado com base em regras configuráveis. Diferentemente do robots.txt, que depende da conformidade voluntária do crawler, os WAFs impõem proteção no nível da infraestrutura, tornando-os significativamente mais eficazes para controlar o acesso de crawlers de IA. A comparação a seguir ilustra como os WAFs diferem de abordagens tradicionais de segurança:

| Recurso | Robots.txt | Firewall Tradicional | WAF Moderno |

|---|---|---|---|

| Nível de Aplicação | Orientativo/Voluntário | Bloqueio por IP | Inspeção consciente da aplicação |

| Detecção de Crawler de IA | Apenas por user-agent | Reconhecimento limitado de bots | Análise comportamental + fingerprinting |

| Adaptação em Tempo Real | Arquivo estático | Requer atualizações manuais | Inteligência de ameaças contínua |

| Controle Granular | Apenas por caminho | Faixas amplas de IP | Políticas de nível de requisição |

| Machine Learning | Nenhum | Nenhum | Classificação avançada de bots |

Os WAFs oferecem classificação granular de bots usando fingerprinting de dispositivos, análise comportamental e machine learning para perfilar bots por intenção e sofisticação, permitindo controle muito mais refinado do que simples regras de permitir/negar.

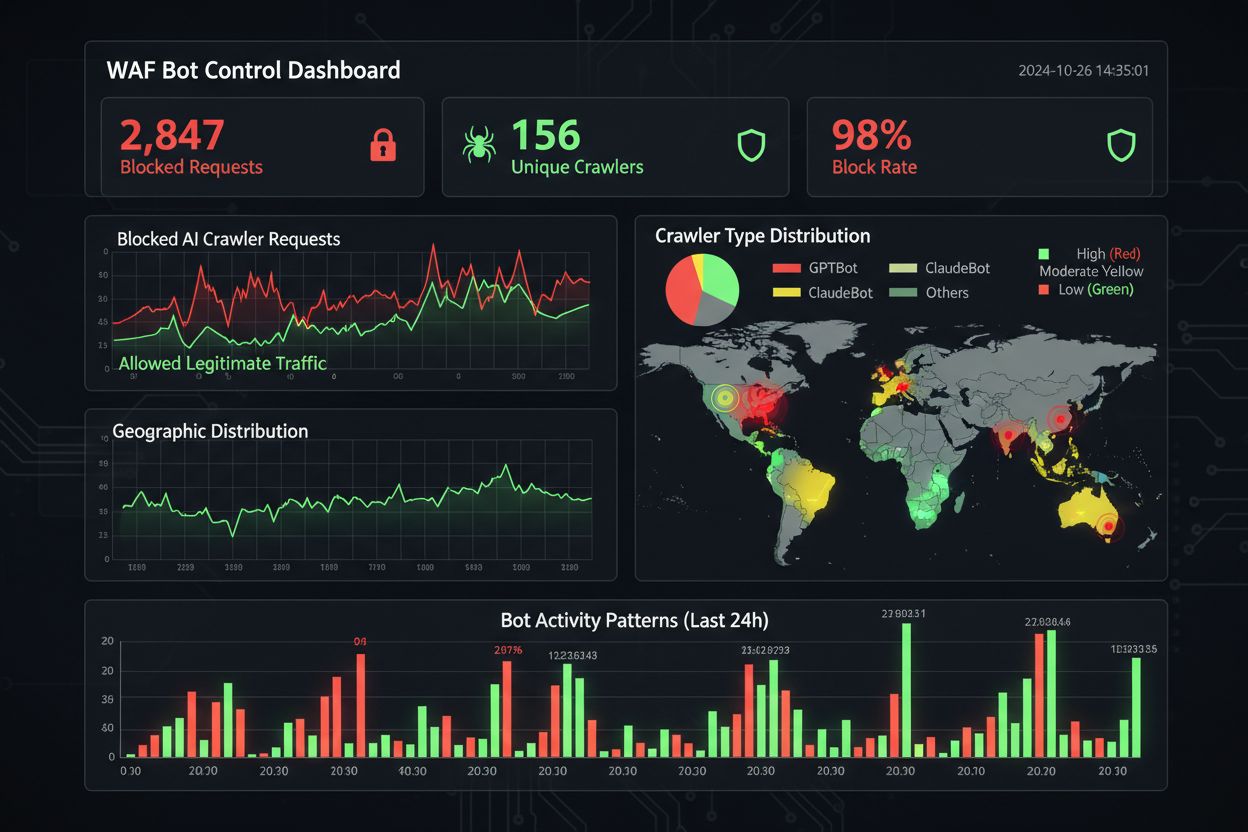

Os crawlers de IA se enquadram em três categorias distintas, cada uma apresentando ameaças diferentes e exigindo estratégias de mitigação específicas. Crawlers de treinamento como GPTBot, ClaudeBot e Google-Extended coletam sistematicamente conteúdo web para construir datasets para desenvolvimento de grandes modelos de linguagem, representando cerca de 80% de todo o tráfego de crawlers de IA e retornando valor zero de referência para editores. Crawlers de busca e citação como OAI-SearchBot e PerplexityBot indexam conteúdo para experiências de busca baseadas em IA e podem fornecer algum tráfego de referência através de citações, embora em volumes significativamente menores do que motores de busca tradicionais. Fetchers acionados por usuário ativam-se apenas quando usuários solicitam conteúdo através de assistentes de IA, operando com volume mínimo e requisições pontuais, ao invés de padrões sistemáticos de crawling. O cenário de ameaças inclui:

WAFs modernos empregam métodos sofisticados de detecção técnica que vão muito além da simples correspondência do user-agent para identificar e classificar crawlers de IA com alta precisão. Esses sistemas utilizam análise comportamental para examinar padrões de requisição, incluindo velocidade de crawling, sequência de requisições e características de manipulação de resposta que distinguem bots de usuários humanos. Técnicas de fingerprinting de dispositivos analisam cabeçalhos HTTP, assinaturas TLS e características do navegador para identificar user-agents falsificados tentando burlar defesas tradicionais. Modelos de machine learning treinados em milhões de requisições podem detectar assinaturas de crawlers emergentes e novas táticas de bots em tempo real, adaptando-se a novas ameaças sem exigir atualizações manuais de regras. Além disso, os WAFs podem verificar a legitimidade do crawler cruzando os endereços IP das requisições com faixas de IP publicadas mantidas por grandes empresas de IA—OpenAI publica IPs verificados em https://openai.com/gptbot.json, enquanto a Amazon fornece em https://developer.amazon.com/amazonbot/ip-addresses/—garantindo que apenas crawlers autenticados de fontes legítimas sejam permitidos.

Implementar regras WAF eficazes para crawlers de IA exige uma abordagem em camadas, combinando bloqueio por user-agent, verificação de IP e políticas comportamentais. O exemplo de código abaixo demonstra uma configuração básica de regras WAF que bloqueia crawlers de treinamento conhecidos enquanto permite funcionalidades legítimas de busca:

# Regra WAF: Bloquear Crawlers de Treinamento de IA

Nome da Regra: Block-AI-Training-Crawlers

Condição 1: User-Agent HTTP corresponde (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Ação: Bloquear (retornar 403 Forbidden)

# Regra WAF: Permitir Crawlers de Busca Verificados

Nome da Regra: Allow-Verified-Search-Crawlers

Condição 1: User-Agent HTTP corresponde (OAI-SearchBot|PerplexityBot)

Condição 2: IP de origem na faixa de IP verificada

Ação: Permitir

# Regra WAF: Rate Limit em Tráfego Suspeito de Bot

Nome da Regra: Rate-Limit-Suspicious-Bots

Condição 1: Taxa de requisição excede 100 requisições/minuto

Condição 2: User-Agent contém indicadores de bot

Condição 3: Sem correspondência de IP verificado

Ação: Desafiar (CAPTCHA) ou Bloquear

As organizações devem implementar a precedência das regras com cuidado, assegurando que regras mais específicas (como verificação de IP para crawlers legítimos) sejam executadas antes de regras de bloqueio mais amplas. Testes e monitoramentos regulares da eficácia das regras são essenciais, já que user-agents e faixas de IP de crawlers evoluem frequentemente. Muitos provedores WAF oferecem conjuntos de regras pré-construídas especificamente voltadas para gerenciamento de crawlers de IA, reduzindo a complexidade da implementação e mantendo proteção abrangente.

Verificação e allowlist de IPs representam o método mais confiável para distinguir crawlers legítimos de IA de requisições falsificadas, pois user-agents podem ser facilmente forjados enquanto endereços IP são significativamente mais difíceis de falsificar em escala. Grandes empresas de IA publicam faixas oficiais de IP em formato JSON, possibilitando verificação automatizada sem manutenção manual—OpenAI oferece listas separadas de IP para GPTBot, OAI-SearchBot e ChatGPT-User, enquanto a Amazon mantém uma lista abrangente para o Amazonbot. Regras WAF podem ser configuradas para permitir apenas requisições originadas dessas faixas de IP verificadas, evitando que agentes maliciosos burlem restrições apenas alterando o header user-agent. Para organizações que usam bloqueio em nível de servidor via .htaccess ou regras de firewall, combinar verificação de IP com user-agent oferece proteção em camadas, independente da configuração do WAF. Além disso, alguns crawlers respeitam meta tags HTML como <meta name="robots" content="noarchive">, sinalizando para crawlers compatíveis que o conteúdo não deve ser usado em treinamento de modelo, oferecendo um mecanismo adicional e granular de controle para editores.

Monitoramento e conformidade eficazes requerem visibilidade contínua da atividade dos crawlers e verificação de que as regras de bloqueio estão funcionando como esperado. Organizações devem analisar regularmente os logs de acesso do servidor para identificar quais crawlers estão acessando seus sites e se crawlers bloqueados continuam fazendo requisições—logs do Apache normalmente ficam em /var/log/apache2/access.log e do Nginx em /var/log/nginx/access.log; filtros com grep identificam rapidamente padrões suspeitos. Plataformas de análise diferenciam cada vez mais tráfego de bots de visitantes humanos, permitindo mensurar o impacto do bloqueio de crawlers em métricas legítimas como taxa de rejeição, conversões e SEO. Ferramentas como o Cloudflare Radar fornecem visibilidade global sobre padrões de tráfego de bots de IA e podem identificar crawlers emergentes que ainda não estão em sua lista de bloqueio. Do ponto de vista da conformidade, logs do WAF geram trilhas de auditoria demonstrando que a organização implementou medidas razoáveis para proteger dados de clientes e propriedade intelectual, cada vez mais importante para GDPR, CCPA e outras regulamentações de proteção de dados. Revisões trimestrais de sua lista de bloqueio de crawlers são essenciais, pois novos crawlers de IA surgem regularmente e crawlers existentes atualizam seus user-agents—o projeto ai.robots.txt no GitHub

, mantido pela comunidade, é um recurso valioso para acompanhar ameaças emergentes.

Equilibrar a proteção de conteúdo com objetivos de negócio exige análise cuidadosa de quais crawlers bloquear ou permitir, já que bloqueio excessivamente agressivo pode reduzir a visibilidade em canais de descoberta alimentados por IA. Bloquear crawlers de treinamento como GPTBot e ClaudeBot protege a propriedade intelectual sem impacto direto no tráfego, pois esses crawlers não enviam tráfego de referência. No entanto, bloquear crawlers de busca como OAI-SearchBot e PerplexityBot pode reduzir a visibilidade nos resultados de busca por IA, onde usuários buscam ativamente citações e fontes—um trade-off que depende da estratégia de conteúdo e público-alvo. Alguns editores estão explorando abordagens alternativas, como permitir crawlers de busca e bloquear crawlers de treinamento, ou implementar modelos de pagamento por crawl em que empresas de IA remuneram editores pelo acesso ao conteúdo. Ferramentas como o AmICited.com auxiliam editores a rastrearem se seu conteúdo está sendo citado em respostas geradas por IA, fornecendo dados para embasar decisões de bloqueio. A configuração ideal do WAF depende do modelo de negócio: veículos de notícias podem priorizar o bloqueio de crawlers de treinamento para proteger conteúdo e liberar crawlers de busca para visibilidade, enquanto empresas SaaS podem bloquear todos os crawlers de IA para evitar que concorrentes analisem preços e recursos. O monitoramento regular de padrões de tráfego e métricas de receita após a implementação das regras WAF garante que sua estratégia de proteção esteja alinhada aos resultados reais do negócio.

Ao comparar soluções WAF para gerenciamento de crawlers de IA, organizações devem avaliar várias capacidades que diferenciam plataformas corporativas de ofertas básicas. O AI Crawl Control do Cloudflare integra-se ao WAF para fornecer regras pré-construídas para crawlers de IA conhecidos, com possibilidade de bloquear, permitir ou implementar monetização por crawl para crawlers específicos—a ordem de precedência da plataforma garante que regras do WAF sejam executadas antes de outras camadas de segurança. O AWS WAF Bot Control oferece níveis de proteção básica e avançada, sendo o avançado baseado em interrogação de navegador, fingerprinting e heurísticas comportamentais para detectar bots sofisticados que não se identificam, além de análise opcional com machine learning das estatísticas de tráfego. O Azure WAF traz capacidades similares via conjuntos de regras gerenciadas, embora com menor especialização em IA do que Cloudflare ou AWS. Além dessas plataformas, soluções especializadas de gerenciamento de bots de fornecedores como DataDome oferecem modelos avançados de machine learning treinados especificamente sobre comportamento de crawlers de IA, embora com custo mais elevado. A escolha entre soluções depende da infraestrutura existente, orçamento e nível de sofisticação necessário—organizações já usando Cloudflare se beneficiam da integração fluida, enquanto clientes AWS podem aproveitar o Bot Control em sua infraestrutura WAF existente.

As boas práticas para gerenciamento de crawlers de IA enfatizam uma abordagem de defesa em camadas, combinando múltiplos mecanismos de controle ao invés de depender de uma única solução. Organizações devem realizar revisões trimestrais das listas de bloqueio para capturar novos crawlers e user-agents atualizados, manter análise dos logs do servidor para verificar se crawlers bloqueados não estão burlando regras e testar regularmente as configurações do WAF para garantir a execução correta das regras. O futuro da tecnologia WAF incorporará cada vez mais detecção de ameaças alimentada por IA, adaptando-se em tempo real a novas táticas de crawlers, com integração a ecossistemas de segurança mais amplos para proteção contextual. À medida que regulamentações se tornam mais rigorosas sobre scraping de dados e fontes de treinamento de IA, os WAFs serão ferramentas essenciais de conformidade e não mais recursos opcionais de segurança. Organizações devem começar a implementar regras WAF abrangentes para crawlers de IA agora, antes que ameaças como agentes de IA baseados em navegador e crawlers headless se tornem comuns—o custo da inação, medido em perda de tráfego, análises comprometidas e possível exposição legal, supera em muito o investimento necessário para uma infraestrutura de proteção robusta.

O robots.txt é um arquivo de orientação que depende da boa vontade dos crawlers em respeitar suas diretivas, enquanto as regras WAF são impostas no nível da infraestrutura e se aplicam a todas as requisições, independentemente do cumprimento do crawler. Os WAFs oferecem detecção e bloqueio em tempo real, já o robots.txt é estático e facilmente ignorado por crawlers não conformes.

Sim, muitos crawlers de IA ignoram as diretivas do robots.txt porque são projetados para maximizar a coleta de dados de treinamento. Enquanto crawlers bem-comportados de grandes empresas geralmente respeitam o robots.txt, agentes mal-intencionados e alguns crawlers emergentes não o fazem. Por isso as regras WAF fornecem uma proteção mais confiável.

Verifique os logs de acesso do seu servidor (geralmente em /var/log/apache2/access.log ou /var/log/nginx/access.log) por cadeias de user-agent contendo identificadores de bots. Ferramentas como o Cloudflare Radar oferecem visibilidade global sobre padrões de tráfego de crawlers de IA, e plataformas de análise estão diferenciando cada vez mais o tráfego de bots dos visitantes humanos.

Bloquear crawlers de treinamento como o GPTBot não tem impacto direto no SEO, pois eles não enviam tráfego de referência. No entanto, bloquear crawlers de busca como o OAI-SearchBot pode reduzir a visibilidade nos resultados de busca alimentados por IA. O Google AI Overviews segue as regras padrão do Googlebot, então bloquear o Google-Extended não afeta a indexação de busca regular.

O AI Crawl Control do Cloudflare, AWS WAF Bot Control e o Azure WAF oferecem soluções eficazes. O Cloudflare traz os recursos mais específicos para IA, com regras pré-construídas e opções de pagamento por crawl. A AWS oferece detecção avançada com machine learning, enquanto o Azure tem conjuntos de regras gerenciadas robustos. Escolha de acordo com sua infraestrutura atual e orçamento.

Revise e atualize suas regras WAF pelo menos trimestralmente, pois novos crawlers de IA surgem regularmente e crawlers existentes atualizam seus user-agents. Monitore o projeto ai.robots.txt mantido pela comunidade no GitHub para ameaças emergentes e verifique os logs do servidor mensalmente para identificar novos crawlers acessando seu site.

Sim, essa é uma estratégia comum. Você pode configurar regras WAF para bloquear crawlers de treinamento como GPTBot e ClaudeBot e permitir crawlers de busca como OAI-SearchBot e PerplexityBot. Isso protege seu conteúdo de ser usado em treinamento de modelos, mantendo a visibilidade nos resultados de busca por IA.

O preço do WAF varia conforme o provedor. O Cloudflare oferece WAF a partir de US$ 20/mês com recursos de AI Crawl Control. O AWS WAF cobra por web ACL e regra, geralmente US$ 5-10/mês para proteção básica. O Azure WAF está incluso no Application Gateway. Os custos de implementação são mínimos comparados ao valor de proteger seu conteúdo e manter análises precisas.

O AmICited rastreia a atividade de crawlers de IA e monitora como seu conteúdo é citado no ChatGPT, Perplexity, Google AI Overviews e outras plataformas de IA. Tenha visibilidade sobre sua presença em IA e entenda quais crawlers estão acessando seu conteúdo.

Saiba como permitir ou bloquear seletivamente crawlers de IA com base em objetivos de negócios. Implemente o acesso diferencial de crawlers para proteger seu co...

Aprenda como auditar o acesso de crawlers de IA ao seu site. Descubra quais bots podem ver seu conteúdo e corrija bloqueios que impedem a visibilidade em IA com...

Aprenda como tomar decisões estratégicas sobre o bloqueio de crawlers de IA. Avalie tipo de conteúdo, fontes de tráfego, modelos de receita e posição competitiv...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.