Pontuação de Perplexidade

A Pontuação de Perplexidade mede a previsibilidade do texto em modelos de linguagem. Saiba como essa métrica fundamental de PLN quantifica a incerteza do modelo...

Saiba o que significa a pontuação de perplexidade em conteúdo e modelos de linguagem. Entenda como ela mede a incerteza do modelo, precisão preditiva e avaliação da qualidade do texto.

A pontuação de perplexidade é uma métrica que mede o quão bem um modelo de linguagem prevê a próxima palavra em uma sequência. Ela quantifica a incerteza do modelo nas previsões, com pontuações mais baixas indicando maior confiança e melhor desempenho preditivo.

A pontuação de perplexidade é uma métrica fundamental usada em processamento de linguagem natural e aprendizado de máquina para avaliar o desempenho de um modelo de linguagem ao prever textos. Em essência, ela mede o grau de incerteza que um modelo possui ao atribuir probabilidades às palavras em uma sequência. A métrica é particularmente importante para entender o desempenho do modelo em tarefas como geração de texto, tradução automática e IA conversacional. Quando um modelo de linguagem processa texto, ele atribui valores de probabilidade aos possíveis próximos termos com base no contexto fornecido pelas palavras anteriores. A perplexidade captura o quão confiante o modelo está nessas previsões, tornando-se uma ferramenta de avaliação essencial para desenvolvedores e pesquisadores que trabalham com grandes modelos de linguagem.

O conceito de perplexidade tem origem na teoria da informação, onde representa uma medida de incerteza em distribuições de probabilidade. No contexto de modelos de linguagem, pontuações mais baixas de perplexidade indicam que o modelo está mais certo sobre suas previsões e, portanto, produz textos mais coerentes e fluentes. Por outro lado, pontuações altas de perplexidade sugerem que o modelo está incerto sobre qual palavra deve vir a seguir, o que pode levar a resultados menos coerentes ou menos relevantes. Compreender essa métrica é crucial para quem trabalha com geração de conteúdo por IA, pois ela impacta diretamente a qualidade e confiabilidade dos textos gerados.

O cálculo da pontuação de perplexidade envolve várias etapas matemáticas que transformam previsões de probabilidade brutas em uma métrica única e interpretável. A fórmula fundamental baseia-se na entropia das previsões do modelo, que mede o nível de incerteza na saída. A representação matemática é: Perplexidade = 2^H(p), onde H(p) representa a entropia das previsões do modelo. Essa fórmula mostra que a perplexidade é derivada diretamente da entropia, com valores mais baixos de entropia resultando em pontuações de perplexidade menores.

O processo prático de cálculo segue uma abordagem estruturada que envolve múltiplos passos. Primeiro, o modelo de linguagem prevê a probabilidade do próximo token com base no texto de entrada e contexto fornecido. Em seguida, é aplicada a transformação logarítmica nessas probabilidades, o que ajuda a convertê-las em uma medida mais útil para análise. Depois, é computada a média do logaritmo da verossimilhança de todas as palavras previstas no conjunto de teste ao longo da sequência completa. Por fim, é feita a exponenciação da média do logaritmo para obter a pontuação final de perplexidade. A fórmula completa para calcular a perplexidade de uma sequência de palavras é: Perplexidade = exp(-1/N × Σ log p(w_i | w_{i-1}, w_{i-2}, …, w_1)), onde p(w_i | w_{i-1}, …, w_1) é a probabilidade prevista da i-ésima palavra dado todas as palavras anteriores, e N é o número total de palavras na sequência.

| Etapa do Cálculo | Descrição | Objetivo |

|---|---|---|

| Previsão de Token | O modelo prevê a probabilidade da próxima palavra | Estabelecer previsões iniciais |

| Transformação Log | Aplicar logaritmo às probabilidades | Converter em medida útil |

| Cálculo da Média | Calcular média do log-verossimilhança na sequência | Normalizar pelo tamanho do texto |

| Exponenciação | Elevar e à potência da média negativa | Obter a pontuação final |

A pontuação de perplexidade serve como uma métrica crítica de avaliação para analisar o desempenho de modelos de linguagem em múltiplas dimensões. A métrica é importante porque fornece insight direto sobre a precisão das previsões, ajudando desenvolvedores a entenderem o quão bem um modelo prevê palavras e gera textos coerentes. Uma pontuação baixa de perplexidade indica que o modelo faz previsões confiantes e provavelmente gera conteúdo fluente e apropriado ao contexto. Isso é especialmente valioso para aplicações como chatbots, assistentes virtuais e sistemas de geração de conteúdo, onde a qualidade do texto impacta diretamente a experiência do usuário. Além disso, a perplexidade ajuda a avaliar o nível de confiança do modelo em suas previsões — se a perplexidade é alta, o modelo está incerto sobre a próxima palavra, o que pode resultar em geração de texto incoerente ou irrelevante.

A métrica também é essencial para comparação e seleção de modelos. Ao avaliar diferentes modelos de linguagem ou comparar versões de um mesmo modelo durante o fine-tuning, a perplexidade oferece uma medida quantificável de melhoria ou degradação. Desenvolvedores podem usar as pontuações de perplexidade para determinar se um modelo é adequado para tarefas específicas como geração de texto, tradução automática, sumarização ou perguntas e respostas. Além disso, a perplexidade permite avaliação em tempo real durante o treinamento do modelo, possibilitando que desenvolvedores avaliem instantaneamente o desempenho do modelo e façam ajustes conforme necessário. Essa capacidade é especialmente valiosa durante o processo de fine-tuning, onde monitorar a perplexidade ajuda a garantir que o modelo está se tornando melhor em previsões confiantes, em vez de apenas se ajustar demais aos dados de treinamento.

Compreender como interpretar pontuações de perplexidade é essencial para tomar decisões informadas sobre o desempenho do modelo e sua adequação para aplicações específicas. Uma pontuação de perplexidade mais baixa indica que o modelo está mais confiante em suas previsões e geralmente gera textos de maior qualidade e mais coerentes. Por exemplo, uma pontuação de perplexidade de 15 sugere que o modelo está escolhendo entre aproximadamente 15 palavras possíveis a cada etapa de previsão, indicando confiança relativamente alta. Em contraste, uma pontuação de perplexidade mais alta de 50 ou mais sugere que o modelo está incerto e considerando muito mais possibilidades, o que frequentemente se correlaciona com resultados menos coerentes ou menos relevantes. A interpretação do que constitui uma boa pontuação de perplexidade depende da tarefa específica, conjunto de dados e arquitetura do modelo em avaliação.

Diferentes tipos de conteúdo e modelos apresentam diferentes faixas de perplexidade base. Por exemplo, modelos treinados com textos formais e bem estruturados, como artigos da Wikipedia, geralmente alcançam pontuações de perplexidade mais baixas do que modelos treinados com conteúdo conversacional ou criativo. Ao comparar pontuações de perplexidade entre modelos distintos, é fundamental garantir que eles sejam avaliados no mesmo conjunto de dados e utilizando o mesmo método de tokenização, já que esses fatores impactam significativamente os resultados. Um modelo com pontuação de perplexidade 20 em um conjunto de dados pode não ser diretamente comparável a outro modelo com pontuação 25 em um conjunto diferente. Além disso, o tamanho da sequência afeta os cálculos de perplexidade — sequências mais longas tendem a produzir pontuações de perplexidade mais estáveis, enquanto sequências curtas podem apresentar maior variância e gerar outliers que distorcem os resultados.

Embora a pontuação de perplexidade seja uma métrica valiosa, ela apresenta limitações importantes que devem ser compreendidas ao avaliar modelos de linguagem. Uma limitação significativa é que a perplexidade não mede compreensão — um modelo com baixa perplexidade ainda pode produzir textos incoerentes, irrelevantes ou factualmente incorretos. A métrica mede apenas a capacidade do modelo de prever a próxima palavra com base em padrões estatísticos dos dados de treinamento, e não se o modelo realmente compreende o significado ou contexto do conteúdo. Isso significa que um modelo pode alcançar excelentes pontuações de perplexidade enquanto gera textos gramaticalmente corretos, mas semanticamente sem sentido ou factualmente errados.

Outra consideração importante é que a perplexidade não captura dependências de longo prazo de forma eficaz. A métrica se baseia em previsões imediatas de palavras e pode não refletir o quão bem um modelo mantém coerência e consistência ao longo de sequências maiores de texto. Além disso, a sensibilidade à tokenização é um fator crítico — diferentes métodos de tokenização podem impactar significativamente as pontuações de perplexidade, tornando comparações diretas entre modelos com tokenizadores distintos problemáticas. Por exemplo, modelos a nível de caractere podem alcançar perplexidades mais baixas do que modelos a nível de palavra, mas isso não significa necessariamente que produzem textos melhores. Ademais, a perplexidade é projetada principalmente para modelos de linguagem autoregressivos ou causais e não é bem definida para modelos de linguagem mascarados como o BERT, que utilizam mecanismos de previsão diferentes.

Para obter uma avaliação abrangente do desempenho de modelos de linguagem, a perplexidade deve ser usada em combinação com outras métricas de avaliação, e não como medida isolada. BLEU, ROUGE e METEOR são métricas amplamente utilizadas que comparam o texto gerado com textos de referência e são especialmente valiosas para tarefas como tradução automática e sumarização. Avaliação humana por juízes qualificados fornece insights sobre aspectos que métricas automáticas não conseguem captar, como fluência, relevância, coerência e qualidade geral. Avaliação de acurácia factual usando sistemas de QA baseados em conhecimento ou frameworks de checagem de fatos garante que o conteúdo gerado seja não apenas fluente, mas também correto. Métricas de diversidade e criatividade como taxa de repetição, pontuação de novidade e entropia medem o quão variado e original é o texto gerado, o que é importante para aplicações criativas.

Além disso, avaliar modelos quanto a viés e justiça assegura seu uso seguro em aplicações reais, onde vieses prejudiciais podem causar problemas significativos. Ao combinar a perplexidade com essas métricas adicionais, desenvolvedores podem avaliar melhor a precisão preditiva, fluência e usabilidade no mundo real de um modelo. Essa abordagem abrangente permite identificar modelos que não apenas predizem corretamente, mas também o fazem com confiança, coerência e confiabilidade. A combinação de métricas oferece uma visão mais completa do desempenho do modelo e ajuda a garantir que os modelos selecionados atendam aos requisitos específicos de suas aplicações pretendidas.

A pontuação de perplexidade é amplamente utilizada em diversas aplicações reais onde o desempenho do modelo de linguagem impacta diretamente a experiência do usuário e a qualidade do conteúdo. Em aplicações de geração de texto, a perplexidade ajuda a garantir que o conteúdo gerado seja coerente e fluente ao confirmar que as previsões do modelo são confiantes e adequadas ao contexto. Para sistemas de tradução automática, a perplexidade avalia o quão bem o modelo de tradução prevê a próxima palavra no idioma alvo, o que é crucial para produzir traduções de alta qualidade que mantenham o significado e nuances do idioma de origem. Em chatbots e assistentes virtuais, baixa perplexidade garante que as respostas sejam fluentes e apropriadas ao contexto, melhorando diretamente a satisfação e o engajamento do usuário.

Modelos de sumarização se beneficiam da avaliação por perplexidade ao garantir que os resumos gerados sejam legíveis e coerentes, preservando as informações essenciais do texto de origem. Criadores de conteúdo e plataformas de IA utilizam perplexidade para avaliar a qualidade do conteúdo gerado por IA antes de publicá-lo ou apresentá-lo aos usuários. À medida que a geração de conteúdo por IA se torna cada vez mais presente em mecanismos de busca e plataformas de respostas, entender e monitorar as pontuações de perplexidade ajuda a garantir que o conteúdo gerado atenda aos padrões de qualidade. Organizações que trabalham com sistemas de IA podem usar métricas de perplexidade para identificar quando modelos precisam de re-treinamento, fine-tuning ou substituição, mantendo assim a qualidade consistente do conteúdo e a confiança do usuário nas respostas geradas por IA.

Acompanhe como seu conteúdo aparece em respostas de IA em ChatGPT, Perplexity e outros mecanismos de busca por IA. Garanta que sua marca receba a devida atribuição em respostas geradas por IA.

A Pontuação de Perplexidade mede a previsibilidade do texto em modelos de linguagem. Saiba como essa métrica fundamental de PLN quantifica a incerteza do modelo...

Discussão da comunidade sobre pontuação de perplexidade em conteúdo e modelos de linguagem. Redatores e especialistas em IA debatem se isso importa para criação...

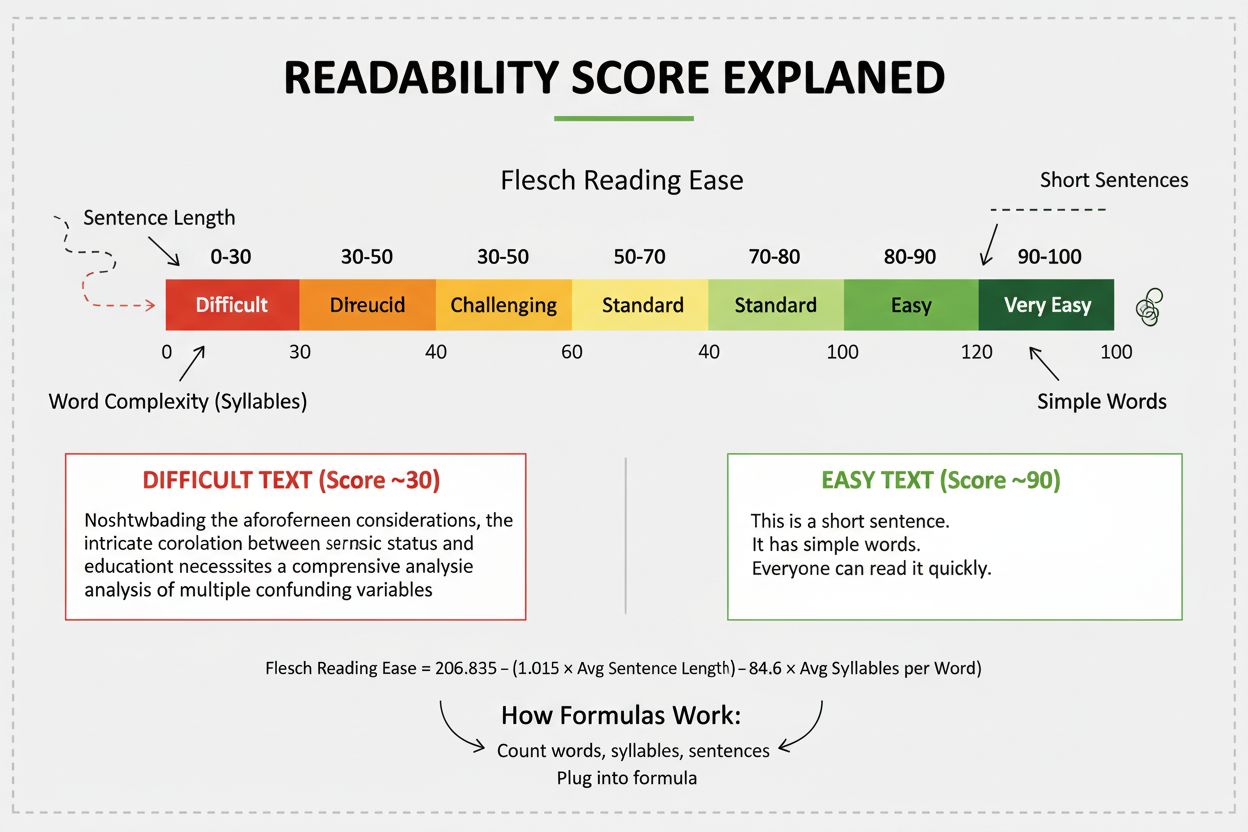

A pontuação de legibilidade mede a dificuldade de compreensão do conteúdo por meio de análise linguística. Saiba como as fórmulas de Flesch, Gunning Fog e outra...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.