Cartão de Referência de Crawlers de IA: Todos os Bots em um Relance

Guia completo de referência sobre crawlers e bots de IA. Identifique GPTBot, ClaudeBot, Google-Extended e mais de 20 outros crawlers de IA com user agents, taxa...

Uma abordagem estratégica que permite aos proprietários de sites permitir seletivamente certos crawlers de IA enquanto bloqueiam outros, com base em objetivos de negócios, acordos de licenciamento de conteúdo e avaliação de valor. Em vez de aplicar políticas generalizadas, o acesso diferencial avalia cada crawler individualmente para determinar se ele gera tráfego, respeita os termos de licenciamento ou está alinhado com as metas de monetização. Os editores usam ferramentas como robots.txt, cabeçalhos HTTP e controles específicos de plataforma para implementar políticas de acesso granulares. Esse método equilibra oportunidades de inovação com a proteção de conteúdo e remuneração justa.

Uma abordagem estratégica que permite aos proprietários de sites permitir seletivamente certos crawlers de IA enquanto bloqueiam outros, com base em objetivos de negócios, acordos de licenciamento de conteúdo e avaliação de valor. Em vez de aplicar políticas generalizadas, o acesso diferencial avalia cada crawler individualmente para determinar se ele gera tráfego, respeita os termos de licenciamento ou está alinhado com as metas de monetização. Os editores usam ferramentas como robots.txt, cabeçalhos HTTP e controles específicos de plataforma para implementar políticas de acesso granulares. Esse método equilibra oportunidades de inovação com a proteção de conteúdo e remuneração justa.

A explosão dos crawlers de IA perturbou fundamentalmente a relação de décadas entre proprietários de sites e bots. Durante anos, a internet funcionou com uma troca simples: motores de busca como o Google indexavam conteúdos e direcionavam tráfego de volta às fontes originais, criando uma relação simbiótica que recompensava a criação de conteúdo de qualidade. Hoje, uma nova geração de crawlers de IA—including GPTBot, ClaudeBot, PerplexityBot e dezenas de outros—opera sob regras diferentes. Esses bots extraem conteúdo não para indexá-lo para descoberta, mas para alimentar diretamente modelos de IA que geram respostas sem enviar usuários de volta à fonte original. O impacto é evidente: segundo dados da Cloudflare, o GPTBot da OpenAI mantém uma proporção de rastreamento para referência de aproximadamente 1.700:1, enquanto o ClaudeBot da Anthropic chega a 73.000:1, ou seja, para cada visitante enviado de volta ao site do editor, milhares de páginas são rastreadas como dados de treinamento. Essa troca quebrada forçou os editores a reconsiderar suas políticas de acesso a crawlers, migrando da escolha binária de “permitir todos” ou “bloquear todos” para uma estratégia mais refinada: acesso diferencial de crawlers. Em vez de aplicar políticas generalizadas, editores experientes agora avaliam cada crawler individualmente, fazendo perguntas críticas sobre valor, licenciamento e alinhamento com objetivos de negócio.

Compreender os diferentes tipos de crawlers de IA é essencial para implementar uma estratégia eficaz de acesso diferencial, já que cada um serve a propósitos distintos e tem impactos variados para seu negócio. Os crawlers de IA se dividem em três categorias principais: crawlers de treinamento (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider) que coletam conteúdo para treinamento de modelos; crawlers de busca (OAI-SearchBot, PerplexityBot, Google-Extended) que indexam conteúdo para resultados de busca com IA; e agentes acionados por usuário (ChatGPT-User, Claude-Web, Perplexity-User) que buscam conteúdo apenas quando usuários solicitam explicitamente. A proposta de valor varia bastante entre essas categorias. Crawlers de treinamento normalmente geram tráfego mínimo de volta ao seu site—eles extraem valor sem benefício recíproco—tornando-os candidatos ideais para bloqueio. Crawlers de busca, por sua vez, podem gerar tráfego de referência significativo e conversões de assinantes, semelhantes aos motores de busca tradicionais. Agentes acionados por usuário ocupam um meio-termo, ativando-se somente quando há envolvimento ativo do usuário com sistemas de IA. O The Atlantic, um dos maiores editores digitais, implementou uma abordagem sofisticada de scorecard para avaliar crawlers, rastreando tanto o volume de tráfego quanto conversões de assinantes para cada bot. Sua análise revelou que enquanto alguns crawlers geram valor significativo, outros geram praticamente zero tráfego enquanto consomem largura de banda. Essa abordagem baseada em dados permite decisões informadas em vez de suposições.

| Tipo de Crawler | Exemplos | Propósito Principal | Valor de Tráfego Típico | Acesso Recomendado |

|---|---|---|---|---|

| Treinamento | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Datasets de treinamento de modelo | Muito baixo (proporção de 1.700:1 a 73.000:1) | Frequentemente bloqueado |

| Busca | OAI-SearchBot, PerplexityBot, Google-Extended | Indexação de busca com IA | Médio a alto | Frequentemente permitido |

| Acionado por Usuário | ChatGPT-User, Claude-Web, Perplexity-User | Requisições diretas do usuário | Variável | Caso a caso |

Implementar o acesso diferencial de crawlers exige uma combinação de ferramentas técnicas e decisões estratégicas, com múltiplos métodos disponíveis conforme as capacidades técnicas e as necessidades do negócio. A ferramenta mais fundamental é o robots.txt, um arquivo de texto simples na raiz do site que comunica preferências de acesso usando diretivas User-agent. Embora o robots.txt seja voluntário e apenas 40-60% dos bots de IA o respeitem, ele segue como primeira linha de defesa e não custa nada para implementar. Para editores que buscam reforço mais forte, o robots.txt gerenciado da Cloudflare cria e atualiza automaticamente as diretivas de crawler, inserindo-as no seu arquivo existente e eliminando a necessidade de manutenção manual. Além do robots.txt, diversos mecanismos de enforcement oferecem controle adicional:

A abordagem mais eficaz combina múltiplas camadas: robots.txt para crawlers compatíveis, regras de WAF para enforcement e ferramentas de monitoramento para acompanhar a eficácia e identificar novas ameaças.

Implementar o acesso diferencial de crawlers exige ir além da execução técnica para desenvolver uma estratégia de negócio coerente, alinhada ao modelo de receita e ao posicionamento competitivo. A abordagem do The Atlantic fornece uma estrutura prática: eles avaliam cada crawler com base em dois principais critérios—volume de tráfego e conversões de assinantes—perguntando se o crawler gera valor suficiente para justificar o acesso ao conteúdo. Para um editor com valor anual de assinante de $80, um crawler que gera 1.000 assinantes representa $80.000 em receita anual, mudando fundamentalmente a decisão de acesso. No entanto, métricas de tráfego e assinantes são apenas parte da equação. Os editores também devem considerar:

Os editores mais estratégicos implementam políticas de acesso em camadas: permitem crawlers de busca que geram tráfego, bloqueiam crawlers de treinamento que não geram e negociam acordos de licenciamento com empresas de IA de alto valor. Essa abordagem maximiza visibilidade e receita, protegendo a propriedade intelectual.

Apesar das vantagens do acesso diferencial de crawlers, a realidade é mais complexa que a teoria, com diversos desafios fundamentais limitando a eficácia e exigindo gestão contínua. A limitação mais crítica é que o robots.txt é voluntário—os crawlers o respeitam por escolha, não por obrigação. Pesquisas indicam que o robots.txt bloqueia apenas 40-60% dos bots de IA, outros 30-40% são barrados por bloqueio de user-agent, deixando 10-30% dos crawlers operando sem restrições. Algumas empresas de IA e agentes maliciosos ignoram deliberadamente as diretivas do robots.txt, considerando o acesso ao conteúdo mais valioso que a conformidade. Além disso, técnicas de evasão de crawlers continuam evoluindo: bots sofisticados falsificam user agents para parecer navegadores legítimos, usam IPs distribuídos para evitar detecção e empregam browsers headless que simulam comportamento humano. O dilema do Google-Extended exemplifica a complexidade: bloquear o Google-Extended impede que seu conteúdo seja usado para treinar o Gemini AI, mas o Google AI Overviews (que aparece nos resultados de busca) utiliza as regras padrão do Googlebot, o que significa que não é possível optar por sair do AI Overviews sem sacrificar visibilidade na busca. Monitoramento e enforcement também exigem recursos significativos—rastrear novos crawlers, atualizar políticas e validar a eficácia demanda atenção contínua. Por fim, o cenário jurídico permanece incerto: embora a lei de direitos autorais teoricamente proteja o conteúdo, acionar judicialmente empresas de IA é caro e com resultados imprevisíveis, deixando os editores com controle técnico, mas sem garantias legais.

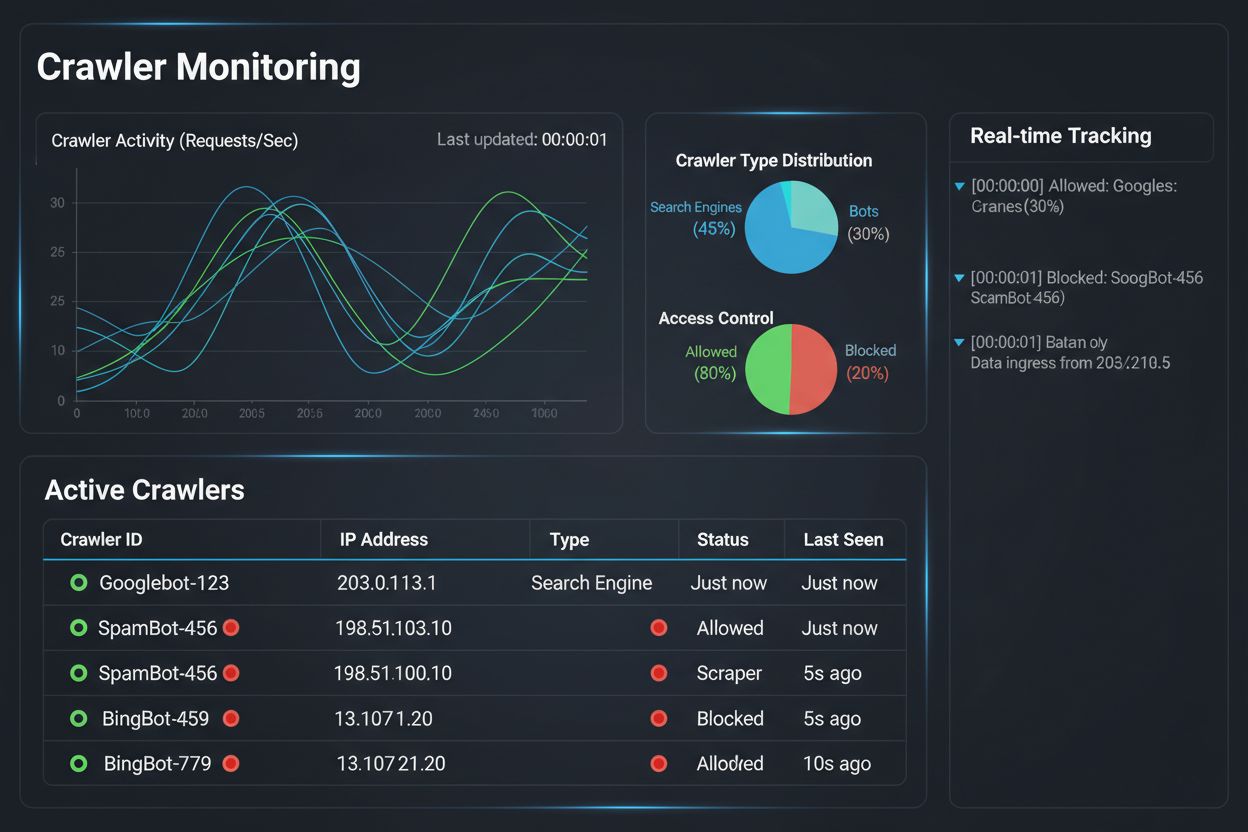

Implementar uma estratégia de acesso diferencial de crawlers é apenas metade do desafio; a outra metade é entender o impacto real das suas políticas por meio de monitoramento e mensuração abrangentes. É aqui que o AmICited.com se torna essencial para sua estratégia de gestão de crawlers. O AmICited é especializado em monitorar como sistemas de IA referenciam e citam sua marca em GPTs, Perplexity, Google AI Overviews e outras plataformas de IA—oferecendo visibilidade sobre quais crawlers realmente usam seu conteúdo e como ele aparece em respostas geradas por IA. Em vez de depender de logs de servidor e suposições, o painel do AmICited mostra exatamente quais sistemas de IA acessaram seu conteúdo, com que frequência e, o mais importante, se seu conteúdo está sendo citado ou apenas absorvido nos dados de treinamento sem atribuição. Essa inteligência informa diretamente suas decisões de acesso diferencial: se um crawler acessa seu conteúdo mas nunca o cita em respostas de IA, o bloqueio se torna uma decisão clara de negócio. O AmICited também permite benchmarking competitivo, mostrando como sua visibilidade em sistemas de IA se compara à de concorrentes, ajudando a entender se suas políticas de acesso estão muito restritivas ou permissivas. Alertas em tempo real da plataforma notificam quando novos sistemas de IA começam a referenciar seu conteúdo, possibilitando ajustes rápidos de política. Combinando o monitoramento do AmICited com as ferramentas de enforcement da Cloudflare, os editores obtêm visibilidade e controle completos: podem ver quais crawlers acessam seu conteúdo, medir o impacto de negócios e ajustar políticas conforme necessário. Essa abordagem orientada por dados transforma o gerenciamento de crawlers de uma tarefa técnica em uma função estratégica de negócios.

O cenário do acesso diferencial de crawlers está evoluindo rapidamente, com padrões e modelos de negócio emergentes redesenhando como editores e empresas de IA interagem em torno do conteúdo. A proposta de preferências de IA do IETF representa um avanço relevante, estabelecendo formas padronizadas para sites comunicarem suas preferências quanto ao uso de conteúdo para treinamento, inferência e busca em IA. Em vez de depender do robots.txt—um padrão de 30 anos criado para motores de busca—esse novo framework oferece controle explícito e granular sobre como sistemas de IA podem utilizar o conteúdo. Ao mesmo tempo, modelos de negócio baseados em permissão estão ganhando força, com a iniciativa Pay Per Crawl da Cloudflare pioneirando um modelo em que empresas de IA pagam aos editores pelo acesso ao conteúdo, transformando crawlers de ameaças em fontes de receita. Essa mudança de bloqueio para licenciamento representa uma transformação fundamental na economia da internet: em vez de brigar pelo acesso, editores e empresas de IA negociam compensação justa. Padrões de autenticação e verificação de crawlers também avançam, com métodos criptográficos permitindo aos editores confirmar a identidade do crawler e evitar solicitações falsificadas. Para o futuro, espera-se o aumento de marcos regulatórios sobre dados de treinamento de IA, possivelmente exigindo consentimento explícito e compensação pelo uso de conteúdo. A convergência dessas tendências—padrões técnicos, modelos de licenciamento, mecanismos de autenticação e pressão regulatória—sugere que o acesso diferencial de crawlers evoluirá de uma estratégia defensiva para uma função de negócio sofisticada, em que editores gerenciam, monitoram e monetizam ativamente o acesso de IA. Quem implementar monitoramento abrangente e políticas estratégicas hoje estará melhor posicionado para aproveitar essas oportunidades emergentes.

Bloquear todos os crawlers remove seu conteúdo totalmente dos sistemas de IA, eliminando riscos e oportunidades. O acesso diferencial permite que você avalie cada crawler individualmente, bloqueando aqueles que não fornecem valor e permitindo os que geram tráfego ou representam oportunidades de licenciamento. Essa abordagem nuance maximiza visibilidade e receita, protegendo a propriedade intelectual.

Você pode monitorar a atividade dos crawlers pelos logs do servidor, pelo painel de análise da Cloudflare ou por ferramentas especializadas como o AmICited.com. O AmICited rastreia especificamente quais sistemas de IA estão acessando seu conteúdo e como sua marca aparece em respostas geradas por IA, proporcionando insights de negócio além dos logs técnicos.

Não. Bloquear crawlers de treinamento de IA como GPTBot, ClaudeBot e CCBot não afeta seu ranqueamento no Google ou Bing. Motores de busca tradicionais usam crawlers diferentes (Googlebot, Bingbot), que operam de forma independente. Só bloqueie esses se quiser sumir dos resultados de busca completamente.

Sim, essa é a abordagem mais estratégica para muitos editores. Você pode permitir crawlers focados em busca como OAI-SearchBot e PerplexityBot (que geram tráfego) enquanto bloqueia crawlers de treinamento como GPTBot e ClaudeBot (que normalmente não geram). Assim, mantém a visibilidade nos resultados de busca de IA enquanto protege o conteúdo de ser absorvido em bases de treinamento.

Enquanto os principais crawlers da OpenAI, Anthropic e Google respeitam o robots.txt, alguns bots o ignoram deliberadamente. Se um crawler não respeita seu robots.txt, será necessário métodos adicionais de reforço como regras de WAF, bloqueio de IPs ou recursos de gestão de bots da Cloudflare. Por isso, ferramentas de monitoramento como o AmICited são essenciais—elas mostram quais crawlers realmente respeitam suas políticas.

Revise suas políticas pelo menos trimestralmente, pois as empresas de IA frequentemente lançam novos crawlers. A Anthropic, por exemplo, fundiu seus bots 'anthropic-ai' e 'Claude-Web' em 'ClaudeBot', dando ao novo bot acesso irrestrito temporário a sites que não atualizaram suas regras. O monitoramento regular com ferramentas como o AmICited ajuda você a se antecipar às mudanças.

O Googlebot é o crawler de busca do Google que indexa conteúdo para os resultados de pesquisa. O Google-Extended é um token de controle que governa se seu conteúdo será usado para o treinamento da IA Gemini. Você pode bloquear o Google-Extended sem afetar o ranqueamento de busca, mas observe que o Google AI Overviews (que aparece nos resultados) usa as regras padrão do Googlebot—portanto, não é possível optar por sair do AI Overviews sem sacrificar visibilidade na busca.

Sim, modelos emergentes de licenciamento como o Pay Per Crawl da Cloudflare permitem que editores cobrem das empresas de IA pelo acesso aos seus conteúdos. Isso transforma crawlers de ameaças em fontes de receita. No entanto, isso exige negociação com as empresas de IA e pode envolver acordos legais. O monitoramento do AmICited ajuda a identificar quais crawlers representam as oportunidades de licenciamento mais valiosas.

Acompanhe quais sistemas de IA estão acessando seu conteúdo e como sua marca aparece em respostas geradas por IA. Obtenha insights em tempo real sobre o comportamento dos crawlers e meça o impacto de negócios das suas políticas de acesso diferencial.

Guia completo de referência sobre crawlers e bots de IA. Identifique GPTBot, ClaudeBot, Google-Extended e mais de 20 outros crawlers de IA com user agents, taxa...

Saiba como Firewalls de Aplicação Web oferecem controle avançado sobre crawlers de IA além do robots.txt. Implemente regras WAF para proteger seu conteúdo contr...

Aprenda como tomar decisões estratégicas sobre o bloqueio de crawlers de IA. Avalie tipo de conteúdo, fontes de tráfego, modelos de receita e posição competitiv...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.