SEO Empresarial

SEO Empresarial é a prática de otimizar sites grandes e complexos com milhares de páginas para mecanismos de busca. Aprenda estratégias, desafios e melhores prá...

JavaScript SEO é o processo de otimizar sites renderizados em JavaScript para garantir que os mecanismos de busca possam rastrear, renderizar e indexar o conteúdo de forma eficaz. Envolve as melhores práticas para tornar aplicações web baseadas em JavaScript descobertas e ranqueadas nos resultados de busca, mantendo desempenho e experiência do usuário ideais.

JavaScript SEO é o processo de otimizar sites renderizados em JavaScript para garantir que os mecanismos de busca possam rastrear, renderizar e indexar o conteúdo de forma eficaz. Envolve as melhores práticas para tornar aplicações web baseadas em JavaScript descobertas e ranqueadas nos resultados de busca, mantendo desempenho e experiência do usuário ideais.

JavaScript SEO é a prática especializada de otimizar sites renderizados em JavaScript para garantir que os mecanismos de busca possam rastrear, renderizar e indexar o conteúdo de forma eficaz. Envolve um conjunto abrangente de estratégias técnicas, melhores práticas e métodos de implementação projetados para tornar aplicações web baseadas em JavaScript totalmente descobertas e ranqueadas nos resultados de busca. Ao contrário dos sites tradicionais baseados em HTML, onde o conteúdo está imediatamente disponível na resposta do servidor, o conteúdo renderizado em JavaScript requer etapas adicionais de processamento que podem impactar significativamente como os mecanismos de busca entendem e classificam suas páginas. A disciplina combina expertise em SEO técnico com o entendimento de como frameworks modernos como React, Vue e Angular interagem com os crawlers dos mecanismos de busca. O JavaScript SEO tornou-se cada vez mais crítico à medida que 98,7% dos sites agora incorporam algum nível de JavaScript, tornando esse conhecimento essencial para qualquer profissional de SEO que trabalhe com tecnologias web contemporâneas.

O surgimento dos frameworks JavaScript transformou fundamentalmente a forma como os sites são construídos e como os mecanismos de busca precisam processá-los. No início da web, o Googlebot simplesmente analisava as respostas HTML dos servidores, tornando o SEO direto — o conteúdo no HTML era indexado. Porém, à medida que os desenvolvedores adotaram a renderização no lado do cliente para criar experiências de usuário mais interativas e dinâmicas, os mecanismos de busca enfrentaram um desafio crítico: o conteúdo não estava mais presente no HTML inicial, mas sim gerado pela execução do JavaScript no navegador. Essa mudança criou um grande gap entre o que os usuários viam e o que os mecanismos de busca podiam acessar inicialmente. O Google respondeu desenvolvendo capacidades de renderização via headless Chromium, permitindo que o Googlebot executasse JavaScript e processasse o DOM renderizado. Entretanto, esse processo de renderização consome muitos recursos — aproximadamente 100 vezes mais caro do que simplesmente analisar HTML — o que significa que o Google não pode renderizar todas as páginas imediatamente. Essa restrição de recursos criou o conceito de orçamento de renderização, onde as páginas são colocadas em fila para renderização com base em sua importância esperada e potencial de tráfego de busca. Compreender essa evolução é crucial porque explica por que o JavaScript SEO não é opcional, mas sim um componente fundamental da estratégia moderna de SEO técnico.

A abordagem do Google para conteúdo renderizado em JavaScript segue um processo sofisticado de três fases que difere fundamentalmente do rastreamento tradicional de HTML. Na fase de rastreamento, o Googlebot solicita uma URL e recebe a resposta HTML inicial. Ele imediatamente analisa essa resposta para extrair links e verificar diretivas de indexação como meta robots e declarações noindex. Criticamente, se uma página contém uma tag noindex no HTML inicial, o Google não prossegue para renderizá-la — essa é uma distinção fundamental que muitos SEOs ignoram. Simultaneamente, a URL é colocada em fila para a fase de renderização, onde o Web Rendering Service (WRS) usa o headless Chromium para executar JavaScript, construir o DOM e gerar o HTML renderizado completo. Essa etapa pode levar segundos ou mais, dependendo da complexidade do JavaScript, e páginas podem esperar longos períodos na fila de renderização se os recursos do Google estiverem limitados. Por fim, na fase de indexação, o Google processa o HTML renderizado para extrair conteúdo, links e metadados para inclusão no índice de busca. O ponto crítico aqui é que o Google indexa com base no HTML renderizado, não no HTML de resposta inicial — ou seja, o JavaScript pode mudar completamente o que é indexado. Esse processo de três fases explica por que sites em JavaScript frequentemente experimentam indexação mais lenta, por que atrasos na renderização importam e por que comparar HTML de resposta com HTML renderizado é essencial para diagnosticar problemas de JavaScript SEO.

| Método de Renderização | Como Funciona | Vantagens para SEO | Desvantagens para SEO | Melhor Para |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | Conteúdo totalmente renderizado no servidor antes de ser entregue ao cliente | Conteúdo disponível imediatamente no HTML inicial; indexação rápida; sem atrasos de renderização; suporta todos os crawlers | Maior carga no servidor; TTFB mais lento; implementação complexa | Sites críticos para SEO, e-commerce, sites com muito conteúdo, publishers de notícias |

| Client-Side Rendering (CSR) | Servidor envia HTML mínimo; JavaScript renderiza conteúdo no navegador | Menor carga no servidor; melhor escalabilidade; transições de página mais rápidas para usuários | Indexação atrasada; requer renderização; invisível para crawlers de LLM; carregamento inicial mais lento; consome orçamento de rastreamento | Aplicações web, dashboards, conteúdo atrás de login, sites sem foco em SEO |

| Renderização Dinâmica | Servidor detecta crawlers e entrega HTML pré-renderizado; usuários recebem CSR | Conteúdo disponível imediatamente para crawlers; equilibra experiência do bot e do usuário; mais fácil que SSR | Configuração complexa; depende de ferramentas; riscos de cloaking; requer detecção de bots; solução temporária | Grandes sites pesados em JavaScript, SPAs que precisam de visibilidade em busca, solução de transição |

| Static Site Generation (SSG) | Conteúdo pré-renderizado em tempo de build; servido como HTML estático | Melhor performance; SEO ótimo; sem atrasos de renderização; excelentes Core Web Vitals | Conteúdo dinâmico limitado; precisa rebuild para atualizações; não adequado para dados em tempo real | Blogs, documentação, sites institucionais, conteúdo que muda raramente |

Sites renderizados em JavaScript apresentam diversos obstáculos técnicos que impactam diretamente a performance em SEO e a visibilidade na busca. O desafio mais fundamental é o atraso na renderização — como a renderização consome muitos recursos, o Google pode demorar horas ou até dias para renderizar páginas, ou seja, seu conteúdo não será indexado imediatamente após a publicação. Isso é especialmente problemático para conteúdos sensíveis ao tempo, como notícias ou lançamentos de produtos. Outro problema crítico são os erros soft 404, que ocorrem quando aplicações de página única retornam um código de status HTTP 200 mesmo para páginas inexistentes, confundindo os mecanismos de busca sobre quais páginas devem ser indexadas. Alterações causadas pelo JavaScript em elementos críticos representam outro grande obstáculo: quando o JavaScript modifica títulos, tags canônicas, diretivas meta robots ou links internos após a resposta HTML inicial, os mecanismos de busca podem indexar versões incorretas ou perder sinais importantes de SEO. O problema do consumo do orçamento de rastreamento é especialmente severo para sites grandes — arquivos JavaScript são pesados e consomem muitos recursos, fazendo com que o Google gaste mais para renderizar menos páginas, limitando a profundidade do rastreamento. Além disso, crawlers de LLM e ferramentas de busca por IA não executam JavaScript, tornando conteúdo exclusivo em JavaScript invisível para plataformas emergentes de IA como Perplexity, Claude e outras. Estatísticas mostram que 31,9% dos SEOs não sabem como identificar se um site é significativamente dependente de JavaScript, e 30,9% não se sentem confortáveis investigando problemas de SEO causados por JavaScript, destacando a lacuna de conhecimento no setor.

Otimizar conteúdo renderizado em JavaScript exige uma abordagem multifacetada que aborde tanto a implementação técnica quanto as decisões estratégicas. A primeira e mais importante prática é incluir o conteúdo essencial na resposta HTML inicial — títulos, meta descriptions, tags canônicas e conteúdo crítico do corpo devem estar presentes na resposta do servidor antes da execução do JavaScript. Isso garante que os mecanismos de busca tenham uma impressão completa da sua página sem precisar esperar pela renderização para entender sobre o que ela trata. Evite bloquear arquivos JavaScript no robots.txt, pois isso impede o Google de renderizar corretamente suas páginas; em vez disso, permita acesso a todos os recursos JavaScript necessários para renderização. Implemente códigos de status HTTP adequados — use 404 para páginas inexistentes e 301 para conteúdo movido, em vez de depender do JavaScript para lidar com esses cenários. Para aplicações de página única, use a History API em vez de fragmentos de URL para garantir que cada visualização tenha uma URL única e rastreável; fragmentos como #/produtos são pouco confiáveis para mecanismos de busca. Minimize e adie JavaScript não crítico para reduzir o tempo de renderização e melhorar os Core Web Vitals — use code splitting para carregar somente o JavaScript necessário em cada página. Implemente lazy loading para imagens usando o atributo nativo loading="lazy" em vez de soluções baseadas em JavaScript, permitindo que os mecanismos de busca descubram as imagens sem renderização. Use hash de conteúdo em nomes de arquivos JavaScript (ex: main.2a846fa617c3361f.js) para que o Google saiba quando o código mudou e precisa ser buscado novamente. Teste sua implementação cuidadosamente usando a Ferramenta de Inspeção de URL do Google Search Console, o Screaming Frog com renderização ativada ou o relatório Response vs Render do Sitebulb para comparar o HTML inicial com o renderizado e identificar discrepâncias.

Escolher a abordagem de renderização correta é uma das decisões mais importantes para JavaScript SEO. Server-Side Rendering (SSR) é o padrão ouro para sites críticos em SEO porque o conteúdo é totalmente renderizado no servidor antes da entrega, eliminando atrasos de renderização e garantindo que todos os crawlers possam acessar o conteúdo. Frameworks como Next.js e Nuxt.js facilitam a implementação de SSR para equipes de desenvolvimento modernas. Entretanto, SSR exige mais recursos do servidor e pode resultar em um Time to First Byte (TTFB) mais lento, impactando a experiência do usuário. Client-Side Rendering (CSR) é apropriado para aplicações web onde SEO não é a principal preocupação, como dashboards, ferramentas atrás de login ou aplicações internas. O CSR reduz a carga no servidor e permite experiências altamente interativas, mas cria atrasos de indexação e torna o conteúdo invisível para crawlers de LLM. A renderização dinâmica serve como um meio-termo prático: detecta crawlers de mecanismos de busca e entrega para eles HTML pré-renderizado enquanto os usuários recebem a experiência interativa do CSR. Ferramentas como Prerender.io fazem isso automaticamente, mas o Google afirma explicitamente que é uma solução temporária e recomenda migrar para SSR a longo prazo. Static Site Generation (SSG) é ideal para conteúdo que não muda frequentemente — o conteúdo é pré-renderizado em tempo de build e servido como HTML estático, oferecendo o melhor desempenho e características de SEO. A decisão deve considerar as prioridades de SEO do seu site, recursos técnicos e frequência de atualização do conteúdo. Dados mostram que 60% dos SEOs já usam crawlers JavaScript em auditorias, indicando uma crescente conscientização de que a renderização deve ser considerada na análise técnica de SEO.

Uma gestão eficaz de JavaScript SEO exige o monitoramento contínuo de métricas e indicadores específicos que revelem como os mecanismos de busca interagem com seu conteúdo renderizado em JavaScript. A comparação entre HTML de resposta e HTML renderizado é fundamental — usando ferramentas como o relatório Response vs Render do Sitebulb, você pode identificar exatamente o que o JavaScript muda em suas páginas, incluindo modificações em títulos, meta descriptions, tags canônicas, links internos e diretivas robots. Estatísticas demonstram que 18,26% dos rastreamentos JavaScript têm H1 apenas no HTML renderizado (e não na resposta inicial) e, criticamente, 4,60% das auditorias JavaScript mostram tags noindex apenas no HTML de resposta — um cenário problemático em que o Google vê o noindex e nunca renderiza a página, impedindo a indexação de conteúdo que você deseja indexar. O consumo do orçamento de renderização deve ser monitorado pelo relatório de Cobertura do Google Search Console, que mostra quantas páginas estão na fila para renderização versus já renderizadas. Core Web Vitals são especialmente importantes para sites em JavaScript, pois a execução do JavaScript impacta diretamente o Largest Contentful Paint (LCP), First Input Delay (FID) e Cumulative Layout Shift (CLS). Monitore a latência de indexação — quanto tempo após a publicação seu conteúdo aparece no índice do Google —, já que sites em JavaScript normalmente experimentam atrasos maiores do que sites em HTML. Acompanhe a eficiência do rastreamento comparando o número de páginas rastreadas com o total de páginas do seu site; sites em JavaScript frequentemente têm eficiência de rastreamento menor devido às restrições de recursos. Use a Ferramenta de Inspeção de URL do Google Search Console para verificar se o conteúdo crítico aparece no HTML renderizado processado pelo Google, e não apenas na resposta inicial.

O surgimento de plataformas de busca com IA como Perplexity, ChatGPT, Claude e Google AI Overviews criou uma nova dimensão para o JavaScript SEO que vai além dos mecanismos de busca tradicionais. A maioria dos crawlers de LLM não executa JavaScript — eles consomem o HTML bruto e o conteúdo do DOM como aparece na resposta inicial do servidor. Isso significa que, se seu conteúdo crítico, informações de produto ou mensagens de marca aparecem apenas após a execução do JavaScript, estarão completamente invisíveis para as ferramentas de busca por IA. Isso cria um duplo problema de visibilidade: conteúdo invisível para crawlers de LLM não será citado em respostas de IA, e usuários buscando por IA não encontrarão seu conteúdo. Para usuários do AmICited que monitoram aparições de marca e domínio em respostas de IA, isso é especialmente crítico — se seu conteúdo renderizado em JavaScript não for acessível aos crawlers de LLM, você não aparecerá em citações de IA. A solução é garantir que conteúdo essencial esteja presente na resposta HTML inicial, tornando-o acessível tanto para mecanismos de busca tradicionais quanto para crawlers de IA. Por isso, Server-Side Rendering ou Renderização Dinâmica tornam-se ainda mais importantes na era da busca por IA — seu conteúdo precisa estar visível não só para o Googlebot, mas também para o crescente ecossistema de ferramentas de busca com IA que não executam JavaScript.

O cenário do JavaScript SEO continua evoluindo à medida que mecanismos de busca e tecnologias web avançam. O Google fez investimentos significativos em melhorar suas capacidades de renderização de JavaScript, migrando de um processo de duas fases (rastrear e indexar) para três fases (rastrear, renderizar e indexar) que lidam melhor com aplicações web modernas. No entanto, a renderização continua limitada por recursos, e não há indícios de que o Google renderizará todas as páginas imediatamente ou que os orçamentos de renderização deixarão de existir. O setor está migrando para abordagens híbridas de renderização, onde o conteúdo crítico é renderizado no servidor enquanto elementos interativos ficam no cliente, equilibrando necessidades de SEO com experiência do usuário. Web Components e Shadow DOM estão se tornando mais comuns, exigindo que SEOs entendam como essas tecnologias interagem com a renderização dos mecanismos de busca. O avanço da busca por IA pressiona ainda mais para garantir que o conteúdo seja acessível sem execução de JavaScript, impulsionando a adoção de SSR e SSG. Core Web Vitals continuam sendo fator de ranqueamento, e o impacto do JavaScript nessas métricas reforça que otimização de performance é inseparável do JavaScript SEO. Dados do setor mostram que apenas 10,6% dos SEOs entendem perfeitamente como o Google rastreia, renderiza e indexa JavaScript, indicando amplo espaço para capacitação e desenvolvimento de habilidades. À medida que frameworks JavaScript se tornam mais sofisticados e plataformas de busca com IA proliferam, a expertise em JavaScript SEO será cada vez mais valiosa e essencial para a visibilidade orgânica competitiva.

main.2a846fa617c3361f.js) para que o Google saiba quando o código mudou e precisa ser buscado novamenteloading="lazy") em vez de soluções baseadas em JavaScript para melhor compatibilidade com crawlersJavaScript SEO evoluiu de uma preocupação técnica de nicho para um componente fundamental da otimização moderna para mecanismos de busca. Com 98,7% dos sites utilizando JavaScript e 88% dos SEOs lidando regularmente com sites dependentes de JavaScript, a capacidade de otimizar conteúdo renderizado em JavaScript deixou de ser opcional — é essencial. A complexidade do pipeline de renderização em três fases, as restrições de recursos dos orçamentos de renderização e o surgimento de plataformas de busca com IA criaram um desafio multifacetado que exige conhecimento técnico e tomada de decisões estratégicas. As estatísticas são contundentes: 41,6% dos SEOs nunca leram a documentação de JavaScript do Google, 31,9% não sabem como identificar sites dependentes de JavaScript e 30,9% não se sentem confortáveis investigando problemas causados por JavaScript. Ainda assim, o impacto é significativo — 4,60% das auditorias de JavaScript mostram problemas críticos, como tags noindex exclusivamente no HTML de resposta, que impedem a indexação. O caminho adiante exige investimento em educação, adoção das estratégias de renderização adequadas e implementação de melhores práticas que garantam que o conteúdo seja acessível tanto para mecanismos de busca quanto para crawlers de IA. Seja por meio de Server-Side Rendering, Renderização Dinâmica ou otimização cuidadosa de Client-Side Rendering, o objetivo permanece constante: tornar seu conteúdo em JavaScript totalmente descoberto, indexado e visível em todas as plataformas de busca — do Google tradicional até as novas ferramentas de busca por IA. Para organizações que usam o AmICited para monitorar a visibilidade de marca em respostas de IA, o JavaScript SEO torna-se ainda mais crítico, já que conteúdo renderizado em JavaScript sem otimização ficará invisível para crawlers de LLM e não gerará citações nos resultados da busca por IA.

Sim, o Google renderiza e indexa conteúdo em JavaScript usando o headless Chromium. No entanto, a renderização consome muitos recursos e é adiada até que o Google tenha recursos disponíveis. O Google processa páginas em três fases: rastreamento, renderização e indexação. Páginas marcadas com tags noindex não são renderizadas, e atrasos na renderização podem retardar a indexação. O mais importante: o HTML renderizado — e não o HTML da resposta inicial — é o que o Google usa para decisões de indexação.

Segundo dados de 2024, 98,7% dos sites agora têm algum nível de dependência de JavaScript. Além disso, 62,3% dos desenvolvedores usam JavaScript como principal linguagem de programação, com 88% dos SEOs lidando com sites dependentes de JavaScript às vezes ou o tempo todo. Essa adoção generalizada torna o conhecimento de JavaScript SEO essencial para profissionais modernos de SEO.

Os principais desafios incluem atrasos na renderização que retardam a indexação, processamento que consome muitos recursos e gasta o orçamento de rastreamento, potenciais erros soft 404 em aplicações de página única e alterações em elementos críticos como títulos, canônicos e meta robots causadas pelo JavaScript. Além disso, a maioria dos crawlers de LLM e ferramentas de busca com IA não executam JavaScript, tornando o conteúdo invisível nessas plataformas se ele aparecer apenas após a renderização.

O HTML de resposta é o HTML inicial enviado pelo servidor (o que você vê em 'Ver código-fonte'). O HTML renderizado é o DOM final após a execução do JavaScript (o que você vê no inspetor do navegador). O JavaScript pode modificar significativamente o DOM ao injetar conteúdo, alterar meta tags, reescrever títulos e adicionar ou remover links. Os mecanismos de busca indexam com base no HTML renderizado, não no HTML de resposta.

Server-Side Rendering (SSR) é o ideal para SEO, pois o conteúdo é totalmente renderizado no servidor antes da entrega. Client-Side Rendering (CSR) exige que os mecanismos de busca renderizem as páginas, causando atrasos e problemas de indexação. A renderização dinâmica entrega HTML pré-renderizado aos crawlers enquanto os usuários recebem CSR, mas o Google recomenda isso apenas como solução temporária. Escolha com base nas prioridades de SEO do seu site e nos recursos técnicos disponíveis.

Use a Ferramenta de Inspeção de URL do Google Search Console: acesse Inspeção de URL, clique em 'Testar URL ativo' e veja a guia 'HTML' para conferir o HTML renderizado processado pelo Google. Como alternativa, utilize ferramentas como Screaming Frog com renderização ativada, o relatório Response vs Render do Sitebulb ou o Chrome DevTools para comparar o HTML inicial com o DOM renderizado e identificar problemas relacionados ao JavaScript.

O orçamento de renderização é a quantidade de recursos que o Google aloca para renderizar páginas do seu site. O Google prioriza a renderização para páginas com maior expectativa de tráfego de busca. Sites pesados em JavaScript e com baixa prioridade podem enfrentar atrasos significativos na renderização, retardando a indexação. Por isso, otimizar o JavaScript para reduzir o tempo de renderização e garantir que o conteúdo crítico esteja no HTML inicial é fundamental para a performance em SEO.

A maioria dos crawlers de LLM e ferramentas de busca com IA (como Perplexity, Claude e outros) não executa JavaScript — eles consomem o HTML bruto. Se seu conteúdo crítico aparece apenas após a execução do JavaScript, ele fica invisível tanto para o rastreamento inicial do Google quanto para plataformas de busca por IA. Isso torna o JavaScript SEO essencial não só para busca tradicional, mas também para visibilidade e oportunidades de citação em busca por IA.

Comece a rastrear como os chatbots de IA mencionam a sua marca no ChatGPT, Perplexity e outras plataformas. Obtenha insights acionáveis para melhorar a sua presença de IA.

SEO Empresarial é a prática de otimizar sites grandes e complexos com milhares de páginas para mecanismos de busca. Aprenda estratégias, desafios e melhores prá...

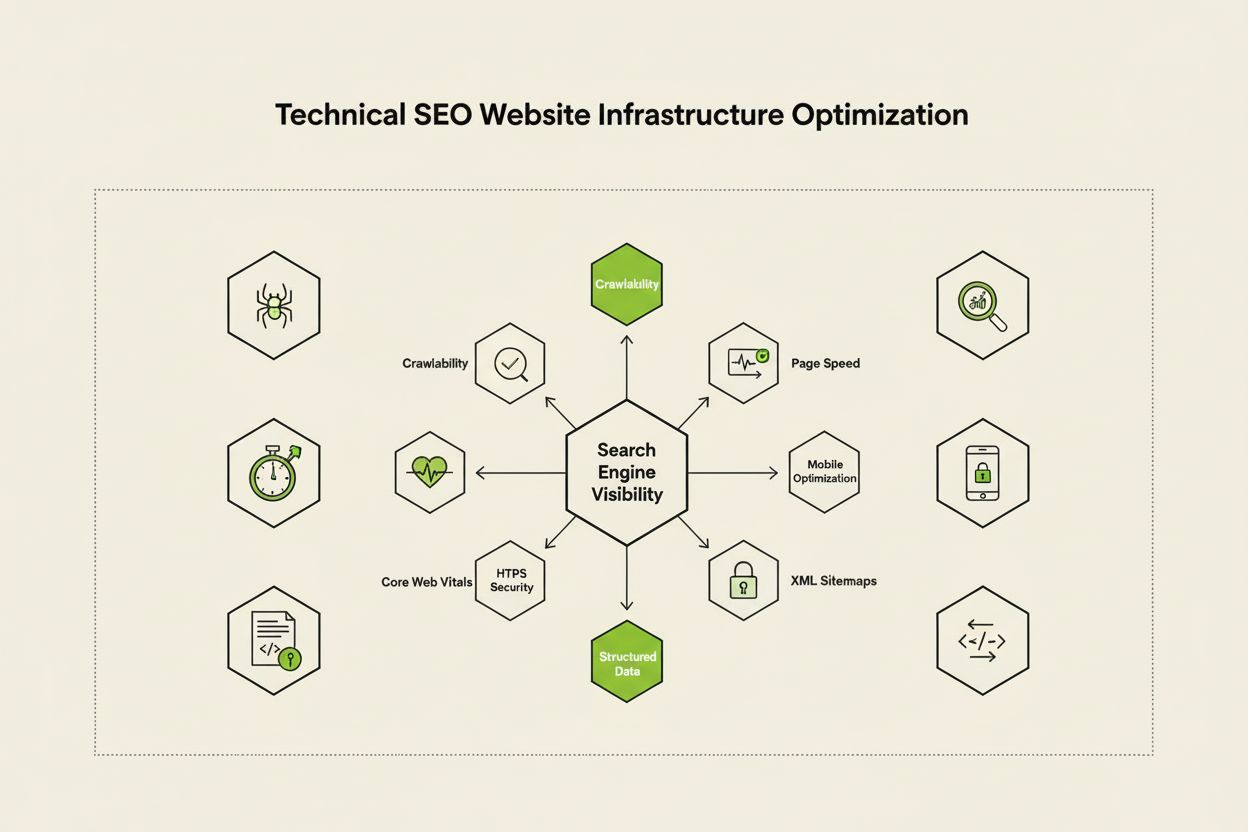

SEO Técnico otimiza a infraestrutura do site para rastreamento, indexação e ranqueamento nos mecanismos de busca. Aprenda sobre rastreabilidade, Core Web Vitals...

YouTube SEO é o processo de otimizar vídeos e canais para alcançar melhores posições nos resultados de busca do YouTube. Aprenda fatores de ranqueamento, estrat...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.