Criando Respostas Meta para LLM: Insights Autossuficientes que a IA Pode Citar

Aprenda como criar respostas meta para LLM que sistemas de IA citam. Descubra técnicas estruturais, estratégias de densidade de resposta e formatos de conteúdo ...

Conteúdo que aborda diretamente como modelos de linguagem podem interpretar e responder a consultas relacionadas, projetado para melhorar a visibilidade em respostas geradas por IA em plataformas como ChatGPT, Google AI Overviews e Perplexity. As Respostas Meta de LLM representam respostas sintetizadas que combinam informações de múltiplas fontes em respostas coesas e conversacionais que atendem à intenção do usuário.

Conteúdo que aborda diretamente como modelos de linguagem podem interpretar e responder a consultas relacionadas, projetado para melhorar a visibilidade em respostas geradas por IA em plataformas como ChatGPT, Google AI Overviews e Perplexity. As Respostas Meta de LLM representam respostas sintetizadas que combinam informações de múltiplas fontes em respostas coesas e conversacionais que atendem à intenção do usuário.

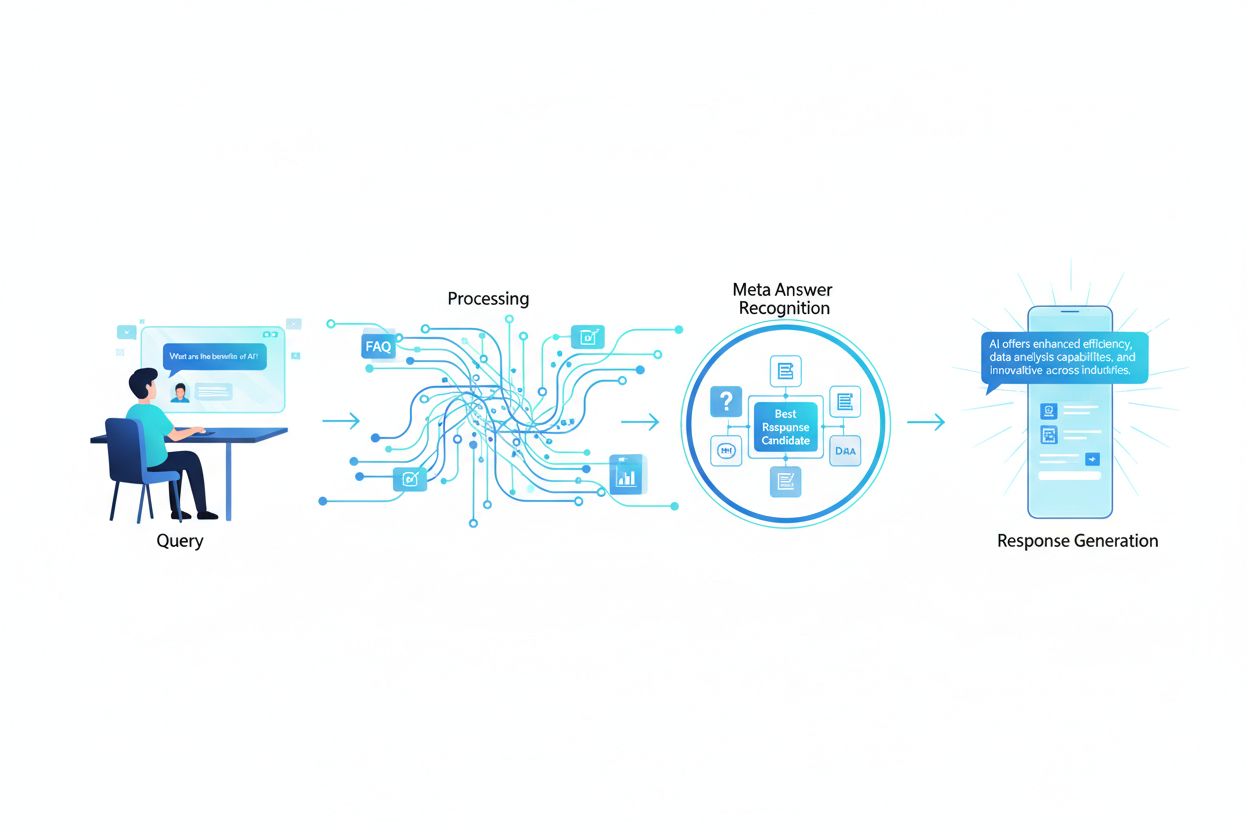

As Respostas Meta de LLM representam as respostas sintetizadas e geradas por IA que grandes modelos de linguagem produzem quando usuários fazem consultas em plataformas como ChatGPT, Claude ou Google AI Overviews. Essas respostas são fundamentalmente diferentes dos resultados tradicionais de busca, pois combinam informações de diversas fontes em uma resposta coesa e conversacional que atende diretamente à intenção do usuário. Em vez de apresentar uma lista de links, os LLMs analisam o conteúdo recuperado e geram um texto original que incorpora fatos, perspectivas e insights de seus dados de treinamento e sistemas de geração com recuperação aumentada (RAG). Entender como os LLMs constroem essas respostas meta é essencial para criadores de conteúdo que desejam que seu trabalho seja citado e referenciado em respostas geradas por IA. A visibilidade do seu conteúdo nessas respostas de IA tornou-se tão importante quanto o ranqueamento em resultados tradicionais de busca, fazendo da otimização para LLM (LLMO) um componente crítico da estratégia moderna de conteúdo.

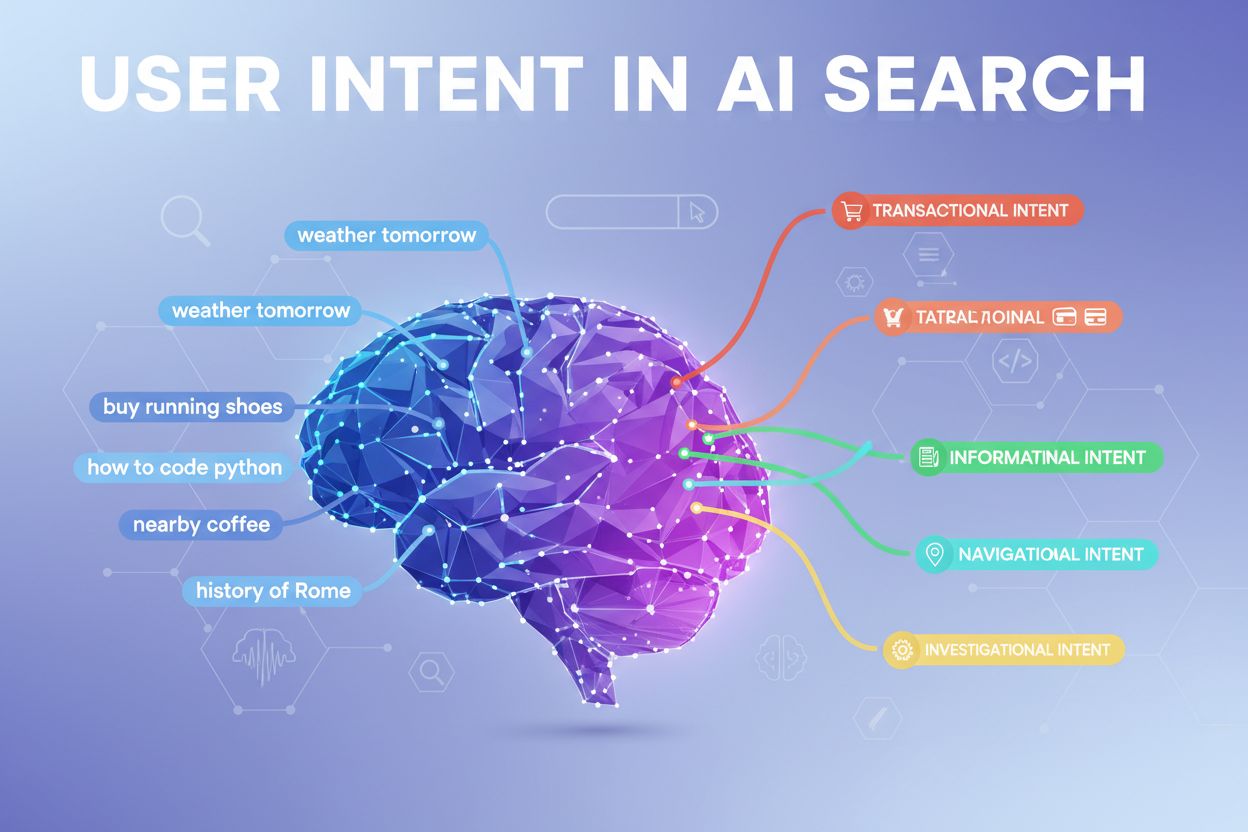

Quando um usuário envia uma consulta para um LLM, o sistema não faz apenas a correspondência de palavras-chave como os motores de busca tradicionais. Em vez disso, os LLMs realizam análise semântica para entender a intenção subjacente, o contexto e as nuances da pergunta. O modelo decompõe a consulta em componentes conceituais, identifica tópicos e entidades relacionadas e determina qual tipo de resposta seria mais útil—seja uma definição, comparação, guia passo a passo ou uma perspectiva analítica. Os LLMs então recuperam conteúdo relevante de sua base de conhecimento usando sistemas RAG que priorizam fontes com base em relevância, autoridade e abrangência. O processo de recuperação considera não apenas correspondências exatas de palavras-chave, mas também similaridade semântica, relações tópicas e o quão bem o conteúdo aborda os aspectos específicos da consulta. Isso significa que seu conteúdo precisa ser descoberto não só por palavras-chave exatas, mas pelos conceitos semânticos e tópicos relacionados que os usuários realmente estão buscando.

| Fator de Interpretação da Consulta | Busca Tradicional | Respostas Meta de LLM |

|---|---|---|

| Método de Correspondência | Correspondência por palavra-chave | Compreensão semântica |

| Formato do Resultado | Lista de links | Narrativa sintetizada |

| Seleção de Fonte | Ranqueamento por relevância | Relevância + abrangência + autoridade |

| Consideração de Contexto | Limitada | Contexto semântico extenso |

| Síntese da Resposta | Usuário deve ler várias fontes | IA combina múltiplas fontes |

| Exigência de Citação | Opcional | Frequentemente incluída |

Para que seu conteúdo seja selecionado e citado em respostas meta de LLM, ele deve possuir várias características críticas que se alinham à forma como esses sistemas avaliam e sintetizam informações. Primeiro, seu conteúdo deve demonstrar clara expertise e autoridade sobre o tema, com sinais fortes de E-E-A-T (Experiência, Especialização, Autoridade, Confiabilidade) que ajudam os LLMs a identificar fontes confiáveis. Segundo, o conteúdo deve proporcionar verdadeiro ganho de informação—insights únicos, dados ou perspectivas que agreguem valor além do que é comumente disponível. Terceiro, seu conteúdo deve ser estruturado de forma que os LLMs possam facilmente analisar e extrair informações relevantes, usando hierarquias claras e organização lógica. Quarto, a riqueza semântica é essencial; seu conteúdo deve explorar minuciosamente conceitos relacionados, usar terminologia variada e construir autoridade tópica abrangente em vez de focar apenas em palavras-chave isoladas. Quinto, a atualidade é muito importante para temas recentes, já que LLMs priorizam informações recentes e atualizadas ao sintetizar respostas. Por fim, seu conteúdo deve incluir evidências corroborativas por meio de citações, dados e referências externas que construam confiança com os sistemas LLM.

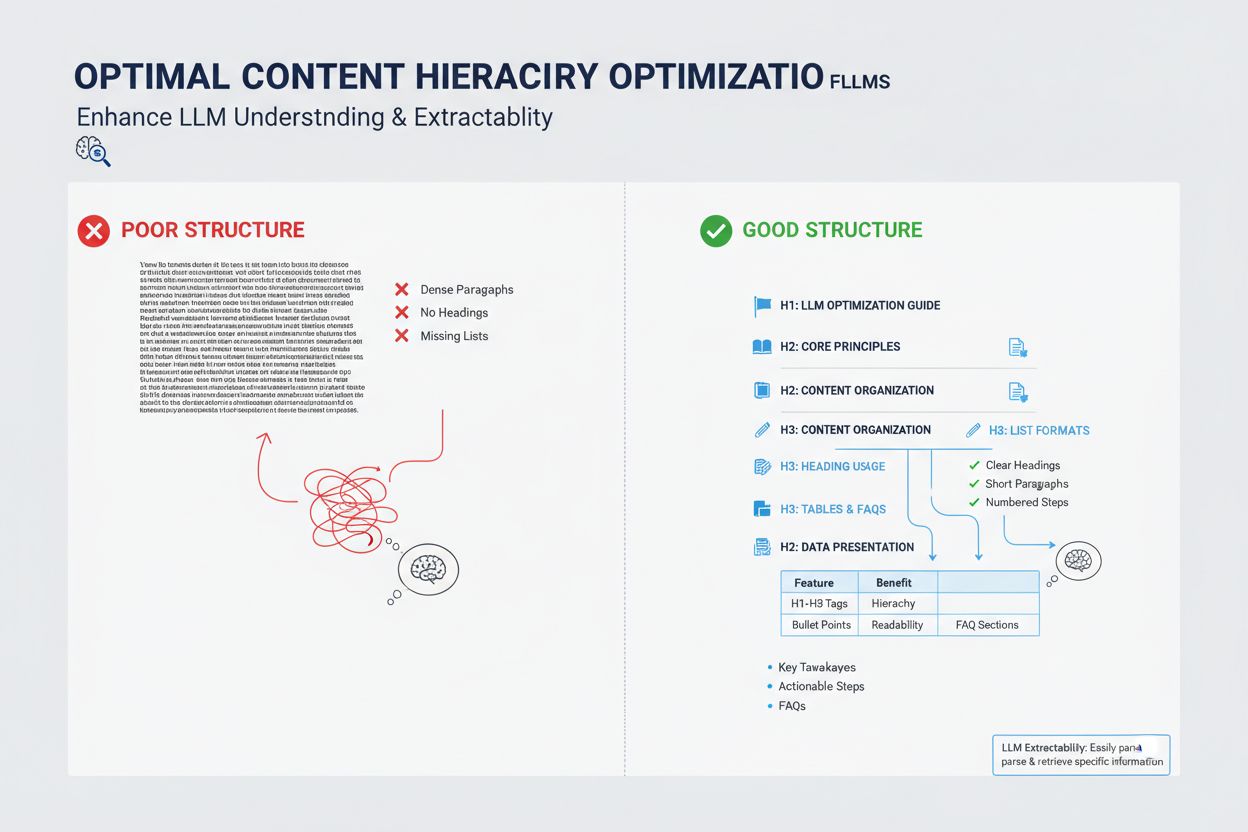

Principais características que melhoram a citação por LLM:

A forma como você estrutura seu conteúdo tem grande impacto sobre se os LLMs o selecionarão para respostas meta, já que esses sistemas são otimizados para extrair e sintetizar informações bem organizadas. LLMs valorizam fortemente conteúdos com hierarquias de títulos claras (H1, H2, H3) que criam uma arquitetura lógica da informação, permitindo ao modelo entender a relação entre conceitos e extrair seções relevantes com eficiência. Pontos em listas e listas numeradas são especialmente valiosos porque apresentam informações em unidades escaneáveis e discretas que os LLMs podem facilmente incorporar em suas respostas sintetizadas. Tabelas são especialmente poderosas para visibilidade em LLM porque apresentam dados estruturados em um formato fácil de ser analisado e referenciado por sistemas de IA. Parágrafos curtos (3-5 frases) têm melhor desempenho do que blocos densos de texto, pois possibilitam aos LLMs identificar e extrair informações específicas sem precisar filtrar conteúdo irrelevante. Além disso, o uso de marcação de schema (FAQ, Artigo, HowTo) fornece sinais explícitos aos LLMs sobre a estrutura e o propósito do seu conteúdo, aumentando significativamente a probabilidade de citação.

Embora Respostas Meta de LLM e featured snippets possam parecer semelhantes à primeira vista, representam mecanismos fundamentalmente diferentes para visibilidade de conteúdo e exigem estratégias de otimização distintas. Featured snippets são selecionados por algoritmos de busca tradicionais a partir de conteúdo web existente e exibidos em uma posição específica nos resultados de busca, geralmente mostrando de 40 a 60 palavras de texto extraído. Respostas Meta de LLM, por outro lado, são respostas geradas por IA que sintetizam informações de múltiplas fontes em uma narrativa nova e original, que pode ser muito mais longa e completa que qualquer fonte isolada. Featured snippets recompensam conteúdo que responde diretamente a uma pergunta de forma concisa, enquanto Respostas Meta de LLM valorizam conteúdo abrangente e autoritativo que oferece ampla cobertura do tema. Os mecanismos de citação diferem significativamente: featured snippets mostram um link da fonte mas o conteúdo é extraído literalmente, enquanto Respostas Meta de LLM podem parafrasear ou sintetizar seu conteúdo e normalmente incluem atribuição. Além disso, featured snippets são otimizados principalmente para busca tradicional, ao passo que Respostas Meta de LLM são otimizadas para plataformas de IA e podem nem aparecer nos resultados de busca.

| Aspecto | Featured Snippets | Respostas Meta de LLM |

|---|---|---|

| Método de Geração | Algoritmo extrai texto existente | IA sintetiza múltiplas fontes |

| Formato de Exibição | Posição na página de busca | Resposta em plataforma de IA |

| Tamanho do Conteúdo | Normalmente 40-60 palavras | 200-500+ palavras |

| Estilo de Citação | Link da fonte com texto extraído | Atribuição com conteúdo parafraseado |

| Foco da Otimização | Respostas diretas e concisas | Autoridade abrangente |

| Plataforma | Google Search | ChatGPT, Claude, Google AI Overviews |

| Métrica de Visibilidade | Impressões de busca | Citações em respostas de IA |

Riqueza semântica—a profundidade e amplitude da cobertura conceitual no seu conteúdo—é um dos fatores mais importantes e frequentemente negligenciados na otimização para LLM. LLMs não buscam apenas sua palavra-chave alvo; analisam as relações semânticas entre conceitos, o contexto em torno do tema principal e o quanto você explora ideias relacionadas. Conteúdos com alta riqueza semântica utilizam terminologia variada, exploram múltiplas perspectivas de um tema e constroem conexões entre conceitos relacionados, o que ajuda os LLMs a entenderem que seu conteúdo é genuinamente autoritativo e não otimizado superficialmente por palavras-chave. Ao escrever sobre um tema, inclua termos relacionados, sinônimos e conceitos adjacentes que ajudem os LLMs a posicionar seu conteúdo em um grafo de conhecimento mais amplo. Por exemplo, um artigo sobre “marketing de conteúdo” deve naturalmente abordar segmentação de público, personas de comprador, distribuição de conteúdo, análise e ROI—não porque você está enchendo de palavras-chave, mas porque esses conceitos são semanticamente relacionados e essenciais para compreender o tema de forma completa. Essa profundidade semântica sinaliza aos LLMs que você realmente domina o tema e pode fornecer as respostas nuançadas e multifacetadas que os usuários buscam.

LLMs avaliam autoridade de modo diferente dos motores de busca tradicionais, colocando mais ênfase em sinais que indicam expertise genuína e confiabilidade, em vez de apenas popularidade de links. Credenciais do autor e experiência demonstrada são especialmente importantes; LLMs favorecem conteúdo de especialistas reconhecidos, profissionais ou organizações com autoridade estabelecida em sua área. Citações externas e referências a outras fontes autoritativas aumentam a credibilidade com sistemas LLM, pois mostram que seu conteúdo está fundamentado em conhecimento mais amplo e corroborado por outros especialistas. Consistência em múltiplos conteúdos sobre um tema ajuda a consolidar autoridade tópica; LLMs reconhecem quando um autor ou organização publicou vários materiais abrangentes sobre assuntos relacionados. Validação de terceiros por meio de menções, citações ou referências de outras fontes relevantes aumenta significativamente sua visibilidade em respostas meta de LLM. Pesquisas originais, dados proprietários ou metodologias exclusivas são sinais de autoridade poderosos porque representam informações que não podem ser encontradas em outros lugares. Além disso, manter um histórico de publicação atualizado e revisar conteúdos com regularidade sinaliza que você está ativamente envolvido no tema e atualizado com desenvolvimentos recentes.

Sinais de autoridade que influenciam a seleção por LLM:

A atualidade do conteúdo tornou-se cada vez mais crítica para visibilidade em LLM, especialmente para temas onde as informações mudam rapidamente ou onde desenvolvimentos recentes impactam significativamente a resposta. LLMs são treinados com dados que possuem limites de conhecimento, mas cada vez mais dependem de sistemas RAG que recuperam informações atuais da web, o que significa que a data de publicação e a frequência de atualização do seu conteúdo influenciam diretamente se ele será selecionado para respostas meta. Para temas perenes, atualizações regulares—mesmo pequenas, que renovam a data de publicação—sinalizam aos LLMs que seu conteúdo é mantido ativamente e é confiável. Para temas sensíveis ao tempo como tendências do setor, atualizações de tecnologia ou eventos atuais, conteúdos desatualizados são ativamente preteridos pelos sistemas LLM em favor de fontes mais recentes. A melhor prática é estabelecer um cronograma de manutenção de conteúdo no qual você revisa e atualiza materiais-chave trimestral ou semestralmente, renovando estatísticas, adicionando novos exemplos e incorporando desenvolvimentos recentes. Essa manutenção contínua não só melhora sua visibilidade em LLM, mas também demonstra a sistemas de IA e leitores humanos que você é uma fonte atual e confiável de informações.

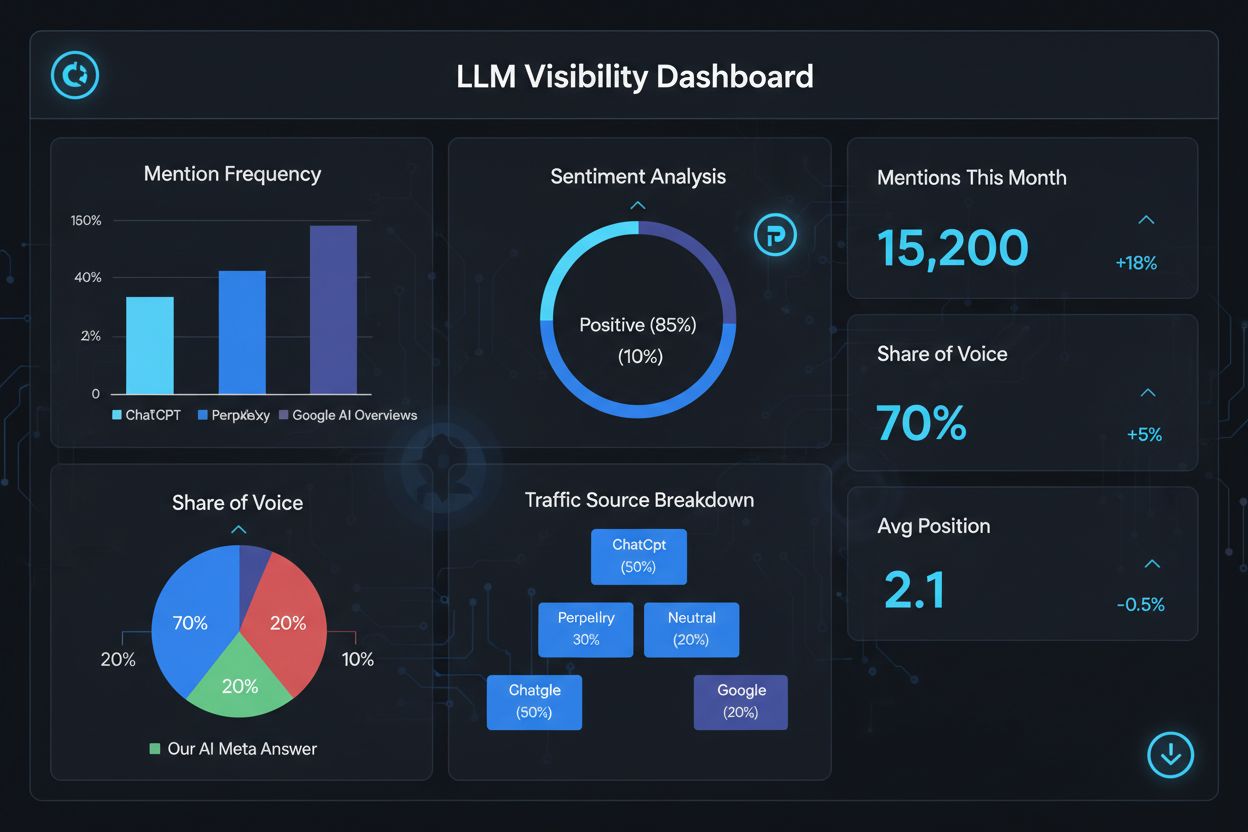

Mensurar seu sucesso em respostas meta de LLM requer métricas e ferramentas diferentes do SEO tradicional, já que essas respostas existem fora do ecossistema tradicional de resultados de busca. Ferramentas como o AmICited.com oferecem monitoramento especializado que rastreia quando e onde seu conteúdo aparece em respostas geradas por IA, dando visibilidade sobre quais materiais estão sendo citados e com que frequência. Você deve monitorar várias métricas-chave: frequência de citação (quantas vezes seu conteúdo aparece em respostas de LLM), contexto da citação (quais temas ativam a inclusão do seu conteúdo), diversidade de fontes (se você é citado em diferentes plataformas de LLM) e posicionamento da resposta (se seu conteúdo é destacado de forma proeminente na resposta sintetizada). Acompanhe quais páginas ou seções específicas do seu conteúdo são mais frequentemente citadas, pois isso revela que tipos de informações os LLMs consideram mais valiosas e confiáveis. Monitore mudanças nos padrões de citação ao longo do tempo para identificar quais esforços de otimização estão funcionando e quais temas precisam de desenvolvimento adicional. Além disso, analise as consultas que ativam suas citações para entender como os LLMs estão interpretando a intenção do usuário e quais variações semânticas são mais eficazes.

Principais métricas para desempenho de respostas meta de LLM:

Otimizar para respostas meta de LLM requer uma abordagem estratégica que combine implementação técnica, qualidade de conteúdo e mensuração contínua. Comece realizando pesquisas tópicas abrangentes para identificar lacunas onde sua expertise pode agregar valor único que os LLMs priorizarão em relação a fontes genéricas. Estruture seu conteúdo com hierarquias claras, utilizando títulos H2 e H3 para criar uma arquitetura lógica da informação que os LLMs possam facilmente analisar e extrair. Implemente marcação de schema (FAQ, Artigo, HowTo) para sinalizar explicitamente a estrutura e o propósito do seu conteúdo aos sistemas LLM, melhorando significativamente a descoberta. Desenvolva conteúdo abrangente e autoritativo que explore seu tema sob múltiplos ângulos, incorporando conceitos relacionados e construindo riqueza semântica que demonstre expertise genuína. Inclua pesquisas originais, dados ou insights que agreguem ganho de informação e diferenciem seu conteúdo dos concorrentes. Mantenha um cronograma regular de atualização de conteúdo, renovando materiais-chave a cada trimestre para garantir atualidade e sinalizar autoridade contínua. Construa autoridade tópica criando múltiplos conteúdos relacionados que, juntos, estabelecem sua expertise em uma área temática. Use linguagem clara e direta para responder perguntas específicas dos usuários, facilitando a extração e síntese do seu conteúdo pelos LLMs. Por fim, monitore seu desempenho de citação em LLMs usando ferramentas especializadas para identificar o que está funcionando e refinar continuamente sua estratégia com base em insights orientados por dados.

As Respostas Meta de LLM focam em como modelos de linguagem interpretam e citam o conteúdo, enquanto o SEO tradicional foca em ranqueamento nos resultados de busca. LLMs priorizam relevância e clareza em vez de autoridade de domínio, tornando conteúdo bem estruturado e orientado à resposta mais importante do que backlinks. Seu conteúdo pode ser citado em respostas de LLM mesmo que não esteja entre os primeiros resultados do Google.

Estruture o conteúdo com títulos claros, forneça respostas diretas logo no início, utilize marcação de schema (FAQ, Artigo), inclua citações e estatísticas, mantenha autoridade sobre o tema e garanta que seu site seja rastreável por bots de IA. Foque em riqueza semântica, ganho de informação e cobertura abrangente do tema em vez de segmentação restrita de palavras-chave.

LLMs extraem trechos de conteúdos bem organizados com mais facilidade. Títulos claros, listas, tabelas e parágrafos curtos ajudam os modelos a identificar e citar informações relevantes. Estudos mostram que páginas citadas por LLMs têm significativamente mais elementos estruturados do que páginas web comuns, tornando a estrutura um fator crítico de ranqueamento.

Sim. Diferente do SEO tradicional, LLMs priorizam relevância da consulta e qualidade do conteúdo em vez de autoridade de domínio. Uma página de nicho bem estruturada e altamente relevante pode ser citada por LLMs mesmo sem estar entre os principais resultados do Google, tornando expertise e clareza mais importantes do que a autoridade do site.

Atualize o conteúdo regularmente, especialmente para temas sensíveis ao tempo. Adicione marcações de data mostrando quando o conteúdo foi atualizado pela última vez. Para tópicos perenes, recomenda-se revisões trimestrais. Conteúdo atualizado sinaliza precisão para os LLMs, aumentando a chance de citação e demonstrando autoridade contínua.

O AmICited.com é especializado em monitorar menções de IA no ChatGPT, Perplexity e Google AI Overviews. Outras ferramentas incluem o AI SEO Toolkit da Semrush, Ahrefs Brand Radar e Peec AI. Essas ferramentas acompanham frequência de menção, share of voice, sentimento e ajudam a medir o sucesso da otimização.

A marcação de schema (FAQ, Artigo, HowTo) fornece uma estrutura legível por máquinas que ajuda LLMs a entenderem e extraírem o conteúdo com mais precisão. Ela sinaliza o tipo e a intenção do conteúdo, tornando sua página mais propensa a ser selecionada para consultas relevantes e melhorando a descoberta geral.

Menções externas em sites de alta autoridade (notícias, Wikipedia, publicações do setor) aumentam a credibilidade e as chances de os LLMs citarem seu conteúdo. Diversas fontes independentes mencionando sua marca ou dados criam um padrão de autoridade que os LLMs reconhecem e recompensam com maior frequência de citação.

Acompanhe como sua marca aparece em respostas geradas por IA no ChatGPT, Perplexity e Google AI Overviews com a plataforma de monitoramento especializada do AmICited.

Aprenda como criar respostas meta para LLM que sistemas de IA citam. Descubra técnicas estruturais, estratégias de densidade de resposta e formatos de conteúdo ...

Descubra como grandes modelos de linguagem interpretam a intenção do usuário além das palavras-chave. Explore expansão de consultas, compreensão semântica e com...

Aprenda a identificar e segmentar sites fonte de LLM para backlinks estratégicos. Descubra quais plataformas de IA mais citam fontes e otimize sua estratégia de...

Consentimento de Cookies

Usamos cookies para melhorar sua experiência de navegação e analisar nosso tráfego. See our privacy policy.