Vizibilitatea AI a site-urilor guvernamentale: Optimizare în sectorul public

Află cum pot agențiile guvernamentale să își optimizeze prezența digitală pentru sisteme AI precum ChatGPT și Perplexity. Descoperă strategii pentru îmbunătățir...

Află cum să implementezi politici eficiente de guvernanță a conținutului AI cu cadre de vizibilitate. Descoperă cerințe de reglementare, bune practici și instrumente pentru gestionarea responsabilă a sistemelor AI.

Vizibilitatea AI se referă la capacitatea cuprinzătoare de a observa, urmări și înțelege modul în care sistemele de inteligență artificială operează în cadrul ecosistemului tău de conținut. În guvernanța conținutului, vizibilitatea reprezintă stratul de bază care permite organizațiilor să mențină controlul, să asigure conformitatea și să reducă riscurile asociate conținutului generat sau procesat de AI. Fără o vizibilitate clară asupra sistemelor AI, organizațiile operează orbește—neputând detecta prejudecăți, asigura respectarea reglementărilor sau reacționa la amenințări emergente. Guvernanța axată pe vizibilitate transformă gestionarea reactivă a crizelor în prevenție proactivă a riscurilor, permițând echipelor să ia decizii informate privind calitatea conținutului, autenticitatea și alinierea la valorile organizaționale.

Majoritatea organizațiilor se confruntă cu un deficit critic de guvernanță între ritmul de adoptare a AI și capacitatea lor de a guverna eficient aceste sisteme. Cercetările arată că 63% dintre organizații nu au programe formale de guvernanță AI, ceea ce le face vulnerabile la încălcări de conformitate, daune de imagine și eșecuri operaționale. Acest deficit se adâncește pe măsură ce sistemele AI devin tot mai sofisticate și integrate în procesele de bază ale afacerii, iar vizibilitatea devine din ce în ce mai greu de obținut fără cadre și instrumente dedicate. Consecințele depășesc penalitățile de reglementare—organizațiile fără vizibilitate întâmpină dificultăți în menținerea calității conținutului, detectarea rezultatelor dăunătoare și demonstrarea responsabilității față de părțile interesate. Reducerea acestui deficit necesită investiții intenționate în mecanisme de vizibilitate care să ofere perspective în timp real asupra comportamentului sistemelor AI și rezultatelor de conținut.

| Aspect | Guvernanță reactivă | Guvernanță proactivă |

|---|---|---|

| Descoperire | Probleme identificate după expunerea publică | Monitorizare continuă care detectează problemele devreme |

| Răspuns | Gestionarea crizei și limitarea daunelor | Acțiuni preventive și reducerea riscurilor |

| Conformitate | Corecții post-audit și penalizări | Verificare continuă a conformității |

| Risc | Expunere mare la amenințări necunoscute | Identificare și management sistematic al riscurilor |

Politicile eficiente de guvernanță a conținutului AI se bazează pe șase principii fundamentale care ghidează deciziile și practicile operaționale la nivel organizațional. Aceste principii creează un cadru coerent care echilibrează inovația cu responsabilitatea, asigurând că sistemele AI servesc obiectivelor organizației și protejează părțile interesate. Prin integrarea acestor principii în politici, stabilești așteptări clare privind comportamentul sistemelor AI și modul în care echipele trebuie să le gestioneze. Principiile acționează sinergic—transparența permite responsabilitatea, supravegherea umană garantează echitatea, iar protecția vieții private construiește încrederea. Organizațiile care aplică constant aceste principii performează mai bine decât concurenții în ceea ce privește conformitatea, încrederea stakeholderilor și sustenabilitatea pe termen lung.

Peisajul de reglementare pentru guvernanța AI a evoluat rapid, cu multiple cadre care stabilesc cerințe obligatorii pentru organizațiile care implementează sisteme AI. EU AI Act reprezintă cea mai cuprinzătoare abordare, clasificând sistemele AI după nivelul de risc și impunând cerințe stricte pentru aplicațiile cu risc ridicat, inclusiv moderarea și generarea conținutului. NIST AI Risk Management Framework oferă o abordare flexibilă, ne-prescriptivă, care ajută organizațiile să identifice, să măsoare și să gestioneze riscurile AI la nivel operațional. ISO 42001 stabilește standarde internaționale pentru sisteme de management AI, oferind o metodologie structurată pentru implementarea guvernanței la nivel de companie. În plus, ordinele executive din SUA și reglementările la nivel de stat creează un ansamblu complex de cerințe cu care organizațiile trebuie să jongleze. Aceste cadre converg către teme comune: transparență, responsabilitate, supraveghere umană și monitorizare continuă—făcând din vizibilitate factorul cheie al conformității cu reglementările.

Construirea unui cadru robust de politici necesită evaluarea sistematică a sistemelor AI actuale, a fluxurilor de conținut și a expunerii la risc. Începe cu un inventar AI care să documenteze fiecare sistem care generează, procesează sau distribuie conținut, inclusiv scopul, datele de intrare și impactul potențial asupra părților interesate. Stabilește apoi niveluri de guvernanță care să atribuie diferite grade de supraveghere în funcție de risc—sistemele cu risc ridicat, precum moderarea conținutului, necesită monitorizare intensivă, iar aplicațiile cu risc scăzut pot necesita guvernanță mai ușoară. Dezvoltă politici clare care să specifice modul de operare al fiecărui sistem, ce rezultate sunt acceptabile și cum trebuie să răspundă echipele la probleme. Creează structuri de responsabilitate care să atribuie proprietari pentru respectarea politicilor și să stabilească proceduri de escaladare pentru problemele de guvernanță. În final, implementează mecanisme de măsurare care să urmărească respectarea politicilor și să furnizeze date pentru îmbunătățirea continuă a abordării de guvernanță.

Obținerea vizibilității AI necesită implementarea unor instrumente și mecanisme specializate care oferă perspective în timp real asupra comportamentului sistemelor și rezultatelor de conținut. Dashboard-urile de monitorizare agregă date din sistemele AI, platforme de conținut și sisteme de conformitate într-o vedere unificată ce permite detectarea rapidă a problemelor. Traseele de audit captează înregistrări detaliate ale deciziilor AI, modificărilor de conținut și acțiunilor de guvernanță, creând responsabilitate și susținând investigațiile de reglementare. Cadrele de evaluare analizează sistematic sistemele AI în raport cu principiile de guvernanță, identificând lacunele și oportunitățile de îmbunătățire înainte ca problemele să escaladeze. Sistemele automate de detecție semnalează conținutul problematic, rezultatele părtinitoare sau încălcările de politici, reducând dependența de revizuirea manuală și sporind consistența. Organizațiile care investesc în instrumente cuprinzătoare de vizibilitate obțin avantaje competitive privind conformitatea, încrederea stakeholderilor și eficiența operațională.

Monitorizarea continuă transformă guvernanța dintr-un exercițiu periodic de conformitate într-o disciplină operațională permanentă, care detectează și răspunde la probleme în timp real. Stabilește protocoale de monitorizare care să definească ce metrici sunt esențiale pentru fiecare sistem AI—rata de acuratețe, indicatori de părtinire, scoruri de calitate a conținutului și frecvența încălcărilor de politici. Implementează sisteme automate de alertare care notifică echipele relevante atunci când metricile depășesc limitele acceptabile, permițând investigarea și reacția rapidă. Creează buclă de feedback care să conecteze datele de monitorizare la îmbunătățirea sistemului, permițând echipelor să rafineze modelele AI și procesele de guvernanță în funcție de performanța observată. Programează revizuiri periodice de conformitate pentru a evalua dacă sistemele de monitorizare rămân eficiente și dacă politicile de guvernanță trebuie actualizate în funcție de riscurile noi sau modificările legislative. Organizațiile care integrează monitorizarea continuă în operațiuni rezolvă mai rapid problemele, reduc costurile de conformitate și câștigă încrederea stakeholderilor.

O guvernanță eficientă a conținutului AI necesită efort coordonat între mai multe funcții organizaționale, fiecare aducând expertiză și perspectivă esențială în deciziile de guvernanță. Echipele juridice și de conformitate asigură alinierea politicilor la cerințele legale și gestionează relațiile externe cu autoritățile de reglementare. Echipele tehnice implementează sisteme de monitorizare, mențin trasee de audit și optimizează performanța AI în limitele guvernanței. Echipele de conținut și editoriale pun în practică politicile de guvernanță, luând decizii zilnice privind calitatea și adecvarea conținutului. Echipele de risc și etică evaluează amenințările emergente, identifică potențiale prejudicii și recomandă ajustări ale politicilor pentru a răspunde noilor provocări. Conducerea executivă oferă resurse, stabilește priorități organizaționale și demonstrează angajamentul față de guvernanță prin decizii și comunicare. Organizațiile care aliniază aceste funcții în jurul unor obiective comune de guvernanță obțin rezultate superioare față de cele în care guvernanța rămâne izolată în cadrul unui singur departament.

Guvernanța conținutului AI reprezintă ansamblul de politici, procese și controale care asigură că informațiile generate sau procesate de AI rămân de încredere, conforme și aliniate valorilor organizaționale. Aceasta include totul, de la crearea și validarea conținutului, până la monitorizare și răspuns la incidente.

Vizibilitatea permite organizațiilor să înțeleagă unde operează sistemele AI, cum performează și ce riscuri generează. Fără vizibilitate, guvernanța devine reactivă și ineficientă. Vizibilitatea transformă guvernanța din gestionare de criză în prevenție proactivă a riscurilor.

Principalele cadre includ EU AI Act (clasificare legală bazată pe risc), NIST AI Risk Management Framework (ghidare flexibilă), ISO 42001 (standarde internaționale) și diverse ordine executive și reglementări de stat. Fiecare cadru pune accent pe transparență, responsabilitate și supraveghere umană.

Folosește cadre de evaluare structurate, aliniate la standarde recunoscute precum NIST AI RMF sau ISO 42001. Evaluează controalele existente comparativ cu cerințele cadrului, identifică lacunele și stabilește niveluri țintă de maturitate. Evaluările regulate oferă perspective asupra punctelor slabe sistemice și oportunităților de îmbunătățire.

Politicile eficiente ar trebui să acopere cazuri de utilizare acceptabile, reguli privind sursele de date, cerințe de documentare, proceduri de supraveghere umană, mecanisme de monitorizare și proceduri de escaladare. Politicile trebuie operaționalizate prin instrumente și fluxuri de lucru utilizate efectiv de echipe în activitatea zilnică.

Guvernanța trebuie monitorizată continuu, cu revizuiri formale periodice cel puțin trimestrial. Monitorizarea în timp real detectează imediat problemele, iar revizuirile periodice evaluează eficacitatea cadrului de guvernanță și necesitatea actualizării politicilor în funcție de noi riscuri sau schimbări legislative.

Instrumentele eficiente includ dashboard-uri de monitorizare pentru metrici în timp real, trasee de audit pentru responsabilitate, cadre de evaluare pentru control, sisteme automate de detecție a încălcărilor de politici și platforme de cuantificare a riscurilor. Aceste instrumente ar trebui să fie integrate în întregul stack tehnologic.

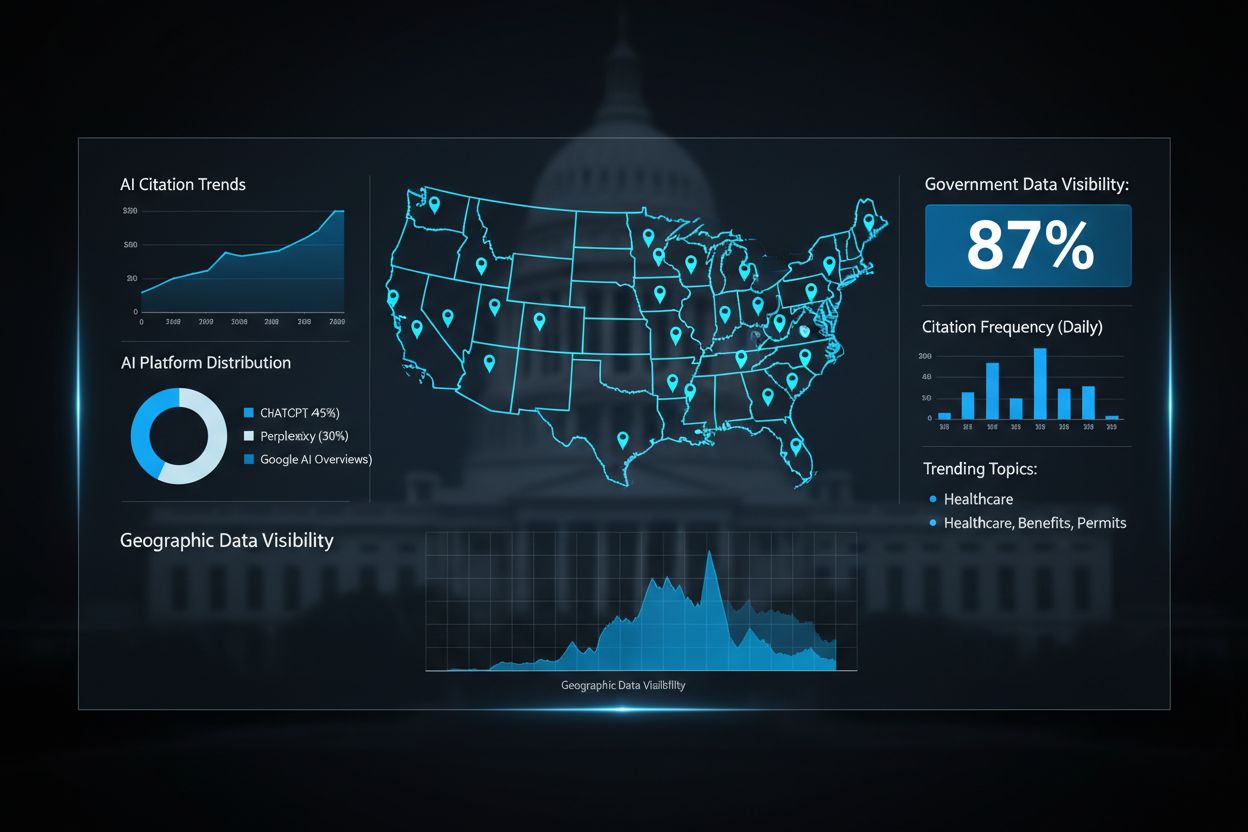

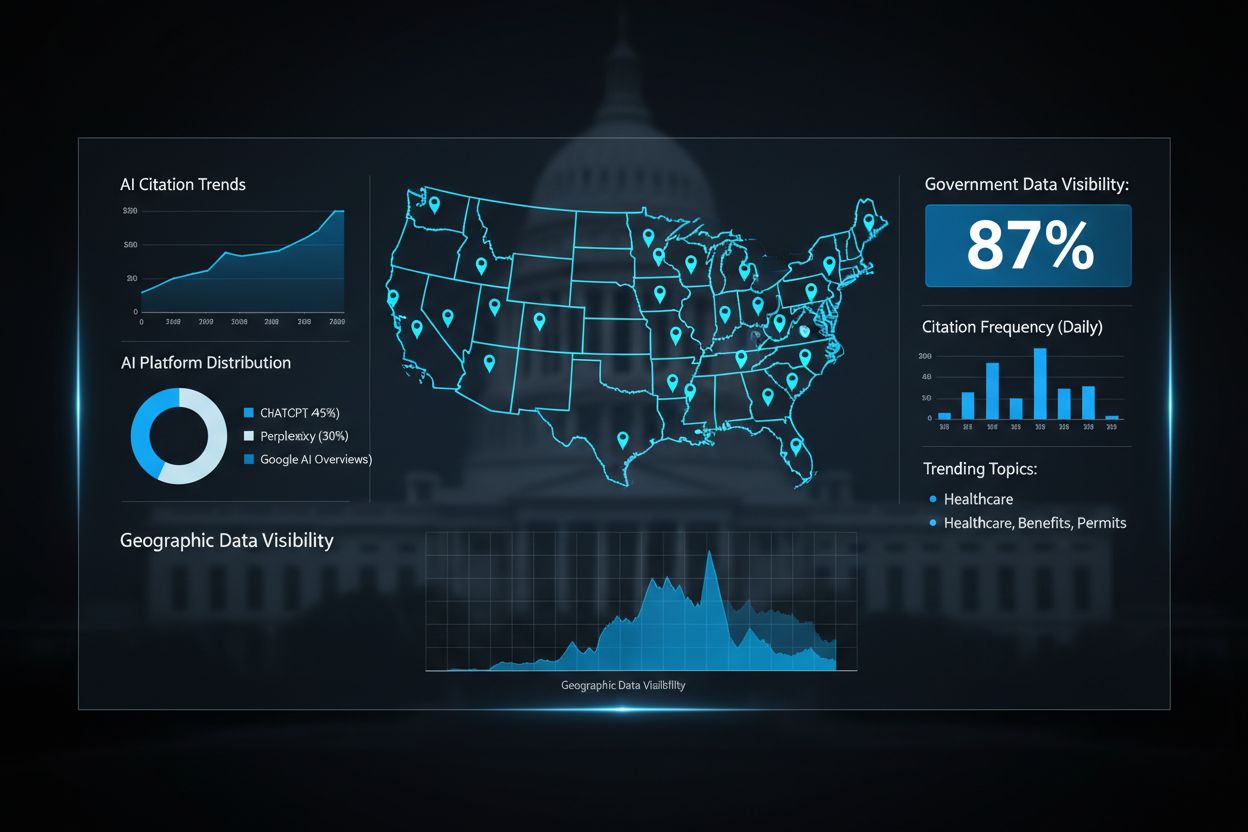

AmICited monitorizează modul în care sistemele AI și LLM-urile fac referire la brandul tău în GPT-uri, Perplexity și Google AI Overviews. Acest lucru oferă vizibilitate asupra prezenței tale în AI, te ajută să înțelegi cum este utilizat conținutul tău de către sisteme AI și îți permite să-ți protejezi reputația brandului în ecosistemul de conținut condus de AI.

AmICited urmărește modul în care sistemele AI și LLM-urile citează conținutul tău în GPT-uri, Perplexity și Google AI Overviews. Obține vizibilitate asupra prezenței tale în AI și protejează-ți reputația brandului.

Află cum pot agențiile guvernamentale să își optimizeze prezența digitală pentru sisteme AI precum ChatGPT și Perplexity. Descoperă strategii pentru îmbunătățir...

Învață strategii dovedite pentru a menține și îmbunătăți vizibilitatea conținutului tău în răspunsurile generate de AI pe ChatGPT, Perplexity și Google AI Overv...

Află cum companiile media obțin vizibilitate în răspunsurile generate de AI prin optimizarea conținutului, media câștigată, PR digital și poziționare strategică...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.