Impactul crawlerelor AI asupra resurselor serverului: La ce să te aștepți

Află cum crawlerii AI influențează resursele serverului, lățimea de bandă și performanța. Descoperă statistici reale, strategii de reducere și soluții de infras...

Aflați cum să luați decizii strategice despre blocarea crawlerilor AI. Evaluați tipul de conținut, sursele de trafic, modelele de venituri și poziția competitivă cu ajutorul cadrului nostru decizional cuprinzător.

Crawlerii AI au devenit o forță semnificativă în ecosistemul digital, schimbând fundamental modul în care conținutul este descoperit, indexat și utilizat pe internet. Aceste sisteme automatizate sunt concepute pentru a naviga sistematic pe site-uri, a extrage date și a le alimenta în modele de învățare automată care stau la baza motoarelor de căutare și a aplicațiilor AI generative. Peisajul acoperă trei tipuri distincte de crawleri: data scrapers care extrag informații specifice în scopuri comerciale, crawleri ai motoarelor de căutare precum Googlebot care indexează conținut pentru rezultate de căutare și crawleri asistenți AI care colectează date pentru antrenarea modelelor lingvistice de mari dimensiuni. Exemple includ GPTBot de la OpenAI, Claude-Web de la Anthropic și crawlerul AI Overviews de la Google, fiecare având scopuri și impacturi diferite. Potrivit analizelor recente, aproximativ 21% dintre cele mai mari 1.000 de site-uri au implementat deja o formă de blocare a crawlerilor AI, semnalând o conștientizare tot mai mare a necesității de a gestiona acești vizitatori automatizați. Înțelegerea crawlerilor care accesează site-ul dvs. și a motivelor pentru care o fac este primul pas esențial pentru a lua o decizie informată privind blocarea sau permiterea lor. Miza este mare, deoarece această decizie impactează direct vizibilitatea conținutului, tiparele de trafic și, în cele din urmă, modelul de venituri.

În loc să luați o decizie generală de a bloca sau permite toți crawlerii AI, o abordare mai sofisticată implică evaluarea situației dvs. specifice prin Cadrul BEDC, care înseamnă Model de Afaceri, Risc de Expunere, Dependență de Trafic Organic și Poziție Competitivă. Fiecare dintre acești patru factori are o pondere diferită în funcție de caracteristicile site-ului dvs., iar împreună creează o matrice decizională cuprinzătoare care ține cont de complexitatea publicării digitale moderne. Cadrul recunoaște că nu există o soluție universală — ceea ce funcționează pentru o organizație de știri poate fi complet greșit pentru o companie SaaS, iar ceea ce avantajează un brand consacrat poate dăuna unui concurent emergent. Evaluând sistematic fiecare factor, puteți depăși reacțiile emoționale față de AI și lua decizii bazate pe date, aliniate cu obiectivele dvs. de business.

| Factor | Recomandare | Considerație Cheie |

|---|---|---|

| Model de afaceri | Site-urile susținute prin reclame ar trebui să fie mai precaute; modelele pe bază de abonament pot fi mai permisive | Dependența veniturilor de implicarea directă a utilizatorului vs. licențiere |

| Risc de expunere | Cercetarea originală și conținutul proprietar necesită blocare; conținutul de tip commodity poate fi mai deschis | Avantaj competitiv legat de perspective sau date unice |

| Dependență de căutare organică | Dependență ridicată (>40% trafic) sugerează permiterea crawlerilor Google, dar blocarea asistenților AI | Echilibru între vizibilitatea în căutare și protecția datelor pentru antrenarea AI |

| Poziție competitivă | Liderii de piață își pot permite să blocheze; jucătorii emergenți pot beneficia de vizibilitate AI | Avantaj de prim mover în parteneriate AI vs. protecția conținutului |

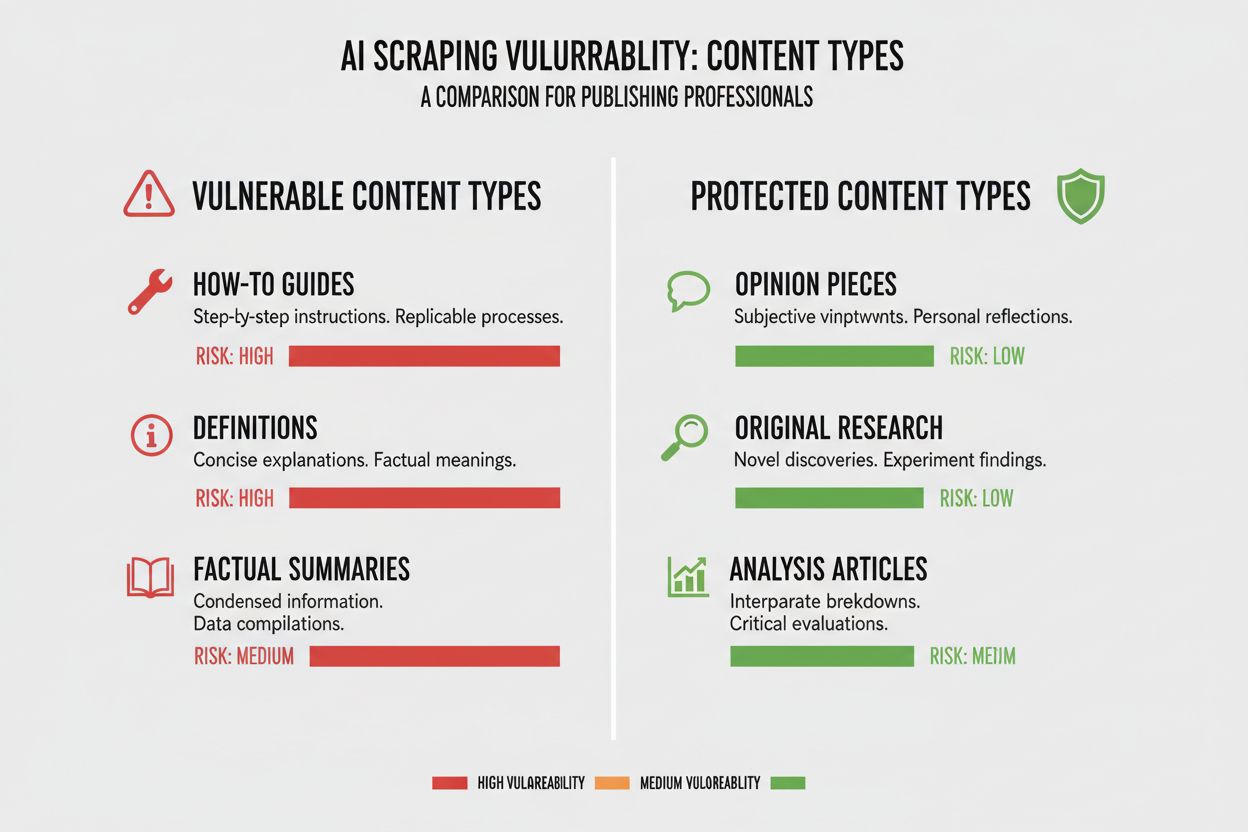

Tipurile de conținut au niveluri foarte diferite de vulnerabilitate la crawling AI, iar înțelegerea poziției conținutului dvs. pe acest spectru este esențială pentru decizia corectă. Cercetarea originală și datele proprietare reprezintă cele mai valoroase active și necesită cea mai puternică protecție, deoarece modelele AI antrenate pe acest conținut pot concura direct cu strategia dvs. de monetizare. Știrile și informațiile de ultimă oră ocupă o zonă de mijloc — valoarea lor se diminuează rapid, dar indexarea în motoarele de căutare rămâne critică pentru trafic, creând o tensiune între vizibilitate și protecție. Conținutul de tip commodity precum ghiduri practice, tutoriale și materiale de referință generală este mult mai puțin vulnerabil deoarece este larg răspândit pe internet și nu este sursa principală de venit. Conținutul multimedia și bazat pe voce se bucură de o protecție naturală, deoarece crawlerii AI actuali nu pot extrage valoare semnificativă din audio și video, făcând aceste formate intrinsec mai sigure. Conținutul educațional evergreen și opiniile se situează undeva la mijloc, fiind valoroase pentru trafic din căutări, dar mai puțin amenințate direct de AI. Concluzia este că strategia dvs. de blocare ar trebui să fie proporțională cu avantajul competitiv al conținutului — protejați “bijuteriile coroanei”, dar rămâneți deschiși pentru crawling acolo unde distribuția largă aduce beneficii.

Dependența de traficul organic din căutări este poate cel mai concret factor în decizia legată de crawlerii AI, deoarece cuantifică direct compromisurile între vizibilitate și protecția conținutului. Site-urile care obțin peste 40% din trafic din căutări organice se confruntă cu o constrângere critică: blocarea crawlerilor AI poate însemna și limitarea sau blocarea crawlerilor Google, ceea ce ar devasta vizibilitatea și traficul organic. Distincția dintre Google-Extended (care crawlează pentru antrenarea AI) și Googlebot (pentru indexare în căutare) este crucială, pentru că teoretic puteți permite unuia și bloca pe celălalt, deși acest lucru aduce complexitate tehnică. Un studiu de caz relevant, The New York Times, a primit aproximativ 240.600 de vizite de la crawleri AI într-o perioadă, demonstrând amploarea traficului generat de AI pentru publisherii mari. Totuși, datele Akamai arată că blocarea crawlerilor duce la cu 96% mai puțin trafic de referință din acele surse, sugerând că aportul crawlerilor AI este minim față de căutările tradiționale. Raportul crawl-to-referral pentru majoritatea crawlerilor AI este foarte scăzut — sub 0,15% din conținutul crawlat generează vizite de întoarcere — astfel încât blocarea acestor crawleri are impact minim asupra traficului real. Pentru site-urile dependente de căutări organice, decizia de a bloca crawleri AI trebuie cântărită atent față de riscul de a bloca accidental crawlerii motoarelor de căutare, ceea ce ar fi mult mai dăunător afacerii.

Modelul de venituri influențează fundamental modul în care abordați crawlerii AI, deoarece strategiile de monetizare diferite creează stimulente diferite privind distribuția și protecția conținutului. Site-urile susținute prin reclame se confruntă cu cea mai mare tensiune, deoarece veniturile lor depind de vizitarea site-ului de către utilizatori pentru a vedea reclame, iar modelele AI care rezumă conținutul reduc motivația de a da click. Modelele bazate pe abonament își pot permite să fie mai permisive cu crawlerii AI, deoarece veniturile provin direct de la abonați, iar vizibilitatea AI ar putea chiar stimula înscrierea la abonament. Modelele hibride, care combină reclame, abonamente și venituri din afiliere, necesită o gândire mai nuanțată, deoarece blocarea crawlerilor poate proteja veniturile din reclame, dar poate afecta oportunitățile de afiliere sau creșterea abonaților. O oportunitate emergentă este modelul de referință AI, unde site-urile pot câștiga venituri permițând accesul crawlerilor AI în schimbul atribuirii și referințelor de trafic — un model încă în dezvoltare, dar care poate schimba economia distribuției digitale. Pentru publisherii care doresc să înțeleagă impactul complet al crawlerilor AI, instrumente precum AmICited.com oferă capabilități esențiale de monitorizare pentru a urmări unde este citat și folosit conținutul de către AI, oferindu-vă vizibilitate asupra valorii reale generate. Cheia este să înțelegeți profund modelul dvs. de venituri pentru a anticipa impactul crawlerilor AI pe fiecare flux, nu să decideți la nivel de principiu.

După ce decideți să blocați anumiți crawleri AI, implementarea tehnică presupune cunoașterea atât a capacităților, cât și a limitărilor instrumentelor disponibile. Cea mai comună metodă este robots.txt, un fișier text simplu plasat la rădăcina site-ului, care instrucționează crawlerii ce secțiuni pot accesa. Totuși, robots.txt are o limitare critică: este un standard voluntar, iar crawlerii rău intenționați sau agresivi îl pot ignora. Iată un exemplu de blocare a unor crawleri AI în robots.txt:

User-agent: GPTBot

Disallow: /

User-agent: CCBot

Disallow: /

User-agent: anthropic-ai

Disallow: /

User-agent: Claude-Web

Disallow: /

Dincolo de robots.txt, ar trebui să luați în considerare blocarea acestor principalii crawleri AI:

Pentru protecție mai robustă, multe organizații implementează blocare la nivel de CDN prin servicii precum Cloudflare, care blochează traficul la marginea rețelei, înainte de a ajunge la server, oferind performanță și securitate mai bune. O abordare în două straturi care combină robots.txt cu blocare la nivel de CDN oferă cea mai puternică protecție, deoarece acoperă atât crawlerii care respectă robots.txt, cât și pe cei agresivi care îl ignoră. Este important de menționat că blocarea la nivel de CDN necesită mai multă sofisticare tehnică și poate avea consecințe neintenționate dacă nu este configurată corect, fiind potrivită organizațiilor cu resurse tehnice dedicate.

Adevărul incomod despre blocarea crawlerilor AI este că impactul real asupra traficului este de obicei mult mai mic decât reacția emoțională la scraping, iar datele arată o imagine mai nuanțată decât s-ar aștepta publisherii. Analize recente arată că crawlerii AI reprezintă de obicei doar 0,15% din traficul total al site-ului pentru majoritatea publisherilor, un procent surprinzător de mic față de atenția acordată subiectului. Totuși, rata de creștere a traficului crawlerilor AI este dramatică, unele rapoarte arătând o creștere de 7 ori de la an la an a solicitărilor. ChatGPT reprezintă aproximativ 78% din tot traficul crawlerilor AI, fiind forța dominantă, urmată de contribuții mult mai mici ale altor companii AI. Datele crawl-to-referral sunt deosebit de relevante: deși crawlerii AI pot solicita milioane de pagini, generează vizite reale la rate de sub 0,15%, ceea ce înseamnă că blocarea lor are impact minim asupra traficului real. Blocarea crawlerilor AI reduce traficul de referință cu 96%, dar deoarece acel trafic era oricum minim (sub 0,15% din total), impactul net asupra afacerii este adesea neglijabil. Se creează astfel un paradox: blocarea crawlerilor AI pare o poziție de principiu împotriva furtului de conținut, dar impactul real în afaceri este adesea atât de mic încât abia se vede în analitice. Întrebarea reală nu este dacă blocarea crawlerilor vă va afecta traficul — de obicei nu — ci dacă permiterea lor creează oportunități sau riscuri strategice care depășesc aportul minim de trafic pe care îl oferă.

Poziția dvs. competitivă pe piață influențează fundamental modul de abordare a crawlerilor AI, deoarece strategia optimă pentru un lider de piață diferă dramatic de cea a unui concurent emergent. Jucătorii dominanți precum The New York Times, Wall Street Journal și marile organizații de știri își pot permite să blocheze crawlerii AI, deoarece recunoașterea brandului și relațiile directe cu publicul înseamnă că nu depind de descoperirea AI pentru trafic. Jucătorii emergenți și publisherii de nișă au un calcul diferit: să fie indexați de sistemele AI și să apară în rezumate generate de AI poate fi una dintre puținele căi de a câștiga vizibilitate în fața competitorilor consacrați. Avantajul de prim mover în parteneriatele cu AI poate fi semnificativ — publisherii care negociază termeni favorabili devreme pot obține atribuire, trafic sau acorduri de licențiere mai bune decât cei care așteaptă. Există și un efect de subvenționare: când publisherii dominanți blochează crawlerii AI, companiile AI tind să folosească mai mult conținutul celor care permit crawling-ul, oferindu-le acestora o vizibilitate disproporționată în sistemele AI. Se creează astfel o dinamică competitivă în care blocarea poate dăuna poziției dacă competitorii permit crawling și câștigă astfel vizibilitate AI. Înțelegerea poziției proprii în peisajul competitiv e esențială pentru a anticipa cum va influența decizia de blocare poziția pe piață față de concurenți.

Decizia de a bloca sau permite crawlerii AI necesită evaluarea sistematică a situației proprii după criterii concrete. Folosiți această listă pentru a vă ghida procesul decizional:

Evaluarea expunerii conținutului

Analiza compoziției traficului

Evaluarea poziției pe piață

Evaluarea riscului pentru venituri

Dincolo de această evaluare inițială, implementați revizuiri trimestriale ale strategiei privind crawlerii AI, deoarece peisajul evoluează rapid și decizia optimă de azi s-ar putea schimba în câteva luni. Folosiți instrumente precum AmICited.com pentru a urmări unde este citat și folosit conținutul dvs. de către AI, obținând date concrete despre valoarea schimbului. Ideea cheie este că această decizie nu trebuie luată o singură dată și uitată — necesită evaluare și ajustare continuă pe măsură ce peisajul AI maturizează și circumstanțele afacerii se schimbă.

O oportunitate emergentă semnificativă care poate schimba întregul peisaj al crawlerilor AI este funcționalitatea pay-per-crawl de la Cloudflare, care introduce un model de internet bazat pe permisiuni, unde proprietarii de site pot monetiza accesul crawlerilor AI în loc să îi blocheze sau să îi permită pur și simplu. Această abordare recunoaște că firmele AI extrag valoare din crawling-ul conținutului și, în loc să se angajeze într-un război de blocare, puteți negocia compensații pentru acces. Modelul se bazează pe verificare criptografică pentru a se asigura că doar crawlerii autorizați pot accesa conținutul, prevenind scraping-ul neautorizat și permițând companiilor AI legitime să plătească pentru acces. Astfel obțineți control granular asupra crawlerilor care pot accesa anumite conținuturi, permițând monetizarea conținutului de valoare, rămânând deschis pentru motoarele de căutare și crawlerii benefici. Modelul pay-per-crawl permite și capabilități de audit AI, putând vedea exact ce conținut a fost crawlat, când și de către cine, oferind transparență imposibilă cu metodele tradiționale de blocare. Pentru publisherii care implementează această strategie, capabilitățile de monitorizare ale AmICited.com devin și mai valoroase, deoarece puteți urmări nu doar unde apare conținutul în sistemele AI, ci și dacă primiți compensația corespunzătoare pentru acea utilizare. Deși acest model este încă la început și cu adopție limitată, reprezintă o abordare potențial mai sofisticată decât alegerea binară între blocare și permitere — una care recunoaște valoarea reciprocă în relația dintre publisheri și companiile AI, protejând totodată interesele dvs. prin mecanisme contractuale și tehnice.

Blocarea crawlerilor AI îi împiedică să acceseze conținutul dvs. prin robots.txt sau blocare la nivel de CDN, protejându-vă conținutul de a fi folosit pentru antrenarea AI-ului. Permițând crawlerilor, conținutul dvs. poate fi indexat de sisteme AI și poate apărea în rezumate și răspunsuri generate de AI. Alegerea depinde de tipul de conținut, modelul de venituri și poziția competitivă.

Blocarea crawlerilor AI nu vă va afecta direct SEO-ul dacă blocați doar crawleri specifici AI precum GPTBot și permiteți accesul Googlebot. Totuși, dacă blocați accidental Googlebot, clasamentul dvs. în căutări va avea de suferit semnificativ. Cheia este să folosiți un control granular pentru a bloca doar crawlerii pentru antrenarea AI, păstrând accesul motoarelor de căutare.

Da, puteți folosi robots.txt pentru a bloca anumiți crawleri în funcție de user-agent, permițând altora accesul. De exemplu, puteți bloca GPTBot și permite Google-Extended sau invers. Această abordare granulară vă permite să vă protejați conținutul față de anumite companii AI, rămânând vizibil pentru altele.

robots.txt este un standard voluntar care se bazează pe respectarea instrucțiunilor de către crawleri — unele companii AI îl ignoră. Blocarea la nivel de CDN (precum cea oferită de Cloudflare) blochează traficul la marginea rețelei, înainte să ajungă la serverele dvs., oferind o protecție mai puternică. O abordare în două straturi, folosind ambele metode, oferă cea mai bună protecție.

Puteți verifica jurnalele serverului pentru user-agent-uri cunoscute ale crawlerilor AI, precum GPTBot, CCBot și Claude-Web. Instrumente precum AmICited.com oferă capabilități de monitorizare pentru a urmări unde apare conținutul dvs. în sistemele AI și cât de des este accesat de crawlerii AI.

Pay-per-crawl este un model emergent prin care companiile AI plătesc pentru accesul la conținutul dvs. Deși este încă în fază beta și cu adopție limitată, reprezintă o posibilă sursă nouă de venit. Viabilitatea depinde de volumul traficului de crawleri AI și de tarifele pe care companiile AI sunt dispuse să le plătească.

Dacă un crawler AI ignoră directivele din robots.txt, implementați blocarea la nivel de CDN prin servicii precum Cloudflare. De asemenea, puteți configura serverul să returneze erori 403 pentru user-agent-uri cunoscute ale crawlerilor AI. Pentru încălcări persistente, luați în considerare acțiuni legale sau contactarea directă a companiei AI.

Revizuiți strategia privind crawlerii AI trimestrial, deoarece peisajul se schimbă rapid. Monitorizați schimbările în traficul crawlerilor AI, apariția de noi crawleri și modificările poziției dvs. competitive. Folosiți instrumente precum AmICited.com pentru a urmări cum este folosit conținutul dvs. de către sistemele AI și ajustați strategia în consecință.

Urmăriți unde apare conținutul dvs. în răspunsurile generate de AI și înțelegeți impactul crawlerilor AI asupra afacerii dvs. cu platforma cuprinzătoare de monitorizare oferită de AmICited.com.

Află cum crawlerii AI influențează resursele serverului, lățimea de bandă și performanța. Descoperă statistici reale, strategii de reducere și soluții de infras...

Află cum să identifici și să monitorizezi crawlerele AI precum GPTBot, PerplexityBot și ClaudeBot în jurnalele serverului tău. Descoperă șiruri user-agent, meto...

Înțelegeți cum funcționează crawlerii AI precum GPTBot și ClaudeBot, diferențele lor față de crawlerii de căutare tradiționali și cum să vă optimizați site-ul p...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.