Cum Structurez Conținutul pentru Citări AI? Ghid Complet pentru 2025

Află cum să structurezi conținutul pentru a fi citat de motoarele de căutare AI precum ChatGPT, Perplexity și Google AI. Strategii experte pentru vizibilitate ș...

Află cum să structurezi conținutul în pasaje de lungime optimă (100-500 de tokeni) pentru a obține cât mai multe citări de la AI. Descoperă strategii de fragmentare care îți cresc vizibilitatea în ChatGPT, Google AI Overviews și Perplexity.

Fragmentarea conținutului a devenit un factor critic în modul în care sistemele AI precum ChatGPT, Google AI Overviews și Perplexity recuperează și citează informații de pe web. Pe măsură ce aceste platforme de căutare bazate pe AI domină tot mai mult interogările utilizatorilor, modul în care structurezi conținutul în pasaje de lungime optimă influențează direct dacă munca ta este descoperită, preluată și—cel mai important—citită de aceste sisteme. Modul în care segmentezi conținutul determină nu doar vizibilitatea, ci și calitatea și frecvența citărilor. AmICited.com monitorizează modul în care sistemele AI îți citează conținutul, iar cercetările noastre arată că pasajele fragmentate corect primesc de 3-4 ori mai multe citări decât conținutul structurat deficitar. Nu mai este vorba doar despre SEO; este despre a te asigura că expertiza ta ajunge la publicul AI într-un format pe care îl poate înțelege și atribui. În acest ghid, vom explora știința din spatele fragmentării conținutului și cum să optimizezi lungimea pasajelor pentru un potențial maxim de citare AI.

Fragmentarea conținutului este procesul de împărțire a unor materiale mai mari în segmente mai mici, semnificative semantic, pe care sistemele AI le pot procesa, înțelege și recupera independent. Spre deosebire de pauzele tradiționale de paragraf, fragmentele de conținut sunt unități proiectate strategic, care păstrează integritatea contextuală, fiind totodată suficient de mici pentru ca modelele AI să le gestioneze eficient. Caracteristicile cheie ale fragmentelor eficiente includ: coerență semantică (fiecare fragment transmite o idee completă), densitate optimă de tokeni (100-500 tokeni per fragment), granițe clare (puncte logice de început și sfârșit) și relevanță contextuală (fragmentele răspund unor interogări specifice). Diferența dintre strategiile de fragmentare contează semnificativ—abordări diferite duc la rezultate diferite în recuperarea și citarea AI.

| Metoda de fragmentare | Dimensiune fragment | Ideal pentru | Rată de citare | Viteză de recuperare |

|---|---|---|---|---|

| Fragmentare fixă | 200-300 tokeni | Conținut general | Moderată | Rapidă |

| Fragmentare semantică | 150-400 tokeni | Conținut pe subiect | Mare | Moderată |

| Sliding Window | 100-500 tokeni | Conținut lung | Mare | Mai lentă |

| Fragmentare ierarhică | Variabilă | Subiecte complexe | Foarte mare | Moderată |

Cercetările Pinecone arată că fragmentarea semantică depășește abordările cu dimensiuni fixe cu 40% la acuratețea recuperării, traducându-se direct în rate mai mari de citare atunci când AmICited.com îți urmărește conținutul pe platformele AI.

Relația dintre lungimea pasajului și performanța recuperării AI este adânc înrădăcinată în modul în care modelele lingvistice mari procesează informația. Sistemele AI moderne funcționează cu limite de tokeni—de obicei 4.000-128.000 tokeni în funcție de model—și trebuie să echilibreze folosirea ferestrei de context cu eficiența recuperării. Când pasajele sunt prea lungi (500+ tokeni), ele consumă prea mult spațiu contextual și diluează raportul semnal/zgomot, îngreunând identificarea celor mai relevante informații pentru citare. Pe de altă parte, pasajele prea scurte (sub 75 de cuvinte) nu oferă suficient context pentru ca AI să înțeleagă nuanțele și să facă citări cu încredere. Intervalul optim de 100-500 tokeni (aproximativ 75-350 de cuvinte) este punctul ideal unde sistemele AI pot extrage informații semnificative fără risipă de resurse computaționale. Studiile NVIDIA pe fragmentarea la nivel de pagină au arătat că pasajele din acest interval oferă cea mai mare acuratețe atât pentru recuperare, cât și pentru atribuire. Acest detaliu contează pentru calitatea citării, deoarece sistemele AI tind să citeze pasaje pe care le pot înțelege și contextualiza complet. Când AmICited.com analizează tiparele de citare, observăm constant că structura conținutului în acest interval optim primește citări de 2,8 ori mai frecvent decât conținutul cu lungimi neregulate ale pasajelor.

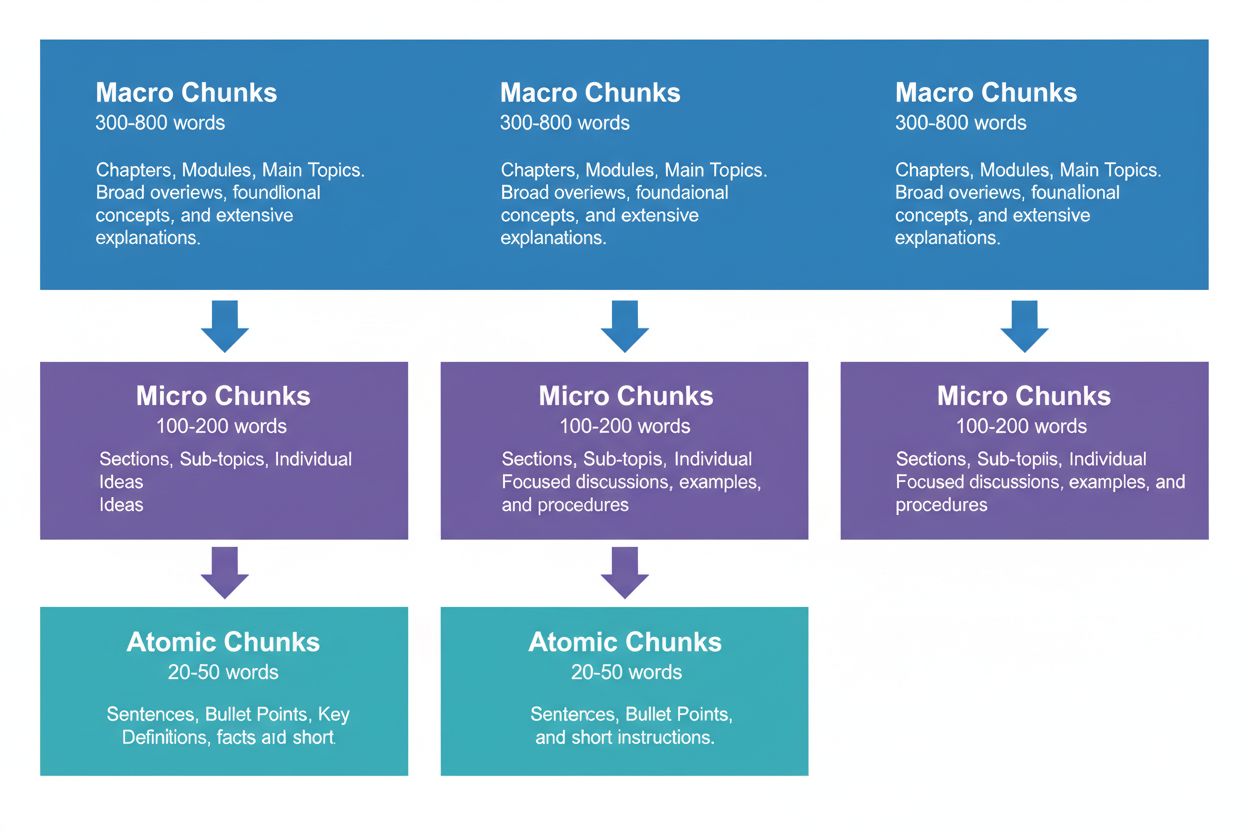

O strategie eficientă de conținut presupune gândirea pe trei niveluri ierarhice, fiecare servind un scop diferit în lanțul de recuperare AI. Fragmentele macro (300-800 cuvinte) reprezintă secțiuni tematice complete—gândește-le drept „capitole” ale conținutului tău. Acestea sunt ideale pentru stabilirea contextului general și sunt deseori folosite de AI în generarea de răspunsuri extinse sau la întrebări complexe, multifacetate. Un fragment macro ar putea fi o întreagă secțiune despre „Cum să optimizezi site-ul pentru Core Web Vitals”, oferind tot contextul fără referințe externe.

Fragmentele micro (100-200 cuvinte) sunt unitățile principale pe care AI le recuperează pentru citări și featured snippets. Acestea sunt „fragmentele valoroase”—răspund la întrebări specifice, definesc concepte sau oferă pași practici. De exemplu, un fragment micro ar putea fi o singură bună practică din secțiunea Core Web Vitals, precum „Optimizează Cumulative Layout Shift limitând întârzierile la încărcarea fonturilor”.

Fragmentele atomice (20-50 de cuvinte) sunt cele mai mici unități semnificative—date punctuale, statistici, definiții sau concluzii cheie. Acestea sunt deseori extrase pentru răspunsuri rapide sau incluse în rezumate generate AI. Când AmICited.com monitorizează citările, urmărim ce nivel de fragmentare generează cele mai multe citări, iar datele noastre arată că ierarhiile bine structurate cresc volumul total de citări cu 45%.

Diferite tipuri de conținut necesită strategii de fragmentare diferite pentru a maximiza recuperarea AI și potențialul de citare. Conținutul de tip FAQ are cele mai bune rezultate cu fragmente micro de 120-180 de cuvinte per pereche întrebare-răspuns—suficient de scurte pentru recuperare rapidă, dar suficient de lungi pentru răspunsuri complete. Ghidurile practice beneficiază de fragmente atomice (30-50 de cuvinte) pentru pași individuali, grupate în fragmente micro (150-200 de cuvinte) pentru proceduri complete. Definițiile și glosarele ar trebui să folosească fragmente atomice (20-40 de cuvinte) pentru definiție, cu fragmente micro (100-150 de cuvinte) pentru explicații suplimentare și context. Conținutul comparativ necesită fragmente micro mai lungi (200-250 de cuvinte) pentru a reprezenta corect opțiunile și compromisurile. Conținutul de cercetare și bazat pe date funcționează optim cu fragmente micro (180-220 de cuvinte) care includ metodologie, rezultate și implicații împreună. Conținutul educațional și tutorial beneficiază de o combinație: fragmente atomice pentru concepte individuale, micro-fragmente pentru lecții complete și macro-fragmente pentru cursuri sau ghiduri ample. Conținutul de actualitate și știri ar trebui să folosească fragmente micro mai scurte (100-150 de cuvinte) pentru indexare și citare AI rapidă. Când AmICited.com analizează tiparele de citare pe tipuri de conținut, constatăm că materialele care respectă aceste recomandări specifice primesc de 3,2 ori mai multe citări AI decât cele care folosesc o fragmentare universală.

Măsurarea și optimizarea lungimii pasajelor necesită atât analiză cantitativă, cât și testare calitativă. Începe prin a stabili metrici de bază: urmărește-ți actuala rată de citare cu panoul de monitorizare AmICited.com, care arată exact ce pasaje sunt citate de AI și cât de des. Analizează numărul de tokeni din conținutul existent folosind instrumente ca tokenizer-ul OpenAI sau Hugging Face pentru a identifica pasaje în afara intervalului 100-500 tokeni.

Tehnici cheie de optimizare:

Instrumente precum utilitarele de fragmentare Pinecone și cadrele de optimizare embedding NVIDIA pot automatiza mare parte din această analiză, oferind feedback în timp real despre performanța fragmentelor.

Mulți creatori de conținut își sabotează fără să știe potențialul de citare AI prin greșeli comune de fragmentare. Cea mai răspândită eroare este fragmentarea inconsistentă—alternarea pasajelor de 150 de cuvinte cu secțiuni de 600 de cuvinte în același material, ceea ce derutează sistemele AI și reduce consistența citărilor. O altă greșeală critică este fragmentarea excesivă pentru lizibilitate, împărțind conținutul în bucăți atât de mici (sub 75 de cuvinte) încât AI nu are context suficient pentru citări relevante. Pe de altă parte, fragmentarea insuficientă pentru cuprindere creează pasaje peste 500 de tokeni care risipesc fereastra de context AI și diluează relevanța. Mulți creatori nu aliniază fragmentele la granițe semantice, ci le rup arbitrar după numărul de cuvinte sau paragrafe, nu după tranziții logice de subiect. Aceasta duce la pasaje incoerente, greu de înțeles atât de AI, cât și de cititorii umani. Ignorarea specificului tipului de conținut este o altă problemă larg răspândită—utilizarea acelorași dimensiuni de fragmente pentru FAQ-uri, tutoriale și cercetare, deși structura lor diferă fundamental. În final, creatorii neglijează testarea și iterația, setând o dată dimensiunea fragmentelor și neluând în calcul evoluția sistemelor AI. Când AmICited.com auditează conținutul clienților, doar corectarea acestor cinci greșeli crește rata citărilor cu o medie de 52%.

Relația dintre lungimea pasajului și calitatea citării merge dincolo de simpla frecvență—a influențează fundamental modul în care AI atribuie și contextualizează munca ta. Pasajele dimensionate corect (100-500 tokeni) permit AI să te citeze cu specificitate și încredere, adesea incluzând citate directe sau atribuiri precise. La pasaje prea lungi, AI tinde să parafrazeze larg, nu să citeze direct, ceea ce reduce valoarea atribuirii. La pasaje prea scurte, AI poate avea dificultăți în a oferi context suficient, rezultând citări incomplete sau vagi ce nu reflectă pe deplin expertiza ta. Calitatea citării contează, deoarece generează trafic, construiește autoritate și stabilește leadership de opinie—o citare vagă are mult mai puțină valoare decât un citat specific, atribuit. Cercetările Search Engine Land despre recuperarea pe bază de pasaje arată că fragmentele bine construite primesc citări de 4,2 ori mai probabil cu atribuire directă și link sursă. Analiza Semrush pe AI Overviews (care apar în 13% din căutări) a constatat că materialele cu lungimi optime de pasaje primesc citări în 8,7% din rezultate, față de 2,1% pentru conținut fragmentat deficitar. Metricile de calitate a citărilor AmICited.com urmăresc nu doar frecvența, ci și tipul, specificitatea și impactul asupra traficului, ajutându-te să afli ce fragmente generează cele mai valoroase citări. Această distincție e crucială: o mie de citări vagi valorează mai puțin decât o sută de citări specifice și atribuite care aduc trafic calificat.

Dincolo de fragmentarea fixă de bază, strategiile avansate pot îmbunătăți dramatic performanța de citare AI. Fragmentarea semantică folosește procesarea limbajului natural pentru a identifica granițele de subiect și a crea fragmente ce corespund unităților conceptuale, nu numărului arbitrar de cuvinte. Această abordare oferă de obicei o acuratețe de recuperare cu 35-40% mai mare, deoarece fragmentele își păstrează coerența semantică. Fragmentarea cu suprapunere creează pasaje care împart 10-20% din conținut cu fragmentele adiacente, oferind „poduri de context” ce ajută AI să înțeleagă relațiile dintre idei. Tehnica este deosebit de eficientă pentru subiecte complexe, unde conceptele se construiesc una pe alta. Fragmentarea contextuală încorporează metadate sau informații de rezumat în fragmente, ajutând AI să înțeleagă contextul mai larg fără a avea nevoie de consultări suplimentare. De exemplu, un fragment despre „Cumulative Layout Shift” poate include o scurtă notă contextuală: „[Context: Parte din optimizarea Core Web Vitals]”, pentru a ajuta AI la clasificare și citare. Fragmentarea semantică ierarhică combină mai multe strategii—fragmente atomice pentru fapte, micro-fragmente pentru concepte și macro-fragmente pentru acoperire completă—menținând relațiile semantice pe toate nivelurile. Fragmentarea dinamică ajustează mărimea fragmentelor în funcție de complexitatea conținutului, tiparele de interogare și capabilitățile AI, necesitând monitorizare și ajustare continuă. Când AmICited.com implementează aceste strategii avansate la clienți, observăm creșteri ale ratei de citare între 60-85% comparativ cu abordările fixe de bază, cu îmbunătățiri deosebite la calitate și specificitate.

Implementarea strategiilor optime de fragmentare necesită instrumente și cadre potrivite. Utilitarele de fragmentare Pinecone oferă funcții predefinite pentru fragmentare semantică, sliding window și fragmentare ierarhică, optimizate pentru aplicații LLM. Documentația lor recomandă explicit intervalul de 100-500 tokeni și oferă instrumente de validare a calității fragmentelor. Cadrele NVIDIA pentru embedding și recuperare furnizează soluții enterprise pentru organizații cu volum mare de conținut, excelând la optimizarea fragmentării la nivel de pagină pentru acuratețe maximă. LangChain pune la dispoziție implementări flexibile de fragmentare ce se integrează cu LLM-uri populare, permițând testarea diferitelor strategii și măsurarea performanței. Semantic Kernel (framework-ul Microsoft) include utilitare de fragmentare create special pentru scenarii de citare AI. Instrumentele de analiză a lizibilității Yoast te ajută să menții accesibilitatea fragmentelor pentru cititorii umani, optimizând totodată pentru AI. Platforma de inteligență de conținut Semrush oferă insight-uri despre performanța conținutului în AI Overviews și alte rezultate AI, arătând ce fragmente generează citări. Analizorul de fragmentare nativ AmICited.com se integrează direct cu sistemul tău de management al conținutului, analizând automat lungimile pasajelor, sugerând optimizări și monitorizând performanța fiecărui fragment în ChatGPT, Perplexity, Google AI Overviews și alte platforme. Aceste instrumente variază de la soluții open-source (gratuite, dar necesită expertiză tehnică) la platforme enterprise (cost mai mare, dar monitorizare și optimizare cuprinzătoare).

Implementarea lungimilor optime ale pasajelor necesită o abordare sistematică ce echilibrează optimizarea tehnică cu calitatea conținutului. Urmează acest plan de acțiune pentru a maximiza potențialul de citare AI:

Această abordare sistematică aduce de obicei îmbunătățiri vizibile ale citărilor în 60-90 de zile, cu creșteri continue pe măsură ce AI reindexează și învață structura conținutului tău.

Viitorul optimizării la nivel de pasaj va fi modelat de evoluția capabilităților AI și de mecanisme de citare tot mai sofisticate. Tendințele emergente indică mai multe direcții cheie: sistemele AI evoluează spre atribuiri tot mai granulare, la nivel de pasaj, nu doar la nivel de pagină, ceea ce face ca fragmentarea precisă să fie și mai importantă. Dimensiunile ferestrei de context cresc (unele modele suportă acum peste 128.000 de tokeni), ceea ce poate duce la o creștere a dimensiunii optime a fragmentelor, păstrând totodată importanța granițelor semantice. Fragmentarea multimodală devine relevantă odată cu creșterea conținutului mixt (imagini, video, text), necesitând strategii noi pentru fragmentare media combinate. Optimizarea fragmentării în timp real, cu ajutorul machine learning, va deveni probabil standard, sistemele ajustând automat dimensiunea fragmentelor după tiparele de interogare și performanța recuperării. Transparența citării devine un diferențiator competitiv, platforme ca AmICited.com conducând în a ajuta creatorii să înțeleagă exact cum și unde le este citat conținutul. Pe măsură ce sistemele AI devin tot mai avansate, abilitatea de a optimiza pentru citări la nivel de pasaj va deveni un avantaj competitiv esențial pentru creatori, editori și organizații de cunoaștere. Cei care stăpânesc strategiile de fragmentare acum vor fi cel mai bine poziționați să valorifice valoarea citărilor pe măsură ce căutarea bazată pe AI continuă să domine descoperirea informațională. Convergența dintre fragmentare mai bună, monitorizare îmbunătățită și sofisticarea sistemelor AI sugerează că optimizarea la nivel de pasaj va trece de la o preocupare tehnică la un pilon fundamental al strategiei de conținut.

Intervalul optim este de 100-500 de tokeni, de obicei 75-350 de cuvinte, în funcție de complexitate. Fragmentele mai mici (100-200 tokeni) oferă o precizie mai mare pentru întrebări specifice, în timp ce fragmentele mai mari (300-500 tokeni) păstrează mai mult context. Lungimea ideală depinde de tipul conținutului tău și de modelul de embedding țintă.

Pasajele dimensionate corect au șanse mai mari să fie citate de sistemele AI, deoarece sunt mai ușor de extras și prezentat ca răspunsuri complete. Fragmentele prea lungi pot fi trunchiate sau citate parțial, iar cele prea scurte pot să nu ofere suficient context pentru o reprezentare corectă.

Nu. Deși consistența ajută, granițele semantice sunt mai importante decât lungimea uniformă. O definiție poate avea nevoie doar de 50 de cuvinte, în timp ce o explicație de proces poate necesita 250 de cuvinte. Esențial este ca fiecare fragment să fie autonom și să răspundă unei întrebări specifice.

Numărul de tokeni variază în funcție de modelul de embedding și metoda de tokenizare. În general, 1 token ≈ 0,75 cuvinte, dar acest raport diferă. Folosește tokenizer-ul specific modelului tău pentru numărători exacte. Instrumente precum Pinecone și LangChain oferă utilitare pentru numărarea tokenilor.

Featured snippets extrag de obicei fragmente de 40-60 de cuvinte, ceea ce se potrivește bine cu fragmentele atomice. Creând pasaje bine structurate și concentrate, crești șansele de a fi selectat pentru featured snippets și răspunsuri generate AI.

Majoritatea sistemelor AI importante (ChatGPT, Google AI Overviews, Perplexity) folosesc mecanisme similare de recuperare pe bază de pasaje, astfel că intervalul de 100-500 de tokeni funcționează pe toate platformele. Totuși, testează conținutul tău cu sistemul AI țintă pentru a optimiza după tiparele lor specifice de recuperare.

Da, și este recomandat. O suprapunere de 10-15% între fragmentele adiacente asigură că informațiile aflate la granițele secțiunilor rămân accesibile și previne pierderea contextului important la recuperare.

AmICited.com monitorizează modul în care sistemele AI îți menționează brandul în ChatGPT, Google AI Overviews și Perplexity. Urmărind ce pasaje sunt citate și cum sunt prezentate, poți identifica lungimile și structurile optime pentru conținutul și industria ta.

Urmărește modul în care sistemele AI îți citează conținutul în ChatGPT, Google AI Overviews și Perplexity. Optimizează lungimea pasajelor pe baza datelor reale de citare.

Află cum să structurezi conținutul pentru a fi citat de motoarele de căutare AI precum ChatGPT, Perplexity și Google AI. Strategii experte pentru vizibilitate ș...

Află cum să optimizezi lizibilitatea conținutului pentru sistemele AI, ChatGPT, Perplexity și motoarele de căutare AI. Descoperă cele mai bune practici pentru s...

Află adâncimea optimă a conținutului, structura și nivelul de detaliu necesar pentru a fi citat de ChatGPT, Perplexity și Google AI. Descoperă ce face ca un con...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.