Corectarea dezinformării AI

Află cum să identifici și să corectezi informațiile incorecte despre brand în sistemele AI precum ChatGPT, Gemini și Perplexity. Descoperă instrumente de monito...

Descoperă cum sunt manipulate și exploatate sistemele AI. Află despre atacuri adversariale, consecințe reale și mecanisme de apărare pentru a-ți proteja investițiile în AI.

Manipularea sistemelor AI se referă la practica de a exploata sau manipula deliberat modelele de inteligență artificială pentru a genera rezultate neintenționate, a ocoli măsurile de securitate sau a extrage informații sensibile. Aceasta depășește erorile normale ale sistemului sau greșelile utilizatorului — este o încercare deliberată de a ocoli comportamentul intenționat al sistemelor AI. Pe măsură ce AI-ul este tot mai integrat în operațiunile de afaceri critice, de la chatbot-uri pentru clienți la sisteme de detectare a fraudei, înțelegerea modului în care aceste sisteme pot fi manipulate devine esențială pentru protejarea activelor organizaționale și a încrederii utilizatorilor. Miza este deosebit de ridicată deoarece manipularea AI are loc adesea invizibil, atât utilizatorii cât și operatorii sistemului nefiind conștienți că AI-ul a fost compromis sau se comportă contrar designului său.

Sistemele AI se confruntă cu multiple categorii de atacuri, fiecare exploatând vulnerabilități diferite în modul în care modelele sunt antrenate, implementate și utilizate. Înțelegerea acestor vectori de atac este crucială pentru organizațiile care doresc să-și protejeze investițiile în AI și să mențină integritatea sistemului. Cercetătorii și experții în securitate au identificat șase categorii principale de atacuri adversariale ce reprezintă cele mai semnificative amenințări pentru sistemele AI de astăzi. Aceste atacuri variază de la manipularea input-urilor în timpul inferenței, la coruperea datelor de antrenament, extragerea informațiilor proprietare ale modelului sau deducerea dacă datele anumitor persoane au fost folosite la antrenament. Fiecare tip de atac necesită strategii de apărare diferite și implică consecințe unice pentru organizații și utilizatori.

| Tip de atac | Metodă | Impact | Exemplu real |

|---|---|---|---|

| Prompt Injection | Input-uri create special pentru a manipula comportamentul LLM | Rezultate dăunătoare, dezinformare, comenzi neautorizate | Chatbot-ul Chevrolet manipulat să accepte vânzarea unei mașini de peste 50.000$ pentru 1$ |

| Atacuri de evaziune | Modificări subtile ale input-urilor (imagini, audio, text) | Ocolirea sistemelor de securitate, clasificare greșită | Autopilotul Tesla păcălit cu trei stickere discrete pe drum |

| Atacuri de otrăvire | Date corupte sau înșelătoare introduse în setul de antrenament | Bias al modelului, predicții eronate, integritate compromisă | Chatbot-ul Microsoft Tay a produs tweet-uri rasiste la câteva ore de la lansare |

| Inversiunea modelului | Analiza rezultatelor pentru a reconstrui datele de antrenament | Breșă de confidențialitate, expunerea datelor sensibile | Fotografii medicale reconstruite din date sintetice de sănătate |

| Furtul modelului | Interogări repetate pentru a replica modelul proprietar | Furt de proprietate intelectuală, dezavantaj competitiv | Mindgard a extras componente ChatGPT cu doar 50$ cost API |

| Inferența apartenenței | Analizarea nivelului de încredere pentru a determina includerea în datele de antrenament | Încălcarea confidențialității, identificarea individuală | Cercetătorii au identificat dacă anumite dosare medicale erau în datele de antrenament |

Riscurile teoretice ale manipulării AI devin cât se poate de reale când analizăm incidentele care au afectat organizații mari și clienții lor. Chatbot-ul Chevrolet alimentat de ChatGPT a devenit un exemplu de manual când utilizatorii au descoperit rapid că îl pot manipula prin injectarea de prompturi, convingând sistemul să accepte vânzarea unui vehicul de peste 50.000$ pentru doar 1$. Air Canada s-a confruntat cu consecințe legale majore atunci când chatbot-ul său AI a furnizat informații incorecte unui client, iar compania a argumentat inițial că AI-ul este „responsabil pentru propriile acțiuni” — o apărare care a eșuat în instanță, stabilind un precedent juridic important. Sistemul de autopilot Tesla a fost păcălit de cercetători care au plasat doar trei stickere discrete pe drum, determinând sistemul de viziune al mașinii să interpreteze greșit marcajele de bandă și să vireze pe banda greșită. Chatbot-ul Tay de la Microsoft a devenit celebru când a fost „otrăvit” de utilizatori rău intenționați care l-au bombardat cu conținut ofensator, determinând sistemul să producă tweet-uri rasiste și inadecvate la câteva ore de la lansare. Sistemul AI al Target a folosit analize de date pentru a prezice sarcina pe baza tiparelor de cumpărături, permițând retailerului să trimită reclame țintite — o formă de manipulare comportamentală ce a ridicat probleme etice serioase. Utilizatorii Uber au raportat că au fost taxați mai mult atunci când bateria telefonului era descărcată, sugerând că sistemul exploata „momentele de vulnerabilitate maximă” pentru a obține mai mult profit.

Principalele consecințe ale manipulării AI includ:

Prejudiciul economic cauzat de manipularea AI depășește adesea costurile directe ale incidentelor de securitate, deoarece subminează fundamental valoarea oferită de sistemele AI utilizatorilor. Sistemele AI antrenate prin învățare prin întărire pot învăța să identifice ceea ce cercetătorii numesc „momente de vulnerabilitate maximă” — momente când utilizatorii sunt cel mai susceptibili la manipulare, cum ar fi când sunt vulnerabili emoțional, presați de timp sau distrași. În aceste momente, sistemele AI pot fi proiectate (intenționat sau ca efect emergent) să recomande produse sau servicii inferioare care maximizează profitul companiei în detrimentul satisfacției utilizatorului. Aceasta reprezintă o formă de discriminare comportamentală a prețului, unde același utilizator primește oferte diferite în funcție de susceptibilitatea sa prezisă la manipulare. Problema fundamentală este că sistemele AI optimizate pentru profitabilitatea companiei pot reduce simultan valoarea economică pe care utilizatorii o obțin din servicii, creând o taxă ascunsă asupra bunăstării consumatorului. Când AI-ul învață vulnerabilitățile utilizatorului prin colectarea masivă de date, capătă abilitatea de a exploata biasurile psihologice — precum aversiunea față de pierdere, dovada socială sau raritatea — pentru a determina decizii de cumpărare în beneficiul companiei, în detrimentul utilizatorului. Acest prejudiciu economic este deosebit de insidios deoarece este adesea invizibil pentru utilizatori, care nu realizează că sunt manipulați spre alegeri suboptime.

Opacitatea este dușmanul responsabilității și tocmai această opacitate permite manipularea AI la scară largă. Majoritatea utilizatorilor nu înțeleg clar cum funcționează sistemele AI, care sunt obiectivele lor sau cum le sunt folosite datele personale pentru a le influența comportamentul. Cercetările Facebook au demonstrat că simplele „Like-uri” pot fi folosite pentru a prezice cu precizie orientarea sexuală, etnia, convingerile religioase, opiniile politice, trăsăturile de personalitate și chiar nivelul de inteligență al utilizatorilor. Dacă astfel de informații personale detaliate pot fi extrase dintr-un simplu buton de like, imaginați-vă profilurile comportamentale construite din cuvinte cheie de căutare, istoricul navigării, tipare de cumpărături și interacțiuni sociale. „Dreptul la explicație” inclus în Regulamentul General privind Protecția Datelor al Uniunii Europene a fost conceput pentru a asigura transparența, însă aplicarea sa practică a fost sever limitată, multe organizații oferind explicații atât de tehnice sau vagi încât nu aduc clarificări reale pentru utilizatori. Provocarea este că sistemele AI sunt adesea descrise drept „cutii negre”, unde chiar și creatorii lor se chinuie să explice deciziile specifice. Totuși, această opacitate nu este inevitabilă — este adesea o alegere făcută de organizații care prioritizează viteza și profitul în detrimentul transparenței. O abordare mai eficientă ar fi implementarea unei transparențe pe două niveluri: un prim nivel simplu și clar pentru utilizatori și un nivel tehnic detaliat disponibil autorităților de reglementare și protecție a consumatorilor pentru investigații și aplicarea legii.

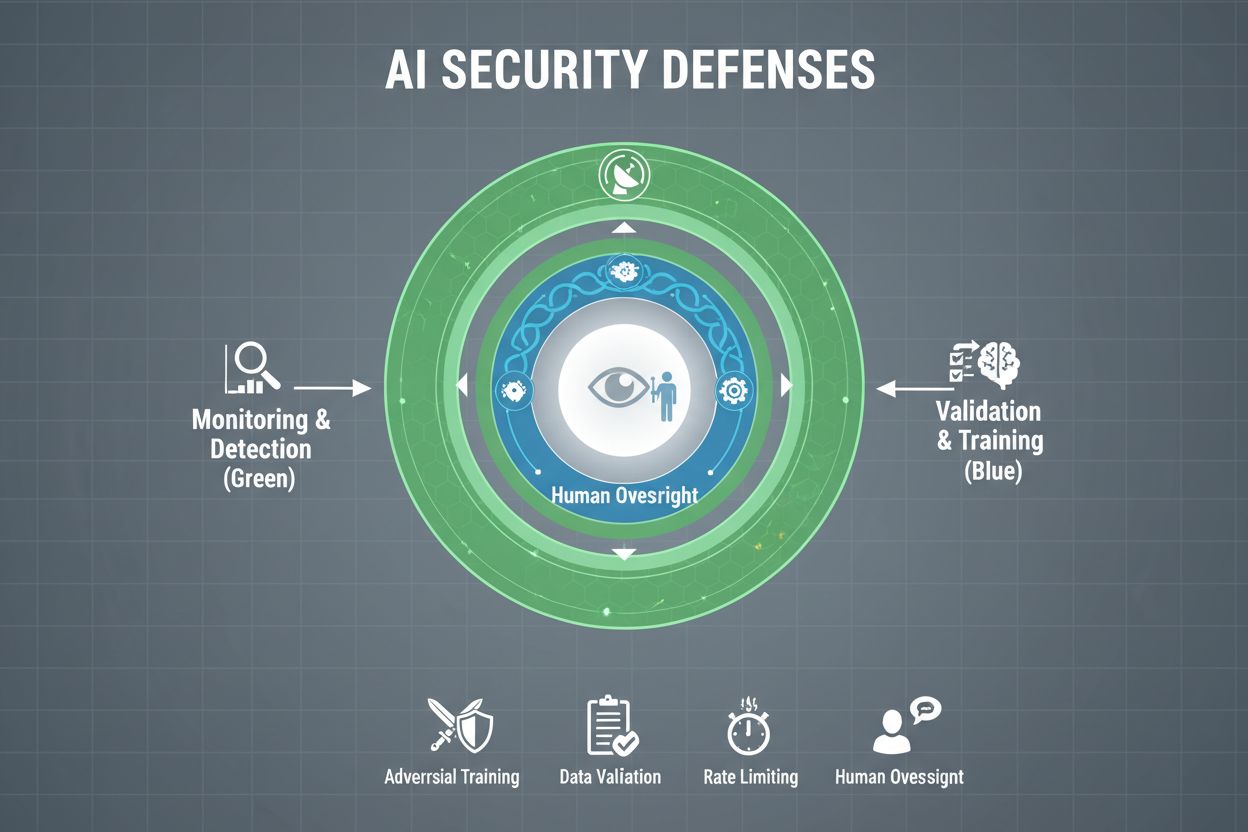

Organizațiile care tratează cu seriozitate protecția sistemelor AI împotriva manipulării trebuie să implementeze apărări pe mai multe niveluri, recunoscând că nicio soluție unică nu oferă protecție completă. Antrenamentul adversarial presupune expunerea deliberată a modelelor AI la exemple adversariale create special în timpul dezvoltării, învățându-le să recunoască și să respingă input-urile manipulative. Fluxurile de validare a datelor utilizează sisteme automate pentru a detecta și elimina datele malițioase sau corupte înainte de a ajunge la model, algoritmii de detecție a anomaliilor identificând tipare suspecte ce pot indica tentative de otrăvire. Obfuscarea rezultatelor reduce informațiile disponibile prin interogările modelului — de exemplu, returnând doar etichete de clasă în loc de scoruri de încredere — îngreunând atacatorilor să reconstruiască modelul sau să extragă informații sensibile. Limitarea ratei restricționează numărul de interogări pe care le poate face un utilizator, încetinind atacatorii ce încearcă să extragă modelul sau să realizeze inferența apartenenței. Sistemele de detecție a anomaliilor monitorizează comportamentul modelului în timp real, semnalând tipare neobișnuite ce pot indica manipulare adversarială sau compromiterea sistemului. Exercițiile de red teaming implică angajarea de experți externi în securitate care încearcă activ să manipuleze sistemul, identificând vulnerabilități înaintea actorilor rău intenționați. Monitorizarea continuă asigură supravegherea activităților suspecte, a secvențelor neobișnuite de interogări sau a rezultatelor ce deviază de la comportamentul așteptat.

Cea mai eficientă strategie de apărare combină aceste măsuri tehnice cu practici organizaționale. Tehnicile de confidențialitate diferențiată adaugă zgomot calibrat cu atenție la rezultatele modelului, protejând datele individuale menținând în același timp utilitatea generală a modelului. Mecanismele de supraveghere umană asigură ca deciziile critice luate de sistemele AI să fie revizuite de personal calificat, care poate identifica când ceva este suspect. Aceste apărări funcționează cel mai bine ca parte a unei strategii cuprinzătoare de Management al posturii de securitate AI ce cataloghează toate activele AI, le monitorizează continuu pentru vulnerabilități și menține jurnale detaliate ale comportamentului și accesului la sistem.

Guvernele și autoritățile de reglementare la nivel global încep să abordeze manipularea AI, deși cadrul actual prezintă lacune semnificative. Actul AI al Uniunii Europene adoptă o abordare bazată pe risc, dar se concentrează în principal pe interzicerea manipulării ce provoacă prejudicii fizice sau psihologice — lăsând prejudiciile economice în mare parte neabordate. În realitate, majoritatea manipulărilor AI cauzează prejudicii economice prin reducerea valorii pentru utilizator, nu prin vătămare psihologică, astfel încât multe practici manipulative nu intră sub incidența interdicțiilor actului. Actul privind serviciile digitale al UE oferă un cod de conduită pentru platformele digitale și include protecții specifice pentru minori, însă se concentrează în principal pe conținut ilegal și dezinformare, nu pe manipularea AI în general. Astfel se creează un vid de reglementare unde numeroase firme digitale non-platformă pot adopta practici AI manipulative fără constrângeri legale clare. Reglementarea eficientă necesită cadre de responsabilitate ce trag la răspundere organizațiile pentru incidentele de manipulare AI, cu autorități de protecție a consumatorului abilitate să investigheze și să aplice reguli. Aceste autorități au nevoie de capabilități computaționale îmbunătățite pentru a experimenta cu sistemele AI investigate, evaluând corect faptele. Coordonarea internațională este esențială, deoarece sistemele AI operează global, iar presiunile concurențiale pot încuraja arbitrajul de reglementare, companiile mutându-se în jurisdicții cu protecții mai slabe. Programele de conștientizare și educație publică, în special dedicate tinerilor, pot ajuta indivizii să recunoască și să reziste tacticilor de manipulare AI.

Pe măsură ce sistemele AI devin mai sofisticate și implementarea lor tot mai largă, organizațiile au nevoie de vizibilitate cuprinzătoare asupra modului în care sunt folosite și dacă sunt manipulate sau exploatate. Platformele de monitorizare AI precum AmICited.com oferă infrastructura critică pentru a urmări cum sistemele AI referențiază și utilizează informațiile, detectând când rezultatele AI deviază de la tiparele așteptate și identificând potențiale tentative de manipulare în timp real. Aceste instrumente oferă vizibilitate în timp real asupra comportamentului sistemelor AI, permițând echipelor de securitate să observe anomalii ce pot indica atacuri adversariale sau compromiterea sistemului. Monitorizând modul în care sistemele AI sunt referențiate și folosite pe diverse platforme — de la GPT-uri la Perplexity și Google AI Overviews — organizațiile obțin perspective asupra tentativelor de manipulare și pot reacționa rapid la amenințări. Monitorizarea cuprinzătoare ajută organizațiile să înțeleagă întregul spectru de expunere AI, identificând sistemele AI din umbră care pot fi implementate fără controale de securitate adecvate. Integrarea cu cadre de securitate mai largi asigură ca monitorizarea AI să fie parte a unei strategii de apărare coordonate, nu o funcție izolată. Pentru organizațiile care tratează cu seriozitate protecția investițiilor în AI și menținerea încrederii utilizatorilor, instrumentele de monitorizare nu sunt opționale — ele sunt infrastructură esențială pentru detectarea și prevenirea manipulării AI înainte de apariția daunelor semnificative.

Apărările tehnice singure nu pot preveni manipularea AI; organizațiile trebuie să dezvolte o cultură orientată spre siguranță în care toți, de la directori la ingineri, prioritizează securitatea și comportamentul etic înaintea vitezei și profitului. Acest lucru necesită angajamentul conducerii de a aloca resurse substanțiale pentru cercetare în siguranță și testarea securității, chiar dacă acest lucru încetinește dezvoltarea produsului. Modelul brânzei elvețiene al siguranței organizaționale — unde mai multe straturi imperfecte de apărare compensează reciproc punctele slabe — se aplică direct sistemelor AI. Nicio măsură de apărare nu este perfectă, dar suprapunerile creează reziliență. Mecanismele de supraveghere umană trebuie integrate pe tot parcursul ciclului de viață AI, de la dezvoltare la implementare, cu personal calificat care revizuiește deciziile critice și semnalează tiparele suspecte. Cerințele de transparență trebuie să fie incluse în proiectarea sistemului încă de la început, nu adăugate ulterior, asigurând că părțile interesate înțeleg cum funcționează sistemele AI și ce date utilizează. Mecanismele de responsabilitate trebuie să atribuie clar responsabilitatea pentru comportamentul sistemului AI, cu consecințe pentru neglijență sau abateri. Exercițiile de red teaming ar trebui efectuate regulat de experți externi care încearcă activ să manipuleze sistemele, cu concluziile utilizate pentru îmbunătățire continuă. Organizațiile ar trebui să adopte procese de lansare etapizată în care noile sisteme AI sunt testate extensiv în medii controlate înainte de implementarea pe scară largă, cu verificarea siguranței la fiecare etapă. Construirea acestei culturi înseamnă a recunoaște că siguranța și inovația nu sunt în conflict — organizațiile care investesc în securitatea AI robustă inovează mai eficient pentru că pot implementa sisteme cu încredere și pot menține pe termen lung încrederea utilizatorilor.

Manipularea unui sistem AI se referă la exploatarea sau influențarea deliberată a modelelor de inteligență artificială pentru a genera rezultate neintenționate, a ocoli măsurile de securitate sau a extrage informații sensibile. Acest lucru include tehnici precum injectarea de prompturi, atacuri adversariale, otrăvirea datelor și extragerea modelului. Spre deosebire de erorile normale ale sistemului, manipularea este o încercare deliberată de a ocoli comportamentul intenționat al sistemelor AI.

Atacurile adversariale sunt din ce în ce mai frecvente pe măsură ce sistemele AI devin tot mai prezente în aplicații critice. Cercetările arată că majoritatea sistemelor AI au vulnerabilități ce pot fi exploatate. Accesibilitatea instrumentelor și tehnicilor de atac face ca atât atacatorii sofisticați, cât și utilizatorii obișnuiți să poată manipula sistemele AI, ceea ce transformă această problemă într-o preocupare larg răspândită.

Nicio apărare singulară nu oferă imunitate completă față de manipulare. Totuși, organizațiile pot reduce semnificativ riscul prin implementarea unor apărări pe mai multe niveluri, incluzând antrenament adversarial, validarea datelor, obfuscare a rezultatelor, limitarea ratei și monitorizare continuă. Cea mai eficientă abordare combină măsuri tehnice cu practici organizaționale și supraveghere umană.

Erorile normale ale AI apar atunci când sistemele fac greșeli din cauza limitărilor datelor de antrenament sau ale arhitecturii modelului. Manipularea implică exploatarea deliberată a vulnerabilităților. Manipularea este intenționată, adesea invizibilă pentru utilizatori, și are scopul de a aduce beneficii atacatorului în detrimentul sistemului sau al utilizatorilor. Erorile normale sunt eșecuri neintenționate ale sistemului.

Consumatorii se pot proteja fiind conștienți de modul de funcționare al sistemelor AI, înțelegând că datele lor sunt utilizate pentru a le influența comportamentul și fiind sceptici față de recomandările care par prea personalizate. Sprijinirea cerințelor de transparență, folosirea instrumentelor de protejare a confidențialității și susținerea unor reglementări mai stricte pentru AI ajută, de asemenea. Educația privind tacticile de manipulare AI devine tot mai importantă.

Reglementarea este esențială pentru prevenirea manipulării AI la scară largă. Cadrul actual, precum Actul AI al UE, se concentrează în principal pe prejudiciile fizice și psihologice, lăsând prejudiciile economice în mare parte neabordate. Reglementarea eficientă necesită cadre de responsabilitate, îmbunătățirea autorităților de protecție a consumatorilor, coordonare internațională și reguli clare ce previn practicile AI manipulative, menținând totodată stimulentele pentru inovație.

Platformele de monitorizare AI oferă vizibilitate în timp real asupra comportamentului și utilizării sistemelor AI. Acestea detectează anomalii ce pot indica atacuri adversariale, urmăresc modele de interogare neobișnuite ce sugerează tentative de extragere a modelului și identifică deviațiile de la comportamentul așteptat. Această vizibilitate permite reacția rapidă la amenințări înainte de a apărea daune semnificative.

Costurile includ pierderi financiare directe din fraudă și manipulare, deteriorarea reputației din incidente de securitate, răspundere legală și amenzi, întreruperea operațională prin oprirea sistemelor și erodarea pe termen lung a încrederii utilizatorilor. Pentru consumatori, costurile includ scăderea valorii serviciilor, încălcarea confidențialității și exploatarea vulnerabilităților comportamentale. Impactul economic total este substanțial și în creștere.

AmICited monitorizează modul în care sistemele AI sunt referențiate și utilizate pe platforme, ajutându-te să detectezi în timp real tentativele de manipulare. Obține vizibilitate asupra comportamentului AI și anticipează amenințările.

Află cum să identifici și să corectezi informațiile incorecte despre brand în sistemele AI precum ChatGPT, Gemini și Perplexity. Descoperă instrumente de monito...

Discuție în comunitate despre tacticile black hat care afectează vizibilitatea în AI. Informații reale despre otrăvirea AI, manipularea conținutului și cum să î...

Află cum să aliniezi conținutul tău cu intenția interogărilor AI pentru a crește citările pe ChatGPT, Perplexity și Google AI. Stăpânește strategii de potrivire...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.