Cum să te asiguri că AI Crawlers văd tot conținutul tău

Află cum să faci conținutul tău vizibil pentru crawlerii AI precum ChatGPT, Perplexity și AI-ul Google. Descoperă cerințe tehnice, bune practici și strategii de...

Află de ce crawlerele AI precum ChatGPT nu pot vedea conținutul redat prin JavaScript și cum îți poți face site-ul vizibil pentru sistemele AI. Descoperă strategii de randare pentru vizibilitate AI.

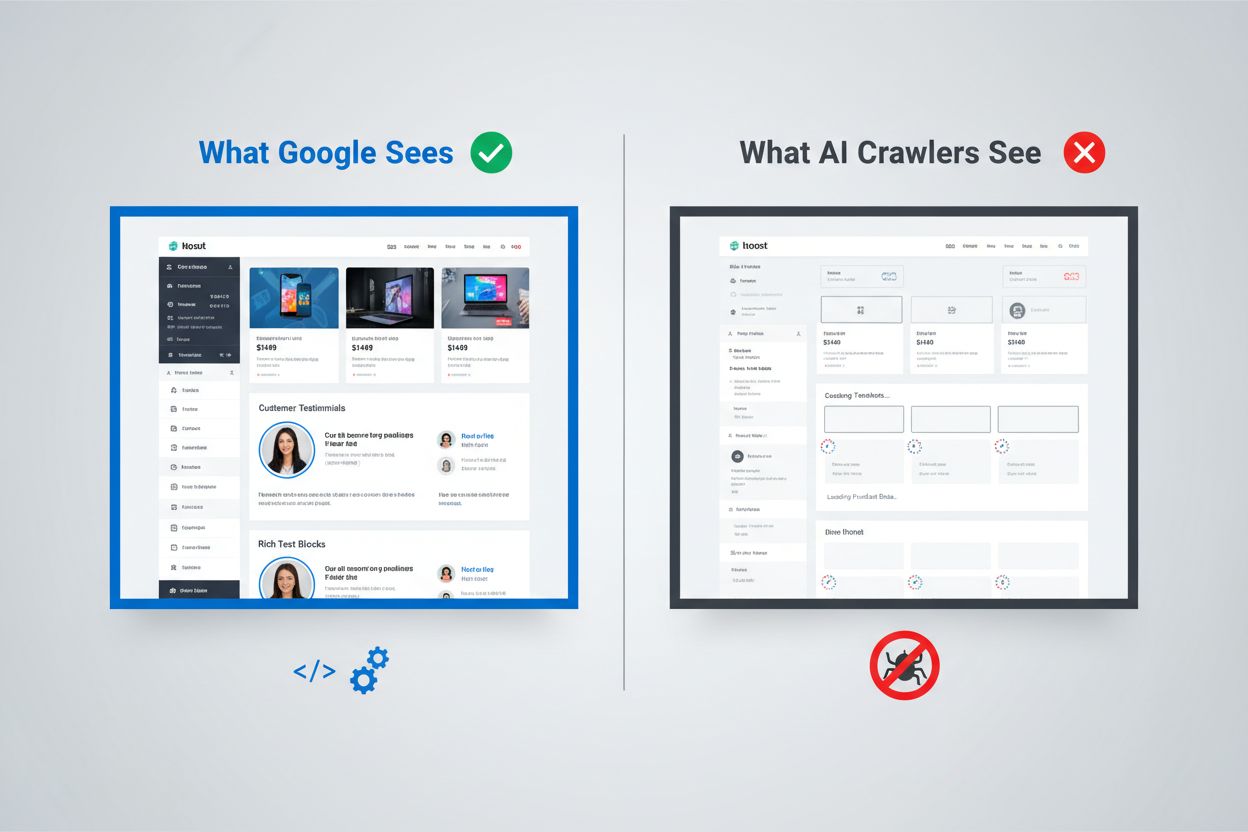

Peisajul digital s-a schimbat fundamental, însă majoritatea organizațiilor nu au ținut pasul. Deși pipeline-ul sofisticat de randare al Google poate executa JavaScript și indexa conținutul generat dinamic, crawlerele AI precum ChatGPT, Perplexity și Claude funcționează în condiții complet diferite. Acest lucru creează o lacună critică de vizibilitate: conținutul care arată perfect pentru utilizatori umani și chiar pentru motorul de căutare Google poate fi complet invizibil pentru sistemele AI care, tot mai mult, generează trafic și influențează deciziile de cumpărare. Înțelegerea acestei distincții nu mai este doar o curiozitate tehnică—devine esențială pentru menținerea vizibilității în întregul ecosistem digital. Miza e mare, iar soluțiile sunt mai nuanțate decât realizează majoritatea organizațiilor.

Abordarea Google pentru randarea JavaScript reprezintă unul dintre cele mai sofisticate sisteme construite vreodată pentru indexarea web. Gigantul căutărilor folosește un sistem de randare în două valuri: paginile sunt mai întâi parcurse pentru conținutul lor HTML static, apoi re-randate ulterior folosind un browser headless Chrome prin Web Rendering Service (WRS). În această a doua etapă, Google execută JavaScript-ul, construiește DOM-ul complet (Document Object Model) și captează starea complet redată a paginii. Acest proces include caching-ul randării, ceea ce înseamnă că Google poate reutiliza versiuni randate anterior ale paginilor pentru a economisi resurse. Întregul sistem este conceput să gestioneze complexitatea aplicațiilor web moderne, păstrând totodată capacitatea de a parcurge miliarde de pagini. Google investește resurse computaționale uriașe în această capacitate, rulând mii de instanțe headless Chrome pentru a procesa conținutul web-ului încărcat cu JavaScript. Pentru organizațiile care se bazează pe Google Search, asta înseamnă că și conținutul generat pe client are o șansă la vizibilitate—dar doar pentru că Google a construit o infrastructură extrem de costisitoare pentru a susține acest lucru.

Crawlerele AI funcționează sub constrângeri economice și arhitecturale fundamental diferite, care fac execuția JavaScript-ului nepractică. Limitările de resurse sunt principala problemă: executarea JavaScript-ului presupune pornirea unor motoare de browser, gestionarea memoriei și menținerea stării între cereri—operațiuni costisitoare la scară largă. Majoritatea crawlerelelor AI operează cu ferestre de timeout de 1-5 secunde, adică trebuie să preia și proceseze conținutul extrem de rapid sau să abandoneze cererea. Analiza cost-beneficiu nu favorizează execuția JavaScript pentru sistemele AI; ele pot prelucra mult mai mult conținut procesând doar HTML static decât redând fiecare pagină întâlnită. În plus, pipeline-ul de procesare pentru datele de antrenament ale modelelor lingvistice mari elimină CSS și JavaScript la ingestie, concentrându-se doar pe conținutul semantic HTML. Filosofia arhitecturală diferă fundamental: Google a integrat redarea în sistemul de indexare pentru că relevanța căutării depinde de înțelegerea conținutului redat, în timp ce sistemele AI prioritizează acoperirea pe scară largă în detrimentul profunzimii randării. Nu este o limitare ușor de depășit—este integrată în economia fundamentală a acestor sisteme.

Când un crawler AI solicită o pagină, primește fișierul HTML brut fără nicio execuție JavaScript, ceea ce înseamnă adesea că vede o versiune dramatic diferită a conținutului față de utilizatorii umani. Single Page Applications (SPA) construite cu React, Vue sau Angular sunt deosebit de problematice, deoarece, de obicei, furnizează un HTML minimal și se bazează complet pe JavaScript pentru a popula conținutul paginii. Un crawler AI care solicită un site ecommerce bazat pe React poate primi un HTML ce conține doar taguri goale <div id="root"></div>, fără nicio informație despre produse, prețuri sau descrieri. Crawlerul vede scheletul paginii, dar nu și conținutul propriu-zis. Pentru site-urile concentrate pe conținut, asta înseamnă că cataloagele de produse, articolele de blog, tabelele de prețuri și secțiunile dinamice nu există în viziunea crawlerului AI. Exemple reale sunt numeroase: un tabel comparativ de funcționalități al unei platforme SaaS poate fi complet invizibil, recomandările de produse ale unui magazin online pot să nu fie indexate, iar articolele încărcate dinamic pe un site de știri pot apărea ca pagini goale. HTML-ul primit de crawlerele AI este adesea doar învelișul aplicației—conținutul real trăiește în bundle-uri JavaScript care nu sunt niciodată executate. Se ajunge la situația în care pagina arată perfect în browser, dar aproape goală pentru sistemele AI.

Impactul de business al acestei lacune de randare merge mult dincolo de aspectele tehnice și afectează direct veniturile, vizibilitatea și poziționarea competitivă. Când crawlerele AI nu pot vedea conținutul tău, mai multe funcții critice de business au de suferit:

Efectul cumulativ este că organizațiile care investesc masiv în conținut și experiență de utilizator pot ajunge invizibile pentru o categorie tot mai importantă de utilizatori și sisteme. Aceasta nu este o problemă care se rezolvă de la sine—necesită acțiune deliberată.

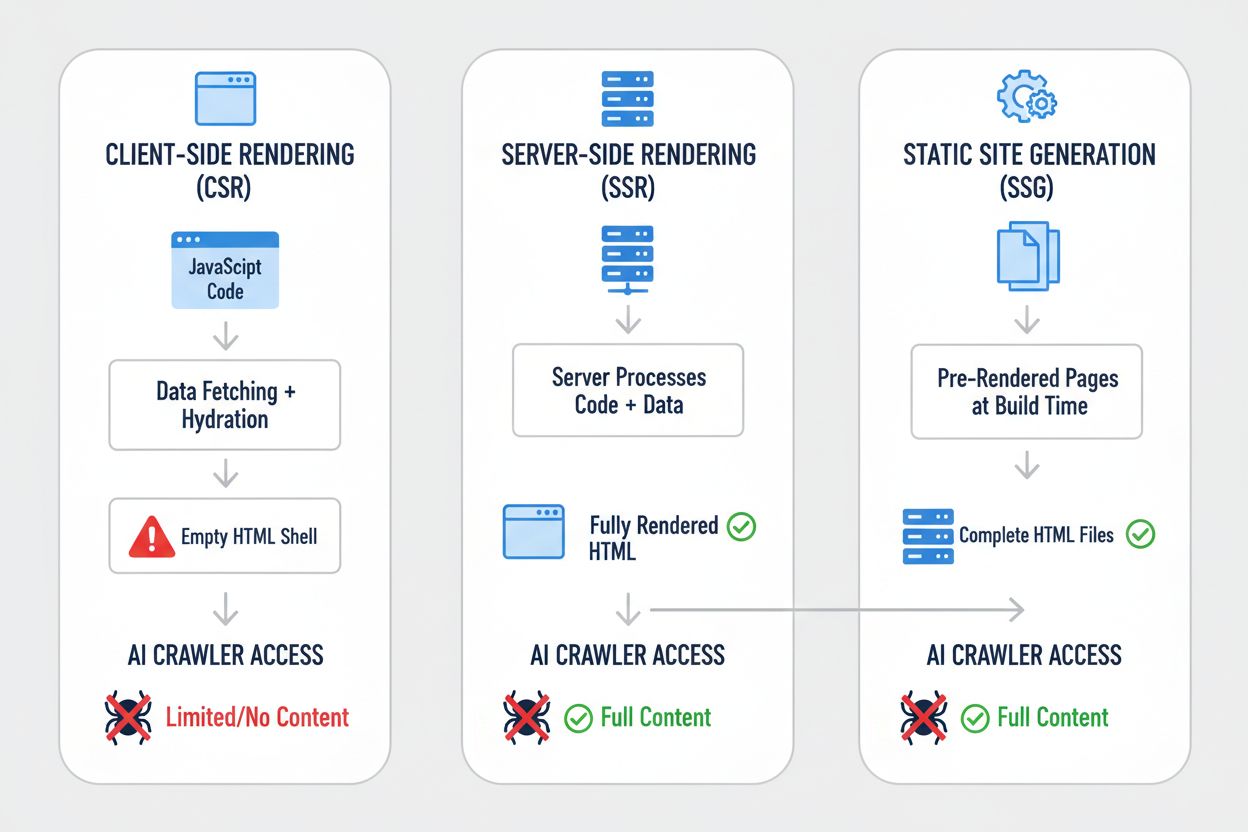

Strategiile diferite de randare produc rezultate dramatic diferite atunci când sunt privite prin prisma vizibilității pentru crawlerele AI. Alegerea metodei de randare determină fundamental ce pot vedea și indexa sistemele AI. Iată cum se compară principalele strategii:

| Strategie | Ce vede AI | Impact asupra vizibilității AI | Complexitate | Recomandat pentru |

|---|---|---|---|---|

| Server-Side Rendering (SSR) | HTML complet cu tot conținutul redat | Vizibilitate totală—AI vede tot | Ridicată | Site-uri cu mult conținut, aplicații critice SEO |

| Static Site Generation (SSG) | Fișiere HTML prerandate | Vizibilitate excelentă—conținut static HTML | Medie | Bloguri, documentație, pagini de marketing |

| Client-Side Rendering (CSR) | Shell HTML gol, conținut minim | Vizibilitate slabă—AI vede doar scheletul | Redusă | Dashboards în timp real, instrumente interactive |

| Hibrid (SSR + CSR) | HTML inițial + îmbunătățiri pe client | Vizibilitate bună—conținut de bază vizibil | Foarte ridicată | Aplicații complexe cu funcții dinamice |

| Serviciu de pre-redare | HTML redat și stocat în cache | Vizibilitate bună—depinde de calitatea serviciului | Medie | Site-uri CSR existente ce au nevoie de corecții rapide |

| API-First + Markup | Date structurate + conținut HTML | Vizibilitate excelentă—dacă este implementat corect | Ridicată | Aplicații web moderne, CMS headless |

Fiecare strategie reprezintă un compromis între complexitatea dezvoltării, performanță, experiență utilizator și vizibilitate AI. Ideea critică este că vizibilitatea pentru sistemele AI corelează puternic cu prezența conținutului în HTML static—indiferent dacă acest HTML este generat la build, la cerere sau servit din cache. Organizațiile trebuie să-și evalueze strategia de randare nu doar pentru UX și performanță, ci explicit și pentru vizibilitatea către crawlerele AI.

Server-Side Rendering (SSR) reprezintă standardul de aur pentru vizibilitatea AI deoarece livrează HTML complet, redat, tuturor solicitanților—browsere umane și crawlere AI deopotrivă. Cu SSR, serverul execută codul aplicației și generează răspunsul HTML complet înainte de a-l trimite clientului, astfel încât crawlerele AI primesc pagina completă încă de la prima solicitare. Framework-uri moderne precum Next.js, Nuxt.js și SvelteKit au făcut SSR mult mai practic decât în trecut, gestionând transparent complexitatea hidratării (momentul în care JavaScript-ul din browser preia controlul de la HTML-ul redat pe server). Beneficiile depășesc vizibilitatea AI: SSR îmbunătățește de obicei Core Web Vitals, reduce Time to First Contentful Paint și oferă performanță mai bună utilizatorilor cu conexiuni lente. Compromisul constă în încărcarea crescută pe server și complexitatea gestionării stării între server și client. Pentru organizațiile unde vizibilitatea AI este critică—în special site-urile cu mult conținut, platformele ecommerce și aplicațiile SaaS—SSR este adesea cea mai defensabilă alegere. Investiția în infrastructura SSR aduce beneficii multiple: vizibilitate mai bună în motoarele de căutare, vizibilitate AI crescută, experiență de utilizator îmbunătățită și metrici de performanță superioare.

Static Site Generation (SSG) abordează problema diferit, prerandând paginile la build și generând fișiere HTML statice care pot fi servite instant oricărui solicitant. Unelte precum Hugo, Gatsby și Astro au făcut SSG tot mai puternic și flexibil, permițând conținut dinamic prin API-uri și re-generare statică incrementală. Când un crawler AI solicită o pagină generată cu SSG, primește HTML complet, static, cu tot conținutul redat—vizibilitate perfectă. Beneficiile de performanță sunt excepționale: fișierele statice se servesc mai rapid decât orice redare dinamică, iar cerințele de infrastructură sunt minime. Limita este că SSG funcționează cel mai bine pentru conținut care nu se schimbă frecvent; paginile trebuie reconstruite și redeployate la fiecare actualizare. Pentru bloguri, site-uri de documentație, pagini de marketing și aplicații concentrate pe conținut, SSG este deseori alegerea ideală. Combinația dintre vizibilitate AI excelentă, performanță superioară și cerințe minime de infrastructură face SSG atractiv pentru multe scenarii. Totuși, pentru aplicații ce necesită personalizare în timp real sau conținut în schimbare rapidă, SSG devine mai puțin practic fără complexitate suplimentară precum re-generarea statică incrementală.

Client-Side Rendering (CSR) rămâne popular în ciuda dezavantajelor majore pentru vizibilitatea AI, în principal datorită experienței excelente pentru dezvoltatori și flexibilității UX pentru aplicații interactive. Cu CSR, serverul trimite HTML minimal și se bazează pe JavaScript pentru a construi pagina în browser—ceea ce înseamnă că crawlerele AI nu văd aproape nimic. Aplicațiile React, Vue și Angular sunt de obicei CSR implicit, și multe organizații și-au construit întreaga tehnologie pe acest model. Atractivitatea e clară: CSR permite experiențe bogate, interactive, actualizări în timp real și navigare fluidă pe client. Problema este că această flexibilitate vine cu prețul vizibilității AI. Pentru aplicațiile care chiar necesită CSR—dashboards în timp real, instrumente colaborative, aplicații interactive complexe—există soluții alternative. Serviciile de pre-redare precum Prerender.io pot genera snapshot-uri HTML statice ale paginilor CSR și le pot servi crawlerelor, în timp ce utilizatorilor li se servește varianta interactivă. Alternativ, organizațiile pot implementa abordări hibride, unde conținutul critic este redat pe server, iar funcțiile interactive rămân pe client. Ideea cheie este că CSR trebuie să fie o alegere conștientă, cu asumarea completă a compromisurilor de vizibilitate, nu o presupunere implicită.

Implementarea unor soluții practice necesită o abordare sistematică ce începe cu înțelegerea stării curente și continuă cu implementarea și monitorizarea continuă. Începe cu un audit: folosește instrumente precum Screaming Frog, Semrush sau scripturi personalizate pentru a parcurge site-ul așa cum ar face-o un crawler AI, examinând ce conținut este vizibil în HTML-ul brut. Implementează îmbunătățiri de randare pe baza auditului—asta poate însemna migrarea la SSR, adoptarea SSG pentru anumite secțiuni sau implementarea pre-redării pentru paginile critice. Testează temeinic comparând ce vede un crawler AI versus ce vede un browser; folosește comenzi curl pentru a extrage HTML-ul brut și compară-l cu versiunea redată. Monitorizează continuu pentru a te asigura că schimbările de randare nu afectează vizibilitatea în timp. Pentru organizațiile cu site-uri mari și complexe, prioritatea ar trebui să fie paginile cu valoare mare—pagini de produs, pagini de prețuri, secțiuni cheie de conținut—apoi întregul site. Unelte precum Lighthouse, PageSpeed Insights și soluții de monitorizare personalizate te pot ajuta să urmărești performanța randării și metricile de vizibilitate. Investiția în această direcție aduce beneficii în vizibilitatea în căutare, vizibilitatea AI și performanța generală a site-ului.

Testarea și monitorizarea strategiei de randare necesită tehnici specifice care să arate ce văd efectiv crawlerele AI. Cel mai simplu test este folosirea curl pentru extragerea HTML-ului brut fără execuție JavaScript:

curl -s https://example.com | grep -i "product\|price\|description"

Asta îți arată exact ce primește un crawler AI—dacă informațiile critice nu apar în rezultat, nu vor fi vizibile nici pentru sistemele AI. Testarea în browser, folosind Chrome DevTools, îți arată diferența dintre HTML-ul inițial și DOM-ul complet redat; deschide DevTools, mergi la tabul Network și analizează răspunsul HTML inițial versus starea finală redată. Pentru monitorizare continuă, implementează monitorizare sintetică care să preia regulat paginile ca un crawler AI și să te alerteze dacă vizibilitatea conținutului scade. Urmărește metrici precum “procentajul conținutului vizibil în HTML-ul inițial” și “timpul până la vizibilitatea conținutului” pentru a înțelege performanța randării. Unele organizații implementează dashboard-uri personalizate de monitorizare care compară vizibilitatea AI asupra concurenților, oferind informații despre cine optimizează pentru AI și cine nu. Cheia este ca această monitorizare să fie continuă și acționabilă—problemele de vizibilitate trebuie identificate și remediate rapid, nu descoperite după luni de scădere a traficului.

Viitorul capacităților crawlerelelor AI rămâne incert, însă limitările actuale nu se vor schimba dramatic pe termen scurt. OpenAI a experimentat cu crawlere mai sofisticate precum Comet și browserele Atlas care pot executa JavaScript, dar acestea rămân experimentale și nu sunt utilizate la scară pentru colectarea de date de antrenament. Economia fundamentală nu s-a schimbat: execuția JavaScript la scară rămâne costisitoare, iar pipeline-ul pentru date de antrenament beneficiază mai mult de acoperire largă decât de profunzime. Chiar dacă crawlerele AI vor executa JavaScript în viitor, optimizarea făcută acum nu va dăuna—conținutul redat pe server funcționează mai bine pentru utilizatori, se încarcă mai rapid și oferă SEO mai bun oricum. Abordarea prudentă este să optimizezi pentru vizibilitatea AI acum, nu să aștepți ca crawlerele să evolueze. Asta înseamnă să tratezi vizibilitatea AI ca pe o preocupare de bază în strategia de randare, nu ca pe o problemă secundară. Organizațiile care fac această schimbare acum vor avea un avantaj competitiv pe măsură ce AI-ul devine tot mai important pentru trafic și vizibilitate.

Monitorizarea vizibilității AI și urmărirea îmbunătățirilor în timp necesită instrumentele și metricile potrivite. AmICited.com oferă o soluție practică pentru a vedea cum apare conținutul tău în răspunsurile generate de AI și pentru a-ți monitoriza vizibilitatea în diferite sisteme AI. Urmărind ce pagini sunt citate, citate sau referențiate în conținutul generat de AI, poți înțelege impactul real al optimizărilor de randare. Platforma te ajută să identifici ce conținut este vizibil pentru sistemele AI și ce conținut rămâne invizibil, oferind date concrete despre eficacitatea strategiei tale de randare. Pe măsură ce implementezi SSR, SSG sau soluții de pre-redare, AmICited.com îți permite să măsori îmbunătățirea reală a vizibilității AI—observând dacă eforturile tale de optimizare se traduc în mai multe citări și referințe. Acest feedback este esențial pentru a justifica investiția în îmbunătățirile de randare și a identifica ce pagini necesită optimizare suplimentară. Combinând monitorizarea tehnică a ceea ce văd crawlerele AI cu metricile de business privind cât de des apare conținutul tău în răspunsurile AI, obții o imagine completă a performanței vizibilității AI.

Nu, ChatGPT și majoritatea crawlerelelor AI nu pot executa JavaScript. Ele văd doar HTML-ul brut din încărcarea inițială a paginii. Orice conținut injectat prin JavaScript după încărcarea paginii rămâne complet invizibil pentru sistemele AI, spre deosebire de Google care folosește browsere headless Chrome pentru a reda JavaScript.

Google utilizează browsere headless Chrome pentru a reda JavaScript, similar cu modul în care funcționează un browser real. Acest lucru necesită multe resurse, dar Google are infrastructura necesară pentru a face asta la scară largă. Sistemul de randare în două valuri al Google mai întâi indexează HTML-ul static, apoi re-randează paginile cu execuția JavaScript pentru a capta DOM-ul complet.

Dezactivează JavaScript în browser și încarcă site-ul sau folosește comanda curl pentru a vedea HTML-ul brut. Dacă lipsește conținut important, nici crawlerele AI nu-l vor vedea. Poți folosi și instrumente precum Screaming Frog în modul 'Text Only' pentru a-ți parcurge site-ul așa cum ar face-o un crawler AI.

Nu. Poți folosi și generarea statică de site-uri (SSG), servicii de pre-redare sau abordări hibride. Cea mai bună soluție depinde de tipul de conținut și frecvența actualizărilor. SSR e potrivit pentru conținut dinamic, SSG pentru conținut stabil, iar serviciile de pre-redare pentru site-uri CSR existente.

Google poate procesa JavaScript, deci pozițiile tale în Google nu ar trebui să fie afectate direct. Totuși, optimizarea pentru crawlerele AI îmbunătățește adesea calitatea generală a site-ului, performanța și experiența utilizatorului, ceea ce poate aduce beneficii indirecte pozițiilor Google.

Depinde de frecvența de crawling a platformei AI. ChatGPT-User crawl-ează la cerere când utilizatorii solicită conținut, în timp ce GPTBot face crawling rar, cu intervale mari de revizitare. Schimbările pot dura săptămâni până să apară în răspunsurile AI, dar poți monitoriza progresul cu instrumente precum AmICited.com.

Serviciile de pre-redare sunt mai ușor de implementat și întreținut cu modificări minime de cod, în timp ce SSR oferă mai mult control și performanțe mai bune pentru conținut dinamic. Alege în funcție de resursele tehnice, frecvența actualizărilor de conținut și complexitatea aplicației tale.

Da, poți folosi robots.txt pentru a bloca crawlerele AI specifice, precum GPTBot. Totuși, asta înseamnă că al tău conținut nu va apărea în răspunsuri generate de AI, ceea ce poate reduce vizibilitatea și traficul din instrumente de căutare și asistenți bazați pe AI.

Urmărește cum sistemele AI fac referire la brandul tău pe ChatGPT, Perplexity și Google AI Overviews. Identifică lacunele de vizibilitate și măsoară impactul optimizărilor de randare.

Află cum să faci conținutul tău vizibil pentru crawlerii AI precum ChatGPT, Perplexity și AI-ul Google. Descoperă cerințe tehnice, bune practici și strategii de...

Află cum să testezi dacă crawler-ele AI precum ChatGPT, Claude și Perplexity pot accesa conținutul site-ului tău web. Descoperă metode de testare, instrumente ș...

Află cum să faci un audit al accesului crawlerelor AI la site-ul tău. Descoperă ce boturi îți pot vedea conținutul și rezolvă blocajele care împiedică vizibilit...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.