Redarea JavaScript pentru AI

Află cum redarea JavaScript influențează vizibilitatea în AI. Descoperă de ce crawler-ele AI nu pot executa JavaScript, ce conținut rămâne ascuns și cum soluții...

Aflați cum prerendering-ul face conținutul JavaScript vizibil crawlerelor AI precum ChatGPT, Claude și Perplexity. Descoperiți cele mai bune soluții tehnice pentru optimizarea căutărilor AI și îmbunătățiți-vă vizibilitatea în rezultatele căutărilor alimentate de AI.

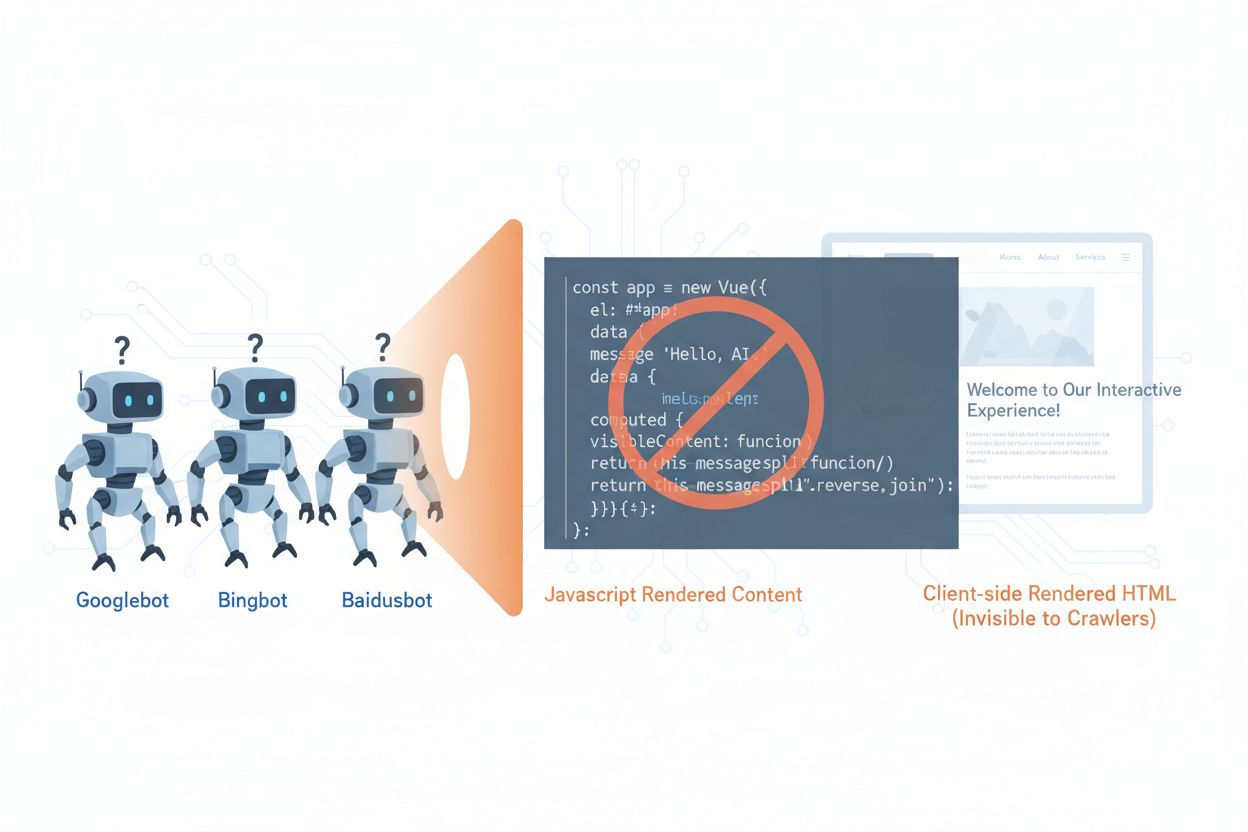

Crawlerele AI precum GPTBot, ClaudeBot și PerplexityBot au schimbat fundamental modul în care conținutul este descoperit și indexat pe web, dar se confruntă cu o limitare critică: nu pot executa JavaScript. Aceasta înseamnă că orice conținut redat dinamic prin JavaScript—care alimentează aplicațiile moderne single-page (SPA), paginile dinamice de produse și dashboard-urile interactive—rămâne complet invizibil pentru aceste crawlere. Potrivit datelor recente, crawlerele AI reprezintă acum aproximativ 28% din traficul Googlebot, ceea ce le face o parte semnificativă din bugetul de crawling al site-ului dvs. și un factor crucial în accesibilitatea conținutului. Când un crawler AI solicită o pagină, primește doar structura inițială HTML fără conținutul redat, văzând practic o versiune goală sau incompletă a site-ului dvs. Acest lucru creează un paradox: conținutul dvs. este perfect vizibil pentru utilizatorii umani cu browsere care permit JavaScript, dar invizibil pentru sistemele AI care influențează din ce în ce mai mult descoperirea, sumarizarea și clasificarea conținutului în motoarele de căutare și aplicațiile alimentate de AI.

Motivele tehnice pentru limitările crawlerelelor AI cu JavaScript derivă din diferențe arhitecturale fundamentale între modul în care browserele și crawlerele procesează conținutul web. Browserele au un motor JavaScript complet care execută codul, manipulează DOM-ul (Document Object Model) și redă rezultatul vizual final, în timp ce crawlerele AI operează, de obicei, cu capabilități minime sau inexistente de execuție JavaScript din motive de resurse și securitate. Încărcarea asincronă—în care conținutul este adus din API-uri după încărcarea inițială a paginii—reprezintă o altă provocare majoră, deoarece crawlerele primesc doar HTML-ul inițial înainte ca restul conținutului să fie disponibil. Aplicațiile single-page (SPA) agravează această problemă, bazându-se exclusiv pe rutare și randare pe partea de client, lăsând crawlerele cu nimic altceva decât un pachet JavaScript. Iată cum se compară diferitele metode de randare în ceea ce privește vizibilitatea pentru crawlerele AI:

| Metoda de redare | Cum funcționează | Vizibilitate pentru crawlerele AI | Performanță | Cost |

|---|---|---|---|---|

| CSR (Client-Side Rendering) | Browserul execută JavaScript pentru a reda conținutul | ❌ Slabă | Rapid pentru utilizatori | Infrastructură redusă |

| SSR (Server-Side Rendering) | Serverul redă HTML la fiecare solicitare | ✅ Excelentă | Încărcare inițială mai lentă | Infrastructură costisitoare |

| SSG (Static Site Generation) | Conținut pre-generat la build | ✅ Excelentă | Cea mai rapidă | Mediu (timp de build) |

| Prerendering | HTML static cache-uit la cerere | ✅ Excelentă | Rapid | Mediu (echilibrat) |

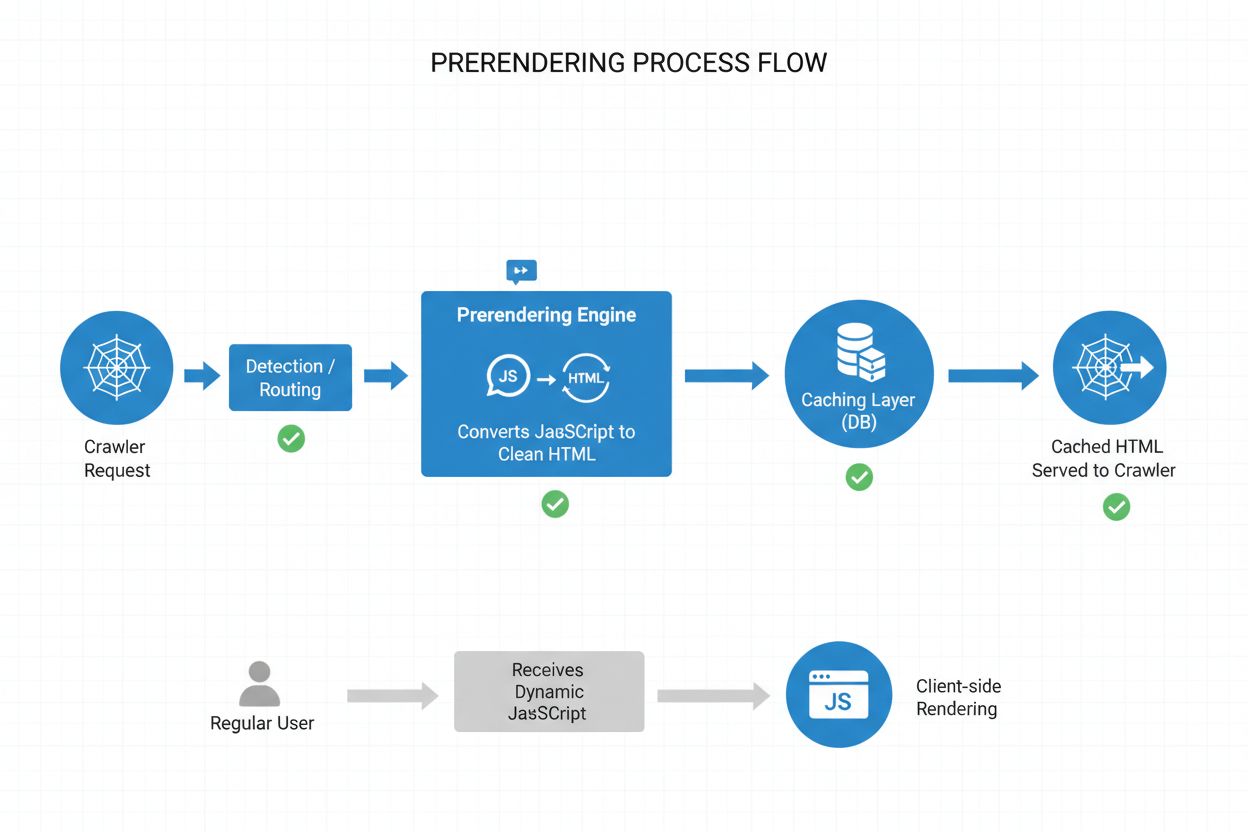

Prerendering-ul oferă o cale de mijloc elegantă între cerințele consumatoare de resurse ale server-side rendering-ului și limitările generate la build ale static site generation-ului. În loc să redea conținutul la fiecare solicitare (SSR) sau la build (SSG), prerendering-ul generează instantanee HTML statice la cerere atunci când un crawler sau bot solicită o pagină, apoi cache-uiește acea versiune redată pentru solicitările ulterioare. Această abordare înseamnă că crawlerele AI primesc HTML complet redat, conținând tot conținutul care ar fi generat de JavaScript, în timp ce utilizatorii obișnuiți primesc în continuare versiunea dinamică și interactivă a site-ului dvs., fără niciun impact asupra experienței lor. Prerendering-ul este deosebit de rentabil deoarece redă doar paginile solicitate efectiv de crawlere, evitând supraîncărcarea de a pre-renda întregul site sau de a menține infrastructură costisitoare de SSR. Povara de mentenanță este minimă—codul aplicației dvs. rămâne neschimbat, iar stratul de prerendering funcționează transparent în fundal, făcându-l o soluție ideală pentru echipele care doresc accesibilitate pentru crawlerele AI fără restructurări arhitecturale.

Procesul de prerendering funcționează printr-un workflow sofisticat, dar simplu, care asigură că crawlerele AI primesc conținut optimizat, în timp ce utilizatorii nu sunt afectați în niciun fel. Când o solicitare ajunge la serverul dvs., sistemul detectează mai întâi user agent-ul pentru a identifica dacă este vorba de un crawler AI (GPTBot, ClaudeBot, PerplexityBot) sau de un browser obișnuit. Dacă este detectat un crawler AI, solicitarea este redirecționată către motorul de prerendering, care lansează o instanță de browser headless, execută tot JavaScript-ul, așteaptă încărcarea conținutului asincron și generează o instantanee HTML completă a paginii redate. Acest HTML este apoi cache-uit (de obicei pentru 24-48 de ore) și servit direct crawlerului, ocolind complet aplicația dumneavoastră și reducând încărcarea serverului. Între timp, solicitările browserelor obișnuite trec direct la aplicația interactivă, asigurându-se că utilizatorii au experiența completă, cu actualizări în timp real și funcționalitate dinamică. Întregul proces este transparent—crawlerele văd conținut redat complet, utilizatorii văd aplicația neschimbată, iar infrastructura dvs. rămâne eficientă deoarece prerendering-ul se activează doar pentru traficul de tip bot.

Deși atât prerendering-ul, cât și server-side rendering (SSR) rezolvă problema vizibilității JavaScript-ului, ele diferă semnificativ în implementare, cost și scalabilitate. SSR redă conținutul la fiecare solicitare, ceea ce înseamnă că serverul trebuie să inițializeze un runtime JavaScript, să execute întregul cod al aplicației și să genereze HTML pentru fiecare vizitator—un proces costisitor la scară mare, care poate crește Time to First Byte (TTFB) pentru toți utilizatorii. Prerendering-ul, în schimb, cache-uiește paginile redate și le regenerează doar atunci când conținutul se schimbă sau cache-ul expiră, reducând dramatic încărcarea serverului și îmbunătățind timpii de răspuns atât pentru crawlere, cât și pentru utilizatori. SSR este potrivit pentru conținut foarte personalizat sau date care se schimbă frecvent și unde fiecare utilizator are nevoie de HTML unic, în timp ce prerendering-ul excelează pentru conținut relativ static sau cu schimbări rare—pagini de produse, articole de blog, documentație, conținut de marketing. Multe implementări sofisticate folosesc o abordare hibridă: prerendering pentru crawlere AI și conținut static, SSR pentru experiențe personalizate, și rendering pe partea de client pentru funcții interactive. Această strategie stratificată oferă tot ce e mai bun—accesibilitate excelentă pentru crawlerele AI, performanță rapidă pentru utilizatori și costuri rezonabile de infrastructură.

Datele structurate în format JSON-LD sunt esențiale pentru a ajuta crawlerele AI să înțeleagă semnificația și contextul conținutului dvs., însă majoritatea implementărilor nu țin cont de limitările crawlerelor AI. Când datele structurate sunt injectate în pagină prin JavaScript—o practică obișnuită cu Google Tag Manager și alte sisteme de gestionare a tag-urilor—crawlerele AI nu le văd niciodată, deoarece nu execută JavaScript-ul care creează aceste structuri de date. Aceasta înseamnă că rich snippets, informațiile despre produse, detaliile despre organizație și alte marcaje semantice rămân invizibile pentru sistemele AI, deși sunt perfect vizibile pentru motoarele de căutare tradiționale care au evoluat să gestioneze JavaScript. Soluția este simplă: asigurați-vă că toate datele structurate critice sunt prezente în HTML-ul redat pe server, nu injectate prin JavaScript. Acest lucru poate însemna mutarea blocurilor JSON-LD din tag manager în șablonul server-side al aplicației sau utilizarea prerendering-ului pentru a capta datele structurate injectate de JavaScript și a le servi ca HTML static către crawlere. Crawlerele AI se bazează puternic pe date structurate pentru a extrage fapte, relații și informații despre entități, ceea ce face implementarea server-side a datelor structurate esențială pentru motoarele de căutare AI și integrarea în knowledge graph.

Implementarea prerendering-ului necesită o abordare strategică ce echilibrează acoperirea, costul și mentenanța. Urmați acești pași pentru a începe:

Identificați paginile încărcate cu JavaScript: Auditați site-ul pentru a găsi paginile unde conținutul esențial este redat prin JavaScript—de obicei SPA-uri, pagini dinamice de produse, dashboard-uri interactive. Folosiți instrumente precum Lighthouse sau inspecție manuală pentru a identifica paginile unde HTML-ul inițial diferă semnificativ de versiunea redată.

Alegeți un serviciu de prerendering: Selectați un furnizor de prerendering precum Prerender.io, care se ocupă de rendering-ul cu browser headless, cache și detecție de crawlere. Evaluați în funcție de preț, durata de cache, fiabilitatea API-ului și suportul pentru tehnologia dvs.

Configurați detecția user agent-ului: Configurați serverul sau CDN-ul pentru a detecta user agent-urile crawlerelor AI (GPTBot, ClaudeBot, PerplexityBot, Bingbot, Googlebot) și a le redirecționa către serviciul de prerendering, permițând browserelor obișnuite să acceseze site-ul normal.

Testați și validați: Folosiți instrumente precum curl cu user agent customizat pentru a verifica dacă crawlerele primesc HTML complet redat. Testați cu user agent-uri reale de crawlere AI pentru a vă asigura că conținutul și datele structurate sunt vizibile.

Monitorizați rezultatele: Configurați logare și analiză pentru a urmări eficiența prerendering-ului, ratele de accesare a cache-ului și eventualele erori de rendering. Monitorizați panoul de control al serviciului de prerendering pentru metrici de performanță și erori.

Monitorizarea eficientă este esențială pentru a vă asigura că implementarea prerendering-ului funcționează corect și că crawlerele AI pot accesa conținutul dvs. Analiza jurnalelor este principalul instrument—analizați jurnalele serverului pentru a identifica solicitările de la user agent-uri de crawlere AI, urmăriți ce pagini accesează și identificați eventuale pattern-uri de crawling sau erori. Majoritatea serviciilor de prerendering precum Prerender.io oferă panouri ce arată ratele de accesare a cache-ului, metrici de succes/eșec la redare și statistici de performanță, oferindu-vă vizibilitate asupra eficienței servirii conținutului prerenderizat. Principalele metrici de urmărit sunt rata de accesare a cache-ului (procentajul de solicitări servite din cache), rata de succes la redare (procentul de pagini redate fără erori), timpul mediu de redare și volumul traficului crawlerelor. Configurați alerte pentru erori de redare sau pattern-uri neobișnuite de crawling care pot indica probleme cu JavaScript-ul sau conținutul dinamic al site-ului. Corelând metricile prerendering-ului cu traficul motoarelor AI și vizibilitatea conținutului dvs., puteți cuantifica impactul implementării și identifica oportunități de optimizare.

Un prerendering de succes necesită atenție la detalii și mentenanță continuă. Evitați aceste greșeli frecvente:

Nu prerenderizați paginile 404: Configurați serviciul de prerendering să sară peste paginile care returnează codul de stare 404, deoarece cache-uirea paginilor de eroare irosește resurse și derutează crawlerele cu privire la structura site-ului.

Asigurați prospețimea conținutului: Setați timpi de expirare a cache-ului adecvați în funcție de frecvența actualizării conținutului. Paginile cu trafic mare și actualizări frecvente pot necesita ferestre de cache de 12-24 de ore, iar conținutul static poate avea durate mai lungi.

Monitorizați continuu: Nu implementați prerendering-ul și apoi să-l ignorați. Verificați periodic că paginile sunt randate corect, datele structurate sunt prezente și crawlerele primesc conținutul așteptat.

Evitați cloaking-ul: Nu serviți niciodată conținut diferit crawlerelor față de utilizatori—acest lucru încalcă politicile motoarelor de căutare și subminează încrederea. Prerendering-ul trebuie să arate crawlerelor același conținut ca utilizatorilor, doar în formă statică.

Testați cu crawlere reale: Folosiți user agent-uri reale de crawlere AI în testare, nu doar identificatori generici de bot. Diferite crawlere pot avea cerințe sau limitări diferite de redare.

Mențineți conținutul actualizat: Dacă conținutul prerenderizat devine învechit, crawlerele vor indexa informații depășite. Implementați strategii de invalidare a cache-ului care să actualizeze paginile prerenderizate când conținutul se schimbă.

Importanța optimizării pentru crawlerele AI va crește pe măsură ce aceste sisteme devin centrale pentru descoperirea conținutului și extragerea cunoștințelor. Deși crawlerele AI actuale au capabilități limitate de executare JavaScript, tehnologii emergente precum Comet și Atlas browsers sugerează că viitoarele crawlere ar putea avea abilități de randare mai sofisticate, însă prerendering-ul va rămâne valoros pentru performanță și fiabilitate. Implementând prerendering-ul acum, nu rezolvați doar problema actuală a crawlerelor AI—ci asigurați viitorul conținutului dvs. împotriva schimbărilor în capabilitățile crawlerelor și vă asigurați că site-ul rămâne accesibil indiferent de evoluția sistemelor AI. Convergența dintre SEO tradițional și optimizarea pentru crawlerele AI înseamnă că, pentru a rămâne în față, este necesară o abordare cuprinzătoare: optimizați atât pentru utilizatorii umani, cât și pentru sistemele AI, asigurați-vă că aveți conținut accesibil în mai multe formate și păstrați flexibilitatea pentru a vă adapta pe măsură ce peisajul se schimbă. Prerendering-ul reprezintă o soluție pragmatică și scalabilă care face legătura între aplicațiile moderne bogate în JavaScript și cerințele de accesibilitate ale sistemelor de căutare și descoperire alimentate de AI, fiind o componentă esențială a oricărei strategii SEO și de conținut orientată spre viitor.

Prerendering-ul generează instantanee HTML statice la cerere și le cachează, în timp ce server-side rendering-ul (SSR) redă conținutul la fiecare solicitare. Prerendering-ul este mai rentabil și mai scalabil pentru majoritatea cazurilor de utilizare, în timp ce SSR este mai potrivit pentru conținut foarte personalizat sau care se schimbă frecvent și necesită HTML unic pentru fiecare utilizator.

Nu, prerendering-ul afectează doar modul în care crawlerele văd conținutul dumneavoastră. Utilizatorii obișnuiți vor primi în continuare aplicația dvs. JavaScript dinamică și interactivă exact ca înainte. Prerendering-ul funcționează transparent în fundal și nu are niciun impact asupra funcționalității sau performanței vizibile de către utilizatori.

Timpul de expirare al cache-ului depinde de cât de des se schimbă conținutul dumneavoastră. Paginile cu trafic ridicat și actualizări frecvente pot necesita ferestre de cache de 12-24 de ore, în timp ce conținutul static poate avea durate mai lungi. Majoritatea serviciilor de prerendering vă permit să configurați timpul de cache pe pagină sau șablon.

Da, prerendering-ul funcționează bine cu conținutul dinamic. Puteți seta timpi de expirare a cache-ului mai scurți pentru paginile care se schimbă frecvent sau puteți implementa strategii de invalidare a cache-ului care actualizează paginile prerenderizate la modificarea conținutului. Astfel, crawlerele văd mereu un conținut relativ proaspăt.

Principalele crawlere AI pentru care ar trebui să optimizați sunt GPTBot (ChatGPT), ClaudeBot (Claude) și PerplexityBot (Perplexity). De asemenea, continuați optimizarea pentru crawlerele tradiționale precum Googlebot și Bingbot. Majoritatea serviciilor de prerendering oferă configurare pentru toate crawlerele AI și de căutare importante.

Dacă utilizați deja SSR, accesibilitatea pentru crawlerele AI este bună. Totuși, prerendering-ul poate aduce beneficii suplimentare prin reducerea încărcării serverului, îmbunătățirea performanței și oferirea unui nivel de cache care face infrastructura mai eficientă și scalabilă.

Monitorizați panoul de control al serviciului de prerendering pentru ratele de accesare a cache-ului, metricile de succes ale redării și statisticile de performanță. Verificați jurnalele serverului pentru solicitări de la crawlerele AI și asigurați-vă că acestea primesc HTML complet redat. Urmăriți modificările în vizibilitatea conținutului dvs. în căutările AI și în citările primite în timp.

Costurile pentru prerendering variază în funcție de serviciu și de volumul de utilizare. Majoritatea furnizorilor oferă prețuri pe niveluri, în funcție de numărul de pagini redate lunar. De obicei, costurile sunt mult mai mici decât menținerea unei infrastructuri de server-side rendering, ceea ce face ca prerendering-ul să fie o soluție rentabilă pentru majoritatea site-urilor.

Urmăriți modul în care platformele AI precum ChatGPT, Claude și Perplexity vă menționează conținutul cu AmICited. Obțineți informații în timp real despre vizibilitatea în căutările AI și optimizați-vă strategia de conținut.

Află cum redarea JavaScript influențează vizibilitatea în AI. Descoperă de ce crawler-ele AI nu pot executa JavaScript, ce conținut rămâne ascuns și cum soluții...

Află cum să faci conținutul tău vizibil pentru crawlerii AI precum ChatGPT, Perplexity și AI-ul Google. Descoperă cerințe tehnice, bune practici și strategii de...

Descoperă cum strategiile de randare SSR și CSR afectează vizibilitatea pentru crawlerele AI, mențiunile brandului în ChatGPT și Perplexity și prezența ta gener...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.