Card de Referință AI Crawler: Toți Boții dintr-o Privire

Ghid complet de referință pentru crawlerele și boții AI. Identifică GPTBot, ClaudeBot, Google-Extended și peste 20 de alte crawlere AI cu user agent, rate de cr...

Învață cum să optimizezi sitemap-urile XML pentru crawlerele AI precum GPTBot și ClaudeBot. Stăpânește cele mai bune practici pentru sitemap-uri pentru a-ți crește vizibilitatea în răspunsurile generate de AI și indexarea LLM.

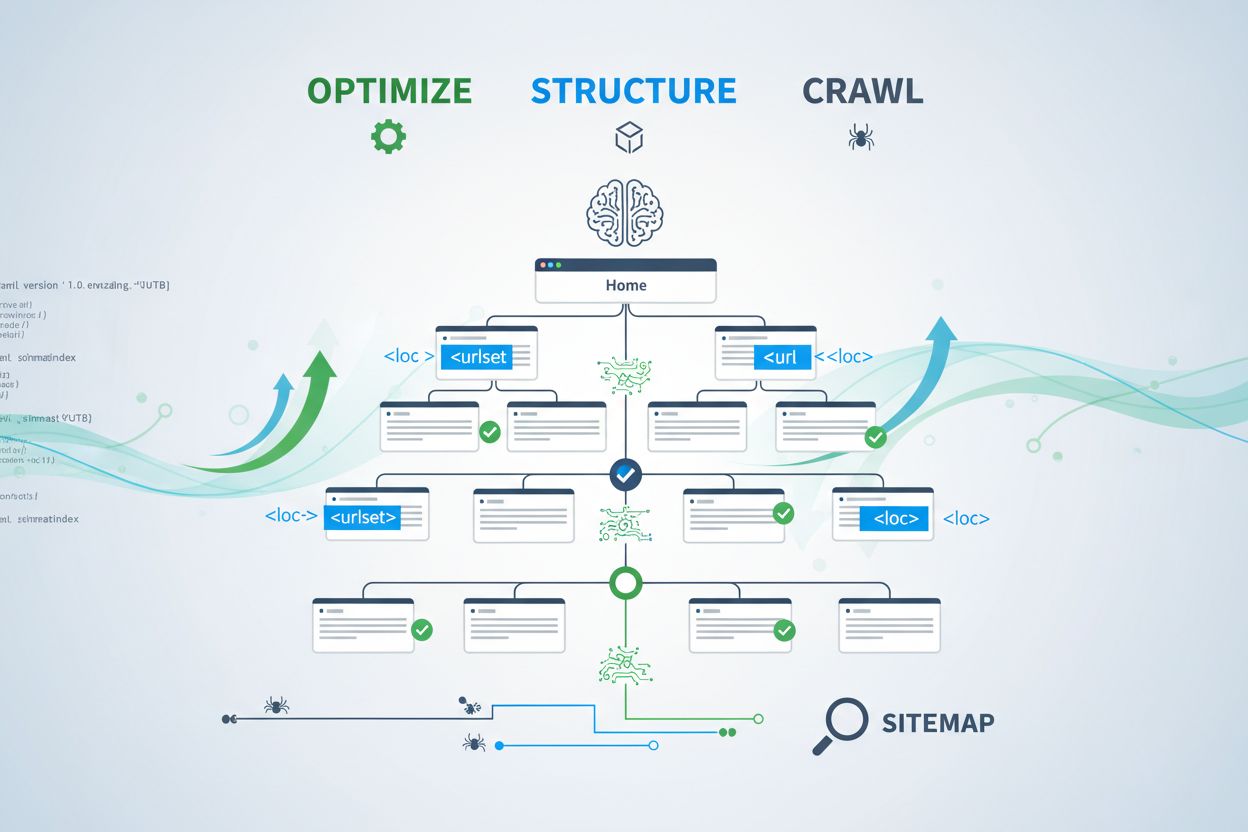

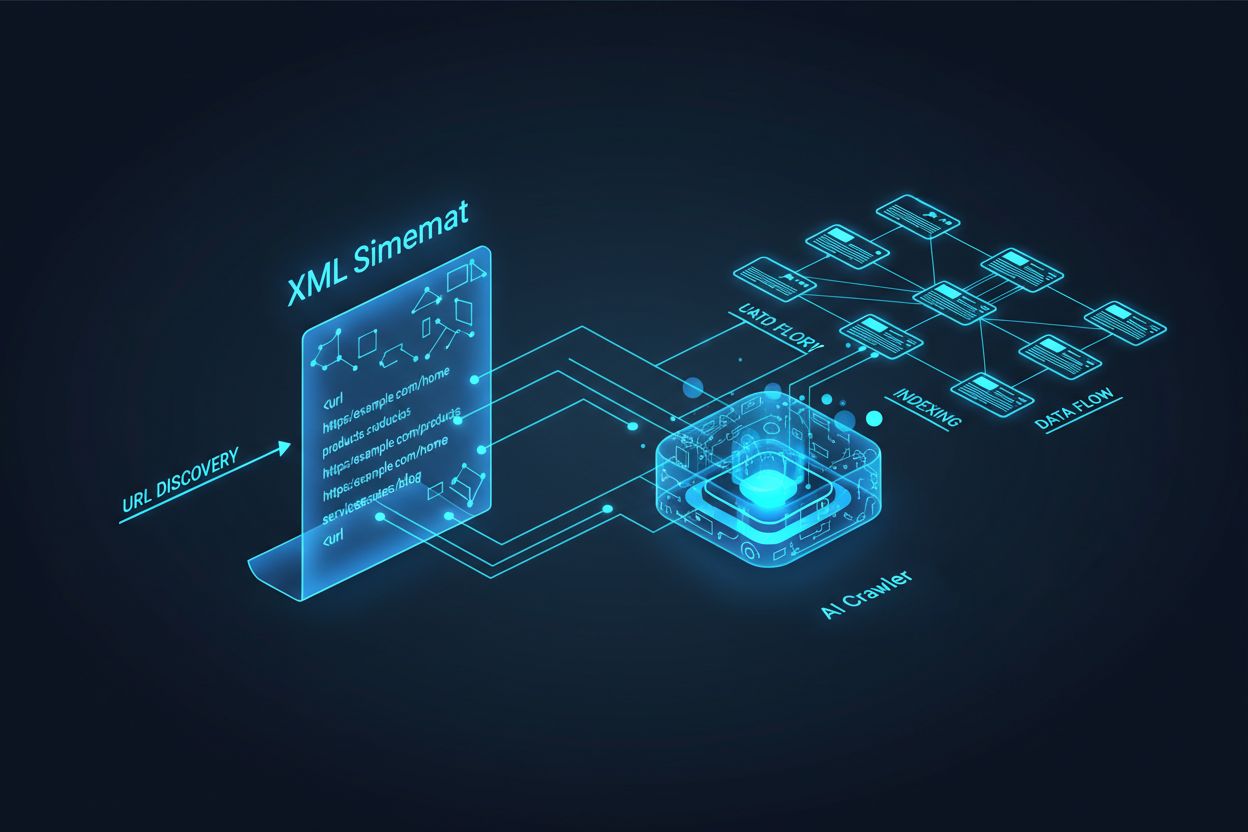

Crawlerele AI precum GPTBot, ClaudeBot și PerplexityBot funcționează fundamental diferit față de boții tradiționali ai motoarelor de căutare. În timp ce Googlebot indexează pagini pentru clasarea în rezultate de căutare, crawlerele AI extrag cunoștințe pentru a antrena și informa modelele lingvistice mari care stau la baza căutării conversaționale și a răspunsurilor generate de AI. Fără un sitemap XML optimizat corespunzător, conținutul tău rămâne invizibil pentru aceste sisteme critice, indiferent cât de bine scris sau autorizat ar fi. Gândește-te la sitemap-ul tău ca la o hartă care le spune sistemelor AI exact unde se află cel mai valoros conținut al tău și cum este organizat.

Distincția dintre crawlerele tradiționale de căutare și crawlerele AI este esențială pentru a înțelege de ce optimizarea sitemap-ului contează mai mult ca niciodată. Motoarele de căutare tradiționale precum Google se concentrează pe clasarea paginilor individuale pentru anumite cuvinte cheie, în timp ce crawlerele AI prioritizează captarea cunoștințelor și înțelegerea semantică. Iată cum diferă:

| Aspect | Crawlere tradiționale (Googlebot) | Crawlere AI (GPTBot, ClaudeBot) |

|---|---|---|

| Scop principal | Clasare pagini în rezultate de căutare | Extrage cunoștințe pentru antrenarea LLM și răspunsuri în timp real |

| Focalizare | Metadate, linkuri interne, semnale de clasare | Structură de conținut, semnificație semantică, densitate factuală |

| Prioritate crawlare | Pe baza PageRank și prospețime | Pe baza autorității, relevanței tematice și valorii informaționale |

| Impact citare | Generează trafic prin linkuri albastre | Determină dacă apari în răspunsuri generate de AI |

| Manipulare JavaScript | Execută și randază JavaScript | Adesea sare peste JavaScript; prioritizează HTML server-rendered |

Această diferență fundamentală înseamnă că optimizarea doar pentru SEO-ul tradițional nu mai este suficientă. Sitemap-ul tău trebuie acum să servească dublu scop: să ajute motoarele de căutare tradiționale să înțeleagă structura site-ului, dar și să ghideze sistemele AI către cele mai valoroase resurse de cunoaștere.

Un sitemap XML funcționează ca o schiță a site-ului tău, spunând explicit crawlerelor ce pagini există și cum se leagă acestea cu strategia ta de conținut. Pentru sistemele AI, sitemap-urile au un rol și mai critic decât pentru căutarea tradițională. Crawlerele AI folosesc sitemap-urile pentru a înțelege arhitectura tematică a site-ului, a identifica conținutul cu prioritate ridicată și a decide ce pagini merită o analiză mai profundă. Când sitemap-ul tău este cuprinzător și bine organizat, sistemele AI pot descoperi și evalua mai eficient conținutul tău pentru includere în răspunsuri generative. În schimb, un sitemap incomplet sau învechit creează zone oarbe care împiedică sistemele AI să descopere cele mai importante pagini ale tale. Impactul este direct: paginile care nu apar în sitemap-ul tău au șanse semnificativ mai mici să fie citate de sistemele AI, indiferent de calitatea sau relevanța lor.

Crearea unui sitemap eficient pentru crawlerele AI necesită mai mult decât simpla listare a fiecărui URL de pe site. Sitemap-ul ar trebui să fie strategic curatat pentru a include doar paginile care oferă valoare reală atât utilizatorilor, cât și sistemelor AI. Iată cele mai importante bune practici:

Un sitemap bine structurat acționează ca un filtru de calitate, transmițând sistemelor AI că ai curatat atent conținutul și că fiecare URL inclus merită atenție. Această abordare strategică îți crește semnificativ șansele de a fi selectat pentru citare în răspunsurile generate de AI.

Recența este unul dintre cei mai puternici factori de clasare în sistemele de căutare pe bază de AI. Când crawlerele AI evaluează ce surse să citeze în răspunsurile generate, ele acordă o pondere mare prospețimii conținutului. Timestamp-ul lastmod din sitemap-ul XML este principalul semnal care le spune sistemelor AI când a fost actualizat ultima dată conținutul tău. Timestamps-urile învechite sau lipsă pot face ca și conținutul autoritativ să fie dezavantajat în fața unor surse mai recente. Dacă sitemap-ul arată că o pagină nu a fost actualizată de ani, sistemele AI pot presupune că informația este depășită și pot alege conținutul concurenților. În schimb, timestamp-urile lastmod corecte care reflectă actualizări reale semnalează crawlerelor AI că informația ta este actuală și de încredere. Pentru subiecte sensibile la timp precum prețuri, reglementări sau tendințe din industrie, menținerea unor timestamp-uri corecte devine și mai critică. Actualizările automate de timestamp prin intermediul CMS-ului asigură că orice modificare de conținut este reflectată imediat în sitemap, maximizând vizibilitatea în răspunsurile generate de AI.

În timp ce sitemap-urile invită crawlerele să indexeze conținutul, fișierele robots.txt controlează ce părți din site pot fi accesate de crawlere. Aceste două fișiere trebuie să funcționeze în armonie pentru a-ți maximiza vizibilitatea AI. O greșeală frecventă este crearea unui sitemap cuprinzător, dar blocarea crawlerelor AI în robots.txt, ceea ce creează o contradicție care derutează crawlerele și reduce vizibilitatea. Robots.txt ar trebui să permită explicit crawlerele AI importante precum GPTBot, ClaudeBot și PerplexityBot să-ți acceseze conținutul. Poți folosi robots.txt strategic pentru a bloca doar paginile care nu ar trebui indexate, precum panourile de administrare, paginile de login sau versiunile duplicate de conținut. Esențial este ca regulile din robots.txt să fie aliniate cu strategia sitemap-ului—dacă o pagină este în sitemap, ea trebuie să fie accesibilă conform regulilor din robots.txt. Auditările regulate ale ambelor fișiere ajută la identificarea configurațiilor greșite care ar putea limita în tăcere vizibilitatea AI.

Cele mai eficiente strategii de optimizare AI tratează sitemap-urile și datele structurate ca sisteme complementare care se consolidează reciproc. Când sitemap-ul scoate în evidență o pagină ca fiind importantă și acea pagină include markup schema relevant, transmiți semnale coerente crawlerelor AI despre scopul și valoarea paginii. De exemplu, dacă sitemap-ul prioritizează un ghid how-to, acea pagină ar trebui să includă schema HowTo care oferă informații structurate despre pași. Similar, paginile de produs din sitemap ar trebui să includă schema Product cu prețuri, disponibilitate și recenzii. Această aliniere creează o imagine de date coerentă pe care sistemele AI o pot interpreta și în care pot avea încredere. Când sitemap-ul și datele structurate sunt în conflict sau divergente, crawlerele AI devin nesigure cu privire la scopul real al paginii, reducând șansa de citare. Asigurându-te că strategia sitemap-ului este aliniată cu implementarea schema, creezi un semnal unificat care îți crește dramatic șansele de a fi selectat pentru includere în răspunsuri generate de AI.

Tipuri diferite de conținut necesită strategii diferite de sitemap pentru maximizarea vizibilității AI. Postările de blog, paginile de produs, descrierile de servicii și conținutul FAQ au scopuri diferite și trebuie optimizate corespunzător:

| Tip de conținut | Strategie sitemap | Schema recomandată | Considerații de prioritate |

|---|---|---|---|

| Postări de blog & articole | Include cu date corecte de publicare și actualizare | Article, NewsArticle, BlogPosting | Prioritizează conținutul recent, evergreen; actualizează lastmod regulat |

| Pagini de produs | Include cu actualizări de stoc; ia în calcul un sitemap separat pentru produse | Product, Offer, AggregateRating | Evidențiază bestsellerele și produsele noi; actualizează prețurile frecvent |

| Pagini de servicii | Include cu date de actualizare a serviciilor | Service, LocalBusiness, ProfessionalService | Prioritizează serviciile principale; actualizează disponibilitatea și prețurile |

| Pagini FAQ | Include cu date de actualizare a conținutului | FAQPage, Question, Answer | Prioritizează FAQ-urile cuprinzătoare; actualizează răspunsurile când se schimbă informațiile |

| Conținut video | Include în sitemap video cu thumbnail și durată | VideoObject, Video | Include transcrieri; actualizează numărul de vizualizări și metricii de engagement |

| Conținut imagine | Include în sitemap imagine cu descrieri | ImageObject, Product (pentru imagini de produs) | Optimizează textul alt; include descrieri relevante |

Această abordare diferențiată asigură că fiecare tip de conținut primește optimizarea potrivită pentru descoperirea AI. Adaptând strategia sitemap la mixul tău de conținut, maximizezi șansele ca sistemele AI să găsească și să citeze cele mai valoroase resurse ale tale.

Standardul llms.txt, propus la sfârșitul lui 2024, reprezintă o abordare experimentală pentru a ajuta sistemele AI să înțeleagă structura site-ului. Spre deosebire de sitemap-urile XML, llms.txt este un fișier bazat pe Markdown care oferă un cuprins citibil de oameni pentru site-ul tău. Listează cele mai importante pagini și resurse într-un format mai ușor de interpretat pentru modelele lingvistice. Deși conceptul este promițător, dovezile actuale sugerează că llms.txt are impact minim asupra vizibilității AI comparativ cu sitemap-urile XML tradiționale. Crawlerele AI principale precum GPTBot și ClaudeBot continuă să se bazeze în principal pe sitemap-urile XML pentru descoperirea URL-urilor și semnale de recență. În loc să înlocuiască sitemap-ul XML, llms.txt ar trebui privit ca un instrument suplimentar care poate oferi context suplimentar sistemelor AI. Dacă implementezi llms.txt, asigură-te că acesta completează, nu înlocuiește strategia principală de sitemap și concentrează-te mai întâi pe perfecționarea sitemap-ului XML cu timestamp-uri exacte și curatare strategică a conținutului.

Chiar și site-urile bine intenționate fac adesea erori critice de sitemap care le limitează în tăcere vizibilitatea AI. Înțelegerea și evitarea acestor greșeli este esențială pentru a-ți maximiza prezența în răspunsurile generate de AI:

Remedierea acestor greșeli comune îți poate îmbunătăți imediat vizibilitatea AI. Începe prin a audita sitemap-ul curent folosind această listă de verificare și rezolvă orice probleme identificate.

Menținerea unui sitemap optimizat necesită monitorizare și validare continuă. Există mai multe instrumente care te pot ajuta să te asiguri că sitemap-ul tău rămâne eficient pentru crawlerele AI. Google Search Console oferă validare sitemap încorporată și îți arată câte URL-uri a indexat Google din sitemap. Screaming Frog SEO Spider îți permite să-ți scanezi întregul site și să compari rezultatele cu sitemap-ul pentru a identifica URL-uri lipsă sau stricate. Validatoarele de sitemap XML verifică sintaxa și conformitatea cu protocolul sitemap XML. Pentru companiile mari, platforme SEO dedicate precum Semrush și Ahrefs includ funcții de analiză sitemap care urmăresc modificările în timp. Auditările regulate—ideal lunar—te ajută să identifici probleme înainte să afecteze vizibilitatea AI. Setează-ți remindere în calendar pentru a revizui sitemap-ul de fiecare dată când faci schimbări majore de conținut, lansezi secțiuni noi sau actualizezi arhitectura site-ului.

Pentru a înțelege cum interacționează crawlerele AI cu sitemap-ul tău, este nevoie de monitorizare și analiză activă. Logurile serverului conțin date valoroase despre ce crawlere AI îți vizitează site-ul, cât de des îl scanează și ce pagini prioritizează. Analizând aceste loguri, poți identifica tipare și îți poți optimiza sitemap-ul în consecință. Instrumente precum AmICited.com te ajută să monitorizezi cât de des este citat conținutul tău de sisteme AI precum ChatGPT, Claude, Perplexity și Google AI Overviews, oferindu-ți feedback direct despre eficiența sitemap-ului tău. Google Analytics poate fi configurat pentru a urmări traficul de referință din partea sistemelor AI, arătându-ți ce pagini generează cea mai multă vizibilitate AI. Corelând aceste date cu structura sitemap-ului, poți identifica ce tipuri de conținut și subiecte rezonează cel mai mult cu sistemele AI. Această abordare bazată pe date îți permite să îți rafinezi continuu strategia sitemap, prioritizând conținutul care generează cele mai multe citări și vizibilitate AI.

Dincolo de optimizarea de bază a sitemap-ului, strategiile avansate îți pot îmbunătăți semnificativ vizibilitatea AI. Crearea de sitemap-uri separate pentru tipuri diferite de conținut—precum sitemap-uri dedicate pentru blog, produse sau video—îți permite să aplici strategii de optimizare specifice fiecărui tip. Generarea dinamică de sitemap, unde sitemap-ul se actualizează în timp real pe măsură ce se schimbă conținutul, asigură că crawlerele AI văd mereu cele mai recente informații. Pentru site-urile enterprise cu mii de pagini, implementarea ierarhiilor de sitemap și a prioritizării strategice ajută crawlerele AI să se concentreze pe conținutul cu cea mai mare valoare. Unele organizații creează sitemap-uri dedicate AI care evidențiază doar cel mai valoros și demn de citare conținut, semnalând sistemelor AI ce pagini merită atenție prioritară. Integrarea strategiei de sitemap cu sistemul de gestionare a conținutului asigură că optimizarea are loc automat și nu necesită actualizări manuale. Aceste abordări avansate necesită mai multă sofisticare tehnică, dar pot aduce îmbunătățiri semnificative în vizibilitatea AI pentru organizațiile cu ecosisteme complexe de conținut.

Peisajul crawlerelor AI evoluează rapid, cu crawlere noi care apar regulat și standarde precum llms.txt care câștigă adopție. Pentru a-ți asigura strategia de sitemap pe viitor, construiește flexibilitate în sisteme și rămâi informat cu privire la evoluțiile din industrie. Implementează sisteme de generare sitemap care pot acomoda ușor cerințe noi ale crawlerelor fără reconfigurări manuale. Monitorizează anunțurile companiilor AI importante privind crawlere noi și actualizează-ți strategiile robots.txt și sitemap în consecință. Ia în considerare valoarea pe termen lung a vizibilității AI versus controlul asupra conținutului—deși unele organizații aleg să blocheze crawlerele AI, tendința sugerează că citările AI vor deveni tot mai importante pentru vizibilitatea brandului. Dezvoltă politici clare despre cum va gestiona organizația ta accesul crawlerelor AI și folosirea conținutului. Privind sitemap-ul ca pe un document viu care evoluează odată cu peisajul AI, te asiguri că informația ta rămâne descoperibilă și citabilă pe măsură ce mecanismele de căutare și descoperire continuă să se transforme.

Ar trebui să-ți actualizezi sitemap-ul ori de câte ori publici conținut nou sau faci modificări semnificative la paginile existente. Ideal ar fi să implementezi generarea automată a sitemap-ului, astfel încât actualizările să aibă loc imediat. Pentru site-urile cu modificări frecvente de conținut, sunt recomandate actualizări zilnice. Pentru site-urile statice, sunt suficiente revizii lunare.

Majoritatea crawlerelor AI importante, precum GPTBot și ClaudeBot, respectă directivele din robots.txt, dar nu toate o fac. Cea mai bună practică este să permiți explicit crawlerele AI în fișierul robots.txt, și să nu te bazezi doar pe comportamentul implicit. Monitorizează logurile serverului pentru a verifica dacă crawlerele se comportă conform așteptărilor.

Sitemap-urile XML sunt fișiere citibile de mașină care listează toate URL-urile cu metadate precum timestamp-urile lastmod. llms.txt este un standard mai nou bazat pe Markdown, conceput pentru a oferi sistemelor AI un cuprins citibil de oameni. În prezent, sitemap-urile XML sunt mai importante pentru vizibilitatea AI, iar llms.txt ar trebui privit ca suplimentar.

Verifică logurile serverului pentru user agent-uri precum 'GPTBot', 'ClaudeBot', 'PerplexityBot' și 'Google-Extended'. Poți folosi și instrumente precum AmICited.com pentru a monitoriza cât de des conținutul tău este citat de sistemele AI, ceea ce indică o accesare și indexare cu succes.

Da, crearea de sitemap-uri separate pentru bloguri, produse, video-uri și imagini îți permite să aplici strategii de optimizare specifice fiecărui tip. Acest lucru ajută și crawlerele AI să înțeleagă mai clar structura conținutului, putând îmbunătăți eficiența crawlării pentru site-urile mari.

Sitemap-urile XML nu ar trebui să conțină mai mult de 50.000 de URL-uri per fișier. Pentru site-urile mari, folosește indexuri de sitemap pentru a organiza mai multe fișiere sitemap. Crawlerele AI pot gestiona sitemap-uri mari, dar împărțirea lor în secțiuni logice îmbunătățește eficiența crawlării și facilitează gestionarea.

Timestamp-urile lastmod semnalează prospețimea conținutului către crawlerele AI. Recența este un factor de clasare puternic în sistemele AI, așa că timestamp-urile corecte ajută conținutul tău să concureze pentru citări. Folosește întotdeauna sisteme automate pentru a actualiza timestamp-urile doar când conținutul chiar se modifică—nu seta niciodată manual timestamp-uri false.

Da, un sitemap întreținut prost poate afecta semnificativ vizibilitatea AI. Linkurile stricate, URL-urile învechite, timestamp-urile incorecte și acoperirea incompletă îți reduc șansele de a fi citat de sistemele AI. Auditările și întreținerea regulată sunt esențiale pentru protejarea vizibilității AI.

Urmărește cât de des este citat conținutul tău de ChatGPT, Claude, Perplexity și Google AI Overviews. Optimizează-ți strategia sitemap pe baza datelor reale de citare AI.

Ghid complet de referință pentru crawlerele și boții AI. Identifică GPTBot, ClaudeBot, Google-Extended și peste 20 de alte crawlere AI cu user agent, rate de cr...

Află ce crawlere AI să permiți sau să blochezi în robots.txt. Ghid cuprinzător despre GPTBot, ClaudeBot, PerplexityBot și peste 25 de crawlere AI, cu exemple de...

Află cum să structurezi site-ul tău pentru indexare optimă de către crawlerele AI, inclusiv HTML semantic, arhitectura site-ului, organizarea conținutului și ce...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.