Card de Referință AI Crawler: Toți Boții dintr-o Privire

Ghid complet de referință pentru crawlerele și boții AI. Identifică GPTBot, ClaudeBot, Google-Extended și peste 20 de alte crawlere AI cu user agent, rate de cr...

Descoperă cum strategiile de randare SSR și CSR afectează vizibilitatea pentru crawlerele AI, mențiunile brandului în ChatGPT și Perplexity și prezența ta generală în căutarea AI.

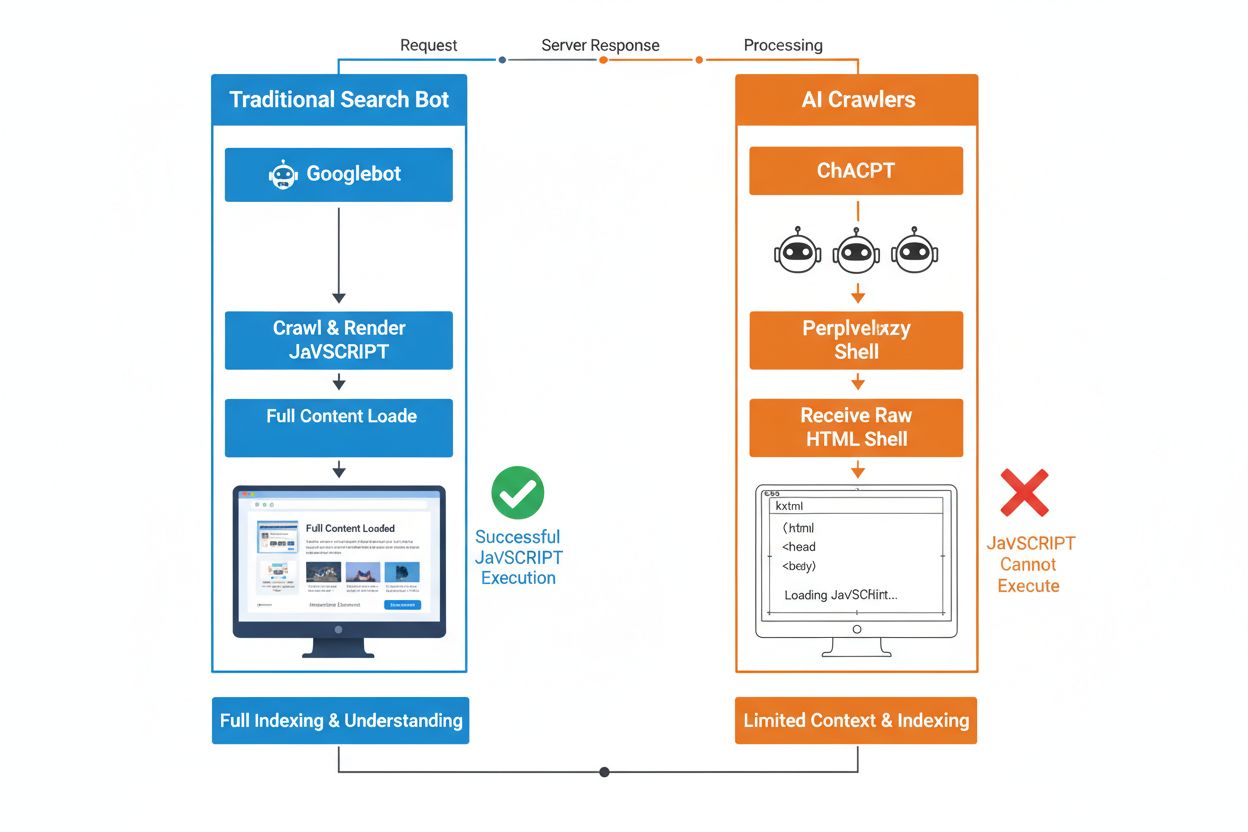

Diferența fundamentală dintre roboții de căutare tradiționali și crawlerele AI constă în modul în care abordează execuția JavaScript. În timp ce Googlebot și alte motoare de căutare tradiționale pot randa JavaScript (deși cu anumite limitări de resurse), crawlerele AI precum GPTBot, ChatGPT-User și OAI-SearchBot nu execută deloc JavaScript—ele văd doar HTML-ul brut livrat la încărcarea inițială a paginii. Această distincție critică înseamnă că dacă conținutul site-ului tău depinde de JavaScript rulat pe client pentru a se afișa, sistemele AI vor primi o versiune incompletă sau goală a paginilor, lipsindu-le detaliile produselor, informațiile despre prețuri, recenziile și alte conținuturi dinamice pe care utilizatorii le văd în browser. Înțelegerea acestei diferențe este esențială, deoarece rezultatele căutării bazate pe AI devin rapid un canal principal de descoperire pentru utilizatori.

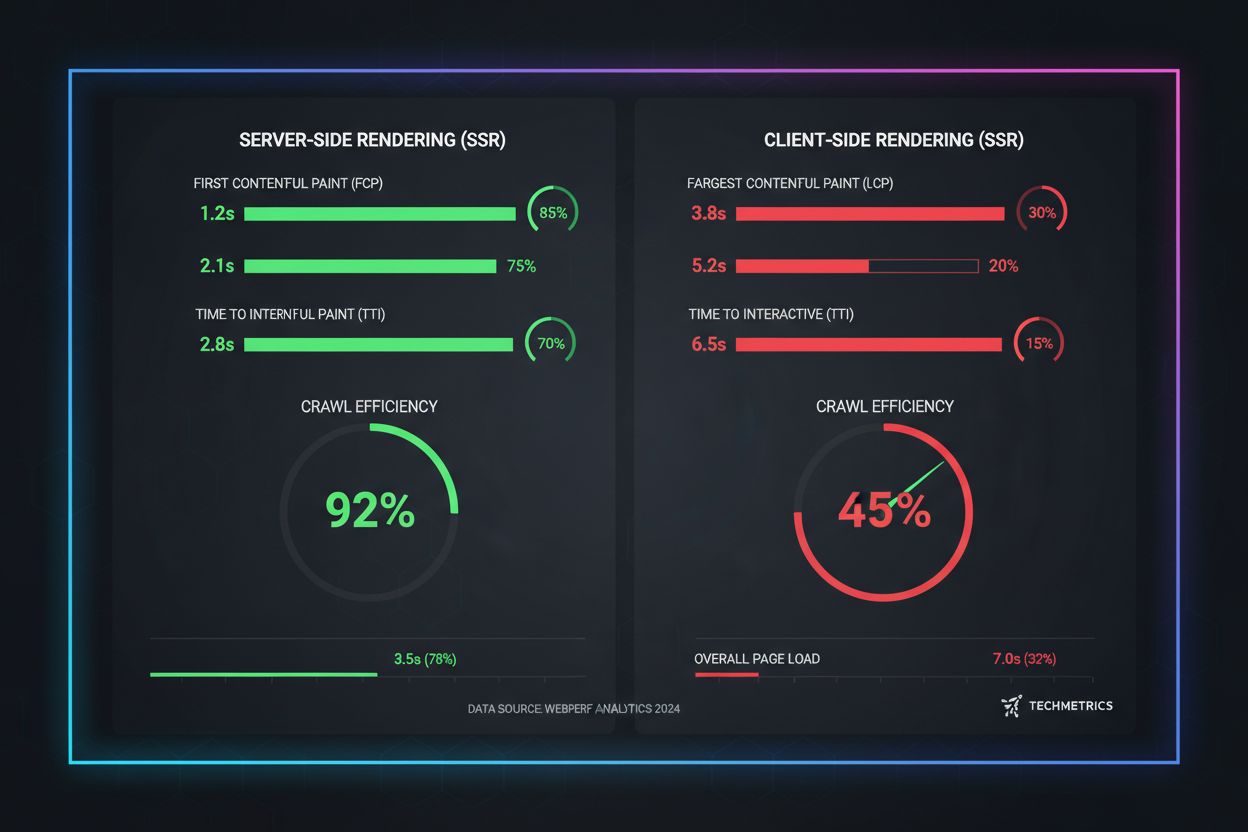

Randarea pe server (SSR) îmbunătățește fundamental vizibilitatea în AI prin livrarea HTML-ului complet randat direct de pe server la prima cerere, eliminând nevoia ca crawlerele AI să execute JavaScript. Cu SSR, tot conținutul critic—titluri, text, informații despre produse, metadate și date structurate—este prezent în HTML-ul primit de roboți, fiind imediat accesibil pentru procesare în corpusurile de antrenare AI și în indexuri. Această abordare asigură livrarea consecventă a conținutului pentru toate crawlerele, viteze de indexare mai rapide și vizibilitate completă a metadatelor de care sistemele AI au nevoie pentru a-ți înțelege și cita corect conținutul. Tabelul următor ilustrează modul în care diferitele strategii de randare afectează vizibilitatea pentru crawlerele AI:

| Tip de Randare | Ce văd crawlerele AI | Viteza de indexare | Completitudinea conținutului | Vizibilitate metadate |

|---|---|---|---|---|

| Randare pe server (SSR) | HTML complet randat cu tot conținutul | Rapidă (imediată) | Complet | Excelentă |

| Randare pe client (CSR) | Schelet HTML minimal, lipsă conținut dinamic | Lentă (dacă se randează) | Incomplet | Slabă |

| Generare statică (SSG) | HTML pre-construit, în cache | Foarte rapidă | Complet | Excelentă |

| Hibrid/Incremental | Amestec de rute statice și dinamice | Moderată spre rapidă | Bună (dacă paginile critice sunt pre-randate) | Bună |

Randarea pe client (CSR) prezintă provocări semnificative pentru vizibilitatea în AI deoarece obligă crawlerele să aștepte execuția JavaScript—ceea ce roboții AI pur și simplu nu fac din cauza constrângerilor de resurse și a timeout-urilor stricte. Când se încarcă un site bazat pe CSR, răspunsul HTML inițial conține doar un schelet minimal cu încărcătoare și elemente placeholder, iar conținutul real se încarcă asincron prin JavaScript. Crawlerele AI impun timeout-uri stricte de 1-5 secunde și nu execută scripturi, ceea ce înseamnă că surprind o versiune goală sau aproape goală a paginii, lipsită de descrieri de produse, prețuri, recenzii și alte informații esențiale. Acest lucru generează o problemă în lanț: instantaneele incomplete duc la chunking și embedding de slabă calitate, ceea ce scade șansele ca paginile tale să fie selectate pentru răspunsuri generate de AI. Pentru site-uri de e-commerce, platforme SaaS și aplicații bogate în conținut care se bazează pe CSR, acest lucru se traduce direct prin pierdere de vizibilitate în AI Overviews, răspunsuri ChatGPT și răspunsuri Perplexity—canalele care generează descoperirea în era AI.

Motivul tehnic pentru care roboții AI nu pot executa JavaScript ține de constrângerile fundamentale de scalabilitate și resurse ale arhitecturii lor. Crawlerele AI prioritizează viteza și eficiența în detrimentul completitudinii, funcționând cu timeout-uri stricte pentru că trebuie să proceseze miliarde de pagini pentru antrenarea și actualizarea modelelor lingvistice. Execuția JavaScript presupune pornirea unor browsere headless, alocarea de memorie și așteptarea operațiunilor asincrone—luxuri care nu pot fi scalate la volumul necesar pentru LLM-uri. În schimb, sistemele AI se concentrează pe extragerea de HTML curat, semantic structurat, disponibil instantaneu, tratând conținutul static ca versiunea canonică a site-ului tău. Această alegere reflectă un adevăr fundamental: sistemele AI sunt optimizate pentru livrarea HTML static, nu pentru randarea framework-urilor complexe de JavaScript, precum React, Vue sau Angular.

Impactul asupra răspunsurilor generate de AI și vizibilității brandului este profund și influențează direct rezultatele afacerii tale. Când crawlerele AI nu pot accesa conținutul din cauza randării JavaScript, brandul tău devine invizibil în AI Overviews, lipsit de mențiuni și absent din rezultatele de căutare bazate pe LLM—chiar dacă ai poziții bune în Google. Pentru site-urile de e-commerce, aceasta înseamnă că detaliile produselor, prețurile și informațiile despre stoc nu ajung la sistemele AI, ducând la recomandări incomplete sau incorecte și pierderi de vânzări. Companiile SaaS pierd vizibilitate pentru paginile de comparație și prețuri care altfel ar atrage lead-uri calificate din instrumentele de cercetare AI. Site-urile de știri și conținut își văd articolele excluse din sumarizările AI, reducând traficul de recomandare de pe platforme precum ChatGPT și Perplexity. Diferența dintre ce văd oamenii și ce văd sistemele AI creează o problemă de vizibilitate pe două niveluri: site-ul tău poate părea performant în metricile SEO clasice, dar să fie invizibil pentru cel mai dinamic canal de descoperire.

Pre-randarea și soluțiile hibride oferă modalități practice de a combina avantajele ambelor metode de randare fără a fi nevoie de o refacere completă a arhitecturii. În loc să alegi între interactivitatea CSR și crawlabilitatea SSR, echipele moderne implementează combinații strategice pentru diverse scopuri:

Aceste abordări permit să menții experiențe interactive bogate pentru utilizatori, asigurând însă că crawlerele AI primesc HTML complet și randat. Framework-uri precum Next.js, Nuxt și SvelteKit fac randarea hibridă accesibilă fără dezvoltare extensivă customizată. Cheia este identificarea paginilor care aduc achiziții, venituri sau reduc nevoia de suport—aceste pagini critice trebuie întotdeauna pre-randate sau randate pe server pentru vizibilitate în AI.

Strategia de randare afectează direct modul în care sistemele AI fac referire și citesc brandul tău, așa că este esențial să monitorizezi vizibilitatea pe platformele AI. Instrumente precum AmICited.com urmăresc cum sistemele AI menționează brandul tău în ChatGPT, Perplexity, Google AI Overviews și alte platforme bazate pe LLM, arătând dacă ajungi cu adevărat la aceste sisteme. Când site-ul tău folosește CSR fără pre-randare, datele AmICited arată adesea o diferență clară: poți avea poziții bune în căutarea tradițională, dar să nu primești nicio mențiune în răspunsurile generate de AI. Această monitorizare relevă adevăratul cost al alegerilor de randare JavaScript—nu doar la nivel de crawlare, ci și prin pierderea vizibilității brandului și a oportunităților de menționare. Implementând SSR sau pre-randare și apoi urmărind rezultatele cu AmICited, poți cuantifica impactul direct al deciziilor de randare asupra vizibilității AI, facilitând justificarea investițiilor către stakeholderii interesați de trafic și conversii.

Auditarea și optimizarea strategiei de randare pentru vizibilitate AI necesită o abordare sistematică, pas cu pas. Începe prin a identifica paginile cu cea mai mare valoare: paginile de produs, cele de prețuri, documentația principală și articolele de blog cu trafic mare ar trebui să fie prioritare. Folosește instrumente precum Screaming Frog (în modul „Text Only”) sau Chrome DevTools pentru a compara ce văd roboții versus utilizatorii—dacă lipsesc conținuturi critice din sursa paginii, ele depind de JavaScript și sunt invizibile pentru crawlerele AI. Apoi, alege strategia de randare în funcție de necesarul de prospețime al conținutului: paginile statice pot folosi SSG, conținutul actualizat frecvent beneficiază de SSR sau ISR, iar funcțiile interactive pot fi adăugate cu JavaScript peste HTML-ul randat pe server. Testează ulterior direct cu boti AI trimițând paginile tale către ChatGPT, Perplexity și Claude pentru a verifica dacă pot accesa conținutul. În final, monitorizează logurile de crawlare pentru user-agent-urile AI (GPTBot, ChatGPT-User, OAI-SearchBot) pentru a confirma că acestea accesează cu succes paginile pre-randate sau randate pe server. Această abordare iterativă transformă randarea dintr-un detaliu tehnic într-o pârghie măsurabilă de vizibilitate.

Metricile de performanță din lumea reală relevă diferențe dramatice între abordările de randare când vine vorba de crawlabilitatea AI. Paginile SSR și pre-randate obțin First Contentful Paint (FCP) în 0.5-1.5 secunde, în timp ce site-urile CSR necesită adesea 2-4 secunde sau mai mult, pe măsură ce JavaScript-ul se descarcă și se execută. Pentru crawlerele AI care operează cu timeout-uri de 1-5 secunde, această diferență înseamnă diferența dintre vizibilitate completă și invizibilitate totală. Eficiența de crawlare se îmbunătățește dramatic cu SSR: un site e-commerce pre-randat poate fi complet scanat și indexat în câteva ore, în timp ce un echivalent CSR poate dura săptămâni din cauza dificultăților de randare JavaScript. Și viteza de indexare este semnificativ mai bună—site-urile SSR văd conținut nou indexat în 24-48 de ore, în timp ce site-urile CSR experimentează adesea întârzieri de 7-14 zile. Pentru conținut sensibil la timp, precum articole de știri, lansări de produse sau oferte limitate, această întârziere înseamnă pierdere directă de vizibilitate în perioada critică de căutare.

Viitorul SEO este inseparabil de vizibilitatea în căutarea AI, ceea ce face strategia de randare o investiție esențială pe termen lung, nu doar un detaliu tehnic. Căutarea bazată pe AI crește exponențial—13,14% dintre toate rezultatele Google declanșează acum AI Overviews, iar platforme precum ChatGPT primesc peste patru miliarde de vizite lunar, cu Perplexity și Claude în creștere rapidă. Pe măsură ce AI devine principalul canal de descoperire pentru tot mai mulți utilizatori, deciziile de randare luate azi îți vor determina vizibilitatea de mâine. Monitorizarea continuă este esențială deoarece comportamentul crawlerelor AI, pragurile de timeout și suportul pentru JavaScript evoluează pe măsură ce aceste sisteme devin mai mature. Echipele care tratează randarea ca pe o migrare unică ajung deseori invizibile din nou în câteva luni, pe măsură ce platformele AI își schimbă strategiile de crawlare. În schimb, integrează optimizarea randării în planificarea trimestrială, include verificări de vizibilitate AI în testarea de regresie și folosește instrumente precum AmICited pentru a urmări dacă brandul tău rămâne vizibil pe măsură ce peisajul AI evoluează. Brandurile care câștigă în căutarea AI sunt cele care tratează strategia de randare ca pe un avantaj competitiv de bază, nu ca pe o datorie tehnică de rezolvat ulterior.

Crawlerele AI precum GPTBot și ChatGPT-User funcționează sub constrângeri stricte de resurse și timeout-uri scurte (1-5 secunde) deoarece trebuie să proceseze miliarde de pagini pentru a antrena modelele de limbaj. Execuția JavaScript presupune pornirea unor browsere headless și așteptarea operațiunilor asincrone—lucruri care nu pot fi scalate la volumul necesar pentru antrenarea LLM-urilor. În schimb, sistemele AI se concentrează pe extragerea de HTML curat, static, care este imediat disponibil.

Randarea pe Server (Server-Side Rendering) livrează HTML complet randat la prima cerere, făcând tot conținutul accesibil instantaneu pentru crawlerele AI fără execuție JavaScript. Acest lucru asigură că detaliile produsului, prețurile, recenziile și metadatele ajung fiabil la sistemele AI, crescând șansele ca brandul tău să fie menționat în răspunsurile generate de AI și să apară în AI Overviews.

Randarea pe Server (SSR) procesează paginile la cerere când sosește o solicitare, în timp ce pre-randarea generează fișiere HTML statice la momentul build-ului. Pre-randarea este ideală pentru conținut care nu se schimbă frecvent, în timp ce SSR este mai potrivit pentru conținut dinamic care se actualizează regulat. Ambele metode asigură că crawlerele AI primesc HTML complet fără execuție JavaScript.

Da, dar cu limitări semnificative. Poți folosi instrumente de pre-randare pentru a genera instantanee HTML statice ale paginilor tale CSR sau poți implementa randare hibridă unde paginile critice sunt randate pe server, iar cele mai puțin importante rămân randate pe client. Totuși, fără aceste optimizări, site-urile CSR sunt în mare parte invizibile pentru crawlerele AI.

Folosește instrumente precum Screaming Frog (mod Text Only), Chrome DevTools sau Google Search Console pentru a compara ce văd roboții cu ce văd utilizatorii. Dacă lipsesc conținuturi critice din sursa paginii, acestea depind de JavaScript și sunt invizibile pentru crawlerele AI. Poți testa direct și cu ChatGPT, Perplexity și Claude pentru a verifica dacă pot accesa conținutul tău.

Paginile SSR și pre-randate obțin de obicei First Contentful Paint (FCP) în 0.5-1.5 secunde, în timp ce site-urile CSR necesită deseori 2-4+ secunde. Deoarece crawlerele AI operează cu timeout-uri de 1-5 secunde, o randare mai rapidă se traduce direct într-o mai bună crawlabilitate AI. Îmbunătățirea Core Web Vitals aduce beneficii și experienței utilizatorului și clasamentelor SEO tradiționale.

AmICited monitorizează cum sistemele AI menționează brandul tău în ChatGPT, Perplexity și Google AI Overviews. Prin urmărirea vizibilității tale în AI înainte și după implementarea SSR sau pre-randării, poți cuantifica impactul direct al deciziilor de randare asupra mențiunilor brandului și prezenței în căutările AI.

Depinde de cerințele de actualizare ale conținutului și prioritățile afacerii tale. Conținutul static beneficiază de SSG, cel actualizat frecvent de SSR, iar funcționalitățile interactive pot fi adăugate cu JavaScript peste HTML-ul randat pe server. Începe prin identificarea paginilor cu valoare mare (pagini produse, prețuri, documentație) și prioritizează-le pe acestea pentru SSR sau pre-randare.

Urmărește cum ChatGPT, Perplexity și Google AI Overviews fac referire la brandul tău. Înțelege impactul real al strategiei tale de randare asupra mențiunilor în AI.

Ghid complet de referință pentru crawlerele și boții AI. Identifică GPTBot, ClaudeBot, Google-Extended și peste 20 de alte crawlere AI cu user agent, rate de cr...

Află cum să faci conținutul tău vizibil pentru crawlerii AI precum ChatGPT, Perplexity și AI-ul Google. Descoperă cerințe tehnice, bune practici și strategii de...

Descoperă factorii tehnici SEO esențiali care îți influențează vizibilitatea în motoarele de căutare AI precum ChatGPT, Perplexity și Google AI Mode. Află cum v...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.