Acces diferențial pentru crawlere

Află cum să permiți sau să blochezi selectiv crawlerele AI în funcție de obiectivele de afaceri. Implementează acces diferențial pentru crawlere pentru a-ți pro...

Află cum firewall-urile pentru aplicații web oferă control avansat asupra crawlerelor AI, dincolo de robots.txt. Implementează reguli WAF pentru a-ți proteja conținutul de scraping AI neautorizat și monitorizează citările AI cu AmICited.

Ineficiența robots.txt ca mecanism de apărare de sine stătător a devenit tot mai evidentă în era consumului de conținut generat de AI. În timp ce motoarele de căutare tradiționale respectă, în general, directivele robots.txt, crawlerele AI moderne funcționează pe baza unor stimulente și mecanisme de aplicare fundamental diferite, făcând politicile simple bazate pe text insuficiente pentru protejarea conținutului. Potrivit analizei Cloudflare, crawlerele AI reprezintă acum aproape 80% din tot traficul de bot către site-uri, iar crawlerele de antrenare consumă cantități mari de conținut, returnând trafic de referință minim—crawlerele OpenAI au un raport crawl-to-referral de 400:1, iar cel al Anthropic ajunge la 38.000:1. Pentru editori și deținătorii de conținut, această relație asimetrică reprezintă o amenințare critică la adresa afacerii, deoarece modelele AI antrenate pe conținutul lor pot reduce direct traficul organic și pot diminua valoarea proprietății intelectuale.

Un Web Application Firewall (WAF) funcționează ca un proxy invers poziționat între utilizatori și serverele web, inspectând fiecare solicitare HTTP în timp real pentru a filtra traficul nedorit pe baza unor reguli configurabile. Spre deosebire de robots.txt, care se bazează pe conformitatea voluntară a crawlerelor, WAF-urile impun protecția la nivel de infrastructură, făcându-le mult mai eficiente pentru controlul accesului crawlerelor AI. Următoarea comparație ilustrează diferențele dintre WAF și abordările tradiționale de securitate:

| Caracteristică | Robots.txt | Firewall tradițional | WAF modern |

|---|---|---|---|

| Nivel de aplicare | Consultativ/Voluntar | Blocare pe baza IP | Inspecție la nivel de aplicație |

| Detectare crawlere AI | Doar potrivire user-agent | Recunoaștere limitată a botului | Analiză comportamentală + amprentare |

| Adaptare în timp real | Fișier static | Actualizări manuale necesare | Informații continue despre amenințări |

| Control granular | Doar la nivel de cale | Interval larg de IP-uri | Politici la nivel de cerere |

| Machine learning | Niciuna | Niciuna | Clasificare avansată a boturilor |

WAF-urile oferă clasificare granulară a boturilor prin amprentarea dispozitivului, analiză comportamentală și machine learning pentru a profila boturile în funcție de intenție și sofisticare, permițând un control mult mai nuanțat decât regulile simple de permitere/blocare.

Crawlerele AI se împart în trei categorii distincte, fiecare prezentând amenințări diferite și necesitând strategii diferite de atenuare. Crawlerele de antrenare precum GPTBot, ClaudeBot și Google-Extended colectează sistematic conținut web pentru a construi seturi de date pentru dezvoltarea modelelor de limbaj de mari dimensiuni, reprezentând aproximativ 80% din tot traficul crawlerelor AI și returnând valoare de referință zero pentru editori. Crawlerele de căutare și citare precum OAI-SearchBot și PerplexityBot indexează conținut pentru experiențe de căutare AI și pot furniza ceva trafic de referință prin citări, însă la volume semnificativ mai mici decât motoarele de căutare tradiționale. Fetcher-ele declanșate de utilizator se activează doar când utilizatorii solicită explicit conținut prin asistenți AI, operând la volum minim cu cereri unice, nu prin tipare de crawling sistematic. Peisajul amenințărilor include:

WAF-urile moderne utilizează metode tehnice sofisticate de detectare care depășesc cu mult simpla potrivire a stringului user-agent pentru a identifica și clasifica crawlerele AI cu acuratețe ridicată. Aceste sisteme folosesc analiza comportamentală pentru a examina tiparele de cereri, inclusiv viteza de crawling, secvențierea cererilor și modul de gestionare a răspunsurilor, aspecte care deosebesc boturile de utilizatorii umani. Tehnicile de amprentare a dispozitivelor analizează anteturile HTTP, semnăturile TLS și caracteristicile browserului pentru a identifica user-agents falsificați care încearcă să ocolească apărările tradiționale. Modelele de machine learning antrenate pe milioane de cereri pot detecta semnături noi de crawlere și tactici de bot noi în timp real, adaptându-se la amenințări fără a necesita actualizări manuale de reguli. În plus, WAF-urile pot verifica legitimitatea crawlerului prin compararea adreselor IP ale cererilor cu intervale IP publicate de mari companii AI—OpenAI publică IP-uri verificate la https://openai.com/gptbot.json, iar Amazon la https://developer.amazon.com/amazonbot/ip-addresses/—asigurând că doar crawlerele autentificate din surse legitime sunt permise.

Implementarea unor reguli WAF eficiente pentru crawlerele AI necesită o abordare pe mai multe straturi care combină blocarea user-agentului, verificarea IP-ului și politici comportamentale. Exemplul de cod următor demonstrează o configurație de bază pentru reguli WAF care blochează crawlerele de antrenare cunoscute, permițând funcționalitatea de căutare legitimă:

# Regulă WAF: Blochează crawlerele AI de antrenare

Nume regulă: Block-AI-Training-Crawlers

Condiția 1: HTTP User-Agent se potrivește cu (GPTBot|ClaudeBot|anthropic-ai|Google-Extended|Meta-ExternalAgent|Amazonbot|CCBot|Bytespider)

Acțiune: Blochează (returnează 403 Forbidden)

# Regulă WAF: Permite crawlerele de căutare verificate

Nume regulă: Allow-Verified-Search-Crawlers

Condiția 1: HTTP User-Agent se potrivește cu (OAI-SearchBot|PerplexityBot)

Condiția 2: IP sursă în intervalul IP verificat

Acțiune: Permite

# Regulă WAF: Limitează traficul suspect de bot

Nume regulă: Rate-Limit-Suspicious-Bots

Condiția 1: Rata cererilor depășește 100 cereri/minut

Condiția 2: User-Agent conține indicatori de bot

Condiția 3: Nu există potrivire IP verificat

Acțiune: Provocare (CAPTCHA) sau Blochează

Organizațiile trebuie să implementeze precedența regulilor cu atenție, asigurându-se că regulile mai specifice (precum verificarea IP-ului pentru crawlere legitime) se execută înaintea regulilor generale de blocare. Testarea și monitorizarea regulată a eficienței regulilor sunt esențiale, deoarece stringurile user-agent și intervalele IP ale crawlerelor evoluează frecvent. Mulți furnizori WAF oferă seturi de reguli predefinite special concepute pentru gestionarea crawlerelor AI, reducând complexitatea implementării și asigurând protecție cuprinzătoare.

Verificarea și permiterea IP-ului reprezintă cea mai fiabilă metodă de a distinge crawlerele AI legitime de cererile false, deoarece stringurile user-agent pot fi ușor falsificate, în timp ce adresele IP sunt mult mai greu de falsificat la scară largă. Marile companii AI publică intervale oficiale de IP în format JSON, permițând verificarea automată fără mentenanță manuală—OpenAI furnizează liste separate de IP pentru GPTBot, OAI-SearchBot și ChatGPT-User, iar Amazon menține o listă cuprinzătoare pentru Amazonbot. Regulile WAF pot fi configurate pentru a permite doar cererile provenite din aceste intervale IP verificate, prevenind astfel eficient actorii rău-intenționați să ocolească restricțiile doar schimbând antetul user-agent. Pentru organizațiile care folosesc blocare la nivel de server prin .htaccess sau reguli firewall, combinarea verificării IP cu potrivirea user-agent oferă protecție în profunzime, independentă de configurația WAF. În plus, unele crawlere respectă meta tag-uri HTML precum <meta name="robots" content="noarchive">, ceea ce semnalează crawlerelor conforme că acest conținut nu ar trebui folosit pentru antrenarea modelelor, oferind un mecanism suplimentar de control pentru editorii care doresc protecție granulară la nivel de pagină.

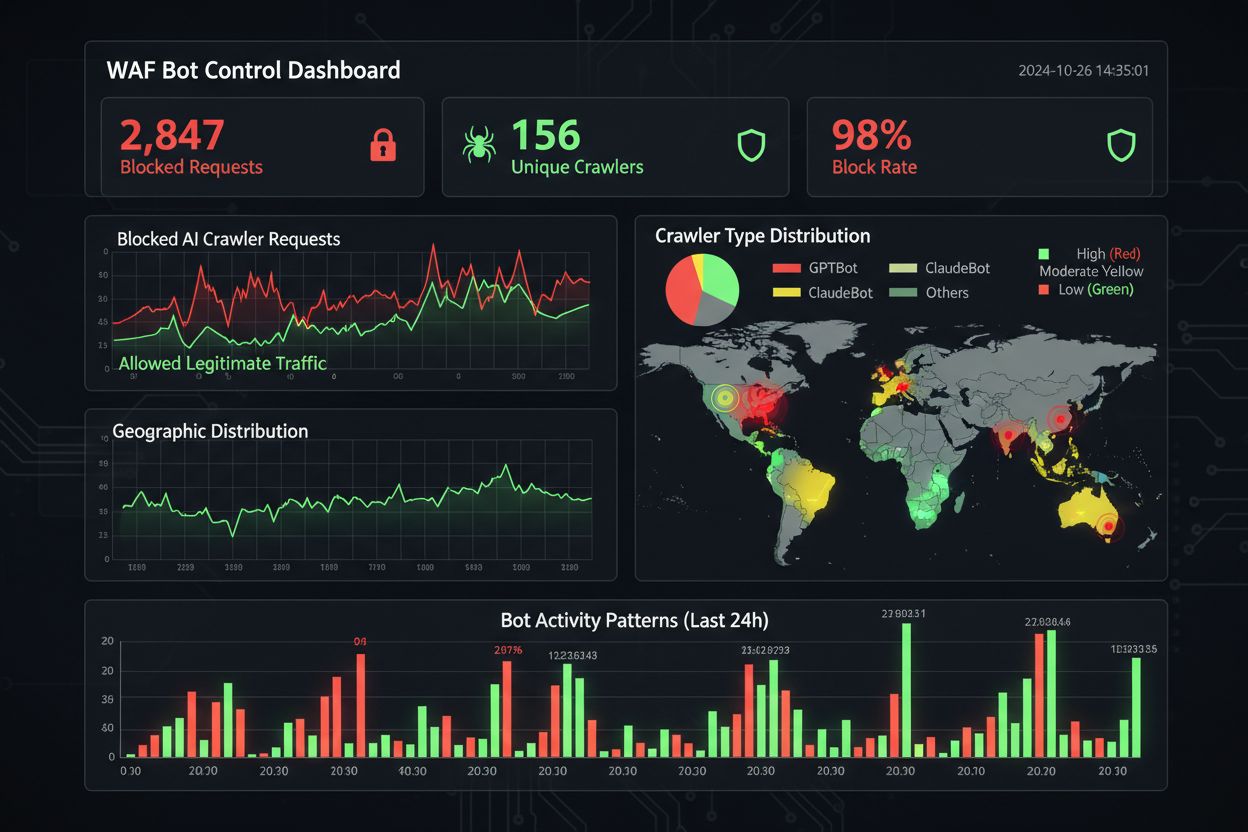

O monitorizare și conformitate eficientă necesită vizibilitate continuă asupra activității crawlerelor și verificarea faptului că regulile de blocare funcționează conform intenției. Organizațiile ar trebui să analizeze regulat logurile de acces ale serverului pentru a identifica ce crawlere accesează site-urile și dacă crawlerele blocate mai fac cereri—logurile Apache sunt de obicei în /var/log/apache2/access.log iar cele Nginx în /var/log/nginx/access.log, iar filtrarea cu grep poate identifica rapid tipare suspecte. Platformele de analiză diferențiază tot mai mult traficul de bot de cel uman, permițând echipelor să măsoare impactul blocării crawlerelor asupra metricilor legitime precum rata de respingere, urmărirea conversiilor și performanța SEO. Unelte precum Cloudflare Radar furnizează vizibilitate globală asupra tiparelor de trafic bot AI și pot identifica crawlere emergente care nu sunt încă pe lista ta de blocare. Din perspectiva conformității, logurile WAF generează trasee de audit care demonstrează că organizațiile au implementat măsuri rezonabile de securitate pentru a proteja datele clienților și proprietatea intelectuală, ceea ce devine tot mai important pentru GDPR, CCPA și alte reglementări privind protecția datelor. Revizuirile trimestriale ale listei de blocare a crawlerelor sunt esențiale, deoarece apar frecvent crawlere AI noi și cele existente își modifică stringurile user-agent—proiectul ai.robots.txt pe GitHub

, menținut de comunitate, este o resursă valoroasă pentru monitorizarea amenințărilor emergente.

Echilibrarea protecției conținutului cu obiectivele de business necesită o analiză atentă a crawlerelor ce trebuie blocate versus permise, deoarece o blocare prea agresivă poate reduce vizibilitatea în noile canale de descoperire AI. Blocarea crawlerelor de antrenare precum GPTBot și ClaudeBot protejează proprietatea intelectuală, dar nu are impact direct asupra traficului, deoarece aceste crawlere nu trimit niciodată trafic de referință. Totuși, blocarea crawlerelor de căutare precum OAI-SearchBot și PerplexityBot poate reduce vizibilitatea în rezultatele de căutare AI unde utilizatorii caută activ citări și surse—un compromis ce depinde de strategia ta de conținut și publicul țintă. Unii editori explorează abordări alternative, precum permiterea crawlerelor de căutare, dar blocarea celor de antrenare, sau implementarea unor modele pay-per-crawl unde companiile AI compensează editorii pentru acces la conținut. Unelte precum AmICited.com ajută editorii să urmărească dacă și cum este citat conținutul lor în răspunsuri AI, oferind date pentru deciziile de blocare. Configurația WAF optimă depinde de modelul tău de afaceri: publisherii de știri pot prioritiza blocarea crawlerelor de antrenare pentru a-și proteja conținutul, permițând totodată crawlerele de căutare pentru vizibilitate, în timp ce companiile SaaS pot bloca toate crawlerele AI pentru a împiedica analiza prețurilor și funcționalităților de către competiție. Monitorizarea regulată a tiparelor de trafic și a metricilor de venit după implementarea regulilor WAF asigură că strategia de protecție se aliniază cu rezultatele reale de business.

Când compari soluții WAF pentru gestionarea crawlerelor AI, organizațiile ar trebui să evalueze câteva capabilități cheie care diferențiază platformele enterprise de ofertele de bază. Cloudflare AI Crawl Control se integrează cu WAF-ul său pentru a oferi reguli predefinite pentru crawlerele AI cunoscute, cu posibilitatea de a bloca, permite sau implementa monetizare pay-per-crawl pentru crawlere specifice—ordinea de precedență a platformei asigură că regulile WAF se execută înaintea altor straturi de securitate. AWS WAF Bot Control oferă niveluri de protecție de bază și țintită, nivelul țintit folosind interogare de browser, amprentare și euristici comportamentale pentru a detecta boturi sofisticate care nu se auto-identifică, plus analiză opțională cu machine learning a statisticilor de trafic. Azure WAF oferă capabilități similare prin seturile sale de reguli gestionate, însă cu o specializare AI mai redusă față de Cloudflare sau AWS. Dincolo de aceste platforme majore, soluțiile specializate de management al boturilor de la furnizori precum DataDome oferă modele avansate de machine learning antrenate special pe comportamentul crawlerelor AI, însă la costuri mai ridicate. Alegerea soluției depinde de infrastructura existentă, buget și nivelul de sofisticare necesar—organizațiile care folosesc deja Cloudflare beneficiază de integrare fără cusur, iar clienții AWS pot folosi Bot Control în cadrul infrastructurii WAF existente.

Cele mai bune practici pentru gestionarea crawlerelor AI pun accentul pe o abordare de tip defense-in-depth, care combină mai multe mecanisme de control, nu se bazează pe o singură soluție. Organizațiile ar trebui să implementeze revizuiri trimestriale ale listei de blocare pentru a surprinde crawlere noi și stringuri user-agent actualizate, să mențină analiza logurilor serverului pentru a verifica dacă crawlerele blocate nu ocolesc regulile și să testeze regulat configurațiile WAF pentru a asigura ordinea corectă de execuție a regulilor. Viitorul tehnologiei WAF va include tot mai mult detecție a amenințărilor bazată pe AI, care se adaptează în timp real la tacticile noi ale crawlerelor, cu integrare în ecosisteme de securitate mai largi pentru protecție context-aware. Pe măsură ce reglementările privind scraping-ul de date și sursele de antrenare AI devin mai stricte, WAF-urile vor deveni instrumente esențiale pentru conformitate, nu doar opționale. Organizațiile ar trebui să înceapă implementarea unor reguli WAF cuprinzătoare pentru crawlerele AI chiar acum, înainte ca amenințările emergente precum agenții AI bazați pe browser și crawlerele cu browser fără interfață să devină răspândite—costul inacțiunii, măsurat în trafic pierdut, analitici compromise și posibile expuneri legale, depășește cu mult investiția necesară pentru o infrastructură robustă de protecție.

Robots.txt este un fișier consultativ care se bazează pe respectarea voluntară a directivelor de către crawlere, în timp ce regulile WAF sunt aplicate la nivel de infrastructură și se aplică tuturor cererilor, indiferent de conformitatea crawlerului. WAF-urile oferă detectare și blocare în timp real, pe când robots.txt este static și poate fi ușor ocolit de crawlerele neconforme.

Da, multe crawlere AI ignoră directivele robots.txt deoarece sunt proiectate să maximizeze colectarea datelor pentru antrenare. Deși crawlerele respectabile ale companiilor mari respectă, în general, robots.txt, actorii rău-intenționați și unele crawlere noi nu o fac. De aceea, regulile WAF oferă o protecție mai fiabilă.

Verifică logurile de acces ale serverului tău (de obicei în /var/log/apache2/access.log sau /var/log/nginx/access.log) pentru stringuri user-agent care conțin identificatori de bot. Unelte precum Cloudflare Radar oferă vizibilitate globală asupra tiparelor de trafic ale crawlerelor AI, iar platformele de analiză diferențiază tot mai mult traficul de bot de cel al vizitatorilor umani.

Blocarea crawlerelor de antrenare precum GPTBot nu are impact direct asupra SEO, deoarece acestea nu trimit trafic de referință. Totuși, blocarea crawlerelor de căutare precum OAI-SearchBot poate reduce vizibilitatea în rezultatele de căutare AI. Google AI Overviews urmează regulile Googlebot standard, deci blocarea Google-Extended nu afectează indexarea obișnuită.

Cloudflare AI Crawl Control, AWS WAF Bot Control și Azure WAF oferă soluții eficiente. Cloudflare furnizează cele mai multe funcții specifice AI cu reguli predefinite și opțiuni de plată per crawl. AWS oferă detecție avansată bazată pe machine learning, iar Azure are seturi solide de reguli gestionate. Alege în funcție de infrastructura și bugetul pe care le ai.

Revizuiește și actualizează regulile WAF cel puțin trimestrial, deoarece apar frecvent crawlere AI noi, iar cele existente își modifică stringul user-agent. Monitorizează proiectul ai.robots.txt menținut de comunitate pe GitHub pentru amenințări noi și verifică lunar logurile serverului pentru a identifica crawlere noi care accesează site-ul.

Da, aceasta este o strategie comună. Poți configura reguli WAF pentru a bloca crawlerele de antrenare precum GPTBot și ClaudeBot, permițând în același timp crawlerele de căutare precum OAI-SearchBot și PerplexityBot. Astfel îți protejezi conținutul de a fi folosit la antrenarea modelelor, dar menții vizibilitatea în rezultatele AI.

Prețurile WAF variază în funcție de furnizor. Cloudflare oferă WAF de la 20$/lună cu funcții AI Crawl Control. AWS WAF taxează per web ACL și regulă, de obicei 5-10$/lună pentru protecție de bază. Azure WAF este inclus cu Application Gateway. Costurile de implementare sunt minime comparativ cu valoarea protejării conținutului și menținerii analiticilor corecte.

AmICited urmărește activitatea crawlerelor AI și monitorizează modul în care conținutul tău este citat pe ChatGPT, Perplexity, Google AI Overviews și alte platforme AI. Obține vizibilitate asupra prezenței tale AI și înțelege ce crawlere accesează conținutul tău.

Află cum să permiți sau să blochezi selectiv crawlerele AI în funcție de obiectivele de afaceri. Implementează acces diferențial pentru crawlere pentru a-ți pro...

Află strategii dovedite pentru a crește cât de des crawlerele AI vizitează site-ul tău, îmbunătățește descoperirea conținutului în ChatGPT, Perplexity și alte m...

Înțelege frecvența vizitelor crawler-elor AI, modelele de crawl pentru ChatGPT, Perplexity și alte sisteme AI. Află ce factori influențează cât de des îți vizit...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.