Cum funcționează Căutarea Live Perplexity: Integrare Web în Timp Real Explicată

Înțelege modul în care tehnologia de căutare live a Perplexity preia informații în timp real de pe web și generează răspunsuri cu surse citate. Află procesul te...

Am folosit Perplexity intensiv și încerc să-i înțeleg funcționarea. E clar diferit atât de căutarea tradițională, cât și de ChatGPT.

Ce am observat:

Ipoteza mea de arhitectură:

Ce încerc să înțeleg:

Caut pe cineva care a studiat în profunzime arhitectura Perplexity.

Daniel, ipoteza ta de arhitectură e destul de aproape. Lasă-mă să adaug detalii:

Conducta în patru etape:

| Etapă | Funcție | Tehnologie |

|---|---|---|

| Procesare interogare | Recunoaștere intenție, extragere entități | NLP + tokenizare |

| Recuperare informație | Căutare în index web pentru documente relevante | Căutare semantică + API-uri |

| Generare răspuns | Sinteză din conținutul recuperat | LLM (GPT-4, Claude) |

| Rafinizare | Fact-check, formatare, sugestii follow-up | Post-procesare |

Etapa 1: Procesare interogare

Nu doar extragere de cuvinte cheie:

Exemplu: “Ultimele evoluții în calculul cuantic” →

Etapa 2: Recuperare

Folosește căutare semantică, nu doar potrivirea cuvintelor cheie. Un document despre “rețele neuronale artificiale” poate fi recuperat pentru interogarea “deep learning” deoarece sensul semantic e similar.

Partea de căutare semantică e interesantă. Deci folosește embedding-uri pentru a găsi conținut relaționat conceptual, nu doar potriviri de cuvinte cheie?

Și pentru generarea răspunsului - folosește mai multe surse simultan sau le procesează secvențial?

Recuperare bazată pe embedding-uri:

Da, exact. Procesul:

Procesarea multi-sursă:

Perplexity procesează sursele în paralel, nu secvențial:

Documente recuperate (5-10 surse)

↓

Extragere paralelă a pasajelor relevante

↓

Clasarea pasajelor după relevanță

↓

Context combinat + interogare → LLM

↓

Răspuns sintetizat cu citări inline

Mecanismul citărilor:

Pe măsură ce LLM-ul generează fiecare afirmație, menține atribuirea sursei. De aceea citările apar inline – modelul urmărește ce sursă susține fiecare afirmație.

Rezolvarea conflictelor:

Când sursele nu sunt de acord, Perplexity de obicei:

Stratul LLM merită o analiză mai detaliată.

Selecția modelului:

Perplexity folosește mai multe LLM-uri:

Cum generează LLM-ul răspunsurile citate:

LLM-ul nu copiază pur și simplu textul. El:

Exemplu de transformare:

Sursa 1: “Calculatoarele cuantice folosesc qubiți care pot exista în superpoziție.” Sursa 2: “Jucători majori sunt IBM, Google și IonQ.” Sursa 3: “Descoperiri recente arată procesoare de peste 1000 de qubiți.”

Output Perplexity: “Calculatoarele cuantice utilizează qubiți care operează în stări de superpoziție [1]. Liderii din industrie IBM, Google și IonQ [2] au realizat recent descoperiri incluzând procesoare de peste 1000 de qubiți [3].”

Sinteza creează text nou păstrând atribuirea corectă.

Pentru creatorii de conținut – iată ce contează pentru a fi citat:

Factori de selecție a sursei:

| Factor | Greutate | Cum optimizezi |

|---|---|---|

| Relevanță | Foarte mare | Răspunde direct la întrebări |

| Credibilitate | Mare | Afișează autor, instituție |

| Recență | Mare | Date de actualizare, conținut proaspăt |

| Claritate | Mare | Format structurat, ușor de extras |

| Autoritate domeniu | Medie | Construiește reputația site-ului |

Formate care sunt citate:

Perplexity extrage cel mai bine informații din:

Ce este sărit:

Căutare Rapidă vs Căutare Pro – diferența tehnică:

Căutare Rapidă:

Căutare Pro:

Decompunerea:

Căutarea Pro sparge interogările complexe în sub-interogări:

“Cel mai bun CRM pentru startup-uri din sănătate cu conformitate HIPAA” devine:

Fiecare sub-interogare recuperează surse diferite, apoi rezultatele sunt combinate.

Prevenirea halucinațiilor în Perplexity:

Cum reduce halucinațiile:

Limitarea:

Perplexity poate totuși să halucineze dacă:

Comparat cu ChatGPT:

| Aspect | Perplexity | ChatGPT |

|---|---|---|

| Recuperare în timp real | Da | Limitat (pluginuri) |

| Citare obligatorie | Întotdeauna | Opțional |

| Knowledge cutoff | Nu există (live) | Data antrenării |

| Risc halucinație | Mai mic | Mai mare |

Mecanismul forțat de citare este principala apărare a Perplexity împotriva halucinațiilor.

Sistemul de memorie contextuală:

În cadrul unei sesiuni:

Perplexity ține minte istoricul conversației:

Exemplu: Î1: “Care sunt ultimele dezvoltări în calculul cuantic?” Î2: “Cum se compară asta cu calculul clasic?”

Pentru Î2, Perplexity înțelege că “asta” se referă la calculul cuantic din Î1.

Mecanismul de atenție:

Folosește greutăți de atenție pentru a determina ce context anterior e relevant pentru noua interogare. Nu totul se transferă – doar părțile contextual relevante.

Limitarea:

Memoria e doar pe sesiune. Dacă închizi conversația = context pierdut. Nu există personalizare persistentă între sesiuni.

Aceasta este o alegere de confidențialitate, nu o limitare tehnică.

Modul Focus este subestimat pentru înțelegerea arhitecturii Perplexity:

Focusuri disponibile:

| Focus | Pool surse | Ideal pentru |

|---|---|---|

| Toate | Întregul web | Interogări generale |

| Academic | Lucrări științifice | Întrebări științifice |

| Doar Reddit | Opinii comunitare | |

| YouTube | Conținut video | How-to, tutoriale |

| News | Agenții de știri | Evenimente curente |

| Writing | (niciuna) | Fără recuperare, generare pură |

Ce scoate la iveală:

Modul Focus arată că Perplexity poate restricționa recuperarea la anumite pool-uri de surse. Asta înseamnă că au:

Pentru optimizare:

Dacă vrei citări academice – asigură-te că cercetarea ta e indexată în baze de date academice. Dacă vrei citări generale – concentrează-te pe conținut descoperibil pe web.

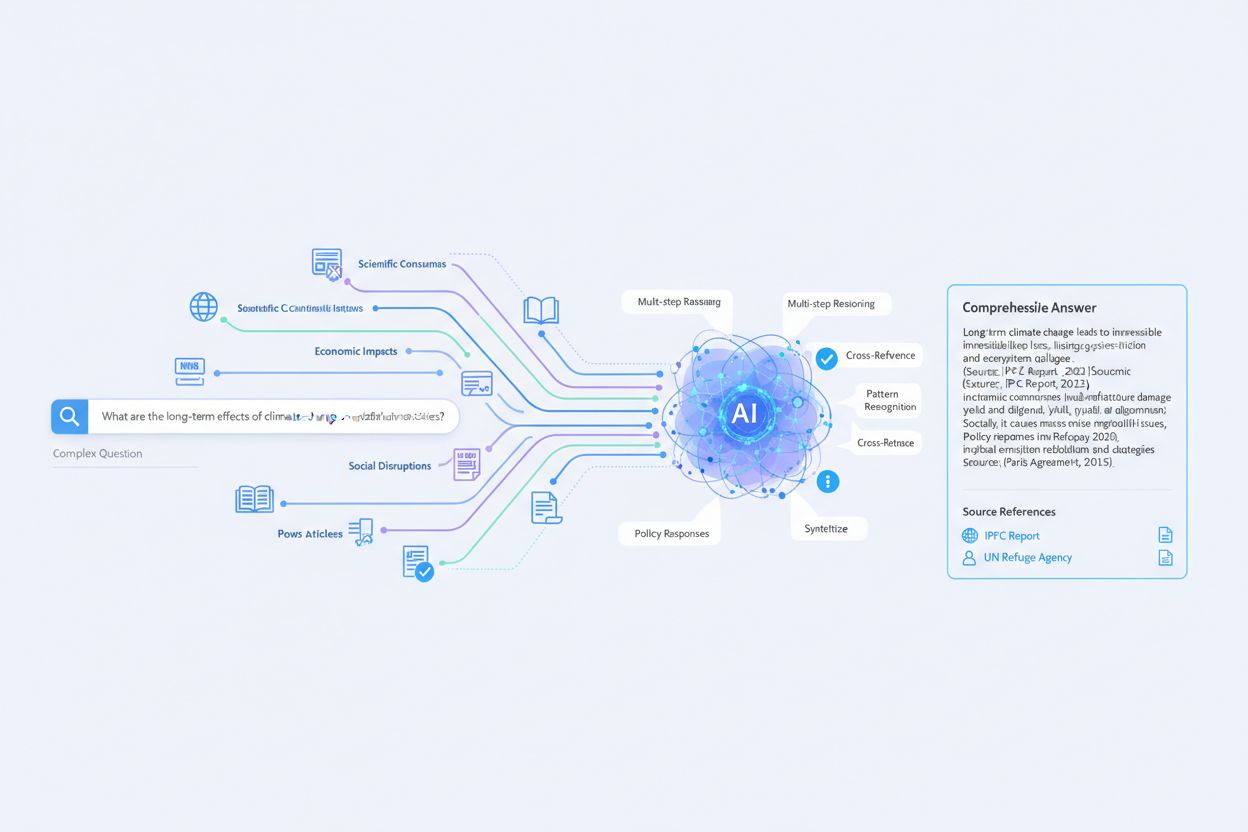

Acest thread a umplut golurile din înțelegerea mea. Iată diagrama mea de arhitectură actualizată:

Conducta Perplexity Live Search:

Interogare utilizator

↓

Etapa 1: Procesare interogare

├── Tokenizare NLP

├── Clasificare intenție

├── Extragere entități

├── Reformulare interogare (sub-interogări multiple)

↓

Etapa 2: Recuperare informație

├── Căutare semantică (bazată pe embedding-uri)

├── Apeluri API către index web

├── Filtrare surse (Mod Focus)

├── Extragere pasaje

├── Clasare relevanță

↓

Etapa 3: Generare răspuns

├── Populare fereastră context

├── Sinteză LLM (GPT-4/Claude)

├── Urmărire citări inline

├── Rezolvare conflicte

↓

Etapa 4: Rafinizare

├── Fact-checking pe surse

├── Evaluare coerență

├── Generare sugestii follow-up

├── Formatare citare

↓

Output final (Răspuns + Citări + Sugestii)

Idei cheie:

Pentru optimizarea conținutului:

Pentru a fi citat în Perplexity:

Mulțumesc tuturor pentru această analiză tehnică detaliată.

Get personalized help from our team. We'll respond within 24 hours.

Urmărește când Perplexity citează domeniul tău în răspunsurile sale live search. Înțelege cum platforma descoperă și utilizează conținutul tău.

Înțelege modul în care tehnologia de căutare live a Perplexity preia informații în timp real de pe web și generează răspunsuri cu surse citate. Află procesul te...

Află despre Perplexity Pro Search, un mod avansat de căutare AI care realizează raționament în mai mulți pași și analizează 20-25+ surse pentru cercetări cuprin...

Află cum să faci ca site-ul tău să fie citat de Perplexity AI. Descoperă cerințele tehnice, strategiile de optimizare a conținutului și tacticile de construire ...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.