Ce instrumente verifică accesibilitatea AI? Cele mai bune soluții de monitorizare

Descoperă cele mai bune instrumente pentru verificarea accesibilității AI. Învață cum să monitorizezi accesul GPTBot, ClaudeBot și PerplexityBot la site-ul tău ...

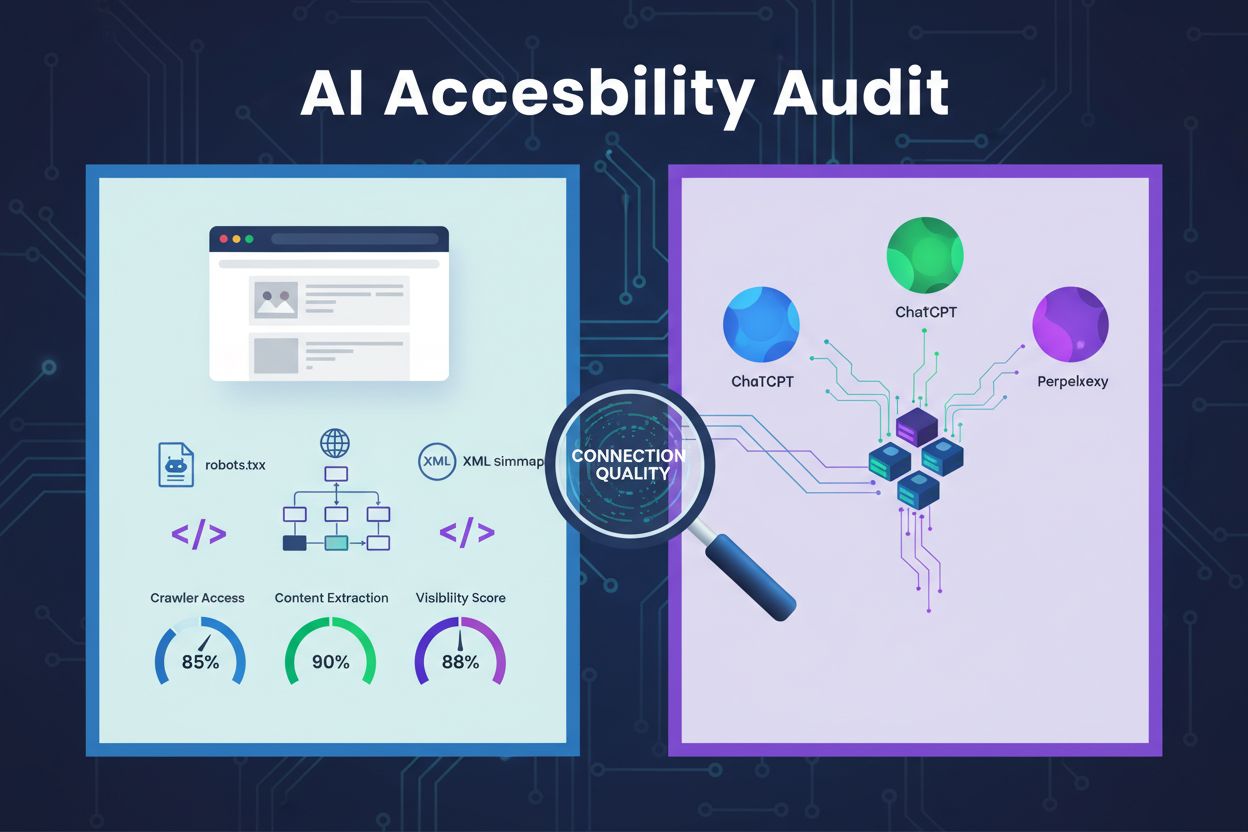

O revizuire tehnică a arhitecturii site-ului web, a configurației și a structurii conținutului pentru a determina dacă crawler-ele AI pot accesa, înțelege și extrage eficient conținutul. Evaluează configurația robots.txt, sitemap-urile XML, crawlabilitatea site-ului, randarea JavaScript și capacitatea de extragere a conținutului pentru a asigura vizibilitatea pe platformele de căutare alimentate de AI precum ChatGPT, Claude și Perplexity.

O revizuire tehnică a arhitecturii site-ului web, a configurației și a structurii conținutului pentru a determina dacă crawler-ele AI pot accesa, înțelege și extrage eficient conținutul. Evaluează configurația robots.txt, sitemap-urile XML, crawlabilitatea site-ului, randarea JavaScript și capacitatea de extragere a conținutului pentru a asigura vizibilitatea pe platformele de căutare alimentate de AI precum ChatGPT, Claude și Perplexity.

Un audit de accesibilitate AI este o revizuire tehnică a arhitecturii site-ului tău, a configurației și a structurii conținutului pentru a determina dacă crawler-ele AI pot accesa, înțelege și extrage eficient conținutul tău. Spre deosebire de auditurile SEO tradiționale care se concentrează pe clasamentele cuvintelor cheie și backlink-uri, auditurile de accesibilitate AI examinează fundamentele tehnice care permit sistemelor AI precum ChatGPT, Claude și Perplexity să descopere și să citeze conținutul tău. Acest audit evaluează componente critice precum configurația robots.txt, sitemap-urile XML, crawlabilitatea site-ului, randarea JavaScript și capacitatea de extragere a conținutului pentru a asigura vizibilitatea completă a site-ului tău în ecosistemul de căutare alimentat de AI.

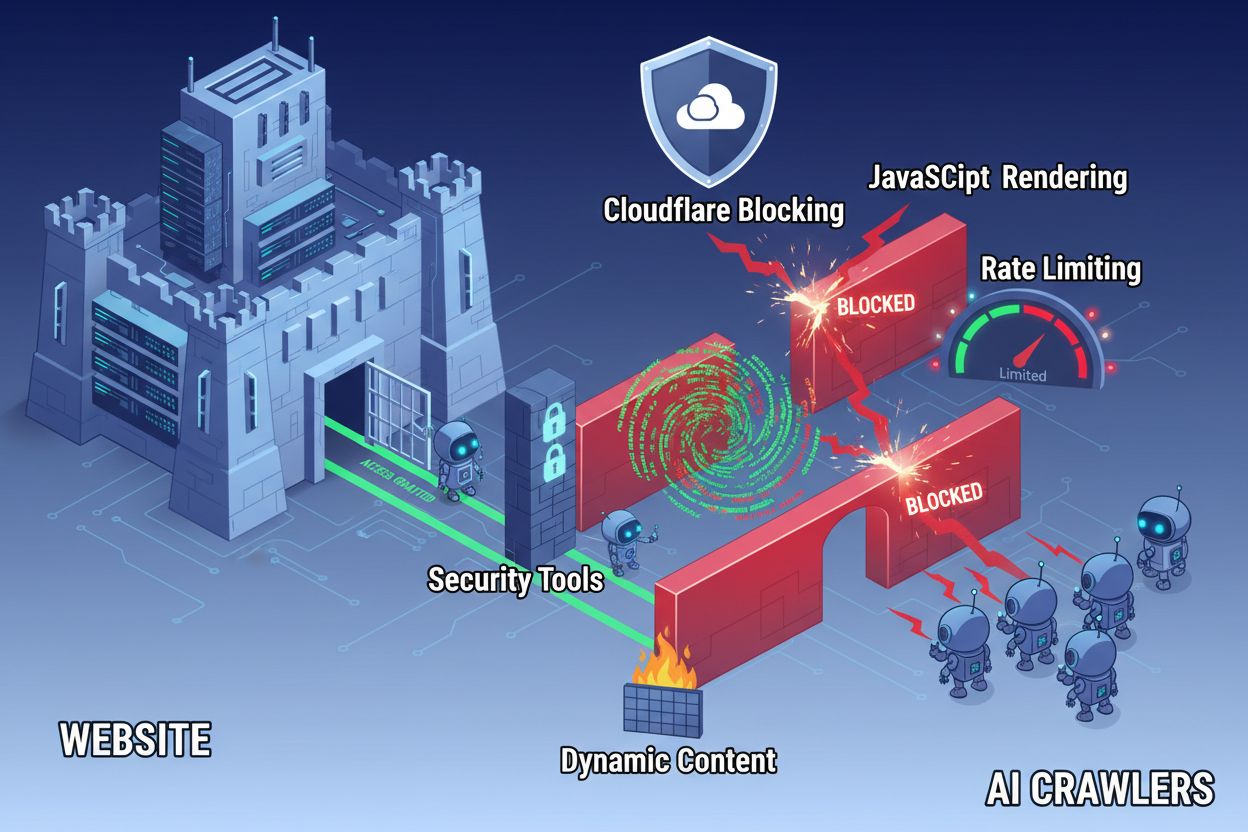

În ciuda progreselor tehnologice web, crawler-ele AI se confruntă cu bariere semnificative atunci când încearcă să acceseze site-uri moderne. Principala provocare este că multe site-uri contemporane se bazează masiv pe randarea JavaScript pentru a afișa dinamic conținutul, dar majoritatea crawler-elor AI nu pot executa cod JavaScript. Aceasta înseamnă că aproximativ 60-90% din conținutul site-urilor moderne rămâne invizibil pentru sistemele AI, chiar dacă se afișează perfect în browserele utilizatorilor. În plus, instrumente de securitate precum Cloudflare blochează implicit crawler-ele AI, tratându-le ca potențiale amenințări și nu ca boți legitimi de indexare. Cercetările arată că 35% dintre site-urile enterprise blochează accidental crawler-ele AI, împiedicând descoperirea și citarea conținutului valoros de către sistemele AI.

Bariere comune care împiedică accesul crawler-elor AI includ:

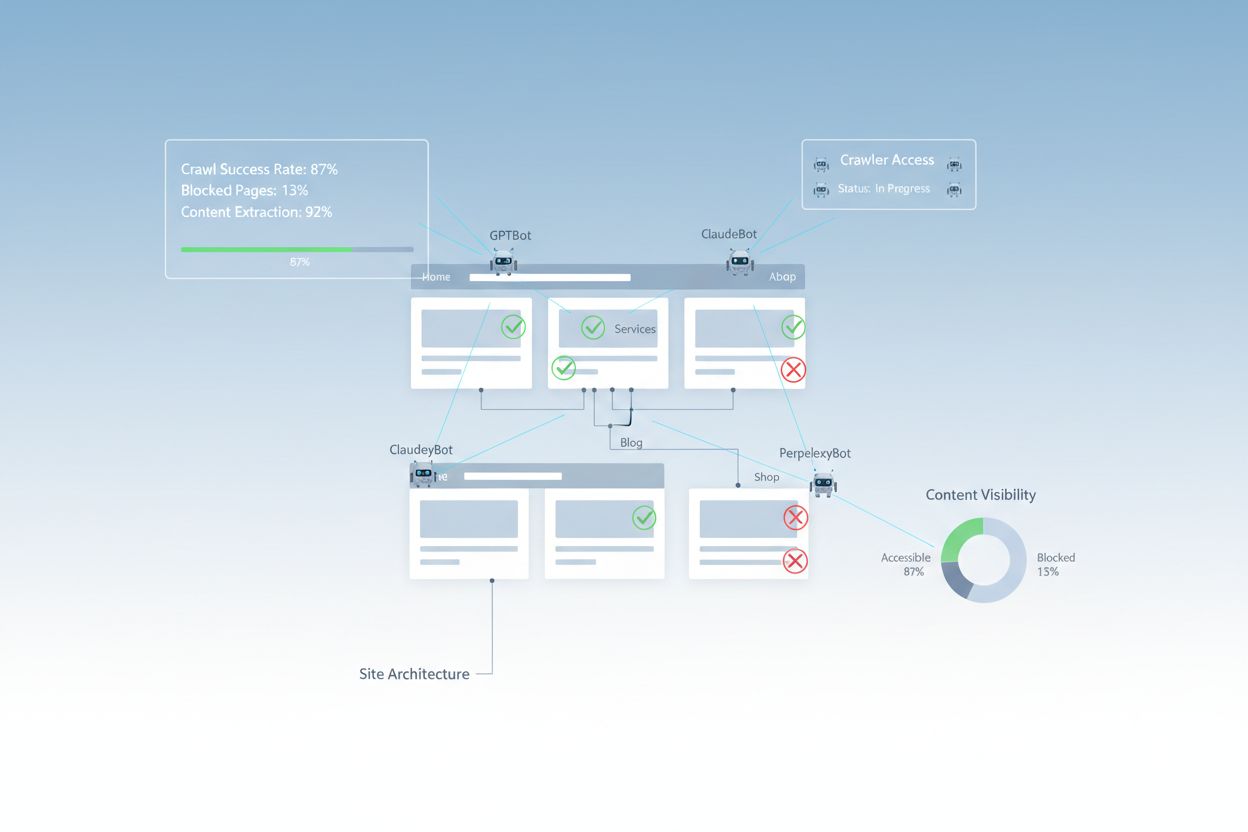

Un audit AI de accesibilitate cuprinzător examinează multiple elemente tehnice și structurale care influențează modul în care sistemele AI interacționează cu site-ul tău. Fiecare componentă joacă un rol distinct în determinarea vizibilității conținutului tău pe platformele de căutare alimentate de AI. Procesul de audit implică testarea crawlabilității, verificarea fișierelor de configurare, evaluarea structurii conținutului și monitorizarea comportamentului real al crawler-elor. Prin evaluarea sistematică a acestor componente, poți identifica bariere specifice și implementa soluții țintite pentru a-ți îmbunătăți vizibilitatea AI.

| Componentă | Scop | Impact asupra vizibilității AI |

|---|---|---|

| Configurație robots.txt | Controlează ce crawler-e pot accesa anumite secțiuni ale site-ului | Critic – O configurare greșită blochează complet crawler-ele AI |

| Sitemap-uri XML | Ghidează crawler-ele către paginile importante și structura conținutului | Ridicat – Ajută sistemele AI să prioritizeze și să descopere conținutul |

| Crawlabilitatea site-ului | Asigură accesul la pagini fără autentificare sau navigare complexă | Critic – Paginile blocate sunt invizibile pentru sistemele AI |

| Randare JavaScript | Determină dacă conținutul dinamic este vizibil crawler-elor | Critic – 60-90% din conținut poate fi ratat fără pre-randare |

| Extragere conținut | Evaluează cât de ușor pot sistemele AI să analizeze și să înțeleagă conținutul | Ridicat – Structura deficitară scade probabilitatea de citare |

| Configurația instrumentelor de securitate | Gestionează regulile de firewall și protecție ce influențează accesul crawler-elor | Critic – Regulile prea restrictive blochează boții AI legitimi |

| Implementare schema markup | Furnizează context lizibil pentru mașini despre conținut | Mediu – Îmbunătățește înțelegerea și probabilitatea de citare AI |

| Structura legăturilor interne | Stabilește relații semantice între pagini | Mediu – Ajută AI să înțeleagă autoritatea și relevanța subiectului |

Fișierul robots.txt este principalul mecanism de control pentru ce crawler-e pot accesa site-ul tău. Situat la rădăcina domeniului, acest fișier text simplu conține directive care le indică crawler-elor dacă li se permite accesul la anumite secțiuni ale site-ului. Pentru accesibilitatea AI, configurarea corectă a robots.txt este esențială deoarece reguli greșite pot bloca complet crawler-ele AI importante precum GPTBot (OpenAI), ClaudeBot (Anthropic) și PerplexityBot (Perplexity). Cheia este să permiți explicit acestor crawler-e în timp ce menții securitatea blocând boții rău intenționați și protejând zonele sensibile.

Exemplu de configurație robots.txt pentru crawler-ele AI:

# Permite toate crawler-ele AI

User-agent: GPTBot

User-agent: ChatGPT-User

User-agent: ClaudeBot

User-agent: Claude-Web

User-agent: PerplexityBot

User-agent: Google-Extended

Allow: /

# Blochează zonele sensibile

Disallow: /admin/

Disallow: /private/

Disallow: /api/

# Sitemap-uri

Sitemap: https://yoursite.com/sitemap.xml

Sitemap: https://yoursite.com/ai-sitemap.xml

Această configurație permite explicit crawler-elor AI importante accesul la conținutul public, protejând în același timp secțiunile administrative și private. Directivele Sitemap ajută crawler-ele să descopere rapid cele mai importante pagini ale tale.

Un sitemap XML funcționează ca o hartă pentru crawler-e, listând URL-urile pe care vrei să le indexeze și oferind metadate despre fiecare pagină. Pentru sistemele AI, sitemap-urile sunt deosebit de valoroase deoarece ajută crawler-ele să înțeleagă structura site-ului, să prioritizeze conținutul important și să descopere pagini care altfel ar putea fi omise prin crawling standard. Spre deosebire de motoarele de căutare tradiționale care pot deduce structura site-ului prin linkuri, crawler-ele AI beneficiază semnificativ de ghidarea explicită cu privire la ce pagini sunt cele mai relevante. Un sitemap bine structurat, cu metadate corecte, crește probabilitatea ca AI-ul să descopere, să înțeleagă și să citeze conținutul tău.

Exemplu de structură sitemap XML pentru optimizarea AI:

<?xml version="1.0" encoding="UTF-8"?>

<urlset xmlns="http://www.sitemaps.org/schemas/sitemap/0.9">

<!-- Conținut cu prioritate ridicată pentru crawler-ele AI -->

<url>

<loc>https://yoursite.com/about</loc>

<lastmod>2025-01-03</lastmod>

<priority>1.0</priority>

</url>

<url>

<loc>https://yoursite.com/products</loc>

<lastmod>2025-01-03</lastmod>

<priority>0.9</priority>

</url>

<url>

<loc>https://yoursite.com/blog/ai-guide</loc>

<lastmod>2025-01-02</lastmod>

<priority>0.8</priority>

</url>

<url>

<loc>https://yoursite.com/faq</loc>

<lastmod>2025-01-01</lastmod>

<priority>0.7</priority>

</url>

</urlset>

Atributul priority semnalizează crawler-elor AI ce pagini sunt cele mai importante, iar lastmod indică prospețimea conținutului. Acest lucru ajută sistemele AI să aloce eficient resursele de crawling și să înțeleagă ierarhia conținutului.

Dincolo de fișierele de configurare, mai multe bariere tehnice pot împiedica crawler-ele AI să acceseze eficient conținutul tău. Randarea JavaScript rămâne cea mai semnificativă provocare, deoarece framework-urile moderne precum React, Vue și Angular randază conținut dinamic în browser, lăsând crawler-ele AI cu HTML gol. Cloudflare și instrumente similare de securitate blochează adesea implicit crawler-ele AI, tratând volumele mari de cereri drept atacuri potențiale. Limitarea ratei poate împiedica indexarea completă, iar arhitectura complexă a site-ului și încărcarea dinamică a conținutului complică suplimentar accesul crawler-elor. Din fericire, există multiple soluții pentru depășirea acestor bariere.

Soluții pentru îmbunătățirea accesului crawler-elor AI:

Sistemele AI nu trebuie doar să acceseze conținutul tău—ele trebuie să-l și înțeleagă. Extragerea conținutului se referă la cât de eficient pot crawler-ele AI să analizeze, să înțeleagă și să extragă informații relevante din paginile tale. Acest proces depinde masiv de structura semantică HTML, care presupune folosirea ierarhiilor corecte de titluri, text descriptiv și o organizare logică. Când conținutul tău este bine structurat, cu titluri clare (H1, H2, H3), paragrafe descriptive și un flux logic, sistemele AI pot identifica mai ușor informațiile cheie și contextul. În plus, schema markup oferă metadate lizibile pentru mașini care indică explicit despre ce este conținutul tău, îmbunătățind semnificativ înțelegerea și probabilitatea de citare.

Structura semantică adecvată presupune și folosirea elementelor HTML semantice precum <article>, <section>, <nav> și <aside> în locul tag-urilor generice <div>. Acest lucru ajută sistemele AI să înțeleagă scopul și importanța diferitelor secțiuni de conținut. Combinate cu date structurate de tip schema pentru FAQ, Produs sau Organizație, paginile tale devin mult mai accesibile pentru AI, crescând șansele de a fi incluse în răspunsuri și rezultate generate de AI.

După implementarea îmbunătățirilor, trebuie să verifici dacă crawler-ele AI pot accesa efectiv conținutul tău și să monitorizezi performanța continuă. Jurnalele serverului oferă dovada directă a activității crawler-elor, arătând ce boți ți-au vizitat site-ul, ce pagini au accesat și dacă au întâmpinat erori. Google Search Console oferă date despre modul în care crawler-ele Google interacționează cu site-ul tău, iar instrumentele specializate de monitorizare a vizibilității AI urmăresc modul în care conținutul tău apare pe diverse platforme AI. AmICited.com monitorizează specific modul în care sistemele AI fac referire la brandul tău pe ChatGPT, Perplexity și Google AI Overviews, oferind vizibilitate asupra paginilor citate și a frecvenței acestora.

Instrumente și metode pentru monitorizarea accesului crawler-elor AI:

Optimizarea site-ului tău pentru accesul crawler-elor AI necesită o abordare strategică și continuă. În loc să tratezi accesibilitatea AI ca pe un proiect punctual, organizațiile de succes implementează procese de monitorizare și îmbunătățire continuă. Cea mai eficientă strategie combină o configurare tehnică corectă cu optimizarea conținutului, asigurând că atât infrastructura, cât și conținutul tău sunt pregătite pentru AI.

De făcut pentru accesibilitate AI:

De evitat pentru accesibilitate AI:

Cea mai de succes strategie de accesibilitate AI tratează crawler-ele ca parteneri în distribuția conținutului, nu ca amenințări de blocat. Asigurându-te că site-ul tău este tehnic solid, corect configurat și semantic clar, maximizezi șansele ca sistemele AI să descopere, să înțeleagă și să citeze conținutul tău în răspunsurile generate pentru utilizatori.

Auditurile de accesibilitate AI se concentrează pe structura semantică, conținutul lizibil de mașini și valoarea citării pentru sistemele AI, în timp ce auditurile SEO tradiționale pun accent pe cuvinte cheie, backlink-uri și clasamente în căutare. Auditurile AI examinează dacă crawler-ele pot accesa și înțelege conținutul, în timp ce auditurile SEO vizează factorii de clasare pentru rezultatele Google.

Verifică jurnalele serverului pentru user agent-uri de crawler AI precum GPTBot, ClaudeBot și PerplexityBot. Folosește Google Search Console pentru a monitoriza activitatea de crawling, testează fișierul robots.txt cu instrumente de validare și utilizează platforme specializate precum AmICited pentru a urmări modul în care sistemele AI fac referire la conținutul tău pe diferite platforme.

Cele mai frecvente bariere includ limitările de randare JavaScript (crawler-ele AI nu pot executa JavaScript), blocarea de către Cloudflare și alte instrumente de securitate (35% dintre site-urile enterprise blochează crawler-ele AI), limitarea ratei care împiedică indexarea completă, arhitectura complexă a site-ului și încărcarea dinamică a conținutului. Fiecare barieră necesită soluții diferite.

Majoritatea afacerilor beneficiază de permiterea accesului crawler-elor AI, deoarece acestea cresc vizibilitatea brandului în rezultatele căutărilor alimentate de AI și interfețele conversaționale. Totuși, decizia depinde de strategia ta de conținut, poziționarea competitivă și obiectivele de afaceri. Poți folosi robots.txt pentru a permite selectiv anumite crawler-e și a bloca altele, în funcție de nevoile tale.

Efectuează un audit complet trimestrial sau ori de câte ori faci modificări semnificative ale arhitecturii site-ului, strategiei de conținut sau configurației de securitate. Monitorizează continuu activitatea crawler-elor folosind jurnalele serverului și instrumente specializate. Actualizează robots.txt și sitemap-urile ori de câte ori lansezi secțiuni noi de conținut sau modifici structura URL-urilor.

Robots.txt este principalul tău mecanism de control al accesului crawler-elor AI. O configurare corectă permite explicit crawler-ele AI importante (GPTBot, ClaudeBot, PerplexityBot) în timp ce protejează zonele sensibile. Un robots.txt configurat greșit poate bloca complet crawler-ele AI, făcând conținutul tău invizibil pentru sistemele AI, indiferent de calitatea acestuia.

Deși optimizarea tehnică este importantă, poți îmbunătăți vizibilitatea AI și prin optimizarea conținutului—folosind structură semantică HTML, implementând schema markup, îmbunătățind legăturile interne și asigurând completitudinea conținutului. Totuși, barierele tehnice precum randarea JavaScript și blocarea de către instrumentele de securitate necesită de obicei soluții tehnice pentru accesibilitate AI completă.

Folosește analiza jurnalelor de server pentru a urmări activitatea crawler-elor, Google Search Console pentru statistici de crawling, validatoare robots.txt pentru a verifica configurația, validatoare schema markup pentru date structurate și platforme specializate precum AmICited pentru a monitoriza citările AI. Multe instrumente SEO precum Screaming Frog oferă și simularea crawler-elor pentru testarea accesibilității AI.

Urmărește modul în care ChatGPT, Perplexity, Google AI Overviews și alte sisteme AI fac referire la brandul tău cu AmICited. Primește informații în timp real despre vizibilitatea ta în căutările AI și optimizează-ți strategia de conținut.

Descoperă cele mai bune instrumente pentru verificarea accesibilității AI. Învață cum să monitorizezi accesul GPTBot, ClaudeBot și PerplexityBot la site-ul tău ...

Învață metodologia completă pas cu pas pentru a realiza un audit de vizibilitate AI. Descoperă cum să măsori mențiunile brandului, citările și vizibilitatea pe ...

Transformă constatările auditului tău de vizibilitate AI într-un plan de acțiune strategic. Află cum să prioritizezi remedierea problemelor, să construiești con...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.