Cum funcționează motoarele de căutare AI: Arhitectură, recuperare și generare

Află cum funcționează motoarele de căutare AI precum ChatGPT, Perplexity și Google AI Overviews. Descoperă LLM-uri, RAG, căutare semantică și mecanisme de recup...

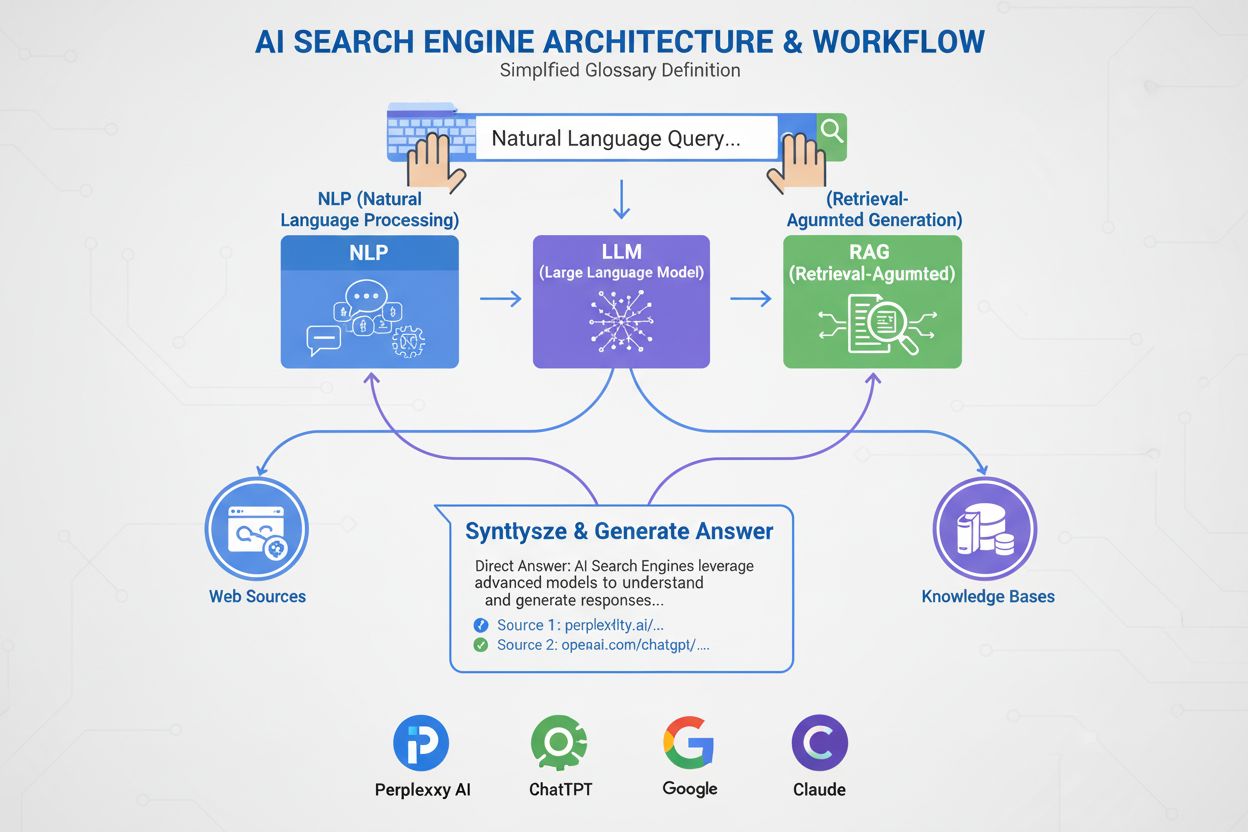

Un motor de căutare AI este o platformă care folosește inteligența artificială, procesarea limbajului natural și modele lingvistice mari pentru a interpreta interogările utilizatorilor și a genera răspunsuri directe, conversaționale, sintetizate din surse web, în loc să afișeze liste tradiționale de linkuri. Aceste platforme utilizează generarea augmentată prin recuperare (RAG) pentru a oferi informații actualizate, citate, cu acces web în timp real.

Un motor de căutare AI este o platformă care folosește inteligența artificială, procesarea limbajului natural și modele lingvistice mari pentru a interpreta interogările utilizatorilor și a genera răspunsuri directe, conversaționale, sintetizate din surse web, în loc să afișeze liste tradiționale de linkuri. Aceste platforme utilizează generarea augmentată prin recuperare (RAG) pentru a oferi informații actualizate, citate, cu acces web în timp real.

Un motor de căutare AI este o platformă care folosește inteligență artificială, procesare a limbajului natural (NLP) și modele lingvistice mari (LLM) pentru a interpreta interogările utilizatorilor și a genera răspunsuri directe, conversaționale, sintetizate din surse web. Spre deosebire de motoarele de căutare tradiționale care afișează liste de linkuri, motoarele de căutare AI oferă rezumate concise, în limbaj clar, care răspund direct intenției utilizatorului. Aceste platforme utilizează generarea augmentată prin recuperare (RAG) pentru a combina recuperarea web în timp real cu sinteza AI generativă, permițându-le să livreze informații actuale, citate. Motoarele de căutare AI reprezintă o schimbare fundamentală în modul în care oamenii descoperă informații online, trecând de la liste de linkuri bazate pe cuvinte cheie la înțelegere semantică și răspunsuri directe. Tehnologia care stă la baza acestor sisteme integrează multiple discipline AI—incluzând căutarea semantică, recunoașterea entităților și AI conversațională—pentru a crea o experiență de căutare mai intuitivă și mai eficientă.

Apariția motoarelor de căutare AI marchează o evoluție semnificativă în tehnologia de recuperare a informațiilor. Timp de decenii, motoarele de căutare au funcționat pe un model de potrivire a cuvintelor cheie, unde relevanța era determinată de prezența și frecvența termenilor de căutare în documentele indexate. Totuși, creșterea modelelor lingvistice mari și progresele în înțelegerea limbajului natural au schimbat fundamental posibilitățile. Piața globală a motoarelor de căutare AI a atins 15,23 miliarde USD în 2024 și este estimată să înregistreze o rată anuală compusă de creștere (CAGR) de 16,8% până în 2032, conform studiilor de piață. Această creștere explozivă reflectă atât adopția în mediul de afaceri, cât și cererea consumatorilor pentru experiențe de căutare mai inteligente, conversaționale.

AI generativă a remodelat modul în care oamenii descoperă informații online, ducând căutarea dincolo de lista clasică de linkuri albastre către răspunsuri directe, conversaționale. Lideri din industrie precum Google și Microsoft Bing au integrat rapid AI în platformele lor pentru a ține pasul cu stele emergente precum Perplexity și You.com. Conform cercetărilor McKinsey, aproximativ 50% dintre căutările Google au deja rezumate AI, procent care se estimează că va depăși 75% până în 2028. Această schimbare nu ține doar de interfață—ea redefinește strategia de conținut și optimizarea pentru motoare de căutare într-o nouă eră numită “optimizare pentru motoare generative” (GEO).

Tranziția reflectă o adoptare mai largă a tehnologiilor AI la nivel organizațional. 78% dintre organizații au raportat că folosesc AI în 2024, față de 55% în anul precedent, conform raportului AI Index al Stanford. Pentru specialiștii în căutare și marketing, acest lucru înseamnă că vizibilitatea depinde acum de înțelegerea modului în care sistemele AI analizează, condensează și reiau conținutul în rezumate în limbaj simplu. Provocarea este că răspunsurile generate AI adesea deturnează traficul de la site-urile originale, creând atât oportunități, cât și provocări pentru creatorii de conținut și brandurile care caută vizibilitate în acest nou peisaj.

Motoarele de căutare AI operează printr-o succesiune sofisticată de etape care combină recuperarea, clasificarea și sinteza. Procesul începe cu înțelegerea interogării, unde sistemul analizează inputul utilizatorului prin procesarea limbajului natural pentru a extrage semnificația, intenția și contextul. În loc să trateze interogarea ca pe un simplu șir de cuvinte cheie, sistemul creează mai multe reprezentări: o formă lexicală pentru recuperare exactă, o încorporare densă pentru căutarea semantică și o formă de entitate pentru potrivirea în grafuri de cunoștințe.

Odată ce interogarea este înțeleasă, majoritatea motoarelor de căutare AI folosesc generarea augmentată prin recuperare (RAG), un model arhitectural care abordează slăbiciunile fundamentale ale modelelor lingvistice mari. RAG realizează o etapă de recuperare live, căutând în indexuri web sau API-uri pentru a extrage documente și pasaje relevante. Acești candidați sunt apoi reclasificați folosind modele mai sofisticate care evaluează împreună interogarea și candidatul pentru a produce scoruri de relevanță rafinate. Rezultatele cel mai bine clasate sunt introduse într-un model lingvistic mare ca context de ancorare, care sintetizează un răspuns conversațional, menținând fidelitatea față de sursele recuperate.

Pipeline-urile de recuperare hibridă sunt standard pe platformele de top. Acestea combină căutarea lexicală (bazată pe cuvinte cheie, algoritmi precum BM25) cu căutarea semantică (bazată pe vectori, similaritate de încorporare). Căutarea lexicală excelează la precizie pentru potriviri exacte, termeni rari și entități denumite, în timp ce căutarea semantică excelează la acoperire pentru conținut relaționat conceptual. Prin combinarea ambelor abordări și aplicarea reclasificării cross-encoder, motoarele de căutare AI obțin o acuratețe mai mare decât oricare metodă singură. Etapa finală de sinteză folosește un model lingvistic mare pentru a compune un răspuns coerent, asemănător celui uman, care integrează informații din mai multe surse oferind și citări.

| Aspect | Motoare de căutare tradiționale | Motoare de căutare AI |

|---|---|---|

| Formatul rezultatelor | Liste de linkuri cu fragmente scurte | Rezumate conversaționale cu răspunsuri directe |

| Procesarea interogării | Potrivire și clasificare pe cuvinte cheie | Înțelegere semantică și analiză a intenției |

| Mecanism de învățare | Pornește de la zero la fiecare interogare | Învață continuu din interacțiuni și feedback |

| Recuperarea informațiilor | Potrivire lexicală/bazată pe cuvinte cheie | Hibrid (lexical + semantic + bazat pe entități) |

| Formate de intrare | Doar text | Text, imagini, voce și video (multimodal) |

| Actualizări în timp real | Pe bază de index, crawling periodic | Acces web în timp real prin RAG |

| Comportament citare | Fără citări; utilizatorii găsesc singuri sursele | Citări integrate și atribuirea sursei |

| Interacțiune utilizator | O singură interogare, rezultate statice | Conversații pe mai multe runde cu follow-up-uri |

| Gestionarea biasului | Curatorii organizează informația | Sinteza AI poate introduce bias de dezvoltator |

| Risc de halucinație | Scăzut (linkurile sunt factuale) | Ridicat (LLM-urile pot genera informații false) |

Diferite motoare de căutare AI implementează abordări arhitecturale distincte, fiecare cu implicații unice de optimizare. AI Overviews și AI Mode de la Google folosesc o strategie de query fan-out, unde o interogare de utilizator este spartă în mai multe subinterogări care vizează dimensiuni diferite ale intenției. Aceste subinterogări rulează în paralel pe diverse surse de date—indexul web, Knowledge Graph, transcrierile YouTube, feed-urile Google Shopping și indexuri specializate. Rezultatele sunt agregate, deduplicate și clasificate înainte de a fi sintetizate într-un overview. Pentru practicienii GEO, acest lucru înseamnă că un conținut trebuie să abordeze multiple fațete ale unei interogări, în mod extractibil, pentru a supraviețui procesului fan-out.

Bing Copilot reprezintă o abordare mai tradițională, nativă căutării, utilizând infrastructura matură de clasificare Bing și suprapunând sinteză de tip GPT peste ea. Platforma folosește recuperare dual-lane, combinând căutarea lexicală BM25 cu căutarea semantică pe vectori densi. Rezultatele trec printr-un reclasificator contextual cross-encoder ce se concentrează pe relevanța la nivel de pasaj, nu la nivel de pagină. Această arhitectură înseamnă că semnalele SEO clasice—crawlabilitate, taguri canonice, HTML curat, viteză de încărcare—contează în continuare semnificativ, deoarece determină ce candidați ajung în setul de ancorare. Bing Copilot pune accent și pe extractibilitate: pasaje cu structură clară, liste, tabele și formulări de tip definiție au șanse mai mari să fie citate.

Perplexity AI funcționează cu transparență intenționată, afișând sursele proeminent înaintea răspunsului generat. Platforma realizează căutări în timp real, adesea extrăgând atât din indexurile Google, cât și Bing, apoi evaluează candidații după o combinație de relevanță lexicală și semantică, autoritate tematică și extractibilitate a răspunsului. Cercetări care analizează 59 de factori ce influențează comportamentul de clasificare al Perplexity arată că platforma prioritizează formatarea cu răspuns direct—paginile care repetă explicit interogarea într-un heading, urmate imediat de un răspuns concis și dens informativ, sunt reprezentate disproporționat în seturile de citare. Prominența entităților și linking-ul joacă și ele un rol major; Perplexity favorizează pasaje unde entitățile-cheie sunt clar numite și contextual legate de concepte conexe.

ChatGPT Search adoptă o abordare oportunistă, generând interogări de căutare dinamic și apelând API-ul Bing pentru a extrage URL-uri specifice. Spre deosebire de platformele cu indexuri persistente, ChatGPT preia conținut în timp real, ceea ce înseamnă că includerea depinde exclusiv de recuperabilitatea în momentul interogării. Dacă un site este blocat de robots.txt, se încarcă greu, este ascuns în spatele randării pe client sau este opac semantic, nu va fi folosit în sinteză. Această arhitectură prioritizează accesibilitatea și claritatea: paginile trebuie să fie crawlable tehnic, ușoare și semnatic transparente astfel încât preluarea on-the-fly să ofere text curat, parsabil.

Procesarea limbajului natural (NLP) este tehnologia fundamentală care permite motoarelor de căutare AI să depășească potrivirea pe cuvinte cheie. NLP permite sistemelor să analizeze structura, semantica și intenția din spatele interogărilor, înțelegând contextul și recunoscând sinonime și concepte conexe. Când un utilizator întreabă „cele mai bune locuri de mâncat aproape de mine cu terasă”, un sistem alimentat de NLP înțelege că interogarea caută restaurante cu terasă, chiar dacă aceste cuvinte nu apar exact. Această înțelegere semantică permite motoarelor de căutare AI să ofere rezultate relevante chiar și când intenția nu este evidentă sau este formulată conversațional.

Modelele lingvistice mari (LLM) alimentează etapa de sinteză a motoarelor de căutare AI. Antrenate pe cantități vaste de date text, LLM-urile prezic următorul cuvânt logic pe baza contextului, permițându-le să producă texte coerente, corecte gramatical, foarte apropiate de cele scrise de oameni. Totuși, LLM-urile introduc și riscuri. Ele pot halucina—prezentând neadevăruri ca fapte—deoarece generează text din cunoștințe probabilistice, nu citând surse live. De aceea, generarea augmentată prin recuperare (RAG) este esențială: ancorând sinteza LLM-ului în surse proaspăt recuperate și autoritare, motoarele de căutare AI reduc riscul de halucinație și îmbunătățesc acuratețea faptică. Unele platforme au introdus citări linie cu linie pentru articole, pentru a contracara suplimentar halucinația, deși articolele citate nu sunt întotdeauna corecte și uneori nu există deloc.

Motoarele de căutare AI diferă de cele tradiționale în mai multe privințe fundamentale. În primul rând, ele oferă rezumate în loc de linkuri. Motoarele de căutare obișnuite afișează rezultatele ca liste de linkuri cu fragmente scurte, în timp ce cele AI generează rezumate concise care răspund direct, scutind utilizatorii de a căuta și accesa mai multe site-uri. În al doilea rând, căutarea AI învață în timp, în timp ce cea tradițională reia de la zero la fiecare interogare. Motoarele de căutare AI sunt construite pentru a învăța și a se adapta continuu la interacțiuni și date noi, îmbunătățindu-și performanța în timp. Motoarele tradiționale funcționează de fiecare dată de la zero, fără a ține cont de interogările sau interacțiunile anterioare.

În al treilea rând, căutarea AI se concentrează pe semantică, cea tradițională pe cuvinte cheie. Motoarele de căutare clasice interpretează interogările mai ales pe baza potrivirii de cuvinte cheie, în timp ce cele AI pun accent pe semantică—semnificația largă a cuvintelor în context. Astfel, motoarele de căutare AI pot înțelege mai bine intenția utilizatorului și oferi rezultate mai apropiate de ceea ce se caută. În al patrulea rând, căutarea AI acceptă mai multe formate de intrare, cea tradițională doar text. Unele motoare de căutare AI au capabilități multimodale, adică pot procesa și înțelege informații dincolo de text, precum imagini, video și audio. Aceasta oferă o experiență de căutare mai intuitivă și flexibilă decât tastarea de cuvinte cheie.

Ascensiunea motoarelor de căutare AI remodelează modul în care brandurile abordează vizibilitatea și strategia de conținut. În loc să concureze doar pentru clasamentele pe cuvinte cheie, editorii și companiile trebuie acum să țină cont de modul în care sistemele AI analizează, condensează și reiau conținutul lor în rezumate clare. Această schimbare a inaugurat o nouă eră a “optimizării pentru motoare generative” (GEO), unde scopul nu mai este doar să fii clasat, ci să fii recuperat, sintetizat și citat de sistemele AI.

Cercetările arată că performanța GEO a liderilor din industrie poate fi cu 20 până la 50 la sută mai slabă decât cea SEO, potrivit analizei McKinsey. Această diferență reflectă caracterul incipient al strategiilor GEO și complexitatea optimizării simultane pentru mai multe platforme AI. Pentru branduri, implicațiile sunt majore: vizibilitatea în căutarea AI depinde de faptul că un conținut este recuperabil (apare în rezultate), extractibil (structurat astfel încât sistemele AI să-l poată parsa și cita ușor) și de încredere (demonstrează expertiză, autoritate și credibilitate). Instrumente de monitorizare precum AmICited urmăresc acum mențiunile brandului pe platforme AI—incluzând Perplexity, ChatGPT, Google AI Overviews și Claude—pentru a măsura această nouă formă de vizibilitate și a identifica oportunități de optimizare.

Peisajul motoarelor de căutare AI evoluează rapid, cu implicații semnificative asupra modului în care informația este descoperită, distribuită și monetizată. Piața globală a motoarelor de căutare AI este estimată să crească cu un CAGR de 16,8% până în 2032, impulsionată de adoptarea în mediul de afaceri și cererea consumatorilor pentru experiențe conversaționale și inteligente de căutare. Pe măsură ce motoarele de căutare AI se maturizează, se estimează că vor apărea câteva tendințe-cheie.

În primul rând, consolidarea și specializarea se vor accelera. În timp ce platformele generaliste precum Google, Bing și Perplexity vor domina în continuare, motoare de căutare AI specializate pe verticale—legal, medical, tehnic, e-commerce—se vor înmulți. Aceste motoare specializate vor oferi expertiză mai profundă și sinteză mai precisă pentru interogări de nișă. În al doilea rând, mecanismele de citare și atribuire vor deveni mai sofisticate și standardizate. Odată cu creșterea presiunii regulatorii și a cerințelor publisherilor pentru atribuire clară, motoarele de căutare AI vor implementa sisteme de citare mai granulare ce vor facilita trasabilitatea și măsurarea vizibilității de către publisheri.

În al treilea rând, definiția și măsurarea „vizibilității” se vor schimba fundamental. În era SEO tradițională, vizibilitatea însemna poziția în clasament și rata de click. În era GEO, vizibilitatea înseamnă a fi recuperat, sintetizat și citat—metrice ce impun noi cadre de măsurare și instrumente. AmICited și platforme similare inovează acest spațiu de măsurare, urmărind mențiuni ale brandurilor pe mai multe platforme AI și oferind insight-uri despre cât de des și în ce context apar brandurile în răspunsurile AI.

În al patrulea rând, tensiunea dintre căutarea AI și cea tradițională se va accentua. Pe măsură ce motoarele de căutare AI captează mai multă atenție și trafic, cele tradiționale vor fi forțate să evolueze sau să riște irelevanța. Integrarea AI în produsul principal de căutare Google reprezintă un răspuns strategic la această amenințare, dar câștigătorul pe termen lung rămâne incert. Publisherii și brandurile trebuie să optimizeze atât pentru căutarea tradițională, cât și pentru cea AI, ceea ce complică și intensifică strategia de conținut.

În final, încrederea și acuratețea vor deveni esențiale. Pe măsură ce motoarele de căutare AI devin surse primare de informație, miza pentru acuratețe și reducerea biasului va crește. Vor apărea probabil cadre de reglementare privind transparența și responsabilitatea AI, cerând motoarelor de căutare să dezvăluie datele de antrenament, factorii de clasificare și metodologiile de citare. Pentru branduri și publisheri, asta înseamnă că semnalele E-E-A-T—expertiză, experiență, autoritate și încredere—vor deveni și mai critice pentru vizibilitatea atât în căutarea tradițională, cât și în cea AI.

+++ showCTA = true ctaHeading = “Monitorizează vizibilitatea brandului tău în motoarele de căutare AI” ctaDescription = “Înțelegerea motoarelor de căutare AI este doar primul pas. Urmărește unde și cum apare brandul tău în ChatGPT, Perplexity, Google AI Overviews și Claude cu platforma de monitorizare AI search AmICited. Măsoară performanța GEO, identifică oportunități de citare și optimizează-ți conținutul pentru noua generație de căutare.” ctaPrimaryText = “Contactează-ne” ctaPrimaryURL = “/contact/” ctaSecondaryText = “Încearcă acum” ctaSecondaryURL = “https://app.amicited.com ” +++

Motoarele de căutare tradiționale afișează rezultatele sub formă de liste de linkuri cu fragmente, în timp ce motoarele de căutare AI generează rezumate conversaționale care răspund direct la interogări. Motoarele de căutare AI folosesc procesarea limbajului natural și modele lingvistice mari pentru a înțelege semantic intenția utilizatorului, nu doar potrivirea pe cuvinte cheie. Ele învață continuu din interacțiunile utilizatorilor și pot procesa mai multe formate de intrare, inclusiv text, imagini și voce. În plus, motoarele de căutare AI oferă adesea acces web în timp real prin generarea augmentată prin recuperare (RAG), permițându-le să furnizeze informații actualizate cu citări ale surselor.

Generarea augmentată prin recuperare (RAG) este o tehnică ce permite modelelor lingvistice mari să recupereze și să încorporeze informații proaspete din surse externe înainte de a genera răspunsuri. RAG abordează limitările fundamentale ale modelelor LLM—halucinații și lipsa de actualitate—ancorând răspunsurile în date recuperate în timp real. În motoarele de căutare AI, RAG funcționează printr-un prim pas de căutare sau recuperare live, extrăgând documente sau fragmente relevante, apoi sintetizând un răspuns bazat pe acele elemente recuperate. Această abordare asigură că răspunsurile sunt actuale și pot fi urmărite până la surse specifice, făcând posibilă citarea și îmbunătățind acuratețea faptică.

Motoarele de căutare AI de top includ Perplexity (cunoscut pentru citările transparente), ChatGPT Search (bazat pe GPT-4o cu acces web în timp real), Google Gemini și AI Overviews (integrate în infrastructura de căutare Google), Bing Copilot (bazat pe indexul Bing al Microsoft) și Claude (modelul Anthropic cu căutare web selectivă). Perplexity prioritizează recuperarea în timp real și atribuirea vizibilă a surselor, în timp ce ChatGPT generează interogări de căutare oportunist. Abordarea Google folosește query fan-out pentru a acoperi mai multe dimensiuni ale intenției, iar Bing CoPilot combină semnale SEO tradiționale cu sinteză generativă. Fiecare platformă are arhitecturi de recuperare, comportamente de citare și cerințe de optimizare distincte.

Motoarele de căutare AI urmează un proces cu mai multe etape: mai întâi, analizează interogarea utilizatorului prin procesarea limbajului natural pentru a înțelege intenția; apoi, recuperează documente sau pasaje relevante din indexuri web sau API-uri folosind recuperare hibridă (combinând căutarea lexicală și semantică); ulterior, reevaluează candidații pe baza relevanței și extractibilității; și, în final, sintetizează un răspuns conversațional folosind un model lingvistic mare, inserând citări către documentele sursă. Mecanismul de citare variază în funcție de platformă—unele afișează citări inline, altele prezintă liste de surse, iar unele integrează citările direct în textul răspunsului. Calitatea și acuratețea citărilor depind de cât de bine se potrivesc fragmentele recuperate cu afirmațiile sintetizate.

Optimizarea pentru motoare generative (GEO) este practica de optimizare a conținutului și vizibilității brandului special pentru motoarele de căutare AI, spre deosebire de SEO tradițional care vizează clasamentele pe cuvinte cheie în rezultatele bazate pe linkuri. GEO se concentrează pe a face conținutul recuperabil, extractibil și citabil de către sistemele AI. Strategiile-cheie GEO includ structurarea conținutului pentru claritate și răspunsuri directe, folosirea unui limbaj natural care să corespundă intenției utilizatorului, implementarea markup-ului pentru entități și schema, asigurarea încărcării rapide a paginii și construirea autorității tematice. Conform cercetării McKinsey, aproximativ 50% dintre căutările Google au deja rezumate AI, procentul urmând să depășească 75% până în 2028, făcând GEO tot mai esențial pentru vizibilitatea brandului.

Motoarele de căutare AI pot atât crește, cât și scădea traficul site-urilor în funcție de modul de optimizare a conținutului. Când conținutul este citat în răspunsuri generate AI, acesta câștigă vizibilitate și credibilitate, dar utilizatorii pot primi răspunsul direct fără a accesa sursa. Cercetările arată că AI Overviews poate deturna trafic de la site-urile originale, deși oferă și atribuiri și linkuri către sursă. Pentru branduri, această schimbare înseamnă că vizibilitatea depinde acum de a fi recuperat, sintetizat și citat de sistemele AI—nu doar de clasarea în rezultatele tradiționale. Instrumente precum AmICited monitorizează mențiunile brandului pe platforme AI (Perplexity, ChatGPT, Google AI Overviews, Claude) pentru a măsura această nouă formă de vizibilitate și a optimiza în consecință.

Procesarea limbajului natural (NLP) este fundamentală pentru modul în care motoarele de căutare AI înțeleg și procesează interogările utilizatorilor. NLP permite sistemelor să analizeze structura, semantica și intenția din spatele interogărilor, nu doar potrivirea pe cuvinte cheie. Permite motoarelor de căutare AI să înțeleagă contextul, să dezambiguizeze sensul și să recunoască sinonime și concepte înrudite. NLP alimentează și etapa de sinteză, unde modelele lingvistice generează răspunsuri coerente, corecte gramatical și naturale pentru utilizatori. În plus, NLP ajută motoarele de căutare AI să extragă și să structureze informații din paginile web, identificând entități-cheie, relații și afirmații ce pot fi incluse în răspunsurile generate.

Motoarele de căutare AI gestionează informațiile în timp real prin generarea augmentată prin recuperare (RAG), care efectuează căutări live sau apeluri API pentru a prelua date actuale la momentul interogării, nu doar pe baza datelor de antrenament. Platforme precum Perplexity și modul AI al Google interoghează web-ul în timp real, asigurând că răspunsurile reflectă cele mai recente informații. ChatGPT folosește API-ul de căutare Bing pentru a accesa conținut web actual atunci când browsing-ul este activat. Semnalele de actualitate sunt integrate și în algoritmii de clasare—paginile cu date recente de publicare și conținut actualizat sunt prioritizate pentru interogările sensibile la timp. Totuși, unele motoare de căutare AI se bazează parțial pe date de antrenament, care pot rămâne în urmă față de evenimentele reale, ceea ce face ca recuperarea în timp real să fie un diferențiator cheie între platforme.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Află cum funcționează motoarele de căutare AI precum ChatGPT, Perplexity și Google AI Overviews. Descoperă LLM-uri, RAG, căutare semantică și mecanisme de recup...

Află cum să trimiți și să optimizezi conținutul tău pentru motoarele de căutare AI precum ChatGPT, Perplexity și Gemini. Descoperă strategii de indexare, cerinț...

Află cum funcționează indexurile de căutare AI, diferențele dintre metodele de indexare ChatGPT, Perplexity și SearchGPT și cum să optimizezi conținutul pentru ...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.