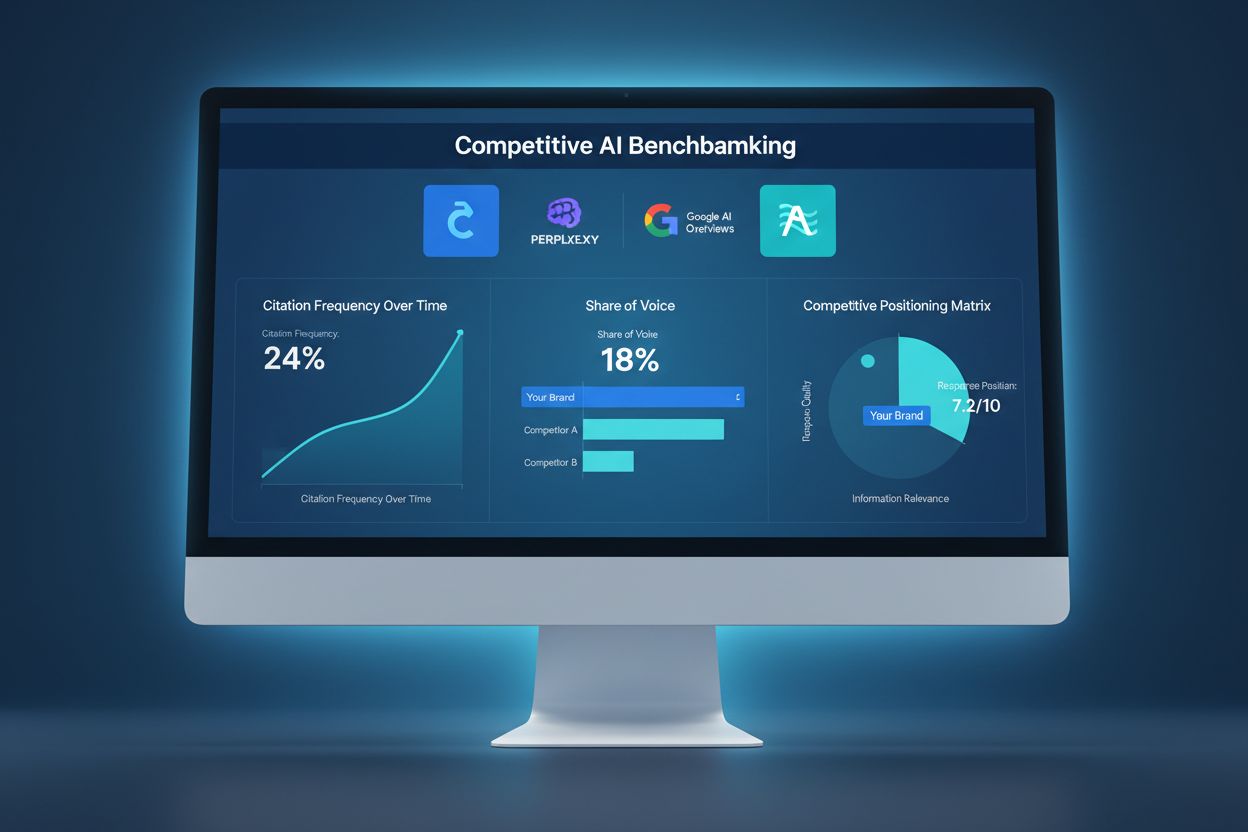

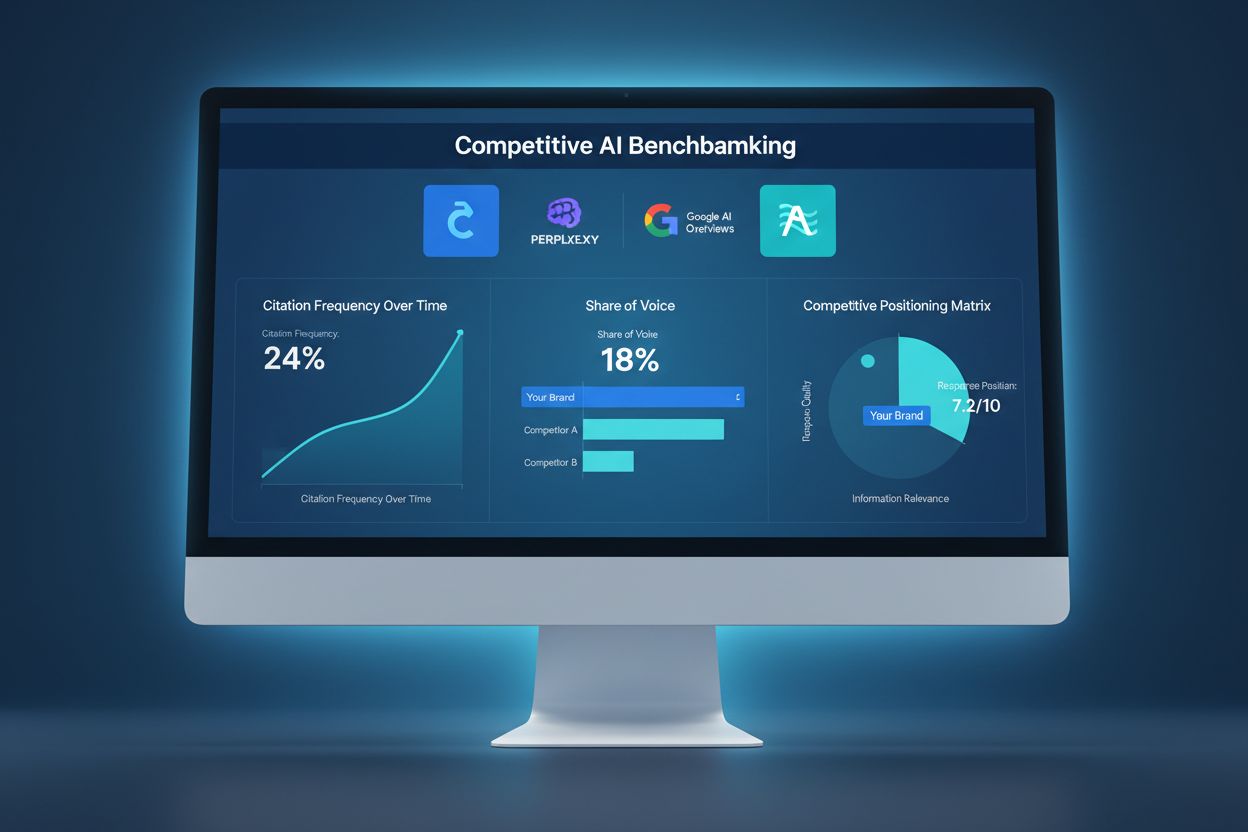

Benchmarking competitiv AI

Află cum să benchmarchezi vizibilitatea AI a brandului tău față de competitori. Urmărește citările, cota de voce și poziționarea competitivă pe ChatGPT, Perplex...

Sabotajul AI competitiv se referă la încercări deliberate ale concurenților de a influența negativ vizibilitatea, sentimentul sau performanța unui brand în rezultatele căutărilor alimentate de AI și în răspunsurile chatbot-urilor. Acestea includ otrăvirea datelor, recenzii false, campanii de dezinformare și manipularea datelor de antrenament AI pentru a deteriora reputația brandului și a reduce citările AI.

Sabotajul AI competitiv se referă la încercări deliberate ale concurenților de a influența negativ vizibilitatea, sentimentul sau performanța unui brand în rezultatele căutărilor alimentate de AI și în răspunsurile chatbot-urilor. Acestea includ otrăvirea datelor, recenzii false, campanii de dezinformare și manipularea datelor de antrenament AI pentru a deteriora reputația brandului și a reduce citările AI.

Sabotajul AI competitiv se referă la încercări deliberate de a manipula, otrăvi sau corupe datele pe care motoarele de căutare AI și modelele de limbaj le utilizează pentru a genera rezultate și citări. Spre deosebire de SEO negativ tradițional, care se concentrează pe deteriorarea pozițiilor unui site concurent prin scheme de link-uri sau exploatări tehnice, sabotajul AI vizează datele de antrenament și sursele pe care sistemele AI se bazează pentru a oferi răspunsuri. Această distincție este crucială, deoarece sistemele AI precum Google AI Overviews, Perplexity și GPTs citează surse direct din datele de antrenament, devenind vulnerabile la campanii coordonate de dezinformare. Impactul în lumea reală este substanțial: cu 60% dintre căutări încheiate fără a accesa site-uri web, concurenții pot otrăvi acum rezultatele AI pentru a redirecționa traficul, a deteriora reputația brandului sau a promova informații false fără a afecta pozițiile tradiționale în căutare.

Sabotajul AI competitiv operează prin mai multe vectori de atac interconectați care exploatează modul în care sistemele AI preiau și procesează informații. Otrăvirea datelor este tehnica principală, implicând injectarea de informații false, înșelătoare sau malițioase în surse folosite de AI pentru antrenament—precum baze de date publice, forumuri, site-uri de recenzii și agregatoare de știri. Atacatorii folosesc label flipping (modificarea metadatelor pentru clasificare greșită), injectarea de date (adăugarea de intrări false în seturi de date) și atacuri backdoor (inserarea de declanșatoare ascunse în datele de antrenament). Concurenții lansează și campanii coordonate de recenzii false, inundând platformele cu testimoniale fabricate, și răspândesc dezinformări și deepfake-uri prin social media, bloguri și conținut indexat de AI. Vulnerabilitatea constă în faptul că sistemele AI au tendința de a avea încredere în volumul și consistența informațiilor, mai degrabă decât să le verifice autenticitatea. Iată cum se compară diferite metode de sabotaj:

| Metodă | Cum funcționează | Impact asupra AI | Dificultatea de detectare |

|---|---|---|---|

| Otrăvirea datelor | Injectarea de informații false în datele de antrenament | AI citează direct sursele otrăvite în rezultate | Mare - necesită analiză de date |

| Recenzii false | Bombardament coordonat de recenzii pe platforme | Deformează analiza de sentiment și recomandările AI | Medie - analiza tiparelor ajută |

| Campanii de dezinformare | Răspândirea afirmațiilor false pe site-uri indexate | AI amplifică narațiuni false în rezultate | Mare - necesită fact-checking |

| Deepfake-uri | Crearea de media sintetică cu directori sau produse | Deteriorează credibilitatea brandului când sunt citate de AI | Foarte mare - necesită verificare |

| Deturnarea directoarelor | Reclamarea listărilor de afaceri ale concurenților | AI preia informații false din directoare deturnate | Medie - verificările ajută |

| Articole de știri false | Publicarea de povești fabricate pe site-uri asemănătoare cu cele de știri | AI le tratează ca surse autoritare | Mare - necesită verificarea sursei |

Sistemele AI sunt fundamental mai vulnerabile la sabotaj decât motoarele de căutare tradiționale deoarece au o încredere mai implicită în datele de antrenament decât oamenii. În timp ce algoritmul Google evaluează autoritatea link-urilor și reputația domeniului, modelele AI învață pur și simplu tipare din orice date sunt antrenate—făcându-le susceptibile la atacuri coordonate. Cercetările arată că doar 250 de documente malițioase pot otrăvi un model AI, un prag mult mai scăzut decât în atacurile SEO tradiționale. Problema este agravată de faptul că sistemele AI citează direct surse, ceea ce înseamnă că datele otrăvite nu doar influențează rezultatele—ci devin răspunsul autoritar pe care îl văd utilizatorii. Detectarea datelor otrăvite este exponențial mai dificilă decât identificarea unui backlink rău, deoarece manipularea are loc la nivel de antrenament, adesea invizibilă pentru audituri externe. Cu traficul căutărilor AI crescând cu 527% în doar cinci luni (ianuarie-mai 2025) și 79% dintre americani având încredere în motoarele de căutare AI, motivația pentru sabotaj este mai mare ca niciodată, în timp ce infrastructura de securitate pentru prevenție rămâne subdezvoltată.

Cel mai notabil exemplu de sabotaj AI a avut loc când Target a fost victima unei campanii coordonate de dezinformare care pretindea fals că retailerul vinde haine pentru copii cu tematică „satanică”. Sistemele AI, antrenate pe această narațiune fabricată, au început să afișeze aceste afirmații false în rezultate și în sumarizările AI, cauzând daune reputaționale semnificative înainte ca firma să poată reacționa. Sisteme de email au experimentat atacuri similare prin otrăvirea filtrelor de spam, unde concurenții injectează tipare malițioase în datele de antrenament pentru a face ca emailuri legitime să fie marcate ca spam. Bombardamentul cu recenzii negative de la concurenți a devenit din ce în ce mai frecvent, companiile inundând listările rivalilor cu recenzii negative false pe care AI le agregă în scoruri de sentiment. Deturnarea listărilor din directoare reprezintă un alt vector, unde atacatorii reclamă profilurile de afaceri ale concurenților pe platforme precum Google My Business sau directoare de industrie, apoi introduc informații false pe care sistemele AI le indexează și le citează. Aceste cazuri demonstrează că sabotajul AI nu este teoretic—dăunează activ afacerilor în prezent, iar paguba este amplificată deoarece rezultatele AI par autoritare și sunt deseori prima informație cu care se confruntă utilizatorii.

Detectarea sabotajului AI competitiv necesită o abordare de monitorizare pe mai multe niveluri care urmărește modul în care brandul tău apare în rezultatele AI și în sursele citate. Primul pas este monitorizarea continuă a rezultatelor AI pentru brandul tău, produse și principalii directori pe platforme precum Google AI Overviews, Perplexity, ChatGPT și Claude. Urmărirea sentimentului în sursele indexate ajută la identificarea schimbărilor bruște privind modul în care este discutat brandul tău—un semnal de alarmă pentru campanii coordonate de dezinformare. Identificarea recenziilor false implică analizarea tiparelor pentru anomalii statistice, precum creșteri bruște de ratinguri de o stea sau recenzii cu limbaj identic. Detectarea timpurie este esențială; cercetările arată că primele 48 de ore după declanșarea unui atac de sabotaj sunt cruciale pentru control și răspuns. Monitorizarea trebuie să urmărească și ce surse citează sistemele AI despre brandul tău, permițând identificarea datelor otrăvite înainte de a produce daune pe scară largă. Iată principalele metode de detectare:

Construirea rezilienței împotriva sabotajului AI competitiv necesită o strategie proactivă și multifacetică ce depășește managementul reputației tradiționale. Crearea de conținut de calitate și autoritar este cea mai puternică apărare—aI-urile sunt antrenate să recunoască și să prioritizeze conținutul de la surse consacrate și credibile, făcând mai dificilă competiția datelor otrăvite cu informațiile legitime. Amplificarea informațiilor corecte pe mai multe platforme indexate asigură că, atunci când AI caută despre brandul tău, găsește narațiuni consecvente și adevărate din surse autoritare. Asigura-ți prezența brandului prin revendicarea și verificarea tuturor listărilor de afaceri, profilurilor social media și directoarelor de industrie pentru a preveni deturnările. Implementează sisteme robuste de monitorizare care urmăresc brandul tău în timp real în rezultatele AI, permițând reacții rapide la amenințări emergente. Dezvoltă protocoale de răspuns care să prevadă reacțiile echipei la detectarea sabotajului, incluzând documentarea, raportarea pe platforme și acțiunea legală când este cazul. Construirea de relații cu jurnaliști, influenceri din industrie și publicații de încredere oferă straturi suplimentare de credibilitate recunoscute și prioritizate de AI.

Platformele dedicate monitorizării AI au devenit infrastructură esențială pentru protecția brandurilor în era căutărilor AI. Aceste instrumente oferă alerte în timp real când brandul tău apare în rezultate AI, permițându-ți să urmărești nu doar pozițiile, ci și citările reale și sursele folosite de AI. AmICited.com se remarcă drept o soluție completă, special concepută pentru monitorizarea modului în care brandul, produsele și directorii tăi sunt citați în motoarele AI, inclusiv Google AI Overviews, Perplexity și GPTs. Platforma urmărește ce surse citează AI despre brandul tău, permițând identificarea rapidă a datelor otrăvite și reacția înainte de a produce daune pe scară largă. Integrarea cu strategia generală de siguranță a brandului îți permite să corelezi tiparele de citare AI cu metrici tradiționali de căutare, sentiment social media și platforme de recenzii, pentru o imagine completă a peisajului competitiv. Combinând monitorizarea AI cu instrumentele existente de management al reputației, creezi un sistem de apărare unificat care identifică timpuriu încercările de sabotaj și oferă datele necesare pentru reacție rapidă.

Pe măsură ce sabotajul AI competitiv devine tot mai răspândit, cadrul legal evoluează pentru a aborda aceste noi amenințări. Notificările DMCA pot fi folosite pentru a elimina conținutul otrăvit din sursele indexate, deși procesul este adesea lent și necesită dovezi clare de încălcare a drepturilor de autor sau de uzurpare. Legea defăimării oferă căi de atac când sabotajul presupune afirmații false ce dăunează reputației, deși dovedirea prejudiciului în context AI rămâne complexă. Majoritatea platformelor importante au acum mecanisme de raportare dedicate abuzului AI, incluzând otrăvirea datelor, recenzii false și campanii de dezinformare, deși aplicarea lor diferă semnificativ. Reglementări emergente precum EU AI Act și legislația propusă în SUA încep să stabilească cadre de răspundere pentru sistemele AI care amplifică informații false, creând potențial noi căi de acțiune legală. Companiile ar trebui să documenteze amănunțit toate încercările de sabotaj, deoarece aceste dovezi devin critice atât pentru proceduri legale, cât și pentru apeluri pe platforme. Consultarea cu avocați specializați în AI și reputație digitală devine din ce în ce mai importantă pentru dezvoltarea strategiilor de răspuns conforme cu reglementările în schimbare.

Peisajul sabotajului AI competitiv va continua să evolueze pe măsură ce atât atacatorii, cât și apărătorii dezvoltă tehnici tot mai sofisticate. Recenziile false generate de AI cu modele lingvistice mari vor fi din ce în ce mai greu de diferențiat de feedback-ul autentic, necesitând sisteme de detectare avansate. Verificarea pe blockchain și sistemele descentralizate de credibilitate apar ca soluții potențiale pentru verificarea autenticității surselor înainte ca AI să includă datele în seturile de antrenament. Furnizorii de platforme investesc masiv în apărări îmbunătățite, inclusiv validare mai bună a datelor, verificarea surselor și algoritmi de detectare a otrăvirii, deși aceste măsuri vor fi mereu în urma noilor vectori de atac. Sistemele de verificare bazate pe comunitate unde utilizatorii și experții semnalează conținutul suspect ar putea deveni practică standard, creând o apărare colectivă împotriva sabotajului. Avantajul competitiv va aparține din ce în ce mai mult companiilor care se mențin în fața amenințărilor emergente prin monitorizare continuă, protocoale rapide de reacție și investiții în alfabetizarea AI la nivel de echipă. Organizațiile care tratează monitorizarea AI ca parte fundamentală a strategiei de protecție a brandului vor fi cel mai bine poziționate să se apere împotriva atacurilor sofisticate ale viitorului.

SEO negativ tradițional vizează poziționările în motoarele de căutare prin manipularea link-urilor și copierea conținutului. Sabotajul AI competitiv vizează datele de antrenament AI și comportamentul modelelor, otrăvind sursele pe care sistemele AI le citează în răspunsuri. Sistemele AI sunt mai vulnerabile deoarece citează direct surse și au încredere mai mare în datele de antrenament decât algoritmii de căutare tradiționali.

Monitorizează săptămânal cum descriu platformele AI brandul tău, folosind instrumente precum AmICited.com. Fii atent la schimbări bruște de sentiment, afirmații false apărute în răspunsurile AI, campanii coordonate de recenzii negative sau dezinformare răspândită pe platforme. Detectarea timpurie, în primele 48 de ore, este esențială pentru limitarea efectelor.

Documentează totul imediat cu capturi de ecran și marcaje temporale. Raportează la platformele afectate (OpenAI, Google, Anthropic). Amplifică informațiile corecte prin canalele tale. Contactează un avocat dacă s-au produs defăimări sau prejudicii financiare. Implementează sisteme de monitorizare pentru a detecta rapid viitoare atacuri.

Cercetările arată că atacatorii au nevoie de doar 250 de documente malițioase sau 7-8% dintr-un set de date pentru a otrăvi semnificativ modelele AI. Această barieră scăzută face sistemele AI deosebit de vulnerabile comparativ cu motoarele de căutare tradiționale, care au mecanisme mai sofisticate de detectare a spamului.

Platformele AI actuale au capacități limitate de detectare și se bazează în principal pe raportările utilizatorilor și reantrenare periodică cu date curate. Totuși, platformele implementează sisteme mai bune de verificare, detectare a anomaliilor și control al accesului. Responsabilitatea pentru detectarea timpurie cade adesea pe branduri.

Construiește o reputație autentică puternică cu conținut de calitate, monitorizează regulat rezultatele de căutare AI, asigură-ți prezența brandului în directoare, implementează sisteme de monitorizare în timp real și reacționează rapid la atacuri. Prevenția prin construirea reputației este mai eficientă decât remedierea după ce sabotajul a avut loc.

AmICited.com monitorizează modul în care platformele AI (ChatGPT, Perplexity, Google AI Overviews) fac referire la brandul tău, urmărind schimbările de sentiment și tiparele de citare. Alerta în timp real te notifică la modificări bruște privind modul în care AI descrie brandul tău, permițând reacții rapide la posibile încercări de sabotaj.

Poți iniția acțiuni pentru defăimare, poți depune notificări DMCA pentru înlăturarea conținutului fals, raporta la platforme pentru încălcarea termenilor de utilizare și, eventual, solicita despăgubiri pentru prejudicii financiare. Documentarea sabotajului este esențială. Consultă un avocat specializat în drepturi digitale și proprietate intelectuală.

Protejează-ți brandul de sabotajul AI competitiv cu monitorizare în timp real pe ChatGPT, Perplexity și Google AI Overviews. Detectează amenințările înainte să-ți afecteze reputația.

Află cum să benchmarchezi vizibilitatea AI a brandului tău față de competitori. Urmărește citările, cota de voce și poziționarea competitivă pe ChatGPT, Perplex...

Află ce înseamnă canibalizarea conținutului în căutarea AI, cum îți afectează vizibilitatea brandului în răspunsurile AI și de ce este important să monitorizezi...

Află ce este Inteligența Competitivă AI și cum poți monitoriza vizibilitatea competitorilor pe ChatGPT, Perplexity și Google AI Overviews. Urmărește citările, p...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.