Fereastră de context

Fereastra de context explicată: numărul maxim de tokeni pe care un LLM îi poate procesa simultan. Află cum influențează ferestrele de context acuratețea AI, hal...

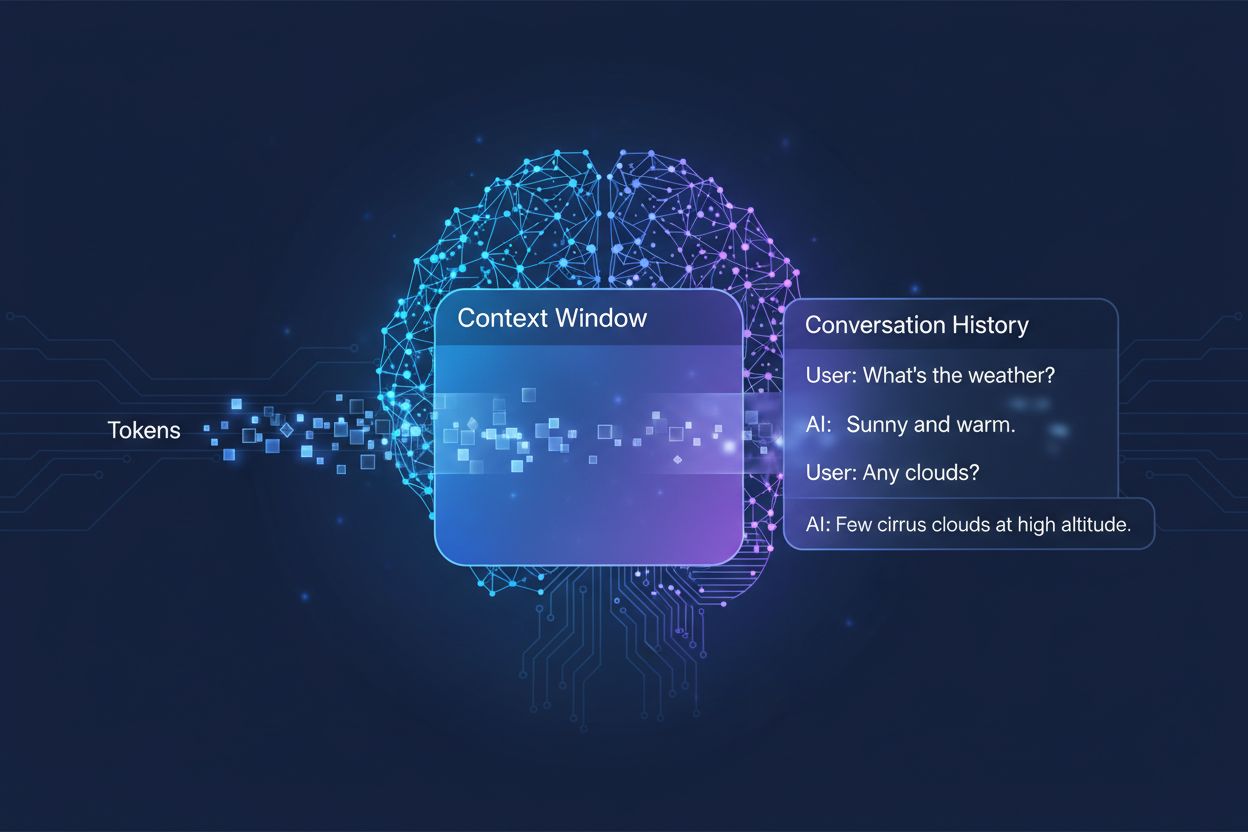

Cantitatea de conversație anterioară pe care un sistem AI o ia în considerare când generează răspunsuri, măsurată în tokeni. Ea determină cât text poate procesa AI-ul simultan și influențează direct calitatea și coerența rezultatelor sale în conversații cu mai multe schimburi.

Cantitatea de conversație anterioară pe care un sistem AI o ia în considerare când generează răspunsuri, măsurată în tokeni. Ea determină cât text poate procesa AI-ul simultan și influențează direct calitatea și coerența rezultatelor sale în conversații cu mai multe schimburi.

O fereastră de context reprezintă cantitatea maximă de text pe care un model lingvistic AI o poate procesa și la care poate face referire simultan, în timpul unei conversații sau sarcini. Gândește-te la ea ca la memoria de lucru a modelului — așa cum oamenii pot păstra doar o cantitate limitată de informație în conștiința lor imediată, modelele AI pot „vedea” doar o anumită cantitate de text înainte și după poziția curentă. Această capacitate este măsurată în tokeni, care sunt unități mici de text ce reprezintă, de obicei, cuvinte sau fragmente de cuvinte (în medie, un cuvânt englezesc echivalează cu aproximativ 1,5 tokeni). Înțelegerea ferestrei de context a modelului tău este crucială deoarece determină direct câtă informație poate lua în considerare AI-ul la generarea răspunsurilor, fiind o constrângere fundamentală în modul în care modelul poate gestiona conversații complexe cu mai multe schimburi sau documente lungi.

Modelele lingvistice moderne, în special cele cu arhitectură de tip transformer, procesează textul convertindu-l în tokeni și analizând simultan relațiile dintre toți tokenii din fereastra de context. Arhitectura transformer, introdusă în lucrarea fundamentală din 2017 „Attention is All You Need”, folosește un mecanism numit self-attention pentru a determina care părți ale intrării sunt cele mai relevante unele pentru altele. Acest mecanism permite modelului să cântărească importanța diferiților tokeni între ei, permițându-i să înțeleagă contextul și semnificația pe întregul interval. Totuși, acest proces devine costisitor computațional pe măsură ce fereastra de context crește, deoarece mecanismul de atenție trebuie să calculeze relațiile dintre fiecare token și fiecare alt token — o problemă cu scalare pătratică. Tabelul următor ilustrează cum se compară diferite modele AI de vârf în ceea ce privește capacitățile ferestrei de context:

| Model | Fereastră de Context (Tokeni) | Data Lansării |

|---|---|---|

| GPT-4 | 128.000 | Martie 2023 |

| Claude 3 Opus | 200.000 | Martie 2024 |

| Gemini 1.5 Pro | 1.000.000 | Mai 2024 |

| GPT-4 Turbo | 128.000 | Noiembrie 2023 |

| Llama 2 | 4.096 | Iulie 2023 |

Aceste capacități diferite reflectă opțiuni de proiectare și compromisuri computaționale distincte pentru fiecare organizație, ferestrele mai mari permițând aplicații mai sofisticate, dar necesitând și mai multă putere de procesare.

Drumul către ferestre de context mai mari reprezintă una dintre cele mai semnificative progrese în capabilitățile AI din ultimul deceniu. Primele rețele neuronale recurente (RNN) și modelele long short-term memory (LSTM) aveau dificultăți în gestionarea contextului, deoarece procesau textul secvențial și rețineau greu informații din părți îndepărtate ale intrării. Progresul major a venit în 2017 odată cu introducerea arhitecturii Transformer, care a permis procesarea paralelă a întregii secvențe și a îmbunătățit dramatic capacitatea modelului de a menține contextul pe texte mai lungi. Această bază a dus la GPT-2 în 2019, cu generare lingvistică impresionantă și o fereastră de context de 1.024 tokeni, urmată de GPT-3 în 2020 cu 2.048 tokeni și, în cele din urmă, GPT-4 în 2023 cu 128.000 tokeni. Fiecare progres a contat pentru că a extins posibilitățile: ferestrele mai mari au permis modelelor să gestioneze documente mai lungi, să mențină coerența pe conversații cu mai multe schimburi și să înțeleagă relații complexe între concepte îndepărtate din text. Creșterea exponențială a dimensiunii ferestrelor de context reflectă atât inovații arhitecturale, cât și resurse computaționale crescute disponibile laboratoarelor AI de top.

Ferestrele de context mai mari extind fundamental ceea ce pot realiza modelele AI, permițând aplicații care anterior erau imposibile sau sever limitate. Iată principalele beneficii:

Continuitatea conversației îmbunătățită: Modelele pot păstra conștientizarea întregului istoric conversațional, reducând nevoia de a reexplica contextul și permițând dialoguri naturale, coerente și continue, fără întreruperi.

Procesarea documentelor la scară largă: Ferestrele mari permit AI-ului să analizeze documente întregi, lucrări științifice sau cod sursă dintr-o singură dată, identificând tipare și relații pe tot conținutul, fără a pierde informații din secțiunile anterioare.

Raționament și analiză îmbunătățite: Având la dispoziție mai mult context, modelele pot realiza sarcini de raționament mai sofisticate care necesită înțelegerea relațiilor între mai multe concepte, devenind mai eficiente pentru cercetare, analiză și rezolvarea problemelor complexe.

Reducerea costului de reintroducere a contextului: Utilizatorii nu mai trebuie să rezume sau să reintroducă manual informația de fiecare dată; modelul poate face referire la întregul istoric conversațional, reducând fricțiunea și sporind eficiența în fluxurile de lucru colaborative.

Gestionarea mai bună a sarcinilor nuanțate: Aplicațiile precum revizuirea documentelor juridice, analiza fișelor medicale sau auditarea codului beneficiază semnificativ de posibilitatea de a considera contextul complet, ducând la rezultate mai precise și detaliate.

Fluxuri de lucru fără întreruperi pe mai multe documente: Profesioniștii pot lucra cu documente conexe simultan, iar modelul poate face referire încrucișată la informații și identifica conexiuni imposibil de observat cu ferestre mai mici.

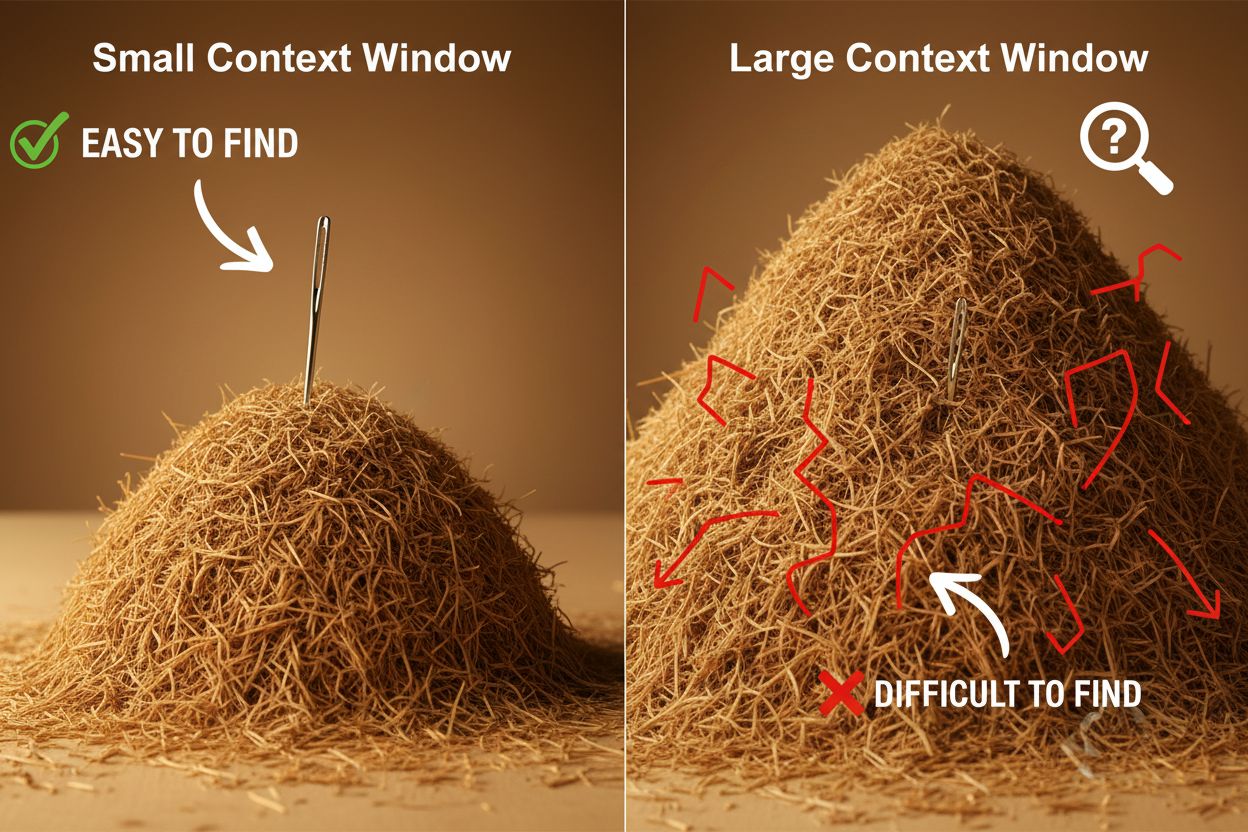

În ciuda avantajelor, ferestrele de context mari aduc provocări tehnice și practice semnificative pe care dezvoltatorii și utilizatorii trebuie să le gestioneze cu atenție. Cea mai evidentă este costul computațional: procesarea secvențelor lungi necesită exponențial mai multă memorie și putere de procesare, din cauza scalării pătratice a mecanismului de atenție. Astfel, ferestrele de context mari sunt mult mai scumpe de rulat. Această cerință crescută duce și la probleme de latență, deoarece ferestrele mari generează timpi de răspuns mai lenți — un aspect critic pentru aplicațiile în timp real unde utilizatorii așteaptă răspunsuri rapide. O altă problemă subtilă dar importantă este fenomenul „acul în carul cu fân”, unde modelele au dificultăți în a găsi și utiliza informația relevantă când aceasta este îngropată într-o fereastră de context foarte mare, performanța putând fi chiar mai slabă decât cu ferestre mai mici. În plus, apare context rot atunci când informațiile de la începutul unei ferestre lungi devin mai puțin influente la ieșirea modelului, mecanismul de atenție putând să prioritizeze tokenii recenți în detrimentul celor mai vechi. Aceste provocări arată că maximizarea dimensiunii ferestrei de context nu este întotdeauna soluția optimă pentru orice caz de utilizare.

Înțelegerea fenomenului de context rot este esențială pentru a lucra eficient cu ferestre de context mari: pe măsură ce secvențele devin mai lungi, tokenii de la începutul contextului tind să aibă o influență tot mai mică asupra ieșirii modelului, ceea ce înseamnă că informațiile critice pot fi „uitate” efectiv, chiar dacă se află tehnic în fereastră. Acest lucru se întâmplă deoarece bugetul de atenție — capacitatea modelului de a acorda importanță tuturor tokenilor — se împarte pe un interval mai mare de text. Din fericire, au apărut mai multe tehnici sofisticate pentru a gestiona aceste limitări. Retrieval-Augmented Generation (RAG) rezolvă problema stocând informația în baze de date externe și recuperând doar cele mai relevante părți la nevoie, oferind modelului o bază de cunoștințe efectiv mai largă fără a necesita o fereastră de context uriașă. Tehnicile de compactare a contextului rezumă sau comprimă informațiile mai puțin relevante, păstrând detaliile importante și reducând totodată consumul de tokeni. Notele structurate încurajează organizarea ierarhică a informațiilor, facilitând prioritizarea și localizarea conceptelor-cheie de către model. Aceste soluții funcționează fiind strategice cu privire la ce informație intră în fereastra de context și cum este organizată, nu încercând pur și simplu să încapă totul în memorie odată.

Ferestrele de context extinse ale modelelor AI moderne au deschis aplicații reale care anterior erau impracticabile sau imposibile. Sistemele de suport clienți pot acum revizui întregul istoric al unui tichet și documentația aferentă dintr-o singură cerere, oferind răspunsuri mai exacte și relevante contextual, fără ca utilizatorii să fie nevoiți să-și reexplice situația. Analiza documentelor și cercetarea au fost transformate de modele care pot procesa integral lucrări științifice, contracte legale sau specificații tehnice, identificând informațiile-cheie și răspunzând la întrebări detaliate despre conținutul pe care unui om i-ar lua ore să-l parcurgă. Revizuirea de cod și dezvoltarea software beneficiază de ferestre de context suficient de mari pentru a include fișiere întregi sau chiar mai multe fișiere conexe, permițând AI-ului să înțeleagă structuri arhitecturale și să ofere sugestii mai inteligente. Crearea de conținut de lungă durată și fluxurile de scriere iterative devin mai eficiente când modelul păstrează conștientizarea tonului, stilului și arcului narativ al întregului document pe parcursul editării. Analiza transcrierilor de întâlniri și sinteza cercetărilor folosesc ferestre de context mari pentru a extrage perspective din ore de conversație sau zeci de documente sursă, identificând teme și conexiuni greu de observat manual. Aceste aplicații demonstrează că dimensiunea ferestrei de context se traduce direct în valoare practică pentru profesioniști din diverse industrii.

Traiectoria dezvoltării ferestrelor de context sugerează că ne îndreptăm spre extinderi și mai dramatice în viitorul apropiat, Gemini 1.5 Pro demonstrând deja o fereastră de context de 1.000.000 tokeni, iar laboratoarele de cercetare explorând capacități și mai mari. Dincolo de mărimea brută, viitorul va presupune probabil ferestre de context dinamice care își ajustează inteligent dimensiunea în funcție de sarcină, alocând mai multă capacitate când este nevoie și reducând-o pentru solicitări simple, pentru a îmbunătăți eficiența și a reduce costurile. Cercetătorii progresează și în dezvoltarea unor mecanisme de atenție mai eficiente, care să reducă penalizarea computațională a ferestrelor mari, existând potențialul de a depăși bariera scalării pătratice ce limitează în prezent dimensiunea contextului. Pe măsură ce aceste tehnologii se maturizează, ne putem aștepta ca ferestrele de context să devină tot mai puțin o constrângere, permițând dezvoltatorilor să se concentreze pe alte aspecte ale capabilității și fiabilității AI. Convergența dintre ferestre mai mari, eficiență sporită și management inteligent al contextului va defini probabil următoarea generație de aplicații AI, deschizând cazuri de utilizare încă neimaginate.

O fereastră de context reprezintă cantitatea totală de text (măsurată în tokeni) pe care un model AI o poate procesa simultan, în timp ce limita de tokeni se referă la numărul maxim de tokeni pe care modelul îi poate gestiona. Acești termeni sunt adesea folosiți interschimbabil, însă fereastra de context se referă specific la memoria de lucru disponibilă în timpul unei inferențe, pe când limita de tokeni poate indica și limitări de ieșire sau restricții de utilizare a API-ului.

Ferestrele de context mai mari îmbunătățesc în general calitatea răspunsurilor, permițând modelului să ia în considerare mai multe informații relevante și să mențină o continuitate mai bună a conversației. Totuși, ferestrele extrem de mari pot uneori să scadă calitatea din cauza fenomenului de context rot, unde modelul are dificultăți în a prioritiza informațiile importante printre cantități mari de text. Dimensiunea optimă a ferestrei de context depinde de sarcina specifică și de cât de bine este organizată informația.

Ferestrele de context mai mari necesită mai multă putere de procesare din cauza scalării pătratice a mecanismului de atenție în modelele de tip transformer. Mecanismul de atenție trebuie să calculeze relațiile dintre fiecare token cu fiecare alt token, astfel încât dublarea ferestrei de context aproape cvadruplează cerințele de procesare. De aceea, ferestrele de context mai mari sunt mai costisitoare și generează timpi de răspuns mai mari.

Problema "acului în carul cu fân" apare când un model AI are dificultăți în a localiza și utiliza informațiile relevante ("acul") atunci când acestea sunt îngropate într-o fereastră de context foarte mare ("carul cu fân"). Modelele pot performa uneori mai slab cu ferestre de context extrem de mari pentru că mecanismul de atenție se diluează pe prea multă informație, fiind mai greu de identificat ce este cu adevărat important.

Pentru a maximiza eficiența ferestrei de context, organizează informația clar și ierarhic, plasează cele mai importante date la începutul sau finalul contextului, folosește formate structurate precum JSON sau markdown și ia în considerare utilizarea Retrieval-Augmented Generation (RAG) pentru a încărca dinamic doar informațiile relevante. Evită supraîncărcarea modelului cu detalii irelevante care consumă tokeni fără valoare adăugată.

Fereastra de context reprezintă capacitatea tehnică a modelului de a procesa textul la un moment dat, pe când istoricul conversației este de fapt înregistrarea mesajelor anterioare dintr-o discuție. Istoricul conversației trebuie să încapă în fereastra de context, însă fereastra include și spațiu pentru prompturi de sistem, instrucțiuni și alte metadate. Istoricul poate fi mai lung decât fereastra de context, necesitând rezumare sau trunchiere.

Nu există în prezent modele AI cu ferestre de context cu adevărat nelimitate, deoarece toate modelele au constrângeri arhitecturale și computaționale. Totuși, unele modele precum Gemini 1.5 Pro oferă ferestre extrem de mari (1.000.000 tokeni), iar tehnici precum Retrieval-Augmented Generation (RAG) pot extinde efectiv baza de cunoștințe a modelului dincolo de fereastra de context, prin recuperarea dinamică a informațiilor necesare.

Dimensiunea ferestrei de context influențează direct costurile API deoarece ferestrele mai mari necesită mai multe resurse computaționale pentru a fi procesate. Majoritatea furnizorilor de API AI taxează în funcție de numărul de tokeni folosiți, deci folosirea unei ferestre de context mai mari înseamnă mai mulți tokeni procesați și costuri mai mari. Unii furnizori percep, de asemenea, tarife premium pentru modele cu ferestre de context extinse, motiv pentru care este important să alegi dimensiunea potrivită nevoilor tale.

AmICited urmărește cum sistemele AI precum ChatGPT, Perplexity și Google AI Overviews citează și fac referire la conținutul tău. Înțelege vizibilitatea brandului tău în AI și monitorizează mențiunile brandului pe platformele AI.

Fereastra de context explicată: numărul maxim de tokeni pe care un LLM îi poate procesa simultan. Află cum influențează ferestrele de context acuratețea AI, hal...

Află ce sunt ferestrele de context în modelele de limbaj AI, cum funcționează, impactul lor asupra performanței modelelor și de ce contează pentru aplicațiile b...

Discuție comunitară despre ferestrele de context în AI și implicațiile lor pentru marketingul de conținut. Înțelegerea modului în care limitele de context influ...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.