Ar trebui să blocați sau să permiteți crawlerii AI? Cadru decizional

Aflați cum să luați decizii strategice despre blocarea crawlerilor AI. Evaluați tipul de conținut, sursele de trafic, modelele de venituri și poziția competitiv...

O abordare strategică ce permite proprietarilor de site-uri să permită selectiv anumitor crawlere AI accesul, blocându-le pe altele, în funcție de obiectivele de afaceri, acordurile de licențiere a conținutului și evaluarea valorii. În loc să implementeze politici generale, accesul diferențial evaluează fiecare crawler individual pentru a determina dacă aduce trafic, respectă termenii de licențiere sau se aliniază cu obiectivele de monetizare. Editorii folosesc instrumente precum robots.txt, antete HTTP și controale specifice platformelor pentru a implementa politici de acces granulare. Această metodă echilibrează oportunitățile de inovație cu protecția conținutului și compensarea corectă.

O abordare strategică ce permite proprietarilor de site-uri să permită selectiv anumitor crawlere AI accesul, blocându-le pe altele, în funcție de obiectivele de afaceri, acordurile de licențiere a conținutului și evaluarea valorii. În loc să implementeze politici generale, accesul diferențial evaluează fiecare crawler individual pentru a determina dacă aduce trafic, respectă termenii de licențiere sau se aliniază cu obiectivele de monetizare. Editorii folosesc instrumente precum robots.txt, antete HTTP și controale specifice platformelor pentru a implementa politici de acces granulare. Această metodă echilibrează oportunitățile de inovație cu protecția conținutului și compensarea corectă.

Explozia crawlerelor AI a perturbat fundamental relația veche de zeci de ani dintre proprietarii de site-uri și roboți. Ani la rând, internetul a funcționat pe baza unui schimb simplu: motoarele de căutare precum Google indexau conținutul și redirecționau traficul către sursele originale, creând o relație simbiotică ce recompensa crearea de conținut de calitate. Astăzi, o nouă generație de crawlere AI — inclusiv GPTBot, ClaudeBot, PerplexityBot și zeci de altele — operează după reguli diferite. Acești roboți extrag conținutul nu pentru a-l indexa sau a-l face descoperibil, ci pentru a-l introduce direct în modele AI care generează răspunsuri fără a trimite utilizatorii înapoi la sursa originală. Impactul este drastic: conform datelor Cloudflare, GPTBot de la OpenAI are un raport crawlare-trimitere de aproximativ 1.700:1, iar ClaudeBot de la Anthropic ajunge la 73.000:1, adică pentru fiecare vizitator trimis înapoi pe site-ul unui editor, mii de pagini sunt crawl-uite pentru date de antrenare. Acest schimb dezechilibrat i-a forțat pe editori să-și regândească politicile de acces pentru crawlere, renunțând la alegerea binară „permite tot” sau „blochează tot”, în favoarea unei strategii mai nuanțate: acces diferențial pentru crawlere. În loc să implementeze politici uniforme, editorii experimentați evaluează acum fiecare crawler individual, punând întrebări critice despre valoare, licențiere și aliniere cu obiectivele de business.

Înțelegerea diferitelor tipuri de crawlere AI este esențială pentru implementarea unei strategii eficiente de acces diferențial, deoarece fiecare servește scopuri distincte cu impacturi variate asupra afacerii tale. Crawlerele AI se împart în trei categorii principale: crawlere de antrenare (GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider) care colectează conținut pentru antrenarea modelelor; crawlere de căutare (OAI-SearchBot, PerplexityBot, Google-Extended) care indexează conținutul pentru rezultate de căutare AI; și agenți declanșați de utilizator (ChatGPT-User, Claude-Web, Perplexity-User) care preiau conținut doar la cererea explicită a utilizatorului. Propunerea de valoare diferă dramatic între aceste categorii. Crawlerele de antrenare generează de obicei trafic minim către site-ul tău — extrag valoare fără beneficiu reciproc — fiind candidate principale pentru blocare. Crawlerele de căutare, în schimb, pot aduce trafic semnificativ de recomandare și conversii de abonați, similar motoarelor de căutare tradiționale. Agenții declanșați de utilizator ocupă o zonă intermediară, activând numai când utilizatorii interacționează efectiv cu sistemele AI. The Atlantic, unul dintre cei mai mari editori digitali, a implementat o abordare sofisticată de tip scorecard pentru evaluarea crawlerelor, urmărind atât volumul de trafic cât și conversiile de abonați pentru fiecare robot. Analiza lor a arătat că, în timp ce unele crawlere aduc valoare semnificativă, altele generează practic zero trafic, consumând totodată multă lățime de bandă. Această abordare bazată pe date le permite editorilor să ia decizii informate, nu bazate pe presupuneri.

| Tip crawler | Exemple | Scop principal | Valoare tipică a traficului | Acces recomandat |

|---|---|---|---|---|

| Antrenare | GPTBot, ClaudeBot, anthropic-ai, CCBot, Bytespider | Seturi de date pentru antrenare modele | Foarte scăzut (raport 1.700:1 până la 73.000:1) | Adesea blocat |

| Căutare | OAI-SearchBot, PerplexityBot, Google-Extended | Indexare pentru căutare AI | Mediu spre ridicat | De obicei permis |

| Declanșat de utilizator | ChatGPT-User, Claude-Web, Perplexity-User | Cereri directe ale utilizatorilor | Variabil | De la caz la caz |

Implementarea accesului diferențial pentru crawlere necesită o combinație între instrumente tehnice și decizii strategice, cu metode multiple disponibile în funcție de capabilitățile tehnice și cerințele de business. Cel mai fundamental instrument este robots.txt, un fișier text simplu plasat în directorul rădăcină al site-ului tău, care comunică preferințele de acces crawlerelor prin directive User-agent. Deși robots.txt este voluntar și doar 40-60% dintre roboții AI îl respectă, rămâne prima linie de apărare și nu implică costuri. Pentru editorii care doresc aplicare mai strictă, robots.txt gestionat de Cloudflare creează și actualizează automat directivele pentru crawlere, adăugându-le la fișierul existent și eliminând necesitatea întreținerii manuale. Dincolo de robots.txt, mai multe mecanisme de aplicare oferă control suplimentar:

Cea mai eficientă abordare combină mai multe straturi: robots.txt pentru roboții conformi, reguli WAF pentru aplicare, iar instrumente de monitorizare pentru a urmări eficiența și a identifica amenințările noi.

Implementarea accesului diferențial pentru crawlere presupune să depășești faza tehnică și să dezvolți o strategie de business coerentă, aliniată modelului tău de venit și poziționării competitive. Abordarea The Atlantic oferă un cadru practic: ei evaluează fiecare crawler pe baza a două metrici principale—volumul de trafic și conversiile de abonați—punând întrebarea dacă robotul generează suficientă valoare pentru a justifica accesul la conținut. Pentru un editor cu o valoare anuală a abonatului de 80 $, un crawler care aduce 1.000 de abonați înseamnă 80.000 $ venit anual, ceea ce schimbă fundamental decizia de acces. Totuși, traficul și conversiile reprezintă doar o parte a ecuației. Editorii trebuie să ia în calcul și:

Cei mai strategici editori implementează politici de acces pe niveluri: permit crawlerele de căutare care aduc trafic, blochează crawlerele de antrenare care nu o fac și negociază acorduri de licențiere cu companiile AI de valoare. Această abordare maximizează vizibilitatea și veniturile, protejând proprietatea intelectuală.

Deși accesul diferențial pentru crawlere oferă avantaje semnificative, realitatea este mai complexă decât teoria, existând mai multe provocări fundamentale ce limitează eficiența și necesită management continuu. Cea mai importantă limitare este că robots.txt este voluntar—crawlerele care îl respectă o fac din proprie inițiativă, nu din obligație. Cercetările arată că robots.txt oprește doar 40-60% din roboții AI, alți 30-40% sunt blocați prin user-agent, lăsând 10-30% de crawlere care operează fără restricție. Unele companii AI și actori rău-intenționați ignoră în mod deliberat directivele robots.txt, considerând accesul la conținut mai valoros decât conformitatea. În plus, tehnicile de evitare ale crawlerelor evoluează constant: roboții sofisticați falsifică user-agent-ul pentru a părea browsere legitime, folosesc adrese IP distribuite pentru a evita detectarea și utilizează browsere headless ce imită comportamentul uman. Dilema Google-Extended exemplifică această complexitate: blocarea Google-Extended previne ca Gemini AI să se antreneze pe conținutul tău, dar Google AI Overviews (care apar în rezultate de căutare) folosesc regulile standard Googlebot, ceea ce înseamnă că nu poți renunța la AI Overviews fără a pierde vizibilitatea în căutare. Monitorizarea și aplicarea cer și ele resurse semnificative—urmărirea crawlerelor noi, actualizarea politicilor și validarea eficacității necesită atenție continuă. În final, peisajul legal rămâne incert: deși legea drepturilor de autor teoretic protejează conținutul, aplicarea împotriva companiilor AI este costisitoare și cu rezultate imprevizibile, lăsând editorii cu control tehnic, dar fără certitudine juridică.

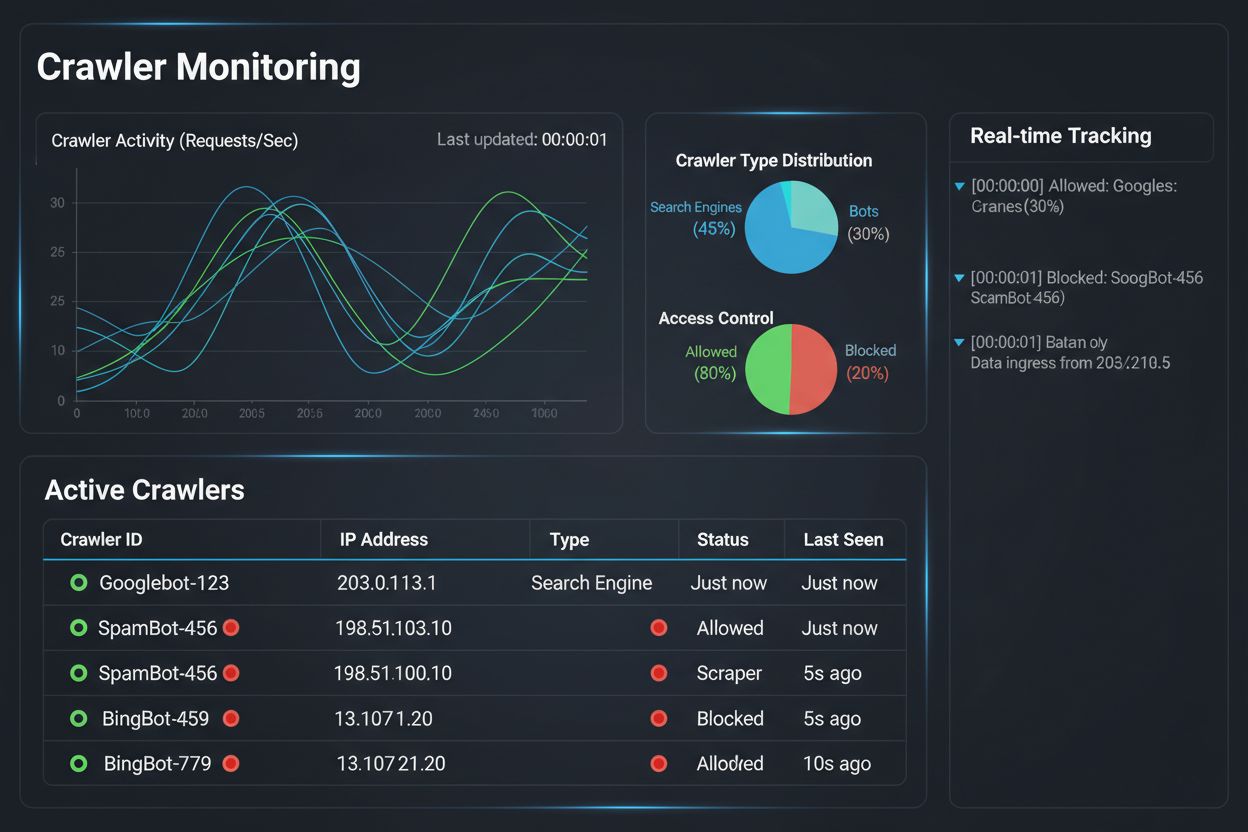

Implementarea unei strategii de acces diferențial pentru crawlere reprezintă doar jumătate din luptă; cealaltă jumătate constă în înțelegerea impactului real al politicilor tale prin monitorizare și măsurare cuprinzătoare. Aici intervine AmICited.com, esențial pentru strategia ta de management al crawlerelor. AmICited este specializat în monitorizarea modului în care sistemele AI fac referire și citează brandul tău în GPT-uri, Perplexity, Google AI Overviews și alte platforme AI—oferindu-ți vizibilitate asupra crawlerelor care folosesc efectiv conținutul tău și asupra modului în care acesta apare în răspunsuri generate de AI. În loc să te bazezi pe loguri de server și presupuneri, dashboard-ul AmICited îți arată exact ce sisteme AI au accesat conținutul tău, cât de des și, cel mai important, dacă acesta este citat sau doar absorbit în datele de antrenare fără atribuire. Această inteligență informează direct deciziile tale de acces diferențial: dacă un crawler îți accesează conținutul dar nu îl citează niciodată în răspunsurile AI, blocarea devine o decizie clară de business. AmICited permite și benchmarking competitiv, arătând cum se compară vizibilitatea conținutului tău în sistemele AI față de competitori, ajutându-te să înțelegi dacă politicile tale de acces sunt prea restrictive sau prea permisive. Alertele în timp real ale platformei te notifică când sisteme AI noi încep să folosească conținutul tău, permițând ajustări rapide ale politicilor. Prin combinarea capacităților de monitorizare ale AmICited cu instrumentele de aplicare Cloudflare, editorii obțin vizibilitate și control complet: pot vedea ce crawlere accesează conținutul, măsura impactul de business și ajusta politicile în consecință. Această abordare bazată pe date transformă managementul crawlerelor dintr-o bifă tehnică într-o funcție strategică de business.

Peisajul accesului diferențial pentru crawlere evoluează rapid, cu standarde și modele de business emergente care schimbă modul în care editorii și companiile AI interacționează în jurul conținutului. Propunerea IETF privind preferințele AI reprezintă o dezvoltare semnificativă, stabilind modalități standardizate pentru ca site-urile web să comunice preferințele privind antrenarea, inferența și utilizarea în căutare AI. În loc să se bazeze pe robots.txt—un standard vechi de 30 de ani, creat pentru motoare de căutare—acest nou cadru oferă control explicit și granular asupra modului în care sistemele AI pot folosi conținutul. În același timp, modelele de business bazate pe permisiune câștigă teren, inițiativa Pay Per Crawl de la Cloudflare fiind pionieră în stabilirea unui cadru prin care companiile AI plătesc editorilor pentru acces la conținut, transformând crawlerele din amenințări în surse de venit. Această trecere de la blocare la licențiere marchează o schimbare fundamentală în economia internetului: în loc să lupte pentru acces, editorii și companiile AI negociază o compensație echitabilă. Standardele de autentificare și verificare a crawlerelor avansează și ele, metodele criptografice permițând editorilor să confirme identitatea crawlerului și să prevină cererile falsificate. Pe viitor, ne putem aștepta la cadre de reglementare sporite privind datele de antrenare AI, care ar putea impune consimțământ explicit și compensare pentru utilizarea conținutului. Convergența acestor tendințe—standarde tehnice, modele de licențiere, mecanisme de autentificare și presiune reglementară—sugerează că accesul diferențial pentru crawlere va evolua dintr-o strategie defensivă într-o funcție de business sofisticată, în care editorii gestionează, monitorizează și monetizează activ accesul crawlerelor AI. Editorii care implementează astăzi monitorizare cuprinzătoare și politici strategice vor fi cel mai bine poziționați să valorifice aceste oportunități emergente.

Blocarea tuturor crawlerelor elimină complet conținutul tău din sistemele AI, înlăturând atât riscurile, cât și oportunitățile. Accesul diferențial îți permite să evaluezi fiecare crawler individual, blocându-le pe cele care nu aduc valoare și permițându-le pe cele care generează trafic sau oferă oportunități de licențiere. Această abordare nuanțată maximizează atât vizibilitatea, cât și veniturile, protejând în același timp proprietatea intelectuală.

Poți monitoriza activitatea crawlerelor prin jurnalele serverului, dashboard-ul de analiză Cloudflare sau instrumente specializate de monitorizare precum AmICited.com. AmICited urmărește în mod specific ce sisteme AI accesează conținutul tău și cum apare brandul tău în răspunsurile generate de AI, oferind informații de business dincolo de logurile tehnice.

Nu. Blocarea crawlerelor de antrenare AI precum GPTBot, ClaudeBot și CCBot nu îți afectează clasamentul în Google sau Bing. Motoarele de căutare tradiționale folosesc alte crawlere (Googlebot, Bingbot) care operează independent. Blochează-le doar dacă vrei să dispari complet din rezultatele de căutare.

Da, aceasta este cea mai strategică abordare pentru mulți editori. Poți permite crawlerele orientate pe căutare precum OAI-SearchBot și PerplexityBot (care generează trafic), blocând crawlerele de antrenare precum GPTBot și ClaudeBot (care, de obicei, nu o fac). Astfel menții vizibilitatea în rezultatele AI, protejând totodată conținutul de a fi absorbit în seturi de date pentru antrenare.

Deși crawlerele majore de la OpenAI, Anthropic și Google respectă robots.txt, unele roboți îl ignoră deliberat. Dacă un crawler nu respectă robots.txt, ai nevoie de metode suplimentare de aplicare, precum reguli WAF, blocare IP sau funcțiile de gestionare a roboților din Cloudflare. De aceea, instrumente de monitorizare precum AmICited sunt esențiale—îți arată ce crawlere respectă cu adevărat politicile tale.

Revizuiește politicile cel puțin trimestrial, deoarece companiile AI lansează regulat crawlere noi. Anthropic a fuzionat roboții 'anthropic-ai' și 'Claude-Web' în 'ClaudeBot', oferind noului bot acces temporar nelimitat pe site-urile care nu și-au actualizat regulile. Monitorizarea regulată cu instrumente ca AmICited te ajută să fii mereu cu un pas înainte.

Googlebot este crawlerul de căutare al Google care indexează conținutul pentru rezultate. Google-Extended este un token de control care guvernează dacă conținutul tău este folosit pentru antrenarea Gemini AI. Poți bloca Google-Extended fără să afectezi clasamentul în căutare, dar trebuie să știi că Google AI Overviews (prezentările AI din rezultate) folosesc regulile standard Googlebot, deci nu poți renunța la AI Overviews fără să pierzi vizibilitatea în căutare.

Da, modele emergente de licențiere precum Pay Per Crawl de la Cloudflare permit editorilor să taxeze companiile AI pentru acces la conținut. Astfel, crawlerele devin surse de venit în loc de amenințări. Totuși, acest lucru necesită negociere cu companiile AI și, posibil, acorduri legale. Monitorizarea oferită de AmICited te ajută să identifici ce crawlere reprezintă cele mai valoroase oportunități de licențiere.

Urmărește ce sisteme AI accesează conținutul tău și cum apare brandul tău în răspunsurile generate de AI. Obține informații în timp real despre comportamentul crawlerelor și măsoară impactul de business al politicilor tale de acces diferențial.

Aflați cum să luați decizii strategice despre blocarea crawlerilor AI. Evaluați tipul de conținut, sursele de trafic, modelele de venituri și poziția competitiv...

Află cum firewall-urile pentru aplicații web oferă control avansat asupra crawlerelor AI, dincolo de robots.txt. Implementează reguli WAF pentru a-ți proteja co...

Învață să identifici și să monitorizezi crawlerii AI precum GPTBot, ClaudeBot și PerplexityBot în jurnalele serverului tău. Ghid complet cu șiruri user-agent, v...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.