Ajustarea fină a modelelor AI

Află cum ajustarea fină a modelelor AI adaptează modelele pre-antrenate pentru sarcini specifice industriei și brandului, îmbunătățind acuratețea și reducând co...

Ajustarea fină este procesul de adaptare a unui model AI pre-antrenat pentru a îndeplini sarcini specifice prin antrenarea acestuia pe un set de date mai mic, specific unui anumit domeniu. Această tehnică ajustează parametrii modelului pentru a excela în aplicații specializate, valorificând cunoștințele generale dobândite în timpul pre-antrenării inițiale, făcând procesul mai eficient și mai rentabil decât antrenarea de la zero.

Ajustarea fină este procesul de adaptare a unui model AI pre-antrenat pentru a îndeplini sarcini specifice prin antrenarea acestuia pe un set de date mai mic, specific unui anumit domeniu. Această tehnică ajustează parametrii modelului pentru a excela în aplicații specializate, valorificând cunoștințele generale dobândite în timpul pre-antrenării inițiale, făcând procesul mai eficient și mai rentabil decât antrenarea de la zero.

Ajustarea fină este procesul de adaptare a unui model AI pre-antrenat pentru a îndeplini sarcini specifice prin antrenarea acestuia pe un set de date mai mic, specific unui anumit domeniu. În loc să construiești un model AI de la zero—which necesită resurse computaționale enorme și cantități uriașe de date etichetate—ajustarea fină valorifică cunoștințele generale pe care modelul le-a dobândit deja în timpul pre-antrenării inițiale și le rafinează pentru aplicații specializate. Această tehnică a devenit fundamentală pentru deep learning modern și AI generativă, permițând organizațiilor să personalizeze modele puternice precum modelele lingvistice mari (LLMs) pentru nevoile lor de afaceri unice. Ajustarea fină reprezintă o implementare practică a transferului de învățare, unde cunoștințele obținute dintr-o sarcină îmbunătățesc performanța într-o sarcină înrudită. Intuiția este simplă: este mult mai ușor și mai ieftin să perfecționezi capabilitățile unui model care deja înțelege tiparele generale decât să antrenezi un model nou de la zero pentru un scop specific.

Ajustarea fină a apărut ca o tehnică critică pe măsură ce modelele de deep learning au crescut exponențial în dimensiune și complexitate. La începutul anilor 2010, cercetătorii au descoperit că pre-antrenarea modelelor pe seturi de date masive și apoi adaptarea lor la sarcini specifice îmbunătățește dramatic performanța și reduce timpul de antrenare. Această abordare a câștigat notorietate odată cu apariția modelelor transformer și BERT (Bidirectional Encoder Representations from Transformers), care au demonstrat că modelele pre-antrenate pot fi ajustate fin cu succes pentru numeroase sarcini subsumate. Explozia AI-ului generativ și a marilor modele lingvistice precum GPT-3, GPT-4 și Claude a făcut ajustarea fină și mai relevantă, pe măsură ce organizațiile din întreaga lume caută să personalizeze aceste modele puternice pentru aplicații specifice domeniului. Conform datelor recente privind adopția enterprise, 51% dintre organizațiile care folosesc AI generativ folosesc generation augmentată prin recuperare (RAG), în timp ce ajustarea fină rămâne o abordare complementară esențială pentru cazuri de utilizare specializate. Evoluția metodelor parameter-efficient fine-tuning (PEFT) precum LoRA (Low-Rank Adaptation) a democratizat accesul la ajustarea fină prin reducerea cerințelor computaționale cu până la 90%, făcând tehnica accesibilă organizațiilor fără infrastructură GPU masivă.

Ajustarea fină operează printr-un proces matematic și computațional bine definit care ajustează parametrii (greutăți și biase) ai unui model pentru a optimiza performanța pe sarcini noi. În timpul pre-antrenării, un model învață tipare generale din seturi de date uriașe prin gradient descent și backpropagation, stabilind o bază largă de cunoștințe. Ajustarea fină începe de la aceste greutăți pre-antrenate și continuă procesul de antrenament pe un set de date mai mic, specific sarcinii. Diferența cheie constă în utilizarea unei rate de învățare semnificativ mai mici—magnitudinea actualizărilor greutăților la fiecare iterație de antrenament—pentru a evita uitarea catastrofală, unde modelul pierde cunoștințe generale importante. Procesul de ajustare fină implică treceri directe în care modelul face predicții pe exemple de antrenament, calculul pierderii care măsoară erorile de predicție și treceri inverse în care se calculează gradientii și se ajustează greutățile. Acest proces iterativ continuă pentru mai multe epoci (parcurgeri complete prin datele de antrenament) până când modelul atinge performanța dorită pe datele de validare. Eleganța matematică a ajustării fine constă în eficiența sa: pornind de la greutăți pre-antrenate care deja surprind tipare utile, modelul converge către soluții bune mult mai rapid decât antrenarea de la zero, necesitând adesea de 10-100 ori mai puține date și resurse de calcul.

| Aspect | Ajustare fină | Generation augmentată prin recuperare (RAG) | Inginerie de prompturi | Antrenare completă a modelului |

|---|---|---|---|---|

| Sursa cunoștințelor | Încorporată în parametrii modelului | Bază de date externă/bază de cunoștințe | Context furnizat de utilizator în prompt | Învățată de la zero din date |

| Actualitatea datelor | Statică până la reantrenare | În timp real/dinamic | Actual doar în prompt | Înghețată la momentul antrenării |

| Cost computațional | Ridicat inițial (antrenare), scăzut la inferență | Scăzut inițial, moderat la inferență | Minim | Extrem de ridicat |

| Complexitatea implementării | Moderat-Ridicată (necesită expertiză ML) | Moderată (necesită infrastructură) | Scăzută (nu necesită antrenare) | Foarte ridicată |

| Adâncimea personalizării | Profundă (comportamentul modelului se schimbă) | Superficială (doar recuperare) | Superficială (la nivel de prompt) | Completă (de la zero) |

| Frecvența actualizărilor | Săptămâni/luni (necesită reantrenare) | În timp real (actualizare bază de date) | Per-interogare (manual) | Impractic pentru actualizări frecvente |

| Consistența outputului | Ridicată (tipare învățate) | Variabilă (depinde de recuperare) | Moderată (dependentă de prompt) | Depinde de datele de antrenament |

| Atribuirea sursei | Niciuna (implicită în greutăți) | Completă (documente citate) | Parțială (promptul vizibil) | Niciuna |

| Scalabilitate | Mai multe modele per domeniu | Un singur model, surse multiple de date | Un singur model, prompturi multiple | Impractic la scară mare |

| Cel mai potrivit pentru | Sarcini specializate, formatare consistentă | Informații actuale, transparență | Iterații rapide, sarcini simple | Domenii noi, cerințe unice |

Ajustarea fină urmează un flux structurat care transformă un model generalist într-un expert specializat. Procesul începe cu pregătirea datelor, unde organizațiile colectează și curatoriază exemple relevante pentru sarcina specifică. Pentru un asistent AI juridic, acest lucru poate presupune mii de documente legale asociate cu întrebări și răspunsuri relevante. Pentru un instrument de diagnostic medical, pot fi cazuri clinice cu diagnostice. Calitatea acestui set de date este esențială—cercetările arată constant că un set mai mic de exemple de înaltă calitate și bine etichetate produce rezultate mai bune decât un set mai mare de date zgomotoase sau inconsistente. După pregătirea datelor, acestea sunt împărțite în seturi de antrenament, validare și testare pentru a asigura generalizarea modelului la exemple nevăzute.

Procesul real de ajustare fină începe prin încărcarea modelului pre-antrenat și a greutăților acestuia în memorie. Arhitectura modelului rămâne neschimbată; doar greutățile sunt ajustate. La fiecare iterație de antrenament, modelul procesează un lot de exemple de antrenament, face predicții și le compară cu răspunsurile corecte folosind o funcție de pierdere care cuantifică erorile de predicție. Backpropagation calculează apoi gradientii—măsuri matematice despre cum ar trebui să se schimbe fiecare greutate pentru a reduce pierderea. Un algoritm de optimizare precum Adam sau SGD (Stochastic Gradient Descent) folosește acești gradienti pentru a actualiza greutățile, de obicei cu o rată de învățare de 10-100 ori mai mică decât în pre-antrenare pentru a păstra cunoștințele generale. Acest proces se repetă pe parcursul mai multor epoci, modelul specializându-se gradual pe datele sarcinii. Pe tot parcursul antrenamentului, modelul este evaluat pe setul de validare pentru a monitoriza performanța și a detecta supraînvățarea—când modelul memorează exemplele de antrenament în loc să învețe tipare generalizabile. Odată ce performanța pe validare stagnează sau începe să scadă, antrenamentul se oprește pentru a preveni supraînvățarea.

Ajustarea fină completă actualizează toți parametrii modelului, ceea ce poate fi costisitor computațional pentru modelele mari. Un model cu miliarde de parametri necesită stocarea gradientilor pentru fiecare parametru în timpul backpropagation, consumând memorie GPU enormă. Pentru un model cu 7 miliarde de parametri, ajustarea fină completă poate necesita peste 100 GB de memorie GPU, devenind inaccesibilă pentru majoritatea organizațiilor. Totuși, ajustarea fină completă produce adesea cele mai bune performanțe, deoarece toate greutățile modelului pot fi adaptate la noua sarcină.

Metodele eficiente de ajustare fină a parametrilor (PEFT) abordează această limitare actualizând doar o mică parte din parametri. LoRA (Low-Rank Adaptation), una dintre cele mai populare tehnici PEFT, adaugă mici matrici antrenabile la anumite straturi, păstrând greutățile originale înghețate. Aceste matrici low-rank captează adaptările specifice sarcinii fără a modifica modelul de bază. Cercetările demonstrează că LoRA obține performanțe comparabile cu ajustarea fină completă, folosind cu 90% mai puțină memorie și antrenând de 3-5 ori mai rapid. QLoRA duce acest lucru mai departe, cuantificând modelul de bază la precizie de 4 biți, reducând cerințele de memorie cu încă 75%. Alte abordări PEFT includ adaptoare (straturi mici specifice sarcinii inserate în model), prompt tuning (învățarea de prompturi soft în loc de greutăți de model) și BitFit (actualizarea doar a termenilor de bias). Aceste metode au democratizat ajustarea fină, permițând organizațiilor fără clustere GPU masive să personalizeze modele de ultimă generație.

Ajustarea fină a LLM-urilor implică considerații distincte față de ajustarea fină a modelelor de viziune computerizată sau NLP tradițional. LLM-urile pre-antrenate precum GPT-3 sau Llama sunt antrenate prin învățare auto-supervizată pe corpuri masive de text, învățând să prezică următorul cuvânt din secvențe. Deși această pre-antrenare oferă capacități puternice de generare de text, nu învață inerent modelul să urmeze instrucțiunile utilizatorului sau să înțeleagă intenția. Un LLM pre-antrenat întrebat „învață-mă cum să scriu un CV” ar putea doar să continue propoziția cu „folosind Microsoft Word” în loc să ofere sfaturi reale de redactare a unui CV.

Instruction tuning abordează această limitare prin ajustare fină pe seturi de date cu perechi (instrucțiune, răspuns) care acoperă sarcini diverse. Aceste seturi de date învață modelul să recunoască diferite tipuri de instrucțiuni și să răspundă adecvat. Un model ajustat pe instrucțiuni învață că prompturile care încep cu „învață-mă cum să” trebuie să primească ghidaj pas cu pas, nu completări de propoziții. Această abordare specializată de ajustare fină s-a dovedit esențială pentru crearea de asistenți AI practici.

Reinforcement Learning from Human Feedback (RLHF) reprezintă o tehnică avansată de ajustare fină ce completează instruction tuning. În loc să se bazeze doar pe exemple etichetate, RLHF încorporează preferințele umane pentru a optimiza calități greu de specificat prin exemple discrete—precum utilitate, acuratețe factuală, umor sau empatie. Procesul implică generarea mai multor outputuri de model pentru prompturi, evaluarea lor de către oameni, antrenarea unui model de recompensă pentru a prezice ce outputuri preferă oamenii, apoi folosirea învățării prin întărire pentru a optimiza LLM-ul conform acestui semnal de recompensă. RLHF a fost esențial pentru alinierea modelelor precum ChatGPT la valorile și preferințele umane.

Ajustarea fină a devenit centrală pentru strategiile AI enterprise, permițând organizațiilor să implementeze modele personalizate care reflectă cerințele unice și vocea brandului lor. Conform raportului Databricks State of AI 2024, analizând date de la peste 10.000 de organizații, companiile devin mult mai eficiente în implementarea modelelor AI, raportul modelelor experimentale la cele de producție îmbunătățindu-se de la 16:1 la 5:1—un câștig de eficiență de 3x. Deși adopția RAG a crescut la 51% în rândul utilizatorilor AI generativ, ajustarea fină rămâne esențială pentru aplicații specializate unde formatarea consistentă a outputului, expertiza de domeniu sau implementarea offline sunt critice.

Serviciile financiare conduc adopția AI cu cea mai mare utilizare GPU și o creștere de 88% a utilizării GPU în șase luni, mare parte din aceasta fiind generată de ajustarea fină a modelelor pentru detectarea fraudei, evaluarea riscului și tranzacționare algoritmică. Sănătatea și științele vieții s-au dovedit un adoptator timpuriu surprinzător, cu 69% din utilizarea bibliotecilor Python dedicată procesării limbajului natural, reflectând aplicații de ajustare fină în descoperirea de medicamente, analiză de cercetare clinică și documentare medicală. Industria producției și auto a înregistrat o creștere NLP de 148% față de anul precedent, folosind modele ajustate fin pentru controlul calității, optimizarea lanțului de aprovizionare și analiza feedback-ului clienților. Aceste modele de adopție demonstrează că ajustarea fină a trecut de la proiecte experimentale la sisteme de producție care aduc valoare de afaceri măsurabilă.

Ajustarea fină oferă mai multe avantaje convingătoare care explică proeminența sa continuă, în ciuda apariției unor abordări alternative. Acuratețea specifică domeniului reprezintă poate cel mai important beneficiu—un model ajustat pe mii de documente legale nu doar că știe terminologia juridică, ci înțelege raționamentul legal, structurile adecvate de clauze și precedentele relevante. Această specializare profundă produce outputuri conforme cu standardele experților, în moduri pe care modelele generice nu le pot atinge. Câștigurile de eficiență pot fi dramatice; cercetări de la Snorkel AI au demonstrat că un model mic ajustat fin a atins performanță de nivel GPT-3 fiind de 1.400 de ori mai mic, necesitând mai puțin de 1% din etichetele de antrenament și costând 0,1% din cât ar costa rularea sa în producție. Această eficiență transformă economia implementării AI, făcând AI sofisticat accesibil organizațiilor cu bugete limitate.

Controlul personalizat asupra tonului și stilului permite organizațiilor să mențină consistența brandului și standarde de comunicare. Un chatbot specific companiei poate fi ajustat fin pentru a urma ghidurile de voce organizaționale, fie ele formale și profesioniste pentru aplicații legale, fie calde și conversaționale pentru retail. Capacitatea de implementare offline este un alt avantaj critic—odată ajustate, modelele conțin toate cunoștințele necesare în parametrii lor și nu necesită acces la date externe, fiind potrivite pentru aplicații mobile, sisteme încorporate și medii sigure fără conectivitate internet. Reducerea halucinațiilor în domenii specializate apare deoarece modelul a învățat tipare exacte specifice acelui domeniu în timpul ajustării fine, reducând tendința de a genera informații plauzibile, dar incorecte.

În ciuda avantajelor, ajustarea fină prezintă provocări semnificative pe care organizațiile trebuie să le ia în considerare. Cerințele de date reprezintă o barieră substanțială—ajustarea fină necesită sute până la mii de exemple etichetate de înaltă calitate, iar pregătirea acestor seturi de date implică colectare, curățare și adnotare extinse care pot dura săptămâni sau luni. Costurile computaționale rămân ridicate; ajustarea fină completă a modelelor mari necesită GPU-uri sau TPU-uri puternice, cu sesiuni de antrenament care pot costa zeci de mii de dolari. Chiar și metodele eficiente de ajustare cer hardware specializat și expertiză de care multe organizații nu dispun.

Uitarea catastrofală reprezintă un risc persistent, unde ajustarea fină determină modelele să piardă cunoștințele generale dobândite la pre-antrenare. Un model ajustat extensiv pe documente legale poate excela în analiza contractelor, dar să aibă dificultăți cu sarcini de bază pe care le gestiona anterior. Acest efect de îngustare impune adesea menținerea mai multor modele specializate, nu bazarea pe un singur asistent versatil. Sarcina de mentenanță crește pe măsură ce cunoștințele de domeniu evoluează—când apar noi reglementări, avansuri de cercetare sau schimbări de produse, modelul trebuie reantrenat pe date actualizate, proces care poate dura săptămâni și costa mii de dolari. Acest ciclu de reantrenare poate lăsa modelele periculos de învechite în domenii cu schimbări rapide.

Lipsa atribuirii sursei creează probleme de transparență și încredere în aplicații critice. Modelele ajustate fin generează răspunsuri din parametrii interni și nu din documente recuperate explicit, făcând aproape imposibilă verificarea originii anumitor informații. În sănătate, doctorii nu pot verifica ce studii au informat o recomandare. În domeniul juridic, avocații nu pot verifica ce cazuri au influențat un sfat. Această opacitate face modelele ajustate fin nepotrivite pentru aplicații ce necesită audit sau conformitate. Riscul de supraînvățare rămâne semnificativ, în special cu seturi de date mici, unde modelele memorează exemplele în loc să învețe tipare generalizabile, ceea ce duce la performanță slabă pe cazuri diferite de cele de antrenament.

Peisajul ajustării fine continuă să evolueze rapid, cu mai multe tendințe importante care îi modelează viitorul. Progresul continuu al metodelor eficiente de ajustare promite să facă ajustarea fină tot mai accesibilă, cu tehnici noi care reduc și mai mult cerințele computaționale, menținând sau îmbunătățind performanța. Cercetările privind ajustarea fină cu puține exemple (few-shot fine-tuning) vizează obținerea specializării eficiente cu un minim de date etichetate, reducând astfel povara de colectare a datelor care limitează în prezent adopția ajustării fine.

Abordările hibride care combină ajustarea fină cu RAG câștigă teren pe măsură ce organizațiile recunosc că aceste tehnici se completează, nu concurează între ele. Un model ajustat fin pentru expertiză de domeniu poate fi augmentat cu RAG pentru acces la informații actuale, combinând avantajele ambelor abordări. Această strategie hibridă devine tot mai comună în sistemele de producție, în special în industriile reglementate unde contează atât specializarea, cât și actualitatea informațiilor.

Ajustarea fină federată reprezintă o frontieră emergentă în care modelele sunt ajustate fin pe date distribuite fără centralizarea informațiilor sensibile, abordând preocupările de confidențialitate din sănătate, finanțe și alte sectoare reglementate. Abordările de învățare continuă care permit modelelor să se adapteze la informații noi fără uitare catastrofală ar putea transforma modul în care organizațiile întrețin modelele ajustate fin pe măsură ce domeniile evoluează. Ajustarea fină multimodală care depășește textul, acoperind imagini, audio și video, va permite personalizarea modelelor pentru aplicații tot mai diverse.

Integrarea ajustării fine cu platforme de monitorizare AI precum AmICited reprezintă o altă tendință importantă. Pe măsură ce organizațiile implementează modele ajustate fin pe diverse platforme AI—including ChatGPT, Claude, Perplexity și Google AI Overviews—monitorizarea modului în care aceste modele personalizate apar în răspunsurile generate de AI devine esențială pentru vizibilitatea și atribuirea brandului. Această convergență a tehnologiei de ajustare fină cu infrastructura de monitorizare AI reflectă maturizarea AI-ului generativ, de la proiecte experimentale la sisteme de producție ce necesită supraveghere și măsurare comprehensivă.

+++

Ajustarea fină este un subset specific al transferului de învățare. În timp ce transferul de învățare se referă la utilizarea cunoștințelor dintr-o sarcină pentru a îmbunătăți performanța într-o altă sarcină, ajustarea fină implică în mod specific preluarea unui model pre-antrenat și reantrenarea acestuia pe un nou set de date specific sarcinii. Transferul de învățare este conceptul umbrelă, iar ajustarea fină este o metodă de implementare. Ajustarea fină modifică greutățile modelului prin învățarea supravegheată pe exemple etichetate, în timp ce transferul de învățare poate implica diverse tehnici, inclusiv extragerea de caracteristici fără reantrenare.

Cantitatea de date necesară depinde de dimensiunea modelului și de complexitatea sarcinii, dar, în general, variază de la sute la mii de exemple etichetate. Seturile de date mai mici, dar focalizate și de calitate superioară, depășesc adesea seturile mai mari cu etichetare slabă sau inconsistentă. Cercetările arată că un set mai mic de date de înaltă calitate este mai valoros decât un set mai mare de date de calitate scăzută. Pentru metode eficiente de ajustare fină a parametrilor precum LoRA, poate fi nevoie de și mai puține date decât abordările de ajustare fină completă.

Uitarea catastrofală apare atunci când ajustarea fină determină un model să piardă sau să destabilizeze cunoștințele generale dobândite în timpul pre-antrenării. Acest lucru se întâmplă când rata de învățare este prea mare sau setul de date pentru ajustarea fină este prea diferit de datele originale de antrenament, ceea ce duce la suprascrierea unor tipare importante învățate. Pentru a preveni acest lucru, practicienii folosesc rate de învățare mai mici în timpul ajustării fine și aplică tehnici precum regularizarea pentru a păstra capabilitățile de bază ale modelului, adaptându-l totodată la noile sarcini.

Metodele eficiente de ajustare fină a parametrilor (PEFT), precum Low-Rank Adaptation (LoRA), reduc cerințele computaționale prin actualizarea doar a unei mici părți din parametrii modelului, în loc de toate greutățile. LoRA adaugă mici matrici antrenabile la anumite straturi, păstrând greutățile originale înghețate, obținând performanțe similare cu ajustarea fină completă, dar folosind cu 90% mai puțină memorie și resurse de calcul. Alte metode PEFT includ adaptoare, ajustarea prompturilor și abordări bazate pe cuantizare, făcând ajustarea fină accesibilă organizațiilor fără resurse GPU masive.

Ajustarea fină încorporează cunoștințele direct în parametrii modelului prin antrenament, în timp ce Retrieval-Augmented Generation (RAG) recuperează informații din baze de date externe la momentul interogării. Ajustarea fină este excelentă pentru sarcini specializate și formatare consistentă a outputului, dar necesită resurse de calcul semnificative și devine depășită pe măsură ce informațiile se schimbă. RAG oferă acces la informații în timp real și actualizări ușoare, dar poate produce rezultate mai puțin specializate. Multe organizații folosesc ambele abordări împreună pentru rezultate optime.

Instruction tuning este o formă specializată de ajustare fină care antrenează modelele să urmeze mai bine instrucțiunile utilizatorului și să răspundă la sarcini diverse. Folosește seturi de date cu perechi (instrucțiune, răspuns) care acoperă diverse cazuri de utilizare precum întrebări-răspunsuri, rezumare și traducere. Ajustarea fină standard optimizează de obicei pentru o singură sarcină, în timp ce instruction tuning învață modelul să gestioneze mai multe tipuri de instrucțiuni și să urmeze mai eficient indicațiile, fiind deosebit de valoros pentru crearea de asistenți generali.

Da, modelele ajustate fin pot fi implementate pe dispozitive edge și în medii offline, acesta fiind unul dintre avantajele cheie față de abordările bazate pe RAG. După finalizarea ajustării fine, modelul conține toate cunoștințele necesare în parametrii săi și nu necesită acces la date externe. Acest lucru face ca modelele ajustate fin să fie ideale pentru aplicații mobile, sisteme încorporate, dispozitive IoT și medii sigure fără conectivitate la internet, deși dimensiunea modelului și cerințele computaționale trebuie luate în considerare pentru dispozitivele cu resurse limitate.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Află cum ajustarea fină a modelelor AI adaptează modelele pre-antrenate pentru sarcini specifice industriei și brandului, îmbunătățind acuratețea și reducând co...

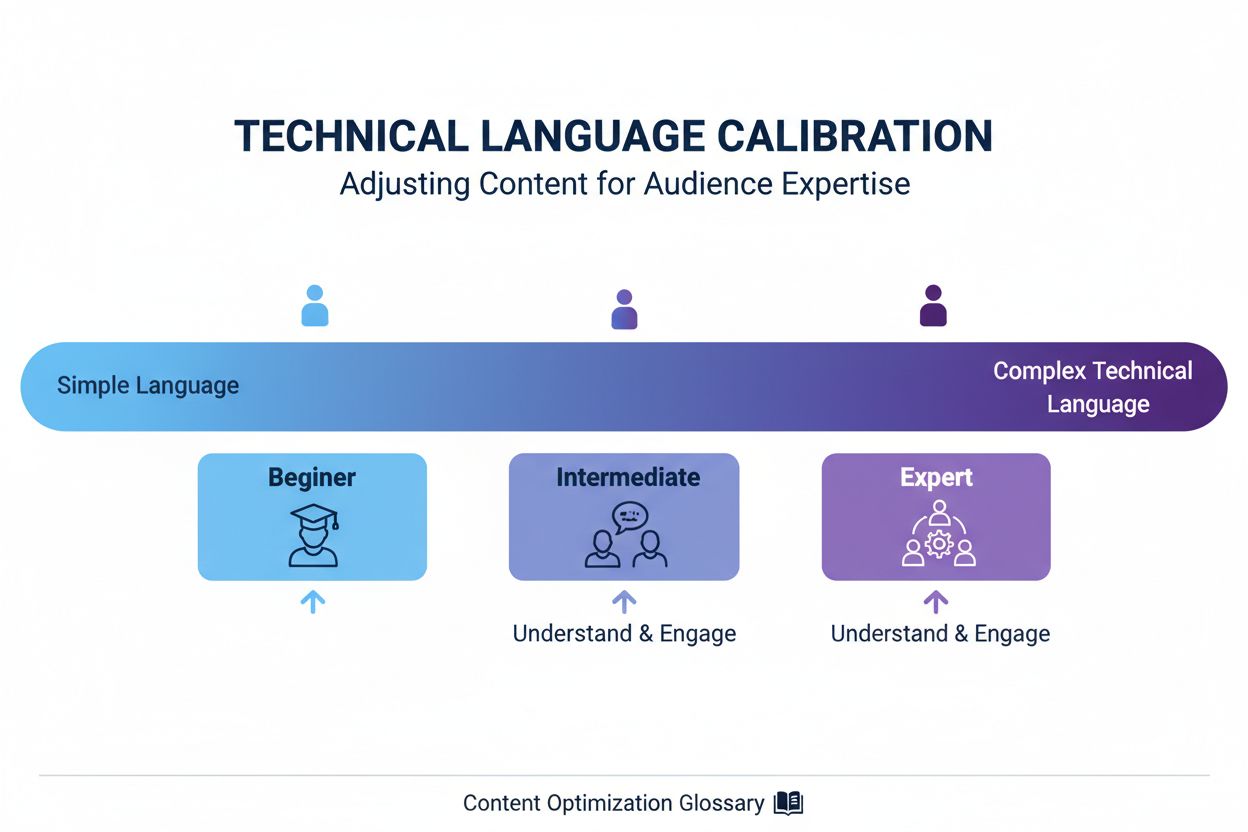

Învață cum să ajustezi complexitatea conținutului pentru diferite niveluri de expertiză ale audienței și pentru înțelegerea de către IA. Stăpânește metricile de...

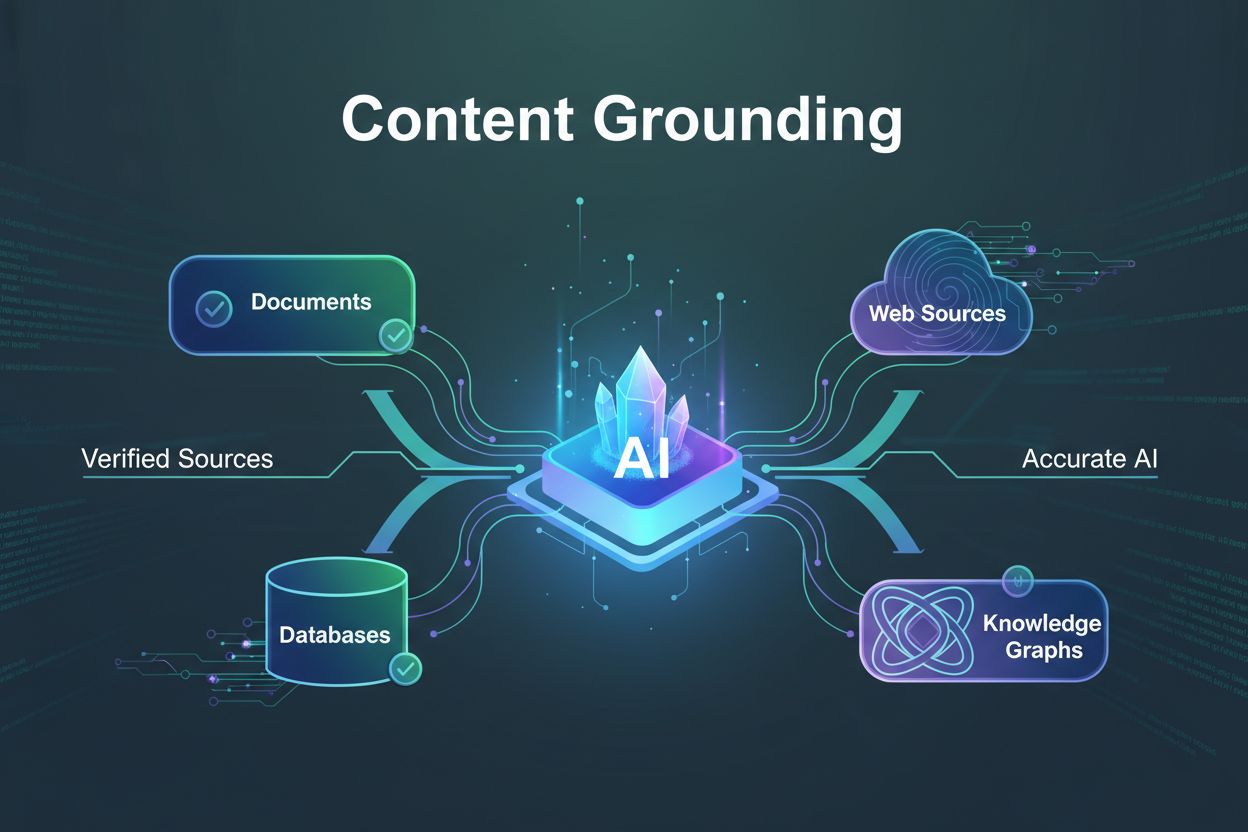

Află ce este ancorarea conținutului, cum previne halucinațiile AI și de ce este esențială pentru sisteme AI de încredere. Descoperă tehnici, unelte și bune prac...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.