Generare de conținut AI

Află ce este generarea de conținut AI, cum funcționează, beneficiile și provocările sale, precum și cele mai bune practici pentru utilizarea instrumentelor AI p...

Inteligența artificială generativă este inteligența artificială care creează conținut nou și original, precum text, imagini, videoclipuri, cod și audio, pe baza modelelor învățate din datele de instruire. Utilizează modele de învățare profundă precum transformerele și modelele de difuzie pentru a genera rezultate diverse ca răspuns la solicitările sau cererile utilizatorilor.

Inteligența artificială generativă este inteligența artificială care creează conținut nou și original, precum text, imagini, videoclipuri, cod și audio, pe baza modelelor învățate din datele de instruire. Utilizează modele de învățare profundă precum transformerele și modelele de difuzie pentru a genera rezultate diverse ca răspuns la solicitările sau cererile utilizatorilor.

Inteligența artificială generativă este o categorie de inteligență artificială care creează conținut nou și original pe baza modelelor învățate din datele de instruire. Spre deosebire de sistemele AI tradiționale care clasifică sau prezic informații, modelele AI generative produc autonom rezultate noi precum text, imagini, videoclipuri, audio, cod și alte tipuri de date ca răspuns la solicitările sau cererile utilizatorilor. Aceste sisteme utilizează modele sofisticate de învățare profundă și rețele neuronale pentru a identifica modele și relații complexe în seturi masive de date, folosind apoi aceste cunoștințe pentru a genera conținut care seamănă cu datele de instruire, dar este distinct de acestea. Termenul „generativ” subliniază capacitatea modelului de a genera—de a crea ceva nou, nu doar de a analiza sau categoriza informații existente. De la lansarea publică a ChatGPT în noiembrie 2022, AI generativă a devenit una dintre cele mai transformative tehnologii din IT, schimbând fundamental modul în care organizațiile abordează crearea de conținut, rezolvarea problemelor și luarea deciziilor în aproape orice industrie.

Bazele AI generative se întind pe parcursul a decenii, deși tehnologia a evoluat dramatic în ultimii ani. Modelele statistice timpurii din secolul XX au pus bazele înțelegerii distribuțiilor de date, dar adevărata AI generativă a apărut odată cu progresele în învățarea profundă și rețelele neuronale în anii 2010. Introducerea autoencoderelor variaționale (VAE) în 2013 a marcat un progres semnificativ, permițând modelelor să genereze variații realiste ale datelor precum imagini și vorbire. În 2014, au apărut rețelele generative adversariale (GAN) și modelele de difuzie, îmbunătățind și mai mult calitatea și realismul conținutului generat. Momentul de cotitură a venit în 2017, când cercetătorii au publicat „Attention is All You Need”, introducând arhitectura transformer—un progres ce a transformat fundamental modul în care modelele AI generative procesează și generează date secvențiale. Această inovație a permis dezvoltarea marilor modele de limbaj (LLM) precum seria GPT de la OpenAI, care au demonstrat capacități fără precedent de înțelegere și generare a limbajului uman. Potrivit cercetărilor McKinsey, o treime dintre organizații foloseau deja AI generativă în mod regulat în cel puțin o funcție de business până în 2023, iar Gartner estimează că peste 80% dintre companii vor fi implementat aplicații sau API-uri AI generative până în 2026. Accelerarea rapidă de la curiozitate de cercetare la necesitate enterprise reprezintă unul dintre cele mai rapide cicluri de adoptare a tehnologiei din istorie.

AI generativă operează printr-un proces multi-fază ce începe cu antrenarea pe seturi masive de date, urmată de ajustare pentru aplicații specifice și cicluri continue de generare, evaluare și re-ajustare. În faza de antrenare, practicienii oferă algoritmilor de învățare profundă terabiți de date brute, neorganizate—precum texte de pe internet, imagini sau depozite de cod—iar algoritmul efectuează milioane de exerciții de tip „completează spațiul liber”, prezicând următorul element dintr-o secvență și ajustându-se pentru a minimiza erorile de predicție. Acest proces creează o rețea neuronală de parametri ce encodează modelele, entitățile și relațiile descoperite în datele de antrenament. Rezultatul este un model foundation—un model mare, pre-antrenat, capabil să realizeze multiple sarcini în diferite domenii. Modelele foundation precum GPT-3, GPT-4 și Stable Diffusion servesc ca bază pentru numeroase aplicații specializate. Faza de ajustare implică fine-tuning cu date etichetate specifice unei sarcini sau folosirea învățării prin întărire cu feedback uman (RLHF), unde evaluatorii umani punctează diverse rezultate pentru a ghida modelul spre o mai mare acuratețe și relevanță. Dezvoltatorii și utilizatorii evaluează continuu rezultatele și ajustează modelele—uneori săptămânal—pentru a îmbunătăți performanța. O altă tehnică de optimizare este generarea augmentată prin regăsire (RAG), care extinde modelul foundation pentru a accesa surse externe relevante, asigurând acces constant la informații actuale și transparență privind sursele.

| Tip Model | Abordare de Antrenare | Viteză de Generare | Calitate Output | Diversitate | Cele mai Bune Utilizări |

|---|---|---|---|---|---|

| Modele de Difuzie | Eliminare iterativă a zgomotului din date aleatorii | Lent (mai multe iterații) | Foarte ridicată (fotorealistic) | Ridicată | Generare de imagini, sinteză de înaltă fidelitate |

| Rețele Generative Adversariale (GANs) | Competiție generator vs. discriminator | Rapidă | Ridicată | Mai scăzută | Generare specifică domeniului, transfer de stil |

| Autoencodere Variaționale (VAE) | Encoder-decoder cu spațiu latent | Moderată | Moderată | Moderată | Compresie de date, detecție de anomalii |

| Modele Transformer | Auto-atenție pe date secvențiale | Moderată spre rapidă | Foarte ridicată (text/cod) | Foarte ridicată | Generare de limbaj, sinteză de cod, LLM-uri |

| Abordări Hibride | Combinarea mai multor arhitecturi | Variabilă | Foarte ridicată | Foarte ridicată | Generare multimodală, sarcini complexe |

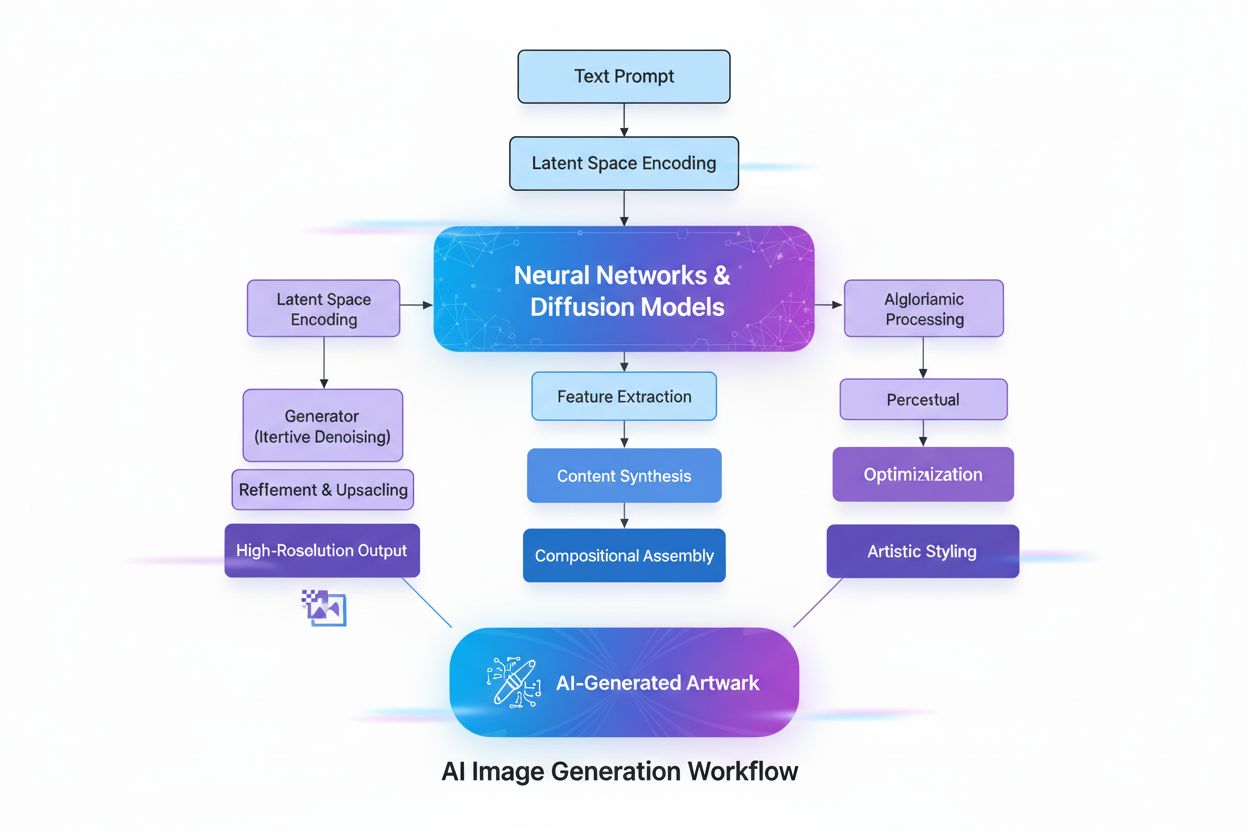

Arhitectura transformer reprezintă cea mai influentă tehnologie ce permite AI generativă modernă. Transformerele folosesc mecanisme de auto-atenție pentru a determina care părți din datele de intrare sunt cele mai importante la procesarea fiecărui element, permițând modelului să capteze dependențe pe termen lung și context. Codificarea pozițională reprezintă ordinea elementelor de intrare, permițând transformerelor să înțeleagă structura secvenței fără procesare secvențială. Această capacitate de procesare paralelă accelerează dramatic antrenarea comparativ cu rețelele neuronale recurente (RNN) anterioare. Structura encoder-decoder a transformerului, combinată cu multiple straturi de capete de atenție, permite modelului să analizeze simultan diverse aspecte ale datelor și să rafineze embedding-urile contextuale la fiecare nivel. Aceste embedding-uri surprind de la gramatică și sintaxă până la semnificații semantice complexe. Marile modele de limbaj (LLM) precum ChatGPT, Claude și Gemini sunt construite pe arhitecturi transformer și conțin miliarde de parametri—reprezentări codificate ale modelelor învățate. Scara acestor modele, împreună cu antrenamentul pe date la scară internet, le permite să realizeze sarcini diverse, de la traducere și rezumare la scriere creativă și generare de cod. Modelele de difuzie, o altă arhitectură esențială, lucrează adăugând inițial zgomot datelor de antrenament până ajung aleatorii, apoi antrenând algoritmul să elimine iterativ acel zgomot pentru a obține rezultatele dorite. Deși modelele de difuzie necesită mai mult timp de antrenare decât VAE sau GAN, oferă control superior asupra calității outputului, în special pentru instrumente de generare de imagini de înaltă fidelitate precum DALL-E și Stable Diffusion.

Cazul de business pentru AI generativă s-a dovedit convingător, companiile experimentând creșteri măsurabile de productivitate și reducerea costurilor. Potrivit raportului OpenAI din 2025 despre AI enterprise, utilizatorii raportează economii de 40–60 de minute pe zi datorită aplicațiilor AI generative, ceea ce se traduce în îmbunătățiri semnificative de productivitate. Piața AI generative a fost evaluată la 16,87 miliarde USD în 2024 și se estimează că va ajunge la 109,37 miliarde USD până în 2030, cu o rată CAGR de 37,6%—una dintre cele mai rapide creșteri din istoria software-ului enterprise. Cheltuielile enterprise pentru AI generativă au ajuns la 37 miliarde USD în 2025, față de 11,5 miliarde USD în 2024, reprezentând o creștere de 3,2 ori de la an la an. Această accelerare reflectă o încredere tot mai mare în ROI, cumpărătorii AI având o rată de conversie de 47% față de 25% pentru SaaS-ul tradițional, indicând că AI generativă oferă valoare imediată suficientă pentru a justifica adoptarea rapidă. Organizațiile implementează AI generativă în mai multe funcții: echipele de customer service folosesc chatboți AI pentru răspunsuri personalizate și rezolvarea rapidă a solicitărilor; departamentele de marketing folosesc generarea de conținut pentru bloguri, emailuri și social media; echipele de dezvoltare software utilizează instrumente de generare de cod pentru a accelera ciclurile de dezvoltare; iar echipele de cercetare folosesc modele generative pentru a analiza seturi complexe de date și a propune soluții inovatoare. Companiile din servicii financiare utilizează AI generativă pentru detectarea fraudelor și consiliere financiară personalizată, iar organizațiile din sănătate o aplică în descoperirea de medicamente și analiza imaginilor medicale. Versatilitatea tehnologiei în toate industriile demonstrează potențialul său transformator pentru operațiunile de business.

Aplicațiile AI generative acoperă practic orice sector și funcție. În generarea de text, modelele produc conținut coerent și relevant contextual, incluzând documentație, texte de marketing, articole de blog, lucrări de cercetare și scriere creativă. Ele excelează în automatizarea sarcinilor plictisitoare de redactare, precum rezumarea documentelor și generarea de metadate, eliberând scriitorii umani pentru activități creative de valoare mai mare. Instrumentele de generare de imagini precum DALL-E, Midjourney și Stable Diffusion creează imagini fotorealistice, artă originală, transfer de stil și editare de imagini. Generarea de videoclipuri permite crearea de animații din prompturi text și aplicarea de efecte speciale mai rapid decât metodele tradiționale. Generarea de audio și muzică sintetizează vorbire naturală pentru chatboți și asistenți digitali, creează naratori de cărți audio și generează muzică originală care imită compoziții profesionale. Generarea de cod permite dezvoltatorilor să scrie cod original, să completeze automat fragmente, să traducă între limbaje de programare și să depaneze aplicații. În sănătate, AI generativă accelerează descoperirea de medicamente prin generarea de secvențe proteice și structuri moleculare noi cu proprietăți dorite. Generarea de date sintetice produce date de instruire etichetate pentru modele de machine learning, fiind valoroasă când datele reale sunt restricționate, indisponibile sau insuficiente pentru cazuri rare. În automotive, AI generativă creează simulări 3D pentru dezvoltarea vehiculelor și date sintetice pentru instruirea vehiculelor autonome. Companiile din media și entertainment utilizează AI generativă pentru a crea animații, scenarii, medii de joc și recomandări personalizate de conținut. Companiile de energie aplică modele generative pentru managementul rețelei, optimizarea siguranței operaționale și prognoza producției de energie. Diversitatea aplicațiilor demonstrează rolul AI generative ca tehnologie fundamentală ce remodelează modul în care organizațiile creează, analizează și inovează.

În ciuda capabilităților remarcabile, AI generativă prezintă provocări semnificative pe care organizațiile trebuie să le abordeze. Halucinațiile AI—rezultate care sună plauzibil, dar sunt incorecte factual—apar deoarece modelele generative prezic următorul element pe baza modelelor, nu a verificării faptelor. Un avocat a folosit celebru ChatGPT pentru cercetare juridică și a primit citări de cauze complet fictive, cu tot cu citate și atribuiri. Problemele de bias și echitate apar atunci când datele de antrenament conțin prejudecăți sociale, determinând modelele să genereze conținut părtinitor, incorect sau ofensator. Rezultatele inconsistente rezultă din natura probabilistică a modelelor generative, unde aceleași inputuri pot produce rezultate diferite—problematic pentru aplicații ce necesită consistență precum chatboții de suport clienți. Lipsa de explicabilitate face dificilă înțelegerea modului în care modelele ajung la anumite rezultate; chiar și inginerii întâmpină dificultăți în a explica procesele decizionale ale acestor „cutii negre”. Amenințările de securitate și confidențialitate apar când datele proprietare sunt folosite la antrenarea modelelor sau când acestea generează conținut ce expune proprietate intelectuală sau încalcă drepturile altora. Deepfake-urile—imagini, video sau audio generate sau manipulate de AI pentru a induce în eroare—reprezintă una dintre cele mai îngrijorătoare aplicații, infractorii cibernetici folosind deepfake-uri în escrocherii vocale și fraude financiare. Costurile computaționale rămân semnificative, antrenarea marilor modele foundation necesitând mii de GPU-uri și săptămâni de procesare ce costă milioane de dolari. Organizațiile atenuează aceste riscuri prin măsuri de protecție ce restricționează modelele la surse de date de încredere, evaluare și ajustare continuă pentru reducerea halucinațiilor, date de instruire diverse pentru minimizarea biasului, inginerie de prompturi pentru obținerea de rezultate consistente și protocole de securitate ce protejează informațiile proprietare. Transparența privind utilizarea AI și supravegherea umană a deciziilor critice rămân bune practici esențiale.

Pe măsură ce sistemele AI generative devin surse principale de informare pentru milioane de utilizatori, organizațiile trebuie să înțeleagă cum apar brandurile, produsele și conținutul lor în răspunsurile generate de AI. Monitorizarea vizibilității AI presupune urmărirea sistematică a modului în care principalele platforme AI generative—incluzând ChatGPT, Perplexity, Google AI Overviews și Claude—descriu branduri, produse și competitori. Această monitorizare este critică deoarece sistemele AI citează adesea surse și referințează informații fără metricile tradiționale de vizibilitate ale motoarelor de căutare. Brandurile care nu apar în răspunsurile AI pierd oportunități de vizibilitate și influență în peisajul căutărilor conduse de AI. Instrumente precum AmICited permit organizațiilor să urmărească mențiunile brandului, să monitorizeze acuratețea citărilor, să identifice domeniile și URL-urile referențiate în răspunsurile AI și să înțeleagă cum își poziționează AI brandul față de competiție. Aceste date ajută organizațiile să-și optimizeze conținutul pentru citare AI, să identifice informații greșite sau reprezentări inexacte și să mențină vizibilitatea competitivă pe măsură ce AI devine interfața principală între utilizatori și informație. Practica de GEO (Generative Engine Optimization) se concentrează pe optimizarea conținutului special pentru citare și vizibilitate AI, completând strategiile SEO tradiționale. Organizațiile care monitorizează și optimizează proactiv vizibilitatea AI dobândesc avantaje competitive în noul ecosistem informațional condus de AI.

Peisajul AI generative continuă să evolueze rapid, cu mai multe tendințe cheie care modelează viitorul. AI multimodală care integrează fără probleme text, imagini, video și audio devine tot mai sofisticată, permițând generarea de conținut complex și nuanțat. AI agentică—sisteme AI autonome capabile să îndeplinească sarcini și să atingă obiective fără intervenție umană—reprezintă următoarea evoluție dincolo de AI generativă, agenții AI folosind conținutul generat pentru a interacționa cu instrumente și a lua decizii. Modele mai mici și mai eficiente apar ca alternative la modelele foundation masive, permițând organizațiilor să implementeze AI generativă cu costuri computaționale reduse și viteze de inferență mai mari. Generarea augmentată prin regăsire (RAG) evoluează continuu, permițând modelelor să acceseze informații actuale și surse externe, abordând problemele de halucinații și acuratețe. Cadrul de reglementare se dezvoltă la nivel global, guvernele stabilind ghiduri pentru dezvoltarea și implementarea responsabilă a AI. Personalizarea enterprise prin fine-tuning și modele specifice domeniului se accelerează, organizațiile dorind să adapteze AI generativă la propriul context de afaceri. Practici etice în AI devin diferențiatori competitivi, organizațiile prioritizând transparența, echitatea și implementarea responsabilă. Convergența acestor tendințe sugerează că AI generativă va deveni tot mai integrată în operațiunile de business, mai eficientă și accesibilă pentru organizații de orice dimensiune și supusă unor standarde de guvernanță și etică mai riguroase. Organizațiile care investesc în înțelegerea AI generative, monitorizarea vizibilității AI și implementarea responsabilă vor fi cel mai bine poziționate să valorifice această tehnologie transformatoare, gestionând totodată riscurile asociate.

Inteligența artificială generativă creează conținut nou prin învățarea distribuției datelor și generarea de rezultate noi, în timp ce inteligența artificială discriminativă se concentrează pe sarcini de clasificare și predicție, învățând granițele de decizie dintre categorii. Modelele generative AI precum GPT-3 și DALL-E produc conținut creativ, în timp ce modelele discriminative sunt mai potrivite pentru sarcini precum recunoașterea imaginilor sau detectarea spamului. Ambele abordări au aplicații distincte, în funcție de scopul urmărit: crearea de conținut sau clasificarea datelor.

Modelele transformer folosesc mecanisme de auto-atentie și codificare pozițională pentru a procesa date secvențiale, precum textul, fără a necesita procesare secvențială. Această arhitectură permite transformerelor să capteze dependențe pe termen lung între cuvinte și să înțeleagă contextul mai eficient decât modelele anterioare. Capacitatea transformatorului de a procesa întregi secvențe simultan și de a învăța relații complexe a făcut din el fundația majorității sistemelor moderne de AI generativă, inclusiv ChatGPT și GPT-4.

Modelele foundation sunt modele de învățare profundă la scară largă, pre-antrenate pe cantități mari de date neetichetate, care pot îndeplini multiple sarcini în diferite domenii. Exemple includ GPT-3, GPT-4 și Stable Diffusion. Aceste modele servesc ca bază pentru diverse aplicații de AI generativă și pot fi ajustate (fine-tuning) pentru cazuri de utilizare specifice, fiind astfel foarte versatile și eficiente din punct de vedere al costurilor comparativ cu antrenarea modelelor de la zero.

Pe măsură ce sistemele de AI generativă precum ChatGPT, Perplexity și Google AI Overviews devin surse principale de informare, brandurile trebuie să urmărească modul în care apar în răspunsurile generate de AI. Monitorizarea vizibilității AI ajută organizațiile să înțeleagă percepția asupra brandului, să asigure reprezentarea corectă a informațiilor și să mențină poziționarea competitivă în peisajul căutărilor conduse de AI. Instrumente precum AmICited permit brandurilor să urmărească mențiunile și citările pe mai multe platforme AI.

Sistemele AI generative pot produce „halucinații”—rezultate care sună plauzibil, dar sunt incorecte factual—din cauza abordării bazate pe modele. Aceste modele pot reflecta, de asemenea, prejudecăți din datele de instruire, pot genera rezultate inconsistente pentru aceleași inputuri și pot lipsi de transparență în procesele de luare a deciziilor. Abordarea acestor provocări necesită date de instruire diverse, evaluare continuă și implementarea de măsuri de protecție care să restricționeze modelele la surse de date de încredere.

Modelele de difuzie generează conținut prin eliminarea iterativă a zgomotului din date aleatorii, oferind rezultate de înaltă calitate, dar cu viteze de generare mai mici. GAN-urile folosesc două rețele neuronale concurente (generator și discriminator) pentru a produce conținut realist rapid, dar cu diversitate mai scăzută. Modelele de difuzie sunt preferate în prezent pentru generarea de imagini de înaltă fidelitate, în timp ce GAN-urile rămân eficiente pentru aplicații specifice unde este nevoie de un echilibru între viteză și calitate.

Piața AI generative a fost evaluată la 16,87 miliarde USD în 2024 și se estimează că va ajunge la 109,37 miliarde USD până în 2030, crescând cu o rată anuală compusă (CAGR) de 37,6% din 2025 până în 2030. Cheltuielile enterprise pentru AI generativă au ajuns la 37 miliarde USD în 2025, reprezentând o creștere de 3,2 ori față de 11,5 miliarde USD în 2024, ceea ce demonstrează o adoptare rapidă în diverse industrii.

Implementarea responsabilă a AI generative presupune începerea cu aplicații interne pentru a testa rezultatele în medii controlate, asigurarea transparenței prin comunicarea clară a folosirii AI, implementarea de măsuri de securitate pentru a preveni accesul neautorizat la date și testarea extensivă pe scenarii diverse. Organizațiile ar trebui, de asemenea, să stabilească cadre clare de guvernanță, să monitorizeze rezultatele privind biasul și acuratețea și să mențină supravegherea umană a deciziilor critice.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Află ce este generarea de conținut AI, cum funcționează, beneficiile și provocările sale, precum și cele mai bune practici pentru utilizarea instrumentelor AI p...

Află ce sunt imaginile generate de AI, cum sunt create folosind modele de difuzie și rețele neuronale, aplicațiile lor în marketing și design și considerațiile ...

Află ce este Search Generative Experience (SGE), cum funcționează și de ce monitorizarea vizibilității brandului tău în rezultatele SGE este esențială pentru pr...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.