Acoperire Index AI

Află ce este Acoperirea Indexului AI și de ce contează pentru vizibilitatea brandului tău în ChatGPT, Google AI Overviews și Perplexity. Descoperă factori tehni...

Acoperirea indexului se referă la procentajul și starea paginilor unui site web care au fost descoperite, accesate de crawlere și incluse în indexul unui motor de căutare. Ea măsoară care pagini sunt eligibile să apară în rezultatele căutărilor și identifică problemele tehnice ce împiedică indexarea.

Acoperirea indexului se referă la procentajul și starea paginilor unui site web care au fost descoperite, accesate de crawlere și incluse în indexul unui motor de căutare. Ea măsoară care pagini sunt eligibile să apară în rezultatele căutărilor și identifică problemele tehnice ce împiedică indexarea.

Acoperirea indexului reprezintă măsura în care paginile site-ului tău au fost descoperite, accesate de crawlere și incluse în indexul unui motor de căutare. Ea exprimă procentajul paginilor site-ului tău ce sunt eligibile să apară în rezultatele căutărilor și identifică acele pagini care întâmpină probleme tehnice ce împiedică indexarea. În esență, acoperirea indexului răspunde la întrebarea esențială: „Cât din site-ul meu pot motoarele de căutare să descopere și să claseze?” Această metrică este fundamentală pentru a înțelege vizibilitatea site-ului tău în motoarele de căutare și este monitorizată cu ajutorul instrumentelor precum Google Search Console, care oferă rapoarte detaliate despre paginile indexate, excluse sau cu erori. Fără o acoperire corectă a indexului, chiar și cel mai optimizat conținut rămâne invizibil atât pentru motoarele de căutare, cât și pentru utilizatorii care caută informațiile tale.

Acoperirea indexului nu se referă doar la cantitate—ci la a te asigura că sunt indexate paginile potrivite. Un site ar putea avea mii de pagini, dar dacă multe dintre ele sunt duplicate, au conținut slab sau sunt blocate de robots.txt, acoperirea indexului reală poate fi mult mai mică decât te-ai aștepta. Această distincție dintre totalul paginilor și paginile indexate este esențială pentru dezvoltarea unei strategii SEO eficiente. Organizațiile care monitorizează regulat acoperirea indexului pot identifica și remedia problemele tehnice înainte ca acestea să afecteze traficul organic, făcând din acest indicator unul dintre cei mai acționabili metrici din SEO tehnic.

Conceptul de acoperire a indexului a apărut pe măsură ce motoarele de căutare au evoluat de la crawlere simple la sisteme sofisticate, capabile să proceseze milioane de pagini zilnic. În primii ani ai SEO, administratorii de site-uri aveau o vizibilitate limitată asupra modului în care motoarele de căutare interacționau cu site-urile lor. Google Search Console, lansat inițial sub numele Google Webmaster Tools în 2006, a revoluționat această transparență oferind feedback direct despre starea de crawlare și indexare. Raportul de acoperire a indexului (anterior numit „Page Indexing”) a devenit principalul instrument pentru a înțelege ce pagini a indexat Google și de ce altele au fost excluse.

Pe măsură ce site-urile au devenit mai complexe, cu conținut dinamic, parametri și pagini duplicate, problemele de acoperire a indexului au devenit din ce în ce mai frecvente. Cercetările arată că aproximativ 40-60% dintre site-uri au probleme semnificative de acoperire a indexului, multe pagini rămânând nedescoperite sau excluse deliberat din index. Creșterea numărului de site-uri heavy-JavaScript și aplicații single-page a complicat suplimentar indexarea, deoarece motoarele de căutare trebuie să redea conținutul înainte de a determina indexabilitatea. Astăzi, monitorizarea acoperirii indexului este considerată esențială pentru orice organizație ce se bazează pe traficul organic, experții din industrie recomandând audituri lunare cel puțin.

Relația dintre acoperirea indexului și bugetul de crawl a devenit tot mai importantă pe măsură ce site-urile au crescut. Bugetul de crawl se referă la numărul de pagini pe care Googlebot le va accesa pe site-ul tău într-un anumit interval de timp. Site-urile mari, cu o arhitectură slabă sau cu mult conținut duplicat, pot risipi bugetul de crawl pe pagini de valoare redusă, lăsând conținutul important nedescoperit. Studiile arată că peste 78% dintre companii folosesc un instrument de monitorizare a conținutului pentru a urmări vizibilitatea pe motoarele de căutare și platforme AI, recunoscând că acoperirea indexului este fundamentală pentru orice strategie de vizibilitate.

| Concept | Definiție | Control principal | Instrumente folosite | Impact asupra clasamentului |

|---|---|---|---|---|

| Acoperirea indexului | Procentajul paginilor indexate de motoarele de căutare | Meta tag-uri, robots.txt, calitatea conținutului | Google Search Console, Bing Webmaster Tools | Direct—doar paginile indexate pot fi clasate |

| Crawlabilitate | Capacitatea roboților de a accesa și naviga paginile | robots.txt, structura site-ului, linkuri interne | Screaming Frog, ZentroAudit, jurnale server | Indirect—paginile trebuie să fie crawlabile pentru a fi indexate |

| Indexabilitate | Capacitatea paginilor accesate de a fi adăugate în index | Directive noindex, tag-uri canonice, conținut | Google Search Console, URL Inspection Tool | Direct—determină dacă paginile apar în rezultate |

| Buget de crawl | Numărul de pagini accesate de Googlebot într-un interval | Autoritatea site-ului, calitatea paginii, erori de crawl | Google Search Console, jurnale server | Indirect—influențează ce pagini sunt accesate |

| Conținut duplicat | Mai multe pagini cu conținut identic sau similar | Tag-uri canonice, redirecționări 301, noindex | Instrumente audit SEO, revizuire manuală | Negativ—diluează potențialul de clasare |

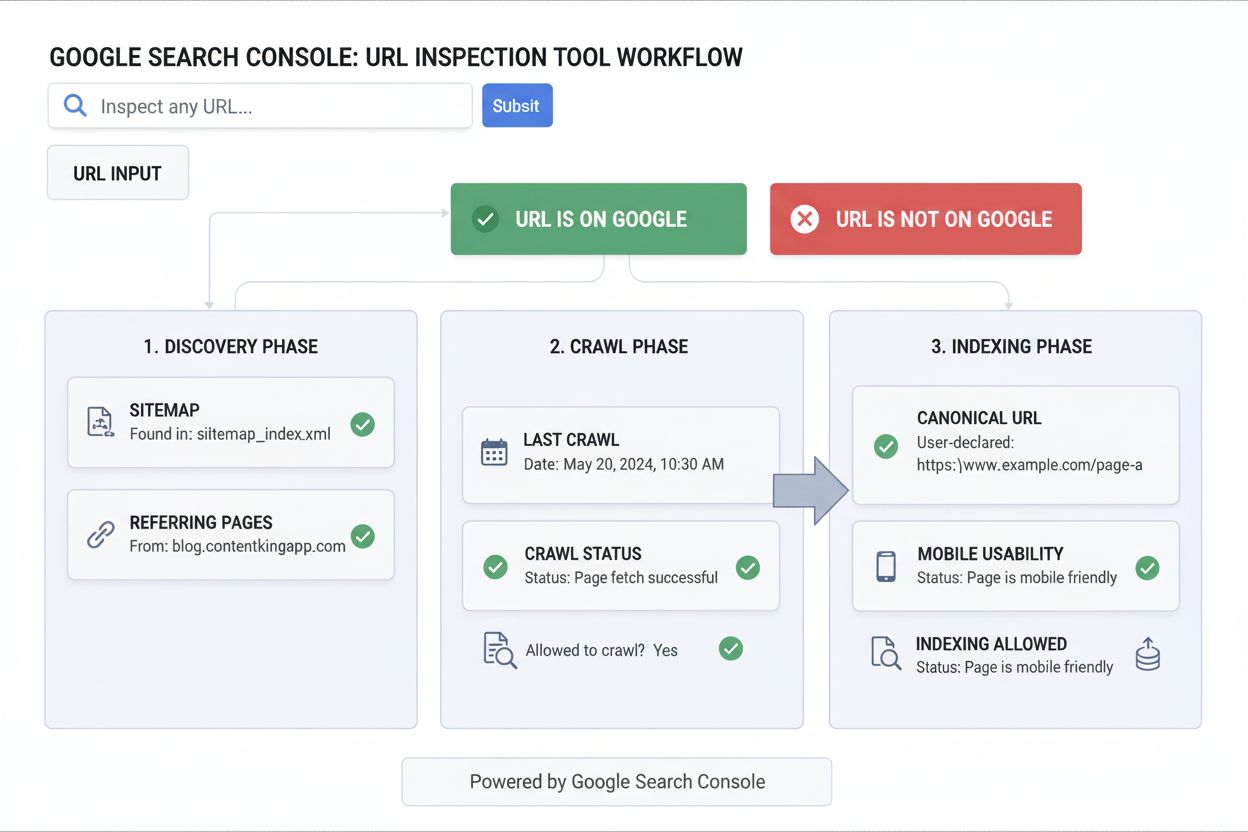

Acoperirea indexului funcționează printr-un proces în trei etape: descoperire, crawlare și indexare. În faza de descoperire, motoarele de căutare găsesc URL-uri prin diverse metode, inclusiv sitemap-uri XML, linkuri interne, backlinkuri externe și trimiteri directe prin Google Search Console. Odată descoperite, URL-urile sunt puse în coada de crawlare, unde Googlebot accesează pagina și îi analizează conținutul. În final, la indexare, Google procesează conținutul paginii, îi determină relevanța și calitatea și decide dacă să o includă în indexul de căutare.

Raportul de acoperire a indexului din Google Search Console clasifică paginile în patru statusuri principale: Valid (pagini indexate), Valid cu avertizări (indexate dar cu probleme), Excluse (intenționat neindexate) și Eroare (pagini ce nu au putut fi indexate). Fiecare status conține tipuri specifice de probleme, oferind detalii despre motivul pentru care anumite pagini sunt sau nu indexate. De exemplu, paginile pot fi excluse din cauza unui meta tag noindex, a blocării prin robots.txt, a duplicării fără tag-uri canonice sau a returnării unor coduri de stare HTTP 4xx/5xx.

Înțelegerea mecanismelor tehnice din spatele acoperirii indexului implică cunoașterea unor componente cheie. Fisierul robots.txt este un fișier text aflat în directorul rădăcină al site-ului, care instruiește crawlerii motoarelor de căutare ce directoare și fișiere pot sau nu pot accesa. O configurare greșită a robots.txt este una dintre cele mai frecvente cauze ale problemelor de acoperire a indexului—blocarea accidentală a unor directoare importante împiedică Google să descopere acele pagini. Meta tag-ul robots, plasat în secțiunea head a paginii HTML, oferă instrucțiuni la nivel de pagină prin directive ca index, noindex, follow și nofollow. Tag-ul canonical (rel=“canonical”) indică motoarelor de căutare care versiune a unei pagini este preferată când există duplicate, prevenind indexarea excesivă și consolidând semnalele de clasare.

Pentru afacerile care depind de traficul organic, acoperirea indexului are impact direct asupra veniturilor și vizibilității. Atunci când pagini importante nu sunt indexate, ele nu pot apărea în rezultatele de căutare, ceea ce înseamnă că potențialii clienți nu le vor găsi prin Google. Site-urile de e-commerce cu acoperire slabă pot avea pagini de produs blocate în statusul „Descoperit – momentan neindexat”, ceea ce duce la pierderi de vânzări. Platformele de content marketing cu mii de articole au nevoie de o acoperire robustă pentru ca informațiile să ajungă la public. Companiile SaaS depind de documentație și articole de blog indexate pentru a genera lead-uri organice.

Implicarea practică depășește căutarea tradițională. Odată cu apariția platformelor AI generative precum ChatGPT, Perplexity și Google AI Overviews, acoperirea indexului a devenit relevantă și pentru vizibilitatea în AI. Aceste sisteme se bazează adesea pe conținutul web indexat pentru date de antrenare și surse de citare. Dacă paginile tale nu sunt indexate corect de Google, e puțin probabil să fie incluse în seturile de date AI sau citate în răspunsurile generate de acestea. Astfel, apare o problemă de vizibilitate compusă: acoperirea slabă a indexului afectează atât clasamentul în căutarea tradițională, cât și vizibilitatea în conținutul generat de AI.

Organizațiile care monitorizează proactiv acoperirea indexului observă creșteri măsurabile ale traficului organic. Un scenariu tipic implică descoperirea că 30-40% dintre URL-urile trimise sunt excluse din cauza tag-urilor noindex, conținutului duplicat sau a erorilor de crawl. După remediere—eliminarea tag-urilor noindex inutile, implementarea corectă a canonicalizării și rezolvarea erorilor de crawl—numărul paginilor indexate crește adesea cu 20-50%, corelat direct cu îmbunătățirea vizibilității organice. Costul inacțiunii este semnificativ: fiecare lună în care o pagină rămâne neindexată înseamnă o lună de trafic și conversii pierdute.

Google Search Console rămâne principalul instrument de monitorizare a acoperirii indexului, oferind cele mai autoritare date despre deciziile de indexare ale Google. Raportul de acoperire index indică paginile indexate, cele cu avertizări, excluse sau cu erori, cu detalii despre tipurile specifice de probleme. Google oferă și URL Inspection Tool, care îți permite să verifici statusul de indexare al unei pagini individuale și să soliciți indexarea conținutului nou sau actualizat. Acest instrument este de neprețuit pentru depanarea paginilor specifice și înțelegerea motivelor pentru care Google nu a indexat anumite conținuturi.

Bing Webmaster Tools oferă funcționalități similare prin Index Explorer și URL Submission. Deși cota de piață a Bing este mai mică decât a Google, este important să ajungi și la utilizatorii care preferă Bing. Datele de acoperire index de la Bing diferă uneori de cele ale Google, scoțând la iveală probleme specifice algoritmilor Bing. Organizațiile care gestionează site-uri mari ar trebui să monitorizeze ambele platforme pentru o acoperire completă.

Pentru monitorizarea AI și vizibilitatea brandului, platforme precum AmICited urmăresc modul în care brandul și domeniul tău apar în ChatGPT, Perplexity, Google AI Overviews și Claude. Aceste platforme corelează acoperirea indexului tradițională cu vizibilitatea în AI, ajutând organizațiile să înțeleagă cum se traduce conținutul indexat în mențiuni în răspunsurile generate de AI. Această integrare este crucială în strategia SEO modernă, deoarece vizibilitatea în sistemele AI influențează tot mai mult notorietatea brandului și traficul.

Instrumente terțe de audit SEO precum Ahrefs, SEMrush și Screaming Frog oferă informații suplimentare despre acoperirea indexului, accesând site-ul independent și comparând rezultatele cu cele raportate de Google. Discrepanțele dintre crawlingul propriu și cel al Google pot evidenția probleme precum randarea JavaScript, probleme server-side sau limitări de buget de crawl. Aceste instrumente identifică și paginile orfane (fără linkuri interne), care adesea au probleme de indexare.

Îmbunătățirea acoperirii indexului necesită o abordare sistematică, ce abordează atât probleme tehnice, cât și strategice. În primul rând, auditează starea actuală folosind raportul de acoperire a indexului din Google Search Console. Identifică principalele tipuri de probleme care afectează site-ul tău—fie că sunt tag-uri noindex, blocaje robots.txt, conținut duplicat sau erori de crawl. Prioritizează remedierea: paginile care ar trebui indexate, dar nu sunt, au prioritate mai mare decât cele corect excluse.

În al doilea rând, corectează setările greșite din robots.txt revizuind fișierul și asigurându-te că nu blochezi accidental directoare importante. O greșeală frecventă este blocarea directoarelor /admin/, /staging/ sau /temp/ (care ar trebui blocate), dar și a directoarelor publice precum /blog/, /products/ sau alte secțiuni. Folosește testerul robots.txt din Google Search Console pentru a verifica dacă paginile importante nu sunt blocate.

În al treilea rând, implementează corect canonicalizarea pentru conținut duplicat. Dacă ai mai multe URL-uri ce oferă conținut similar (ex: pagini de produs accesibile din mai multe categorii), folosește tag-uri canonical autoreferențiale pe fiecare pagină sau redirecționări 301 pentru a consolida totul pe o singură versiune. Astfel previi indexarea excesivă și consolidezi semnalele de clasare pe versiunea preferată.

În al patrulea rând, elimină tag-urile noindex inutile de pe paginile pe care dorești să le indexezi. Auditează site-ul pentru directive noindex, mai ales pe medii de testare ce pot fi lansate accidental în producție. Folosește URL Inspection Tool pentru a verifica dacă paginile importante nu au tag-uri noindex.

În al cincilea rând, trimite un sitemap XML în Google Search Console care să conțină doar URL-uri indexabile. Păstrează sitemap-ul curat, excluzând paginile cu noindex, redirecționări sau erori 404. Pentru site-urile mari, împarte sitemap-ul pe tipuri de conținut sau secțiuni pentru o organizare mai bună și raportare mai granulară a erorilor.

În al șaselea rând, rezolvă erorile de crawl precum linkuri rupte (404), erori de server (5xx) și lanțuri de redirecționări. Folosește Google Search Console pentru a identifica paginile afectate, apoi abordează sistematic fiecare problemă. Pentru erorile 404 pe pagini importante, fie restaurezi conținutul, fie implementezi redirecționări 301 către alternative relevante.

Viitorul acoperirii indexului evoluează odată cu schimbările din tehnologia de căutare și apariția sistemelor AI generative. Pe măsură ce Google continuă să rafineze cerințele Core Web Vitals și standardele E-E-A-T (Experiență, Expertiză, Autoritate, Încredere), acoperirea indexului va depinde tot mai mult de calitatea conținutului și indicatorii de experiență a utilizatorului. Paginile cu scoruri slabe Core Web Vitals sau conținut superficial pot întâmpina dificultăți la indexare, chiar dacă sunt crawlabile tehnic.

Ascensiunea rezultatelor generate de AI și a motorilor de răspuns schimbă modul în care contează acoperirea indexului. Clasamentele tradiționale depind de paginile indexate, dar AI-ul poate cita conținut indexat diferit sau poate prioritiza anumite surse față de altele. Organizațiile vor trebui să monitorizeze nu doar dacă paginile sunt indexate de Google, ci și dacă sunt citate și referențiate de platformele AI. Această cerință duală de vizibilitate face ca monitorizarea acoperirii indexului să se extindă dincolo de Google Search Console, incluzând platforme de monitorizare AI ce urmăresc mențiunile brandului pe ChatGPT, Perplexity și alte sisteme AI generative.

Randarea JavaScript și conținutul dinamic vor continua să complice acoperirea indexului. Pe măsură ce tot mai multe site-uri adoptă framework-uri JavaScript și aplicații single-page, motoarele de căutare trebuie să redea JavaScript pentru a înțelege conținutul paginii. Google și-a îmbunătățit capacitățile de randare JavaScript, dar provocările persistă. Practicile viitoare vor pune accent probabil pe server-side rendering sau dynamic rendering pentru ca paginile să fie accesibile crawlerelor fără a necesita execuție JavaScript.

Integrarea datelor structurate și a schema markup va deveni tot mai importantă pentru acoperirea indexului. Motoarele de căutare folosesc date structurate pentru a înțelege mai bine conținutul și contextul paginilor, ceea ce poate îmbunătăți deciziile de indexare. Organizațiile care implementează schema markup complet pentru tipuri de conținut—articole, produse, evenimente, FAQ—pot observa o acoperire mai bună a indexului și vizibilitate îmbunătățită în rezultatele bogate.

În cele din urmă, conceptul de acoperire a indexului se va extinde dincolo de pagini, incluzând entități și subiecte. În loc să monitorizezi doar dacă paginile sunt indexate, viitorul va presupune urmărirea dacă brandul, produsele și subiectele tale sunt reprezentate corect în knowledge graph-urile motoarelor de căutare și în datele de antrenare AI. Aceasta reprezintă o schimbare fundamentală de la indexarea la nivel de pagină la vizibilitatea la nivel de entitate, necesitând noi abordări și strategii de monitorizare.

+++

Crawlabilitatea se referă la posibilitatea ca roboții motoarelor de căutare să acceseze și să navigheze paginile site-ului tău, fiind controlată de factori precum robots.txt și structura site-ului. Indexabilitatea, însă, determină dacă paginile accesate sunt adăugate efectiv în indexul motorului de căutare, fiind controlată de meta tag-uri robots, tag-uri canonice și calitatea conținutului. O pagină trebuie să fie crawlabilă pentru a fi indexabilă, dar faptul că este crawlabilă nu garantează indexarea.

Pentru majoritatea site-urilor, o verificare lunară a acoperirii indexului este suficientă pentru a depista problemele majore. Totuși, dacă faci modificări semnificative la structura site-ului, publici conținut nou regulat sau realizezi migrații, monitorizează raportul săptămânal sau bilunar. Google trimite notificări pe email despre problemele urgente, însă acestea apar de obicei cu întârziere, așa că monitorizarea proactivă este esențială pentru o vizibilitate optimă.

Acest status indică faptul că Google a găsit o adresă URL (de obicei prin sitemap-uri sau linkuri interne), dar nu a accesat-o încă. Se poate întâmpla din cauza limitărilor de buget de crawl, când Google prioritizează alte pagini ale site-ului. Dacă pagini importante rămân mult timp în acest status, poate semnala probleme de buget de crawl sau o autoritate scăzută a site-ului, care necesită atenție.

Da, trimiterea unui sitemap XML în Google Search Console ajută motoarele de căutare să descopere și să prioritizeze paginile tale pentru crawlare și indexare. Un sitemap bine întreținut, care conține doar URL-uri indexabile, poate îmbunătăți semnificativ acoperirea indexului, direcționând bugetul de crawl al Google către cel mai important conținut și reducând timpul necesar descoperirii.

Problemele comune includ pagini blocate de robots.txt, meta tag-uri noindex pe pagini importante, conținut duplicat fără canonicalizare corectă, erori de server (5xx), lanțuri de redirecționări și conținut slab. De asemenea, erorile 404, soft 404 și paginile care necesită autorizare (erori 401/403) apar frecvent în rapoartele de acoperire a indexului și trebuie remediate pentru a îmbunătăți vizibilitatea.

Acoperirea indexului influențează direct dacă conținutul tău apare în răspunsurile generate de AI de pe platforme precum ChatGPT, Perplexity și Google AI Overviews. Dacă paginile tale nu sunt indexate corect de Google, este puțin probabil să fie incluse în seturile de date pentru antrenare sau să fie citate de sistemele AI. Monitorizarea acoperirii indexului asigură ca brandul tău să fie descoperit și citat atât în căutarea tradițională, cât și pe platformele AI generative.

Bugetul de crawl reprezintă numărul de pagini pe care Googlebot le va accesa pe site-ul tău într-un anumit interval de timp. Site-urile cu un buget de crawl folosit ineficient pot avea multe pagini blocate în statusul 'Descoperit – momentan neindexat'. Optimizarea bugetului de crawl, prin remedierea erorilor de crawl, eliminarea URL-urilor duplicate și utilizarea strategică a robots.txt, asigură că Google se concentrează pe indexarea conținutului tău valoros.

Nu, nu toate paginile ar trebui indexate. Paginile din medii de testare, variante de produse duplicate, rezultate interne de căutare și arhive de politici de confidențialitate sunt de obicei mai bine excluse din index folosind tag-uri noindex sau robots.txt. Scopul este să indexezi doar conținutul valoros, unic, care răspunde intenției utilizatorului și contribuie la performanța generală SEO a site-ului.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Află ce este Acoperirea Indexului AI și de ce contează pentru vizibilitatea brandului tău în ChatGPT, Google AI Overviews și Perplexity. Descoperă factori tehni...

Indexabilitatea este abilitatea motoarelor de căutare de a include pagini în indexul lor. Află cum crawlabilitatea, factorii tehnici și calitatea conținutului i...

Află ce este Instrumentul de Inspectare a URL-urilor, cum funcționează și de ce este esențial pentru monitorizarea stării de indexare a paginilor în Google Sear...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.