Potrivirea conținutului cu prompturile: Optimizare pe baza intenției interogării

Află cum să aliniezi conținutul tău cu intenția interogărilor AI pentru a crește citările pe ChatGPT, Perplexity și Google AI. Stăpânește strategii de potrivire...

Inferența este procesul prin care un model AI antrenat generează rezultate, predicții sau concluzii din date noi de intrare, aplicând tiparele și cunoștințele învățate în timpul antrenamentului. Reprezintă faza operațională în care sistemele AI aplică inteligența dobândită la probleme reale, în medii de producție.

Inferența este procesul prin care un model AI antrenat generează rezultate, predicții sau concluzii din date noi de intrare, aplicând tiparele și cunoștințele învățate în timpul antrenamentului. Reprezintă faza operațională în care sistemele AI aplică inteligența dobândită la probleme reale, în medii de producție.

Inferența este procesul prin care un model de inteligență artificială antrenat generează rezultate, predicții sau concluzii din date noi de intrare, aplicând tiparele și cunoștințele învățate în faza de antrenament. În contextul sistemelor AI, inferența reprezintă faza operațională în care modelele de învățare automată trec din laborator în mediile de producție pentru a rezolva probleme reale. Când interacționezi cu ChatGPT, Perplexity, Google AI Overviews sau Claude, experimentezi inferența AI în acțiune—modelul preia intrarea ta și generează răspunsuri inteligente pe baza tiparelor învățate din seturi de date masive. Inferența este fundamental diferită de antrenament; în timp ce antrenamentul învață modelul ce să facă, inferența este momentul în care modelul chiar execută, aplicând cunoștințele dobândite pe date pe care nu le-a mai întâlnit.

Distincția dintre antrenamentul AI și inferința AI este esențială pentru a înțelege modul în care operează sistemele moderne de inteligență artificială. În faza de antrenament, oamenii de știință în domeniul datelor alimentează rețelele neuronale cu seturi enorme de date curate, permițând modelului să învețe tipare, relații și reguli de decizie prin optimizare iterativă. Acest proces este intensiv din punct de vedere computațional, necesitând adesea săptămâni sau luni de procesare pe hardware specializat precum GPU-uri și TPU-uri. Odată ce antrenamentul este finalizat și modelul a ajuns la greutăți și parametri optimi, modelul intră în faza de inferență. În acest moment, modelul este „înghețat”—nu mai învață din date noi—și aplică tiparele învățate pentru a genera predicții sau rezultate pe date nevăzute anterior. Conform cercetărilor de la IBM și Oracle, inferența este locul unde se realizează adevărata valoare de business a AI, deoarece permite organizațiilor să implementeze capabilități AI la scară în sistemele de producție. Piața globală de inferență AI a fost evaluată la 106,15 miliarde USD în 2025 și este estimată să ajungă la 254,98 miliarde USD până în 2030, reflectând cererea explozivă pentru capabilități de inferență în diverse industrii.

Inferența AI funcționează printr-un proces în mai multe etape care transformă datele brute de intrare în rezultate inteligente. Când un utilizator trimite o solicitare unui model lingvistic mare precum ChatGPT, fluxul de inferență începe cu codificarea intrării, unde textul este convertit în tokenuri numerice pe care rețeaua neuronală le poate procesa. Modelul intră apoi în faza de pre-umplere, în care toate tokenurile de intrare sunt procesate simultan prin fiecare strat al rețelei neuronale, permițând modelului să înțeleagă contextul și relațiile din întrebarea utilizatorului. Această fază este solicitantă din punct de vedere computațional, dar necesară pentru înțelegere. După faza de pre-umplere, modelul intră în faza de decodare, unde generează tokenuri de ieșire secvențial, unul câte unul, fiecare token nou depinzând de toate tokenurile anterioare din secvență. Această generare secvențială creează efectul de streaming caracteristic pe care îl observă utilizatorii când interacționează cu chatbot-urile AI. În final, etapa de conversie a ieșirii transformă tokenurile prezise înapoi în text lizibil, imagini sau alte formate pe care utilizatorii le pot înțelege și folosi. Întregul proces trebuie să se desfășoare în milisecunde pentru aplicațiile în timp real, ceea ce face din optimizarea latenței inferenței o preocupare critică pentru furnizorii de servicii AI.

Organizațiile care implementează sisteme AI trebuie să aleagă între trei arhitecturi principale de inferență, fiecare optimizată pentru cazuri de utilizare și cerințe de performanță diferite. Inferența în loturi procesează volume mari de date offline la intervale programate, fiind ideală pentru scenarii unde nu sunt necesare răspunsuri în timp real, precum generarea de rapoarte zilnice, evaluări de risc săptămânale sau actualizări nocturne de recomandări. Această abordare este foarte eficientă și rentabilă deoarece poate procesa mii de predicții simultan, amortizând costurile computaționale pe mai multe cereri. Inferența online, denumită și inferență dinamică, generează predicții instantaneu la cerere, cu latență minimă, fiind esențială pentru aplicații interactive precum chatbot-uri, motoare de căutare și sisteme de detectare a fraudelor în timp real. Inferența online necesită infrastructură sofisticată pentru a menține latență scăzută și disponibilitate ridicată, folosind strategii de caching și tehnici de optimizare a modelului pentru a asigura răspunsuri în milisecunde. Inferența de streaming procesează continuu date care sosesc de la senzori, dispozitive IoT sau fluxuri de date în timp real, generând predicții pentru fiecare punct de date pe măsură ce acesta sosește. Acest tip alimentează aplicații precum sisteme de mentenanță predictivă pentru echipamente industriale, vehicule autonome care procesează datele senzorilor în timp real și sisteme inteligente de oraș care analizează continuu traficul. Fiecare tip de inferență presupune considerații arhitecturale, cerințe hardware și strategii de optimizare diferite.

| Aspect | Inferență în loturi | Inferență online | Inferență de streaming |

|---|---|---|---|

| Cerință de latență | Secunde până la minute | Milisecunde | Timp real (sub o secundă) |

| Procesare date | Seturi mari de date offline | Cereri individuale la cerere | Flux continuu de date |

| Cazuri de utilizare | Analize, rapoarte, recomandări | Chatbot-uri, căutare, detectare fraudă | Monitorizare IoT, sisteme autonome |

| Eficiență cost | Ridicată (costuri amortizate pe multe predicții) | Medie (necesită infrastructură mereu activă) | Medie-ridicată (depinde de volumul de date) |

| Scalabilitate | Excelentă (procesează în bloc) | Bună (necesită balansare de sarcină) | Excelentă (procesare distribuită) |

| Prioritatea optimizării modelului | Throughput | Echilibru latență-throughput | Echilibru latență-acuratețe |

| Cerințe hardware | GPU-uri/CPU-uri standard | GPU-uri/TPU-uri de performanță înaltă | Hardware edge specializat sau sisteme distribuite |

Optimizarea inferenței a devenit o disciplină esențială pe măsură ce organizațiile doresc să implementeze modele AI mai eficient și cu costuri mai mici. Cuantizarea este una dintre cele mai eficiente tehnici de optimizare, reducând precizia numerică a greutăților modelului de la numere float pe 32 de biți la întregi pe 8 sau chiar 4 biți. Această reducere poate scădea dimensiunea modelului cu 75-90%, menținând 95-99% din acuratețea originală, rezultând viteze de inferență crescute și cerințe de memorie mai mici. Tăierea modelului elimină neuronii, conexiunile sau straturile non-critice din rețea, reducând parametrii redundanți care nu contribuie semnificativ la predicții. Cercetările arată că tăierea poate reduce complexitatea modelului cu 50-80% fără pierderi majore de acuratețe. Distilarea cunoștințelor antrenează un model „student” mai mic și rapid să imite comportamentul unui model „profesor” mai mare și precis, permițând implementarea pe dispozitive cu resurse limitate, menținând totuși performanțe rezonabile. Optimizarea procesării în loturi grupează mai multe cereri de inferență pentru a maximiza utilizarea GPU-ului și throughput-ul. Caching-ul cheie-valoare stochează rezultate intermediare de calcul pentru a evita calcule redundante în faza de decodare a modelelor lingvistice. Conform cercetărilor NVIDIA, combinarea mai multor tehnici de optimizare poate obține îmbunătățiri de performanță de 10x și reduce costurile de infrastructură cu 60-70%. Aceste optimizări sunt esențiale pentru implementarea inferenței la scară, în special pentru organizațiile care procesează mii de cereri simultane.

Accelerarea hardware este fundamentală pentru a atinge cerințele de latență și throughput ale sarcinilor de inferență AI moderne. GPU-urile (Graphics Processing Units) rămân cele mai utilizate acceleratoare de inferență datorită arhitecturii lor paralele, potrivite pentru operațiunile matriciale dominante în calculele rețelelor neuronale. GPU-urile NVIDIA alimentează majoritatea implementărilor de inferență pentru modele lingvistice mari la nivel global, cu nucleele CUDA specializate care permit paralelism masiv. TPU-urile (Tensor Processing Units), dezvoltate de Google, sunt ASIC-uri personalizate optimizate special pentru operațiuni de rețea neurală, oferind performanță superioară per watt comparativ cu GPU-urile pentru anumite sarcini. FPGA-urile (Field-Programmable Gate Arrays) oferă hardware personalizabil care poate fi reprogramat pentru sarcini de inferență specifice, oferind flexibilitate pentru aplicații specializate. ASIC-urile (Application-Specific Integrated Circuits) precum TPU-ul Google sau WSE-3 de la Cerebras sunt proiectate pentru sarcini de inferență dedicate, oferind performanță excepțională, dar cu flexibilitate limitată. Alegerea hardware-ului depinde de mai mulți factori: arhitectura modelului, latența necesară, cerințele de throughput, constrângerile de putere și costurile totale de operare. Pentru inferența la margine pe dispozitive mobile sau senzori IoT, acceleratoarele edge specializate și unitățile de procesare neurală (NPU-uri) permit inferență eficientă cu consum minim de energie. Tranziția globală către fabrici AI—infrastructură optimizată pentru a „produce” inteligență la scară— a determinat investiții masive în hardware pentru inferență, companiile implementând mii de GPU-uri și TPU-uri în centre de date pentru a satisface cererea tot mai mare de servicii AI.

Sistemele de AI generativă precum ChatGPT, Claude și Perplexity se bazează în totalitate pe inferență pentru a genera texte, cod, imagini și alte conținuturi asemănătoare celor produse de oameni. Când trimiți un prompt acestor sisteme, procesul de inferență începe prin tokenizarea intrării tale în reprezentări numerice pe care rețeaua neuronală le poate procesa. Modelul execută apoi faza de pre-umplere, procesând toate tokenurile tale de intrare simultan pentru a construi o înțelegere completă a cererii, inclusiv context, intenție și nuanță. Ulterior, modelul intră în faza de decodare, unde generează tokenuri de ieșire secvențial, prezicând cel mai probabil token următor pe baza tuturor tokenurilor anterioare și a tiparelor învățate în antrenament. Această generare token cu token explică de ce vezi textul apărând progresiv, în timp real, când folosești aceste servicii. Procesul de inferență trebuie să echilibreze mai multe obiective: generarea de răspunsuri precise, coerente și relevante, menținând totodată latență scăzută pentru a menține angajamentul utilizatorului. Speculative decoding, o tehnică avansată de optimizare a inferenței, permite unui model mai mic să prezică mai multe tokenuri viitoare, în timp ce modelul mare validează aceste predicții, reducând semnificativ latența. Scara inferenței pentru modelele lingvistice mari este uriașă—ChatGPT de la OpenAI procesează zilnic milioane de cereri de inferență, fiecare generând sute sau mii de tokenuri, necesitând infrastructură computațională masivă și strategii sofisticate de optimizare pentru a rămâne viabil din punct de vedere economic.

Pentru organizațiile preocupate de prezența brandului și citarea conținutului în răspunsurile generate de AI, monitorizarea inferenței devine tot mai importantă. Când sistemele AI precum Perplexity, Google AI Overviews sau Claude generează răspunsuri, efectuează inferență pe modelele antrenate pentru a produce rezultate care pot face referire sau cita domeniul, brandul sau conținutul tău. Înțelegerea modului de funcționare a sistemelor de inferență ajută organizațiile să își optimizeze strategia de conținut pentru a asigura o reprezentare corectă în răspunsurile generate de AI. AmICited este specializată în monitorizarea locurilor unde apar brandurile și domeniile în rezultatele de inferență AI pe mai multe platforme, oferind vizibilitate asupra modului în care sistemele AI citează și fac referire la conținutul tău. Această monitorizare este crucială deoarece sistemele de inferență pot genera răspunsuri care includ sau exclud brandul tău în funcție de calitatea datelor de antrenament, semnalele de relevanță și alegerile de optimizare ale modelului. Organizațiile pot folosi datele de monitorizare a inferenței pentru a înțelege ce conținut este citat, cât de des apare brandul lor în răspunsurile AI și dacă domeniul este corect atribuit. Această inteligență permite luarea de decizii bazate pe date despre optimizarea conținutului, strategia SEO și poziționarea brandului în peisajul emergent al căutării asistate de AI. Pe măsură ce inferența devine principala interfață prin care utilizatorii descoperă informații, monitorizarea prezenței în rezultatele AI este la fel de importantă ca optimizarea tradițională pentru motoarele de căutare.

Implementarea sistemelor de inferență la scară aduce numeroase provocări tehnice, operaționale și strategice pe care organizațiile trebuie să le gestioneze. Gestionarea latenței rămâne o provocare permanentă, deoarece utilizatorii se așteaptă la răspunsuri sub o secundă de la aplicațiile AI interactive, deși modelele complexe cu miliarde de parametri necesită timp de calcul semnificativ. Optimizarea throughput-ului este la fel de critică—organizațiile trebuie să servească mii sau milioane de cereri de inferență simultane, menținând totodată latență și acuratețe acceptabile. Deriva modelului apare când performanța inferenței scade în timp din cauza schimbărilor în distribuția reală a datelor față de datele de antrenament, necesitând monitorizare continuă și reantrenare periodică. Interpretabilitatea și explicabilitatea devin tot mai importante pe măsură ce sistemele AI influențează decizii ce afectează utilizatorii, impunând organizațiilor să înțeleagă și să explice modul în care modelele ajung la anumite predicții. Conformitatea cu reglementările ridică provocări tot mai mari, cu reglementări precum EU AI Act care impun cerințe de transparență, detectare a bias-ului și supraveghere umană asupra sistemelor de inferență AI. Calitatea datelor rămâne fundamentală—sistemele de inferență pot fi doar la fel de bune ca datele pe care au fost antrenate, iar datele slabe duc la rezultate biasate, inexacte sau dăunătoare. Costurile infrastructurii pot fi semnificative, implementările la scară mare necesitând investiții majore în GPU-uri, TPU-uri, rețelistică și răcire. Lipsa de talente face ca organizațiile să găsească cu greu ingineri și specialiști în date cu expertiză în optimizarea inferenței, implementarea modelelor și MLOps, crescând costurile cu personalul și încetinind lansările.

Viitorul inferinței AI evoluează rapid în mai multe direcții transformative care vor remodela modul în care organizațiile implementează și folosesc sistemele AI. Inferența la margine—rularea inferenței pe dispozitive locale în loc de centre de date cloud—se accelerează, impulsionată de progrese în compresia modelelor, hardware edge specializat și preocupări legate de confidențialitate. Această schimbare va permite capacități AI în timp real pe smartphone-uri, dispozitive IoT și sisteme autonome fără a depinde de conectivitatea cloud. Inferența multimodală, în care modelele procesează și generează simultan text, imagini, audio și video, devine tot mai comună, necesitând strategii noi de optimizare și considerații hardware. Modelele de raționament care efectuează inferență în mai mulți pași pentru a rezolva probleme complexe apar, cu sisteme precum o1 de la OpenAI care demonstrează că inferența poate fi scalată nu doar prin dimensiunea modelului, ci și prin timp de calcul și tokenuri. Arhitecturile de servire disjunctă câștigă teren, unde clustere hardware separate gestionează fazele de pre-umplere și decodare ale inferenței, optimizând utilizarea resurselor pentru tipare computaționale diferite. Speculative decoding și alte tehnici avansate de inferență devin practici standard, permițând reduceri de latență de 2-3x. Inferența la margine combinată cu învățarea federată va permite organizațiilor să implementeze capabilități AI local, menținând confidențialitatea și reducând cerințele de bandă. Piața inferenței AI este estimată să crească cu un CAGR de 19,2% până în 2030, impulsionată de adoptarea în enterprise, noi cazuri de utilizare și imperativul economic de optimizare a costurilor inferenței. Pe măsură ce inferența devine sarcina dominantă în infrastructura AI, tehnicile de optimizare, hardware-ul specializat și framework-urile software dedicate inferenței vor deveni tot mai sofisticate și esențiale pentru avantajul competitiv.

Antrenamentul AI reprezintă procesul de a învăța un model să recunoască tipare folosind seturi mari de date, în timp ce inferența presupune ca acel model antrenat să aplice ce a învățat pentru a genera predicții sau rezultate pe date noi. Antrenamentul este intensiv din punct de vedere computațional și are loc o singură dată, în timp ce inferența este de obicei mai rapidă, necesită mai puține resurse și se desfășoară continuu în mediile de producție. Gândește-te la antrenament ca la pregătirea pentru un examen, iar la inferență ca la susținerea efectivă a examenului.

Latența inferenței—timpul necesar unui model pentru a genera un rezultat—este esențială pentru experiența utilizatorului și pentru aplicațiile în timp real. O inferență cu latență scăzută permite răspunsuri instantanee în chatbot-uri, traducere în timp real, vehicule autonome și sisteme de detectare a fraudelor. Latența ridicată poate face ca aplicațiile să devină inutilizabile pentru sarcinile sensibile la timp. Companiile optimizează latența prin tehnici precum cuantizarea, tăierea modelului și hardware specializat precum GPU-uri și TPU-uri pentru a respecta nivelurile de servicii.

Cele trei tipuri principale sunt inferența în loturi (procesarea unor seturi mari de date offline), inferența online (generarea instantanee a predicțiilor la cerere) și inferența de streaming (procesarea continuă a datelor de la senzori sau dispozitive IoT). Inferența în loturi este potrivită pentru analize zilnice, inferența online alimentează chatbot-urile și motoarele de căutare, iar inferența de streaming permite sisteme de monitorizare în timp real. Fiecare tip are cerințe diferite de latență și cazuri de utilizare specifice.

Cuantizarea reduce precizia numerică a greutăților modelului de la 32 biți la 8 biți sau mai puțin, reducând semnificativ dimensiunea modelului și cerințele computaționale, menținând totodată acuratețea. Tăierea elimină neuronii sau conexiunile non-critice din rețea, reducând complexitatea. Ambele tehnici pot reduce latența inferenței cu 50-80% și costurile hardware. Aceste metode de optimizare sunt esențiale pentru implementarea modelelor pe dispozitive edge și mobile.

Inferența este mecanismul central care permite sistemelor de AI generativă să producă text, imagini și cod. Când soliciți ChatGPT, procesul de inferență tokenizează intrarea, o procesează prin straturile rețelei neuronale antrenate și generează ieșiri token cu token. Faza de pre-umplere procesează toate tokenurile de intrare simultan, iar faza de decodare generează răspunsul secvențial. Această capacitate de inferență face modelele de limbaj mari să fie rapide și practice pentru aplicațiile din lumea reală.

Monitorizarea inferenței urmărește cum performează modelele AI în producție, inclusiv acuratețea, latența și calitatea rezultatelor. Platforme precum AmICited monitorizează unde apar brandurile și domeniile în răspunsurile generate de AI din sisteme precum ChatGPT, Perplexity și Google AI Overviews. Înțelegerea comportamentului inferenței ajută organizațiile să se asigure că conținutul lor este corect citat și reprezentat atunci când sistemele AI fac referință la domeniile sau informațiile despre brandul lor.

Acceleratoarele de inferență obișnuite includ GPU-uri (unități de procesare grafică) pentru procesare paralelă, TPU-uri (unități de procesare tensorială) optimizate pentru rețele neuronale, FPGA-uri (circuite programabile pe teren) pentru sarcini personalizabile și ASIC-uri (circuite integrate specifice aplicației) concepute pentru sarcini dedicate. GPU-urile sunt cele mai utilizate datorită raportului performanță-cost, în timp ce TPU-urile excelează la inferența la scară mare. Alegerea depinde de cerințele de throughput, latență și buget.

Piața globală de inferență AI a fost evaluată la 106,15 miliarde USD în 2025 și este estimată să ajungă la 254,98 miliarde USD până în 2030, reprezentând o rată de creștere anuală compusă (CAGR) de 19,2%. Această creștere rapidă reflectă adoptarea tot mai mare a aplicațiilor AI în mediul enterprise, 78% dintre organizații folosind AI în 2024, față de 55% în 2023. Extinderea este determinată de cererea pentru aplicații AI în timp real în domenii precum sănătate, finanțe, retail și sisteme autonome.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Află cum să aliniezi conținutul tău cu intenția interogărilor AI pentru a crește citările pe ChatGPT, Perplexity și Google AI. Stăpânește strategii de potrivire...

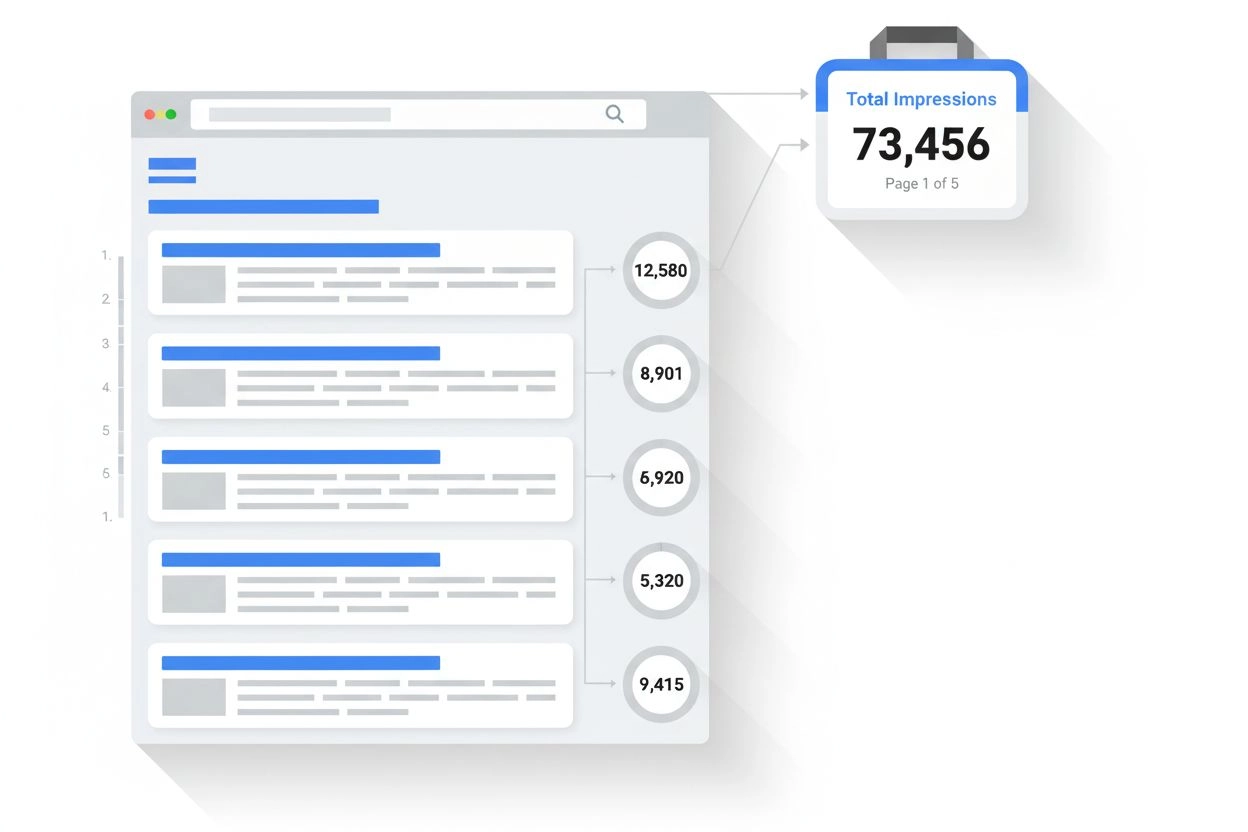

Află ce este o impresie în rezultatele căutării și monitorizarea AI. Înțelege cum sunt numărate impressiile în Google Search, Perplexity, ChatGPT și alte platfo...

Află ce înseamnă intenția de căutare informațională pentru sistemele AI, cum recunoaște AI aceste interogări și de ce este importantă înțelegerea acestei intenț...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.