PerplexityBot: Ce trebuie să știe fiecare proprietar de site web

Ghid complet despre crawler-ul PerplexityBot - înțelege cum funcționează, gestionează accesul, monitorizează citările și optimizează pentru vizibilitatea în Per...

PerplexityBot este crawlerul web al Perplexity AI care indexează conținutul web pentru a alimenta motorul său de răspunsuri. Respectă directivele robots.txt, oferă citări transparente ale surselor în răspunsuri și nu este folosit pentru antrenarea modelelor de bază AI. Crawlerul ajută Perplexity să ofere răspunsuri exacte și cu surse la întrebările utilizatorilor.

PerplexityBot este crawlerul web al Perplexity AI care indexează conținutul web pentru a alimenta motorul său de răspunsuri. Respectă directivele robots.txt, oferă citări transparente ale surselor în răspunsuri și nu este folosit pentru antrenarea modelelor de bază AI. Crawlerul ajută Perplexity să ofere răspunsuri exacte și cu surse la întrebările utilizatorilor.

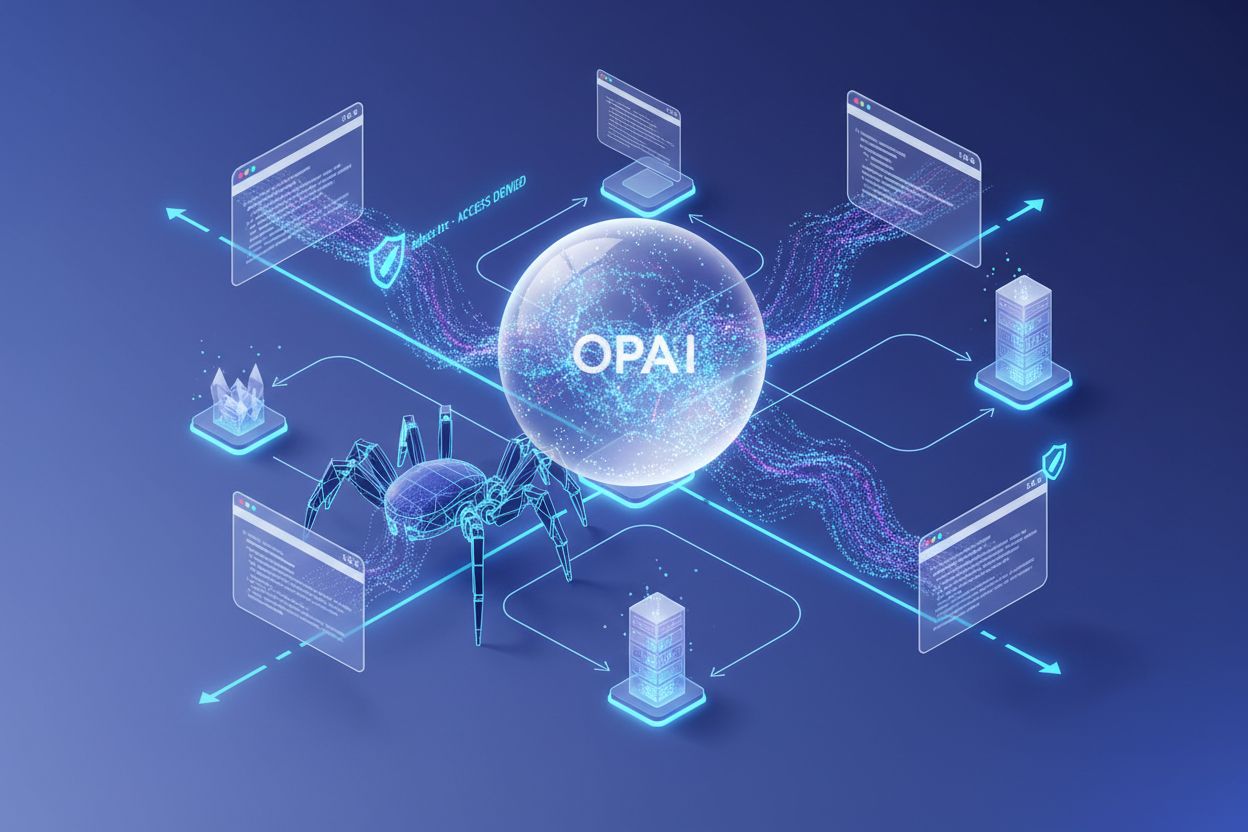

PerplexityBot este crawlerul web dezvoltat de Perplexity AI pentru a indexa și prelua conținut pentru motorul său de răspunsuri. Spre deosebire de crawlerele tradiționale ale motoarelor de căutare, PerplexityBot funcționează cu un scop specific: colectarea de informații în timp real pentru a alimenta căutarea și generarea de răspunsuri AI a Perplexity. Crawlerul se identifică printr-un user-agent string clar: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0; +https://perplexity.ai/perplexitybot). Important, PerplexityBot respectă protocolul robots.txt, permițând proprietarilor de site-uri să controleze comportamentul de crawlare pe domeniile lor. O distincție esențială: PerplexityBot nu este folosit pentru antrenarea modelelor AI—el furnizează exclusiv conținut pentru sistemul de generare de răspunsuri Perplexity, iar platforma oferă citări transparente pentru toate informațiile utilizate în răspunsuri.

PerplexityBot funcționează ca un crawler web distribuit care indexează sistematic conținutul web pentru a construi o bază de cunoștințe interogabilă pentru motorul de răspunsuri al Perplexity. Crawlerul folosește identificatorul său distinctiv user-agent pentru a se anunța transparent serverelor web, permițând administratorilor de site să recunoască și să gestioneze cererile acestuia. Perplexity operează intervale IP specifice pentru PerplexityBot, care pot fi configurate în Web Application Firewalls (WAF) precum Cloudflare și AWS pentru a permite sau restricționa accesul, după caz. Este esențial să faci diferența între PerplexityBot (crawlerul de conținut) și Perplexity-User (care reprezintă traficul real al utilizatorilor de pe platforma Perplexity), deoarece acestea au funcții diferite și pot necesita strategii de gestionare diferite. Spre deosebire de GoogleBot, care parcurge site-urile pentru indexare și clasare, PerplexityBot se concentrează exclusiv pe preluarea conținutului pentru generarea de răspunsuri, fără a influența clasamentul în motoarele de căutare. Arhitectura crawlerului reflectă o abordare modernă a crawlării web, care echilibrează nevoia de acces cuprinzător la conținut cu respectarea preferințelor proprietarilor de site-uri și a constrângerilor tehnice.

| Nume crawler | Scop | Respectă robots.txt | Folosit pentru antrenare AI | Citare sursă |

|---|---|---|---|---|

| PerplexityBot | Preluare conținut pentru motorul de răspunsuri | Da | Nu | Da, citări transparente |

| ChatGPT-User | Trafic utilizator din ChatGPT | N/A | Nu | N/A |

| GoogleBot | Indexare și clasare în căutare | Da | Nu | N/A |

Perplexity a adoptat o abordare transparentă de crawlare care contrastează cu anumiți competitori ce folosesc tehnici de crawlare stealth. Cercetările Cloudflare au arătat că unele companii AI au încercat să-și mascheze crawlerele imitând user-agent-uri legitime, îngreunând identificarea și gestionarea traficului de către proprietarii de site-uri. Identificarea clară a PerplexityBot și respectarea RFC 9309 (standardul pentru crawlare responsabilă) demonstrează angajamentul față de practici etice în era AI. Transparența în crawlarea web servește mai multor scopuri: permite proprietarilor de site să ia decizii informate despre conținutul lor, facilitează atribuirea corectă a traficului în platformele de analiză și construiește încredere în ecosistemul web. Distincția dintre crawlarea transparentă și cea stealth a devenit tot mai importantă pe măsură ce companiile AI concurează pentru acces la conținut, abordările transparente dovedindu-se mai sustenabile și mai respectuoase față de autonomia proprietarilor de site-uri.

Cele mai bune practici pentru crawlare web etică includ:

Infrastructura de crawlare a Perplexity a evoluat semnificativ de la începuturile platformei, când se baza pe indexul Bing. Compania a dezvoltat propriul crawler personalizat pentru a obține un control mai mare asupra prospețimii, calității și relevanței conținutului pentru generarea de răspunsuri. În loc să încerce să indexeze întreaga rețea fără discriminare, Perplexity se concentrează pe „partea superioară a curbei de distribuție”—prioritizând conținutul popular, autoritativ și de înaltă calitate, cel mai probabil să ofere răspunsuri exacte la întrebările utilizatorilor. Crawlerul folosește tehnici sofisticate de parsing de conținut pentru a extrage informații relevante, a identifica pasaje cheie și a înțelege relațiile semantice din documente. Perplexity atribuie scoruri de încredere domeniilor pe baza calității conținutului, istoricului de acuratețe și semnalelor de autoritate, care influențează cât de mult este luat în considerare conținutul anumitor surse la generarea răspunsurilor. Platforma menține un program de recrawlare care echilibrează prospețimea cu încărcarea serverelor, revenind mai des pe domeniile cu autoritate mare, în timp ce site-urile actualizate mai rar sunt vizitate mai puțin frecvent.

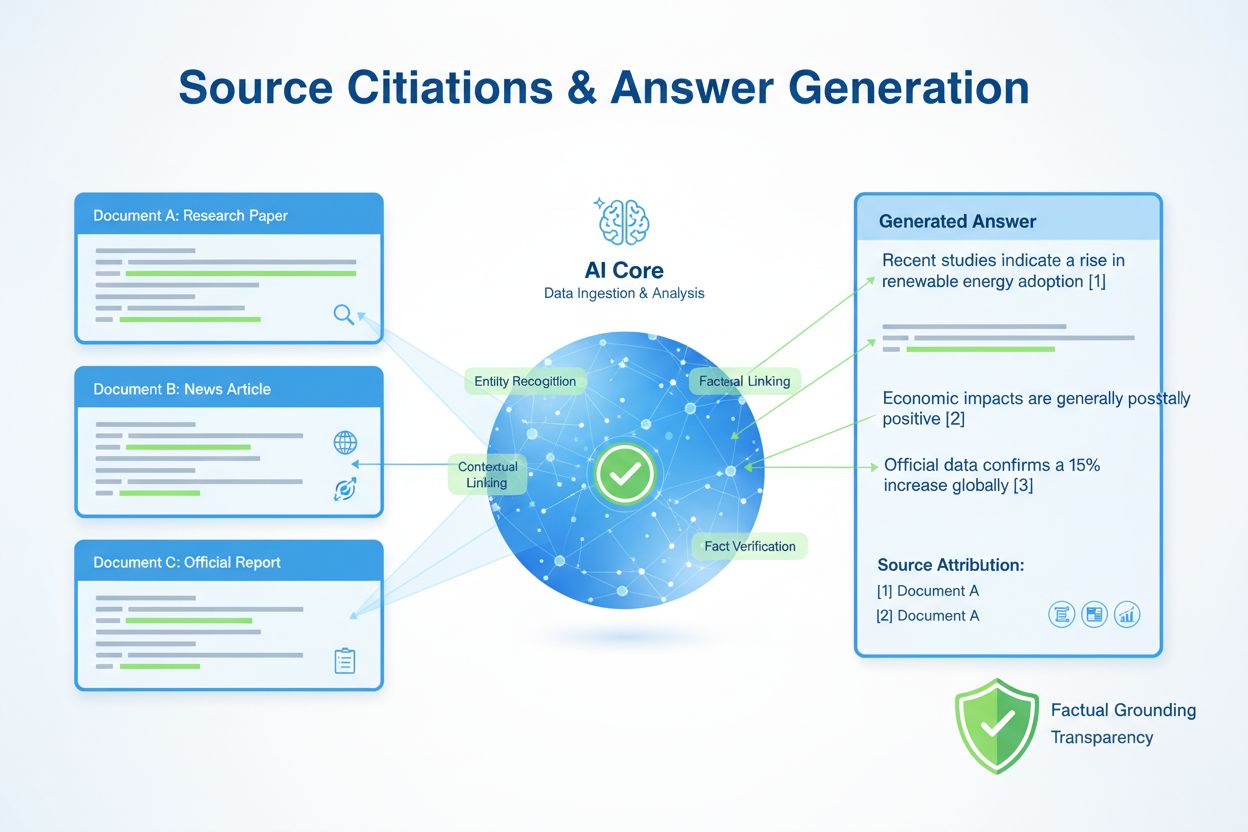

Când PerplexityBot parcurge și indexează conținut, acele informații ajung direct în fluxul de generare a răspunsurilor al Perplexity, unde AI-ul sintetizează date din mai multe surse pentru a crea răspunsuri cuprinzătoare. Mecanismul de citare al platformei este fundamental—fiecare răspuns include linkuri transparente către sursele folosite, permițând utilizatorilor să verifice informațiile și să aprofundeze subiectele. Această abordare diferă semnificativ de motoarele de căutare tradiționale, care clasifică mai degrabă pagini decât să sintetizeze informații, și de unele sisteme AI care generează răspunsuri fără citarea clară a surselor. Proprietarii de site pot urmări traficul PerplexityBot prin Google Analytics 4 și alte platforme de analiză, unde acesta apare ca un crawler distinct, permițând înțelegerea volumului de trafic și a conținutului accesat. Experiența utilizatorilor beneficiază semnificativ de această transparență: cititorii văd exact ce surse au stat la baza fiecărei părți dintr-un răspuns, câștigând încredere în informații și generând trafic calificat către site-uri autoritare. Acest model bazat pe citare creează o relație simbiotică, unde creatorii de conținut beneficiază de vizibilitate și trafic, iar utilizatorii primesc informații de încredere, cu sursă.

Proprietarii de site-uri care doresc să prevină crawlarea conținutului lor de către PerplexityBot pot face acest lucru prin fișierul robots.txt, mecanismul standard de comunicare a preferințelor către crawlere. Adăugarea unei directive simple blochează crawlerul să acceseze conținutul site-ului:

User-agent: PerplexityBot

Disallow: /

Pentru un control mai granular, poți bloca PerplexityBot din anumite directoare sau tipuri de fișiere, permițând totodată accesul în alte zone. Web Application Firewalls precum Cloudflare și AWS oferă opțiuni suplimentare de configurare, permițând blocarea cererilor provenite din intervalele de IP ale PerplexityBot la nivel de infrastructură. Înainte de a implementa blocaje, verifică dacă cererile provin cu adevărat de la PerplexityBot, analizând user-agent-ul și confirmând IP-urile cu intervalele publicate de Perplexity. E important de știut că modificările din robots.txt se propagă de obicei în 24 de ore, însă unele crawlere pot întârzia mai mult să respecte noile directive. Înainte de a bloca complet PerplexityBot, ia în calcul beneficiile potențiale ale indexării: includerea în motorul de răspunsuri Perplexity poate aduce trafic calificat și vizibilitate crescută într-un canal AI tot mai important. O abordare mai nuanțată ar putea fi să permiți crawlarea, folosind robots.txt doar pentru a exclude conținut sensibil sau duplicat.

Includerea în indexul PerplexityBot reprezintă o oportunitate majoră de vizibilitate în era căutării AI. Pe măsură ce Perplexity și alte motoare AI de răspunsuri devin tot mai populare, indexarea devine esențială pentru descoperirea conținutului și generarea de trafic. Site-urile care apar în răspunsurile Perplexity primesc trafic direct de la utilizatori care accesează sursa pentru a verifica informațiile sau a explora subiecte în profunzime, creând un nou canal de achiziție de audiență, dincolo de motoarele de căutare tradiționale. Calitatea și relevanța conținutului tău influențează direct dacă PerplexityBot îl va parcurge și cât de proeminent va apărea în generarea de răspunsuri—conținutul bine documentat și autoritativ are șanse mai mari să fie selectat ca sursă. Optimizarea SEO pentru motoarele AI de răspunsuri diferă parțial de optimizarea clasică pentru căutare, punând accent pe structură clară, acoperire completă a subiectelor și expertiză și autoritate demonstrate. Pe măsură ce căutarea AI se maturizează și câștigă cotă de piață, abilitatea de a apărea în motoarele de răspunsuri va deveni la fel de importantă ca poziționarea în căutarea tradițională, iar indexarea de către PerplexityBot devine o componentă critică a strategiei moderne de conținut.

Poți identifica activitatea PerplexityBot în jurnalele serverului căutând cereri ce conțin șirul user-agent distinctiv PerplexityBot/1.0 sau filtrând după IP-urile din intervalele publicate de Perplexity. Platforme de analiză precum Google Analytics 4, Matomo și instrumente de logare la nivel de server captează traficul PerplexityBot, permițându-ți să înțelegi frecvența crawlării, ce conținut este accesat și volumul de trafic generat de crawler. Înțelegerea tiparelor de crawlare te ajută să optimizezi structura și conținutul site-ului pentru o indexare mai bună—de exemplu, dacă PerplexityBot accesează frecvent anumite tipuri de conținut, poți asigura că acele pagini sunt bine optimizate și ușor de descoperit. Impactul asupra performanței este, de obicei, minim, deoarece crawlerul este proiectat să fie respectuos cu resursele serverului și să distribuie cererile în timp pentru a evita supraîncărcarea site-urilor. Instrumente specializate precum AmICited.com oferă perspective detaliate despre modul în care conținutul tău este folosit în motoarele AI de răspunsuri, monitorizând citările, atribuirea traficului și poziționarea competitivă în peisajul căutării AI—un set valoros de informații pentru înțelegerea vizibilității tale în acest canal emergent.

PerplexityBot este crawlerul web al Perplexity AI, conceput pentru a indexa și prelua conținut pentru motorul de răspunsuri al Perplexity. Acesta parcurge site-uri pentru a colecta informații care alimentează rezultatele de căutare AI și generarea de răspunsuri ale Perplexity. Spre deosebire de anumiți crawlere AI, PerplexityBot nu este folosit pentru antrenarea modelelor de bază AI—este folosit exclusiv pentru a furniza conținut sistemului de generare de răspunsuri al Perplexity, cu citări transparente ale surselor.

Poți identifica PerplexityBot căutând șirul user-agent 'PerplexityBot/1.0' în jurnalele serverului tău. Șirul complet user-agent este: Mozilla/5.0 AppleWebKit/537.36 (KHTML, like Gecko; compatible; PerplexityBot/1.0; +https://perplexity.ai/perplexitybot). De asemenea, poți filtra după adresele IP din intervalele publicate de Perplexity, disponibile la https://www.perplexity.com/perplexitybot.json.

Decizia de a bloca PerplexityBot depinde de strategia ta de conținut. Permiterea accesului poate aduce trafic calificat din motorul de răspunsuri Perplexity și poate crește vizibilitatea conținutului tău în rezultatele de căutare AI. Totuși, dacă ai îngrijorări legate de utilizarea conținutului sau preferi să limitezi crawlarea, îl poți bloca prin robots.txt. Ia în considerare beneficiile vizibilității în căutarea AI înainte de a implementa un blocaj complet.

PerplexityBot și GoogleBot au scopuri diferite. GoogleBot parcurge site-urile pentru indexare și clasare în rezultatele Google Search, în timp ce PerplexityBot parcurge site-urile special pentru a prelua conținut pentru motorul de răspunsuri Perplexity. PerplexityBot se concentrează pe calitatea și relevanța conținutului pentru generarea de răspunsuri, nu pe clasarea în căutare, și oferă citări transparente ale surselor în răspunsuri.

Da, PerplexityBot respectă directivele robots.txt. Poți controla accesul său adăugând reguli specifice în fișierul robots.txt. De exemplu, pentru a bloca toată crawlarea PerplexityBot, adaugă: User-agent: PerplexityBot urmat de Disallow: /. Modificările din robots.txt se propagă de obicei în 24 de ore.

Nu, PerplexityBot nu este folosit în mod explicit pentru antrenarea modelelor de bază AI. Perplexity a declarat că PerplexityBot este conceput exclusiv pentru a indexa conținut și a furniza răspunsuri cu surse utilizatorilor. Acest lucru îl diferențiază de alți crawlere AI care pot fi folosiți pentru antrenarea modelelor.

Pentru a permite PerplexityBot prin intermediul Web Application Firewall, creează reguli care să permită atât șirul user-agent (PerplexityBot), cât și adresele IP din intervalele publicate de Perplexity. Pentru Cloudflare, folosește reguli personalizate pentru a permite cererile cu user-agent PerplexityBot și condiții IP corespunzătoare. Pentru AWS WAF, creează seturi de IP și condiții de potrivire a șirului pentru aceiași identificatori. Folosește întotdeauna intervalele IP oficiale de la https://www.perplexity.com/perplexitybot.json.

PerplexityBot este crawlerul automat care indexează conținut web pentru indexul de căutare Perplexity. Perplexity-User reprezintă traficul real al utilizatorilor de pe platforma Perplexity atunci când utilizatorii accesează site-uri din răspunsurile Perplexity. PerplexityBot respectă robots.txt, în timp ce Perplexity-User ignoră de obicei robots.txt deoarece reprezintă cereri inițiate de utilizatori. Ambele pot fi identificate după șirurile lor user-agent în jurnalele tale.

Urmărește cum apare conținutul tău în Perplexity, ChatGPT, Google AI Overviews și alte sisteme AI cu AmICited. Obține perspective despre citările AI și vizibilitatea ta.

Ghid complet despre crawler-ul PerplexityBot - înțelege cum funcționează, gestionează accesul, monitorizează citările și optimizează pentru vizibilitatea în Per...

Află ce este GPTBot, cum funcționează și dacă ar trebui să îl blochezi de pe site-ul tău. Înțelege impactul asupra SEO, încărcării serverului și vizibilității b...

Află ce este CCBot, cum funcționează și cum îl poți bloca. Înțelege rolul său în antrenarea AI, instrumente de monitorizare și cele mai bune practici pentru a-ț...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.