Ce este Căutarea Semantică pentru AI? Cum Funcționează și De ce Contează

Află cum căutarea semantică folosește AI pentru a înțelege intenția și contextul utilizatorului. Descoperă cum diferă de căutarea prin cuvinte cheie și de ce es...

Căutarea semantică este o tehnică de căutare bazată pe inteligență artificială care înțelege sensul și contextul unei interogări, nu doar potrivirea exactă a cuvintelor cheie. Utilizează procesarea limbajului natural și învățarea automată pentru a interpreta intenția utilizatorului și a livra rezultate pe baza relevanței conceptuale, nu doar a potrivirii exacte a cuvintelor.

Căutarea semantică este o tehnică de căutare bazată pe inteligență artificială care înțelege sensul și contextul unei interogări, nu doar potrivirea exactă a cuvintelor cheie. Utilizează procesarea limbajului natural și învățarea automată pentru a interpreta intenția utilizatorului și a livra rezultate pe baza relevanței conceptuale, nu doar a potrivirii exacte a cuvintelor.

Căutarea semantică este o tehnică de căutare alimentată de inteligență artificială care interpretează sensul și contextul unei interogări, nu doar potrivirea exactă a cuvintelor cheie. Spre deosebire de motoarele de căutare tradiționale care returnează rezultate pe baza potrivirii exacte a cuvintelor, căutarea semantică folosește procesarea limbajului natural (NLP) și învățarea automată pentru a înțelege ce caută cu adevărat utilizatorii, livrând rezultate pe baza relevanței conceptuale și a intenției utilizatorului. Această trecere fundamentală de la potrivirea lexicală la înțelegerea semantică reprezintă unul dintre cele mai importante progrese în tehnologia de regăsire a informațiilor, permițând sistemelor de căutare să acopere diferența dintre modul în care gândesc oamenii și modul în care computerele procesează informațiile. Tehnologia a devenit tot mai esențială în era AI, platforme precum ChatGPT, Perplexity, Google AI Overviews și Claude bazându-se pe căutarea semantică pentru a recupera și sintetiza informații relevante din baze vaste de cunoștințe.

Conceptul de înțelegere semantică în căutare a evoluat semnificativ în ultimele două decenii. Motoarele de căutare timpurii se bazau exclusiv pe potrivirea cuvintelor cheie și indici inversați, care funcționau rezonabil pentru interogări simple, dar eșuau atunci când utilizatorii foloseau sinonime sau când documentele exprimau aceleași concepte cu altă terminologie. Introducerea tehnicilor de procesare a limbajului natural la începutul anilor 2000 a început să schimbe acest peisaj, dar adevărata căutare semantică a apărut odată cu dezvoltarea embedding-urilor de cuvinte precum Word2Vec în 2013 și ulterior a modelelor transformer precum BERT în 2018. Aceste descoperiri au permis computerelor să înțeleagă nu doar cuvinte individuale, ci și relațiile dintre concepte și contextul în care apar cuvintele. Astăzi, căutarea semantică a devenit fundația sistemelor AI și LLM-urilor moderne, piața globală de software pentru căutare semantică fiind evaluată la 1,2 miliarde USD în 2024 și estimată să ajungă la 3,5 miliarde USD până în 2033, reprezentând un CAGR de aproximativ 11,5%. Această creștere explozivă reflectă recunoașterea la nivel mondial a faptului că înțelegerea semantică este esențială pentru livrarea unor experiențe relevante de căutare într-un peisaj digital tot mai complex.

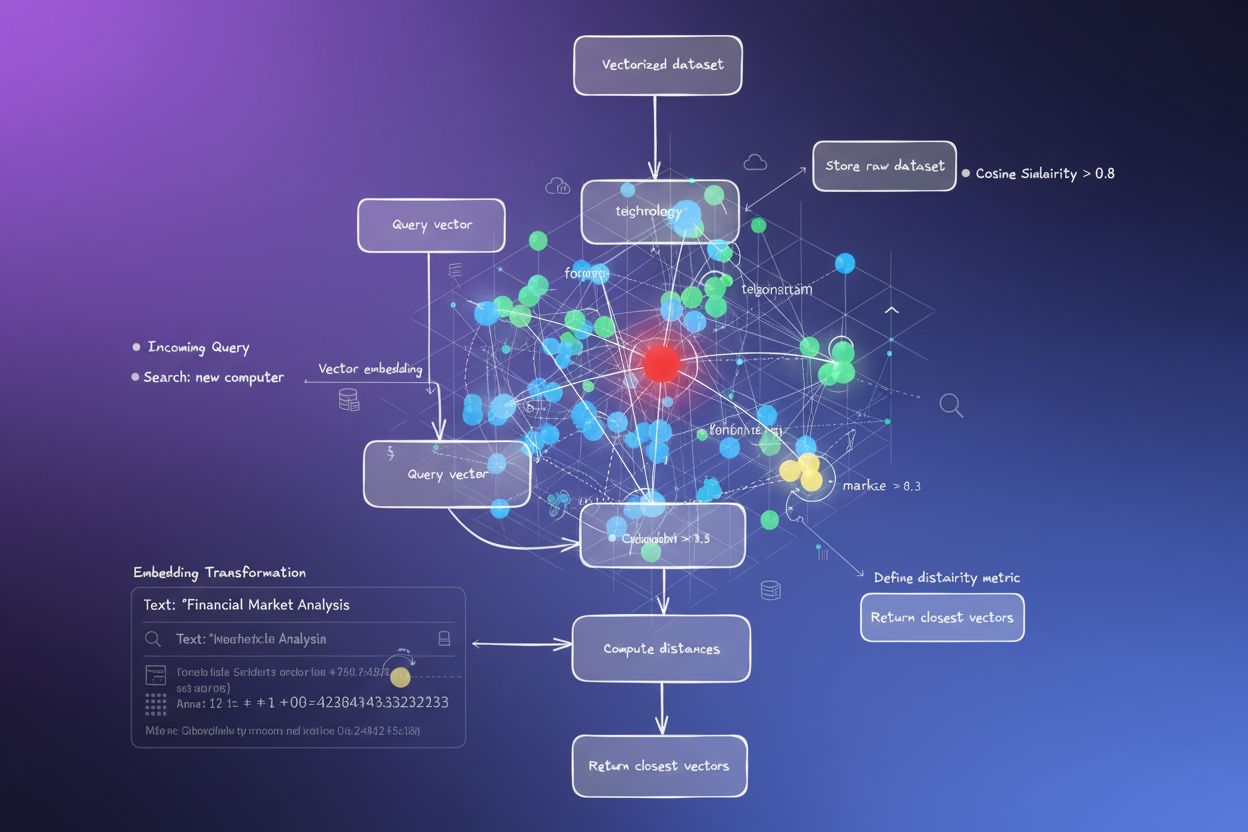

Căutarea semantică operează printr-un proces sofisticat în mai multe etape care transformă atât interogările, cât și documentele în reprezentări matematice ce surprind sensul. Procesul începe când un utilizator introduce o interogare, care este apoi analizată pentru extragerea intenției și contextului. Sistemul folosește modele NLP pentru a înțelege ce caută efectiv utilizatorul, nu doar cuvintele literale introduse. Următorul pas constă în conversia interogării în vectori de embedding — reprezentări numerice în spațiu multidimensional care surprind sensul semantic. Simultan, documentele din indexul de căutare sunt deja convertite în embedding-uri folosind același model, asigurând consistența modului de reprezentare a sensului. Sistemul folosește apoi algoritmul k-nearest neighbor (kNN) pentru a găsi documentele ale căror embedding-uri sunt cele mai apropiate matematic de embedding-ul interogării. Această măsurare a distanței, de obicei cu similaritatea cosinusului, identifică conținutul conceptual apropiat de interogare. În final, un algoritm de reranking evaluează aceste rezultate inițiale folosind factori suplimentari de relevanță precum contextul utilizatorului, istoricul căutării și metrici de engagement pentru a produce lista finală de rezultate prezentate utilizatorului. Întregul proces are loc în milisecunde, permițând experiențe de căutare în timp real, naturale și intuitive.

La baza căutării semantice se află conceptul de embedding-uri vectoriale, reprezentări numerice care codifică sensul semantic în spațiu multidimensional. Când un model transformer precum BERT sau GPT procesează text, generează embedding-uri — de obicei vectori cu sute sau mii de dimensiuni — fiecare dimensiune surprinzând un aspect al sensului textului. De exemplu, biblioteca sentence-transformers produce embedding-uri cu 384 de dimensiuni, însă modelele de producție folosesc frecvent 768 sau 1024 pentru o reprezentare semantică mai bogată. Proprietatea remarcabilă a acestor embedding-uri este că conținutul semantic similar produce vectori matematic similari. Dacă embeddezi expresia “atac de cord” și expresia “infarct miocardic”, vectorii lor vor fi poziționați aproape în spațiul embedding, chiar dacă nu au cuvinte comune. Această grupare a semnificațiilor similare în spațiul multidimensional face posibilă căutarea semantică. La vizualizarea embedding-urilor folosind tehnici de reducere a dimensionalității precum Principal Component Analysis (PCA), embedding-urile se organizează natural în clustere unde documentele pe teme similare se grupează împreună. Această proprietate permite sistemelor de căutare să găsească conținut relevant pe baza sensului, nu doar a potrivirii exacte a cuvintelor cheie, schimbând fundamental modul în care utilizatorii interacționează cu sistemele de regăsire a informației.

| Aspect | Căutare Semantică | Căutare pe Bază de Cuvinte Cheie |

|---|---|---|

| Metoda de potrivire | Potrivește sensul și contextul folosind similaritate vectorială | Potrivește cuvinte sau expresii exacte folosind indici inversați |

| Fundație tehnologică | Modele de învățare automată, embedding-uri, rețele neuronale | Metode statistice precum TF-IDF, analiză frecvență termeni |

| Gestionarea sinonimelor | Înțelege automat sinonimele și conceptele conexe | Necesită mapare explicită sau extindere de interogare |

| Rezolvarea ambiguității | Interpretează contextul pentru a dezambigua omonimele și polisemia | Are dificultăți cu termeni ambigui fără reguli suplimentare |

| Flexibilitate interogare | Gestionează interogări vagi, conversaționale, limbaj natural | Necesită formulare precisă a cuvintelor cheie pentru rezultate optime |

| Cost computațional | Mai ridicat (generare embedding și calcule de similaritate) | Mai redus (căutare simplă în index și ranking) |

| Acuratețe pentru interogări complexe | Superioară (înțelege intenția și nuanța) | Limitată (doar potrivire literală) |

| Experiență utilizator | Mai intuitivă, seamănă cu o conversație umană | Necesită ca utilizatorul să gândească precum motorul de căutare |

| Complexitate implementare | Complexă (necesită modele ML și baze de date vectoriale) | Simplă (indici de baze de date tradiționale) |

| Exemplu real | Căutarea “cum răcesc o cameră fără AC” returnează rezultate despre ventilatoare, ventilație, perdele termice | Returnează doar pagini cu toate cele patru cuvinte, ratând alternative relevante |

Procesarea limbajului natural (NLP) este tehnologia fundamentală care permite căutării semantice să înțeleagă limbajul uman. NLP cuprinde multiple tehnici care extrag împreună sensul din text: tokenizarea împarte textul în unități mai mici, normalizarea standardizează formatul textului, iar etichetarea părților de vorbire identifică rolurile gramaticale. Mai important, NLP-ul modern folosește arhitecturi transformer care pot înțelege contextul analizând relațiile dintre toate cuvintele dintr-o propoziție simultan, nu secvențial. Această înțelegere contextuală este esențială pentru căutarea semantică deoarece permite sistemului să recunoască faptul că “bancă” înseamnă altceva în “mal de râu” față de “bancă de economii”. Mecanismul de atenție din modelele transformer le permite să se concentreze pe cele mai relevante părți din text la generarea embedding-urilor, asigurând captarea informațiilor semantice importante. Când un utilizator caută “cele mai bune pantofi de alergat”, NLP ajută sistemul să înțeleagă că intenția este găsirea de recomandări și recenzii, nu doar o listă de pantofi. Această înțelegere semantică a intenției diferențiază sistemele moderne de căutare de cele bazate pe cuvinte cheie și explică de ce ChatGPT, Perplexity și alte platforme AI pot oferi răspunsuri atât de relevante și potrivite contextului.

Marile platforme AI au implementat căutarea semantică reflectând arhitecturile și capabilitățile lor unice. ChatGPT folosește căutarea semantică pentru a recupera informații relevante din datele sale de antrenament și din surse externe prin pluginuri, înțelegând interogările utilizatorilor la un nivel semantic profund pentru a oferi răspunsuri potrivite contextului. Perplexity a construit întregul său model de căutare în jurul înțelegerii semantice, folosind embedding-uri pentru a găsi surse relevante și a sintetiza informații care răspund direct intenției utilizatorului. Google AI Overviews (fost SGE) integrează căutarea semantică pentru a înțelege intenția interogării și a găsi cele mai relevante pasaje din conținutul web indexat, depășind rankingul tradițional bazat pe cuvinte cheie. Claude utilizează la rândul său înțelegerea semantică pentru a interpreta cererile utilizatorului și a extrage context relevant din baza sa de cunoștințe. Aceste platforme demonstrează că similaritatea semantică a răspunsurilor — măsurată de cercetări ce compară Perplexity și ChatGPT — indică implementări sofisticate de căutare semantică. Faptul că utilizatorii care caută au rate de conversie de 2-3x mai mari decât vizitatorii fără căutare în majoritatea industriilor, retailerii de modă având rate de până la 4,2%, demonstrează impactul real al căutării semantice asupra satisfacției utilizatorilor și rezultatelor de business. Pentru organizațiile care își monitorizează prezența în aceste sisteme AI, înțelegerea modului în care funcționează căutarea semantică este esențială pentru optimizarea vizibilității conținutului.

Căutarea semantică a devenit transformatoare în mediile enterprise și eCommerce, unde înțelegerea intenției utilizatorului influențează direct rezultatele de business. În eCommerce, căutarea semantică permite clienților să găsească produse folosind descrieri în limbaj natural, nu doar denumiri exacte. Un client care caută “pantofi comozi pentru stat mult în picioare” va găsi rezultate relevante chiar dacă baza de produse folosește termeni diferiți precum “încălțăminte ergonomică” sau “pantofi de susținere pentru stat prelungit în picioare”. Această capabilitate a determinat creșteri semnificative ale ratelor de conversie și satisfacției clienților. În căutarea enterprise, căutarea semantică ajută angajații să găsească documente relevante, articole din baza de cunoștințe și resurse interne fără a cunoaște terminologia exactă sau titlurile documentelor. Un profesionist juridic care caută “clauze de reziliere a contractului” va găsi documente despre “dizolvare contract”, “anulare acord” și “prevederi de reziliere”, chiar dacă acestea folosesc vocabular diferit. Amazon a integrat căutarea semantică la nivel global pe platformele sale eCommerce, recunoscând că înțelegerea intenției clientului este crucială pentru creșterea vânzărilor. Alte companii mari precum Microsoft (Bing), IBM watsonx, OpenAI și Anthropic au investit masiv în capabilități de căutare semantică. Chiar și Elon Musk și-a exprimat interesul de a adăuga funcționalitate de căutare semantică pe X (fost Twitter), arătând importanța tot mai mare a tehnologiei pe diverse platforme și utilizări.

Căutarea semantică modernă se bazează pe modele sofisticate de învățare automată antrenate pe volume uriașe de date text pentru a înțelege tiparele limbajului și relațiile semantice. BERT (Bidirectional Encoder Representations from Transformers), lansat de Google în 2018, a revoluționat căutarea semantică prin introducerea înțelegerii contextului bidirecțional — modelul analizează cuvintele în ambele direcții pentru a înțelege sensul. Modelele GPT de la OpenAI duc acest aspect mai departe prin capabilități generative ce permit nu doar înțelegerea, ci și raționamentul semantic. Biblioteca sentence-transformers oferă modele pre-antrenate optimizate pentru sarcini de similaritate semantică, modele precum ‘all-MiniLM-L6-v2’ oferind un echilibru între viteză și acuratețe. Aceste modele sunt antrenate folosind învățare contrastivă, sistemul învățând să apropie textele semantic similare în embedding space și să le depărteze pe cele diferite. Procesul de antrenare implică milioane de perechi de texte, permițând modelului să învețe ce cuvinte și concepte se asociază natural. După antrenare, aceste modele pot fi aplicate pe text nou fără antrenament suplimentar, făcându-le practice pentru aplicații reale. Calitatea embedding-urilor influențează direct calitatea căutării, motiv pentru care organizațiile experimentează frecvent cu modele diferite pentru a găsi echilibrul optim între acuratețe, viteză și cost computațional pentru cazurile lor de utilizare.

Baze de date vectoriale au devenit infrastructură esențială pentru implementarea căutării semantice la scară mare. Spre deosebire de bazele de date relaționale tradiționale optimizate pentru potrivirea exactă, bazele vectoriale sunt concepute special pentru a stoca și interoga embedding-uri de înaltă dimensiune eficient. Milvus, o bază de date open-source, oferă algoritmi de indexare precum HNSW (Hierarchical Navigable Small World) și FAISS (Facebook AI Similarity Search), permițând căutări rapide de similaritate pe milioane sau miliarde de embedding-uri. Pinecone oferă un serviciu gestionat de baze de date vectoriale care preia complexitatea operațională a infrastructurii de căutare semantică. Zilliz Cloud, bazat pe tehnologia Milvus, include funcții enterprise precum recuperare la dezastre, balansare de sarcină și suport multi-tenant. Bazele de date tradiționale s-au adaptat și ele: PostgreSQL a adăugat extensia pgvector pentru operațiuni vectoriale, iar Elasticsearch a extins funcționalitățile dincolo de căutarea pe cuvinte cheie pentru a integra căutarea vectorială. Aceste baze vectoriale permit organizațiilor să implementeze abordări de căutare hibridă, combinând similaritatea semantică cu potrivirea tradițională de cuvinte cheie și valorificând punctele forte ale ambelor metode. Capacitatea de a interoga eficient embedding-uri face cautarea semantică practică pentru sisteme de producție care gestionează volume reale de date și trafic de utilizatori.

Viitorul căutării semantice este modelat de mai multe tendințe și evoluții tehnologice emergente. Embedding-urile multimodale care pot reprezenta text, imagini, audio și video în același spațiu permit căutări cross-modale — găsirea de imagini pe baza descrierilor textuale sau invers. Embedding-urile ajustate pe instrucțiuni sunt rafinate pentru domenii și utilizări specifice, îmbunătățind acuratețea pentru aplicații specializate precum căutarea de documente juridice sau medicale. Tehnicile de cuantizare reduc cerințele computaționale și de stocare ale embedding-urilor, făcând căutarea semantică mai accesibilă organizațiilor cu infrastructură limitată. Integrarea căutării semantice cu retrieval-augmented generation (RAG) permite sistemelor AI să-și ancoreze răspunsurile în documente și baze de cunoștințe concrete, crescând acuratețea și reducând halucinațiile. Pe măsură ce modelele mari de limbaj evoluează, abilitățile lor de înțelegere semantică vor deveni tot mai sofisticate, permițând interpretări mai nuanțate ale intenției utilizatorului. Pentru organizațiile ce-și monitorizează prezența în sisteme AI, evoluția căutării semantice are implicații profunde. Pe măsură ce platformele AI devin tot mai sofisticate în înțelegerea sensului semantic, strategiile tradiționale SEO bazate pe cuvinte cheie devin mai puțin eficiente. În schimb, organizațiile trebuie să se concentreze pe crearea de conținut care răspunde autentic intenției utilizatorului și oferă valoare semantică. Creșterea căutării semantice înseamnă că vizibilitatea conținutului în AI precum ChatGPT, Perplexity și Google AI Overviews depinde mai puțin de optimizarea pe cuvinte cheie și mai mult de calitatea, relevanța și alinierea semantică a conținutului cu interogările utilizatorilor. Aceasta reprezintă o schimbare fundamentală în modul în care organizațiile trebuie să abordeze strategia de conținut și vizibilitatea digitală în era AI.

Pentru platforme precum AmICited care monitorizează aparițiile brandului și domeniilor în răspunsuri generate de AI, înțelegerea căutării semantice este crucială. Când ChatGPT, Perplexity, Google AI Overviews sau Claude generează răspunsuri, utilizează căutarea semantică pentru a recupera informații relevante din bazele lor de cunoștințe și conținut indexat. Un domeniu poate apărea în răspunsurile AI nu pentru că are potriviri exacte de cuvinte cu interogarea utilizatorului, ci pentru că căutarea semantică l-a identificat ca fiind relevant semantic față de intenția utilizatorului. Acest lucru înseamnă că organizațiile trebuie să înțeleagă cum este indexat și recuperat semantic conținutul lor de aceste sisteme AI. Conținutul care răspunde complet intenției utilizatorului, folosește eficient limbajul natural și demonstrează expertiză semantică are mai multe șanse să fie recuperat de algoritmii de căutare semantică. Monitorizarea vizibilității căutării semantice necesită abordări diferite față de monitorizarea SEO tradițională bazată pe cuvinte cheie. Organizațiile trebuie să urmărească nu doar potriviri exacte de cuvinte, ci și variații semantice și interogări bazate pe intenție care le pot aduce conținutul în față. Capacitatea de a înțelege ce concepte și subiecte semantice aduc vizibilitate în sistemele AI permite o optimizare mai strategică a conținutului și ajută organizațiile să identifice oportunități de a-și îmbunătăți prezența în răspunsurile generate de AI.

Căutarea semantică interpretează sensul și contextul folosind modele de învățare automată pentru a înțelege intenția utilizatorului, în timp ce căutarea pe bază de cuvinte cheie potrivește exact cuvinte sau expresii din documente. Căutarea pe bază de cuvinte cheie folosește indici inversați și metode statistice precum TF-IDF, în timp ce căutarea semantică convertește textul în vectori de embedding unde semnificațiile similare sunt grupate matematic. Acest lucru permite cautării semantice să găsească conținut relevant chiar dacă nu există potrivire exactă a cuvintelor, de exemplu găsind 'infarct miocardic' când se caută 'atac de cord'.

Embedding-urile vectoriale sunt reprezentări numerice care surprind sensul semantic prin conversia textului în vectori multidimensionali. Când atât interogările cât și documentele sunt convertite în embedding-uri, sistemul poate măsura similaritatea folosind metrici de distanță precum similaritatea cosinusului. Conceptele similare produc vectori apropiați matematic în spațiul embedding, permițând motorului de căutare să găsească conținut relaționat conceptual, indiferent de potrivirea cuvintelor cheie.

Principalele platforme AI, inclusiv ChatGPT, Perplexity, Google AI Overviews și Claude, integrează capabilități de căutare semantică. Aceste platforme utilizează înțelegerea semantică pentru a interpreta interogările și a recupera informații relevante din bazele lor de cunoștințe. Perplexity și ChatGPT demonstrează o similaritate semantică ridicată în răspunsuri, indicând implementări sofisticate de căutare semantică ce înțeleg intenția utilizatorului dincolo de cuvintele cheie literale.

Piața globală de software de căutare semantică pentru companii a fost evaluată la 1,2 miliarde USD în 2024 și se estimează că va ajunge la 3,5 miliarde USD până în 2033, reprezentând o rată anuală compusă de creștere (CAGR) de aproximativ 11,5%. Această creștere reflectă adoptarea tot mai mare a căutării bazate pe AI în companii, organizațiile recunoscând valoarea înțelegerii semantice pentru îmbunătățirea experienței utilizatorilor și a acurateței căutării în diverse industrii.

Căutarea semantică crește satisfacția utilizatorilor oferind rezultate mai relevante care corespund intenției, nu doar potrivirii cuvintelor cheie. În eCommerce, utilizatorii care caută au rate de conversie de 2-3 ori mai mari decât vizitatorii fără căutare, retailerii de modă având rate de conversie de până la 4,2%. Prin înțelegerea a ceea ce își doresc utilizatorii, nu doar a ceea ce au scris literal, căutarea semantică reduce frustrarea și crește șansele de a găsi conținutul dorit din prima.

Căutarea semantică este alimentată de modele bazate pe arhitecturi transformer precum BERT, GPT și sentence-transformers care generează embedding-uri contextuale. Aceste modele pre-antrenate înțeleg nuanțe ale limbajului și relații între concepte. Biblioteca sentence-transformers, de exemplu, folosește modele precum 'all-MiniLM-L6-v2' care convertesc textul în vectori cu 384 de dimensiuni ce surprind relații semantice. Aceste modele sunt antrenate pe milioane de perechi de texte pentru a învăța care cuvinte și concepte se asociază natural.

Căutarea semantică gestionează ambiguitatea analizând contextul și intenția utilizatorului, nu tratând cuvintele izolat. De exemplu, la căutarea 'aplicații Java', sistemul poate distinge dacă utilizatorul se referă la limbajul de programare sau la produse legate de cafea, examinând contextul și tiparele de comportament. Această înțelegere contextuală permite căutării semantice să returneze rezultate relevante chiar și când interogările conțin omonime sau termeni ambigui care ar deruta sistemele tradiționale.

Algoritmul k-nearest neighbor (kNN) este fundamental în implementarea căutării semantice. După ce interogarea este convertită în embedding, kNN compară vectorul interogării cu vectorii documentelor pentru a găsi cele mai apropiate k documente. Algoritmul măsoară distanța între vectori în spațiul embedding, identificând documentele cele mai apropiate matematic de interogare. Ulterior, un reranker evaluează aceste rezultate folosind factori suplimentari de relevanță pentru a produce lista finală de rezultate.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

Află cum căutarea semantică folosește AI pentru a înțelege intenția și contextul utilizatorului. Descoperă cum diferă de căutarea prin cuvinte cheie și de ce es...

Află cum potrivirea semantică a interogărilor permite sistemelor AI să înțeleagă intenția utilizatorului și să livreze rezultate relevante dincolo de potrivirea...

Căutarea vectorială folosește reprezentări vectoriale matematice pentru a găsi date similare prin măsurarea relațiilor semantice. Află cum embedding-urile, metr...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.