JavaScript SEO

JavaScript SEO optimizează site-urile web generate cu JavaScript pentru explorarea și indexarea de către motoarele de căutare. Află cele mai bune practici, meto...

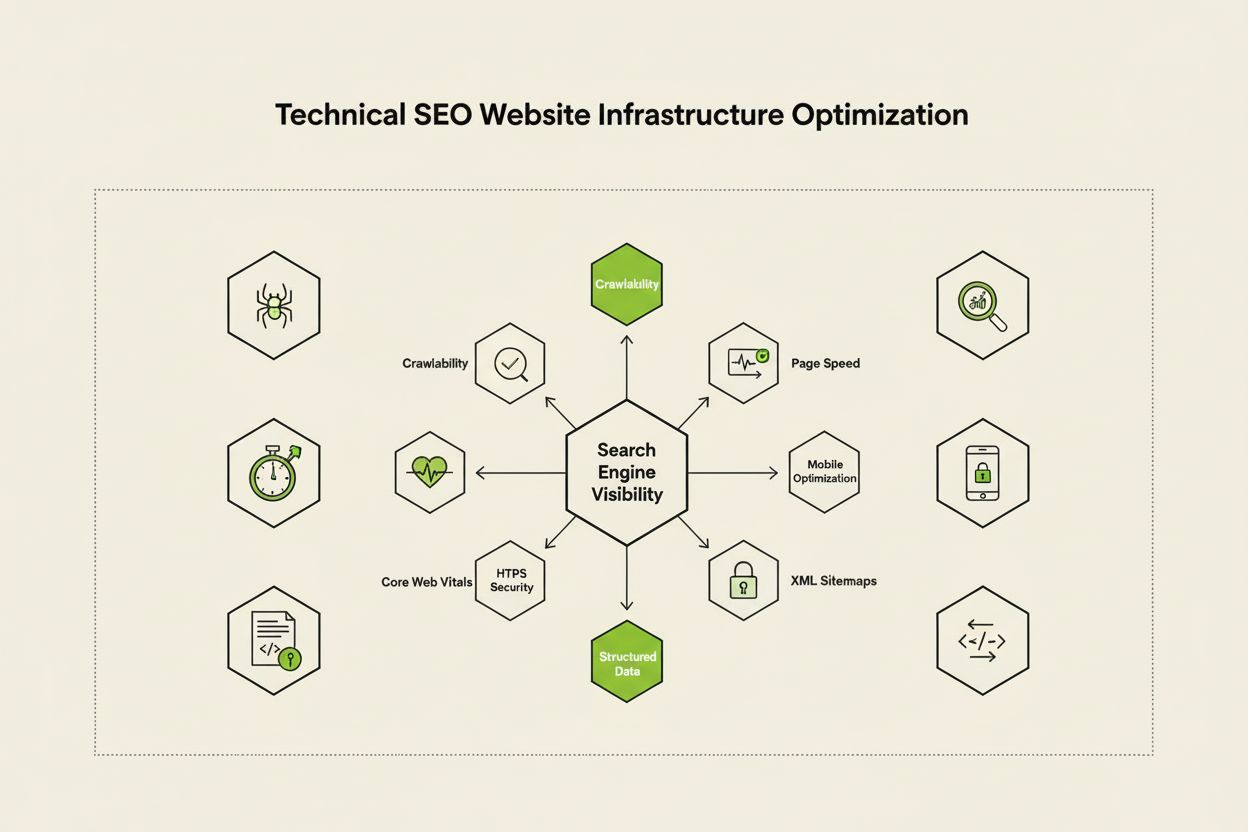

SEO tehnic este procesul de optimizare a infrastructurii unui site web astfel încât motoarele de căutare să poată accesa, reda, indexa și servi conținutul corect și eficient. Acesta cuprinde viteza site-ului, adaptabilitatea pentru mobil, arhitectura site-ului, securitatea și implementarea datelor structurate pentru a asigura că motoarele de căutare pot descoperi și clasa paginile tale.

SEO tehnic este procesul de optimizare a infrastructurii unui site web astfel încât motoarele de căutare să poată accesa, reda, indexa și servi conținutul corect și eficient. Acesta cuprinde viteza site-ului, adaptabilitatea pentru mobil, arhitectura site-ului, securitatea și implementarea datelor structurate pentru a asigura că motoarele de căutare pot descoperi și clasa paginile tale.

SEO tehnic este procesul de optimizare a infrastructurii din spate a unui site web pentru a asigura că motoarele de căutare pot accesa, reda, indexa și servi eficient conținutul. Spre deosebire de SEO on-page, care se concentrează pe calitatea conținutului și optimizarea cuvintelor-cheie, SEO-ul tehnic vizează elementele de bază care determină dacă motoarele de căutare pot accesa și înțelege site-ul tău. Acestea includ viteza site-ului, adaptabilitatea pentru mobil, arhitectura site-ului, protocoalele de securitate, implementarea datelor structurate și factorii de crawlabilitate. SEO-ul tehnic acționează ca o fundație invizibilă pe care se bazează toate celelalte eforturi SEO—fără el, chiar și cel mai calitativ conținut rămâne invizibil pentru motoarele de căutare și utilizatori. Conform cercetărilor din industrie, 91% dintre marketeri au raportat că SEO-ul a îmbunătățit performanța site-ului în 2024, optimizarea tehnică având un rol critic în obținerea rezultatelor măsurabile. Importanța SEO-ului tehnic a crescut pe măsură ce motoarele de căutare devin mai sofisticate și apar platforme de căutare bazate pe AI, necesitând ca site-urile să îndeplinească standarde tehnice din ce în ce mai stricte pentru vizibilitate.

SEO-ul tehnic se bazează pe patru piloni interconectați care lucrează împreună pentru a maximiza vizibilitatea în motoarele de căutare. Crawlabilitatea determină dacă Googlebot și alți crawlere pot accesa paginile site-ului tău prin linkuri, sitemap-uri și structuri interne de navigație. Indexabilitatea asigură că paginile accesate sunt efectiv stocate în indexul Google și eligibile pentru apariția în rezultate. Performanța și Core Web Vitals măsoară cât de rapid se încarcă paginile și cât de receptive sunt la interacțiunile utilizatorilor—factori care influențează direct clasarea și experiența utilizatorului. Optimizarea pentru mobil garantează funcționarea impecabilă a site-ului pe smartphone-uri și tablete, care reprezintă acum peste 60% din traficul total, conform cercetării Sistrix. Acești patru piloni sunt interdependenți; o slăbiciune într-o zonă poate compromite eficiența celorlalte. De exemplu, un site desktop rapid care funcționează prost pe mobil va avea dificultăți în a se clasa în indexul mobile-first al Google, indiferent de cât de bine este optimizată crawlabilitatea. Înțelegerea interacțiunii dintre acești piloni este esențială pentru elaborarea unei strategii tehnice complete care să acopere toate aspectele vizibilității în căutare.

Deși sunt adesea confundate, crawlabilitatea și indexabilitatea reprezintă două etape distincte în fluxul motoarelor de căutare. Crawlabilitatea se referă la capacitatea unui motor de căutare de a descoperi și accesa paginile site-ului tău prin urmărirea linkurilor interne, backlinkurilor externe și sitemapurilor XML. Ea răspunde la întrebarea: “Poate Googlebot să ajungă la această pagină?” Dacă o pagină nu este crawlabilă—poate pentru că este blocată de robots.txt, ascunsă după JavaScript sau orfană fără linkuri interne—nu poate trece la faza de indexare. Indexabilitatea, în schimb, stabilește dacă o pagină accesată este efectiv stocată în indexul Google și eligibilă pentru apariția în rezultate. O pagină poate fi perfect crawlabilă, dar totuși neindexată dacă are un meta tag noindex, conținut duplicat sau nu îndeplinește standardele de calitate ale Google. Potrivit ghidului tehnic SEO de la Search Engine Land, înțelegerea acestei diferențe este crucială deoarece remedierea problemelor de crawlabilitate necesită soluții diferite față de problemele de indexabilitate. Problemele de crawlabilitate implică de obicei structura site-ului, configurarea robots.txt și linkingul intern, în timp ce problemele de indexabilitate țin mai mult de meta taguri, taguri canonice, calitatea conținutului și probleme de redare. Ambele trebuie adresate pentru o vizibilitate optimă în căutare.

Core Web Vitals sunt trei metrici specifice pe care Google le folosește pentru a măsura experiența reală a utilizatorului și care influențează direct clasamentul în căutări. Largest Contentful Paint (LCP) măsoară cât de rapid se încarcă cel mai mare element vizibil pe pagină—Google recomandă un LCP de maximum 2,5 secunde. Interaction to Next Paint (INP), care a înlocuit First Input Delay în 2024, măsoară cât de receptivă este o pagină la interacțiuni precum clicuri și atingeri—ținta este sub 200 de milisecunde. Cumulative Layout Shift (CLS) evaluează stabilitatea vizuală prin monitorizarea schimbărilor neașteptate de layout în timpul încărcării—un scor sub 0,1 este considerat bun. Cercetările DebugBear indică faptul că site-urile au nevoie ca 75% dintre utilizatori să experimenteze performanță “Bună” la toți cei trei indicatori pentru beneficii maxime de clasare. Trecerea la INP ca factor de clasare reflectă angajamentul Google de a evalua receptivitatea pe întreaga interacțiune, nu doar la încărcarea inițială. Optimizarea Core Web Vitals necesită o abordare multiplă: îmbunătățirea LCP presupune optimizarea imaginilor, utilizarea CDN-urilor și amânarea JavaScript-ului neesențial; îmbunătățirea INP necesită fragmentarea sarcinilor JavaScript lungi și optimizarea handlerelor de evenimente; reducerea CLS implică rezervarea spațiului pentru conținut dinamic și evitarea reclamelor care modifică layoutul. Aceste metrici au devenit esențiale pentru un SEO competitiv, paginile cu scoruri slabe fiind penalizate la clasament și având rate de respingere ridicate.

Arhitectura site-ului se referă la modul în care paginile site-ului sunt organizate, structurate și conectate prin linkuri interne. O arhitectură bine gândită îndeplinește funcții critice: ajută motoarele de căutare să înțeleagă ierarhia conținutului, distribuie echitatea linkurilor (puterea de clasare) pe întreg site-ul, asigură descoperirea facilă a paginilor importante și îmbunătățește navigarea pentru utilizatori. Arhitectura ideală urmează o ierarhie clară cu homepage-ul în vârf, paginile de categorie pe al doilea nivel și paginile individuale mai adânc. Recomandarea de bază este ca toate paginile importante să fie accesibile în maximum trei clicuri de la homepage, astfel încât Googlebot să nu irosească crawl budget pe pagini izolate. Linkingul intern acționează ca țesutul de legătură al arhitecturii, ghidând atât utilizatorii, cât și motoarele de căutare prin conținut. Linkingul intern strategic consolidează semnalele de clasare pe paginile prioritare, stabilește relații tematice între conținuturi conexe și ajută motoarele să identifice paginile cele mai importante. De exemplu, un model tip hub-and-spoke—unde o pagină principală cuprinzătoare face legătura cu mai multe subiecte conexe, care la rândul lor trimit înapoi către pilon—creează o structură puternică ce semnalează autoritate tematică. Arhitectura slabă, cu pagini orfane, navigare inconsistentă și niveluri adânci, forțează motoarele să irosească crawl budget și face dificilă stabilirea autorității tematice. Companiile care își restructurează arhitectura site-ului observă adesea îmbunătățiri semnificative în viteza de indexare și performanța la clasament.

Indexarea mobile-first înseamnă că Google folosește în principal versiunea mobilă a site-ului pentru accesare, indexare și clasare, nu pe cea desktop. Această schimbare reflectă realitatea că peste 60% din căutări provin de pe dispozitive mobile. Pentru SEO tehnic, experiența mobilă trebuie să fie impecabilă: design responsiv care se adaptează oricărei dimensiuni de ecran, navigare ușor de folosit cu spațiu suficient între elementele clicabile, dimensiuni de font lizibile fără zoom și încărcare rapidă optimizată pentru rețele mobile. Designul responsiv folosește layouturi fluide și imagini flexibile pentru a se adapta automat dispozitivelor, asigurând funcționalitate constantă. Greșelile comune includ interstitiale intruzive (pop-up-uri) care blochează conținutul, texte prea mici, butoane prea apropiate și pagini lente pe mobil. Testele Google Mobile-Friendly și auditurile Lighthouse pot identifica aceste probleme, dar testarea reală pe dispozitive mobile rămâne esențială. Relația între optimizarea mobilă și clasament este directă: paginile cu experiență slabă pe mobil sunt penalizate, iar cele optimizate câștigă vizibilitate. Pentru ecommerce, SaaS sau publisheri, optimizarea pentru mobil nu mai este opțională—este fundamentală pentru vizibilitatea competitivă.

Sitemap-urile XML servesc drept hartă pentru motoarele de căutare, listând toate URL-urile pe care vrei să le indexezi, împreună cu metadate precum data ultimei modificări și priorități. Un sitemap bine întreținut trebuie să includă doar URL-uri canonice și indexabile—excluzând redirecturi, pagini 404 și conținut duplicat. Robots.txt este un fișier text în directorul rădăcină al site-ului care oferă instrucțiuni de crawling, specificând ce directoare și fișiere pot sau nu fi accesate de boți. Deși robots.txt poate bloca crawlingul, nu previne indexarea dacă pagina e descoperită pe alte căi; pentru excludere reală, folosește meta tagul noindex. Crawl budgetul reprezintă numărul de pagini pe care Googlebot le va accesa într-un anumit interval—o resursă finită ce trebuie gestionată strategic. Site-urile mari, cu milioane de pagini, trebuie să optimizeze crawl budgetul pentru ca Googlebot să se concentreze pe conținut valoros, nu pe pagini de prioritate scăzută, conținut duplicat sau variații generate de navigare facetată. Risipa de crawl budget apare când parametrii de căutare generează nenumărate variante de URL-uri, când mediile de test/dezvoltare sunt expuse crawlerilor sau când paginile subțiri primesc linking intern excesiv. Conform ghidului oficial Google, gestionarea crawl budgetului e deosebit de importantă pentru site-urile mari, întrucât crawlingul ineficient poate întârzia descoperirea și indexarea conținutului nou sau actualizat. Uneltele precum Crawl Stats din Google Search Console și analiza logurilor de server arată exact ce pagini vizitează Googlebot și cât de des, permițând optimizarea datelor de crawling.

Datele structurate, implementate prin schema markup, ajută motoarele de căutare să înțeleagă sensul și contextul conținutului tău, dincolo de simpla analiză textuală. Schema markup folosește un vocabular standardizat (de pe schema.org) pentru a eticheta diverse tipuri de conținut—produse, articole, rețete, evenimente, afaceri locale și multe altele. Când este implementată corect, schema permite rich results în căutare, unde Google afișează informații suplimentare precum ratinguri, prețuri, timpi de gătire sau date de eveniment direct în rezultate. Această vizibilitate crescută poate îmbunătăți considerabil rata de click și implicarea utilizatorilor. Diferite tipuri de conținut necesită implementări diferite: schema Article pentru bloguri și știri, schema Product pentru ecommerce, schema FAQ pentru întrebări frecvente, schema Local Business pentru locații fizice și schema Event pentru evenimente viitoare. Implementarea se face de obicei cu formatul JSON-LD, preferat de Google. Totuși, schema trebuie să reflecte fidel conținutul real—schema înșelătoare poate duce la penalizări manuale. Potrivit Search Engine Land, doar paginile cu markup valid și relevant se califică pentru rich results, acuratețea implementării fiind esențială. Organizațiile care implementează schema pe paginile cele mai importante observă creșterea vizibilității atât în căutarea tradițională, cât și pe platformele AI, acestea bazându-se pe date structurate pentru citarea corectă a conținutului.

HTTPS (Hypertext Transfer Protocol Secure) criptează datele transmise între browserul utilizatorilor și serverul web, protejând informații sensibile și semnalând încredere atât utilizatorilor, cât și motoarelor de căutare. Google a confirmat că HTTPS este factor de clasare, iar site-urile fără HTTPS sunt penalizate direct și indirect (prin avertismente de browser care descurajează utilizatorii). Implementarea HTTPS presupune obținerea unui certificat SSL/TLS de la o autoritate de certificare de încredere și configurarea serverului pentru HTTPS pe toate paginile. Dincolo de implementarea de bază, header-ele de securitate precum Content-Security-Policy, Strict-Transport-Security și X-Content-Type-Options oferă protecție suplimentară împotriva vulnerabilităților web. Erorile de conținut mixt—când paginile HTTPS încarcă resurse HTTP—compromit securitatea și pot declanșa avertismente. Relația dintre securitate și SEO depășește clasamentul: site-urile securizate inspiră încredere, reduc rata de respingere și cresc conversiile. Pentru ecommerce, SaaS sau orice site care colectează date personale, securitatea este obligatorie. Auditurile regulate cu Google Search Console (raportul Security Issues) și scanere terțe de vulnerabilități ajută la identificarea și remedierea problemelor înainte să afecteze clasamentul sau încrederea utilizatorilor.

| Aspect | SEO Tehnic | SEO On-Page | SEO Off-Page |

|---|---|---|---|

| Focus Principal | Infrastructura site-ului, viteză, crawlabilitate, indexabilitate | Calitatea conținutului, cuvinte-cheie, meta taguri, titluri | Backlinkuri, mențiuni de brand, semnale sociale |

| Acces Motoare de Căutare | Asigură accesul și indexarea de către motoare | Ajută motoarele să înțeleagă relevanța paginii | Construiește autoritate și semnale de încredere |

| Elemente Cheie | Viteza site-ului, optimizare mobilă, Core Web Vitals, arhitectură, HTTPS, date structurate | Plasarea cuvintelor-cheie, profunzimea conținutului, linking intern, meta descrieri | Profil de backlinkuri, autoritate domeniu, mențiuni brand |

| Unelte Folosite | PageSpeed Insights, Google Search Console, Screaming Frog, Lighthouse | Yoast SEO, Surfer SEO, Content Genius | Ahrefs, Semrush, Moz, Majestic |

| Impact asupra Clasării | Fundamental—fără el, paginile nu pot fi clasate | Direct—crește relevanța pe cuvinte-cheie țintă | Semnificativ—construiește autoritate și încredere |

| Impact asupra Experienței Utilizatorului | Mare—afectează viteza, utilizabilitatea mobilă, accesibilitatea | Mediu—afectează lizibilitatea și implicarea | Redus—indirect, prin percepția brandului |

| Durata Implementării | Continuă—necesită monitorizare și optimizare permanentă | Continuă—necesită actualizări de conținut și optimizare | Pe termen lung—necesită eforturi constante de link building |

| Măsurarea ROI | Eficiența crawlingului, rata de indexare, scoruri Core Web Vitals, clasamente | Clasări cuvinte-cheie, trafic organic, rata de click | Creștere backlinkuri, autoritate domeniu, trafic de referință |

SEO JavaScript abordează provocările site-urilor puternic bazate pe JavaScript, aplicațiilor single-page (SPA) și redării dinamice. Istoric, Googlebot avea dificultăți cu JavaScript deoarece necesita redarea paginii—executarea codului JS pentru a construi pagina finală—ceea ce complica și întârzia crawlingul. Googlebot-ul modern redă majoritatea paginilor înainte de indexare, însă acest proces aduce noi considerente tehnice. Redarea server-side (SSR) generează HTML complet pe server înainte de a-l trimite browserului, astfel încât motoarele văd conținutul imediat, fără să aștepte execuția JS. Generarea statică a site-ului (SSG) pre-redă paginile la build, creând fișiere HTML statice care se încarcă instant. Redarea dinamică servește HTML pre-redat motoarelor, dar JS utilizatorilor, deși Google spune că e o soluție temporară. Principiul critic: tot conținutul esențial, meta tagurile și datele structurate trebuie să fie vizibile în HTML-ul inițial, nu încărcate dinamic după execuția JS. Paginile care ascund conținut critic după JavaScript riscă indexare incompletă sau întârziată. Framework-urile React, Vue, Angular necesită atenție specială—multe organizații implementează Next.js sau Nuxt.js tocmai pentru redare server-side și performanță SEO. Testarea cu URL Inspection Tool din Google Search Console și funcția de snapshot redat arată dacă Googlebot indexează corect conținutul dependent de JavaScript.

Implementarea eficientă a SEO-ului tehnic necesită o abordare sistematică, axată pe optimizările cu cel mai mare impact. Începe cu elementele de bază: asigură-te că site-ul este crawlabil verificând robots.txt și linkingul intern, verifică indexabilitatea paginilor importante (noindex, canonical) și stabilește un reper pentru scorurile Core Web Vitals. Apoi, optimizează performanța: comprimă și optimizează imaginile, implementează lazy loading pentru conținutul sub fold, amână JS neesențial și folosește CDN-uri pentru livrare rapidă. Optimizează structura site-ului: păstrează paginile importante la maximum trei clicuri de homepage, implementează breadcrumbs cu schema, creează modele clare de linking intern pentru a ghida atât utilizatorii, cât și motoarele. Implementează date structurate pentru cele mai importante tipuri de conținut—produse, articole, business-uri locale, evenimente—folosind JSON-LD validat cu Rich Results Test. Monitorizează continuu cu Google Search Console pentru indexare, PageSpeed Insights pentru Core Web Vitals și loguri de server pentru tipare de crawling. Stabilește responsabilitate urmărind metrici cheie: număr pagini indexate, scoruri Core Web Vitals, eficiență crawling. Organizațiile care tratează SEO-ul tehnic ca un proces continuu, nu ca audit punctual, depășesc constant concurența în vizibilitate și experiența utilizatorului.

Pe măsură ce platformele de căutare AI precum Google AI Overviews, Perplexity, ChatGPT și Claude devin tot mai proeminente, importanța SEO-ului tehnic depășește căutarea Google clasică. Aceste sisteme AI se bazează pe conținut bine indexat și structurat pentru a genera răspunsuri și citări. SEO-ul tehnic asigură ca AI-urile să descopere și să interpreteze corect conținutul prin mai multe mecanisme: indexarea corectă îl face disponibil pentru antrenare și extragere, datele structurate ajută AI-urile să înțeleagă contextul și semnificația, iar bogăția semantică permite recunoașterea autorității și relevanței. Conform cercetărilor Conductor și Botify, paginile care apar în AI Overviews provin de regulă de pe site-uri tehnic solide, cu semnale semantice puternice. Relația e bidirecțională: SEO-ul tradițional vizează clasarea pe cuvinte-cheie, SEO-ul AI vizează furnizarea de răspunsuri complete din surse multiple. Această schimbare impune ca SEO-ul tehnic să sprijine ambele paradigme—indexare pentru căutarea clasică și bogăție semantică pentru AI. Organizațiile care monitorizează vizibilitatea pe multiple platforme AI cu unelte precum AmICited pot identifica ce optimizări tehnice cresc rata de citare și vizibilitatea în căutarea generativă.

Un SEO tehnic eficient necesită urmărirea unor metrici specifice care indică sănătatea site-ului și accesibilitatea pentru motoarele de căutare. Numărul de pagini indexate arată câte pagini intenționate sunt stocate în indexul Google—compararea cu totalul paginilor indexabile evidențiază eficiența indexării. Eficiența crawlingului măsoară cât de eficient utilizează Googlebot crawl budgetul, calculată prin raportul dintre paginile crawlate și totalul paginilor site-ului. Scorurile Core Web Vitals indică calitatea experienței utilizatorului privind viteza (LCP), interactivitatea (INP) și stabilitatea vizuală (CLS). Problemele de utilizare mobilă din Search Console evidențiază erori precum butoane mici, configurare greșită a viewportului sau interstitiale intruzive. Lungimea lanțurilor de redirect trebuie minimizată pentru a păstra echitatea linkurilor și a reduce întârzierile. Acoperirea cu date structurate arată procentul de pagini cu schema validă. Metricile de viteză precum First Contentful Paint (FCP), Time to Interactive (TTI) și Total Blocking Time (TBT) oferă detalii suplimentare de performanță. Organizațiile ar trebui să stabilească valori de bază pentru aceste metrici, să seteze ținte de îmbunătățire și să urmărească progresul lunar sau trimestrial. Schimbările bruște pot semnala probleme tehnice înainte de a afecta clasamentul, permițând remedierea proactivă. Uneltele precum Google Search Console, PageSpeed Insights, Lighthouse și platforme enterprise (Semrush) oferă dashboard-uri complete pentru monitorizare pe întregul site.

Peisajul SEO tehnic continuă să evolueze odată cu schimbările de algoritm, tehnologii emergente și modificări de comportament ale utilizatorilor. Indexarea și clasarea bazate pe AI vor influența tot mai mult ce pagini sunt indexate și cum sunt clasate, necesitând suport semantic și recunoașterea entităților. Edge computing-ul și arhitecturile serverless permit livrare mai rapidă și optimizare în timp real la marginea rețelei, reducând latența și îmbunătățind Core Web Vitals. Accent crescut pe semnalele E-E-A-T (Experiență, Expertiză, Autoritate, Încredere) impune SEO-ului tehnic să susțină credibilitatea conținutului cu markup de autor, date de publicare și semnale de trust. Optimizarea multi-suprafață va deveni standard odată cu proliferarea platformelor AI, necesitând optimizare pentru vizibilitate pe Google, Perplexity, ChatGPT, Claude și altele. Analiticele orientate spre confidențialitate și colectarea datelor first-party vor remodela măsurarea impactului, trecând de la cookies terți la tracking server-side și măsurare bazată pe consimțământ. Maturizarea framework-urilor JavaScript va continua să îmbunătățească capabilitățile SEO, cu Next.js, Nuxt.js, Remix devenind standard pentru aplicații SEO-friendly. SEO tehnic automatizat cu AI va permite detectarea și remedierea rapidă a problemelor, platformele sugerând automat rezolvări pentru crawlabilitate, indexabilitate și performanță. Organizațiile care se actualizează constant rămân cu avantaj competitiv pe partea de vizibilitate organică.

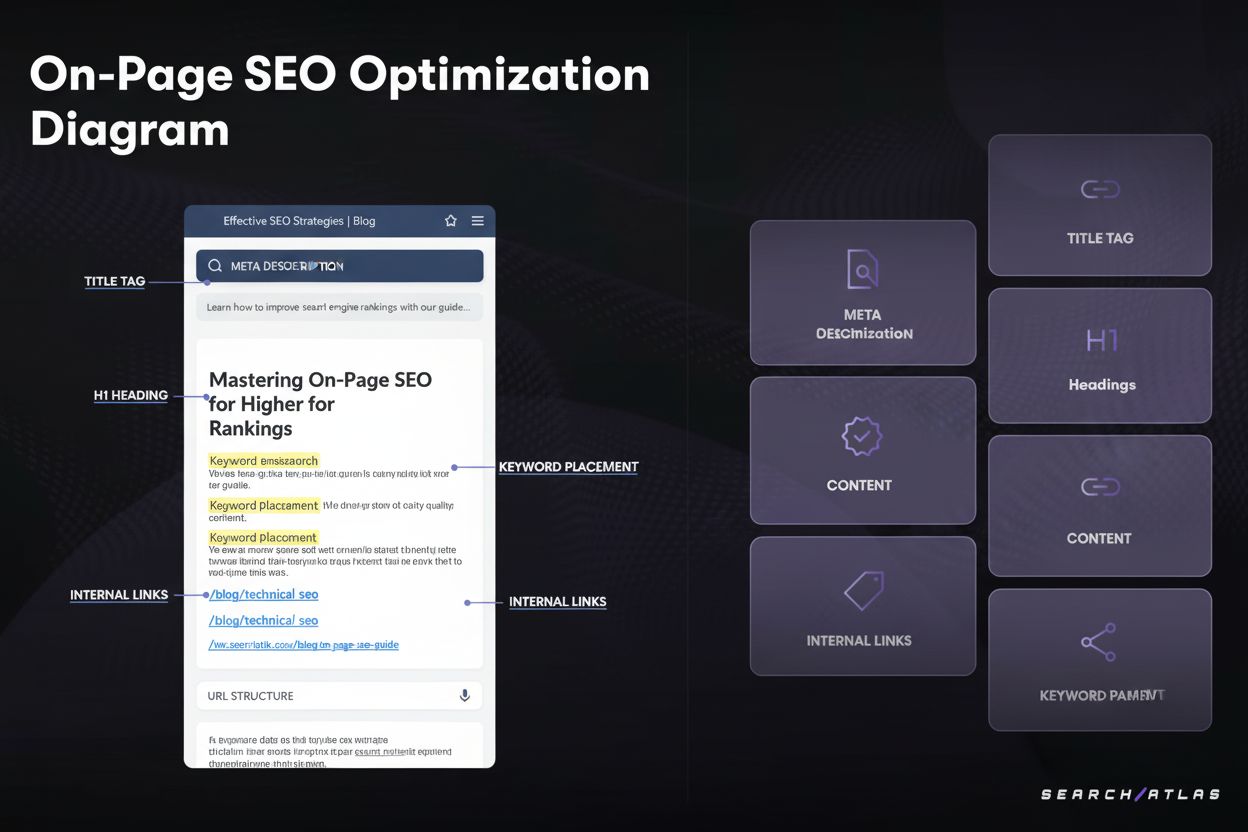

SEO tehnic se concentrează pe optimizarea infrastructurii din spate a unui site web—precum viteza site-ului, crawlabilitate, indexabilitate și configurarea serverului—pentru a ajuta motoarele de căutare să descopere și să proceseze conținutul. SEO on-page, în schimb, se concentrează pe optimizarea elementelor individuale ale paginii, cum ar fi plasarea cuvintelor-cheie, meta tagurile, titlurile și calitatea conținutului pentru a îmbunătăți relevanța pentru interogări specifice. În timp ce SEO tehnic asigură accesul motoarelor de căutare la site, SEO on-page asigură înțelegerea conținutului și a valorii acestuia pentru utilizatori.

Core Web Vitals—Largest Contentful Paint (LCP), Interaction to Next Paint (INP) și Cumulative Layout Shift (CLS)—sunt factori de clasare confirmați care măsoară experiența reală a utilizatorilor. Potrivit cercetărilor DebugBear, site-urile au nevoie ca 75% dintre utilizatori să aibă o experiență 'Bună' la toți cei trei indicatori pentru a primi maximum de beneficii la clasament. Core Web Vitals slabe pot duce la penalizări de clasament, rate de click mai mici și rate de respingere mai mari, afectând direct vizibilitatea organică și implicarea utilizatorilor.

Crawlabilitatea determină dacă roboții motoarelor de căutare pot accesa și urmări legăturile de pe site-ul tău. Dacă Googlebot nu poate accesa paginile din cauza resurselor blocate, a unei structuri slabe a site-ului sau a restricțiilor din robots.txt, acele pagini nu pot fi indexate sau clasate. Fără o crawlabilitate adecvată, chiar și conținutul de înaltă calitate rămâne invizibil pentru motoarele de căutare, făcând imposibilă obținerea vizibilității organice indiferent de calitatea conținutului sau profilul de backlinkuri.

Pe măsură ce platforme de căutare bazate pe AI precum Google AI Overviews și Perplexity devin mai proeminente, SEO-ul tehnic rămâne fundamental. Aceste sisteme AI se bazează pe conținut corect indexat și bine structurat din indexul Google pentru a genera răspunsuri. SEO tehnic asigură ca conținutul tău să fie descoperit, redat corect și suficient de semantic pentru a fi citat și referențiat de sistemele AI. Fără o fundație tehnică solidă, conținutul tău nu va apărea în AI Overviews sau alte rezultate de căutare generativă.

Pentru majoritatea site-urilor, se recomandă efectuarea unui audit tehnic SEO complet trimestrial, cu monitorizare lunară a problemelor critice. Site-urile de tip enterprise, cu actualizări frecvente, ar trebui să auditeze lunar sau să implementeze sisteme de monitorizare continuă. După modificări majore, migrații sau redesign, auditurile imediate sunt esențiale. Auditurile regulate ajută la depistarea timpurie a problemelor înainte să afecteze clasamentul, asigurând menținerea crawlabilității, indexabilității și performanței optime.

Arhitectura site-ului determină modul în care motoarele de căutare navighează și înțeleg ierarhia conținutului. O arhitectură bine optimizată asigură că paginile importante sunt la maximum trei clicuri distanță de pagina principală, distribuie eficient puterea linkurilor și ajută motoarele de căutare să prioritizeze crawlarea conținutului valoros. O arhitectură slabă poate duce la pagini orfane, risipă de crawl budget și dificultăți în stabilirea autorității pe subiect, toate afectând negativ clasarea și vizibilitatea.

Viteza paginii influențează direct atât clasamentul în căutări, cât și comportamentul utilizatorilor. Google a confirmat că Core Web Vitals—care măsoară viteza de încărcare, interactivitatea și stabilitatea vizuală—sunt factori de clasare. Paginile lente au rate de respingere mai mari, implicare mai scăzută și conversii reduse. Studiile arată că paginile care se încarcă sub 2,5 secunde au o retenție și performanță la clasament semnificativ mai bună față de cele mai lente, făcând optimizarea vitezei esențială pentru succesul SEO.

Începe să urmărești cum te menționează chatbot-urile AI pe ChatGPT, Perplexity și alte platforme. Obține informații utile pentru a-ți îmbunătăți prezența în AI.

JavaScript SEO optimizează site-urile web generate cu JavaScript pentru explorarea și indexarea de către motoarele de căutare. Află cele mai bune practici, meto...

SEO pe pagină optimizează elemente ale paginii web precum titluri, conținut și legături pentru a îmbunătăți clasamentul în căutări. Află factorii cheie, tehnici...

SEO pe YouTube este procesul de optimizare a videoclipurilor și canalelor pentru a obține poziții mai bune în rezultatele de căutare YouTube. Află factorii de c...

Consimțământ Cookie

Folosim cookie-uri pentru a vă îmbunătăți experiența de navigare și a analiza traficul nostru. See our privacy policy.