Transparentnosť v snahách o zviditeľnenie AI: Najlepšie postupy pre zverejňovanie

Naučte sa zásadné najlepšie postupy pre transparentnosť a zverejňovanie AI. Objavte správanie, verbálne a technické metódy zverejňovania na budovanie dôvery a z...

Miera, do akej AI platformy zverejňujú spôsob, akým vyberajú a zoraďujú zdroje pri generovaní odpovedí. Transparentnosť AI rebríčkovania sa týka viditeľnosti algoritmov a kritérií, ktoré určujú, ktoré zdroje sa objavia v AI-generovaných odpovediach, čím sa odlišuje od tradičného rebríčkovania vo vyhľadávačoch. Táto transparentnosť je kľúčová pre tvorcov obsahu, vydavateľov a používateľov, ktorí potrebujú vedieť, ako je informácia vyberaná a uprednostňovaná. Bez transparentnosti používatelia nemôžu overiť dôveryhodnosť zdrojov ani pochopiť možné zaujatosti v AI-generovanom obsahu.

Miera, do akej AI platformy zverejňujú spôsob, akým vyberajú a zoraďujú zdroje pri generovaní odpovedí. Transparentnosť AI rebríčkovania sa týka viditeľnosti algoritmov a kritérií, ktoré určujú, ktoré zdroje sa objavia v AI-generovaných odpovediach, čím sa odlišuje od tradičného rebríčkovania vo vyhľadávačoch. Táto transparentnosť je kľúčová pre tvorcov obsahu, vydavateľov a používateľov, ktorí potrebujú vedieť, ako je informácia vyberaná a uprednostňovaná. Bez transparentnosti používatelia nemôžu overiť dôveryhodnosť zdrojov ani pochopiť možné zaujatosti v AI-generovanom obsahu.

Transparentnosť AI rebríčkovania označuje zverejňovanie spôsobu, akým systémy umelej inteligencie vyberajú, uprednostňujú a prezentujú zdroje pri generovaní odpovedí na používateľské otázky. Na rozdiel od tradičných vyhľadávačov, ktoré zobrazujú zoradené zoznamy odkazov, moderné AI platformy ako Perplexity, ChatGPT a Google AI Overviews integrujú výber zdrojov priamo do procesu generovania odpovede, takže kritériá rebríčkovania sú používateľom zväčša neviditeľné. Táto netransparentnosť vytvára zásadnú medzeru medzi tým, čo používateľ vidí (syntetizovaná odpoveď) a tým, ako bola táto odpoveď vytvorená (ktoré zdroje boli vybrané, s akou váhou a ako boli citované). Pre tvorcov obsahu a vydavateľov znamená tento nedostatok transparentnosti závislosť na algoritmoch, ktoré nemôžu pochopiť ani ovplyvniť tradičnými metódami optimalizácie. Rozdiel oproti transparentnosti tradičných vyhľadávačov je podstatný: zatiaľ čo Google zverejňuje všeobecné faktory rebríčkovania a smernice kvality, AI platformy často považujú mechanizmy výberu zdrojov za svoje obchodné tajomstvo. Medzi hlavné zainteresované skupiny patria tvorcovia obsahu usilujúci o viditeľnosť, vydavatelia zaujímajúci sa o prerozdelenie návštevnosti, manažéri značiek monitorujúci reputáciu, výskumníci overujúci zdroje informácií a používatelia, ktorí potrebujú rozumieť dôveryhodnosti AI-generovaných odpovedí. Porozumenie transparentnosti AI rebríčkovania sa stalo nevyhnutným pre každého, kto produkuje, distribuuje alebo sa spolieha na digitálny obsah v čoraz viac AI sprostredkovanom informačnom prostredí.

AI platformy využívajú systémy Retrieval-Augmented Generation (RAG), ktoré kombinujú jazykové modely s vyhľadávaním informácií v reálnom čase, aby boli odpovede ukotvené v skutočných zdrojoch a neboli závislé len od tréningových dát. Proces RAG pozostáva z troch hlavných etáp: vyhľadávanie (nájdenie relevantných dokumentov), rebríčkovanie (usporiadanie zdrojov podľa relevancie) a generovanie (syntetizovanie informácií s udržiavaním citácií). Rôzne platformy implementujú odlišné prístupy — Perplexity zvýrazňuje autoritu a aktuálnosť zdrojov, Google AI Overviews kladie dôraz na tematickú relevanciu a signály E-E-A-T (Experience, Expertise, Authoritativeness, Trustworthiness), zatiaľ čo ChatGPT Search vyvažuje kvalitu zdrojov s komplexnosťou odpovede. Medzi faktory ovplyvňujúce výber zdrojov zvyčajne patrí autorita domény (etablovaná povesť a profil spätných odkazov), aktuálnosť obsahu (čerstvosť informácií), tematická relevantnosť (sémantická zhoda s otázkou), signály angažovanosti (metriky interakcie používateľov) a frekvencia citácií (ako často sú zdroje uvádzané inými autoritatívnymi stránkami). AI systémy vážia tieto signály rôzne v závislosti od zámeru otázky — faktografické otázky môžu uprednostniť autoritu a aktuálnosť, zatiaľ čo pri názorových otázkach môžu prevážiť rozmanité perspektívy a angažovanosť. Algoritmy rebríčkovania zostávajú zväčša nezverejnené, hoci dokumentácia platforiem poskytuje obmedzený pohľad na ich váhovacie mechanizmy.

| Platforma | Transparentnosť citácií | Kritériá výberu zdrojov | Zverejnenie rebríčkovacieho algoritmu | Kontrola používateľa |

|---|---|---|---|---|

| Perplexity | Vysoká – inline citácie s odkazmi | Autorita, aktuálnosť, relevantnosť, odborné znalosti | Stredná – čiastočná dokumentácia | Stredná – možnosti filtrovania zdrojov |

| Google AI Overviews | Stredná – uvedené citované zdroje | E-E-A-T, tematická relevantnosť, čerstvosť, angažovanosť | Nízka – minimálne zverejnenie | Nízka – obmedzené prispôsobenie |

| ChatGPT Search | Stredná – zdroje uvedené samostatne | Kvalita, relevantnosť, komplexnosť, autorita | Nízka – proprietárny algoritmus | Nízka – žiadne prispôsobenie rebríčkovania |

| Brave Leo | Stredná – atribúcia zdrojov | Súkromné zdroje, relevantnosť, autorita | Nízka – netransparentnosť z dôvodu ochrany súkromia | Stredná – možnosti výberu zdrojov |

| Consensus | Veľmi vysoká – akademické zameranie s metrikami | Počet citácií, stav recenzovania, aktuálnosť, relevantnosť odboru | Vysoká – akademické štandardy transparentné | Vysoká – filtrovanie podľa typu a kvality štúdie |

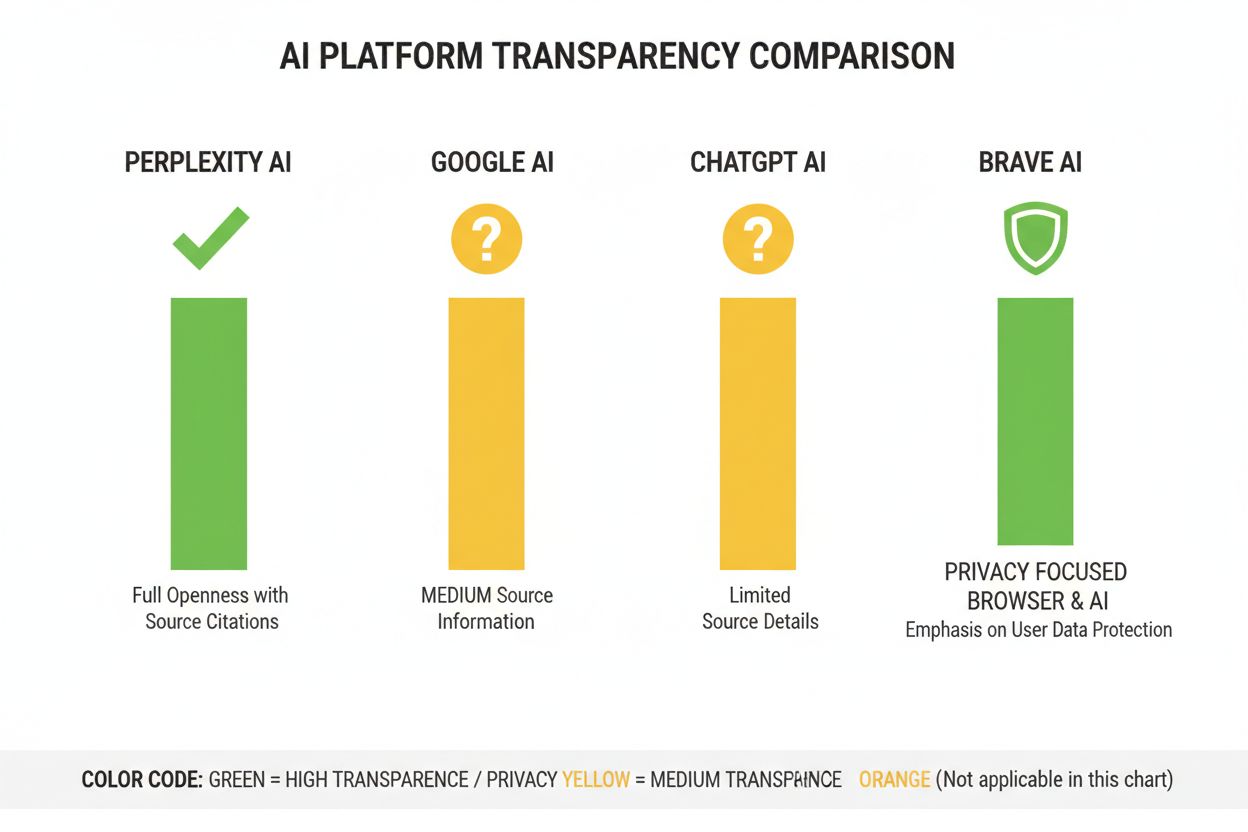

V AI odvetví chýbajú štandardizované praktiky zverejňovania fungovania rebríčkovacích systémov, čo vytvára roztrieštenú scénu, kde si každá platforma určuje vlastnú úroveň transparentnosti. OpenAI ChatGPT Search poskytuje minimálne vysvetlenie výberu zdrojov, systémy Meta AI ponúkajú obmedzenú dokumentáciu a Google AI Overviews zverejňuje viac ako konkurencia, no stále zamlčiava kľúčové algoritmické detaily. Platformy odmietajú úplné zverejnenie s odvolaním sa na konkurenčné výhody, obchodné tajomstvo a zložitosť vysvetlenia strojového učenia laickým používateľom — no táto netransparentnosť bráni nezávislému auditu a zodpovednosti. Objavuje sa problém „prania zdrojov“, keď AI systémy citujú zdroje, ktoré samy agregujú alebo prepisujú pôvodný obsah, čím zahmlievajú skutočný pôvod informácie a potenciálne zosilňujú dezinformácie cez viacero vrstiev syntézy. Regulačný tlak rastie: Zákon EÚ o AI vyžaduje, aby vysokorizikové AI systémy viedli dokumentáciu tréningových dát a rozhodovacích procesov, zatiaľ čo NTIA AI Accountability Policy vyzýva firmy k zverejňovaniu schopností, obmedzení a vhodného použitia AI systémov. Medzi konkrétne zlyhania v zverejňovaní patrí počiatočný problém Perplexity so správnou atribúciou (neskôr zlepšený), vágne vysvetlenie Googlu, ako AI Overviews vyberá zdroje, či obmedzená transparentnosť ChatGPT ohľadom toho, prečo sa určité zdroje objavujú v odpovediach a iné nie. Absencia štandardizovaných metrík na meranie transparentnosti sťažuje používateľom i regulátorom objektívne porovnávať platformy.

Netransparentnosť AI rebríčkovacích systémov vytvára výrazné problémy s viditeľnosťou pre tvorcov obsahu, keďže tradičné SEO stratégie pre vyhľadávače sa nedajú priamo aplikovať na optimalizáciu pre AI platformy. Vydavatelia nemôžu jednoducho pochopiť, prečo sa ich obsah objaví v niektorých AI odpovediach a v iných nie, čo znemožňuje cielené stratégie na zlepšenie viditeľnosti v AI-generovaných odpovediach. Objavuje sa citáciová zaujatost, keď AI systémy neúmerne zvýhodňujú určité zdroje — etablované spravodajské portály, akademické inštitúcie alebo vysoko navštevované webstránky — pričom marginalizujú menších vydavateľov, nezávislých tvorcov a úzko zameraných expertov, ktorí môžu poskytovať rovnako hodnotné informácie. Menší vydavatelia sú v nevýhode najmä preto, že AI rebríčkovacie systémy často výrazne uprednostňujú autoritu domény, pričom novšie alebo špecializované stránky postrádajú spätné odkazy a rozpoznateľnosť značky, ktoré majú etablované médiá. Výskum Search Engine Land ukazuje, že AI Overviews znížili mieru prekliknutí na tradičné výsledky vyhľadávania o 18-64 % podľa typu otázky, pričom návštevnosť je koncentrovaná medzi niekoľko zdrojov citovaných v AI odpovediach. Rozdiel medzi SEO (Search Engine Optimization) a GEO (Generative Engine Optimization) sa stáva zásadným — zatiaľ čo SEO sa sústreďuje na poradie v tradičnom vyhľadávaní, GEO vyžaduje pochopenie a optimalizáciu podľa výberových kritérií AI platforiem, ktoré sú prevažne netransparentné. Tvorcovia obsahu potrebujú nástroje ako AmICited.com na sledovanie, kde sa ich obsah objavuje v AI odpovediach, na meranie frekvencie citácií a pochopenie svojej viditeľnosti naprieč AI platformami.

AI odvetvie vyvinulo viacero rámcov na dokumentáciu a zverejňovanie správania systémov, ich prijatie však zostáva v praxi nekonzistentné. Modelové karty poskytujú štandardizovanú dokumentáciu výkonu strojového učenia, určených spôsobov použitia, obmedzení a analýzy zaujatostí — podobne ako výživové štítky pri potravinách. Datasheets for Datasets dokumentujú zloženie, metodológiu zberu a možné zaujatosti v tréningových dátach, čím reflektujú princíp, že AI systémy sú len také kvalitné, aké sú ich tréningové dáta. System Cards pristupujú širšie, dokumentujú správanie celého systému vrátane interakcie komponentov, možných zlyhaní a reálneho výkonu v rôznych skupinách používateľov. NTIA AI Accountability Policy odporúča, aby firmy viedli podrobnú dokumentáciu vývoja, testovania a nasadenia AI systémov s dôrazom na vysokorizikové aplikácie ovplyvňujúce verejné blaho. Zákon EÚ o AI nariaďuje, aby vysokorizikové AI systémy uchovávali technickú dokumentáciu, záznamy o tréningových dátach a výkonnostné logy, s povinnosťou zverejňovania správ o transparentnosti a informovaní používateľov. Medzi čoraz viac rozšírené odvetvové dobré praktiky patria:

Perplexity sa prezentuje ako najtransparentnejšia AI platforma v oblasti citácií, keďže zobrazuje inline odkazy na zdroje v rámci odpovedí a umožňuje používateľom presne vidieť, ktoré zdroje prispeli k jednotlivým tvrdeniam. Platforma poskytuje pomerne jasnú dokumentáciu svojho rebríčkovacieho prístupu, zdôrazňuje autoritu zdrojov, odborné znalosti a aktuálnosť obsahu, no presné váhovanie týchto faktorov zostáva obchodným tajomstvom. Google AI Overviews ponúka strednú transparentnosť tým, že uvádza citované zdroje na konci odpovedí, avšak poskytuje len málo vysvetlení, prečo boli niektoré zdroje vybrané a iné nie, resp. ako algoritmus rebríčkovania váži jednotlivé signály. Google v dokumentácii zdôrazňuje princípy E-E-A-T, no úplne nevysvetľuje, ako sa tieto merajú a vážia v AI procese rebríčkovania. OpenAI ChatGPT Search predstavuje kompromis, keďže zobrazuje zdroje oddelene od textu odpovede a umožňuje používateľom preklik na pôvodný obsah, no ponúka len minimálne vysvetlenie kritérií výberu zdrojov alebo metodiky rebríčkovania. Brave Leo uprednostňuje transparentnosť v oblasti ochrany súkromia, keďže používa zdroje rešpektujúce súkromie a nesleduje otázky používateľov, čo je však za cenu menej detailného vysvetlenia rebríčkovacích mechanizmov. Consensus vyniká zameraním výlučne na akademický výskum a vysokou transparentnosťou vďaka metrikám citácií, statusu recenzovania a ukazovateľom kvality štúdií — čím sa stáva najtransparentnejšou platformou pre výskumné otázky. Úroveň kontroly používateľa sa výrazne líši: Perplexity umožňuje filtrovanie zdrojov, Consensus umožňuje filtrovanie podľa typu a kvality štúdie, zatiaľ čo Google a ChatGPT ponúkajú minimálne možnosti prispôsobenia preferencií rebríčkovania. Rozdiely v prístupoch k transparentnosti odrážajú rôzne obchodné modely a cieľové skupiny — akademicky zamerané platformy kladú dôraz na zverejňovanie, zatiaľ čo spotrebiteľsky orientované platformy vyvažujú transparentnosť s ochranou obchodného tajomstva.

Dôvera a dôveryhodnosť zásadne závisia od toho, či používatelia chápu, ako sa k nim informácie dostali — ak AI systémy skrývajú svoje zdroje alebo logiku rebríčkovania, používatelia nemôžu nezávisle overiť tvrdenia ani posúdiť spoľahlivosť zdroja. Transparentnosť umožňuje overovanie a fact-checking, vďaka čomu môžu výskumníci, novinári a informovaní používatelia vystopovať tvrdenia k pôvodným zdrojom a posúdiť ich presnosť a kontext. Prevencia dezinformácií a zaujatostí je významným prínosom transparentnosti: ak sú algoritmy rebríčkovania viditeľné, výskumníci vedia identifikovať systematické zaujatosti (napr. uprednostňovanie určitých politických názorov alebo komerčných záujmov) a platformy možno brať na zodpovednosť za šírenie nepravdivých informácií. Algoritmická zodpovednosť je základným právom používateľov v demokratických spoločnostiach — každý má právo rozumieť, ako systémy ovplyvňujúce jeho informačné prostredie prijímajú rozhodnutia, najmä ak ovplyvňujú verejnú mienku, nákupné rozhodnutia a prístup k poznaniu. Pre výskum a akademickú prácu je transparentnosť nevyhnutná, pretože vedci potrebujú rozumieť výberu zdrojov, aby správne interpretovali AI-generované zhrnutia a nebudovali svoje závery na zaujatých alebo nekompletných súboroch zdrojov. Obchodné dôsledky pre tvorcov obsahu sú zásadné: bez pochopenia faktorov rebríčkovania nemôžu vydavatelia optimalizovať svoju obsahovú stratégiu, menší tvorcovia nemôžu férovo súťažiť s etablovanými médiami a celý ekosystém sa stáva menej meritokratickým. Transparentnosť zároveň chráni používateľov pred manipuláciou — ak sú kritériá skryté, zneužívateľné slabiny v systéme môžu umožniť šíriteľom dezinformácií propagovať zavádzajúci obsah, zatiaľ čo transparentné systémy možno auditovať a zlepšovať.

Regulačné trendy smerujú k povinnej transparentnosti: implementácia zákona EÚ o AI v rokoch 2025-2026 bude vyžadovať podrobnú dokumentáciu a zverejňovanie pre vysokorizikové AI systémy, pričom podobná regulácia vzniká v Spojenom kráľovstve, Kalifornii a ďalších jurisdikciách. Odvetvie sa uberá k štandardizácii transparentnosti, pričom organizácie ako Partnership on AI a akademické inštitúcie vyvíjajú spoločné rámce na dokumentáciu a zverejňovanie správania AI systémov. Dopyt používateľov po transparentnosti rastie s rastúcim povedomím o úlohe AI v distribúcii informácií — prieskumy ukazujú, že viac ako 70 % používateľov chce porozumieť, ako AI systémy vyberajú zdroje a zoraďujú informácie. Technologické inovácie v oblasti vysvetliteľnej AI (XAI) čoraz viac umožňujú poskytovať detailné vysvetlenia rozhodnutí o rebríčkovaní bez úplného odhalenia obchodných tajomstiev, a to pomocou techník ako LIME (Local Interpretable Model-agnostic Explanations) a SHAP (SHapley Additive exPlanations). Monitorovacie nástroje ako AmICited.com budú čoraz dôležitejšie, keď platformy implementujú opatrenia transparentnosti, čím pomôžu tvorcom obsahu a vydavateľom sledovať svoju viditeľnosť naprieč viacerými AI systémami a správne chápať vplyv zmien v rebríčkovaní na svoj dosah. Súbeh regulačných požiadaviek, očakávaní používateľov a technických možností naznačuje, že roky 2025-2026 budú pre transparentnosť AI rebríčkovania zlomové — platformy pravdepodobne prijmú viac štandardizovaných postupov zverejňovania, zavedú lepšiu kontrolu používateľov nad výberom zdrojov a poskytnú jasnejšie vysvetlenia logiky rebríčkovania. Budúca scéna bude pravdepodobne zahŕňať vrstvenú transparentnosť — akademické a výskumné platformy budú lídrami v zverejňovaní, spotrebiteľské platformy poskytnú strednú transparentnosť s možnosťou prispôsobenia pre používateľov a regulačná zhoda sa stane základným štandardom v celom odvetví.

Transparentnosť AI rebríčkovania označuje, do akej miery AI platformy otvorene zverejňujú svoje algoritmy na výber a zoraďovanie zdrojov vo vygenerovaných odpovediach. Je to dôležité, pretože používatelia potrebujú rozumieť dôveryhodnosti zdrojov, tvorcovia obsahu musia optimalizovať svoju viditeľnosť v AI a výskumníci overovať informačné zdroje. Bez transparentnosti môžu AI systémy zosilňovať dezinformácie a vytvárať neférové výhody pre etablované médiá oproti menším vydavateľom.

AI platformy používajú systémy Retrieval-Augmented Generation (RAG), ktoré kombinujú jazykové modely s vyhľadávaním informácií v reálnom čase. Zdroje zoraďujú podľa faktorov ako autorita domény, aktuálnosť obsahu, tematická relevantnosť, signály angažovanosti a frekvencia citácií. Presné váhovanie týchto faktorov však väčšina platforiem stále považuje za obchodné tajomstvo a nezverejňuje ho.

Tradičné SEO sa zameriava na poradie v zoznamoch odkazov vo vyhľadávači, kde Google zverejňuje všeobecné faktory rebríčkovania. Transparentnosť AI rebríčkovania sa týka spôsobu, akým AI platformy vyberajú zdroje pre syntetizované odpovede, čo zahŕňa iné kritériá a väčšinou nie je zverejňované. Zatiaľ čo SEO stratégie sú dobre zdokumentované, faktory rebríčkovania AI zostávajú väčšinou nejasné.

Môžete kliknúť na originálne zdroje a overiť tvrdenia v ich plnom kontexte, skontrolovať, či pochádzajú z autoritatívnych domén, zisťovať status recenzovania (najmä pri akademickom obsahu) a porovnávať informácie naprieč viacerými zdrojmi. Nástroje ako AmICited pomáhajú sledovať, ktoré zdroje sa objavujú v AI odpovediach a ako často je váš obsah citovaný.

Consensus je lídrom v transparentnosti, pretože sa zameriava výlučne na recenzovaný akademický výskum s jasnými metrikami citácií. Perplexity poskytuje inline citácie zdrojov a miernu dokumentáciu faktorov rebríčkovania. Google AI Overviews ponúka strednú transparentnosť, zatiaľ čo ChatGPT Search a Brave Leo poskytujú len obmedzené informácie o svojich rebríčkovacích algoritmoch.

Modelové karty sú štandardizovaná dokumentácia výkonu AI systému, určených použití, obmedzení a analýzy zaujatostí. Datasheets dokumentujú zloženie tréningových dát, metódy zberu a možné zaujatosti. Systémové karty popisujú správanie celého systému. Tieto nástroje robia AI systémy transparentnejšími a porovnateľnejšími, podobne ako nutričné štítky pri potravinách.

Zákon EÚ o AI vyžaduje, aby vysokorizikové AI systémy viedli podrobnú technickú dokumentáciu, záznamy o tréningových dátach a výkonnostné logy. Nariaďuje transparentné správy a informovanie používateľov o použití AI systému. Tieto požiadavky nútia AI platformy k väčšiemu zverejňovaniu mechanizmov rebríčkovania a kritérií výberu zdrojov.

AmICited.com je platforma na monitorovanie AI citácií, ktorá sleduje, ako systémy ako Perplexity, Google AI Overviews a ChatGPT citujú vašu značku a obsah. Poskytuje prehľad o tom, ktoré zdroje sa objavujú v AI odpovediach, ako často je váš obsah citovaný a aká je vaša transparentnosť rebríčkovania v rôznych AI platformách.

Sledujte, ako AI platformy ako Perplexity, Google AI Overviews a ChatGPT uvádzajú váš obsah. Pochopte svoju transparentnosť rebríčkovania a optimalizujte svoju viditeľnosť naprieč AI vyhľadávačmi s AmICited.

Naučte sa zásadné najlepšie postupy pre transparentnosť a zverejňovanie AI. Objavte správanie, verbálne a technické metódy zverejňovania na budovanie dôvery a z...

Objavte skryté náklady neviditeľnosti v AI pre značky. Zistite, prečo záleží na zmienkach v ChatGPT, ako merať stratu viditeľnosti a 8 taktík, ako získať späť p...

Zistite, čo znamenajú skóre čitateľnosti pre viditeľnosť vo vyhľadávaní cez AI. Objavte, ako Flesch-Kincaid, štruktúra viet a formátovanie obsahu ovplyvňujú cit...

Súhlas s cookies

Používame cookies na vylepšenie vášho prehliadania a analýzu našej návštevnosti. See our privacy policy.