Den kompletta guiden till att blockera (eller tillåta) AI-crawlers

Lär dig hur du blockerar eller tillåter AI-crawlers som GPTBot och ClaudeBot med robots.txt, serverbaserad blockering och avancerade skyddsmetoder. Komplett tek...

Lär dig hur du granskar AI-crawlers åtkomst till din webbplats. Upptäck vilka botar som kan se ditt innehåll och åtgärda hinder som förhindrar AI-synlighet i ChatGPT, Perplexity och andra AI-sökmotorer.

Sök- och innehållslandskapet förändras dramatiskt. Med AI-drivna sökverktyg som ChatGPT, Perplexity och Google AI Overviews som växer exponentiellt, har din synlighet för AI-crawlers blivit minst lika viktig som traditionell sökmotoroptimering. Om AI-botar inte kan nå ditt innehåll blir din webbplats osynlig för miljontals användare som förlitar sig på dessa plattformar för svar. Insatserna är högre än någonsin: medan Google kan återbesöka din sida om något går fel, arbetar AI-crawlers enligt ett annat paradigm—och att missa den första avgörande crawlen kan innebära månader av förlorad synlighet och missade möjligheter till citeringar, trafik och varumärkesauktoritet.

AI-crawlers arbetar enligt fundamentalt andra regler än de Google- och Bing-botar du optimerat för genom åren. Den mest avgörande skillnaden: AI-crawlers renderar inte JavaScript, vilket innebär att dynamiskt innehåll som laddas via klientsideskript är osynligt för dem—en tydlig kontrast mot Googles avancerade renderingsmöjligheter. Dessutom besöker AI-crawlers webbplatser med dramatiskt högre frekvens, ibland 100 gånger oftare än traditionella sökmotorer, vilket skapar både möjligheter och utmaningar för serverresurser. Till skillnad från Googles indexeringsmodell behåller AI-crawlers inget beständigt index som uppdateras; istället crawlar de vid behov när användare ställer frågor till deras system. Det innebär att det inte finns någon re-indexeringskö, ingen Search Console för att begära omcrawling, och inga andra chanser om din webbplats misslyckas vid första intrycket. Att förstå dessa skillnader är avgörande för att optimera din innehållsstrategi.

| Funktion | AI-Crawlers | Traditionella Botar |

|---|---|---|

| JavaScript-rendering | Nej (endast statisk HTML) | Ja (full rendering) |

| Crawl-frekvens | Mycket hög (100x+ oftare) | Måttlig (veckovis/månadsvis) |

| Re-indexeringsmöjlighet | Ingen (endast vid behov) | Ja (kontinuerliga uppdateringar) |

| Innehållskrav | Ren HTML, schemamarkering | Flexibel (hanterar dynamiskt innehåll) |

| User-Agent-blockering | Specifik per bot (GPTBot, ClaudeBot, etc.) | Generisk (Googlebot, Bingbot) |

| Cache-strategi | Korttidssnapshots | Långsiktig indexunderhåll |

Ditt innehåll kan vara osynligt för AI-crawlers av orsaker du aldrig övervägt. Här är de främsta hindren som förhindrar AI-botar från att få tillgång till och förstå ditt innehåll:

Din robots.txt-fil är det främsta verktyget för att styra vilka AI-botar som får tillgång till ditt innehåll, och den fungerar genom specifika User-Agent-regler som riktar sig mot individuella crawlers. Varje AI-plattform använder unika user-agent-strängar—OpenAI:s GPTBot, Anthropics ClaudeBot, Perplexitys PerplexityBot—och du kan tillåta eller blockera var och en oberoende. Denna detaljerade kontroll gör att du kan bestämma vilka AI-system som får träna på eller citera ditt innehåll, vilket är avgörande för att skydda företagshemligheter eller hantera konkurrensrisker. Många webbplatser blockerar dock omedvetet AI-crawlers genom alltför breda regler som utformades för äldre botar, eller så misslyckas de med att implementera rätt regler överhuvudtaget.

Här är ett exempel på hur du konfigurerar din robots.txt för olika AI-botar:

# Tillåt OpenAI:s GPTBot

User-agent: GPTBot

Allow: /

# Blockera Anthropics ClaudeBot

User-agent: ClaudeBot

Disallow: /

# Tillåt Perplexity men begränsa vissa kataloger

User-agent: PerplexityBot

Allow: /

Disallow: /private/

Disallow: /admin/

# Standardregel för alla andra botar

User-agent: *

Allow: /

Till skillnad från Google, som kontinuerligt crawlar och re-indexerar din webbplats, arbetar AI-crawlers enligt principen en chans—de besöker när en användare skickar en förfrågan, och om ditt innehåll inte är tillgängligt just då har du förlorat möjligheten. Denna grundläggande skillnad innebär att din webbplats måste vara tekniskt redo från dag ett; det finns ingen respit, ingen andra chans att åtgärda problem innan synligheten försämras. En dålig första crawlupplevelse—oavsett om det beror på JavaScript-renderingsfel, saknad schemamarkering eller serverfel—kan leda till att ditt innehåll utesluts från AI-genererade svar i veckor eller månader. Det finns ingen manuell re-indexeringsmöjlighet, ingen “Begär indexering”-knapp i en konsol, vilket gör proaktiv övervakning och optimering helt nödvändigt. Pressen att lyckas vid första försöket har aldrig varit större.

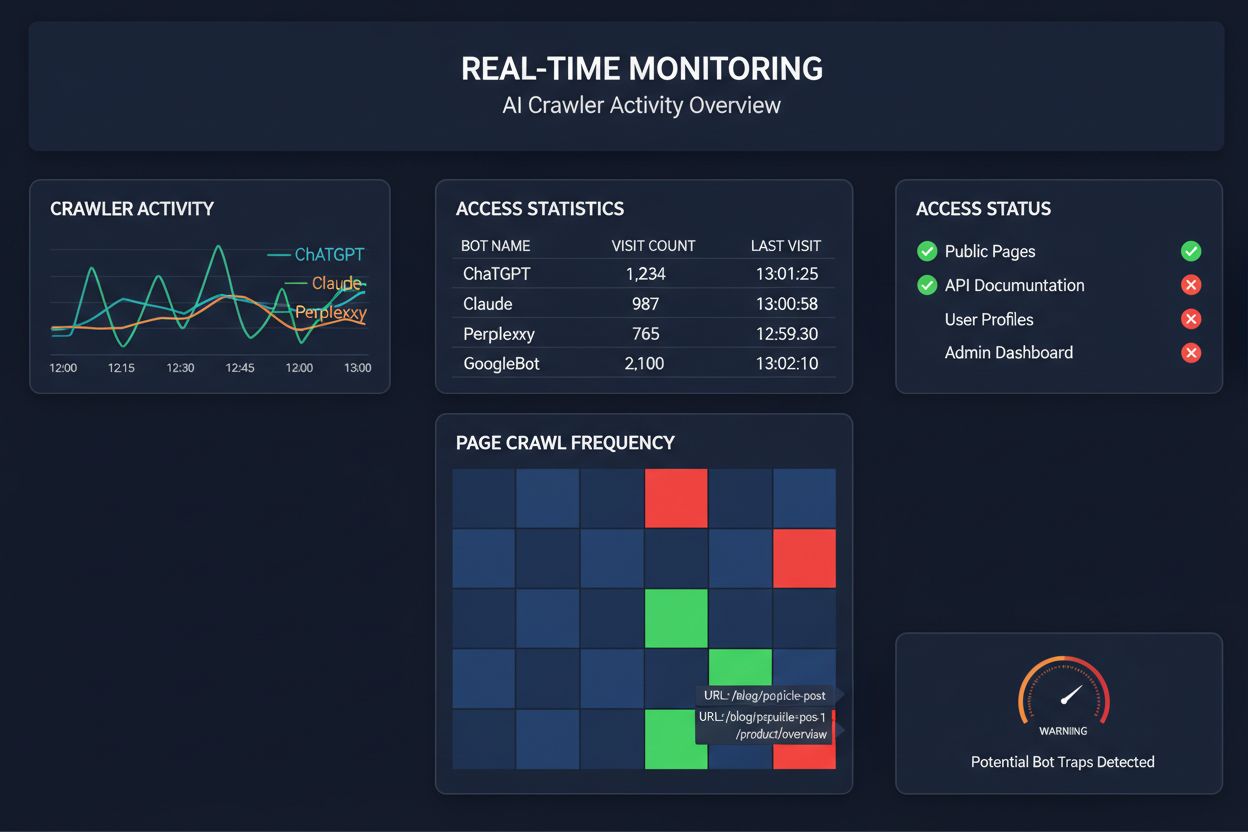

Att förlita sig på schemalagda crawls för att övervaka AI-crawleråtkomst är som att kontrollera huset för bränder en gång i månaden—du missar de kritiska ögonblicken när problemen uppstår. Realtidsövervakning upptäcker problem i samma stund de sker, vilket gör att du kan agera innan ditt innehåll blir osynligt för AI-system. Schemalagda granskningar, som vanligtvis körs veckovis eller månadsvis, skapar farliga blinda fläckar där din webbplats kan vara otillgänglig för AI-crawlers i flera dagar utan att du vet om det. Realtidslösningar spårar crawlerbeteende kontinuerligt, varnar dig för JavaScript-renderingsfel, schemamarkeringsproblem, brandväggsblockeringar eller serverproblem i realtid. Detta proaktiva tillvägagångssätt förvandlar din granskning från en reaktiv efterlevnadskontroll till en aktiv synlighetshanteringsstrategi. Med AI-crawlertrafik som potentiellt är 100 gånger högre än för traditionella sökmotorer kan det bli kostsamt att missa bara några timmars tillgänglighet.

Flera plattformar erbjuder nu specialiserade verktyg för övervakning och optimering av AI-crawleråtkomst. Cloudflare AI Crawl Control ger infrastruktur-nivåhantering av AI-bottrafik, så att du kan sätta gränser och åtkomstpolicyer. Conductor erbjuder omfattande övervakningspaneler som spårar hur olika AI-crawlers interagerar med ditt innehåll. Elementive fokuserar på tekniska SEO-granskningar med särskild uppmärksamhet på AI-crawlerkrav. AdAmigo och MRS Digital tillhandahåller specialiserad rådgivning och övervakning för AI-synlighet. Men för kontinuerlig, realtidsövervakning särskilt utformad för att spåra AI-crawlermönster och varna dig för problem innan de påverkar synligheten, utmärker sig AmICited som en dedikerad lösning. AmICited är specialiserad på att övervaka vilka AI-system som besöker ditt innehåll, hur ofta de crawlar och om de stöter på tekniska hinder. Detta specialiserade fokus på AI-crawlerbeteende—snarare än traditionella SEO-mått—gör det till ett oumbärligt verktyg för organisationer som tar AI-synlighet på allvar.

Att genomföra en omfattande AI-crawlergranskning kräver ett systematiskt tillvägagångssätt. Steg 1: Skapa en grund genom att kontrollera din nuvarande robots.txt-fil och identifiera vilka AI-botar du tillåter eller blockerar. Steg 2: Granska din tekniska infrastruktur genom att testa din webbplats tillgänglighet för crawlers utan JavaScript, kontrollera serverns svarstider och säkerställa att kritiskt innehåll levereras i statisk HTML. Steg 3: Implementera och validera schemamarkering över ditt innehåll, och se till att författarskap, publiceringsdatum, innehållstyp och annan metadata är korrekt strukturerad i JSON-LD-format. Steg 4: Övervaka crawlerbeteende med verktyg som AmICited för att spåra vilka AI-botar som besöker din webbplats, hur ofta och om de stöter på fel. Steg 5: Analysera resultat genom att granska crawlloggar, identifiera mönster i fel och prioritera åtgärder utifrån påverkan. Steg 6: Åtgärda problem med start från de mest kritiska, som JavaScript-renderingsproblem eller saknad schema, och gå vidare till sekundära optimeringar. Steg 7: Etablera kontinuerlig övervakning för att fånga nya problem innan de påverkar synligheten, och sätt upp varningar för crawl-fel eller åtkomstblockeringar.

Du behöver inte göra en total omstrukturering för att förbättra AI-crawleråtkomsten—flera åtgärder med stor effekt kan genomföras snabbt. Servera kritiskt innehåll i ren HTML istället för att förlita dig på JavaScript-rendering; om du måste använda JavaScript, se till att viktig text och metadata även finns i HTML:n från början. Lägg till omfattande schemamarkering med JSON-LD-format, inklusive artikel-schema, författarinformation, publiceringsdatum och innehållsrelationer—detta hjälper AI-crawlers att förstå kontext och korrekt attribuera innehåll. Säkerställ tydlig författarinformation via schema och byline, eftersom AI-system allt mer prioriterar att citera auktoritativa källor. Övervaka och optimera Core Web Vitals (Largest Contentful Paint, First Input Delay, Cumulative Layout Shift) eftersom sidor som laddar långsamt kan överges av crawlers innan de är färdiga. Granska och uppdatera din robots.txt så att du inte av misstag blockerar AI-botar du vill ska nå ditt innehåll. Åtgärda tekniska problem som omdirigeringskedjor, trasiga länkar och serverfel som kan få crawlers att överge din sida mitt i en crawl.

Alla AI-crawlers har inte samma syfte, och att förstå dessa skillnader hjälper dig att fatta informerade beslut kring åtkomstkontroll. GPTBot (OpenAI) används främst för insamling av träningsdata och förbättring av modellernas förmågor, vilket är relevant om du vill att ditt innehåll ska påverka ChatGPT:s svar. OAI-SearchBot (OpenAI) crawlar specifikt för sökciteringssyfte, vilket innebär att det är boten som ansvarar för att inkludera ditt innehåll i ChatGPT:s sökintegrerade svar. ClaudeBot (Anthropic) fyller liknande funktioner för Claude, Anthropics AI-assistent. PerplexityBot (Perplexity) crawlar för citering i Perplexitys AI-drivna sökmotor, som har blivit en viktig trafikkälla för många publicister. Varje bot har olika crawlmönster, frekvens och syften—vissa fokuserar på träningsdata, andra på realtidsciteringar. Att avgöra vilka botar du ska tillåta eller blockera bör anpassas efter din innehållsstrategi: om du vill bli citerad i AI-sökresultat, tillåt sökspecifika botar; om du oroar dig för användning i träningsdata kan du blockera datainsamlingsbotar men tillåta sökbotar. Detta nyanserade sätt att hantera botar är betydligt mer sofistikerat än det traditionella “tillåt alla” eller “blockera alla”-tänket.

En AI-crawlergranskning är en omfattande bedömning av din webbplats tillgänglighet för AI-botar som ChatGPT, Claude och Perplexity. Den identifierar tekniska hinder, problem med JavaScript-rendering, saknad schemamarkering och andra faktorer som förhindrar AI-crawlers från att få tillgång till och förstå ditt innehåll. Granskningen ger handlingsbara rekommendationer för att förbättra din synlighet i AI-drivna sök- och svarsmotorer.

Vi rekommenderar att du genomför en omfattande granskning minst kvartalsvis, eller när du gör betydande förändringar i din webbplats tekniska infrastruktur, innehållsstruktur eller robots.txt-fil. Dock är kontinuerlig övervakning i realtid idealiskt för att fånga problem direkt när de uppstår. Många organisationer använder automatiserade övervakningsverktyg som varnar dem för crawlerfel i realtid, kompletterat med djupgående kvartalsvisa granskningar.

Att tillåta AI-crawlers innebär att ditt innehåll kan nås, analyseras och potentiellt citeras av AI-system, vilket kan öka din synlighet i AI-genererade svar och rekommendationer. Att blockera AI-crawlers hindrar dem från att nå ditt innehåll, vilket skyddar företagshemligheter men kan minska din synlighet i AI-sökresultat. Rätt val beror på dina affärsmål, innehållets känslighet och konkurrenssituation.

Ja, absolut. Din robots.txt-fil möjliggör detaljerad kontroll via User-Agent-regler. Du kan blockera GPTBot och samtidigt tillåta PerplexityBot, eller tillåta sökfokuserade botar (som OAI-SearchBot) men blockera datainsamlingsbotar (som GPTBot). Denna nyanserade strategi gör att du kan optimera din innehållsstrategi utifrån vilka AI-plattformar som är viktigast för din verksamhet.

Om AI-crawlers inte kan nå ditt innehåll betyder det att din webbplats i praktiken är osynlig för AI-drivna sökmotorer och svarsplattformar. Ditt innehåll kommer inte att citeras, rekommenderas eller inkluderas i AI-genererade svar, även om det är mycket relevant. Detta kan leda till förlorad trafik, minskad varumärkessynlighet och missade möjligheter att etablera auktoritet i AI-sökresultat.

Du kan kontrollera dina serverloggar efter User-Agent-strängar från kända AI-crawlers (GPTBot, ClaudeBot, PerplexityBot, etc.), eller använda specialiserade övervakningsverktyg som AmICited som spårar AI-crawler-aktivitet i realtid. Dessa verktyg visar vilka botar som besöker din webbplats, hur ofta de crawlar, vilka sidor de besöker och om de stöter på några fel eller blockeringar.

Detta beror på din specifika situation. Om ditt innehåll är företagshemligt, känsligt eller du är orolig för användning i träningsdata, kan blockering vara lämpligt. Men om du vill synas i AI-sökresultat och bli citerad av AI-system, är det avgörande att tillåta crawlers. Många organisationer väljer en mellanväg: tillåter sökfokuserade botar som ger citeringar men blockerar datainsamlingsbotar.

AI-crawlers renderar inte JavaScript, vilket innebär att allt innehåll som laddas dynamiskt via klientsideskript är osynligt för dem. Om din webbplats är beroende av JavaScript för viktigt innehåll, navigation eller strukturerad data, kommer AI-crawlers endast att se den råa HTML-koden och missa viktig information. Detta kan kraftigt påverka hur ditt innehåll förstås och representeras i AI-svar. Att leverera kritiskt innehåll i statisk HTML är avgörande för AI-crawlbarhet.

Få insikter i realtid om vilka AI-botar som besöker ditt innehåll och hur de ser din webbplats. Starta din kostnadsfria granskning idag och säkerställ att ditt varumärke är synligt på alla AI-söksplattformar.

Lär dig hur du blockerar eller tillåter AI-crawlers som GPTBot och ClaudeBot med robots.txt, serverbaserad blockering och avancerade skyddsmetoder. Komplett tek...

Lär dig hur du spårar och övervakar AI-crawlers aktivitet på din webbplats med hjälp av serverloggar, verktyg och bästa praxis. Identifiera GPTBot, ClaudeBot oc...

Lär dig identifiera och övervaka AI-crawlers som GPTBot, ClaudeBot och PerplexityBot i dina serverloggar. Komplett guide med user-agent-strängar, IP-verifiering...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.