Vad är Multimodalt Innehåll för AI? Definition och Exempel

Lär dig vad multimodalt innehåll för AI är, hur det fungerar och varför det är viktigt. Utforska exempel på multimodala AI-system och deras tillämpningar inom o...

Lär dig hur du optimerar text, bilder och video för multimodala AI-system. Upptäck strategier för att förbättra AI-citeringar och synlighet i ChatGPT, Gemini och Perplexity.

Multimodal AI representerar ett grundläggande skifte i hur artificiella intelligenssystem bearbetar och förstår information. Till skillnad från unimodala system som hanterar endast text, bilder eller video separat, integrerar multimodal AI flera datatyper samtidigt för att skapa en mer heltäckande förståelse av komplex information. Detta återspeglar hur människor naturligt bearbetar världen—vi separerar inte vad vi ser från vad vi hör eller läser, utan syntetiserar alla intryck tillsammans. Marknaden för multimodal AI, värderad till 1,6 miljarder dollar år 2024, upplever explosiv tillväxt med en årlig tillväxttakt (CAGR) på 32,7 %, vilket speglar teknikens avgörande betydelse för företags AI-strategier. Branschanalytiker förutspår att 40 % av alla generativa AI-lösningar kommer att vara multimodala år 2027, enligt Gartner. Denna övergång är inte bara gradvis, utan representerar ett paradigmskifte i hur organisationer utnyttjar AI för konkurrensfördelar. Konvergensen av text-, bild- och videobearbetning gör det möjligt för AI-system att leverera insikter och kapaciteter som tidigare varit omöjliga med enskilda modaliteter.

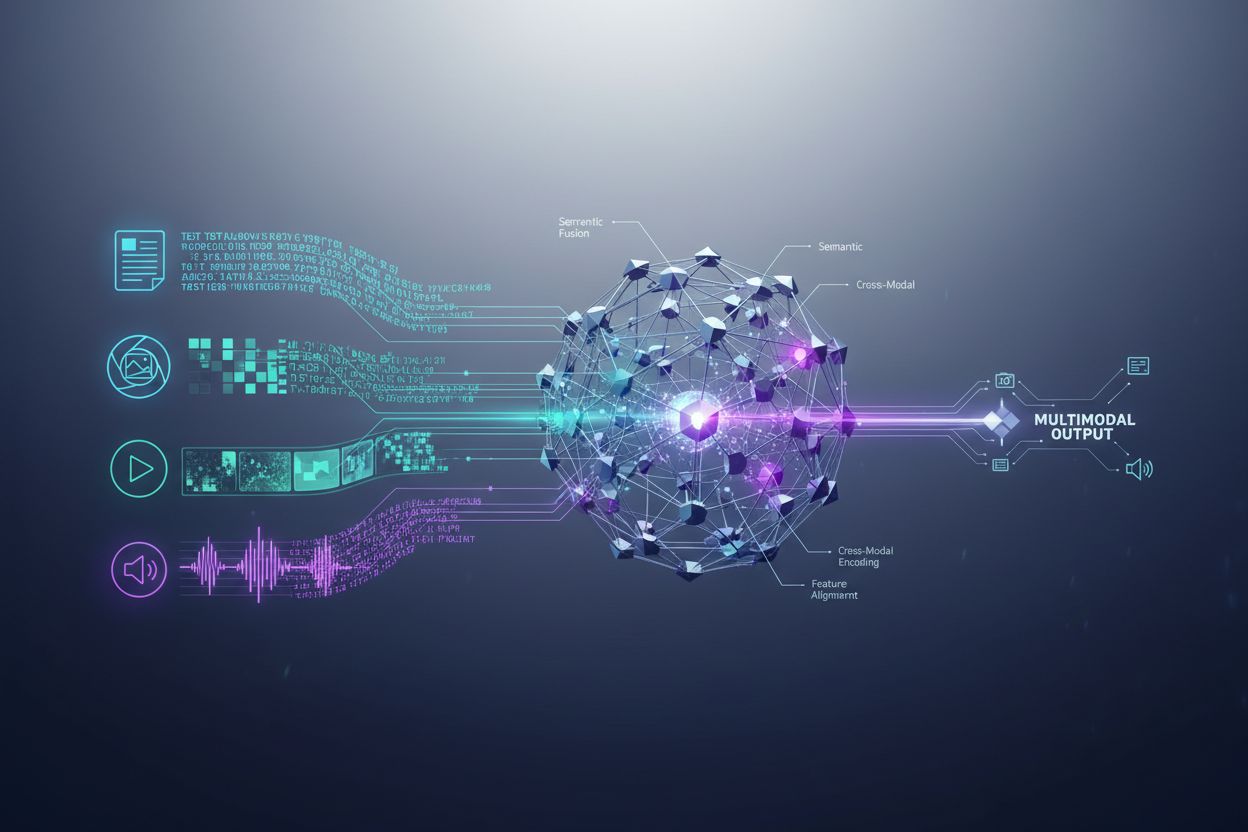

Multimodala AI-system använder sofistikerade arkitektoniska komponenter för att hantera olika datainflöden sömlöst. Encoders är specialiserade neurala nätverk som omvandlar varje datatyp—text, bilder och video—till en enhetlig numerisk representation kallad embeddings. Dessa embeddings fångar den semantiska betydelsen i varje modalitet i ett gemensamt matematiskt rum, vilket gör det möjligt för systemet att jämföra och relatera information över olika innehållstyper. Fusionsmekanismen kombinerar sedan dessa embeddings, antingen genom sammanslagning, addition eller mer avancerade inlärda fusionstekniker som avgör hur mycket vikt varje modalitet ska ge till slutresultatet. Cross-attention-mekanismer gör det möjligt för modellen att dynamiskt fokusera på relevant information över modaliteter; till exempel, när ett produktfoto analyseras tillsammans med tillhörande text, kan systemet uppmärksamma specifika visuella detaljer som motsvarar textbeskrivningen. Denna flerstegsprocess gör att multimodala system kan uppnå kontextuell förståelse som system med enbart en modalitet inte kan replikera. Tabellen nedan visar skillnader i kapacitet:

| Kapacitet | Unimodal AI | Multimodal AI |

|---|---|---|

| Textanalys | Utmärkt | Utmärkt |

| Bildförståelse | Begränsad/Ingen | Utmärkt |

| Videobearbetning | Begränsad/Ingen | Utmärkt |

| Korsmodal resonemang | Ej möjligt | Utmärkt |

| Kontextintegration | En källa | Flera källor |

| Noggrannhet i verkligheten | 60–75 % | 85–95 % |

| Bearbetningshastighet | Snabb | Optimerat snabbt |

Det multimodala AI-landskapet domineras av flera kraftfulla plattformar som satt nya standarder för integrerad bearbetning. GPT-4o från OpenAI är en flaggskeppsmodell för multimodal AI som sömlöst hanterar text, bilder och video med inbyggd integration över alla modaliteter. Google Gemini erbjuder multimodala funktioner i företagsklass med särskild styrka i att förstå komplexa visuella dokument och långformade videor. Claude från Anthropic ger sofistikerat multimodalt resonemang med fokus på noggrannhet och nyanserad förståelse över text- och bildinmatningar. Metas ImageBind-teknik visar på en annan arkitektonisk väg och skapar ett enhetligt embeddingutrymme över sex modaliteter inklusive text, bild, ljud, djup, termisk och IMU-data. Dessa plattformar representerar det främsta inom multimodal teknik, var och en med egna arkitektoniska innovationer och optimeringsstrategier. Organisationer som väljer multimodala plattformar måste inte bara utvärdera kapacitetsbredd, utan även prestandaoptimering, kostnadseffektivitet och integration med befintliga arbetsflöden.

Multimodal AI omvandlar verksamheter i nästan alla branscher och ger märkbara förbättringar i effektivitet, noggrannhet och kundupplevelse. Organisationer som implementerat tekniken rapporterar anmärkningsvärda resultat:

Hälso- och sjukvård: Radiologer använder multimodal AI för att analysera medicinska bilder tillsammans med patientjournaler och kliniska anteckningar, vilket förbättrar diagnostisk träffsäkerhet och minskar analystiden med upp till 40 %. AI-system kan korrelera visuella fynd med textbaserad medicinsk historik för att identifiera mönster som människor kan missa.

Detaljhandel: Mode- och e-handelsföretag använder multimodal AI för att matcha kundbeskrivningar med visuellt lager, vilket möjliggör “sök efter beskrivning” och höjer konverteringsgraden. Produktrekommendationer förbättras avsevärt när AI förstår både visuella preferenser och textåterkoppling.

Tillverkning: Kvalitetskontrollen går mycket snabbare med multimodala inspektionssystem som kombinerar visuell defektdetektion med sensordata och underhållsloggar, vilket ger 100x snabbare katalogisering av produktionsproblem jämfört med manuella processer.

Innehållsskapande: Medieföretag använder multimodal AI för att automatiskt generera bildtexter, transkriptioner och metadata för videoinnehåll, där 72 % av mediachefer med generativ AI rapporterar positiv ROI på sina investeringar.

Kundtjänst: Chattbottar med multimodala funktioner kan bearbeta kundbilder av problem tillsammans med textbeskrivningar för att erbjuda mer exakta och kontextuella supportlösningar.

Jordbruk: Bönder använder multimodala system som analyserar grödbilder, väderdata och markgivarsignaler för att optimera bevattning, gödsling och bekämpning.

Robotik: Autonoma system använder multimodal perception för att navigera i komplexa miljöer, där visuell input kombineras med ljudsignaler och taktil återkoppling för säkrare, intelligentare drift.

För att maximera effekten av multimodala AI-system krävs medvetna optimeringsstrategier för text som förbättrar maskinläsbarheten och kontextförståelsen. Strukturerad data-markup med schema.org-standarder hjälper AI-system att förstå semantiska relationer i ditt innehåll och möjliggör mer exakta korsmodala kopplingar. Att använda konversationston istället för strikt formell prosa gör att multimodala system bättre kan förstå intention och sammanhang, särskilt när text behandlas tillsammans med bilder eller video. Beskrivande rubriker och underrubriker tjänar dubbla syften: de vägleder både mänskliga läsare och ger viktiga strukturella signaler som hjälper AI-system att organisera och prioritera information. Att inkludera relevanta nyckelord i naturliga sammanhang—istället för tvingad överanvändning—säkerställer att texten stämmer överens med hur multimodala system identifierar ämnesrelationer mellan modaliteter. Metadataoptimering, inklusive titeltaggar, metabeskrivningar och strukturerade dataattribut, ger explicita signaler om innehållets betydelse som multimodala system kan använda. Organisationer bör även överväga hur text kompletterar visuellt innehåll; bildtexter och alt-text är inte bara tillgänglighetsfunktioner—de är avgörande optimeringselement som gör att multimodal AI förstår relationen mellan text och bild.

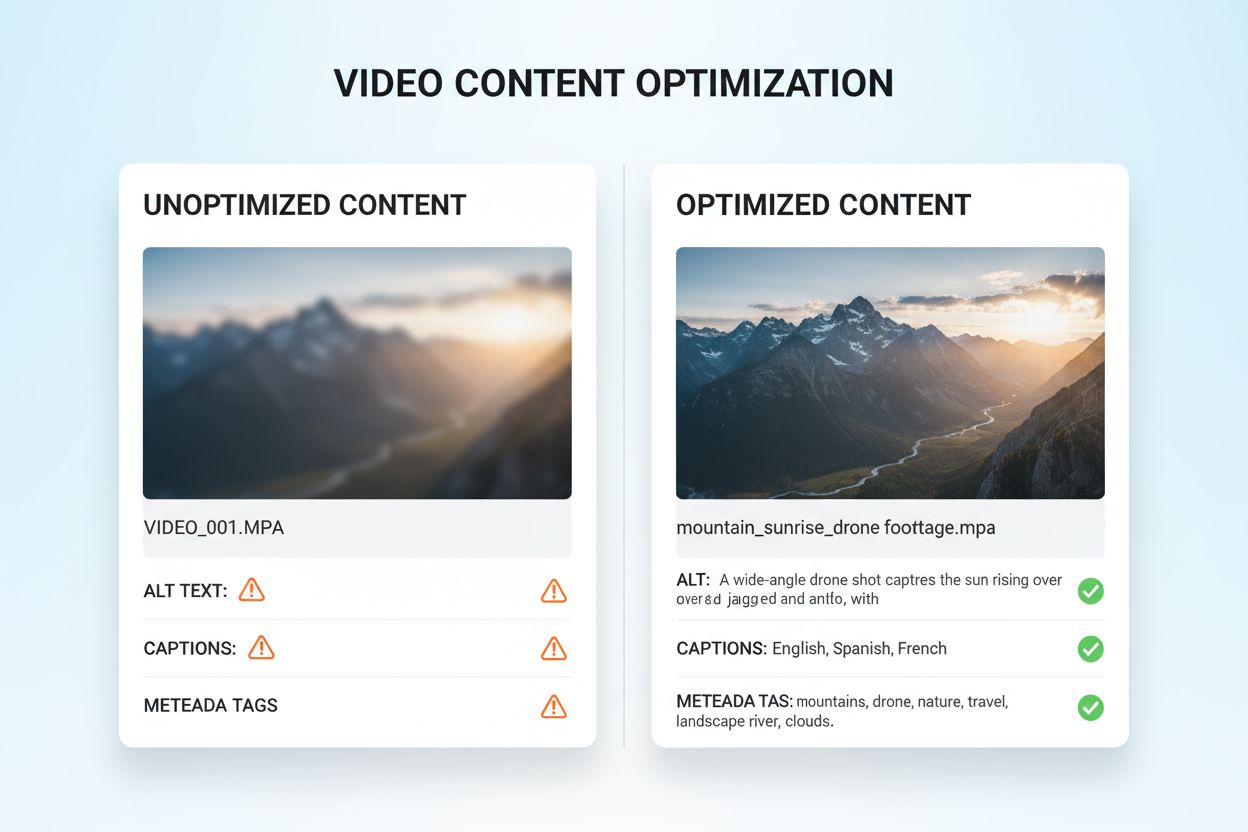

Optimering av visuellt och videoinnehåll för multimodal AI kräver ett helhetsgrepp som går långt utöver traditionell SEO. Beskrivande alt-text är grundläggande; istället för generiska beskrivningar bör alt-texten fånga den semantiska betydelsen, kontexten och viktiga detaljer som hjälper AI-system att förstå bildens innehåll. Filnamnskonventioner är viktiga—beskrivande filnamn som “produkt-jämförelsetabell-2024.jpg” ger avgörande kontext som AI-system använder för att förstå syftet med innehållet. Videotexter och transkriptioner är centrala optimeringselement; de gör att multimodala system kan korrelera talat innehåll med visuella element och avsevärt förbättra förståelsen av komplext videomaterial. Metadatafält som titel, beskrivning och taggar bör fyllas i med noggrannhet och specifikhet eftersom dessa direkt påverkar hur AI-system kategoriserar och relaterar visuellt innehåll till andra modaliteter. Bildkomprimering och teknisk optimering säkerställer att visuell kvalitet är tillräckligt hög för AI-analys samtidigt som snabba laddningstider bibehålls. Strukturerad data för visuellt innehåll, inklusive markup för bilder, videor och mediagallerier, ger explicita signaler om innehållsrelationer. Organisationer bör också överväga tidsmetadata för videoinnehåll—att markera nyckelmoment, scenbyten och ämnesövergångar hjälper multimodala system att förstå narrativ struktur och extrahera relevanta segment.

Multimodala AI-system använder två huvudsakliga arkitektoniska tillvägagångssätt, var och en med sina fördelar och kompromisser. Enhetliga arkitekturer bearbetar alla modaliteter genom ett enda, integrerat neuralt nätverk som lär sig gemensamma representationer från början. Detta tillvägagångssätt ger vanligtvis överlägset korsmodal resonemang eftersom systemet utvecklar djup förståelse för hur modaliteter relaterar till varandra, men kräver mer beräkningsresurser och längre träningstid. Modulära arkitekturer har separata specialnätverk för varje modalitet och kombinerar deras utdata via fusionsmekanismer. Detta ger större flexibilitet, vilket gör det möjligt att byta ut enskilda modalitetsprocessorer utan att träna om hela systemet, och kräver ofta färre beräkningsresurser. Mixture of Experts (MoE)-modeller är ett framväxande hybridalternativ där olika expertnätverk specialiserar sig på olika modaliteter eller uppgifter och en styrningsmekanism vidarebefordrar indata till rätt expert. Denna arkitektur ger effektivitetsvinster på 30–50 % jämfört med täta enhetliga modeller, med bibehållen jämförbar noggrannhet. Valet mellan dessa arkitekturer beror på användningsområdet: enhetliga arkitekturer utmärker sig vid komplexa resonemangsuppgifter som kräver djup korsmodal förståelse, medan modulära lösningar passar där flexibilitet och resurseffektivitet är viktigare.

Effektiv implementering av multimodal AI kräver robusta mätmetoder som följer både teknisk prestanda och affärseffekt. Nyckeltal (KPI:er) bör inkludera noggrannhetsmått för varje modalitet, kvalitet på korsmodal resonemang, processtid och kostnad per inferens. Analysplattformar bör mäta hur multimodal AI påverkar affärsresultat: konverteringsgrad i detaljhandel, diagnostisk träffsäkerhet i vården, produktionseffektivitet i tillverkning. Organisationer måste implementera attributionstracking för att förstå vilken modalitet som bidrar mest till specifika utfall—denna insikt styr optimeringsinsatser och resursfördelning. ROI-mätning bör inkludera både direkta kostnadsbesparingar (som 100x snabbare katalogisering i tillverkning) och indirekta fördelar som ökad kundnöjdhet eller minskade fel. Övervakningsverktyg bör följa modellprestanda över tid, eftersom verkliga dataskiften kan minska noggrannheten i multimodala system om de inte hanteras aktivt. För organisationer som använder AI-genererat innehåll och insikter blir citerings- och attributionstracking allt viktigare; verktyg som AmICited.com hjälper till att övervaka hur AI-system citerar källor och attribuerar information, vilket ger insyn i AI-beslut och säkerställer efterlevnad av krav på innehållsursprung. Regelbundna prestandaöversyner och optimeringscykler säkerställer att multimodala system fortsätter skapa värde när affärsbehov och datamönster förändras.

Det multimodala AI-landskapet utvecklas snabbt, med flera omvälvande trender som förändrar hur organisationer utnyttjar tekniken. Röstintegration är nästa steg, där systemen allt oftare kombinerar ljudinput med visuella och textuella data och möjliggör verkligt heltäckande förståelse av mänsklig kommunikation och miljö. Agentisk AI—AI-agenter som självständigt kan planera och utföra flerstegsuppgifter—kommer att utnyttja multimodal perception för att navigera i komplexa verkliga situationer, från autonoma fordon till robotiserad processautomatisering i företag. Realtidsbearbetning utvecklas snabbt och gör det möjligt att analysera livevideoströmmar, ljudflöden och sensordata samtidigt, vilket öppnar för omedelbart beslutsfattande i tidskritiska tillämpningar. Effektivitetsvinster genom tekniker som distillation och kvantisering kommer att göra sofistikerade multimodala funktioner tillgängliga även för organisationer med begränsade beräkningsresurser och demokratisera tillgången till avancerad AI. Specialiserade domänmodeller kommer att växa fram, där multimodala system finjusteras för branscher som sjukvård, juridik eller finans, med överlägsen prestanda jämfört med allmänna modeller. Dessa trender pekar mot att multimodal AI kommer att gå från konkurrensfördel till ett grundläggande krav för organisationer som vill förbli relevanta i en allt mer AI-drivna värld. De som redan idag börjar optimera sitt innehåll och sina processer för multimodal AI kommer att stå bäst rustade att dra nytta av morgondagens möjligheter.

Multimodal AI bearbetar flera datatyper (text, bilder, ljud, video) samtidigt, medan traditionell unimodal AI hanterar endast en typ. Detta möjliggör rikare kontextförståelse och mer exakta resultat. Multimodala system kan förstå relationer mellan olika modaliteter och leverera insikter som system med enbart en modalitet inte kan replikera.

När multimodal AI blir standard för generativa AI-lösningar (förväntas vara 40 % till 2027), säkerställer optimering av ditt innehåll bättre synlighet i AI-genererade svar. Organisationer som optimerar över text, bild och video ser förbättrade AI-citeringar, högre synlighet i plattformar som ChatGPT och Gemini samt bättre övergripande innehållsprestation.

Spåra nyckelmetrik som noggrannhet över modaliteter, kvalitet på korsmodal resonemang, bearbetningslatens och affärseffekt (konverteringsgrad, engagemang, etc.). Använd verktyg som AmICited.com för att övervaka hur AI-system citerar ditt innehåll och implementera analys för att förstå vilka modaliteter som bidrar mest till dina affärsresultat.

Viktiga utmaningar inkluderar att säkerställa konsekvent metadata över modaliteter, bibehålla högkvalitativ alt-text och bildtexter, anpassa tidsdata i videor och hantera de beräkningsresurser som krävs för bearbetning. Organisationer bör också planera för databerarbetning (10–20 % av projektbudgeten) och förändringsledning när team anpassar sig till nya optimeringsrutiner.

Hälso- och sjukvård, detaljhandel, tillverkning, innehållsskapande, kundtjänst, jordbruk och robotik ser alla betydande fördelar. Hälso- och sjukvården använder det för diagnostisk noggrannhet, detaljhandeln för produktupptäckt, tillverkning för kvalitetskontroll (100x snabbare katalogisering) och medieföretag rapporterar 72 % ROI på investeringar i generativ AI.

AmICited.com övervakar hur AI-system som ChatGPT, Perplexity och Google AI Overviews citerar ditt innehåll över olika modaliteter. Det ger realtidsinsyn i din AI-söknärvaro och hjälper dig att förstå hur ditt text-, bild- och videoinnehåll refereras i AI-genererade svar.

Enhetliga arkitekturer bearbetar alla modaliteter genom ett enda integrerat nätverk, vilket ger överlägset korsmodal resonemang men kräver fler beräkningsresurser. Modulära arkitekturer har separata nätverk för varje modalitet, vilket ger större flexibilitet och effektivitet. Mixture of Experts (MoE)-modeller erbjuder en hybridlösning med 30–50 % effektivitetsförbättringar.

Optimera text med strukturerad data och konversationston, lägg till beskrivande alt-text och metadata på bilder, inkludera bildtexter och transkriptioner för video och använd konsekventa filnamn. Säkerställ att alla modaliteter samverkar för att ge ett heltäckande sammanhang och implementera schema-markup för att hjälpa AI-system att förstå semantiska relationer.

Spåra hur multimodala AI-system citerar ditt innehåll i ChatGPT, Perplexity, Google AI Overviews och andra plattformar. Få realtidsinsyn i din AI-söknärvaro.

Lär dig vad multimodalt innehåll för AI är, hur det fungerar och varför det är viktigt. Utforska exempel på multimodala AI-system och deras tillämpningar inom o...

Bemästra multimodal AI-sökoptimering. Lär dig hur du optimerar bilder och röstfrågor för AI-drivna sökresultat, med strategier för GPT-4o, Gemini och LLMs....

Lär dig hur multimodala AI-söksystem bearbetar text, bilder, ljud och video tillsammans för att leverera mer exakta och kontextuellt relevanta resultat än AI-me...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.