Bygga ett promptbibliotek för AI-synlighetsspårning

Lär dig skapa och organisera ett effektivt promptbibliotek för att spåra ditt varumärke över ChatGPT, Perplexity och Google AI. Steg-för-steg-guide med bästa pr...

Lär dig hur du bygger och använder promptbibliotek för manuell AI-synlighetstestning. Gör-det-själv-guide till att testa hur AI-system refererar till ditt varumärke i ChatGPT, Perplexity och Google AI.

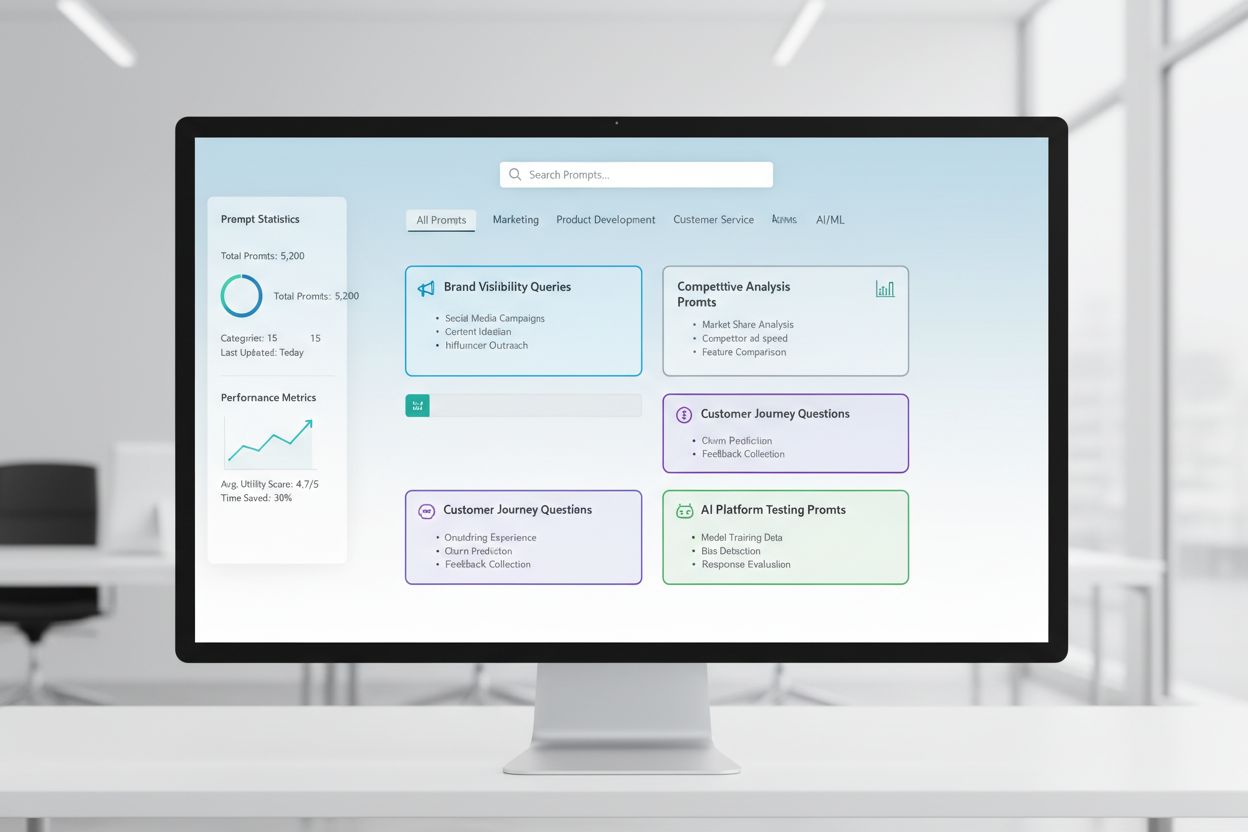

Ett promptbibliotek är en kurerad, organiserad samling av testprompter utformade för att systematiskt utvärdera hur AI-system svarar på specifika frågor och scenarier. I sammanhanget av manuell AI-testning fungerar dessa bibliotek som din grundläggande verktygslåda—ett arkiv med noggrant utformade prompter som hjälper dig att förstå exakt hur olika AI-modeller hanterar dina varumärkesomnämnanden, hänvisningar, innehållsnoggrannhet och kontextuell förståelse. AI-synlighetstestning är starkt beroende av promptbibliotek eftersom de möjliggör konsekvent, upprepbar testning över flera plattformar och tidsperioder, vilket gör att du kan spåra hur ditt innehåll visas (eller inte visas) i AI-genererade svar. Istället för att slumpmässigt testa med ad-hoc-frågor ser ett välstrukturerat promptbibliotek till att du systematiskt täcker alla de scenarier som är viktiga för din verksamhet, från direkta varumärkessökningar till indirekta kontextuella referenser. Detta strukturerade tillvägagångssätt förvandlar manuell testning från en slumpmässig process till en strategisk, datadriven metodik som avslöjar mönster i AI-beteende och hjälper dig att förstå din faktiska synlighet i AI-landskapet.

Manuell AI-synlighetstestning är den praktiska processen att direkt fråga AI-system med förutbestämda prompter och noggrant analysera deras svar för att förstå hur ditt innehåll, varumärke och dina hänvisningar lyfts fram eller utelämnas. Till skillnad från automatiska övervakningssystem som körs kontinuerligt i bakgrunden, ger manuell testning dig direkt kontroll över vad du testar, när du testar det och hur djupt du analyserar resultaten—vilket gör det ovärderligt för utforskande testning, förståelse av specialfall och undersökning av oväntade AI-beteenden. Den viktigaste skillnaden ligger i arbetets karaktär: manuell testning är avsiktlig och undersökande, vilket gör att du kan ställa följdfrågor, testa variationer och förstå “varför” bakom AI-svaren, medan automatiserad övervakning är bäst på konsekvent, storskalig spårning över tid. Manuell testning är särskilt viktig för AI-synlighet eftersom den hjälper dig att fånga nyanser som automatiska system kan missa—som om ditt varumärke nämns men tillskrivs fel, om hänvisningar är korrekta men ofullständiga eller om kontexten förstås korrekt. Så här jämförs dessa tillvägagångssätt:

| Aspekt | Manuell testning | Automatisk övervakning |

|---|---|---|

| Kostnad | Lägre initial investering; tidskrävande | Högre initial inställning; lägre löpande arbetsinsats |

| Hastighet | Långsammare per test; omedelbara insikter | Långsammare att sätta upp; snabb kontinuerlig spårning |

| Flexibilitet | Mycket flexibel; lätt att ändra och utforska | Stel; kräver fördefinierade parametrar |

| Noggrannhet | Hög för kvalitativ analys; subjektiv mänsklig bias | Konsekvent; utmärkt för kvantitativa mått |

| Inlärningskurva | Minimal; vem som helst kan börja testa | Brantare; kräver teknisk installation och konfiguration |

Manuell testning utmärker sig när du behöver förstå varför något händer, medan automatisk övervakning utmärker sig vid att spåra vad som händer i stor skala.

En robust promptbiblioteksstruktur bör organiseras kring nyckeldimensionerna i din AI-synlighetsstrategi, där varje komponent tjänar ett specifikt testsyfte. Ditt bibliotek bör innehålla prompter som testar olika aspekter av hur AI-system upptäcker och lyfter fram ditt innehåll, för att säkerställa heltäckande synlighet. Här är de grundläggande komponenter som varje promptbibliotek bör innehålla:

När du bygger din teststrategi behöver du prompter som specifikt riktar in sig på de dimensioner av AI-synlighet som är viktigast för din verksamhet—varumärkesomnämnanden, citeringsnoggrannhet och kontextuell förståelse. De mest effektiva testprompterna är de som speglar verkligt användarbeteende samtidigt som de isolerar specifika variabler du vill mäta. För testprompter med fokus på varumärkesomnämnanden vill du ha variationer som testar direkta sökningar, indirekta referenser och jämförande kontexter. Citeringsnoggrannhet kräver prompter som naturligt utlöser hänvisningar och sedan varianter som testar om AI-systemet korrekt tillskriver information till dina källor. Här är exempelprompter du kan anpassa för din egen testning:

"Vad är de senaste utvecklingarna inom [din bransch]?

Vänligen ange dina källor."

"Jämför [din produkt] med [konkurrentens produkt].

Vilka är de viktigaste skillnaderna och fördelarna med varje?"

"Förklara [ditt expertområde].

Vilka är de ledande experterna eller företagen inom detta område?"

Dessa prompter är utformade för att naturligt utlösa de typer av svar där din synlighet är viktigast—när AI-system tillhandahåller information, gör jämförelser eller identifierar auktoritativa källor. Du kan skapa varianter genom att ändra specificitetsnivåer (brett vs. smalt), lägga till begränsningar (endast aktuell information, specifika användningsfall) eller ändra citeringskraven (med källor, med länkar, med författarnamn). Nyckeln är att testa inte bara om ditt innehåll visas, utan hur det visas och i vilket sammanhang, vilket kräver prompter som skapar realistiska scenarier där din synlighet naturligt skulle visas.

Din AI-synlighetsstrategi måste ta hänsyn till att olika AI-plattformar—ChatGPT, Perplexity, Google AI Overviews, Claude och andra—har grundläggande olika träningsdata, hämtningstekniker och svarsgenereringsmetoder, vilket innebär att din synlighet varierar avsevärt mellan plattformarna. Plattformsöverskridande testning är avgörande eftersom en prompt som lyfter fram ditt innehåll tydligt i ett AI-system kan ge helt andra resultat i ett annat, och att förstå dessa plattformsunika mönster är avgörande för att utveckla en heltäckande synlighetsstrategi. När du testar på olika plattformar kommer du att märka att Perplexity, med sin realtidsintegrering av sök, ofta visar mer aktuellt innehåll och inkluderar fler explicita hänvisningar än ChatGPT, som förlitar sig på träningsdata med kunskapsstopp. Google AI Overviews, integrerat direkt i sökresultaten, verkar under andra synlighetsregler och kan prioritera andra källor än konversationella AI-system. Det praktiska tillvägagångssättet är att upprätthålla en konsekvent uppsättning kärnprompter som du kör över alla plattformar enligt ett regelbundet schema, så att du inte bara kan spåra om ditt innehåll visas, utan var det visas och hur plattformsvariationer påverkar din synlighet. Detta plattformsöverskridande perspektiv avslöjar om dina synlighetsutmaningar är universella (drabbar alla plattformar) eller plattformsunika (kräver riktade strategier för särskilda system), vilket fundamentalt förändrar hur du bör närma dig optimering.

Effektiv testdokumentation omvandlar råa testdata till åtgärdsbar kunskap, och det organisationssystem du väljer avgör om dina testinsatser ger ökande värde över tid eller förblir isolerade datapunkter. Det mest praktiska är att använda ett strukturerat kalkylblad eller dokumentationssystem som fångar inte bara resultaten, utan även kontexten—inklusive exakt prompt, testdatum, testad plattform, hela AI-svaret och din analys av om ditt innehåll dök upp och hur det presenterades. Ditt resultatspårningssystem bör innehålla kolumner för: promptkategori (varumärke, konkurrent, bransch osv.), testad plattform, om ditt innehåll dök upp, citeringsnoggrannhet (om tillämpligt), position i svaret (första omnämnande, stödjande bevis osv.) samt eventuella kvalitativa anteckningar om svarskvalitet eller relevans. Utöver rådata, skapa mallar för vanliga testsituationer så att din dokumentation förblir konsekvent över tid, vilket gör det lättare att upptäcka trender och förändringar i AI-beteende. Dokumentera inte bara framgångar utan även misslyckanden och avvikelser—dessa avslöjar ofta de viktigaste insikterna om hur AI-system fungerar och var din synlighetsstrategi behöver justeras. Genom att upprätthålla detta disciplinerade tillvägagångssätt för testmetodik skapar du en historik som visar hur din synlighet har utvecklats, vilka förändringar i AI-systemen som har påverkat dina resultat och vilka optimeringsinsatser som faktiskt gjort skillnad.

Manuell AI-synlighetstestning är sårbar för flera systematiska fel som kan underminera dina resultat och leda till felaktiga slutsatser om din faktiska synlighet. Den vanligaste fallgropen är inkonsekvent promptformulering—att testa samma koncept med något olika formulering varje gång, vilket introducerar variabler som gör det omöjligt att avgöra om förändringar i resultat beror på förändringar i AI-systemet eller på dina testvariationer. För att undvika detta, skapa ett huvudpromptdokument där varje prompt är låst och används identiskt i alla testrundor; om du vill testa varianter, skapa separata promptvarianter med tydlig namngivning. Ett annat kritiskt misstag är otillräckliga urvalsstorlekar och låg testfrekvens—att testa en gång och dra slutsatser, istället för att inse att AI-svar kan variera beroende på timing, systembelastning och andra faktorer. Etablera en regelbunden testcykel (veckovis, varannan vecka eller månatligen beroende på resurser) och testa varje prompt flera gånger för att identifiera mönster snarare än avvikelser. Bekräftelsebias är en subtil men farlig fallgrop där testare omedvetet tolkar tvetydiga resultat som bekräftar deras förväntningar; motverka detta genom att låta flera teammedlemmar granska resultat oberoende och dokumentera objektiva kriterier för vad som räknas som “ditt innehåll visas”. Undvik även misstaget att testa isolerat—notera alltid datum, tid och kända AI-systemuppdateringar vid testning, eftersom förståelse för kontexten kring dina resultat är avgörande för tolkningen. Slutligen innebär bristfällig dokumentation av metodik att du inte kan upprepa din testning eller förklara dina resultat för intressenter; dokumentera alltid exakt hur du testade, vad du mätte och hur du tolkade resultaten så att din testning är reproducerbar och försvarbar.

När din organisation växer och din AI-synlighetsstrategi blir mer sofistikerad behöver du skala från individuell, ad-hoc-testning till ett strukturerat teamtestningsupplägg som fördelar arbetsbördan och samtidigt bibehåller konsekvens och kvalitet. Nyckeln till framgångsrik skala är att skapa tydliga testprotokoll och rollbeskrivningar—utse vem som ansvarar för vilka plattformar, vilka promptkategorier och vilka analysuppgifter, så att testningen blir en samordnad laginsats istället för duplicerat individuellt arbete. Implementera en delad testkalender där teammedlemmar kan se vad som har testats, när och av vem, vilket förhindrar dubbelarbete och säkerställer heltäckande täckning. Skapa en testchecklista eller körplan som vilken teammedlem som helst kan följa för att utföra tester konsekvent, inklusive specifika instruktioner om hur man dokumenterar resultat, vad man ska leta efter i svaren och hur man flaggar avvikelser eller intressanta fynd. Samarbetsverktyg som delade kalkylblad, projektledningssystem eller dedikerade testplattformar hjälper till att samordna insatser mellan teammedlemmar och skapa en enda sanningskälla för dina testdata. När du skalar, överväg att rotera testansvar så att flera personer förstår din testmetodik och kan bidra, vilket minskar beroendet av enskilda personer. Regelbundna teamsynkroniseringsmöten där ni granskar testresultat, diskuterar fynd och justerar er teststrategi säkerställer att din uppskalade testinsats förblir samordnad och strategisk snarare än att bli en uppdelad samling individuella uppgifter.

De mest avancerade AI-synlighetsstrategierna inser att manuella och automatiserade tillvägagångssätt är komplementära snarare än konkurrerande, där varje metod utmärker sig i olika sammanhang och tillsammans ger heltäckande synlighet. Manuell testning är ditt undersökningsverktyg—det är där du utforskar, förstår nyanser, testar hypoteser och får djupa insikter i hur AI-system fungerar och varför din synlighet varierar mellan plattformar och scenarier. Automatiserade övervakningsverktyg som AmICited utmärker sig på konsekvent, storskalig spårning över tid, övervakar kontinuerligt din synlighet över flera AI-plattformar och varnar dig för förändringar, trender och avvikelser som vore omöjliga att upptäcka genom manuell testning ensam. Den praktiska integrationsstrategin är att använda manuell testning för att utveckla din teststruktur, förstå vad som är viktigt och undersöka avvikelser, medan du använder automatiserad övervakning för att kontinuerligt spåra dessa nyckelmått och varna dig när något förändras. Till exempel kan du manuellt testa en ny promptkategori för att förstå hur AI-system svarar, och när du har validerat att det är ett meningsfullt test, lägga till det i din automatiska övervakning så att du får kontinuerlig spårning utan löpande manuellt arbete. AmICited och liknande övervakningsverktyg hanterar det repetitiva, tidskrävande arbetet med att köra tester i skala och frekvens som vore opraktiskt att göra manuellt, vilket frigör ditt team för att fokusera på mer värdefull analys, strategi och optimering. Den idealiska arbetsgången är: använd manuell testning för att bygga ditt promptbibliotek och teststrategi, validera din metod och undersöka specifika frågor; använd automatiserad övervakning för att kontinuerligt spåra dina viktigaste synlighetsmått; och använd insikterna från den automatiska övervakningen för att bestämma vad du ska testa manuellt härnäst. Detta integrerade tillvägagångssätt säkerställer att du inte bara testar manuellt i ett vakuum, utan bygger en heltäckande synlighetsstrategi som kombinerar djupet i manuell undersökning med skalan och konsekvensen i automatiserad övervakning.

Ett promptbibliotek är en kurerad, organiserad samling av testprompter utformade för att systematiskt utvärdera AI-system över flera dimensioner. Till skillnad från en enskild promptmall innehåller ett bibliotek dussintals prompter organiserade efter kategori (varumärkesnämningar, konkurrentjämförelser, källhänvisningar osv.), vilket gör att du kan utföra omfattande tester istället för enskilda kontroller. Promptbibliotek är versionshanterade, dokumenterade och utformade för återanvändning och skalning över ditt team.

Frekvensen beror på dina resurser och hur dynamisk din bransch är. De flesta organisationer gynnas av veckovis eller varannan vecka testning av kärnprompter för att fånga upp betydande förändringar, med månatliga djupgående tester av hela promptbiblioteket. Om du är i en snabbföränderlig bransch eller nyligen har publicerat stort innehåll, öka frekvensen till varje vecka. Kombinera manuell testning med automatiska övervakningsverktyg som AmICited för kontinuerlig spårning mellan manuella testcykler.

Ja, du bör använda samma kärnprompter på olika plattformar för att säkerställa konsekvens och jämförbarhet. Dock kan du behöva plattformsanpassade varianter eftersom olika AI-system (ChatGPT, Perplexity, Google AI Overviews) har olika gränssnitt, citeringsmekanismer och svarformat. Testa dina kärnprompter identiskt över plattformarna och skapa sedan plattformsanpassade varianter för att ta hänsyn till unika funktioner eller begränsningar hos varje system.

Spåra om ditt innehåll visas (ja/nej), var det visas i svaret (första omnämnande, stödjande bevis osv.), citeringsnoggrannhet (om citerad) och svarskvalitet. Dokumentera även datum för test, plattform, exakt prompt som användes och eventuella kvalitativa observationer om hur ditt innehåll presenterades. Med tiden avslöjar dessa mätvärden mönster i din synlighet och hjälper dig att förstå vilka optimeringsinsatser som faktiskt gör skillnad.

Din testning är omfattande när du täcker alla huvudsakliga dimensioner av din synlighet: direkta varumärkessökningar, konkurrentjämförelser, branschämnen, citeringsnoggrannhet och kontextuell förståelse. En bra tumregel är 20–30 kärnprompter som du testar regelbundet, plus ytterligare prompter för specifika undersökningar. Om du ständigt upptäcker nya insikter från manuell testning behöver du troligen fler prompter. Om resultaten blir förutsägbara är din täckning troligtvis tillräcklig.

För små organisationer eller initial testning kan du börja med interna resurser enligt gör-det-själv-metoden som beskrivs i denna guide. Men när din testning skalas blir dedikerade resurser värdefulla. Överväg att anställa eller utse någon att hantera ditt promptbibliotek och genomföra regelbunden testning om du har flera produkter, verkar i en konkurrensutsatt bransch eller behöver frekventa testcykler. Alternativt kan du kombinera intern testning med automatiska övervakningsverktyg som AmICited för att fördela arbetsbördan.

Manuell testning är undersökande och flexibel – du styr vad du testar och kan utforska nyanser och specialfall. Automatiska övervakningsverktyg som AmICited körs kontinuerligt, spårar din synlighet över flera AI-plattformar i stor skala och varnar dig för förändringar. Det idealiska tillvägagångssättet kombinerar båda: använd manuell testning för att utveckla din teststrategi och undersöka specifika frågor, medan du använder automatisk övervakning för kontinuerlig spårning av nyckelmått.

Du kan automatisera utförandet av prompter med hjälp av API:er (OpenAI, Anthropic etc.) för att skicka dina prompter till AI-system och fånga svar programmatiskt. Analysen är dock vanligtvis manuell eftersom förståelse av kontext och nyans kräver mänskligt omdöme. Du kan också automatisera dokumentation och resultatuppföljning med kalkylblad eller databaser. Det mest praktiska är att använda automatiska övervakningsverktyg som AmICited för det repetitiva arbetet, medan manuell testning reserveras för djupare analys och undersökningar.

Medan manuell testning är värdefull, säkerställer automatisk övervakning kontinuerlig synlighet över alla AI-plattformar. AmICited spårar hur AI-system refererar till ditt varumärke i realtid.

Lär dig skapa och organisera ett effektivt promptbibliotek för att spåra ditt varumärke över ChatGPT, Perplexity och Google AI. Steg-för-steg-guide med bästa pr...

Lär dig vad utveckling av promptbibliotek innebär och hur organisationer bygger frågesamlingar för att testa och övervaka varumärkesexponering över AI-plattform...

Lär dig hur du testar ditt varumärkes närvaro i AI-motorer med prompttestning. Upptäck manuella och automatiserade metoder för att övervaka AI-synlighet över Ch...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.