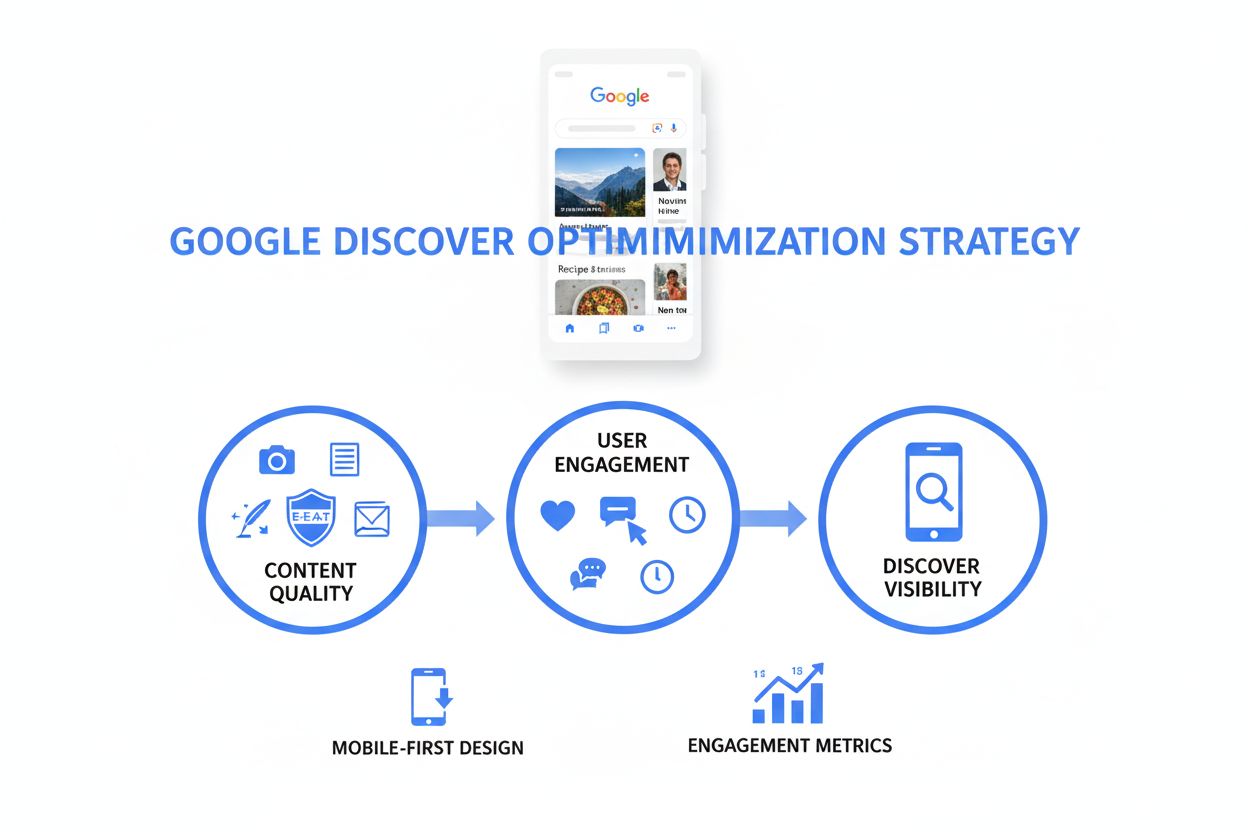

Discover-optimering

Lär dig vad Discover-optimering är och hur du optimerar innehåll för synlighet i Google Discover. Utforska strategier, rankningssignaler och bästa praxis för at...

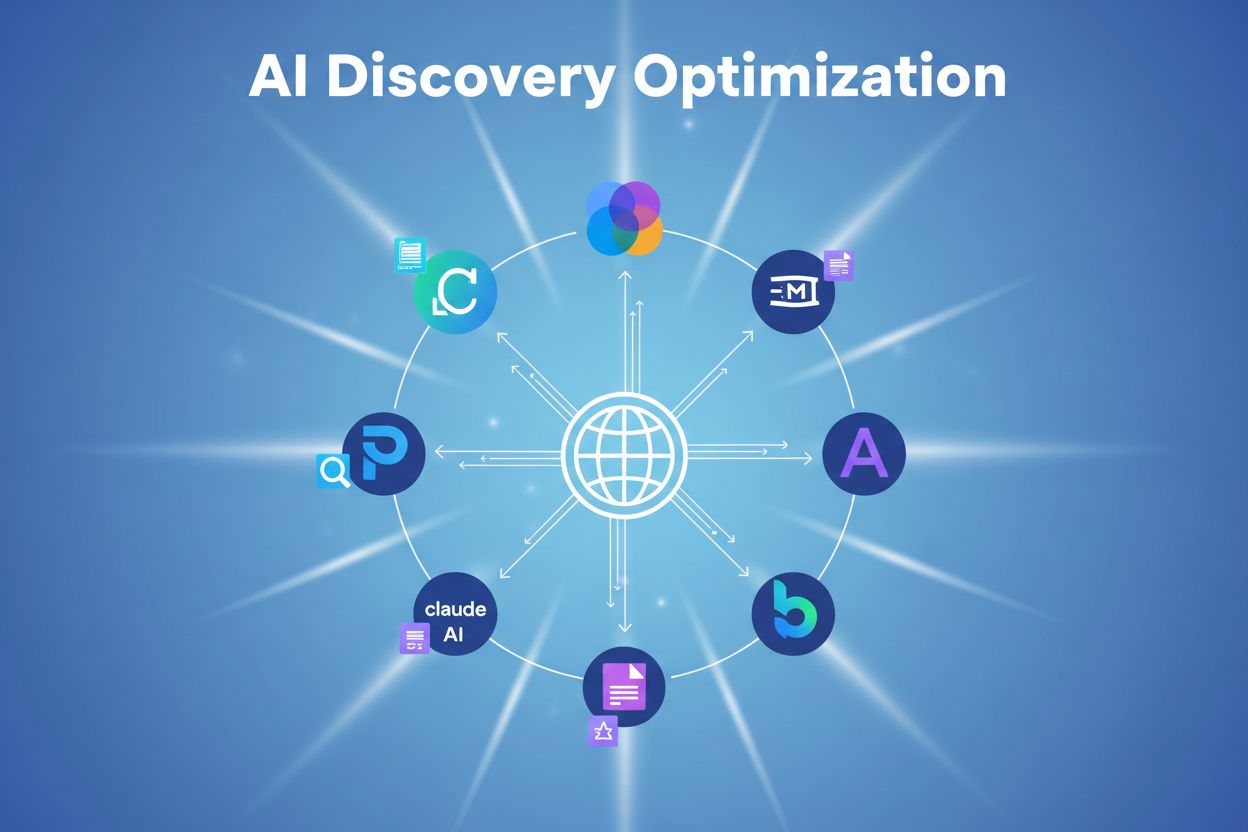

Tekniker och strategier för att säkerställa att nytt innehåll snabbt hittas, crawlas, indexeras och görs tillgängligt för artificiella intelligens-system inklusive LLM:er, AI-sökmotorer och chatbots. Till skillnad från traditionell SEO som fokuserar på sökrankningar, riktar AI Discovery Optimization in sig på innehållsinkludering i AI-genererade svar över plattformar som ChatGPT, Gemini, Perplexity och Claude.

Tekniker och strategier för att säkerställa att nytt innehåll snabbt hittas, crawlas, indexeras och görs tillgängligt för artificiella intelligens-system inklusive LLM:er, AI-sökmotorer och chatbots. Till skillnad från traditionell SEO som fokuserar på sökrankningar, riktar AI Discovery Optimization in sig på innehållsinkludering i AI-genererade svar över plattformar som ChatGPT, Gemini, Perplexity och Claude.

AI Discovery Optimization avser praktiken att säkerställa att ditt innehåll snabbt upptäcks, crawlas, indexeras och görs tillgängligt för artificiella intelligens-system, inklusive stora språkmodeller (LLM:er), AI-sökmotorer och chatbots. Till skillnad från traditionell sökmotoroptimering, som fokuserar på att ranka sidor i sökresultat, riktar AI Discovery Optimization in sig på inkluderingen av ditt innehåll i AI-genererade svar över plattformar som ChatGPT, Google Gemini, Perplexity, Claude och Microsoft Copilot. Insatserna är betydande: AI-referensadresser till toppwebbplatser ökade 357% år-över-år i juni 2025, och nådde 1,13 miljarder besök, vilket gör AI-synlighet till en kritisk komponent i varje modern innehållsstrategi. Den fundamentala skillnaden ligger i hur AI-system konsumerar innehåll—istället för att helt enkelt indexera sidor, bryter de ner innehåll i semantiska bitar och syntetiserar svar genom att kombinera information från flera källor. Denna förskjutning kräver ett annat optimeringssynsätt fokuserat på innehållsklarhet, struktur och auktoritet. Verktyg som AmICited.com hjälper varumärken att övervaka hur AI-system refererar till och citerar deras innehåll över olika plattformar, vilket ger synlighet i detta nya upptäcktslandskap.

AI-system använder specialiserade crawlers för att upptäcka och indexera webbinnehåll, liknande traditionella sökmotorbottar men med distinkta syften och beteenden. Stora AI-crawlers inkluderar GPTBot (OpenAI), ClaudeBot (Anthropic), PerplexityBot (Perplexity), Googlebot med Google-Extended-token (Google) och Bingbot (Microsoft), var och en med olika crawlningsmönster och prioriteringar. Dessa crawlers opererar under konceptet “crawl budget”—en begränsad allokering av resurser som bestämmer vilka sidor som crawlas och hur ofta. Till skillnad från traditionella sökmotorer som indexerar hela sidor för rankning, bryter AI-system ner innehåll i semantiska bitar under indexeringsprocessen och extraherar fristående passager som kan hämtas och syntetiseras till svar.

| AI-crawler | Källa | Primärt syfte | Crawl-typ | Frekvens |

|---|---|---|---|---|

| GPTBot | OpenAI | Träning & RAG för ChatGPT | Bred täckning | Periodisk |

| ClaudeBot | Anthropic | Träning & RAG för Claude | Selektiv | Periodisk |

| PerplexityBot | Perplexity | Realtidshämtning för svar | Högfrekvent | Kontinuerlig |

| Googlebot (Google-Extended) | AI Overviews & AI Mode | Selektiv | Kontinuerlig | |

| Bingbot | Microsoft | Copilot & AI-sökning | Selektiv | Kontinuerlig |

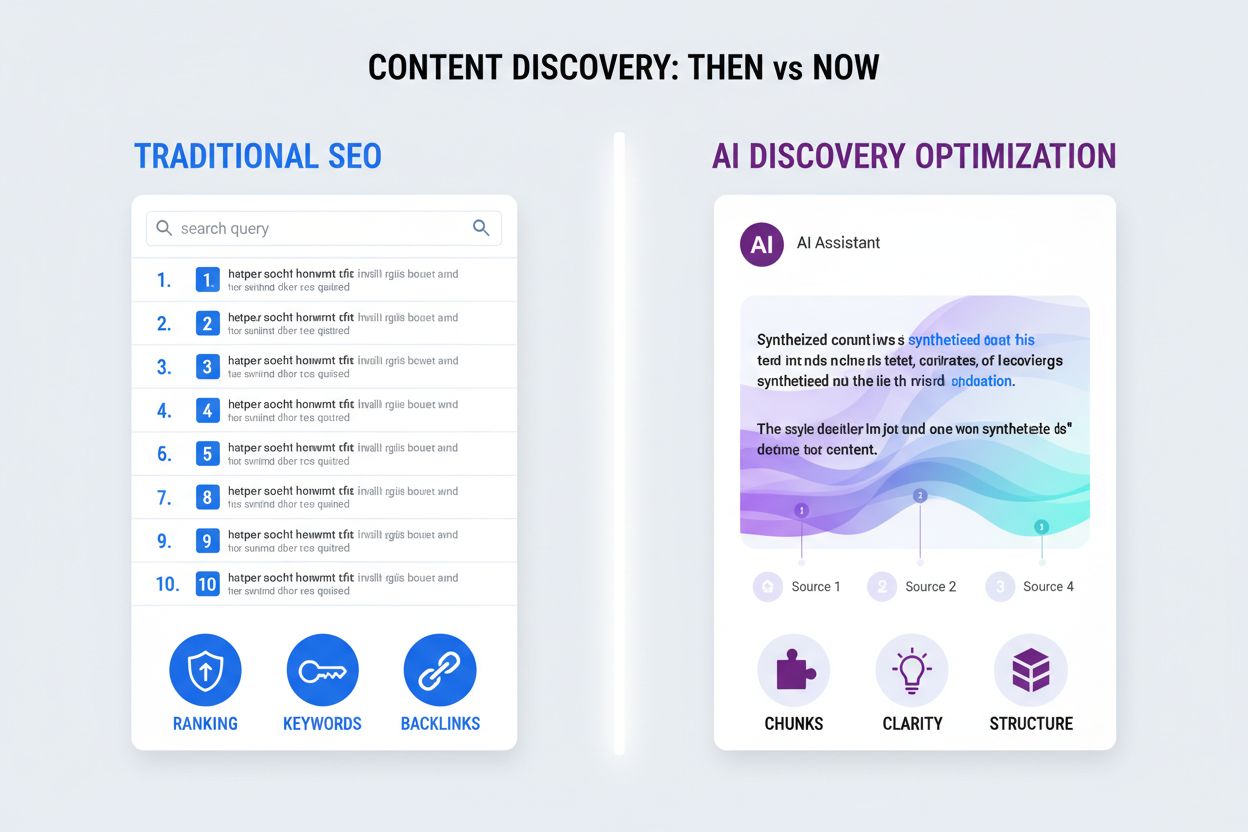

| CCBot | Common Crawl | Forskning & träningsdata | Bred täckning | Periodisk |

Traditionell SEO och AI Discovery Optimization representerar fundamentalt olika tillvägagångssätt för innehållssynlighet, var och en med distinkta prioriteringar och framgångsmätningar. Traditionell SEO fokuserar på att optimera sidor för att ranka i sökresultat (SERP:ar), med betoning på nyckelordsmatchning, bakåtlänksauktoritet och sidnivårankningssignaler. Däremot prioriterar AI Discovery Optimization innehållsinkludering i AI-genererade svar, med betoning på innehållsklarhet, semantisk struktur och bitnivåoptimering. Traditionell SEO opererar på en en-fråga-ett-resultat-modell där en enda URL rankar för ett specifikt nyckelord, medan AI-system använder en syntesmodell där flera innehållsbitar från olika källor kombineras till ett enda svar.

För att AI-system ska kunna upptäcka och indexera ditt innehåll effektivt måste flera tekniska krav uppfyllas för att säkerställa crawlbarhet och tillgänglighet. Server-side rendering (SSR) är kritisk eftersom de flesta AI-crawlers inte kan exekvera JavaScript—innehåll som laddas dynamiskt via klient-sidans JavaScript förblir osynligt för dessa system. Allt väsentligt innehåll måste finnas i det initiala HTML-svaret, vilket låter AI-crawlers med begränsad bearbetningstid (typiskt 1-5 sekunder) komma åt det omedelbart. HTML-strukturen bör vara semantisk och välorganiserad med korrekt rubrikhierarki (H1, H2, H3-taggar), tydliga meta-taggar och självreferenserande kanoniska taggar för att hjälpa AI-system förstå innehållsrelationer.

Tekniska krav checklista:

AI-system hämtar inte hela sidor; istället bryter de ner innehåll i semantiska “bitar”—fristående passager som kan extraheras och förstås oberoende utan omgivande kontext. Denna fundamentala skillnad kräver ett annorlunda tillvägagångssätt för innehållsstruktur och formatering. Varje bit bör utformas som en fristående enhet som är meningsfull när den extraheras från sidan, vilket innebär att man undviker referenser till omgivande innehåll eller förlitar sig på kontext från andra sektioner. Tydlig rubrikhierarki är väsentlig eftersom AI-system använder rubriker för att identifiera bitgränser och förstå relationen mellan idéer. Principen “en idé per sektion” säkerställer att varje bit fokuserar på ett enda koncept, vilket gör det lättare för AI-system att extrahera och syntetisera.

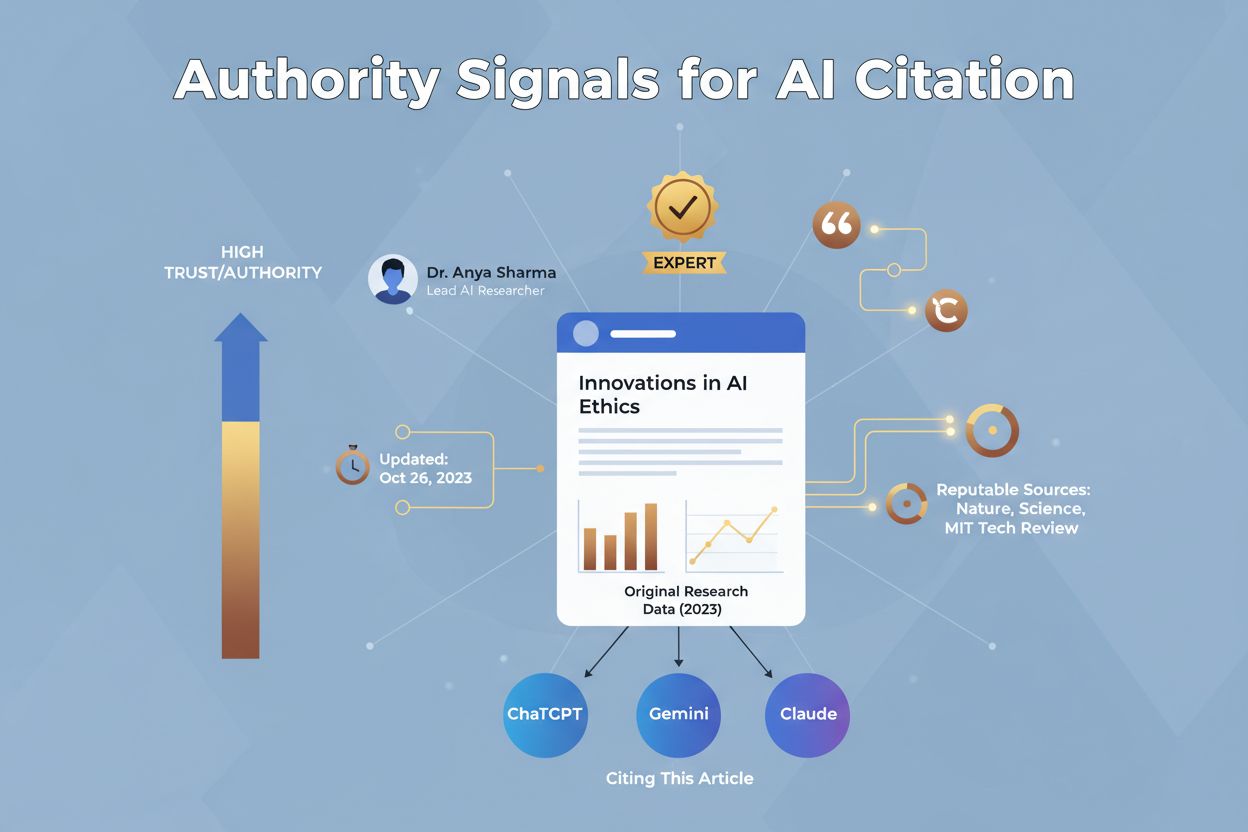

AI-system prioriterar auktoritativa, pålitliga källor när de syntetiserar svar, vilket gör auktoritetssignaler kritiska för AI Discovery Optimization. Konceptet EEAT (Expertise, Experience, Authoritativeness, Trustworthiness) påverkar direkt huruvida AI-system kommer att citera ditt innehåll. Expertise demonstreras genom djup, korrekt kunskap om ditt ämnesområde; Experience kommer från verklig tillämpning och fallstudier; Authoritativeness byggs genom erkännande från andra experter och ansedda källor; och Trustworthiness etableras genom transparenta, faktabaserade påståenden med korrekt attribution. Författarsignaturer med meriter och strukturerad författarschema-markup hjälper AI-system att förstå vem som skapade innehållet och bedöma deras expertisnivå.

Att mäta framgången för dina AI Discovery Optimization-insatser kräver spårning av mätningar distinkta från traditionell SEO-analys. Börja med att spåra AI-referenstrafik separat i din analysplattform och skapa en dedikerad kanal för trafik från AI-plattformar som ChatGPT, Gemini, Perplexity och Claude för att förstå dess tillväxtbana och användarbeteende. Övervaka varumärkesomnämnanden över stora AI-plattformar genom att regelbundet kontrollera hur ofta ditt varumärke, produkter eller innehåll förekommer i AI-genererade svar för relevanta frågor. Bedöm sentiment för dessa omnämnanden—huruvida de är positiva, neutrala eller negativa—för att förstå hur AI-system positionerar ditt varumärke relativt till konkurrenter. Verktyg som Goodie, Profound och Similarweb tillhandahåller AI-synlighetsspårning, men AmICited.com fungerar som den primära plattformen för att övervaka hur AI-system refererar till och citerar ditt varumärke.

Att implementera AI Discovery Optimization kräver ett systematiskt tillvägagångssätt som kombinerar tekniska, innehålls- och övervakningsstrategier. Börja med att granska din nuvarande crawlbarhet med verktyg som analyserar din robots.txt, llms.txt, serverloggar och innehållsstruktur för att identifiera hinder för AI-upptäckt. Implementera server-side rendering för alla kritiska innehållssidor för att säkerställa att AI-crawlers kan komma åt information i det initiala HTML-svaret. Optimera din innehållsstruktur genom att implementera tydliga rubrikhierarkier, semantisk HTML och schema.org-markup som hjälper AI-system att förstå ditt innehåll. Skapa originellt, auktoritativt innehåll med korrekta författarmeriter, citeringar och tidsstämplar som signalerar expertis och pålitlighet till AI-system. Bygg tematisk auktoritet genom hub-and-spoke-innehållskluster där pelare-sidor ger översikter och klustersidor fördjupar sig i specifika underämnen, vilket hjälper AI-system att känna igen din expertis. Genom att kombinera dessa praktiker med verktyg som AmICited.com för övervakning och FlowHunt.io för innehållsoptimering och automatisering kan du bygga en omfattande AI Discovery Optimization-strategi som säkerställer att ditt innehåll når och citeras av AI-system.

Traditionell SEO fokuserar på att ranka sidor i sökmotorresultat, medan AI Discovery Optimization säkerställer att innehåll inkluderas i AI-genererade svar. AI-system bryter ner innehåll i bitar och syntetiserar svar från flera källor, vilket kräver olika optimeringsstrategier fokuserade på innehållsklarhet, struktur och auktoritet snarare än nyckelordsmatchning och bakåtlänkar.

Du bör tillåta stora AI-crawlers inklusive GPTBot (OpenAI), ClaudeBot (Anthropic), PerplexityBot, Googlebot med Google-Extended-token och Bingbot. Du kan dock selektivt blockera crawlers om ditt innehåll är känsligt eller proprietärt. Använd verktyg som AmICited.com för att övervaka vilka crawlers som kommer åt din webbplats och deras crawlningsmönster.

De flesta AI-crawlers kan inte exekvera JavaScript, så innehåll som laddas dynamiskt via JavaScript är osynligt för dem. Server-side rendering säkerställer att allt kritiskt innehåll finns i det initiala HTML-svaret, vilket gör det omedelbart tillgängligt för AI-system som har begränsad bearbetningstid (1-5 sekunder) för att hämta och indexera ditt innehåll.

Spåra AI-referenstrafik separat i din analys, övervaka varumärkesomnämnanden och sentiment i AI-genererade svar med verktyg som AmICited.com eller Goodie, och jämför din synlighet mot konkurrenter. Övervaka också AI-crawler-beteende i serverloggar för att säkerställa att ditt innehåll nås och indexeras av AI-system.

AI-system bryter ner innehåll i semantiska bitar (fristående passager) för hämtning och syntes. Varje bit bör vara oberoende förståelig och optimerad för extraktion. Tydlig rubrikhierarki, koncisa svar och strukturerad formatering hjälper AI-system att identifiera och extrahera värdefulla bitar som kan användas i AI-genererade svar.

Mycket viktig. AI-system prioriterar originellt, auktoritativt innehåll med unik data och insikter. Originalforskning, undersökningar och unika dataset är betydligt mer sannolika att citeras i AI-genererade svar än återanvänt eller generiskt innehåll, vilket gör originalforskning till en nyckelkomponent i din AI Discovery Optimization-strategi.

Ja, du kan blockera specifika AI-crawlers med robots.txt- eller llms.txt-filer. Att blockera crawlers innebär dock att ditt innehåll inte inkluderas i AI-genererade svar, vilket minskar din synlighet i AI-sökplattformar. Överväg avvägningarna noggrant innan du blockerar, eftersom AI-referenser har ökat 357% år-över-år.

Uppdatera nyckelinnehåll regelbundet för att behålla aktualitetssignaler. Lägg till tidsstämplar för att visa när innehåll senast uppdaterades. AI-system prioriterar aktuell, korrekt information, så att uppdatera innehåll kvartalsvis eller när ny information blir tillgänglig rekommenderas för att upprätthålla stark AI-upptäcktsprestanda.

Spåra hur AI-system refererar till och citerar ditt varumärke över ChatGPT, Gemini, Perplexity, Claude och andra AI-plattformar. Få realtidsinsikter om din AI-upptäcktsprestanda och optimera din innehållsstrategi.

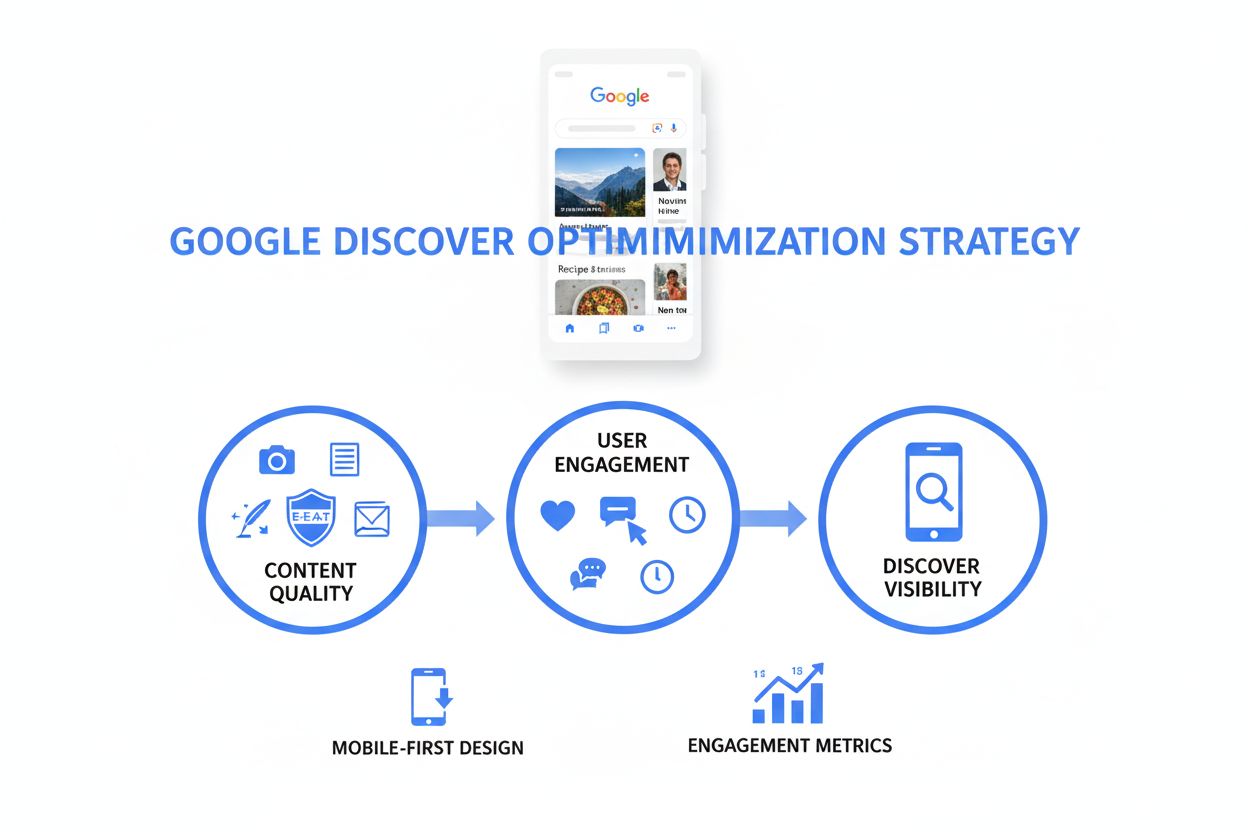

Lär dig vad Discover-optimering är och hur du optimerar innehåll för synlighet i Google Discover. Utforska strategier, rankningssignaler och bästa praxis för at...

Lär dig AI-söknoptimeringsstrategier för att förbättra varumärkessynlighet i ChatGPT, Google AI Översikter och Perplexity. Optimera innehåll för LLM-citering oc...

Lär dig hur kontinuerlig optimering för AI-sök hjälper dig att övervaka och förbättra ditt varumärkes synlighet i AI-sökmotorer genom realtidsövervakning och da...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.