Finjustering

Definition av finjustering: anpassning av förtränade AI-modeller för specifika uppgifter genom domänspecifik träning. Lär dig hur finjustering förbättrar modell...

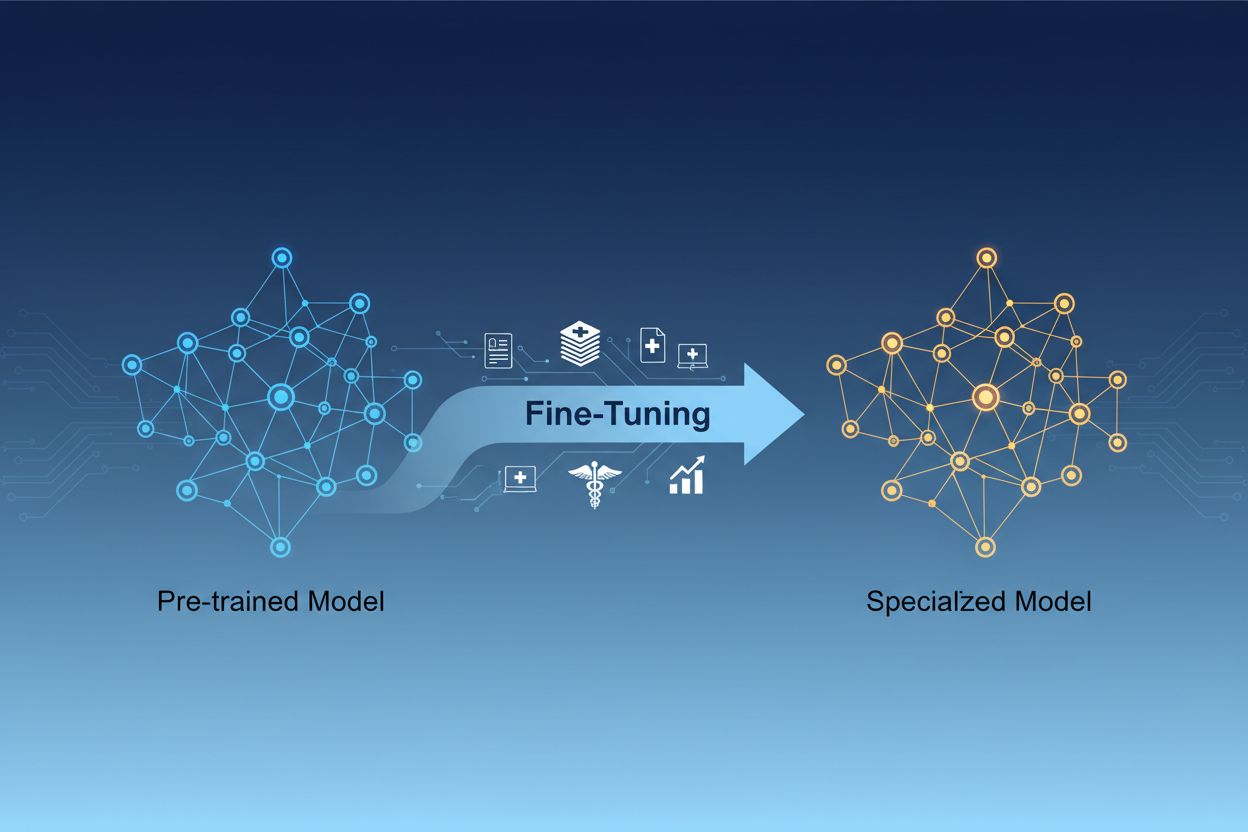

Finjustering av AI-modell är processen att anpassa förtränade artificiella intelligensmodeller för att utföra specifika uppgifter eller arbeta med specialiserad data genom att justera deras parametrar via ytterligare träning på domänspecifika datamängder. Detta tillvägagångssätt utnyttjar befintlig grundläggande kunskap samtidigt som modellerna anpassas för särskilda affärsapplikationer, vilket gör det möjligt för organisationer att skapa högspecialiserade AI-system utan den beräkningsmässiga kostnaden av att träna från grunden.

Finjustering av AI-modell är processen att anpassa förtränade artificiella intelligensmodeller för att utföra specifika uppgifter eller arbeta med specialiserad data genom att justera deras parametrar via ytterligare träning på domänspecifika datamängder. Detta tillvägagångssätt utnyttjar befintlig grundläggande kunskap samtidigt som modellerna anpassas för särskilda affärsapplikationer, vilket gör det möjligt för organisationer att skapa högspecialiserade AI-system utan den beräkningsmässiga kostnaden av att träna från grunden.

Finjustering av AI-modell är processen att ta en förtränad artificiell intelligensmodell och anpassa den för att utföra specifika uppgifter eller arbeta med specialiserad data. Istället för att träna en modell från grunden utnyttjar finjustering den grundläggande kunskap som redan finns inbyggd i en förtränad modell och justerar dess parametrar genom ytterligare träning på domänspecifika eller uppgiftsspecifika datamängder. Detta tillvägagångssätt kombinerar effektiviteten hos transfer learning med den anpassning som krävs för särskilda affärsapplikationer. Finjustering gör det möjligt för organisationer att skapa högspecialiserade AI-modeller utan den beräkningsmässiga kostnaden och tidsåtgången som krävs för att träna från grunden, vilket gör det till en viktig teknik i modern maskininlärningsutveckling.

Skillnaden mellan finjustering och träning från grunden är ett av de viktigaste besluten i maskininlärningsutveckling. När du tränar en modell från grunden börjar du med slumpmässigt initialiserade vikter och måste lära modellen allt om språkstrukturer, visuella egenskaper eller domänspecifik kunskap med hjälp av enorma datamängder och betydande beräkningsresurser. Detta tillvägagångssätt kan kräva veckor eller månader av träningstid och tillgång till specialiserad hårdvara som GPU:er eller TPU:er. Finjustering däremot utgår från en modell som redan förstår grundläggande mönster och begrepp, och kräver bara en bråkdel av data och beräkningskraft för att anpassa den till dina specifika behov. Den förtränade modellen har redan lärt sig generella egenskaper under den initiala träningsfasen, så finjusteringen fokuserar på att justera dessa egenskaper för att matcha ditt specifika användningsområde. Denna effektivitetsvinst gör finjustering till det föredragna tillvägagångssättet för de flesta organisationer, eftersom det minskar både tid till marknad och infrastrukturkostnader och ofta uppnår bättre prestanda jämfört med att träna mindre modeller från grunden.

| Aspekt | Finjustering | Träning från grunden |

|---|---|---|

| Träningstid | Dagar till veckor | Veckor till månader |

| Datakrav | Tusentals till miljoner exempel | Miljoner till miljarder exempel |

| Beräkningskostnad | Måttlig (en GPU ofta tillräcklig) | Extremt hög (flera GPU:er/TPU:er krävs) |

| Initial kunskap | Utnyttjar förtränade vikter | Börjar med slumpmässig initiering |

| Prestanda | Ofta överlägsen vid begränsad data | Bättre med enorma datamängder |

| Krävd expertis | Medelnivå | Avancerad |

| Anpassningsgrad | Hög för specifika uppgifter | Maximal flexibilitet |

| Infrastruktur | Standard molnresurser | Specialiserade hårdvarukluster |

Finjustering har blivit en avgörande förmåga för organisationer som vill implementera AI-lösningar som ger konkurrensfördelar. Genom att anpassa förtränade modeller till din specifika affärskontext kan du skapa AI-system som förstår din branschterminologi, kundpreferenser och operativa krav med imponerande precision. Denna anpassning gör det möjligt för företag att uppnå prestandanivåer som generiska, färdiga modeller helt enkelt inte kan matcha, särskilt inom specialiserade områden som sjukvård, juridiska tjänster eller teknisk support. Finjusteringens kostnadseffektivitet innebär att även mindre organisationer nu kan få tillgång till AI-kapacitet på företagsnivå utan stora infrastrukturinvesteringar. Dessutom kan finjusterade modeller implementeras snabbare, vilket gör det möjligt för företag att snabbt svara på marknadsmöjligheter och konkurrenstryck. Möjligheten att kontinuerligt förbättra modeller genom att finjustera dem på ny data säkerställer att dina AI-system förblir relevanta och effektiva i takt med att affärsförutsättningarna förändras.

Viktiga affärsfördelar med finjustering:

Flera etablerade tekniker har vuxit fram som bästa praxis inom finjustering, var och en med olika fördelar beroende på dina specifika krav. Full finjustering innebär att alla parametrar i den förtränade modellen uppdateras, vilket ger maximal flexibilitet och ofta bäst prestanda, men kräver betydande beräkningsresurser och större datamängder för att undvika överanpassning. Parameter-effektiva finjusteringsmetoder som LoRA (Low-Rank Adaptation) och QLoRA har revolutionerat området genom att möjliggöra effektiv anpassning av modellen samtidigt som endast en liten andel av parametrarna uppdateras, vilket dramatiskt minskar minneskraven och träningstiden. Dessa tekniker fungerar genom att lägga till träningsbara låg-rank-matriser till modellens viktmatriser, vilket fångar uppgiftsrelaterade anpassningar utan att ändra de ursprungliga förtränade vikterna. Adaptermoduler är ett annat tillvägagångssätt där små träningsbara nätverk införs mellan lagren i den frusna förtränade modellen, vilket möjliggör effektiv finjustering med minimalt antal extra parametrar. Prompt-baserad finjustering fokuserar på att optimera inmatningsprompter snarare än modellvikter, användbart för modeller där parameteråtkomst är begränsad. Instruktionsfinjustering tränar modeller att följa specifika instruktioner och kommandon, särskilt viktigt för stora språkmodeller som behöver svara korrekt på olika användarförfrågningar. Valet mellan dessa tekniker beror på dina beräkningsbegränsningar, datamängd, prestandakrav och den specifika modellarkitektur du arbetar med.

Finjustering av stora språkmodeller (LLM:er) innebär unika möjligheter och utmaningar jämfört med finjustering av mindre modeller eller andra typer av neurala nätverk. Moderna LLM:er som GPT-liknande modeller innehåller miljarder parametrar, vilket gör full finjustering beräkningsmässigt orealistiskt för de flesta organisationer. Detta har drivit på användningen av parameter-effektiva tekniker som möjliggör effektiv anpassning av LLM:er utan krav på infrastruktur i företagsklass. Instruktionsfinjustering har blivit särskilt viktig för LLM:er, där modeller tränas på exempel med instruktioner ihop med högkvalitativa svar, vilket gör att de kan följa användardirektiv mer effektivt. Reinforcement Learning from Human Feedback (RLHF) representerar en avancerad finjusteringsteknik där modeller ytterligare förbättras baserat på mänskliga preferenser och utvärderingar, vilket förbättrar överensstämmelsen med mänskliga värderingar och förväntningar. Den relativt lilla mängd uppgiftsspecifik data som krävs för att finjustera LLM:er – ofta bara hundratals eller tusentals exempel – gör denna metod tillgänglig även för organisationer utan stora märkta datamängder. Finjustering av LLM:er kräver dock noggrann uppmärksamhet på val av hyperparametrar, inlärningstakt och förebyggande av katastrofalt glömska, där modellen tappar tidigare inlärda förmågor när den anpassas till nya uppgifter.

Organisationer inom olika branscher har upptäckt kraftfulla tillämpningar för finjusterade AI-modeller som ger mätbart affärsvärde. Automatiserad kundservice är ett av de vanligaste användningsområdena, där modeller finjusteras på företagsspecifika supportärenden, produktinformation och kommunikationsstilar för att skapa chattbotar som hanterar kundförfrågningar med domänkunskap och varumärkeskonsistens. Medicinsk och juridisk dokumentanalys drar nytta av finjustering för att anpassa generella språkmodeller till att förstå specialiserad terminologi, regulatoriska krav och branschspecifika format, vilket möjliggör korrekt informationsutvinning och klassificering. Sentimentanalys och innehållsmoderering kan förbättras avsevärt genom att finjustera modeller på exempel från din specifika bransch eller gemenskap, vilket fångar nyanserade språkstrukturer och kontext som generiska modeller missar. Kodgenerering och mjukvaruutvecklingsstöd gynnas av finjustering på din organisations kodbas, programmeringskonventioner och arkitekturmönster, vilket möjliggör AI-verktyg som genererar kod i linje med era standarder. Rekommendationssystem finjusteras ofta på användarbeteendedata och produktkataloger för att leverera personliga förslag som ökar engagemang och intäkter. Namngiven entityigenkänning och informationsutvinning från domänspecifika dokument – som finansiella rapporter, vetenskapliga artiklar eller tekniska specifikationer – kan förbättras dramatiskt via finjustering på relevanta exempel. Dessa varierade tillämpningar visar att finjustering inte är begränsat till en viss bransch eller ett visst användningsområde, utan snarare är en grundläggande kapacitet för att skapa AI-system som ger konkurrensfördelar inom praktiskt taget varje affärsområde.

Finjusteringsprocessen följer ett strukturerat arbetsflöde som börjar med noggrann förberedelse och sträcker sig till implementering och övervakning. Datapreparering är det kritiska första steget, där du samlar in, rengör och formaterar din domänspecifika datamängd så att den matchar in- och utmatningsstrukturen som den förtränade modellen förväntar sig. Denna datamängd bör vara representativ för de uppgifter din finjusterade modell ska lösa i produktion, och kvalitet är viktigare än kvantitet – en mindre datamängd med högkvalitativa exempel ger oftast bättre resultat än en större med inkonsekventa eller brusiga etiketter. Träning/validering/test-uppdelning säkerställer att du kan utvärdera modellens prestanda korrekt, med typiska fördelningar av 70–80% för träning, 10–15% för validering och 10–15% för test. Val av hyperparametrar innebär att välja inlärningstakt, batchstorlekar, antal träningsgenomgångar och andra parametrar som styr finjusteringsprocessen; dessa val påverkar både prestanda och träningseffektivitet avsevärt. Modellinitiering använder de förtränade vikterna som utgångspunkt, bevarar grundläggande kunskap och tillåter parametrarna att anpassas till din specifika uppgift. Träningsutförande innebär att iterativt uppdatera modellparametrarna på din träningsdata samtidigt som du övervakar valideringsprestandan för att upptäcka överanpassning. Utvärdering och iteration använder din testmängd för att bedöma slutlig prestanda och avgöra om ytterligare finjustering, andra hyperparametrar eller mer träningsdata skulle förbättra resultaten. Implementeringsförberedelse inkluderar att optimera modellen för inferenshastighet och resurseffektivitet, eventuellt via kvantisering eller distillationstekniker. Slutligen säkerställer övervakning och underhåll i produktion att modellen fortsätter att prestera bra när datadistributionen förändras över tid, med periodisk omträning på ny data för att bibehålla noggrannheten.

Finjustering, även om det är mer effektivt än träning från grunden, innebär egna utmaningar som praktiker måste hantera noggrant. Överanpassning inträffar när modeller memorerar träningsdata istället för att lära sig generaliserbara mönster, särskilt riskabelt vid finjustering på små datamängder; detta kan motverkas med tekniker som tidig stoppning, regularisering och dataaugmentation. Katastrofalt glömska uppstår när finjustering gör att modeller tappar tidigare inlärda förmågor, särskilt problematiskt vid anpassning av allmänna modeller till specialiserade uppgifter; noggrant val av inlärningstakt och tekniker som knowledge distillation hjälper till att bevara grundläggande kunskap. Datakvalitet och märkning är betydande praktiska utmaningar, eftersom finjustering kräver högkvalitativa märkta exempel som korrekt representerar din mål-domän och användningsfall. Hantering av beräkningsresurser kräver en balans mellan prestandaförbättringar och träningstid samt infrastrukturkostnader, särskilt viktigt vid arbete med stora modeller. Hyperparametrars känslighet innebär att finjusteringsprestanda kan variera dramatiskt beroende på inlärningstakt, batchstorlek och andra inställningar, vilket kräver systematisk experimentering och validering.

Bästa praxis för framgångsrik finjustering:

Organisationer ställs ofta inför valet mellan tre kompletterande tillvägagångssätt för att anpassa AI-modeller till specifika uppgifter: finjustering, Retrieval-Augmented Generation (RAG) och prompt engineering. Prompt engineering innebär att skapa noggrant formulerade instruktioner och exempel för att styra modellens beteende utan att ändra själva modellen; detta går snabbt och kräver ingen träning, men har begränsad effekt för komplexa uppgifter och kan inte lära modeller genuint ny information. RAG förbättrar modellens svar genom att hämta relevanta dokument eller data från externa källor innan svar genereras, vilket gör att modeller kan få tillgång till aktuell information och domänspecifik kunskap utan parameteruppdateringar; detta fungerar bra för kunskapsintensiva uppgifter men adderar latenstid och komplexitet vid inferens. Finjustering ändrar modellens parametrar för att djupt inarbeta uppgiftsspecifik kunskap och mönster, vilket ger bäst prestanda för väldefinierade uppgifter med tillräcklig träningsdata, men kräver mer tid och beräkningsresurser än de andra metoderna. Den optimala lösningen innebär ofta att kombinera dessa tekniker: använda prompt engineering för snabb prototypframtagning, RAG för kunskapsintensiva applikationer och finjustering för prestandakritiska system där investeringen i träning är motiverad. Finjustering är bäst när du behöver konsekvent, högpresterande beteende på specifika uppgifter, har tillräcklig träningsdata och när prestandavinsterna motiverar utvecklingsinsatsen. RAG fungerar bäst för applikationer som kräver tillgång till aktuell eller proprietär information som ofta förändras. Prompt engineering är en utmärkt startpunkt för utforskning och prototypande innan du satsar på mer resurskrävande tillvägagångssätt. Att förstå styrkor och begränsningar hos varje metod gör det möjligt för organisationer att fatta informerade beslut om vilka tekniker som ska användas för olika delar av sina AI-system.

Transfer learning är det bredare konceptet att utnyttja kunskap från en uppgift för att förbättra prestandan på en annan, medan finjustering är en specifik implementering av transfer learning. Finjustering tar en förtränad modell och justerar dess parametrar på ny data, medan transfer learning även kan inkludera feature extraction där du fryser de förtränade vikterna och bara tränar nya lager. All finjustering innebär transfer learning, men all transfer learning kräver inte finjustering.

Tiden för finjustering varierar kraftigt beroende på modellstorlek, datamängd och tillgänglig hårdvara. Med parameter-effektiva tekniker som LoRA kan en modell med 13 miljarder parametrar finjusteras på cirka 5 timmar på ett enda A100-GPU. Mindre modeller eller parameter-effektiva metoder kan ta bara några timmar, medan full finjustering av större modeller kan ta dagar eller veckor. Den största fördelen är att finjustering går dramatiskt snabbare än träning från grunden, vilket kan ta månader.

Ja, finjustering är specifikt utformad för att fungera effektivt med begränsad data. Förtränade modeller har redan lärt sig generella mönster, så du behöver vanligtvis bara hundratals till tusentals exempel för effektiv finjustering, jämfört med miljontals som krävs för träning från grunden. Men datakvalitet är viktigare än mängd – en mindre datamängd med högkvalitativa, representativa exempel ger bättre resultat än en större datamängd med inkonsekventa eller brusiga etiketter.

LoRA (Low-Rank Adaptation) är en parameter-effektiv finjusteringsteknik som lägger till träningsbara låg-rank-matriser till en modells viktmatriser istället för att uppdatera alla parametrar. Detta tillvägagångssätt minskar antalet träningsbara parametrar med tusentals gånger samtidigt som prestandan är jämförbar med full finjustering. LoRA är viktigt eftersom det gör finjustering tillgängligt på standardhårdvara, minskar minneskraven dramatiskt och gör det möjligt för organisationer att finjustera stora modeller utan dyr infrastruktur.

Överanpassning uppstår när träningsförlusten minskar men valideringsförlusten ökar, vilket indikerar att modellen memorerar träningsdata istället för att lära sig generaliserbara mönster. Övervaka båda mätvärdena under träningen – om valideringsprestandan planar ut eller försämras medan träningsprestandan fortsätter att förbättras, överanpassar din modell troligen. Använd tidig stoppning för att avbryta träningen när valideringsprestandan slutar förbättras, och använd tekniker som regularisering och dataaugmentation för att motverka överanpassning.

Kostnaderna för finjustering inkluderar beräkningsresurser (GPU/TPU-tid), datapreparering och märkning, lagring och infrastruktur för modellutplacering samt kontinuerlig övervakning och underhåll. Dessa kostnader är dock vanligtvis 10–100 gånger lägre än att träna modeller från grunden. Med parameter-effektiva tekniker som LoRA kan de beräkningsmässiga kostnaderna minskas med 80–90% jämfört med full finjustering, vilket gör finjustering till ett ekonomiskt tillvägagångssätt för de flesta organisationer.

Ja, finjustering förbättrar vanligtvis modellens noggrannhet avsevärt för specifika uppgifter. Genom att träna på domänspecifik data lär sig modeller uppgiftsrelevanta mönster och terminologi som generiska modeller missar. Studier visar att finjustering kan förbättra noggrannheten med 10–30% eller mer beroende på uppgift och datakvalitet. Förbättringen är mest dramatisk när finjusteringsuppgiften skiljer sig från förträningsuppgiften, eftersom modellen då anpassar sina inlärda funktioner till dina specifika krav.

Finjustering gör det möjligt för organisationer att behålla känslig data på sin egen infrastruktur istället för att skicka den till tredjeparts-API:er. Du kan finjustera modeller lokalt på egen eller reglerad data utan att exponera den för externa tjänster, vilket säkerställer efterlevnad av dataskyddsförordningar som GDPR, HIPAA eller branschspecifika krav. Detta tillvägagångssätt ger både säkerhets- och efterlevnadsfördelar samtidigt som du behåller prestandafördelarna med att använda förtränade modeller.

Spåra hur AI-system som GPTs, Perplexity och Google AI Overviews citerar och refererar till ditt varumärke med AmICiteds AI-övervakningsplattform.

Definition av finjustering: anpassning av förtränade AI-modeller för specifika uppgifter genom domänspecifik träning. Lär dig hur finjustering förbättrar modell...

Lär dig hur du kan begära rättelser från AI-plattformar som ChatGPT, Perplexity och Claude. Förstå korrigeringsmekanismer, feedbackprocesser och strategier för ...

Modellparametrar är lärbara variabler i AI-modeller som avgör beteende. Förstå vikter, biaser och hur parametrar påverkar AI-modellers prestanda och träning....

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.