Hur du konfigurerar robots.txt för AI-crawlers: Komplett guide

Lär dig hur du konfigurerar robots.txt för att kontrollera AI-crawler-åtkomst, inklusive GPTBot, ClaudeBot och Perplexity. Hantera din varumärkesexponering i AI...

Konfiguration av robots.txt med användaragentsregler som specifikt riktar sig mot AI-crawlers. AI-specifik robots.txt gör det möjligt för webbplatsägare att kontrollera hur artificiella intelligenssystem, stora språkmodeller och AI-träningsbotar får tillgång till och använder deras innehåll. Den skiljer mellan olika typer av AI-crawlers—träningscrawlers, sökcrawlers och användarinitierade hämtare—vilket möjliggör detaljerad kontroll över innehållets synlighet för AI-system. Denna konfiguration har blivit avgörande eftersom AI-crawlers nu står för cirka 80 % av bottrafiken till många webbplatser.

Konfiguration av robots.txt med användaragentsregler som specifikt riktar sig mot AI-crawlers. AI-specifik robots.txt gör det möjligt för webbplatsägare att kontrollera hur artificiella intelligenssystem, stora språkmodeller och AI-träningsbotar får tillgång till och använder deras innehåll. Den skiljer mellan olika typer av AI-crawlers—träningscrawlers, sökcrawlers och användarinitierade hämtare—vilket möjliggör detaljerad kontroll över innehållets synlighet för AI-system. Denna konfiguration har blivit avgörande eftersom AI-crawlers nu står för cirka 80 % av bottrafiken till många webbplatser.

AI-specifik robots.txt-konfiguration avser praktiken att skapa riktade regler i din robots.txt-fil som specifikt adresserar artificiella intelligens-crawlers och träningsbotar, skilda från traditionella sökmotorcrawlers som Googlebot. Medan konventionell robots.txt historiskt har fokuserat på att hantera Googlebot, Bingbot och andra sökindexeringsbotar, har framväxten av stora språkmodeller och AI-träningssystem skapat en helt ny kategori av bottrafik som kräver separata hanteringsstrategier. Enligt färsk data från november 2025 står AI-crawlers nu för cirka 80 % av all bottrafik till många publicisters webbplatser, vilket fundamentalt förändrar vikten av robots.txt-konfiguration från ett trevligt SEO-verktyg till en kritisk mekanism för innehållsskydd. Skillnaden är viktig eftersom AI-träningscrawlers verkar enligt andra affärsmodeller än sökmotorer—de samlar in data för att träna egna modeller snarare än att driva hänvisningstrafik—vilket gör det traditionella utbytet mellan att tillåta crawlers för sökbarhet inte längre är giltigt. För publicister innebär detta att robots.txt-beslut nu direkt påverkar innehållets synlighet för AI-system, potentiell obehörig användning av eget innehåll i träningsdatamängder och de övergripande trafik- och intäktskonsekvenserna av AI-upptäckt.

AI-crawlers faller in i tre distinkta operationella kategorier, var och en med olika egenskaper, trafikpåverkan och strategiska överväganden för publicister. Träningscrawlers är utformade för att samla in stora mängder textdata för maskininlärningsmodellutveckling; de arbetar vanligtvis med höga bandbreddskrav, genererar betydande serverbelastning och ger ingen hänvisningstrafik tillbaka—exempel är OpenAI:s GPTBot och Anthropics ClaudeBot. Sök- och citeringscrawlers fungerar likt traditionella sökmotorer genom att indexera innehåll för återhämtning och ge attribution; de genererar måttliga trafikvolymer och kan driva hänvisningstrafik via citeringar och länkar—denna kategori omfattar OpenAI:s OAI-SearchBot och Googles AI Overviews-crawler. Användarinitierade crawlers arbetar på begäran när slutanvändare uttryckligen efterfrågar AI-analys av en webbsida, såsom ChatGPT:s möjlighet att surfa på webben eller Claudes dokumentanalysfunktioner; dessa genererar lägre trafikvolymer men representerar direkt användarengagemang med ditt innehåll. Kategoriseringen är strategiskt viktig eftersom träningscrawlers utgör störst risk för innehållsskydd med minimal affärsnytta, sökcrawlers erbjuder en medelväg med viss hänvisningspotential och användarinitierade crawlers ofta ligger i linje med användarens avsikt och kan öka synligheten för innehållet.

| Crawlerkategori | Syfte | Trafikvolym | Hänvisningspotential | Innehållsrisk | Exempel |

|---|---|---|---|---|---|

| Träning | Modellutveckling | Mycket hög | Ingen | Mycket hög | GPTBot, ClaudeBot |

| Sök/Citering | Innehållsindexering & attribution | Måttlig | Måttlig | Måttlig | OAI-SearchBot, Google AI |

| Användarinitierad | Efterfrågad analys | Låg | Låg | Låg | ChatGPT Web Browse, Claude |

De stora AI-företagen som driver crawlers inkluderar OpenAI, Anthropic, Google, Meta, Apple och Amazon, alla med särskilda användaragents-strängar som möjliggör identifiering i serverloggar och robots.txt-konfiguration. OpenAI driver flera crawlers: GPTBot (user-agent: GPTBot/1.0) för insamling av träningsdata, OAI-SearchBot (user-agent: OAI-SearchBot/1.0) för sök- och citeringsindexering och ChatGPT-User (user-agent: ChatGPT-User/1.0) för användarinitierad webb-browsing. Anthropics primära crawler är ClaudeBot (user-agent: Claude-Web/1.0 eller anthropic-ai) som används för träning och kunskapsbasutveckling. Google driver Google-Extended (user-agent: Google-Extended/1.1) för Gemini och andra AI-produkter, medan Meta använder facebookexternalhit för innehållsanalys, Apple driver AppleBot för Siri och sökfunktioner, och Amazon använder Amazonbot för Alexa och sökfunktioner. För att identifiera dessa crawlers i dina serverloggar, kontrollera User-Agent-headern i HTTP-förfrågningar—de flesta legitima AI-crawlers inkluderar sitt företagsnamn och versionsnummer i detta fält. För ökad säkerhet kan du verifiera crawlerns legitimitet genom att kontrollera den begärande IP-adressen mot publicerade IP-intervall från respektive företag; OpenAI publicerar sina crawler-IP-intervall, liksom Google och andra större aktörer, vilket gör det möjligt att särskilja legitima crawlers från förfalskade användaragents.

Den grundläggande syntaxen för AI-specifika robots.txt-regler följer standardformatet för robots.txt med användaragent-matchning och allow/disallow-direktiv riktade mot specifika crawlers. För att blockera OpenAI:s GPTBot från att samla träningsdata samtidigt som deras sökcrawler tillåts, skulle du strukturera din robots.txt så här:

User-agent: GPTBot

Disallow: /

User-agent: OAI-SearchBot

Allow: /

För mer detaljerad kontroll kan du tillämpa sökvägsspecifika regler som blockerar vissa sektioner men tillåter andra—t.ex. att blockera AI-crawlers från att komma åt ditt betalväggsinnehåll eller användargenererade innehållssektioner:

User-agent: GPTBot

Disallow: /premium/

Disallow: /user-content/

Allow: /public-articles/

User-agent: ClaudeBot

Disallow: /

Du kan gruppera flera användaragents under en och samma regeluppsättning för att tillämpa identiska restriktioner på flera crawlers, vilket minskar konfigurationskomplexiteten. Testning och validering av din robots.txt-konfiguration är avgörande; verktyg som Google Search Consoles robots.txt-tester och tredjepartsvaliderare kan verifiera att dina regler är syntaktiskt korrekta och tolkas som avsett av crawlers. Kom ihåg att robots.txt är rådgivande snarare än tvingande—kompatibla crawlers kommer att respektera dessa regler, men illasinnade aktörer eller icke-kompatibla botar kan ignorera dem helt, vilket kräver ytterligare åtgärder på servernivå för känsligt innehåll.

Beslutet att blockera eller tillåta AI-crawlers innebär grundläggande avvägningar mellan innehållsskydd och synlighet som varierar kraftigt beroende på din affärsmodell och innehållsstrategi. Att blockera träningscrawlers som GPTBot eliminerar helt risken att ditt innehåll används för att träna egna AI-modeller utan ersättning, men det innebär också att ditt innehåll inte kommer att synas i AI-genererade svar, vilket potentiellt minskar upptäckt och trafik från användare som interagerar med AI-system. Att tillåta träningscrawlers ökar sannolikheten att ditt innehåll införlivas i AI-träningsdatamängder, eventuellt utan attribution eller ersättning, men det kan öka synligheten om AI-systemen i slutändan citerar eller refererar till ditt innehåll. Det strategiska beslutet bör ta hänsyn till ditt innehålls konkurrensfördel—egen forskning, originalanalyser och unik data motiverar striktare blockering, medan evigt utbildningsinnehåll eller generisk information kan gynnas av bredare AI-synlighet. Olika publicisttyper har olika kalkyler: nyhetsorganisationer kan tillåta sökcrawlers för citeringstrafik men blockera träningscrawlers, utbildningspublicister kan tillåta bredare åtkomst för ökad räckvidd, och SaaS-företag kan blockera alla AI-crawlers för att skydda egen dokumentation. Övervakning av effekterna av dina blockeringsbeslut via serverloggar och trafikstatistik är avgörande för att verifiera att din konfiguration ger de affärsresultat du vill uppnå.

Även om robots.txt tillhandahåller en tydlig mekanism för att kommunicera crawlerpolicyer är den i grunden rådgivande och inte juridiskt bindande—kompatibla crawlers respekterar dina regler, men icke-kompatibla aktörer kan helt ignorera dem, vilket kräver ytterligare tekniska verkställighetslager. IP-verifiering och allowlisting är den mest pålitliga verkställighetsmetoden; genom att hålla en lista över legitima IP-adresser som publiceras av OpenAI, Google, Anthropic och andra stora AI-företag kan du verifiera att förfrågningar som påstår sig komma från dessa crawlers faktiskt kommer från deras infrastruktur. Brandväggsregler och blockering på servernivå ger den starkaste verkställighetsmekanismen och gör att du kan avvisa förfrågningar från specifika användaragents eller IP-intervall på nätverksnivå innan de förbrukar serverresurser. För Apache-servrar kan .htaccess-konfiguration verkställa crawlerbegränsningar:

<IfModule mod_rewrite.c>

RewriteEngine On

RewriteCond %{HTTP_USER_AGENT} GPTBot [NC]

RewriteRule ^.*$ - [F,L]

</IfModule>

Meta-taggar i din HTML-head ger detaljerad kontroll på sidnivå över crawler-åtkomst utan att ändra robots.txt:

<meta name="robots" content="noindex, noimageindex, nofollowbyai">

Regelbunden kontroll av serverloggar för crawleraktivitet gör det möjligt att identifiera nya crawlers, verifiera att dina regler följs och upptäcka förfalskade användaragents som försöker kringgå dina restriktioner. Verktyg som Knowatoa och Merkle erbjuder automatiserad validering och övervakning av din robots.txt-konfiguration och crawlerbeteende, vilket ger insyn i vilka crawlers som besöker din webbplats och om de följer dina direktiv.

Löpande underhåll av din AI-specifika robots.txt-konfiguration är avgörande eftersom landskapet för AI-crawlers snabbt förändras, med nya crawlers som ständigt dyker upp och befintliga crawlers som ändrar sina användaragents och beteendemönster. Din övervakningsstrategi bör inkludera:

Den snabba utvecklingen inom AI-crawlerteknik innebär att en robots.txt-konfiguration som var lämplig för sex månader sedan kanske inte längre speglar dina aktuella behov eller hotbilden, varför regelbunden översyn och anpassning är avgörande för att upprätthålla ett effektivt innehållsskydd.

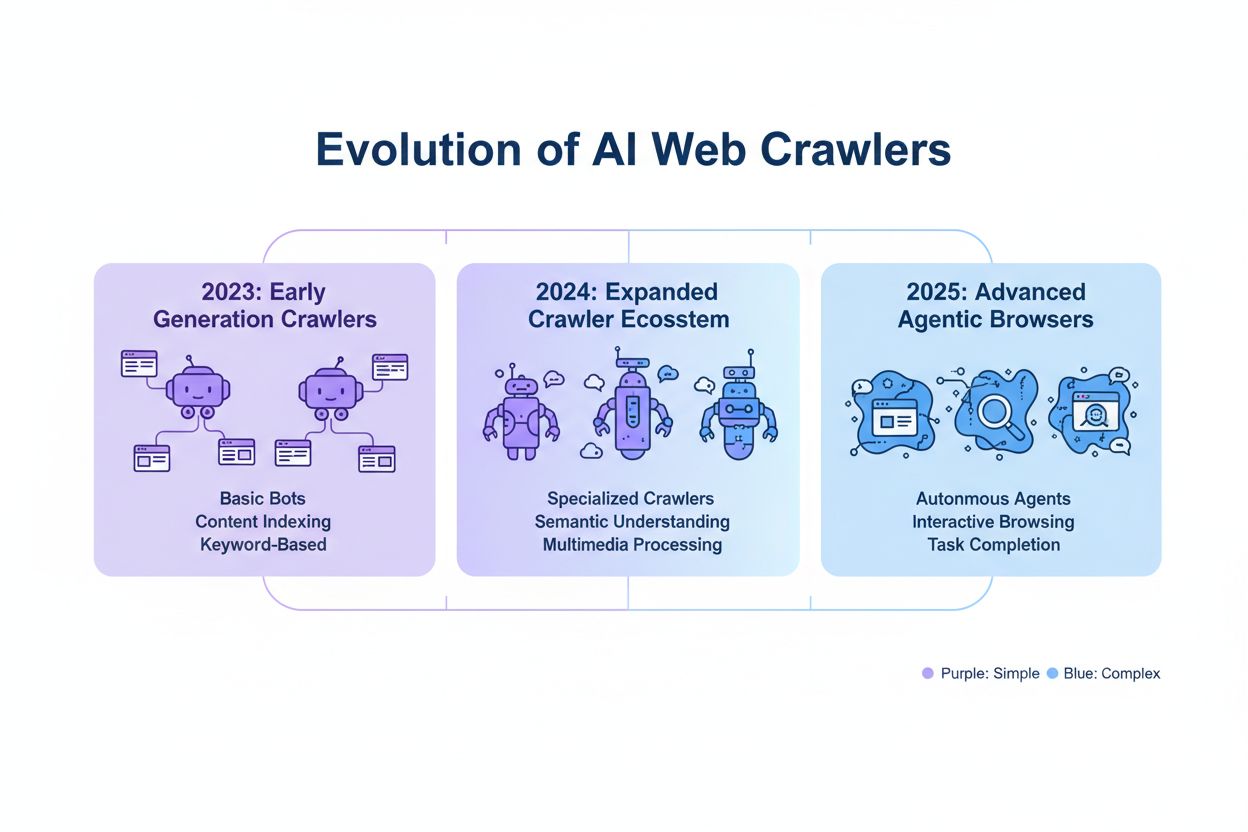

Nästa generation AI-crawlers medför nya utmaningar som traditionell robots.txt-konfiguration kanske inte kan hantera effektivt. Agentiska webbläsarcrawlers som ChatGPT Atlas och Google Project Mariner fungerar som fullfjädrade webbläsare snarare än enkla HTTP-klienter, renderar JavaScript, utför användarinteraktioner och beter sig omöjligt att särskilja från mänskliga användare—dessa crawlers kanske inte identifierar sig med särskilda användaragents, vilket gör robots.txt-baserad blockering ineffektiv. Många nya crawlers använder standardiserade Chrome-användaragents för att undvika upptäckt och blockering, och döljer medvetet sin identitet för att kringgå robots.txt-regler och andra åtkomstkontroller. Denna trend driver ett skifte mot IP-baserad blockering som en nödvändighet, där publicister måste upprätthålla allowlists av legitima crawler-IP-adresser och blockera all annan trafik från misstänkta källor, vilket fundamentalt ändrar verkställighetsmodellen från användaragent-matchning till nätverksnivåkontroll. Förfalskade användaragents och kringgående tekniker blir allt vanligare, med aktörer som utger sig för att vara legitima crawlers eller använder generiska användaragents för att undvika upptäckt. Framtiden för AI-crawlerhantering kommer sannolikt kräva ett flerskiktat tillvägagångssätt som kombinerar robots.txt-konfiguration, IP-verifiering, brandväggsregler och eventuellt beteendeanalys för att särskilja legitima crawlers från illvilliga aktörer. Att hålla sig uppdaterad kring nya crawlertekniker och delta i branschdiskussioner om crawleretik och standarder är avgörande för publicister som vill upprätthålla effektiva innehållsskyddsstrategier.

Att implementera en effektiv AI-specifik robots.txt-konfiguration kräver ett omfattande tillvägagångssätt som balanserar innehållsskydd med strategiska synlighetsmål. Börja med en tydlig policy för innehållsskydd som definierar vilka innehållskategorier som måste blockeras (egen forskning, premiuminnehåll, användargenererat innehåll) jämfört med vad som kan exponeras för AI-crawlers (offentliga artiklar, utbildningsinnehåll, generisk information). Implementera en trappstegsbaserad blockeringsstrategi som skiljer mellan träningscrawlers (blockera oftast), sökcrawlers (vanligtvis tillåt med övervakning) och användarinitierade crawlers (vanligtvis tillåt), istället för att tillämpa en generell tillåt/blockera-policy för alla AI-crawlers. Kombinera robots.txt med servernivåskydd genom att införa brandväggsregler och IP-verifiering för ditt mest känsliga innehåll, med insikten att robots.txt ensam inte räcker för starkt innehållsskydd. Integrera AI-crawlerhantering i din övergripande SEO- och innehållsstrategi genom att beakta hur blockeringsbeslut påverkar din synlighet i AI-genererade svar, citeringar och AI-drivna sökfunktioner—denna integration säkerställer att din robots.txt-konfiguration stöder snarare än underminerar dina affärsmål. Upprätta en rutin för övervakning och underhåll med veckovisa logggranskningar, månatlig IP-verifiering och kvartalsvisa omfattande revisioner för att säkerställa att din konfiguration förblir effektiv i takt med att crawlerlandskapet utvecklas. Använd verktyg som AmICited.com för att övervaka ditt innehålls synlighet i AI-system och förstå effekten av dina blockeringsbeslut på AI-upptäckt och citering. För olika publicisttyper: nyhetsorganisationer bör oftast tillåta sökcrawlers men blockera träningscrawlers för att maximera citeringstrafik; utbildningspublicister kan överväga bredare tillgång för ökad räckvidd; och SaaS-företag bör implementera strikt blockering för egen dokumentation. När robots.txt-blockering inte räcker på grund av förfalskade användaragents eller icke-kompatibla crawlers, gå vidare till brandväggsregler och IP-baserad blockering för att verkställa dina innehållsskyddspolicys på nätverksnivå.

Träningscrawlers som GPTBot och ClaudeBot samlar in data för modellutveckling och ger ingen hänvisningstrafik, vilket gör dem till en högrisk för innehållsskydd. Sökmotorcrawlers som OAI-SearchBot och PerplexityBot indexerar innehåll för AI-drivna sökningar och kan skicka hänvisningstrafik via citeringar. De flesta publicister blockerar träningscrawlers men tillåter sökcrawlers för att balansera innehållsskydd med synlighet.

Google anger officiellt att blockering av Google-Extended inte påverkar sökrankningen eller inkluderingen i AI Overviews. Vissa webbansvariga har dock uttryckt oro, så övervaka din sökprestanda efter att ha implementerat blockeringar. AI Overviews i Google Sök följer standardregler för Googlebot, inte Google-Extended.

Ja, robots.txt är rådgivande snarare än tvingande. Välskötta crawlers från stora företag respekterar vanligtvis robots.txt-direktiv, men vissa crawlers ignorerar dem. För starkare skydd, implementera blockering på servernivå via .htaccess eller brandväggsregler, och verifiera legitima crawlers med publicerade IP-adressintervall.

Granska och uppdatera din blocklista minst varje kvartal. Nya AI-crawlers dyker upp regelbundet, så kontrollera serverloggar varje månad för att identifiera nya crawlers som besöker din webbplats. Följ communityresurser som ai.robots.txt GitHub-projektet för uppdateringar om nya crawlers och användaragentssträngar.

Detta beror på dina affärsprioriteringar. Att blockera träningscrawlers skyddar ditt innehåll från att användas i AI-modeller utan ersättning. Att blockera sökcrawlers kan minska din synlighet i AI-drivna plattformar som ChatGPT-sök eller Perplexity. Många publicister väljer selektiv blockering som riktar sig mot träningscrawlers men tillåter sök- och citeringscrawlers.

Kontrollera dina serverloggar efter crawler-användaragents och verifiera att blockerade crawlers inte får åtkomst till dina innehållssidor. Använd analysverktyg för att övervaka bot-trafikmönster. Testa din konfiguration med Knowatoa AI Search Console eller Merkle robots.txt Tester för att bekräfta att dina regler fungerar som avsett.

Agentiska webbläsarcrawlers som ChatGPT Atlas och Google Project Mariner fungerar som fullfjädrade webbläsare snarare än enkla HTTP-klienter. De använder ofta standardiserade Chrome-användaragents, vilket gör dem omöjliga att särskilja från vanlig webbläsartrafik. IP-baserad blockering blir nödvändig för att kontrollera åtkomst för dessa avancerade crawlers.

AI-specifik robots.txt styr åtkomst till ditt innehåll, medan verktyg som AmICited övervakar hur AI-plattformar refererar och citerar ditt innehåll. Tillsammans ger de fullständig insyn och kontroll: robots.txt hanterar crawler-åtkomst, och övervakningsverktyg spårar hur ditt innehåll påverkar AI-system.

AmICited spårar hur AI-system som ChatGPT, Claude, Perplexity och Google AI Overviews citerar och refererar till ditt varumärke. Kombinera robots.txt-konfiguration med AI-synlighetsövervakning för att förstå ditt innehålls påverkan över AI-plattformar.

Lär dig hur du konfigurerar robots.txt för att kontrollera AI-crawler-åtkomst, inklusive GPTBot, ClaudeBot och Perplexity. Hantera din varumärkesexponering i AI...

Diskussion i communityn om att konfigurera robots.txt för AI-crawlers som GPTBot, ClaudeBot och PerplexityBot. Riktiga erfarenheter från webbansvariga och SEO-s...

Diskussion i communityn om att låta AI-botar crawla din sajt. Verkliga erfarenheter av robots.txt-konfiguration, llms.txt-implementering och hantering av AI-cra...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.