Kontextfönster

Kontextfönster förklarat: det maximala antalet tokens en LLM kan bearbeta åt gången. Lär dig hur kontextfönster påverkar AI-noggrannhet, hallucinationer och var...

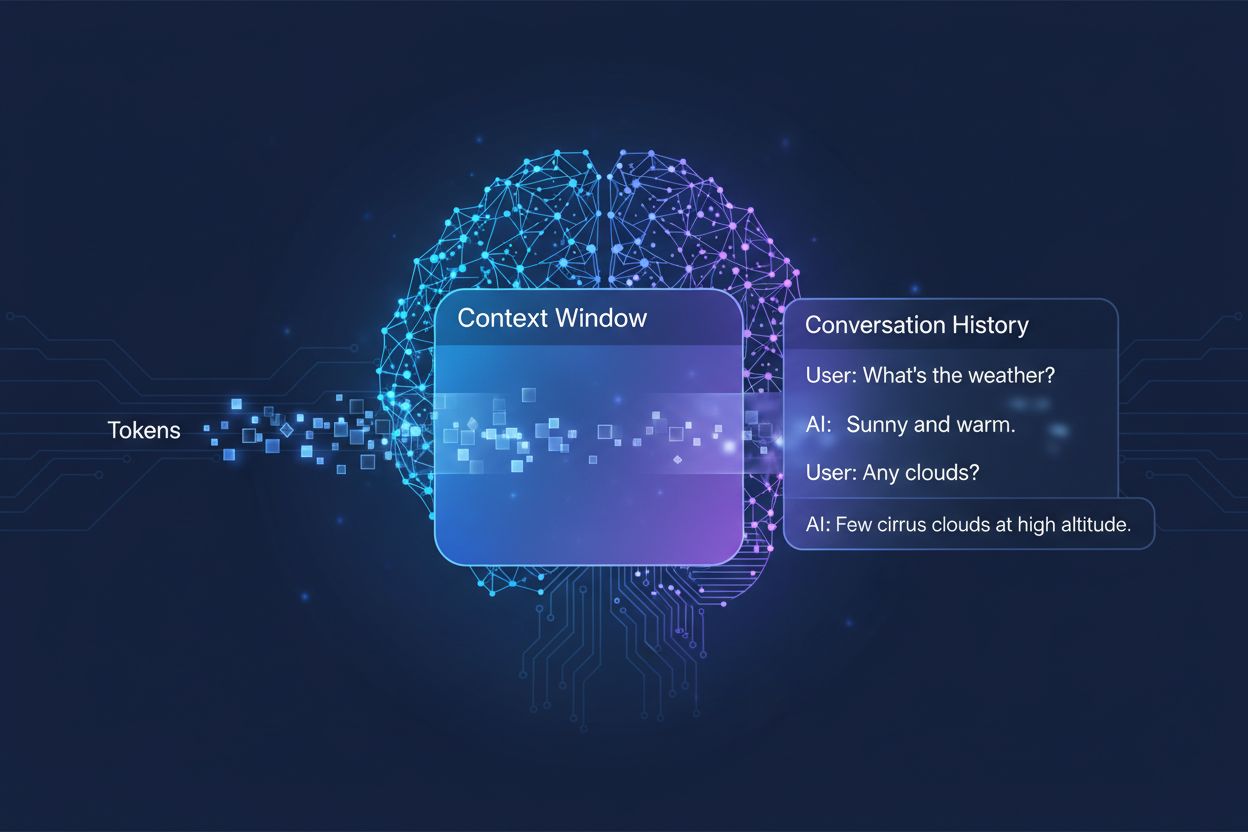

Mängden tidigare konversation som ett AI-system tar hänsyn till när det genererar svar, mätt i tokens. Det avgör hur mycket text ett AI kan bearbeta samtidigt och påverkar direkt kvaliteten och sammanhanget i dess resultat vid flervändiga samtal.

Mängden tidigare konversation som ett AI-system tar hänsyn till när det genererar svar, mätt i tokens. Det avgör hur mycket text ett AI kan bearbeta samtidigt och påverkar direkt kvaliteten och sammanhanget i dess resultat vid flervändiga samtal.

Ett kontextfönster är den maximala mängden text som en AI-språkmodell kan bearbeta och referera till vid ett och samma tillfälle under en konversation eller uppgift. Tänk på det som modellens arbetsminne—precis som människor bara kan hålla en begränsad mängd information i sitt omedelbara medvetande, kan AI-modeller bara “se” en viss mängd text före och efter sin nuvarande position. Denna kapacitet mäts i tokens, som är små textenheter som vanligtvis motsvarar ord eller orddelar (i genomsnitt motsvarar ett engelskt ord cirka 1,5 tokens). Att förstå din modells kontextfönster är avgörande eftersom det direkt avgör hur mycket information AI:n kan ta hänsyn till när den genererar svar, vilket gör det till en grundläggande begränsning för hur effektivt modellen kan hantera komplexa, flervändiga konversationer eller långa dokument.

Moderna språkmodeller, särskilt transformerbaserade arkitekturer, bearbetar text genom att konvertera den till tokens och sedan analysera relationerna mellan alla tokens inom kontextfönstret samtidigt. Transformer-arkitekturen, som introducerades i den banbrytande artikeln “Attention is All You Need” från 2017, använder en mekanism som kallas self-attention för att avgöra vilka delar av indata som är mest relevanta för varandra. Denna uppmärksamhetsmekanism gör att modellen kan väga vikten av olika tokens mot varandra, vilket gör det möjligt att förstå kontext och betydelse över hela fönstret. Denna process blir dock beräkningsmässigt dyr när kontextfönstret växer, eftersom uppmärksamhetsmekanismen måste beräkna relationer mellan varje token och varje annan token—ett kvadratiskt skalningsproblem. Tabellen nedan visar hur olika ledande AI-modeller jämförs vad gäller kapacitet för kontextfönster:

| Modell | Kontextfönster (tokens) | Lanseringsdatum |

|---|---|---|

| GPT-4 | 128 000 | mars 2023 |

| Claude 3 Opus | 200 000 | mars 2024 |

| Gemini 1.5 Pro | 1 000 000 | maj 2024 |

| GPT-4 Turbo | 128 000 | november 2023 |

| Llama 2 | 4 096 | juli 2023 |

Dessa varierande kapaciteter speglar olika designval och beräkningsmässiga kompromisser från varje organisation, där större fönster möjliggör mer sofistikerade tillämpningar men kräver mer processorkraft.

Utvecklingen mot större kontextfönster utgör ett av de mest betydelsefulla framstegen inom AI-kapacitet under det senaste decenniet. Tidiga rekurrenta neurala nätverk (RNN) och long short-term memory (LSTM)-modeller hade problem med kontext, eftersom de bearbetade text sekventiellt och hade svårt att behålla information från avlägsna delar av indata. Genombrottet kom 2017 med introduktionen av Transformer-arkitekturen, som möjliggjorde parallell bearbetning av hela sekvenser och dramatiskt förbättrade modellens förmåga att bibehålla kontext över längre texter. Detta lade grunden för GPT-2 (2019), som visade imponerande språkgenerering med ett kontextfönster på 1 024 tokens, följt av GPT-3 (2020) med 2 048 tokens och slutligen GPT-4 (2023) med 128 000 tokens. Varje framsteg har varit viktigt eftersom det utökat möjligheterna: större fönster har inneburit att modeller kan hantera längre dokument, bibehålla sammanhang i flervändiga konversationer och förstå nyanserade relationer mellan avlägsna begrepp i texten. Den exponentiella tillväxten i kontextfönstrets storlek återspeglar både förbättrade arkitektoniska innovationer och ökade beräkningsresurser hos ledande AI-labb.

Större kontextfönster utökar grundläggande vad AI-modeller kan åstadkomma och möjliggör tillämpningar som tidigare var omöjliga eller starkt begränsade. Här är de viktigaste fördelarna:

Förbättrad samtalskontinuitet: Modeller kan hålla reda på hela samtalshistoriker, vilket minskar behovet av att förklara kontext på nytt och möjliggör naturligare, sammanhängande flervändiga dialoger som känns genuint kontinuerliga istället för fragmenterade.

Dokumentbearbetning i stor skala: Större fönster gör det möjligt för AI att analysera hela dokument, forskningsrapporter eller kodbaser i ett enda slag, identifiera mönster och relationer i hela innehållet utan att tappa bort information från tidigare avsnitt.

Förbättrad slutledning och analys: Med mer tillgänglig kontext kan modeller utföra mer avancerade resonemangsuppgifter som kräver förståelse för relationer mellan flera begrepp, vilket gör dem mer effektiva för forskning, analys och komplex problemlösning.

Minskad overhead för kontextväxling: Användare behöver inte längre sammanfatta eller återinföra information upprepade gånger; modellen kan referera till hela samtalshistoriken, vilket minskar friktionen och ökar effektiviteten i samarbetsflöden.

Bättre hantering av nyanserade uppgifter: Tillämpningar som juridisk dokumentgranskning, analys av patientjournaler och kodgranskning gynnas betydligt av att kunna ta hänsyn till omfattande kontext, vilket leder till mer korrekta och grundliga resultat.

Sömlösa arbetsflöden med flera dokument: Yrkesverksamma kan arbeta med flera relaterade dokument samtidigt, vilket gör det möjligt för modellen att korsreferera information och identifiera samband som vore omöjliga med mindre kontextfönster.

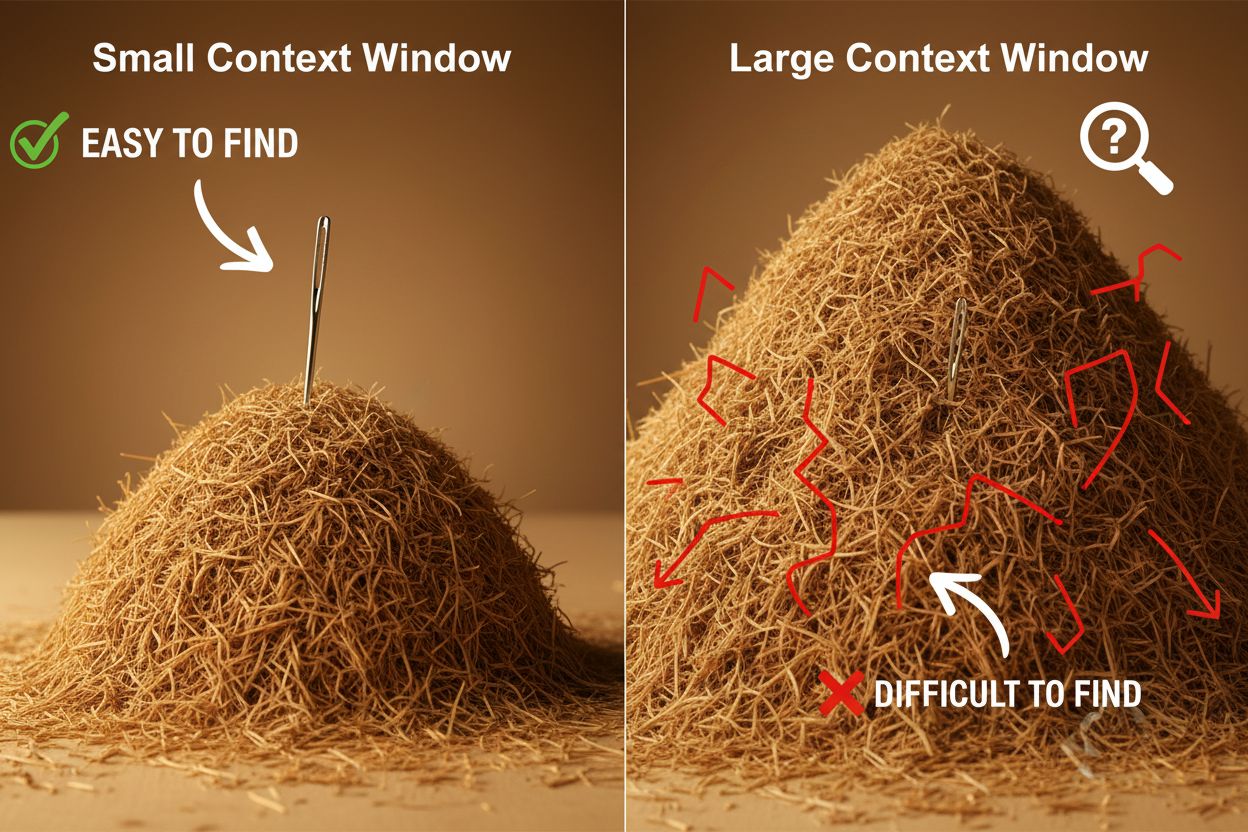

Trots sina fördelar innebär stora kontextfönster betydande tekniska och praktiska utmaningar som utvecklare och användare måste hantera noggrant. Den mest uppenbara utmaningen är beräkningskostnaden: att bearbeta längre sekvenser kräver exponentiellt mer minne och processorkraft på grund av den kvadratiska skalningen hos uppmärksamhetsmekanismen, vilket gör större kontextfönster avsevärt dyrare att köra. Detta ökade beräkningsbehov leder också till latensproblem, eftersom längre kontextfönster ger långsammare svarstider—en kritisk faktor för realtidsapplikationer där användare förväntar sig snabba svar. Ett annat, mer subtilt men viktigt problem är “nålen i höstacken”-fenomenet, där modeller har svårt att hitta och använda relevant information när den är begravd i ett mycket stort kontextfönster, ibland med sämre resultat än med mindre fönster. Dessutom uppstår kontextförfall när information från början av ett långt kontextfönster får minskat inflytande på modellens utdata, eftersom uppmärksamhetsmekanismen kan prioritera bort avlägsna tokens till förmån för mer nyliga. Dessa utmaningar innebär att det inte alltid är optimalt att maximera kontextfönstrets storlek för varje användningsområde.

Att förstå kontextförfall är avgörande för att arbeta effektivt med stora kontextfönster: när sekvenser blir längre tenderar tokens i början av kontexten att få allt mindre inflytande på modellens utdata, vilket innebär att viktig information i praktiken kan “glömmas bort” trots att den tekniskt sett finns inom fönstret. Detta beror på att uppmärksamhetsbudgeten—modellens kapacitet att meningsfullt ta hänsyn till alla tokens—blir utsträckt över ett större textspann. Lyckligtvis har flera sofistikerade tekniker utvecklats för att åtgärda dessa begränsningar. Retrieval-Augmented Generation (RAG) löser detta genom att lagra information i externa databaser och hämta endast de mest relevanta delarna vid behov, vilket effektivt ger modellen en större faktisk kunskapsbas utan att kräva ett massivt kontextfönster. Kompaktering av kontext innebär att sammanfatta eller komprimera mindre relevant information, så att de viktigaste detaljerna behålls samtidigt som tokenanvändningen minskas. Strukturerad anteckningsteknik uppmuntrar användare att organisera information hierarkiskt, vilket gör det lättare för modellen att prioritera och hitta nyckelbegrepp. Dessa lösningar handlar om att vara strategisk med vilken information som får plats i kontextfönstret och hur den organiseras, snarare än att försöka få in allt i minnet på en gång.

De utökade kontextfönstren hos moderna AI-modeller har möjliggjort många verkliga tillämpningar som tidigare var opraktiska eller omöjliga. Kundsupportsystem kan nu granska hela ärendehistoriker och relaterad dokumentation i en enda begäran, vilket möjliggör mer exakta och kontextuellt anpassade svar utan att kunden behöver förklara sin situation på nytt. Dokumentanalys och forskning har transformerats av modeller som kan ta in hela forskningsartiklar, juridiska avtal eller tekniska specifikationer, identifiera nyckelinformation och besvara detaljerade frågor om innehållet som annars skulle ta timmar för en människa att gå igenom. Kodgranskning och mjukvaruutveckling gynnas av kontextfönster som är stora nog att rymma hela filer eller till och med flera relaterade filer, så att AI kan förstå arkitektoniska mönster och ge mer intelligenta förslag. Skapande av långformat innehåll och iterativa skrivarbetsflöden blir effektivare när modellen kan hålla koll på ett helt dokuments ton, stil och berättarstruktur under hela redigeringsprocessen. Mötestranskriptanalys och forskningssyntes drar nytta av stora kontextfönster för att extrahera insikter från timtals konversation eller dussintals källor, identifiera teman och samband som vore svåra att upptäcka manuellt. Dessa tillämpningar visar att kontextfönstrets storlek direkt översätts till praktiskt värde för yrkesverksamma i olika branscher.

Utvecklingen av kontextfönster tyder på att vi inom en snar framtid kommer att se ännu mer dramatiska expansioner, med Gemini 1.5 Pro som redan demonstrerar ett kontextfönster på 1 000 000 tokens och forskningslabb som utforskar ännu större kapaciteter. Utöver ren storlek kommer framtiden troligen att innefatta dynamiska kontextfönster som intelligent justerar storleken utifrån uppgiften, tilldelar mer kapacitet vid behov och minskar den för enklare frågor för att förbättra effektivitet och sänka kostnader. Forskare gör också framsteg med effektivare uppmärksamhetsmekanismer som minskar den beräkningsmässiga straffavgiften för större fönster och potentiellt bryter den kvadratiska skalningsbarriären som för närvarande begränsar kontextstorleken. När dessa tekniker mognar kan vi förvänta oss att kontextfönster blir mindre av en begränsning och mer av ett löst problem, vilket gör att utvecklare kan fokusera på andra aspekter av AI-kapacitet och tillförlitlighet. Kombinationen av större fönster, förbättrad effektivitet och smartare kontexthantering kommer troligen att definiera nästa generation av AI-tillämpningar och möjliggöra användningsområden vi ännu inte kan föreställa oss.

Ett kontextfönster är den totala mängden text (mätt i tokens) som en AI-modell kan bearbeta på en gång, medan en tokenbegränsning avser det maximala antalet tokens modellen kan hantera. Dessa termer används ofta omväxlande, men kontextfönster syftar specifikt på det arbetsminne som finns tillgängligt under en enskild inferens, medan tokenbegränsning också kan avse utdata- eller API-användningsbegränsningar.

Större kontextfönster förbättrar generellt svarskvaliteten genom att modellen kan ta hänsyn till mer relevant information och bibehålla bättre samtalskontinuitet. Extremt stora fönster kan dock ibland försämra kvaliteten på grund av kontextförfall, där modellen har svårt att prioritera viktig information bland stora mängder text. Den optimala storleken på kontextfönstret beror på den specifika uppgiften och hur väl informationen är organiserad.

Större kontextfönster kräver mer beräkningskraft på grund av den kvadratiska skalningen hos uppmärksamhetsmekanismen i transformerbaserade modeller. Uppmärksamhetsmekanismen måste beräkna relationer mellan varje token och varje annan token, så att dubbla kontextfönstret ungefär fyrdubblar beräkningskraven. Det är därför större kontextfönster är dyrare att köra och ger långsammare svarstider.

'Nålen i höstacken'-problemet uppstår när en AI-modell har svårt att hitta och använda relevant information ('nålen') när den ligger begravd i ett mycket stort kontextfönster ('höstacken'). Modeller presterar ibland sämre med extremt stora kontextfönster eftersom uppmärksamhetsmekanismen blir utspädd över så mycket information, vilket gör det svårare att identifiera vad som faktiskt är viktigt.

För att maximera effektiviteten av kontextfönstret, organisera information tydligt och hierarkiskt, placera den viktigaste informationen i början eller slutet av kontexten, använd strukturerade format som JSON eller markdown och överväg att använda Retrieval-Augmented Generation (RAG) för att dynamiskt ladda endast den mest relevanta informationen. Undvik att överbelasta modellen med irrelevant information som tar upp tokens utan att tillföra värde.

Kontextfönster är modellens tekniska kapacitet att bearbeta text samtidigt, medan samtalshistorik är den faktiska posten över tidigare meddelanden i ett samtal. Samtalshistoriken måste få plats inom kontextfönstret, men kontextfönstret inkluderar också utrymme för systemprompter, instruktioner och annan metadata. En samtalshistorik kan vara längre än kontextfönstret och kräver då sammanfattning eller trunkering.

Det finns för närvarande inga AI-modeller med verkligt obegränsade kontextfönster, eftersom alla modeller har arkitektoniska och beräkningsmässiga begränsningar. Dock erbjuder vissa modeller som Gemini 1.5 Pro extremt stora fönster (1 000 000 tokens), och tekniker som Retrieval-Augmented Generation (RAG) kan effektivt utöka modellens kunskapsbas bortom dess kontextfönster genom att dynamiskt hämta information vid behov.

Kontextfönstrets storlek påverkar direkt API-kostnaderna eftersom större fönster kräver mer beräkningsresurser att bearbeta. De flesta AI-API-leverantörer tar betalt baserat på tokenanvändning, så att använda ett större kontextfönster innebär fler bearbetade tokens och högre kostnader. Vissa leverantörer tar också ut premiumpriser för modeller med större kontextfönster, vilket gör det viktigt att välja rätt modellstorlek för dina specifika behov.

AmICited spårar hur AI-system som ChatGPT, Perplexity och Google AI Overviews citerar och refererar till ditt innehåll. Förstå din AI-synlighet och övervaka dina varumärkesomnämnanden över AI-plattformar.

Kontextfönster förklarat: det maximala antalet tokens en LLM kan bearbeta åt gången. Lär dig hur kontextfönster påverkar AI-noggrannhet, hallucinationer och var...

Lär dig vad kontextfönster är i AI-språkmodeller, hur de fungerar, deras påverkan på modellprestanda och varför de är viktiga för AI-drivna applikationer och öv...

Diskussion i communityn om AI:s kontextfönster och dess implikationer för innehållsmarknadsföring. Förstå hur kontextgränser påverkar AI:s bearbetning av ditt i...

Cookie-samtycke

Vi använder cookies för att förbättra din surfupplevelse och analysera vår trafik. See our privacy policy.